O que pode ser chamado de IA e o que não pode ser - em certo sentido, depende da definição. Não se pode negar que o AlphaGo - uma IA que funciona, desenvolvida pela equipe do Google DeepMind e derrotou o campeão mundial -, bem como sistemas similares com treinamento aprofundado nos últimos anos foram capazes de resolver problemas computacionais bastante complexos. Mas eles nos levarão a uma IA real e completa, à inteligência generalizada ou OI? Dificilmente - e aqui está o porquê.

Uma das principais características da OI com a qual você precisa lidar ao criá-la é que ela deve ser capaz de lidar de forma independente com o mundo externo e desenvolver seu próprio entendimento interno de tudo o que encontra, ouve, diz ou faz. Caso contrário, você estará nas mãos dos modernos programas de IA, cujo significado foi definido pelo desenvolvedor do aplicativo. A IA, de fato, não entende o que está acontecendo e sua área de especialização é muito estreita.

O problema do significado é talvez a mais fundamental das tarefas da IA e ainda não foi resolvida. Uma das primeiras pessoas a expressá-lo foi o cientista cognitivo Stevan Harnad, que escreveu em 1990 o trabalho "O Problema dos Símbolos Combinados". Mesmo se você não acredita que estamos manipulando símbolos, a tarefa ainda permanece: comparar a representação existente no sistema com o mundo real.

Para detalhes, observamos que a tarefa de compreensão nos leva a quatro subtarefas:

1. Como estruturar as informações que uma pessoa (pessoa ou IA) recebe do mundo exterior?

2. Como conectar essas informações estruturadas ao mundo, isto é, como construir uma compreensão do mundo por uma pessoa?

3. Como sincronizar esse entendimento com outras personalidades? (Caso contrário, a comunicação será impossível e o intelecto se tornará inexplicável e isolado).

4. Por que uma pessoa faz alguma coisa? Como iniciar todo esse movimento?

O primeiro problema, a estruturação, é bem resolvido por meio de aprendizado profundo e algoritmos de treinamento semelhantes que não exigem supervisão - por exemplo, é usado no AlphaGo. Nesta área, alcançamos sucessos significativos, em particular, graças ao recente aumento no poder de computação e ao uso de GPUs, que paralelizam particularmente o processamento de informações. Esses sistemas funcionam recebendo um sinal excessivamente redundante, expresso no espaço multidimensional, e o reduzem a sinais de dimensões menores, minimizando a perda de informações. Em outras palavras, eles capturam uma parte importante do sinal do ponto de vista do processamento de informações.

O segundo problema, o problema da conexão de informações com o mundo real, isto é, a criação de "entendimento", está diretamente relacionado à robotização. Para interagir com o mundo, você precisa de um corpo e, para construir essa conexão, precisa interagir com o mundo. Portanto, costumo argumentar que sem a robotização não há IA (embora existam excelentes robôs sem a IA, mas isso é outra história). Isso costuma ser chamado de "problema da incorporação", e a maioria dos pesquisadores de IA concorda que inteligência e incorporação estão intimamente relacionadas. Existem diferentes formas de inteligência em diferentes corpos, que podem ser facilmente vistos a partir de animais.

Tudo começa com coisas simples, como a busca de significado em suas próprias partes do corpo e como controlá-las para alcançar o efeito desejado no mundo visível, como a sensação de espaço, distância, cor etc. é construída. Nesta área, uma pesquisa detalhada foi conduzida por um cientista como J. Kevin O'Regan, conhecido por sua "teoria sensório-motora da consciência". Mas este é apenas o primeiro passo, pois será necessário construir conceitos cada vez mais abstratos com base nessas estruturas sensório-motoras mundanas. Ainda não chegamos a esse ponto, mas a pesquisa sobre esse assunto já está em andamento.

O terceiro problema é a questão da origem da cultura. Em alguns animais, as formas mais simples de cultura podem ser rastreadas e até as habilidades transmitidas por gerações, mas em um volume muito limitado, e apenas os seres humanos atingiram o limiar de crescimento exponencial do conhecimento adquirido que chamamos de cultura. A cultura é um catalisador da inteligência, e a IA que não tem a capacidade de interagir culturalmente será de apenas interesse acadêmico.

Mas a cultura não pode ser inserida manualmente na máquina como um código. Deve ser o resultado de um processo de aprendizado. A melhor maneira de procurar maneiras de entender esse processo é a

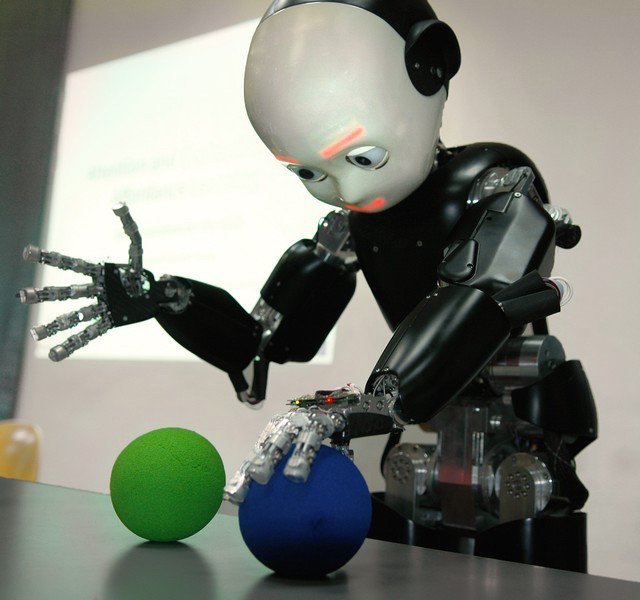

psicologia do desenvolvimento . O trabalho sobre esse tema foi realizado por Jean Piaget e Michael Tomasello, que estudaram o processo de aquisição de conhecimento cultural por crianças. Essa abordagem gerou uma nova disciplina de robótica, “desenvolvimento robótico”, tendo uma criança como modelo (como é o caso do robô iCub na ilustração).

Além disso, essa questão está intimamente relacionada ao estudo do processo de aprendizado de idiomas, e esse é um dos tópicos que eu mesmo estudo. O trabalho de pessoas como Luc Steels e outros mostrou que o processo de aquisição de uma linguagem pode ser comparado à evolução: uma pessoa cria novos conceitos interagindo com o mundo, usando-os para se comunicar com outras personalidades e seleciona estruturas que ajudam a se comunicar com mais sucesso do que outras (principalmente para atingir objetivos compartilhados). Após centenas de tentativas e erros, como no caso da evolução biológica, o sistema gera o melhor conceito e sua tradução sintática / gramatical.

Esse processo foi testado experimentalmente e é surpreendentemente semelhante ao modo como as línguas naturais evoluem e crescem. Ele também é responsável pelo aprendizado instantâneo, quando uma pessoa percebe o conceito imediatamente - essas coisas não são capazes de explicar esses modelos baseados em estatística como aprendizado profundo. Agora, vários laboratórios de pesquisa que usam essa abordagem estão tentando avançar mais no sentido de perceber gramática, gestos e fenômenos culturais mais complexos. Especificamente, este é o AI Lab, fundado por mim na empresa francesa envolvida na robótica Aldebaran. Agora, ele se tornou parte do Grupo SoftBank - eles criaram os robôs

Nao ,

Romeo e

Pepper (abaixo).

E, finalmente, o quarto problema é confrontado com "motivação intrínseca". Por que uma pessoa faz alguma coisa e não apenas fica em repouso. Os requisitos de sobrevivência não são suficientes para explicar o comportamento humano. Mesmo que você alimente e garanta a segurança de uma pessoa, ela não fica esperando o retorno da fome. As pessoas estudam o ambiente, tentam fazer algo e são movidas por alguma forma de curiosidade inerente. O pesquisador Pierre-Yves Oudeyer mostrou que a expressão matemática mais simples da curiosidade, na forma do desejo de uma pessoa de maximizar a velocidade de aprendizado, é suficiente para produzir um comportamento surpreendentemente complexo e inesperado (veja, por exemplo, um experimento com um "playground" realizado em Sony CSL).

Aparentemente, algo semelhante é necessário para o sistema, a fim de induzir nele um desejo de seguir as três etapas anteriores: estruturar as informações sobre o mundo, combiná-las com seu corpo e criar conceitos significativos e, em seguida, escolher o mais eficaz do ponto de vista da comunicação para criar uma articulação. uma cultura em que a cooperação é possível. Do meu ponto de vista, é exatamente isso que é o programa OI.

Repito que o rápido desenvolvimento do aprendizado profundo e o recente sucesso dessa IA em jogos como o go são notícias muito boas, pois essa IA encontrará muitos pontos de aplicação em pesquisa médica, indústria, conservação ambiental e outras áreas. Mas essa é apenas uma parte do problema, que tentei explicar aqui. Não acredito que o aprendizado profundo seja uma panacéia que nos levará a uma IA real, no sentido de uma máquina que pode aprender a viver em paz, interagir naturalmente conosco, entender a complexidade de nossas emoções e distorções culturais e, finalmente, nos ajudar a tornar o mundo um lugar melhor.