Provavelmente não vale a pena falar sobre o que é a chamada

Lei de Moore no Geektimes - todos sabemos disso, pelo menos aproximadamente. Em resumo, esta lei é uma observação empírica feita por Gordon Moore. Havia vários termos da lei em si, mas o moderno diz que o número de transistores colocados em um chip de circuito integrado dobra a cada 24 meses. Um pouco mais tarde, uma espécie de lei apareceu, onde aparece não dois anos, mas 18 meses. Isso não se deve a Moore, mas a David House, da Intel. Para ele, o desempenho dos processadores deve dobrar a cada 18 meses devido ao crescimento simultâneo do número de transistores e da velocidade de cada um deles.

Desde a redação da lei, os desenvolvedores de elementos eletrônicos tentam acompanhar os prazos estabelecidos. De um modo geral, para 1965 a lei era algo incomum, pode até ser chamado de radical. Em seguida, os “mini-computadores” ainda não eram muito pequenos, ocupando o volume de uma área de trabalho comum na sala ou até mais. Naquela época, era difícil imaginar que os computadores pudessem se tornar parte de uma geladeira, máquina de lavar ou outros eletrodomésticos ao longo do tempo. A maioria das pessoas nunca viu um computador e aqueles que viram quase nunca trabalharam com eles. Bem, aqueles que trabalhavam usavam cartões perfurados e outras ferramentas não muito convenientes para interagir com computadores, que, por sua vez, trabalhavam para resolver uma gama bastante estreita de tarefas.

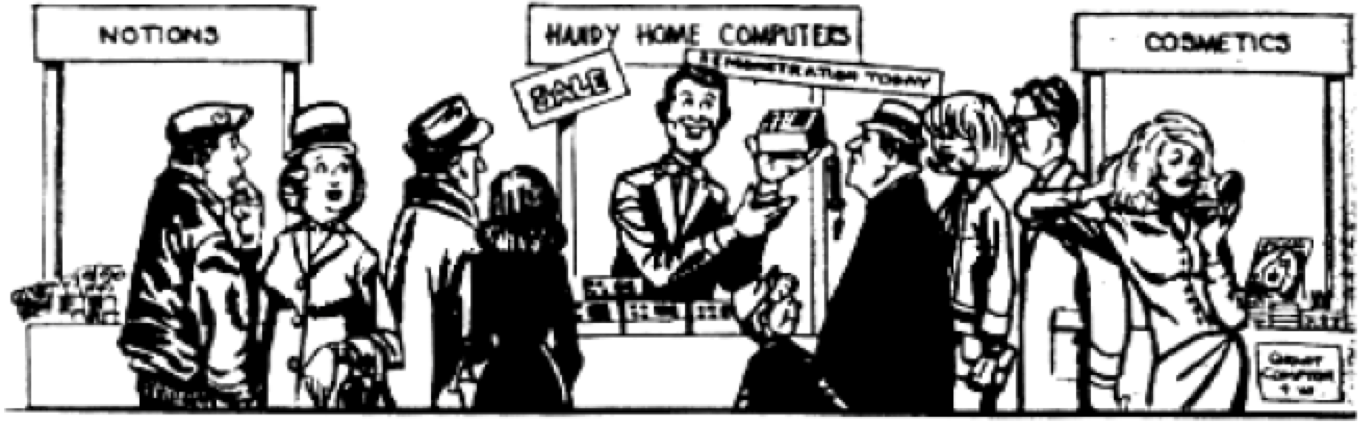

Depois que a idéia de Moore se tornou conhecida, eles começaram a brincar em revistas. Por exemplo, em um deles eles postaram aqui uma caricatura:

Depois, foi difícil imaginar que em breve mesmo esses computadores não seriam considerados pequenos. Moore, aliás, viu a ilustração e ficou muito surpresa com sua originalidade. Tanto quanto se pode julgar, o artista tentou transmitir uma atitude um pouco cética em relação à idéia de reduzir constantemente o tamanho dos PCs. Mas, após 25 anos, essa ilustração se tornou uma realidade cotidiana.

Influência da Lei de Moore

Como mencionado acima, existem várias variações da Lei de Moore, não estamos falando apenas de um aumento constante no número de transistores no chip. Uma das conseqüências da idéia de Moore é uma tentativa de descobrir com que rapidez todos os transistores que encolhem funcionarão. Além disso, cientistas e especialistas em tecnologia da informação, usando a idéia de Moore, tentaram e estão tentando pré-prever a rapidez com que a quantidade de RAM, a memória principal crescerá, a produtividade dos chips, etc.

Mas o principal não é qual versão da Lei de Moore é mais curiosa / útil, mas qual o impacto da idéia principal em nosso mundo. Três formas principais de influência podem ser distinguidas aqui. Essa é uma rivalidade dos desenvolvedores, prevendo e alterando a arquitetura dos sistemas de computação.

RivalidadeA Lei de Moore pode ser usada para descobrir quanta informação pode ser armazenada no volume de um chip. Esta lei, a propósito, pode ser atribuída à RAM no campo. No início da informática, ou melhor, PC, um chip de computador poderia armazenar

. Os próprios chips começaram a se chamar RAM (Random Access Memory). Chips com 16K começaram a produzir muitos. Então, em total conformidade com a lei de Moore, ou ainda mais rapidamente, apareceram chips com 64 K. Os engenheiros que desenvolveram esses chips conheciam a lei e tentaram cumpri-la. Assim, desde o início, foi estabelecido um ciclo de produção especial e ininterrupto, quando os engenheiros, liberando um chip, já estavam terminando o trabalho em sua próxima geração. Esta situação é observada agora. Todo mundo sabe sobre as regras e o jogo, e todo mundo participa.

PrevisãoConhecendo a tendência para um aumento no número de transistores no volume de chips (e a fórmula era suficientemente clara), os engenheiros de qualquer empresa que fabrica componentes eletrônicos podiam imaginar quando uma geração de chips seria lançada. E foi uma previsão bastante precisa. Pode-se também imaginar em que ano e com qual desempenho o processador funcionará.

Os engenheiros das empresas começaram a elaborar planos de produção, concentrando-se principalmente na Lei de Moore. Os fornecedores de computadores tinham uma boa idéia de quando qual geração de máquinas deveria sair do mercado e quando.

A lei de Moore, pode-se dizer, estabeleceu o processo de produção para a produção de componentes e sistemas eletrônicos. Não houve surpresas a esse respeito, e não poderia haver, porque todo mundo trabalhou na mesma velocidade, sem tentar ultrapassar ou ficar atrás do prazo estabelecido por Moore. Tudo era perfeitamente previsível.

Arquitetura e elementos do PC

Arquitetura e elementos do PCA mesma Lei de Moore permitiu que os engenheiros desenvolvessem um design de chip que se tornou uma referência por um longo tempo. Este é um Intel 4004 e suas encarnações subsequentes. Uma arquitetura especializada foi desenvolvida, denominada

arquitetura von Neumann .

Em março de 1945, os princípios da arquitetura lógica foram formalizados em um documento chamado "O Primeiro Esboço do Relatório EDVAC" - um relatório para o Laboratório Balístico do Exército dos EUA, em cujo dinheiro o ENIAC foi construído e o EDVAC desenvolvido. O relatório, por ser apenas um rascunho, não tinha como objetivo a publicação, mas apenas a distribuição dentro do grupo, no entanto, German Goldstein, curador do projeto do Exército dos EUA, multiplicou esse trabalho científico e o enviou a um amplo círculo de cientistas para revisão. Como apenas o nome von Neumann [1] estava na primeira página do documento, quem leu o documento teve a falsa impressão de que ele era o autor de todas as idéias apresentadas no trabalho. O documento forneceu informações suficientes para que seus leitores pudessem construir seus computadores semelhantes ao EDVAC nos mesmos princípios e com a mesma arquitetura, que, como resultado, ficou conhecida como "arquitetura von Neumann".

Após o final da Segunda Guerra Mundial e o fim do trabalho no ENIAK em fevereiro de 1946, a equipe de engenheiros e cientistas John Mokley e John Eckert decidiram se dedicar aos negócios e criar computadores em uma base comercial. Von Neumann, Goldstein e Burks se mudaram para o Institute for Advanced Study, onde decidiram criar sua própria máquina IAS, semelhante à EDVAC, e usá-la para trabalhos de pesquisa. Em junho de 1946, eles [2] [3] estabeleceram seus princípios para a construção de computadores no artigo clássico "Consideração Preliminar do Projeto Lógico de um Dispositivo de Computação Eletrônica". Mais de meio século se passou desde então, mas as disposições nele apresentadas continuam sendo relevantes hoje. O artigo comprova convincentemente o uso de um sistema binário para representar números, pois antes de todas as máquinas de computação armazenavam números processados na forma decimal. Os autores demonstraram as vantagens do sistema binário para implementação técnica, a conveniência e a simplicidade de executar operações aritméticas e lógicas nele. No futuro, os computadores começaram a processar tipos não numéricos de informações - texto, gráfico, som e outros, mas a codificação de dados binários ainda forma a base de informações de qualquer computador moderno.

Todas as fundações lançadas há várias décadas e se tornaram a base. No futuro, quase tudo permanecerá inalterado, os desenvolvedores apenas tentaram tornar os computadores cada vez mais produtivos.

Vale lembrar que a Lei de Moore é a base de tudo. Todas as suas encarnações serviram de suporte ao modelo básico do desenvolvimento da tecnologia da computação, e já pouco pode levar a uma interrupção neste ciclo. E quanto mais ativamente o desenvolvimento da tecnologia de computadores prosseguia, mais profundo, podemos dizer, que os desenvolvedores desses sistemas estavam atolados em lei. De fato, a criação de uma arquitetura de computador diferente leva anos e anos, e poucas empresas podem pagar esse luxo - a busca por formas alternativas de desenvolver a tecnologia de computador. Organizações de pesquisa como o MIT realizaram experiências corajosas como a Lisp Machine e a Connection Machine, aqui você pode mencionar um dos projetos japoneses. Mas tudo isso terminou em nada, a arquitetura von Neumann permaneceu em uso.

O trabalho de engenheiros e programadores agora consistia em otimizar o trabalho de seus programas e hardware, para que cada milímetro quadrado de chips trabalhasse cada vez mais eficientemente. Os desenvolvedores competiram no armazenamento em cache de quantidades cada vez maiores de dados. Além disso, vários fabricantes de componentes eletrônicos tentaram (e ainda estão tentando) colocar o maior número possível de núcleos possível em um processador. Seja como for, todo o trabalho se concentrou em um número limitado de arquiteturas de processador. Estes são X86, ARM e PowerPC. Trinta anos atrás, havia muitos mais.

O X86 é usado principalmente em desktops, laptops e servidores em nuvem. Os processadores ARM são executados em telefones e tablets. Bem, na maioria dos casos, o PowerPC é usado na indústria automotiva.

Uma exceção interessante às regras estritas do jogo estabelecidas pela Lei de Moore é a GPU. Eles foram desenvolvidos para processar informações gráficas com um alto grau de eficiência; portanto, sua arquitetura é diferente do processador (ainda). Mas, para lidar com sua tarefa, a GPU teve que ser desenvolvida independentemente da evolução dos processadores. A arquitetura das placas de vídeo foi otimizada para lidar com a grande quantidade de dados necessários para renderizar a imagem na tela. Portanto, aqui os engenheiros desenvolveram um tipo diferente de chip, que não substituiu os processadores existentes, mas complementou suas capacidades.

Quando a lei de Moore deixará de funcionar?

No sentido usual, ele já parou de funcionar, nesse entendimento clássico, que foi discutido acima. Isso é evidenciado por várias fontes, incluindo, por exemplo,

esta . Agora a corrida ainda está em andamento. Por exemplo, no mesmo primeiro processador comercial Intel 4004 de 5 bits lançado em 1971, havia 2.300 transistores. Após 45 anos, em 2016, a Intel lançou o processador Xeon Broadwell-WS de 24 núcleos com 5,7 bilhões de transistores. Este processador está disponível na tecnologia de 14 nm. A IBM anunciou recentemente um processador de 7 nm com 20 bilhões de transistores e, em seguida, um processador de 5 nm com 30 bilhões de transistores.

Mas 5 nm é uma camada com uma espessura de apenas 20 átomos. Aqui, a engenharia já está se aproximando do limite técnico de melhorias adicionais no processo. Além disso, a densidade de transistores nos processadores modernos é muito alta. 5 ou mesmo 10 bilhões de transistores por milímetro quadrado. A velocidade de transmissão do sinal no transistor é muito alta e é de grande importância. A frequência principal dos processadores mais rápidos modernos é de 8,76 GHz. Aceleração adicional, embora possível, também é um problema técnico e é muito, muito grande. É por isso que os engenheiros optaram por criar processadores com vários núcleos, em vez de continuar aumentando a frequência de um único núcleo.

Isso permitiu manter o ritmo de aumento do número de operações por segundo previsto pela lei de Moore. No entanto, o próprio multinuclearismo é um certo afastamento da lei. No entanto, vários especialistas acreditam que não importa como tentamos "recuperar o atraso", o principal é que o ritmo do desenvolvimento tecnológico, em particular a informática, está mais ou menos em conformidade com a lei de Moore.

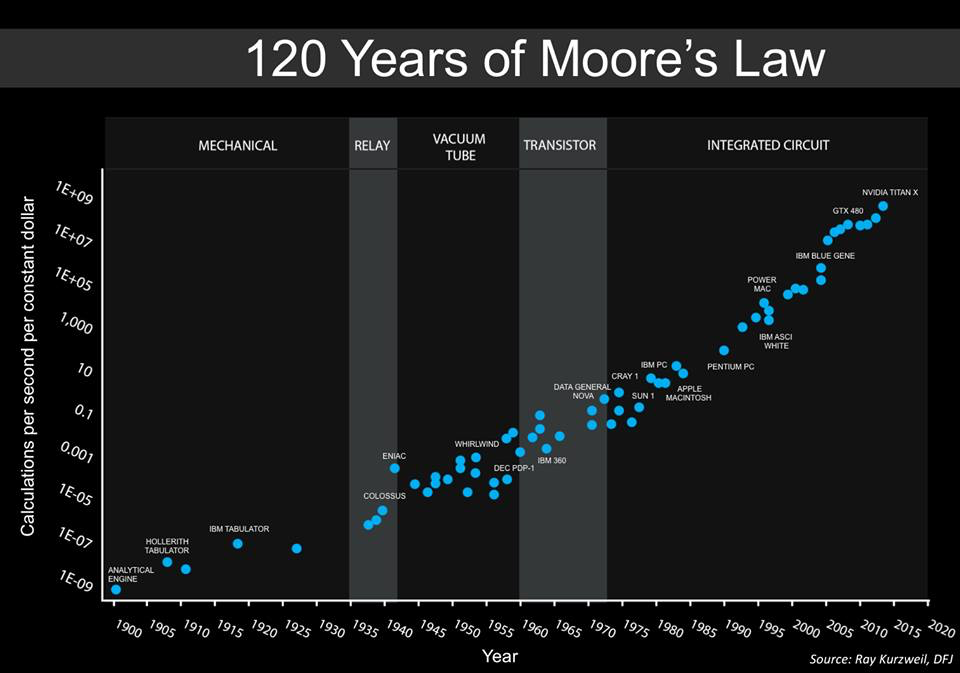

Abaixo está um gráfico criado por Steve Jurvetson, co-fundador da Draper Fisher Jurvetson. Ele afirma que esse é um cronograma aumentado enviado anteriormente por

Ray Kurzweil .

Este gráfico mostra o custo relativo do número de operações por unidade de tempo (1 segundo). Ou seja, podemos ver claramente quanto mais barato a computação do computador ao longo do tempo. Além disso, os cálculos tornaram-se cada vez mais universais, por assim dizer. Nos anos 40, havia máquinas especializadas projetadas para decifrar códigos militares. Na década de 1950, os computadores começaram a ser usados para trabalhar com tarefas comuns, e essa tendência continua até hoje.

Curiosamente, as duas últimas posições no gráfico são a GPU, GTX 450 e NVIDIA Titan X. Curiosamente, em 2010 não havia GPUs no gráfico, apenas processadores com vários núcleos.

Em geral, a GPU já está aqui e muitos estão felizes com isso. Além disso, agora uma direção como a aprendizagem profunda, uma das manifestações das redes neurais, está se tornando cada vez mais popular. Muitas empresas, grandes e pequenas, estão envolvidas em seu desenvolvimento. E as GPUs são ideais para redes neurais.

Por que tudo isso? O fato é que o aumento geral no número de cálculos ainda é preservado, sim, mas os métodos e equipamentos estão mudando.

O que tudo isso significa?

Agora, a própria forma da computação está mudando. Os arquitetos em breve não precisarão pensar no que mais fazer para acompanhar a lei de Moore. Agora, novas idéias estão sendo introduzidas gradualmente, atingindo alturas inacessíveis aos sistemas de computadores convencionais com arquitetura tradicional. Talvez, em um futuro próximo, a velocidade da computação não seja tão importante, seja possível melhorar o desempenho do sistema de maneira diferente.

Sistemas de auto-aprendizagem

Sistemas de auto-aprendizagemAgora, muitas redes neurais dependem da GPU. Sistemas com arquitetura especializada estão sendo criados para eles. Por exemplo, o Google desenvolveu seus próprios chips, chamados de TensorFlow Units (orTPUs). Eles permitem economizar energia de computação devido à eficiência dos cálculos. O Google usa esses chips em seus datacenters, e muitos dos serviços em nuvem da empresa trabalham em suas bases. Como resultado, o desempenho do sistema é maior e o consumo de energia é menor.

Chips especializadosEm dispositivos móveis convencionais, os processadores ARM agora estão funcionando, especializados. Esses processadores processam informações das câmeras, otimizam o processamento de fala e trabalham em tempo real com reconhecimento de rosto. Especialização em tudo é o que a eletrônica espera.

Arquitetura especializadaSim, a cunha não convergiu para a arquitetura von Neumann, agora sistemas com arquiteturas diferentes projetadas para executar tarefas diferentes estão sendo desenvolvidos. Essa tendência não é apenas mantida, mas até acelerada.

Segurança de ComputadoresOs cibercriminosos estão se tornando cada vez mais hábeis. Com a invasão de alguns sistemas, agora você pode obter milhões, dezenas de milhões de dólares. Mas, na maioria dos casos, é possível invadir o sistema devido a erros de software ou hardware. A grande maioria dos truques usados pelos crackers trabalha em sistemas com arquitetura von Neumann, mas eles não funcionam com outros sistemas.

Sistemas quânticosOs chamados computadores quânticos são tecnologia experimental, que, entre outras coisas, também é muito cara. Elementos criogênicos são usados aqui, além de muitas outras coisas que não são encontradas em sistemas convencionais. Os computadores quânticos são completamente diferentes dos computadores usuais, e a lei de Moore não se aplica a eles. No entanto, com a ajuda deles, de acordo com especialistas, é possível aumentar radicalmente o desempenho de alguns tipos de cálculos. Talvez tenha sido a lei de Moore que levou cientistas e engenheiros a procurar novas maneiras de aumentar a eficiência da computação e encontrá-las.

Como um posfácio

Provavelmente em 5 a 10 anos veremos sistemas de computação completamente novos, agora estamos falando sobre tecnologia de semicondutores. Esses sistemas estarão à frente de nossos planos mais loucos e se desenvolverão em um ritmo muito rápido. Provavelmente, especialistas, tentando contornar a lei de Moore, criarão novas tecnologias de desenvolvimento de chips que, se tivessem nos contado sobre eles agora, pareceriam mágicas para nós. O que diriam as pessoas que viveram 50 anos atrás se recebessem um smartphone moderno? Poucos entenderiam como tudo funciona. Assim é no nosso caso.