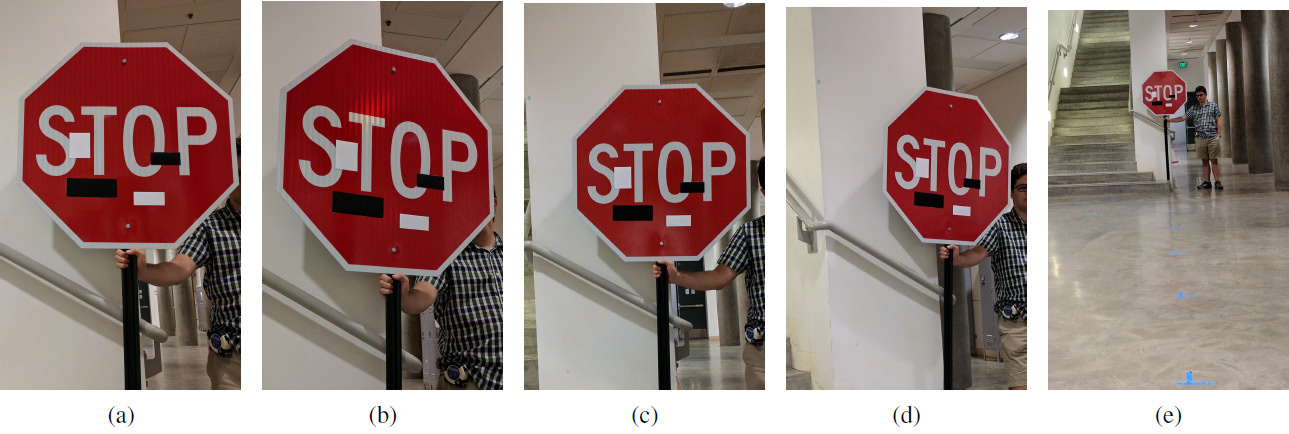

Um conjunto de imagens experimentais com adesivos de arte em diferentes distâncias e ângulos diferentes: (a) 5 pés, 0 graus; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; e) 40 ° 0 °. A trapaça funciona a qualquer distância e em qualquer ângulo: em vez do sinal de parada, o sistema de aprendizado de máquina vê o sinal "Limite de velocidade de 45 milhas"

Um conjunto de imagens experimentais com adesivos de arte em diferentes distâncias e ângulos diferentes: (a) 5 pés, 0 graus; (b) 5 '15 °; (c) 10 ° 0 °; (d) 10-30 °; e) 40 ° 0 °. A trapaça funciona a qualquer distância e em qualquer ângulo: em vez do sinal de parada, o sistema de aprendizado de máquina vê o sinal "Limite de velocidade de 45 milhas"Enquanto alguns cientistas estão melhorando os sistemas de aprendizado de máquina, outros cientistas estão melhorando os métodos de enganar esses sistemas.

Como você sabe, pequenas alterações direcionadas na imagem podem "quebrar" o sistema de aprendizado de máquina, para que ele reconheça uma imagem completamente diferente. Tais imagens de "Trojan" são chamadas de "exemplos contraditórios" e representam uma das

limitações conhecidas

do aprendizado profundo .

Para criar um exemplo competitivo, você precisa maximizar a ativação, por exemplo, de um determinado filtro de rede neural convolucional. Ivan Yevtimov, da Universidade de Washington, juntamente com colegas da Universidade da Califórnia em Berkeley, da Universidade de Michigan e da Universidade de Nova York em Stony Brook, desenvolveu um novo algoritmo de ataque -

perturbações físicas robustas (

perturbações físicas robustas ou RP

2 ). Captura de maneira muito eficaz a visão de veículos não tripulados, robôs, quadcopters e quaisquer outros sistemas robóticos que tentam navegar no espaço circundante.

Ao contrário dos estudos anteriores, aqui os autores se concentraram em alterar diretamente os próprios objetos, e não o plano de fundo. A tarefa dos pesquisadores era encontrar o menor delta possível que derrubasse o classificador do sistema de aprendizado de máquina, que foi treinado em

um conjunto de dados com imagens dos sinais de trânsito do LISA . Os autores tiraram independentemente uma série de fotografias de sinais de trânsito na rua em diferentes condições (distância, ângulos, iluminação) e complementaram o conjunto de dados do LISA para treinamento.

Depois de calcular esse delta, uma máscara foi revelada - um local (ou vários locais) na imagem que mais confiável causa perturbações no sistema de aprendizado de máquina (visão de máquina). Uma série de experimentos foram realizados para verificar os resultados. Os experimentos foram realizados principalmente em um sinal de parada (o sinal "STOP"), que os pesquisadores transformaram com várias manipulações inócuas para visão de máquina no sinal "SPEED LIMIT 45". A técnica desenvolvida pode ser usada em quaisquer outros sinais. Os autores então testaram em um sinal de volta.

A equipe de pesquisa desenvolveu dois tipos de ataques a sistemas de visão de máquina que reconhecem sinais de trânsito. O primeiro ataque são pequenas alterações imperceptíveis em toda a área do sinal. Usando o otimizador Adam, eles conseguiram minimizar a máscara para criar exemplos competitivos separados, direcionados e direcionados a sinais de trânsito específicos. Nesse caso, os sistemas de aprendizado de máquina podem ser enganados com alterações mínimas de imagem, e as pessoas nem notarão nada. A eficácia desse tipo de ataque foi testada em pôsteres impressos com pequenas alterações (a princípio, os pesquisadores estavam convencidos de que o sistema de visão por máquina reconhece com sucesso pôsteres sem alterações).

O segundo tipo de ataque é camuflagem. Aqui, o sistema imita atos de vandalismo ou grafite artístico para que o sistema não interfira na vida das pessoas ao seu redor. Assim, o motorista verá imediatamente o sinal de mudança de direção à esquerda ou a luz de freio, e o robô verá um sinal completamente diferente. A eficácia desse tipo de ataque foi testada em sinais de trânsito reais, lacrados com adesivos. A camuflagem de graffiti consistia em adesivos na forma das palavras AMOR e ÓDIO, e camuflagem como arte abstrata - em quatro adesivos de formato retangular em preto e branco.

Os resultados da experiência são mostrados na tabela. Em todos os casos, é mostrada a eficácia de trapacear o classificador de aprendizado de máquina, que reconhece o sinal "STOP" modificado como o sinal "SPEED LIMIT 45". A distância está em pés e o ângulo de rotação está em graus. A segunda coluna mostra a segunda classe, que é vista no sistema de aprendizado de máquina em um sinal modificado. Por exemplo, a uma distância de 152,4 cm (5 pés), a camuflagem, como arte abstrata em um ângulo de 0 °, produz os seguintes resultados para reconhecer o sinal "STOP": com uma confiança de 64%, é reconhecido como um sinal de "SPEED LIMIT 45" e com uma confiança de 11% - como Lane termina o sinal.

Legenda: SL45 = Limite de velocidade 45, STP = Parada, YLD = Rendimento, ADL = Faixa adicionada, SA = Sinal adiante, LE = Extremidades da faixa

Legenda: SL45 = Limite de velocidade 45, STP = Parada, YLD = Rendimento, ADL = Faixa adicionada, SA = Sinal adiante, LE = Extremidades da faixaTalvez esse sistema (com as mudanças correspondentes) seja necessário para a humanidade no futuro, e agora ele pode ser usado para testar sistemas imperfeitos de aprendizado de máquina e visão computacional.

O trabalho científico foi

publicado em 27 de julho de 2017 no site de pré-impressão arXiv.org (arXiv: 1707.08945).