Os editores do Oxford Dictionary escolheram a palavra "pós-verdade"

como a honrosa "

palavra de 2016 ". Este termo descreve circunstâncias em que fatos objetivos são menos importantes para a formação da opinião pública do que o apelo a emoções e crenças pessoais.

Uma frequência particularmente alta do uso dessa palavra foi observada em publicações em inglês após a eleição presidencial dos EUA em conexão com a divulgação de um grande número de notícias falsas, após o que a verdade em si não importava muito.

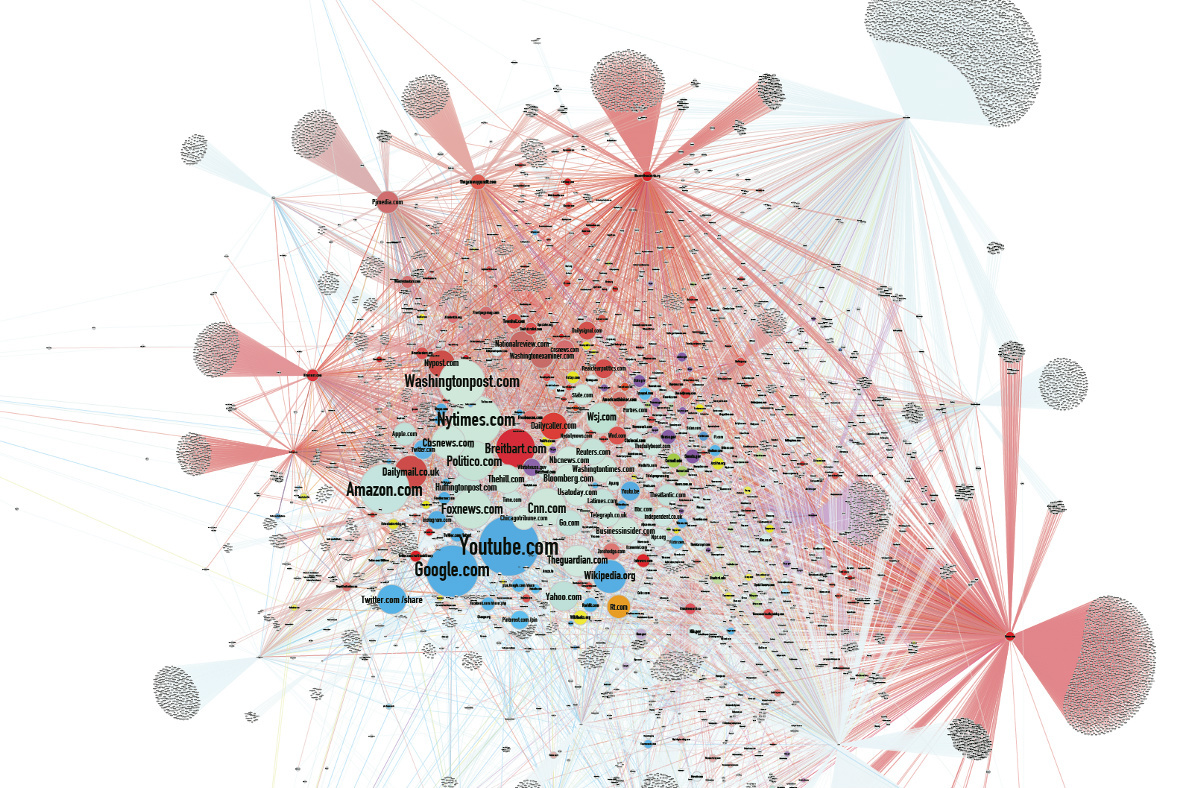

Segundo alguns analistas, a disseminação de notícias difamatórias falsas foi um dos motivos da derrota de Hillary Clinton nas eleições. Feed algorítmico O Facebook

se tornou uma das principais fontes de notícias falsas.

Nesse contexto, as notícias de desenvolvedores no campo da inteligência artificial quase não foram percebidas. Já estamos acostumados ao fato de que as redes neurais desenham, criam uma foto de uma pessoa de acordo com sua descrição verbal e geram música. Eles estão fazendo mais e mais, e cada vez que estão melhorando. Mas o mais interessante é que as máquinas aprenderam a criar falsificações.

A influência de falsificações

Durante a corrida eleitoral nos EUA, o número de republicações de notícias falsas nas redes sociais excedeu o número de republicações de mensagens verdadeiras, porque as falsificações estavam mais alinhadas com as expectativas ou eram mais emocionantes. Após a eleição, o Facebook contratou verificadores independentes para sinalizar mensagens não verificadas para alertar os usuários.

A combinação de maior polarização política da sociedade e uma tendência de ler principalmente títulos dá um efeito cumulativo. As notícias falsas também são frequentemente disseminadas através de sites de notícias falsas, informações das quais frequentemente caem na grande mídia, que buscam atrair tráfego de usuários. E nada atrai o tráfego como uma manchete atraente.

Mas, de fato, a influência de falsificações não se limita apenas à esfera política. Existem muitos exemplos que demonstram o impacto das notícias falsas na sociedade.

Uma empresa de produção de vídeo australiana lança

vídeos virais falsos há dois anos, obtendo centenas de milhões de visualizações.

Em uma

farsa bem pensada sobre Stalin, cujo rosto supostamente apareceu no metrô de Moscou, eles até acreditaram em 1º de abril.

Em 1992, o milionário Ilya Medkov começou a pagar grandes agências de notícias na Rússia e na CEI (incluindo RIA Novosti, Interfax, ITAR-TASS). O ITAR-TASS emitiu uma

mensagem falsa à mídia sobre o acidente na central nuclear de Leningrado em janeiro de 1993. Como resultado, as ações das principais empresas escandinavas caíram de preço e, até aparecer uma refutação da mídia, os agentes de Medkov compraram as ações mais lucrativas das empresas suecas, finlandesas e norueguesas.

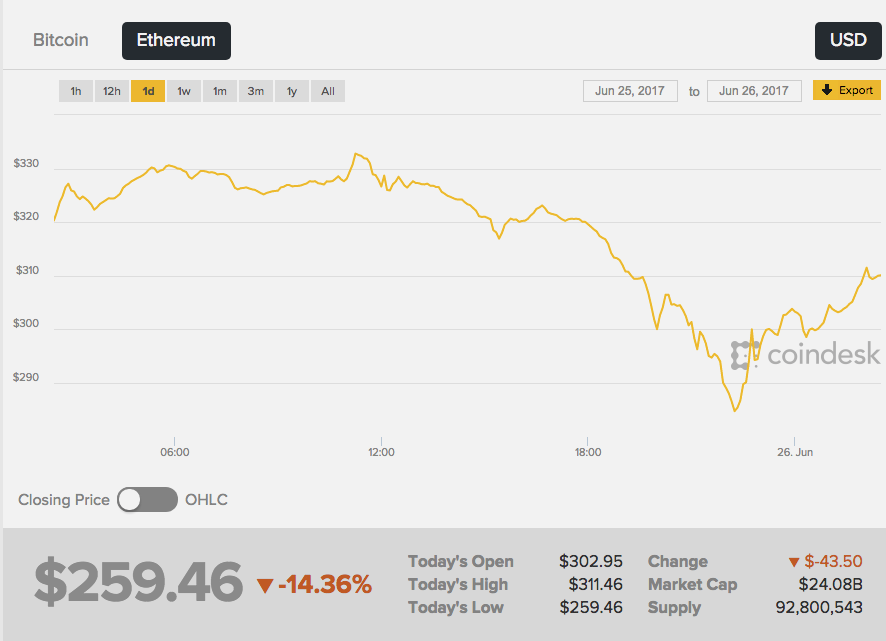

Em 26 de junho de 2017, a taxa da segunda capitalização de criptomoedas Ethereum caiu drasticamente - a troca reagiu a rumores que apareceram na rede sobre a morte trágica do criador de Ether, Vitaliy Buterin. Além disso, as primeiras "notícias urgentes" apareceram em um quadro de imagens 4chan anônimo - e essa fonte, francamente, não é a mais confiável.

A Wikipedia escreveu que "Vitalik

era um programador russo" e, em seguida, a imprensa amarela recebeu a notícia. Como resultado, a taxa de éter

caiu 13%, de cerca de US $ 289 para US $ 252. O curso começou a crescer imediatamente após a negação das notícias do próprio Vitali.

Não há evidências de que alguém tenha deliberadamente criado uma farsa para obter lucro com a diferença nas taxas de criptomoeda. É indiscutível apenas que notícias fictícias sem um único fato confirmado têm um efeito poderoso sobre as pessoas.

Imitação da realidade

A cantora francesa Francoise Ardi repetirá o discurso de Kellianne Conway, consultora do presidente dos EUA, Donald Trump, que ficou famosa depois de falar sobre "fatos alternativos". O interessante aqui é que Ardi tem 73 anos e, no vídeo, ela parece ter 20 anos.

O Roller Alternative Face v1.1 foi

criado pelo artista-acionista alemão Mario Klingeman. Ele fez as entrevistas em áudio de Conway e os antigos videoclipes de Arde. E então ele usou uma rede neural generativa (GAN), que criou conteúdo de vídeo exclusivo de muitos quadros de clipes diferentes do cantor, e cobriu uma faixa de áudio com comentários de Conway.

Nesse caso, o falso é fácil de reconhecer, mas você pode ir além - fazer alterações no arquivo de áudio. As pessoas vão acreditar na imagem e no som gravando com mais disposição do que apenas texto. Mas como fingir o próprio som de uma voz humana?

Os sistemas GAN são capazes de estudar as características estatísticas das gravações de áudio e, em seguida, reproduzi-las em um contexto diferente, com precisão de milissegundos. Basta digitar o texto que a rede neural deve reproduzir e você obterá uma declaração plausível.

A startup canadense Lyrebird publicou seus próprios algoritmos que podem simular a voz de qualquer pessoa com base em um arquivo de som com duração de um minuto. Para demonstrar as possibilidades, a empresa

postou uma conversa entre Obama, Trump e Clinton - todos os heróis, é claro, eram falsos.

O DeepMind, o Instituto Baidu de Aprendizagem Profunda e o Instituto de Montreal para o Estudo de Algoritmos (MILA) já estão trabalhando em algoritmos de conversão de texto em fala altamente realistas.

O resultado ainda não é perfeito, você pode distinguir rapidamente a voz recriada da original, mas a semelhança é sentida. Além disso, na voz, a rede muda emoções, acrescenta raiva ou tristeza, dependendo da situação.

Geração de imagens

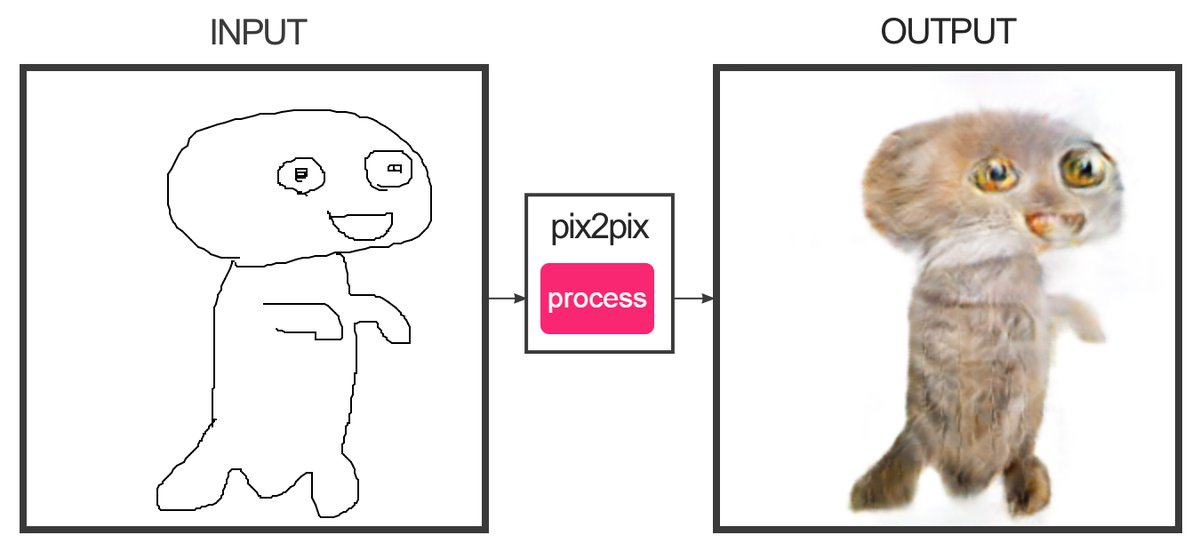

O desenvolvedor Christopher Hesse criou um

serviço que, com a ajuda do aprendizado de máquina, pode "desenhar" esboços que consistem em várias linhas para fotografias coloridas. Sim, este é o site que desenha gatos. Os selos acabam assim - é difícil confundi-los com os reais.

O programador Alexa Jolikier Martino conseguiu

criar gatos exatamente iguais aos reais. Para fazer isso, ele usou o DCGAN - Redes Adversárias Gerativas Convolucionais Profundas (redes competitivas convolucionais geradoras profundas). Os DCGANs são capazes de criar imagens fotorrealistas únicas combinando duas redes neurais profundas que competem entre si.

A primeira rede (geradora) recebe os valores das variáveis na entrada e, na saída, fornece os valores da função dessas variáveis, que devem "convencer" a segunda rede (discriminando ou discriminando) de que os resultados da primeira rede são indistinguíveis do padrão. Como amostras no trabalho de Joliker-Martino, foi utilizado um banco de dados de dez mil retratos de felinos.

Usando os métodos DCGAN, é possível criar imagens falsas que não podem ser objetivamente consideradas falsas sem outra rede neural.

Combinações de conteúdo

Na Universidade de Washington, eles

desenvolveram um algoritmo que permite sobrepor áudio no vídeo de uma pessoa com sincronização labial precisa. O algoritmo foi treinado em 17 horas das mensagens de vídeo de Barack Obama. A rede neural foi treinada para simular os movimentos dos lábios de Obama de maneira a corrigir seus movimentos, imitando a pronúncia das palavras certas. Até agora, você só pode gerar vídeos com palavras que a pessoa realmente disse.

Agora observe a operação do algoritmo, que

permite alterar as expressões faciais de outra pessoa em tempo real para suas próprias expressões faciais. No vídeo com Trump (ainda há uma demonstração sobre Bush, Putin e Obama), a curvatura da pessoa é imposta no estúdio, e o resultado é um Trump mal-humorado. O algoritmo é usado no Face2Face. A tecnologia criada é semelhante, em princípio, ao bot

Smile Vector , que adiciona um sorriso às pessoas nas fotos.

Assim, agora é possível criar um vídeo realista no qual uma pessoa famosa fale fatos fictícios. A fala pode ser cortada de discursos anteriores para compor qualquer mensagem. Mas, no futuro próximo, até esses truques serão supérfluos - a rede colocará qualquer texto na boca de um personagem falso com precisão.

As consequências

Do ponto de vista prático, todas essas tecnologias permitem que você faça muito bem. Por exemplo, você pode melhorar a qualidade da videoconferência sintetizando os quadros ausentes se eles caírem do fluxo de vídeo. E até sintetiza palavras ausentes inteiras, proporcionando excelente comunicação em locais com qualquer nível de sinal.

Será possível "digitalizar" completamente o ator e adicionar uma cópia realista a filmes e jogos.

Mas o que acontecerá com as notícias?

É provável que, nos próximos anos, a geração falsa atinja um novo nível. Existem novas maneiras de lutar. Por exemplo, se você correlacionar uma foto com condições conhecidas na área (velocidade do vento, inclinação das sombras, nível de luz etc.), esses dados ajudarão a identificar uma falsificação.

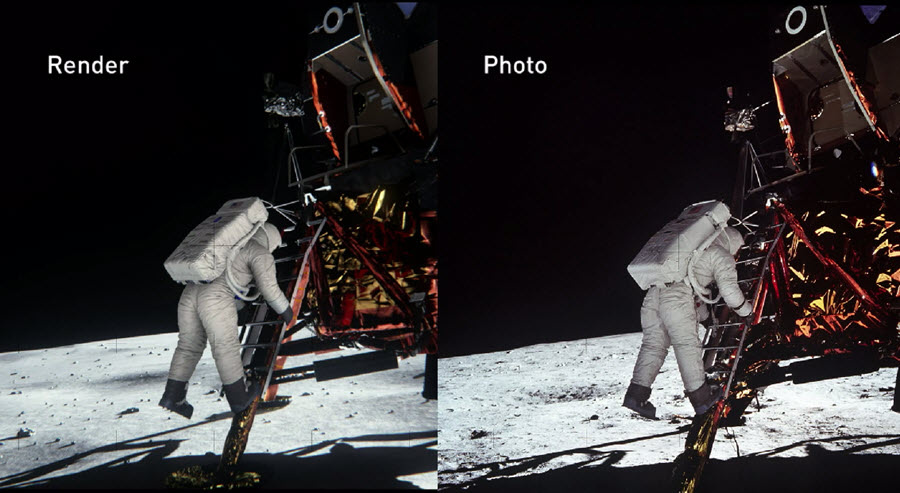

Em 2014, os engenheiros da NVIDIA reconstruíram a cena do pouso na Lua com a maior precisão possível, com base em evidências documentais da época. Nesse caso, todas as propriedades físicas e ópticas dos objetos foram levadas em consideração para descobrir como a luz é refletida em vários materiais e se comporta em tempo real. Como resultado, eles foram capazes de

verificar com

segurança a autenticidade das fotos da NASA.

A NVIDIA confirmou que, com a preparação adequada, pode-se provar a autenticidade (ou refute) até do trabalho fotográfico mais complexo criado décadas atrás.

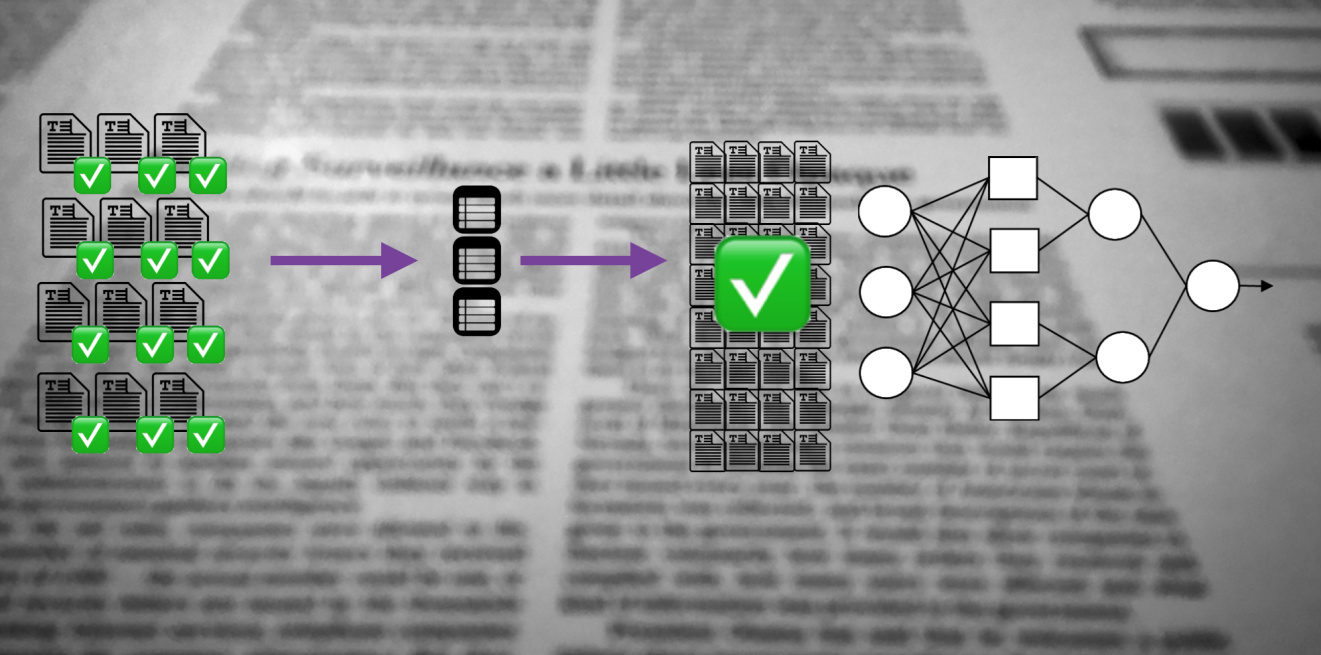

No ano passado, a Agência dos EUA para Pesquisa e Desenvolvimento de Defesa Avançada (DARPA) lançou um projeto de quatro anos para criar um sistema aberto de

Media Forensic que pode identificar fotos que foram processadas ou distorcidas de uma maneira ou de outra.

As redes neurais poderão não apenas alterar o conteúdo original, mas também identificar as falsificações da mais alta qualidade. Quem vencerá nesta corrida tecnológica mostrará o tempo.