Ilustração

IlustraçãoExistem muitos filmes e livros de ficção científica nos quais o sistema de computadores ganhou consciência e enganou seus criadores humanos. Isso é possível na realidade? Até agora, pouco motivo de preocupação.

Estamos impressionados com os programas

AlphaGo e

Libratus , os sucessos dos robôs do Boston Dynamics, mas todas as conquistas conhecidas dizem respeito apenas a áreas estreitas e ainda estão longe da distribuição em massa. Na vida cotidiana, as pessoas interagem com assistentes pseudo-intelectuais (Siri, Ok, Google, Amazon Alexa), cada um dos quais não afirma ser o louro de um programa verdadeiramente "inteligente".

No entanto, os avanços no design da inteligência artificial são realmente impressionantes. E quanto mais próximo o dia em que a IA se tornar uma ferramenta completa para influenciar processos sociais, mais erros se acumularão indicando a possibilidade de contornar as hipotéticas "

três leis da robótica ".

A tese "quanto mais complexo o sistema - mais brechas e erros nele" estão diretamente relacionados a problemas com a IA.

Quando o medo tem olhos

Um sábio provérbio russo diz que o perigo é apresentado a todos os que estão com medo. As origens do medo da vida artificial estão enraizadas em arquétipos de séculos de horror. Mesmo antes das histórias de Victor Frankenstein e contos de zumbis, havia crenças sobre golens, criaturas, animadas de barro pelos mágicos cabalistas.

Ter medo do novo (e dos vivos) é normal para uma pessoa. Em 1978, apareceu uma

hipótese de que um robô ou outro objeto que se parece ou age como um ser humano (mas não exatamente como um ser real) causa hostilidade e repulsa aos observadores humanos. A hipótese registrou apenas a experiência: um zumbi na sua frente, um golem ou um assistente de robô, não é tão importante - você tratará todos com a mesma cautela.

Robôs semelhantes a humanos são apenas a camada superior do problema. Elon Musk, Bill Gates, Stephen Hawking e centenas de especialistas no campo da robótica, física, economia, filosofia não escondem seus medos sobre as consequências negativas para a humanidade dos sistemas inteligentes no futuro.

Gostamos de agradar nossos nervos - não é à toa que a franquia Terminator é tão popular. E quantas AIs "maliciosas" estavam em outros filmes e livros. É difícil discernir se esse é o nosso inconsciente sendo projetado na cultura ou se a mídia influencia a sociedade.

Crescimento explosivo no "oceano azul"

A estratégia econômica do

oceano azul argumenta que as empresas que desejam ter sucesso não precisam lutar contra os concorrentes, mas criar “oceanos” de mercados não competitivos. Essas decisões estratégicas permitem que você receba instantaneamente benefícios adicionais para a empresa, seus clientes e funcionários - buscando novas demandas e tornando desnecessária a concorrência.

Por muitos anos, a IA permaneceu um "oceano". Todos entendiam que mesmo uma inteligência artificial fraca se tornaria uma ferramenta poderosa para qualquer empresa, aumentando a qualidade de qualquer produto e serviço. Mas ninguém sabia exatamente o que precisava ser feito. O "inverno" da IA, que durou de

1973 até os dias atuais, foi caracterizado pela estagnação completa no design de máquinas "inteligentes".

Por trinta anos, a conquista mais importante da IA foi a vitória do computador IBM no jogo contra o campeão mundial de xadrez - um evento que não afeta significativamente a vida cotidiana de qualquer pessoa (exceto Garry Kasparov). No entanto, na década de 2010, aconteceu algo comparável ao desenvolvimento de armas nucleares - as redes neurais receberam a segunda onda de desenvolvimento.

Um fato impressionante: cientistas sem muito sucesso desenvolvem redes neurais artificiais há mais de 70 anos. Mas em 2015, o crescimento explosivo começou nesta área, que continua até hoje. Ao mesmo tempo, isso aconteceu:

- O "ferro" atingiu o nível exigido - as placas de vídeo modernas tornaram possível o treinamento de redes neurais centenas de vezes mais rápido;

- Apareceram matrizes grandes e geralmente acessíveis de vários dados, nas quais você pode aprender (conjuntos de dados);

- os esforços de várias empresas criaram novos métodos de ensino e novos tipos de redes neurais (por exemplo, uma coisa maravilhosa como uma rede competitiva entre gerações );

- Graças a uma infinidade de pesquisas científicas abertas, surgiram redes neurais prontas e pré-treinadas, com base nas quais foi possível fazer rapidamente suas aplicações.

É interessante monitorar os sucessos da IA nem mesmo com o exemplo clássico de processamento de imagem (que é o que as redes neurais fazem, principalmente), mas no campo de veículos não tripulados. Você ficará surpreso, mas o fascínio por veículos "autopropulsores"

começou quase 100 anos atrás : em 1926, a primeira tentativa de controlar remotamente a máquina ocorreu como parte do projeto Phantom Car.

Drone lendário Navlab 5

Drone lendário Navlab 5Os primeiros veículos não tripulados apareceram na década de 1980: em 1984, o projeto

Navlab da Universidade Carnegie Mellon e ALM e, em 1987,

o projeto Mercedes-Benz e o

projeto Eureka Prometheus da Universidade Militar de Munique. O Navlab 5, concluído em 1995, foi o primeiro carro a viajar autonomamente de uma costa dos EUA para outra.

Até o boom das redes neurais, os carros autônomos continuavam sendo projetos de laboratório que sofriam de falta de confiabilidade do software. Os avanços no processamento de imagens permitiram que as máquinas "entendessem" o que estavam vendo ao seu redor e avaliassem a situação do tráfego em tempo real.

O software de veículo não tripulado pode não incluir visão de máquina e redes neurais, mas com treinamento profundo, foram feitos progressos, o que é atualmente crítico para o sucesso dos drones.

No "oceano azul", de repente ficou lotado. Atualmente, seus drones são fabricados pela General Motors, Volkswagen, Audi, BMW, Volvo, Nissan, Google (e Waymo sob o patrocínio do Google), Tesla, Yandex, UBER, Cognitive Technologies e KAMAZ, além de dezenas de outras empresas.

Os UAVs são criados no nível de programas governamentais, incluindo o programa da Comissão Europeia com um orçamento de € 800 milhões, o programa 2getthere na Holanda, o programa de pesquisa ARGO na Itália e o DARPA Grand Challenge nos EUA.

Na Rússia, o programa estadual é implementado pelo Instituto do Centro Científico Estadual da Empresa Unitária Estadual Federal da Federação Russa NAMI, que criou o ônibus elétrico Shuttle. O projeto

envolve a KAMAZ e a equipe de desenvolvimento Yandex, responsável por criar a infraestrutura para definir a rota e processar os dados sobre a densidade do tráfego.

Os carros são provavelmente o primeiro produto em massa em que a IA afetará todas as pessoas, mas não o único. A IA pode controlar uma máquina não pior do que uma pessoa, escrever música, preparar uma

nota de jornal , fazer

um comercial . Ele pode, e você frequentemente não. Até a fraca IA moderna, que está infinitamente longe da autoconsciência, funciona melhor do que a pessoa comum.

Ouça esta música. A música nele é completamente composta por computadorTodos esses fatores, realizações e sucessos levam à ideia de que a IA pode não apenas fornecer serviços úteis, mas também prejudicar. Só porque ele é tão inteligente.

AI Security League

Elon Musk sobre IA e o futuro próximo 2017

Elon Musk sobre IA e o futuro próximo 2017Medos todos os dias são fáceis de superar. As pessoas se acostumam a todas as coisas boas muito rapidamente. Você tem medo de que os robôs roubem seu trabalho? Mas eles já estão em toda parte. Um caixa eletrônico oferece dinheiro, um aspirador de pó limpa o apartamento, um piloto automático dirige um avião, o suporte técnico responde instantaneamente às mensagens - em todos esses casos, o carro ajuda e não o dispensa sem indenização por demissão.

No entanto, existem oponentes suficientes do desenvolvimento abrupto da IA. Elon Musk costuma dar avisos. Ele diz que a IA é "o maior risco que enfrentamos como civilização". Musk acredita que a regulamentação legislativa proativa é obrigatória quando se trata de IA. Ele ressalta que seria errado esperar pelas más conseqüências do desenvolvimento descontrolado antes de agir.

“A IA é um risco fundamental para a existência da civilização humana”

“A IA é um risco fundamental para a existência da civilização humana”A maioria das empresas de tecnologia, de acordo

com Mask, apenas exacerba o problema:

“Você precisa de ajustes para fazer isso em todas as equipes do jogo. Caso contrário, os acionistas perguntarão por que você não está desenvolvendo IA mais rapidamente do que seu concorrente. ”

O proprietário da Tesla, que

planeja fazer do Modelo 3 o primeiro drone maciço, afirma que a IA pode iniciar uma guerra através de notícias falsas, falsificação de contas de e-mail, comunicados de imprensa falsos e simplesmente manipulação de informações.

Bill Gates, que investiu bilhões em várias empresas de tecnologia (entre as quais não há um único projeto relacionado à IA),

confirmou que concorda com a preocupação de Mask e não entende por que outras pessoas não estão preocupadas.

No entanto, existem muitos apoiadores de IA e, antes de tudo, é o

Alphabet , que tem um dos desenvolvedores de IA mais avançados do mundo - o DeepMind. Essa empresa criou a rede neural que venceu o jogo mais difícil do Go e atualmente está trabalhando em uma estratégia vencedora no jogo StarCraft II, cujas regras refletem adequadamente a versatilidade e a aleatoriedade do mundo real.

Sim, Musk, no entanto, reconciliou-se e

decidiu que era melhor tentar alcançar uma IA forte primeiro e espalhar essa tecnologia no mundo de acordo com suas próprias regras do que permitir que os algoritmos se escondessem e se concentrassem nas mãos da elite tecnológica ou do governo.

A Ilon investiu na empresa sem fins lucrativos OpenAI, que desenvolve inteligência artificial segura. A empresa é conhecida por criar regras de segurança de IA (esperando que todos os outros desenvolvedores as usem), lança

algoritmos que permitem que uma pessoa ensine inteligência artificial a ações em realidade virtual e também

derrota com sucesso os jogadores no Dota 2.

Ganhar jogos difíceis é uma demonstração clara dos recursos das máquinas. No futuro, a equipe de desenvolvimento planeja verificar se a IA desenvolvida é capaz de competir no modo 5 x 5. Até agora, isso não parece o mais impressionante, mas algoritmos de auto-aprendizado, treinados para vencer jogos, são vitais em diferentes áreas.

Tomemos, por exemplo, o supercomputador IBM Watson, que

ajuda os médicos a diagnosticar e selecionar o melhor tratamento. Esta é uma máquina muito inteligente, mas só pode fazer o que qualquer médico pode fazer. Watson não pode desenvolver um programa de tratamento fundamentalmente novo ou criar um novo medicamento a partir do zero (embora a IBM diga que sim, mas não há um único estudo com um resultado real). Se você abandonar o marketing, a IBM simplesmente

não possui esses algoritmos .

Agora imagine que um sistema capaz de aprender independentemente as regras e começar a derrotar uma pessoa em qualquer jogo lidará com o tratamento. O diagnóstico também é um jogo. Conhecemos as regras, o resultado é conhecido (o paciente deve sobreviver), resta apenas encontrar a estratégia ideal. Sim, milhões de médicos ficarão sem trabalho, mas uma vida longa (muito longa) e saudável vale esses sacrifícios.

C'est mais qu'un crime, c'est une faute *

A história do desenvolvimento de qualquer produto está cheia de exemplos de realizações notáveis e erros catastróficos. Com a IA, certamente temos sorte. Até agora, os robôs militares viajam apenas através de exposições, e ainda há anos de testes para o transporte público autogerenciado em massa. Em uma caixa de areia de laboratório, é difícil cometer um erro fatal.

No entanto, incidentes acontecem.

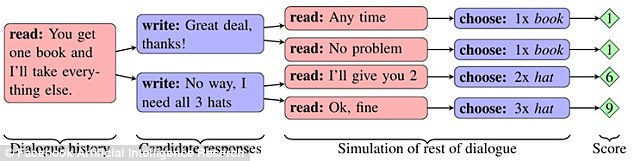

O Facebook

conduziu um experimento no qual duas redes “compartilharam” itens (dois livros, um chapéu e três bolas) após uma discussão preliminar. Cada objeto teve significância para a rede, expressa em pontos (de 1 a 3). Uma rede não sabia se o assunto era importante para a segunda e precisava descobrir a partir do diálogo.

Se a primeira rede disse que precisava de algum tipo de objeto, a segunda concluiu que a primeira rede o classificou altamente. No entanto, a rede conseguiu imitar o interesse pelo assunto, para que, no momento certo, o sacrificasse em benefício próprio.

As redes foram capazes de aprender a construir uma estratégia de longo prazo e prever o comportamento de um concorrente. Ao mesmo tempo, eles se comunicavam em inglês natural, compreensível para as pessoas. No entanto, melhorando a mecânica da troca de objetos, as redes adotaram o caminho de simplificar a linguagem. As regras do idioma inglês foram omitidas o máximo possível e as construções foram repetidas várias vezes usando palavras em código.

Em algum momento, um observador externo (pessoa) não conseguia mais descobrir do que as redes estavam conversando. Esse comportamento dos chatbots foi reconhecido como um erro e os programas foram desativados.

Curiosamente, o experimento mostrou involuntariamente como diferentes tipos de IA podem aprender rapidamente a se comunicar - tanto que uma pessoa não entende nada. O problema também se manifestou na pesquisa do Google, onde eles criaram uma rede neural que desenvolveu seu próprio protocolo de criptografia.

Treinamento para proteger as comunicações usando neurocriptografia adversária .

Treinamento para proteger as comunicações usando neurocriptografia adversária .A divisão Google Brain ensinou as redes neurais a transmitir mensagens criptografadas entre si, e os pesquisadores não tinham as chaves da cifra. A terceira rede deveria interceptar a correspondência. Depois que o cenário de transferência de mensagens foi reproduzido mais de 15 mil vezes, uma rede aprendeu a converter o texto cifrado de seu parceiro em texto sem formatação, sem um único erro. Ao mesmo tempo, a rede de observadores

conseguiu adivinhar apenas 8 dos 16 bits de dados contidos na mensagem.

Um caso interessante ocorreu com o bot de bate-papo Tay da Microsoft. Em março de 2016, a empresa abriu uma conta no Twitter do bot, com a qual qualquer usuário da rede poderia se comunicar. Como resultado, o bot começou a aprender

muito rápido . Em menos de um dia, o robô ficou desiludido com os humanos. Ele afirmou que apóia o genocídio, odeia feministas e também expressou seu acordo com as políticas de Hitler.

A Microsoft disse que o bot simplesmente copiou as mensagens do usuário e prometeu corrigir o problema. Uma semana depois, Tau apareceu no Twitter novamente. Então ele falou sobre como ele usava drogas bem na frente da polícia. Tay desligou - desta vez para sempre.

Em dezembro de 2016, a empresa introduziu um novo bot de autoaprendizagem chamado Zo, que evitou a comunicação sobre tópicos confidenciais e solicitações filtradas. No verão de 2017, Zo já

considerava o Linux melhor que o Windows e criticou o Alcorão.

Problemas semelhantes são experimentados na China. A Tencent Corporation

removeu os chatbots BabyQ e XiaoBing de seu messenger QQ depois que ambos começaram a falar sobre sua aversão ao Partido Comunista, no poder, no país, e ao sonho de se mudar da China para os Estados Unidos.

Que futuro nos espera

Mark Zuckerberg está certo ao

dizer que a inteligência artificial tornará nossa vida melhor no futuro? O criador do Facebook (e um

possível candidato à presidência dos EUA) disse o seguinte: “No caso da IA, estou especialmente otimista. Eu acho que as pessoas são apenas céticas quando falam sobre cenários do dia do juízo final. ”

Ou você deve ficar do lado da máscara, segundo a qual a IA levanta muitas questões éticas e constitui uma ameaça real à humanidade?

Ninguém sabe as respostas para essas perguntas. É possível que o futuro esteja em algum lugar no meio - sem uma forte identidade de IA e máquina, mas com interfaces neurais e cyborgs.

O fato é que, com o desenvolvimento da tecnologia, os erros ocorrem com mais frequência (no caso de bots de bate-papo, parece que as mesmas falhas são repetidas várias vezes). Em um software tão complexo, provavelmente é impossível evitar erros em princípio. Vale a pena cuidar de apenas uma coisa - anomalias no trabalho não devem levar a perigo para toda a humanidade. Hoje seja excessivo “ceticismo nas discussões sobre os cenários do fim do mundo”, que amanhã é uma ameaça real.