Os sistemas de Inteligência Artificial (IA) estão ganhando terreno. Nesse sentido, advogados e legisladores discutem o problema de como esses sistemas devem ser regulamentados, quem será responsável por suas ações. Esse problema requer um estudo cuidadoso e uma abordagem equilibrada, porque os sistemas de IA são capazes de gerar grandes quantidades de dados e são usados em aplicações de diferentes funcionalidades - de sistemas médicos e pilotos automáticos em carros a previsão de crimes e cálculo de possíveis criminosos. Ao mesmo tempo, os cientistas estão se esforçando para criar uma "IA forte" capaz de raciocinar, e surge a questão de como determinar a presença de intenção em suas ações - ou reconhecer ações como não intencionais.

Existem muitas maneiras de levar o sistema de IA à responsabilização e responsabilidade; vários estudos foram publicados sobre esse tópico. Em um novo

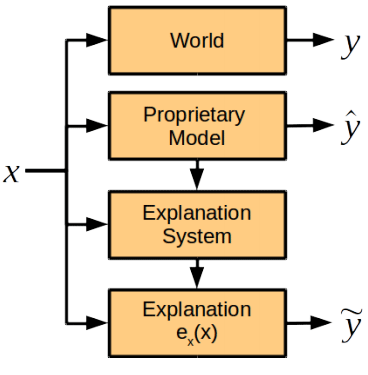

trabalho de pesquisa , especialistas em ciência da computação e advogados das universidades de Harvard e Cambridge (EUA) discutem um componente do futuro sistema de responsabilização da IA, a saber, o papel de uma nota explicativa da AI, ou seja, uma avaliação de como o sistema de inteligência artificial explica suas ações . Os cientistas chegaram à conclusão de que o módulo para explicar ações deve ser separado do sistema geral de IA.

Os autores do trabalho científico descrevem todos os problemas que surgem ao tentar solicitar ao sistema de IA uma explicação de suas ações.

Em primeiro lugar, essa oportunidade deve ser fornecida no estágio de desenvolvimento do sistema, caso contrário, a IA pode recusar ou não será capaz de explicar suas ações.

Em segundo lugar, o sistema de IA processa uma grande variedade de dados usando algoritmos ou métodos proprietários complexos que ele próprio desenvolveu no processo de aprendizado. Assim, ao tentar explicar suas ações da maneira mais completa, ela pode gerar muitos dados que são incompreensíveis para uma pessoa. Ou - como o outro extremo - fornecerá um modelo simplista demais que não refletirá as reais intenções da IA e os motivos das ações. Além disso, os algoritmos de operação do sistema de IA podem ser de propriedade intelectual da empresa em desenvolvimento, por isso é necessário fornecer esse método de compilação de uma nota explicativa para estabelecer as causas do sistema, mas não para fornecer os algoritmos subjacentes.

Os pesquisadores acreditam que uma explicação é possível sem revelar os algoritmos e as regras subjacentes ao funcionamento do sistema de IA. No caso de um incidente, o sistema deve fornecer respostas para as seguintes perguntas:

- Quais são os principais fatores que influenciam a decisão?

- Uma mudança em um determinado fator levaria a uma mudança na decisão?

- Por que dois casos semelhantes levaram a soluções diferentes?

As respostas a essas perguntas não exigem necessariamente a divulgação de segredos de propriedade e algoritmos internos do sistema, mas, ao mesmo tempo, proporcionarão uma compreensão clara de seus motivos.

Os cientistas argumentam em quais casos é apropriado exigir que a IA explique suas ações. De fato, isso é necessário nos casos em que o benefício da explicação supera o preço de seu recebimento: “Acreditamos que existem três condições para situações em que a empresa considera necessário obter uma explicação do tomador de decisão. Essas são razões morais, sociais ou legais ”, explica Finale Doshi-Velez, principal autor do artigo.

Ao mesmo tempo, não se deve exigir explicações da IA literalmente em todas as situações. Como mencionado acima, isso aumenta os riscos de emitir segredos comerciais e impõe um ônus adicional aos desenvolvedores de sistemas de IA. Em outras palavras, a constante responsabilização da IA pelos seres humanos inibirá o desenvolvimento desses sistemas, inclusive em áreas importantes para os seres humanos.

Em contraste com a crença generalizada de que o sistema de IA é uma caixa preta, cujas causas são incompreensíveis para os seres humanos, os autores do trabalho científico têm certeza de que um módulo normalmente funcional para explicar as ações da IA pode ser desenvolvido. Este módulo será integrado ao sistema, mas funcionará independentemente dos algoritmos de tomada de decisão e não os obedecerá.

Os cientistas acreditam que existem alguns pontos na explicação de ações que são fáceis para as pessoas definirem e difíceis para as máquinas e vice-versa.

Comparação de habilidades humanas e IA para explicar | Homem | AI |

|---|

| Os benefícios | Pode explicar o ato posterior | Reprodutibilidade, falta de pressão social |

| Desvantagens | Pode ser impreciso e não confiável, sente pressão social | Requer programação preliminar do módulo de explicação, taxonomias adicionais e expansão do sistema de armazenamento |

No entanto, o grupo de especialistas recomenda, a princípio, estabelecer o mesmo padrão para os sistemas de IA para explicar suas ações atualmente definidas para as pessoas (esse padrão é explicado na lei dos EUA: em particular, é necessária uma explicação em casos de responsabilidade estrita, divórcio e discriminação, por tomar decisões administrativas e de juízes e júris para explicar suas decisões - embora o nível de detalhe da nota explicativa seja muito diferente em cada caso).

Mas se as razões das ações da IA vão além da compreensão do homem, para explicar a IA no futuro, outro padrão pode ser desenvolvido para suas notas explicativas, dizem os cientistas.

O artigo científico foi

publicado em 3 de novembro de 2017 no site de pré-impressão arXiv.org (arXiv: 1711.01134v1).