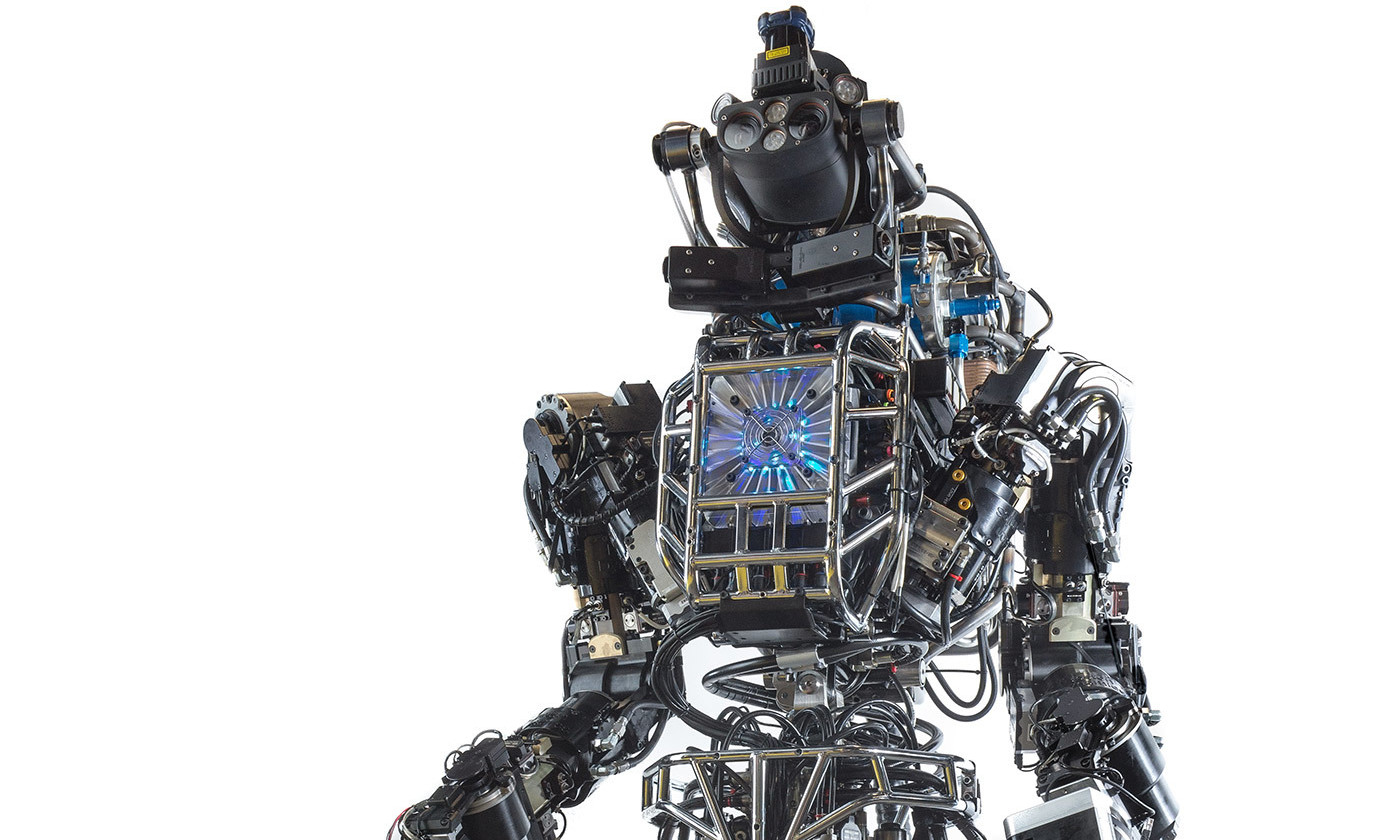

Armas autônomas - robôs assassinos que podem atacar sem intervenção humana - essa é uma ferramenta muito perigosa. Não há dúvida sobre isso. Conforme declarado em sua

carta aberta à ONU, Ilon Musk, que assinou com ele Mustava Suleiman [

co-fundador da empresa de IA DeepMind / aprox. perev. ] e outros autores, armas autônomas podem se tornar "armas de intimidação, armas que tiranos e terroristas podem usar contra uma população inocente, armas que podem ser hackeadas e feitas para funcionar de maneira indesejável".

Mas isso não significa que a ONU deva introduzir uma proibição preventiva de pesquisas adicionais dessas armas, como os autores da carta pedem.

Em primeiro lugar, são necessárias ferramentas perigosas para alcançar objetivos dignos. Lembre-se do

genocídio em Ruanda quando o mundo parou e não fez nada. Se existissem armas autônomas em 1994, talvez não olássemos para o lado. Parece provável que, se o custo das intervenções humanitárias apenas pudesse ser medido com dinheiro, seria mais fácil obter apoio público para tais intervenções.

Em segundo lugar, é ingênuo acreditar que podemos usufruir dos benefícios de avanços recentes na IA sem precisar experimentar algumas de suas deficiências. Suponha que a ONU introduza uma proibição preventiva de qualquer tecnologia de armas autônomas. Também assumimos - já bastante otimistas - que todos os exércitos do mundo respeitarão essa proibição e cancelarão o desenvolvimento de programas de armas autônomos. E mesmo assim, ainda precisamos nos preocupar com isso. Um robomóvel pode ser facilmente transformado em um sistema de armas autônomo: em vez de andar por pedestres, você pode ensiná-lo a movê-los.

De um modo geral, as tecnologias de IA são extremamente úteis e já estão penetrando em nossas vidas, mesmo que às vezes não vejamos isso e não possamos realizá-lo completamente. Dada essa penetração, seria míope pensar que o abuso de tecnologia poderia ser proibido simplesmente proibindo o desenvolvimento de armas autônomas. Talvez sejam precisamente os sistemas de armas autônomas sofisticados e com funcionamento seletivo desenvolvidos por vários exércitos ao redor do mundo que podem efetivamente combater as armas autônomas mais difíceis que são fáceis de desenvolver, reprogramando a tecnologia AI aparentemente pacífica, como os mesmos robomobiles.

Além disso, a idéia de uma proibição simples em nível internacional oferece uma abordagem simplificada à consideração de armas autônomas. Tal conceito não reconhece a longa história das causas e efeitos de ações e acordos de diferentes países entre si e sozinhos, os quais, através de milhares de pequenas ações e omissões, levaram ao desenvolvimento de tais tecnologias. Enquanto o debate sobre armas autônomas é conduzido principalmente no nível da ONU, o cidadão, soldado ou programador médio pode ser perdoado por não assumir obrigações morais pelos danos causados por armas autônomas. Mas essa é uma suposição muito perigosa, que pode levar ao desastre.

Todas as pessoas que estão de alguma forma relacionadas às tecnologias de armas automáticas devem exercer a devida diligência, e cada um de nós deve pensar cuidadosamente sobre a contribuição de sua ação ou inação na lista de perigos potenciais dessa tecnologia. Isso não significa que países e agências internacionais não tenham seu papel importante. Isso é enfatizado pelo fato de que, se queremos eliminar o perigo potencial de armas automáticas, é necessário promover a ética da responsabilidade pessoal, e essa propaganda deve atingir os níveis mais baixos em que as decisões são tomadas. Para começar, é extremamente importante falar detalhadamente e completamente sobre o desenvolvimento de armas autônomas - incluindo as conseqüências das ações de todos aqueles que tomam decisões em todos os níveis.

Finalmente, às vezes se argumenta que uma arma autônoma é perigosa não porque essa ferramenta é perigosa em si mesma, mas porque pode se tornar independente e começar a agir em seus próprios interesses. Este é um erro equivocado e, além disso, a proibição do desenvolvimento de armas autônomas não ajudará a evitar esse perigo. Se a superinteligência é uma ameaça para a humanidade, precisamos urgentemente procurar maneiras de efetivamente combater essa ameaça e fazê-lo independentemente de a tecnologia de armas automáticas ser mais desenvolvida.

Carta aberta à Convenção das Nações Unidas sobre Certas Armas Convencionais

Como algumas empresas criam tecnologias relacionadas à inteligência artificial e robótica que podem ser redirecionadas para o desenvolvimento de armas autônomas, sentimos uma responsabilidade especial por disparar esse alarme. Saudamos calorosamente a decisão da conferência da ONU sobre a adoção da "Convenção sobre tipos específicos de armas convencionais" sobre a nomeação de um

grupo de especialistas governamentais (Grupo de Peritos Governamentais, GGE) em sistemas de armas autônomos letais. Muitos de nossos pesquisadores e engenheiros estão prontos para fornecer conselhos tecnológicos para ajudar com esse problema.

Saudamos a nomeação do Embaixador Amandip Singh Gill da Índia como Presidente do GGE. Pedimos às Altas Partes Contratantes que participam do GGE que trabalhem ativamente para encontrar maneiras de impedir esse tipo de corrida armamentista, proteger os cidadãos de seu uso indevido e evitar os efeitos desestabilizadores dessas tecnologias. Lamentamos que a primeira reunião do GGE, prevista para agosto de 2017, tenha sido cancelada devido ao fato de alguns países não terem contribuído financeiramente para a ONU. Instamos as Altas Partes Contratantes a redobrar seus esforços na primeira reunião do GGE a ser realizada em novembro.

Armas autônomas detalhadas ameaçam provocar uma terceira revolução nos assuntos militares. Após seu desenvolvimento, possibilitará a condução de conflitos militares em uma escala sem precedentes, e em períodos mais curtos do que aquilo que uma pessoa pode perceber. Pode se tornar uma arma de intimidação, uma arma que tiranos e terroristas podem usar contra uma população inocente, uma arma que pode ser hackeada e obrigada a funcionar de maneira indesejável. Ainda temos pouco tempo. Depois de abrir a caixa desta Pandora, será difícil fechá-la. Portanto, pedimos às Altas Partes Contratantes que encontrem maneiras de nos proteger contra essas ameaças.