Novos sistemas de imagem, microscópios e matrizes de vídeo geram imagens digitais com base em cálculos de computador, em vez de lentes tradicionais.

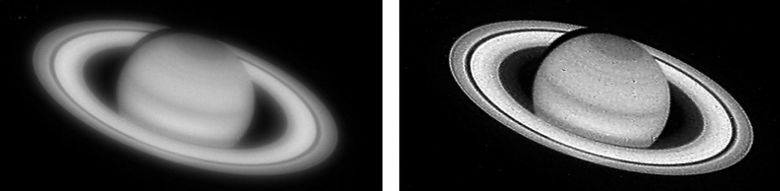

Até artesãos medievais foram capazes de criar lentes de vidro e espelhos curvos para projetar imagens. Tais projetos foram usados para fabricar microscópios, câmeras pinhole, telescópios e outros instrumentos que nos permitem ver melhor objetos muito pequenos e grandes localizados longe e nas proximidades, na Terra e no céu. A próxima revolução na formação da imagem ocorreu em meados do século XIX: a fotografia foi inventada. Agora você pode capturar "momentos parados", reproduzi-los e replicar. Hoje, a era da fotografia química está chegando ao fim, uma nova era está florescendo - a imagem digital. Suas raízes estão na tecnologia da televisão, mas consideraremos o início da era de 1975, quando a primeira câmera digital aparecer. Hoje, bilhões de webcams e câmeras em telefones celulares em todo o mundo capturam mais de um trilhão de imagens por ano, e muitas delas são imediatamente enviadas para a Internet. Apesar do aumento explosivo no número, variedade e maneiras de usar sistemas de imagem, as tarefas dos engenheiros ópticos permanecem praticamente inalteradas: criar uma imagem ótica de alta qualidade que transmita com precisão a cena a ser "feita para parecer boa".

No entanto, nos últimos 10 a 20 anos, um novo paradigma começou a surgir: imagens computacionais. Esse paradigma pode não suplantar completamente as abordagens tradicionais, mas lançará dúvidas sobre idéias seculares e ajudará a criar métodos alternativos para projetar sistemas de imagem. Por exemplo, novas funções e formas de sistemas de imagem já estão disponíveis para nós, incluindo dispositivos super miniatura para fotografar objetos macroscópicos e microscópios sem lentes.

Como o nome indica, a computação desempenha um papel fundamental na formação da imagem digital final. Por um longo tempo, eles melhoraram com a ajuda do processamento de imagem digital: removeram o efeito de olhos vermelhos ao fotografar com o flash, ajustaram as cores etc., mas os circuitos ópticos das lentes nunca foram projetados levando em consideração essas necessidades. No entanto, o processamento do sinal digital permite, por exemplo, corrigir distorções ópticas, como "travesseiros" ou distorções de grande angular nas bordas da imagem. Quando o Telescópio Orbital Hubble enviou as primeiras imagens para a Terra no final dos anos 80, elas eram muito mais "ensaboadas" do que o esperado. Logo ficou claro que havia alguns problemas com a ótica. Os cientistas da NASA determinaram qual era o problema e, até o reparo do telescópio, eles corrigiram muitos defeitos por vários anos usando sofisticados algoritmos de processamento digital.

Em meados dos anos 90, Wade Thomas Cathey e Edward R. Dowski, Jr., tiveram a idéia de projetar lentes para produzir imagens embaçadas e "degradadas", mas degradadas de tal maneira que Os algoritmos de processamento digital tornaram possível que as imagens não fossem piores ou melhores ainda com as lentes tradicionais. Em particular, Katie e Dowsky se voltaram para o recurso característico de todas as câmeras tradicionais: profundidade de campo limitada. Se você se concentrar em um objeto a uma distância média de você, ele parecerá nítido, mas os objetos mais próximos e mais distantes ficarão embaçados. A profundidade de campo refere-se à área dentro da qual todos os objetos parecem razoavelmente nítidos. Então, dois cientistas criaram uma nova lente, que quase tanto turva as imagens ópticas dos objetos a todas as distâncias. E então um algoritmo especial aprimorou a imagem inteira, obtendo uma profundidade de campo inatingível para lentes comuns. Embora muitos cientistas tenham melhorado ainda mais a técnica descrita, a idéia de Katie e Dowsky avançou muito na disciplina de captura computacional e formação de imagens.

Outra conseqüência desse trabalho científico foi que agora estão sendo desenvolvidos circuitos ópticos para lentes com base na criação de imagens para computadores, não para pessoas. É paradoxal que, em nossa era de filmagem total, muito poucas pessoas tenham visto imagens ópticas reais formadas por câmeras. Os dias se passaram quando o fotógrafo, inclinando-se para a câmera e se cobrindo com uma capa grossa, puxou o obturador e, antes de inserir a fita com o filme, viu no vidro fosco uma imagem "ao vivo" diretamente formada pela lente. Hoje, vemos nas telas o resultado do processamento digital de imagens ópticas que caíram nas matrizes de silício.

A próxima área de aplicação para a combinação de óptica e processamento digital foi a simplificação do design da lente. No seu smartphone, uma lente de câmera pode consistir em 7-8 elementos ópticos, e as lentes de câmera profissionais às vezes consistem em mais de 15 elementos ópticos. É necessário um grande número de lentes para corrigir defeitos de imagem - aberrações inerentes a qualquer sistema óptico: cromático (cores fantasma ao redor dos objetos) e óptico (distorção da forma e proporções dos objetos). Ou seja, são necessários designs complexos de lentes para produzir imagens "bonitas". A combinação de óptica e processamento digital ajudará a mudar parte do trabalho para corrigir aberrações para um componente digital, o que permitirá que você abandone alguns elementos ópticos sem comprometer a qualidade da imagem digital final. Ou seja, algoritmos de processamento desempenham o papel de elementos ópticos virtuais. Essa abordagem tornou possível criar sistemas ópticos mais compactos e baratos, sem perda de qualidade.

Até que ponto essas idéias serão desenvolvidas? Que proporção da tarefa de criação de imagens pode ser transferida da óptica para um componente digital? Quão simples pode ser um circuito óptico para obter uma imagem decente? É realista livrar-se de lentes e espelhos? Isso foi alcançado nos últimos anos de três maneiras - as lentes e as imagens ópticas que formam são completamente excluídas. Os métodos são baseados na difração, reconstrução da fase óptica e na técnica de sensoriamento compressivo. E para obter a imagem final adequada para as pessoas, cálculos de computador são usados ativamente.

As lentes tradicionais focam um feixe de luz usando refração : a luz é refratada ao passar através de um limite de mídia (vidro de ar) em diferentes velocidades da luz. Graças ao efeito de refração, um lápis imerso em um copo de água com água parece estar curvado: a luz refletida no lápis é refratada quando entra no ar ao longo do caminho até os olhos. Portanto, a parte subaquática do lápis que vemos não está onde realmente está.

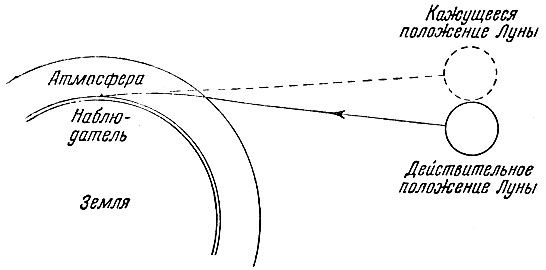

A propósito, graças à refração (refração) na fronteira do espaço e à atmosfera da Terra, todos os objetos celestes parecem estar localizados um pouco acima da sua localização real:

Espelhos curvos, como os usados em grandes telescópios, formam uma imagem diferente: usando reflexão . Para entender a diferença entre refração e reflexão, imagine luz na forma de raios (linhas).

Dois outros fenômenos físicos ajudarão a mudar a direção da propagação da luz e usar sua natureza ondulatória (lembre -se da dualidade onda-partícula ): difração e interferência . Quando duas ondas coerentes de luz se encontram, elas se sobrepõem, a amplitude resultante da onda aparece. Se o máximo de uma onda sempre coincide com o máximo da outra, então as ondas se reforçam, isso é chamado de interferência construtiva . Se o máximo de uma onda sempre coincide com o mínimo da outra, as ondas se cancelam - isso é interferência destrutiva , como resultado da qual a luz pode desaparecer completamente.

Você pode controlar a luz através da difração direcionando-a para a grade de difração - uma série dos melhores traços (rasters) - em uma superfície lisa. Como ondas de comprimentos diferentes são refletidas em diferentes direções, ocorrem manchas de cor. Por exemplo, quando a luz branca é refletida a partir de pequenas ranhuras na superfície de um CD ou DVD, vemos faixas de arco-íris. Devido à dependência do comprimento de onda da varredura, é impossível criar uma grade de difração que simplesmente substitua as lentes. Uma imagem óptica formada por uma grade nunca será tão boa quanto uma imagem de uma lente bem projetada. No entanto, é bem possível criar imagens digitais aceitáveis usando uma combinação de óptica de difração (usando difração) e processamento de sinal correspondente (levando em consideração a óptica).

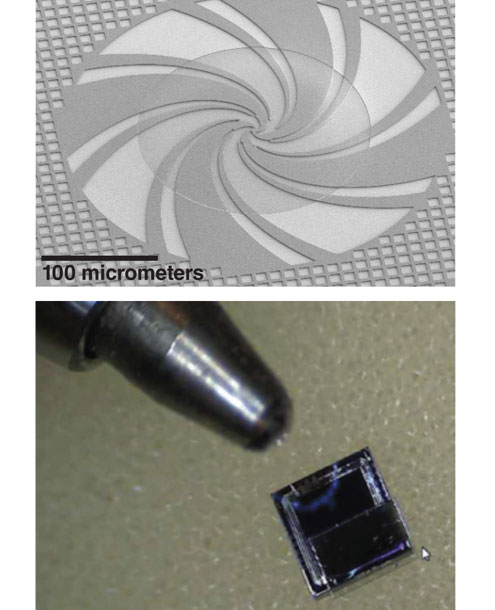

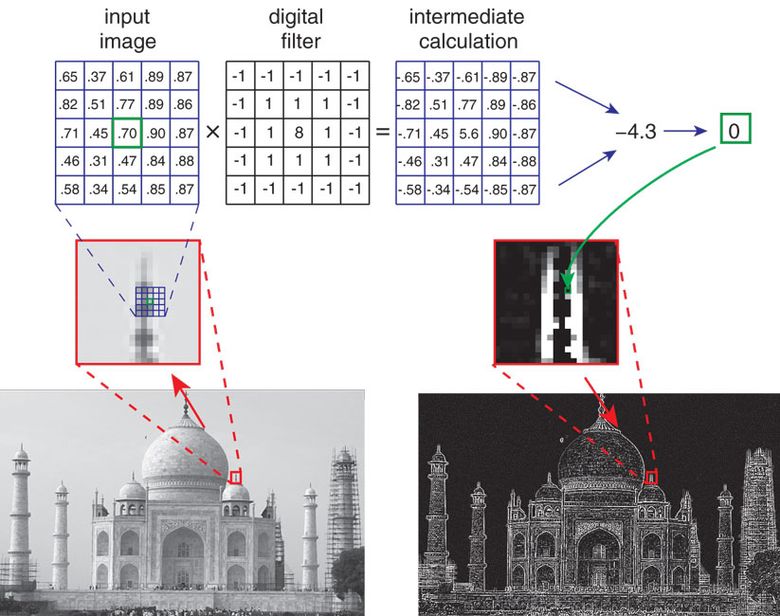

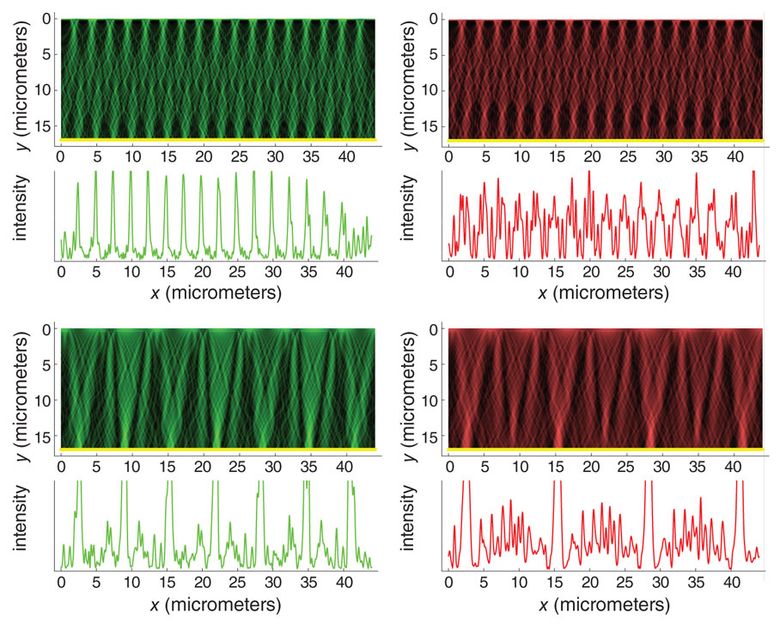

Em uma das classes de dispositivos não objetivos para filmagem macroscópica, são utilizadas grades de difração em miniatura, localizadas gradualmente na espessura de um material transparente (vidro ou silicato) e atrasando uma parte da luz incidente em relação à outra parte. As propriedades matemáticas do esquema escalonado são tais que a distribuição de luz no material depende fracamente do comprimento de onda e, portanto, de uma ligeira variação na espessura do próprio vidro, o que inevitavelmente ocorre durante a fabricação. As redes são conectadas a um sensor fotossensível - como a matriz nas câmeras digitais convencionais. A luz incidente passa pelas grades e atinge a matriz, que já foi decomposta especialmente em "componentes". Não parece uma imagem comum: uma espécie de nuvem embaçada, incompreensível aos olhos humanos. No entanto, essa nuvem contém informações visuais suficientes (embora distribuídas de maneira incomum) para recriar a imagem desejada usando um processo computacional chamado convolução de imagem.

O algoritmo de reconstrução da imagem é um pouco sensível ao ruído visual, por exemplo, flutuações aleatórias no número de fótons ou ruído elétrico durante a conversão do sinal do sensor em uma representação numérica (o chamado erro de quantização). Portanto, a imagem pode ter um ruído visual. Embora essa qualidade seja suficiente para várias tarefas simples (por exemplo, para contar o número de pessoas em um quadro), no entanto, para uma imagem mais decente, você precisa capturar mais informações sobre a cena que está sendo filmada. A solução "na testa" é levar várias grades de fase em miniatura projetadas para capturar várias informações sobre a cena. Ou seja, cada treliça forma uma imagem digital componente, esses componentes podem ser processados e uma imagem melhor pode ser obtida.

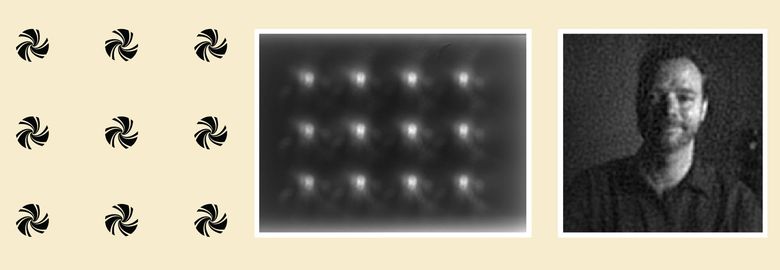

Um tipo de sistema de imagem sem lente usa matrizes que dispersam a luz, em vez de focalizá-la como lentes. No exemplo acima, uma matriz de 12 redes de fase binária (esquerda) é projetada para capturar o máximo de informação visual possível sobre a cena. Depois que a luz passa pela matriz, são obtidos 12 pontos borrados, nenhum dos quais permite que uma pessoa entenda o que é filmado aqui (no centro). No entanto, esta imagem óptica contém informações suficientes para obter um retrato completamente legível (à direita) usando o processamento digital chamado "convolução da imagem".

Essa abordagem ajudará não apenas a formar a imagem da cena, mas também a analisá-la: para determinar as propriedades visuais (por exemplo, se há um rosto humano na foto), a direção e a velocidade do movimento geral da cena ( fluxo visual, fluxo visual), calcular o número de pessoas na cena. dentro de casa. Em tais situações, as grades de difração são projetadas para extrair as informações necessárias e o algoritmo de processamento é adaptado a uma tarefa específica. Por exemplo, se precisamos ler um código de barras vertical, usamos uma grade de difração vertical e um algoritmo que leva cada pixel de uma imagem digital a um valor limite: a luz é convertida em escuro, o escuro em preto. O resultado é uma imagem digital em preto e branco e já pode ser reconhecida pelo algoritmo de leitura de código de barras.

Microscopia de reconstrução de fase

A abordagem para criar microscópios tendenciosos difere dos métodos para criar câmeras computacionais para objetos macro, embora o fenômeno de difração também seja usado aqui. No entanto, diferentemente de um dispositivo que fotografa uma cena com iluminação comum criada pelo Sol ou lâmpadas, somente radiação laser coerente ou luz monocromática de uma ou várias fontes podem ser selecionadas para iluminação em microscopia. Isso permite controlar a difração e a interferência da luz. Além disso, os objetos de interesse para nós são tão pequenos que a difração ocorre quando a luz passa através dos próprios objetos, e não através de uma grade de difração artificial.

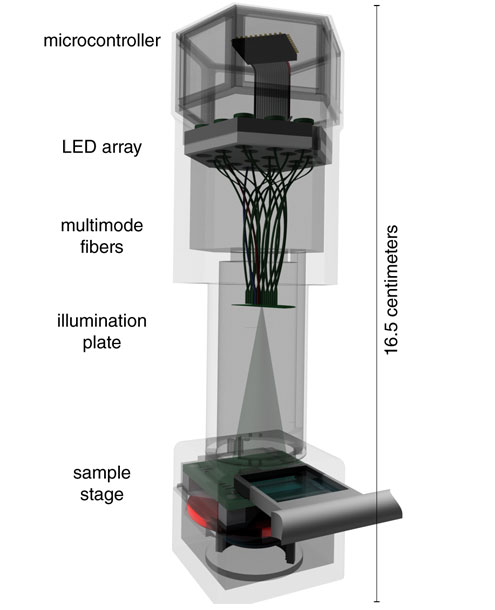

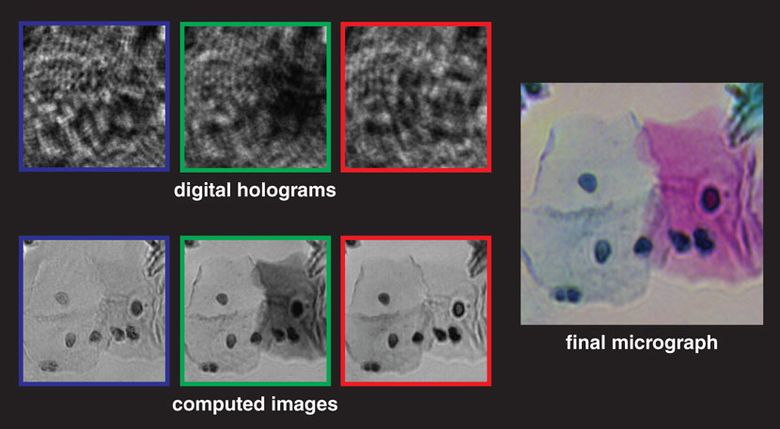

O esquema de tal microscópio implica que a amostra seja colocada em cima de uma matriz fotossensível com um grande número de pequenos pixels: uma matriz de 10 megapixels, por exemplo, frequentemente encontrada em câmeras digitais. Esse esquema também é chamado de "microscópio no chip" porque a amostra é colocada diretamente na matriz de formação de imagem. A luz de um laser ou de um LED de cor espectralmente pura é incidente na amostra e dispersa nos objetos que estão sendo disparados. As ondas de difração resultantes - formando o feixe de objeto ( feixe de objeto) - são sobrepostas à iluminação que passa pela amostra sem distorção - o feixe de referência (feixe de referência). O resultado é um padrão de interferência complexo registrado por uma matriz fotossensível e usado na holografia digital em linha. A imagem bruta lembra vagamente as sombras microscópicas da amostra e, em alguns casos, é suficiente para calcular aproximadamente o número e a localização dos objetos. Mas a imagem holográfica bruta é muito enlameada, barulhenta, contém "artefatos em anel" e não permite determinar a morfologia dos objetos. A imagem está ruim.

O padrão de interferência passa por vários estágios do processamento digital, o estágio principal é o algoritmo de reconstrução de fase. Nele, usando a física da interferência óptica, são tiradas conclusões sobre a estrutura e a localização dos objetos na amostra. Em resumo: o algoritmo procura informações ópticas sobre a fase perdida no holograma na matriz (que registra apenas o padrão de interferência, e não as fases dos próprios raios de luz individuais). O algoritmo calcula iterativamente as informações de fase no feixe do objeto, o que provavelmente levou ao aparecimento de um padrão de interferência óptica. Quando as informações sobre a fase no feixe de objeto são determinadas, o algoritmo calcula sua mudança no tempo para criar uma imagem dos objetos, formando a imagem digital final.

Assim como nos dispositivos macro, a resolução é aumentada capturando várias imagens ópticas, cada uma das quais contém informações ligeiramente diferentes. Por exemplo, antes de registrar cada quadro, você pode mudar ligeiramente a fonte de luz ou a própria amostra ou a matriz. Em seguida, os quadros são processados e combinados para obter uma imagem de interferência de maior resolução (que ainda é incompreensível para os seres humanos) e, em seguida, são executadas as fases de restauração de fase e restauração temporária.

Microscópios objetivos em um chip têm várias vantagens.

Em primeiro lugar, a área de filmagem da amostra (isto é, o campo de visão) pode ser extremamente grande, limitada apenas pelo tamanho da matriz fotossensível na qual a amostra é colocada. As matrizes modernas permitem fornecer um campo de visão de 20 milímetros quadrados a 20 centímetros quadrados.

Em segundo lugar, mesmo objetos transparentes (por exemplo, a maioria das bactérias em uma camada de água) podem ser estudados com microscópios objetivos se eles mudarem a fase da luz que passa por eles. Os microscópios ópticos objetivos especiais também permitem o estudo desses "objetos de fase", embora com um campo de visão muito menor e o tamanho total da amostra.

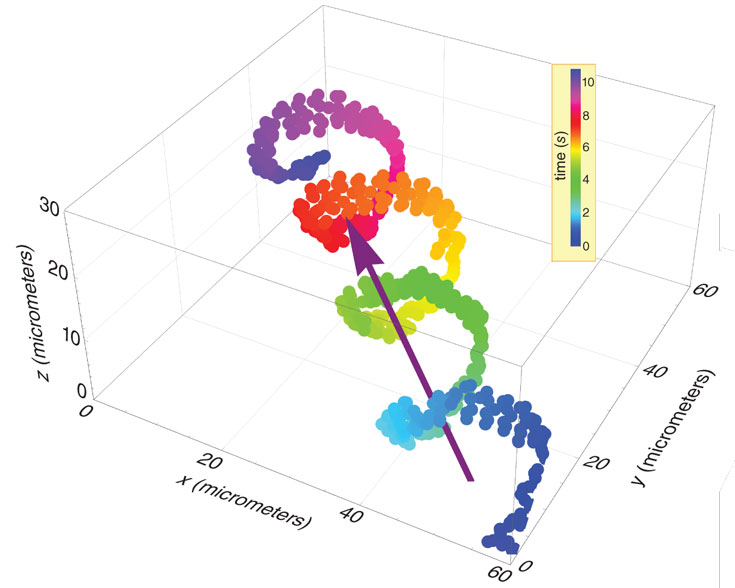

Em terceiro lugar, o processamento digital da imagem óptica permite isolar diferentes tipos de células (por exemplo, esperma ou células sanguíneas nos capilares) e rastrear seus movimentos. Graças a isso, médicos e biólogos podem obter dados importantes.

Quarto, esses microscópios são muito mais baratos e mais compactos que os tradicionais. Os microscópios sem objetivo podem ser conectados a um telefone celular usado em áreas rurais e os dados digitais podem ser transferidos para qualquer lugar para uma análise mais aprofundada.

Técnica de detecção compressiva

A terceira abordagem para a formação de imagens tendenciosas é baseada nos últimos avanços na matemática e nas estatísticas de sinais - a técnica de sensoriamento compressivo . Uma imagem óptica em uma matriz é um sinal complexo, que é apresentado na forma de uma lista de números e é processado por diferentes algoritmos. Como um sinal de som complexo consiste em muitos sons mais simples, cada um dos quais é adicionado na proporção correta, de modo que a imagem é formada a partir de um grande número de imagens mais simples. Um conjunto de imagens simples, ou sinais, é chamado de base . No domínio do som, a base mais comum é um conjunto de tons puros de cosseno. Não importa o quão complicado é o som. Tudo, de uma buzina de carro a uma sinfonia de Beethoven, pode ser criado adicionando-se um grande número de ondas cosseno-básicas, para cada uma das quais a intensidade e a mudança de tempo desejadas são selecionadas.

O que poderia ser uma base semelhante no campo das imagens? As duas bases visuais mais populares e úteis são conjuntos de ondas cosseno-bidimensionais e padrões de wavelets de alta resolução. Esses elementos básicos são matematicamente elegantes e formam a base dos modernos esquemas de compressão de imagem JPEG e JPEG 2000. Em vez de armazenar e transmitir os valores de cada pixel em uma imagem digital, você opera em um arquivo que descreve as amplitudes de diferentes sinais base de componentes. Como resultado, o arquivo "compactado" é muito menor que a própria imagem. Durante décadas, essas bases serviram fielmente como uma ferramenta para o processamento de imagens digitais, mas não levaram à criação de novos métodos para o desenvolvimento de circuitos ópticos; portanto, nenhum elemento óptico facilita a introdução de bases.

Vamos para o sensor de compressão. Teoricamente, as estatísticas mostram que, embora as informações sobre a cena sejam redundantes (ou seja, a imagem pode ser compactada), não há necessidade de medir as bases, as medidas de uma amostra aleatória são suficientes. « », , ( ), compressive sensing. , , .

, (), . . «» , , (). , .

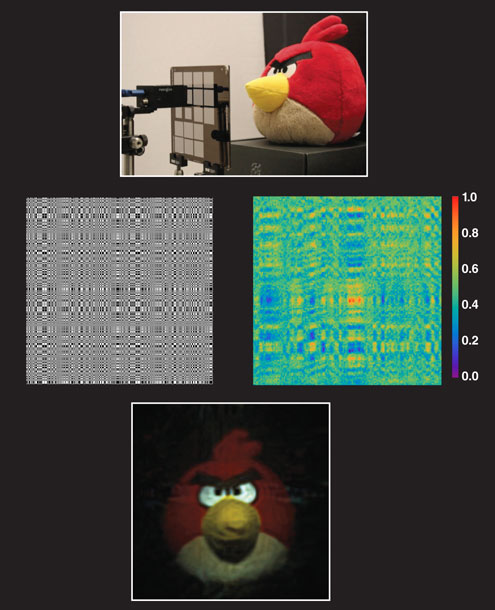

, -. (coded apertures) ( - ) . FlatCam (Ashok Veeraraghavan) . , (. ). — Angry Birds — ( ) . , , , . , . , . compressive sensing «» , .

.

, . , , , . 0,5 0,2 — , . FlatCam , , .

, , , , . , - , . , , .

. , , , , , , . , , , . , , , .

, . , - .