Há alguns meses, enquanto trabalhavam no próximo projeto, os profissionais do nosso laboratório de pesquisa estudaram os discos e as soluções de software NVMe para encontrar a melhor opção para montar uma matriz de software.

Os resultados dos testes foram surpreendentemente desanimadores - o enorme potencial de velocidade dos discos NVMe não se correlacionou com o desempenho demonstrado dos produtos de software existentes.

Nossos desenvolvedores não gostaram. E eles decidiram escrever seu produto ... Um produto que os comerciantes subseqüentemente criaram com o nome RAIDIX ERA.

Hoje, mais de uma dúzia de empresas produzem servidores adaptados para o uso de unidades NVMe. O mercado de produtos que suportam e desenvolvem essa tecnologia tem um enorme potencial. No relatório analítico da G2M, são apresentados números bastante convincentes, convincentes de que este protocolo de transferência de dados dominará em um futuro próximo.

Gráfico do relatório G2M

Gráfico do relatório G2MAtualmente, um dos líderes na produção de componentes NVMe é a Intel. Foi no equipamento deles que realizamos testes para avaliar as capacidades dos produtos de software existentes para gerenciar um hardware "inovador".

Juntamente com nosso parceiro, Promobit (um fabricante de servidores e sistemas de armazenamento de dados sob a marca comercial BITBLAZE), organizamos testes das unidades NVMe da Intel e do software comum para gerenciar esses dispositivos. O teste foi realizado de acordo com o método SNIA.

Neste artigo, compartilharemos os números obtidos durante o teste do sistema de hardware Intel NVMe, matrizes de software do MDRAID, Zvol sobre ZFS RAIDZ2 e, de fato, nosso novo desenvolvimento.

Configuração de hardware

Para a base da plataforma de teste, adotamos o sistema de servidor Intel Server System R2224WFTZS. Possui 2 soquetes para a instalação de processadores escaláveis Intel Xeon e 12 canais de memória (24 DIMMs no total) DDR 4 com uma frequência de até 2666 MHz.

Mais informações sobre a plataforma do servidor podem ser encontradas

no site do fabricante .

Todas as unidades NVMe conectadas através de 3 backplanes

F2U8X25S3PHS .

No total, temos 12 unidades NVMe INTEL SSDPD2MD800G4 com firmware CVEK6256004E1P0BGN no sistema.

A plataforma do servidor foi equipada com dois processadores Intel® Xeon® Gold 6130 CPU a 2.10GHz com Hyper-Threading ativado, permitindo o lançamento de dois threads a partir de cada núcleo. Assim, na saída, recebemos 64 threads de computação.

Preparação do teste

Todos os testes neste artigo foram realizados de acordo com a especificação da metodologia SNIA SSS PTSe v 1.1. Inclusive, foi realizada uma preparação preliminar do armazenamento para obter um resultado estável e honesto.

O SNIA permite que o usuário defina os parâmetros para o número de threads e a profundidade da fila; portanto, configuramos 64/32, com 64 threads de computação em 32 núcleos.

Cada teste foi realizado em 16 rodadas para levar o sistema a um nível estável de indicadores e excluir valores aleatórios.

Antes de iniciar os testes, fizemos uma preparação preliminar do sistema:

- Instalando a versão do kernel 4.11 no CentOS 7.4.

- Desative C-STATES e P-STATES.

- Execute o utilitário admissão ajustado e defina o perfil de desempenho de latência.

O teste de cada produto e item foi realizado com as seguintes etapas:

Preparação de dispositivos de acordo com a especificação SNIA (dependente da carga e independente).

- Teste de IOps em blocos de 4k, 8k, 16k, 32k, 64k, 128k, 1m com variações de combinações de leitura / gravação 0/100, 5/95, 35/65, 50/50, 65/35, 95/5, 100/0 .

- Testes de latência com blocos de 4k, 8k, 16k com variações das combinações de leitura / gravação 0/100, 65/35 e 100/0. O número de encadeamentos e a profundidade da fila é 1-1. Os resultados são registrados como atrasos médios e máximos.

- Teste de produção com blocos de 128k e 1M, em 64 linhas de 8 equipes.

Começamos testando o desempenho, latência e taxa de transferência da plataforma de hardware. Isso nos permitiu avaliar o potencial do equipamento proposto e comparar com os recursos das soluções de software aplicadas.

Teste 1. Teste de Hardware

Para começar, decidimos ver do que uma unidade Intel DCM D3700 NVMe é capaz.

Na especificação, o fabricante declara os seguintes parâmetros de desempenho:

Leitura aleatória (100% de intervalo) 450.000 IOPS

Gravação aleatória (100% de intervalo) 88000 IOPS

Teste 1.1 Uma unidade NVMe. Teste de IOPS

Resultado de desempenho (IOps) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 84017,8 | 91393.8 | 117271.6 | 133059.4 | 175086.8 | 281131.2 | 390969.2 |

| 8k | 42602,6 | 45735,8 | 58980,2 | 67321.4 | 101357.2 | 171316.8 | 216551.4 |

| 16k | 21618,8 | 22834,8 | 29703,6 | 33821.2 | 52552.6 | 89731,2 | 108347 |

| 32k | 10929,4 | 11322 | 14787 | 16811 | 26577,6 | 47185.2 | 50670,8 |

| 64k | 5494,4 | 5671,6 | 7342,6 | 8285,8 | 13130,2 | 23884 | 27249.2 |

| 128k | 2748,4 | 2805,2 | 3617,8 | 4295,2 | 6506,6 | 11997,6 | 13631 |

| 1m | 351,6 | 354,8 | 451,2 | 684,8 | 830,2 | 1574,4 | 1702,8 |

Resultado de desempenho (IOps) em forma gráfica. Mistura de leitura / gravação%.

Nesta fase, obtivemos resultados que não atingem exatamente os de fábrica. Provavelmente, o NUMA (o esquema de implementação da memória do computador usado nos sistemas multiprocessadores, quando o tempo de acesso à memória é determinado por sua localização em relação ao processador) desempenhou seu papel, mas, por enquanto, não prestaremos atenção a ele.

Teste 1.2 Uma unidade NVMe. Testes de atraso

Tempo médio de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,02719 | 0,072134 | 0,099402 |

| 8k | 0,029864 | 0,093092 | 0,121582 |

| 16k | 0,046726 | 0,137016 | 0,16405 |

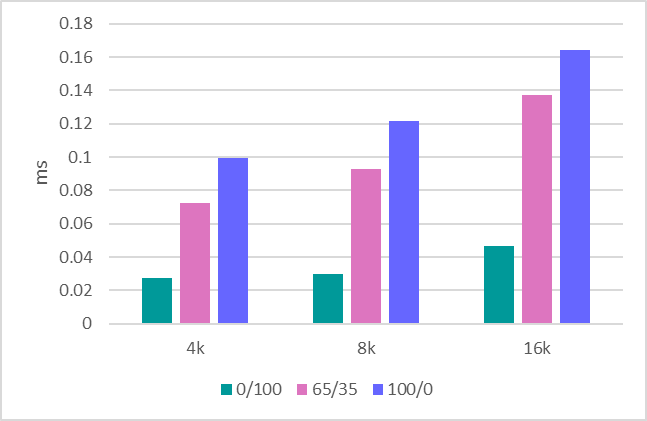

Tempo médio de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

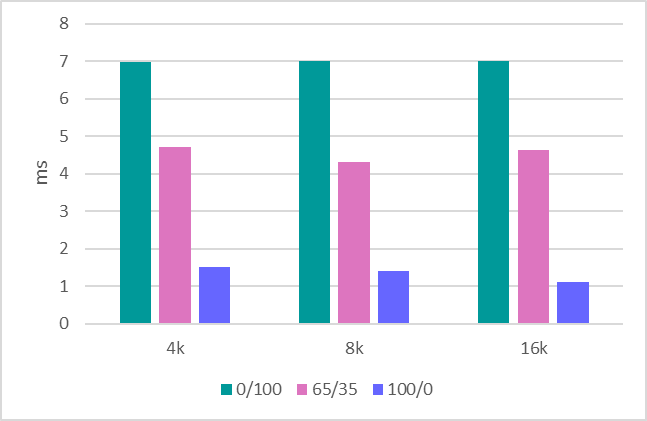

Tempo máximo de resposta

Tempo máximo de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6,9850 | 4.7147 | 1,5098 |

| 8k | 7.0004 | 4.3118 | 1,4086 |

| 16k | 7.0068 | 4,6445 | 1.1064 |

Tempo máximo de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Teste 1.3 Taxa de transferência

A etapa final é avaliar a taxa de transferência. Aqui estão os seguintes indicadores:

Gravação sequencial de 1 MB - 634 MBps.

Leitura sequencial de 1 MB - 1707 MBps.

Gravação sequencial de 128Kb - 620 MBps.

Leitura sequencial de 128Kb - 1704 MBps.

Depois de lidar com uma unidade, passamos a avaliar toda a plataforma, que consiste em 12 unidades.

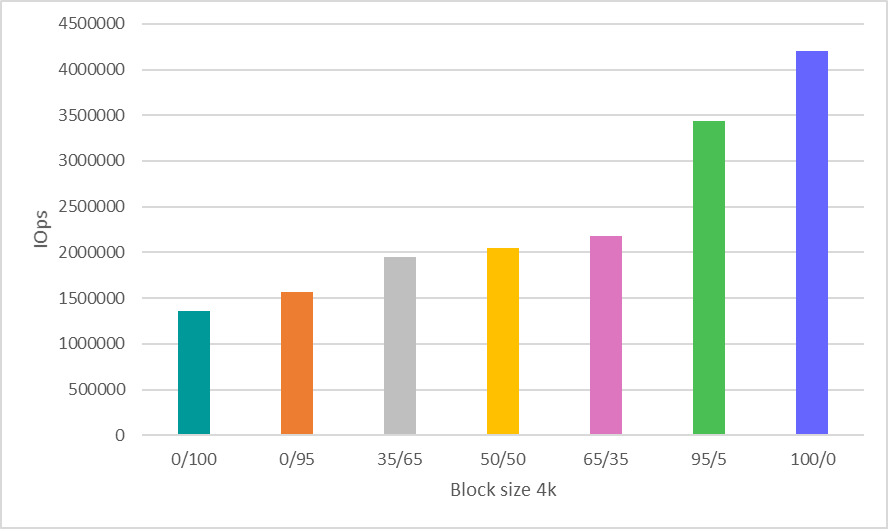

Teste 1.4 Sistema em 12 unidades. Teste de IOPS

Aqui, uma decisão forte foi tomada para economizar tempo e mostrar resultados apenas para trabalhar com o bloco 4k, que é de longe o cenário mais comum e indicativo para avaliar o desempenho.

Resultado de desempenho (IOps) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1363078.6 | 1562345 | 1944105 | 2047612 | 2176476 | 3441311 | 4202364 |

Resultado de desempenho (IOps) em forma gráfica. Mistura de leitura / gravação%.

Teste o sistema 1.5 em 12 unidades. Testes de largura de banda

Gravação sequencial de 1 MB - 8612 MBps.

Leitura sequencial de 1 MB - 20481 MBps.

Gravação sequencial de 128Kb - 7500 MBps.

Leitura sequencial de 128Kb - 20400 MBps.

Analisaremos os indicadores de desempenho de hardware obtidos novamente no final do artigo, comparando-os com os números do software testado nele.

Teste 2: Testando o MDRAID

Quando falamos sobre uma matriz de software, o MDRAID vem à mente primeiro. Lembre-se de que este é o RAID de software básico para Linux, que é distribuído gratuitamente.

Vamos ver como o MDRAID lida com o sistema de 12 discos proposto com um nível de matriz RAID 0. Todos nós entendemos que a criação de RAID 0 em 12 unidades requer coragem especial, mas agora precisamos desse nível de matriz para demonstrar os recursos máximos desta solução.

Teste 2.1 MDRAID. Teste RAID 0. IOPS

Resultado de desempenho (IOps) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 1010396 | 1049306.6 | 1312401.4 | 1459698,6 | 1932776.8 | 2692752.8 | 2963943.6 |

| 8k | 513627,8 | 527230.4 | 678140 | 771887.8 | 1146340.6 | 1894547.8 | 2526853.2 |

| 16k | 261087.4 | 263638.8 | 343679.2 | 392655.2 | 613912,8 | 1034843.2 | 1288299.6 |

| 32k | 131198.6 | 130947.4 | 170846.6 | 216039.4 | 309028.2 | 527920.6 | 644774.6 |

| 64k | 65083.4 | 65099.2 | 85257,2 | 131005,6 | 154839,8 | 268425 | 322739 |

| 128k | 32550,2 | 32718.2 | 43378,6 | 66999,8 | 78935.8 | 136869,8 | 161015.4 |

| 1m | 3802 | 3718,4 | 3233,4 | 3467,2 | 3546 | 6150,8 | 8193,2 |

Resultado de desempenho (IOps) em forma gráfica. Mistura de leitura / gravação%.

Teste 2.2 MDRAID. RAID 0. Testes de atraso

Tempo médio de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,03015 | 0,067541 | 0.102942 |

| 8k | 0,03281 | 0,082132 | 0.126008 |

| 16k | 0,050058 | 0,114278 | 0.170798 |

Tempo médio de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Tempo máximo de resposta

Tempo máximo de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6,7042 | 3.7257 | 0,8568 |

| 8k | 6.5918 | 2.2601 | 0,9004 |

| 16k | 6.3466 | 2,7741 | 2.5678 |

Tempo máximo de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Teste 2.3 MDRAID. RAID 0. Testes de largura de banda

Gravação sequencial de 1 MB - 7820 MBPS.

Leitura sequencial de 1 MB - 20418 MBPS.

Gravação sequencial de 128Kb - 7622 MBPS.

Leitura sequencial de 128Kb - 20.380 MBPS.

Teste 2.4 MDRAID. RAID 6. Teste de IOPS

Vamos agora ver o que esse sistema possui no nível RAID 6.

Opções de criação de matriz

mdadm --create --verbose --chunk 16K / dev / md0 --level = 6 --raid-devices = 12 / dev / nvme0n1 / dev / nvme1n1 / dev / nvme2n1 / dev / nvme3n1 / dev / nvme4n1 / dev / nvme5n1 / dev / nvme8n1 / dev / nvme9n1 / dev / nvme10n1 / dev / nvme11n1 / dev / nvme6n1 / dev / nvme7n1

O volume total da matriz foi de

7450,87 GiB.

Iniciamos o teste após a inicialização preliminar da matriz RAID.

Resultado de desempenho (IOps) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 39907.6 | 42849 | 61609,8 | 78167,6 | 108594,6 | 641950.4 | 1902561.6 |

| 8k | 19474,4 | 20701,6 | 30316.4 | 39737,8 | 57051,6 | 394072.2 | 1875791.4 |

| 16k | 10371.4 | 10979,2 | 16022 | 20992,8 | 29955,6 | 225157.4 | 1267495.6 |

| 32k | 8505,6 | 8824,8 | 12896 | 16657,8 | 23823 | 173261.8 | 596857.8 |

| 64k | 5679,4 | 5931 | 8576,2 | 11137,2 | 15906,4 | 109469.6 | 320874.6 |

| 128k | 3976,8 | 4170,2 | 5974,2 | 7716,6 | 10996 | 68124.4 | 160453.2 |

| 1m | 768,8 | 811,2 | 1177,8 | 1515 | 2149,6 | 4880,4 | 5499 |

Resultado de desempenho (IOps) em forma gráfica. Mistura de leitura / gravação%.

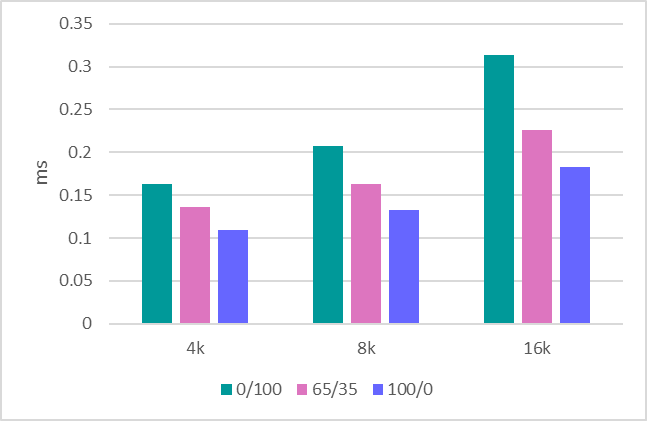

Teste 2.5 MDRAID. RAID 6. Testes de atraso

Tempo médio de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0.193702 | 0,145565 | 0,10558 |

| 8k | 0,266582 | 0,186618 | 0,127142 |

| 16k | 0.426294 | 0,281667 | 0,169504 |

Tempo médio de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Tempo máximo de resposta

Tempo máximo de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 6.1306 | 4.5416 | 4.2322 |

| 8k | 6.2474 | 4.5197 | 3.5898 |

| 16k | 5.4074 | 5.5861 | 4.1404 |

Tempo máximo de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Vale ressaltar que aqui o MDRAID mostrou um nível muito bom de atrasos.

Teste 2.6 MDRAID. RAID 6. Testes de largura de banda

Gravação sequencial de 1 MB - 890 MBPS.

Leitura sequencial de 1 MB - 18800 MBPS.

Gravação sequencial de 128Kb - 870 MBPS.

Leitura sequencial de 128Kb - 10400 MBPS.

Teste 3. Zvol sobre ZFS RAIDZ2

O ZFS possui uma função interna de criação de RAID e um gerenciador de volume interno que cria dispositivos de bloco virtual, usados por muitos fabricantes de armazenamento. Também aproveitaremos esses recursos criando um pool com proteção RAIDZ2 (análoga ao RAID 6) e um volume de bloco virtual em cima dele.

A versão 0.79 (ZFS) foi compilada. Opções de criação de matriz e volume:

ashift = 12 / compressão - desativada / desduplicação - desativada / tamanho do registro = 1M / atime = desativada / cachefile = nenhuma / Tipo RAID = RAIDZ2

O ZFS mostra resultados muito bons com o pool recém-criado. No entanto, com duplicação repetida, o desempenho é reduzido significativamente.

A abordagem SNIA é boa porque permite ver resultados reais de testes de sistemas de arquivos semelhantes (o baseado no ZFS) após substituições repetidas neles.

Teste 3.1 ZVOL (ZFS). RAIDZ2. Teste de IOps

Resultado de desempenho (IOps) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 15719,6 | 15147,2 | 14190.2 | 15592,4 | 17965,6 | 44832,2 | 76314.8 |

| 8k | 15536,2 | 14929,4 | 15140,8 | 16551 | 17898.8 | 44553,4 | 76187.4 |

| 16k | 16696,6 | 15937,2 | 15982,6 | 17350 | 18546,2 | 44895,4 | 75549,4 |

| 32k | 11859,6 | 10915 | 9698,2 | 10235,4 | 11265 | 26741,8 | 38167.2 |

| 64k | 7444 | 6440,2 | 6313,2 | 6578,2 | 7465,6 | 14145,8 | 19099 |

| 128k | 4425,4 | 3785,6 | 4059,8 | 3859,4 | 4246,4 | 7143,4 | 10052,6 |

| 1m | 772 | 730,2 | 779,6 | 784 | 824,4 | 995,8 | 1514,2 |

Resultado de desempenho (IOps) em forma gráfica. Mistura de leitura / gravação%.

Os números de desempenho são completamente inexpressivos. Ao mesmo tempo, o zvol puro (antes de reescrever) fornece resultados significativamente melhores (5 a 6 vezes mais). Aqui, o teste mostrou que, após a primeira cópia, o desempenho cai.

Teste 3.2 ZVOL (ZFS). RAIDZ2. Testes de atraso

Tempo médio de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,332824 | 0,255225 | 0,218354 |

| 8k | 0,3299 | 0,259013 | 0,225514 |

| 16k | 0.139738 | 0.180467 | 0.233332 |

Tempo médio de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Tempo máximo de resposta

Tempo máximo de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 90,55 | 69.9718 | 84,4018 |

| 8k | 91.6214 | 86.6109 | 104.7368 |

| 16k | 108.2192 | 86.2194 | 105.658 |

Tempo máximo de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Teste 3.3 ZVOL (ZFS). RAIDZ2. Testes de largura de banda

Gravação sequencial de 1 MB - 1150 MBPS.

Leitura sequencial de 1 MB - 5500 MBPS.

Gravação sequencial de 128Kb - 1100 MBPS.

Leitura seqüencial de 128Kb - 5300 MBPS.

Teste 4: RAIDIX ERA

Vejamos agora os testes do nosso novo produto - RAIDIX ERA.

Criamos o RAID6. Tamanho da faixa: 16kb. Após a conclusão da inicialização, execute o teste.

Resultado de desempenho (IOps) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 354887 | 363830 | 486865.6 | 619349.4 | 921403.6 | 2202384.8 | 4073187.8 |

| 8k | 180914.8 | 185371 | 249927.2 | 320438.8 | 520188.4 | 1413096.4 | 2510729 |

| 16k | 92115,8 | 96327,2 | 130661.2 | 169247.4 | 275446.6 | 763307.4 | 1278465 |

| 32k | 59994.2 | 61765.2 | 83512,8 | 116562.2 | 167028.8 | 420216.4 | 640418.8 |

| 64k | 27660,4 | 28229,8 | 38687,6 | 56603,8 | 76976 | 214958.8 | 299137.8 |

| 128k | 14475,8 | 14730 | 20674,2 | 30358,8 | 40259 | 109258.2 | 160141.8 |

| 1m | 2892,8 | 3031,8 | 4032,8 | 6331,6 | 7514,8 | 15871 | 19078 |

Resultado de desempenho (IOps) em forma gráfica. Mistura de leitura / gravação%.

Teste 4.2 RAIDIX ERA. RAID 6. Testes de atraso

Tempo médio de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 0,16334 | 0,136397 | 0,10958 |

| 8k | 0,207056 | 0,163325 | 0,132586 |

| 16k | 0,313774 | 0,225767 | 0,182928 |

Tempo médio de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Tempo máximo de resposta

Tempo máximo de resposta (ms) em forma de tabela. Mistura de leitura / gravação%.

| Tamanho do bloco | R0% / W100% | R65% / W35% | R100% / W0% |

|---|

| 4k | 5.371 | 3.4244 | 3.5438 |

| 8k | 5.243 | 3,7415 | 3.5414 |

| 16k | 7.628 | 4,2891 | 4.0562 |

Tempo máximo de resposta (ms) em forma gráfica. Mistura de leitura / gravação%.

Atrasos são semelhantes aos produzidos pelo MDRAID. Porém, para conclusões mais precisas, uma estimativa dos atrasos sob uma carga mais séria deve ser realizada.

Teste 4.3 RAIDIX ERA. RAID 6. Testes de largura de banda

Gravação sequencial de 1 MB - 8160 MBPS.

Leitura sequencial de 1 MB - 19700 MBPS.

Gravação sequencial de 128Kb - 6200 MBPS.

Leitura sequencial de 128Kb - 19700 MBPS.

Conclusão

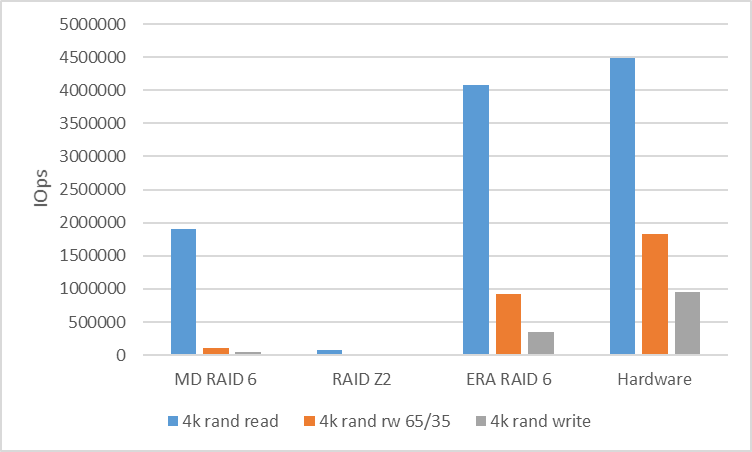

Como resultado dos testes, vale a pena comparar os números obtidos das soluções de software com o que a plataforma de hardware nos fornece.

Para analisar o desempenho da carga aleatória, compararemos a velocidade do RAID 6 (RAIDZ2) ao trabalhar com um bloco em 4k.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Hardware |

|---|

| 4k R100% / W0% | 1902561 | 76314 | 4073187 | 4.494.142 |

| 4k R65% / W35% | 108594 | 17965 | 921403 | 1823432 |

| 4k R0% / W100% | 39907 | 15719 | 354887 | 958054 |

Para analisar o desempenho da carga serial, veremos o RAID 6 (RAIDZ2) com um bloco de 128k. Entre os threads, usamos um deslocamento de 10 GB para eliminar o acerto do cache e mostrar o desempenho real.

| MD RAID 6 | RAIDZ2 | RAIDIX ERA RAID 6 | Hardware |

|---|

| 128k seq read | 10400 | 5300 | 19700 | 20.400 |

| 128k seq write | 870 | 1100 | 6200 | 7500 |

Qual é o resultado?

Matrizes RAID de software populares e acessíveis para trabalhar com dispositivos NVMe não podem mostrar o desempenho inerente ao potencial de hardware.

Aqui há uma necessidade muito óbvia de um software de controle que possa agitar a situação e mostrar que a simbiose de controle de programa com unidades NVMe pode ser muito produtiva e flexível.

Entendendo essa solicitação, nossa empresa criou um produto RAIDIX ERA, cujo desenvolvimento se concentrou na solução dos seguintes problemas:

- Alto desempenho de leitura e gravação (vários milhões de IOps) em matrizes com Paridade no modo de mixagem.

- Desempenho de streaming de 30 GBps, inclusive durante failover e recuperação.

- Suporte para níveis RAID 5, 6, 7.3.

- Inicialização e reconstrução em segundo plano.

- Configurações flexíveis para diferentes tipos de carga (lado do usuário).

Hoje, podemos dizer que essas tarefas foram concluídas e o produto está pronto para uso.

Ao mesmo tempo, entendendo o interesse de muitas partes interessadas em tais tecnologias, preparamos para o lançamento não apenas uma licença paga, mas também uma

licença gratuita , que pode ser totalmente usada para resolver problemas nas unidades NVMe e SSD.

Leia mais sobre o RAIDIX ERA

em nosso site .

UPD Teste ZFS reduzido com tamanho de registro e tamanho de bloco de 8k

Tabela de opções do ZFS

| NAME | PROPRIEDADE | VALUE | FONTE |

|---|

| tanque | tamanho | 8K | local |

| tanque | compressão | fora | padrão |

| tanque | dedup | fora | padrão |

| tanque | soma de verificação | fora | local |

| tanque | volblocksize | - | - |

| tanque / ataque | tamanho | - | - |

| tanque / ataque | compressão | fora | local |

| tanque / ataque | dedup | fora | padrão |

| tanque / ataque | soma de verificação | fora | local |

| tanque / ataque | volblocksize | 8k | padrão |

A gravação piorou, a leitura é melhor.

Mesmo assim, todos os resultados são significativamente piores que outras soluções

| Tamanho do bloco | R0% / W100% | R5% / W95% | R35% / W65% | R50% / W50% | R65% / W35% | R95% / W5% | R100% / W0% |

|---|

| 4k | 13703,8 | 14399,8 | 20903,8 | 25669 | 31610 | 66955,2 | 140849,8 |

| 8k | 15126 | 16227,2 | 22393,6 | 27720,2 | 34274,8 | 67008 | 139480.8 |

| 16k | 11111.2 | 11412.4 | 16980,8 | 20812,8 | 24680,2 | 48803.6 | 83710.4 |