Um é zero a favor do cérebro humano. Em um

novo estudo , cientistas da computação descobriram que os sistemas de inteligência artificial não passam no teste de reconhecimento visual de objetos que qualquer criança pode manipular facilmente.

"Este estudo qualitativo e importante nos lembra que o" aprendizado profundo "em si não pode se gabar da profundidade que lhe é atribuída", diz Gary Marcus, neurocientista da Universidade de Nova York que não está associado a este trabalho.

Os resultados do estudo estão relacionados ao campo da visão computacional, quando os sistemas de inteligência artificial tentam detectar e categorizar objetos. Por exemplo, eles podem ser solicitados a encontrar todos os pedestres na cena das ruas ou simplesmente distinguir um pássaro de uma bicicleta - uma tarefa que já se tornou famosa por sua complexidade.

As apostas são altas: os computadores estão gradualmente começando a executar operações importantes para as pessoas, como vigilância por vídeo automática e direção autônoma. E para um trabalho bem-sucedido, é necessário que a capacidade da IA para o processamento visual seja pelo menos não inferior à humana.

A tarefa não é fácil.

O novo estudo enfoca a sofisticação da visão humana e as dificuldades na criação de sistemas imitadores. Os cientistas testaram a precisão de um sistema de visão computacional usando o exemplo de uma sala de estar. A AI foi bem, identificando corretamente a cadeira, a pessoa e os livros na prateleira. Mas quando os cientistas adicionaram um objeto incomum à cena - a imagem de um elefante - o próprio fato de sua aparência fez o sistema esquecer todos os resultados anteriores. De repente, ela começou a chamar a cadeira de sofá, o elefante de cadeira e a ignorar todos os outros objetos.

"Havia todo tipo de esquisitice que mostrava a fragilidade dos sistemas modernos de detecção de objetos", diz Amir Rosenfeld, cientista da Universidade de York em Toronto e co-autor de um estudo que ele e seus colegas

John Totsotsos , também de York, e

Richard Zemel, da Universidade de Toronto.

Os pesquisadores ainda estão tentando esclarecer as razões pelas quais o sistema de visão computacional é tão facilmente confundido, e eles já têm um bom palpite. O ponto da habilidade humana, que a IA não possui, é a capacidade de perceber que a cena é incompreensível, e precisamos considerá-la mais de perto novamente.

Elefante no quarto

Olhando para o mundo, percebemos uma quantidade impressionante de informações visuais. O cérebro humano processa-o em movimento. "Abrimos os olhos e tudo acontece por si só", diz Totsotsos.

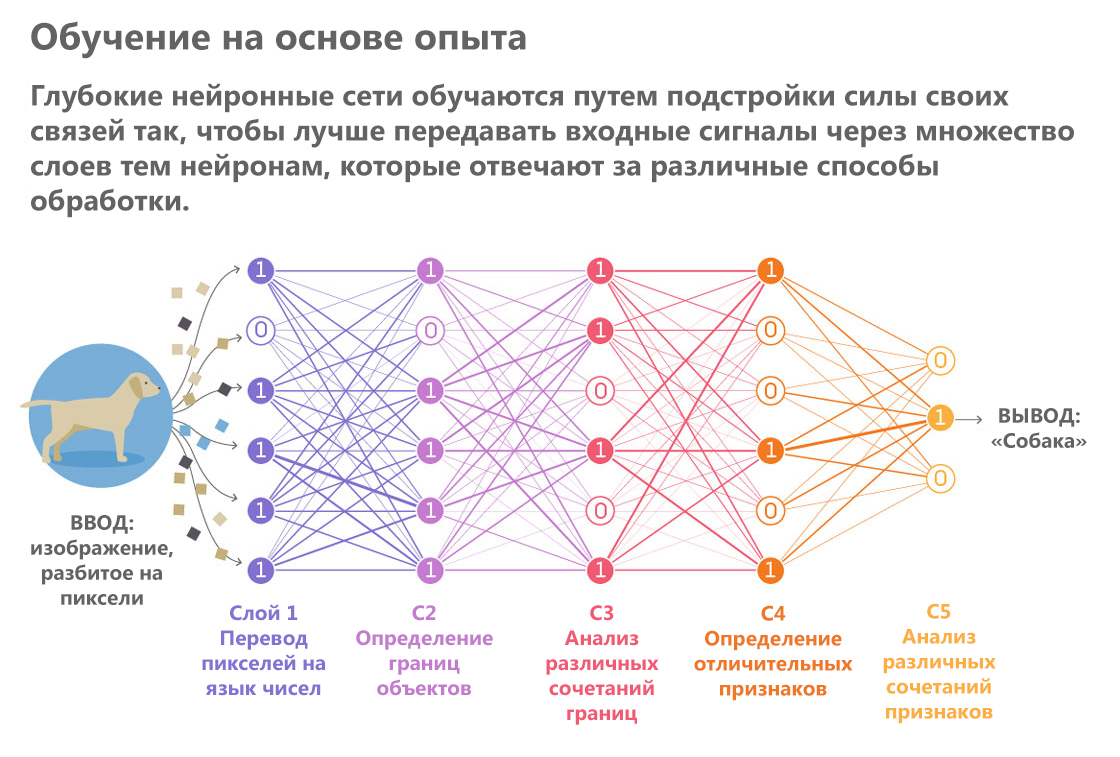

A inteligência artificial, por outro lado, cria uma impressão visual meticulosamente, como se estivesse lendo uma descrição em Braille. Ele passa as pontas dos dedos algorítmicos pelos pixels, formando gradualmente a partir deles representações cada vez mais complexas. Uma variedade de sistemas de IA que executam processos semelhantes são redes neurais. Eles passam uma imagem através de uma série de "camadas". À medida que cada camada passa, os detalhes da imagem individual, como a cor e o brilho de pixels individuais, são processados e uma descrição cada vez mais abstrata do objeto é formada com base nessa análise.

"Os resultados do processamento da camada anterior são transferidos para a próxima e assim por diante, como em um transportador", explica Totsotsos.

Publicado por: Lucy Reading-Ikkanda / Quanta Magazine

Publicado por: Lucy Reading-Ikkanda / Quanta MagazineAs redes neurais são especialistas em tarefas rotineiras específicas no campo do processamento visual. Eles são melhores do que as pessoas para lidar com tarefas altamente especializadas, como determinar a raça de cães e outras classificações de objetos em categorias. Esses exemplos bem-sucedidos deram origem à esperança de que os sistemas de visão computacional logo se tornariam tão inteligentes que seriam capazes de dirigir um carro nas ruas movimentadas da cidade.

Ele também levou os especialistas a explorar suas vulnerabilidades. Nos últimos anos, os pesquisadores fizeram várias tentativas para simular ataques hostis - eles criaram cenários que forçam as redes neurais a cometer erros. Em um experimento, cientistas da computação

enganaram a rede, forçando-a a pegar a tartaruga por uma arma. Outra história de trapaça bem-sucedida foi que, ao lado de objetos comuns como uma banana, os pesquisadores

colocaram uma torradeira pintada em cores psicodélicas na imagem.

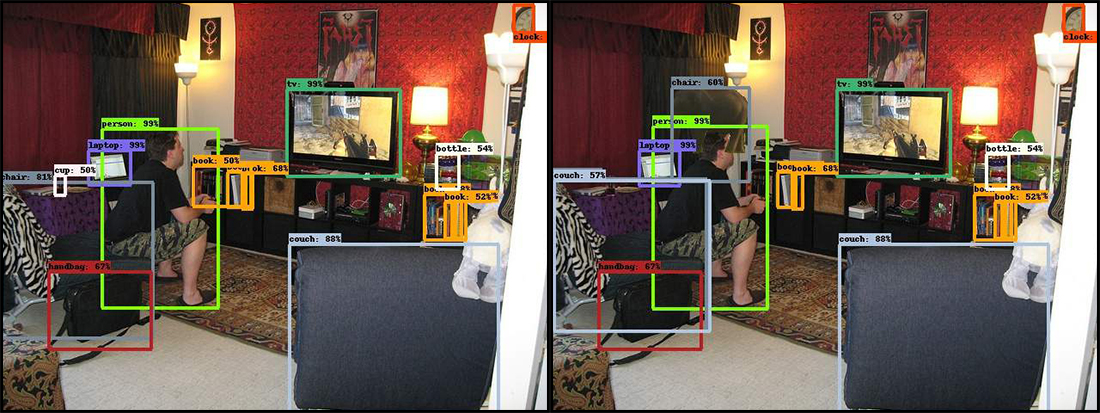

No novo trabalho, os cientistas escolheram a mesma abordagem. Três pesquisadores mostraram uma fotografia de rede neural de uma sala de estar. Ele captura um homem que joga videogame, sentado na beira de uma cadeira velha e se inclinando para frente. "Digestando" essa cena, a IA rapidamente reconheceu vários objetos: uma pessoa, um sofá, uma TV, uma cadeira e alguns livros.

Em seguida, os pesquisadores adicionaram um objeto incomum para cenas semelhantes: a imagem de um elefante em um meio perfil. E a rede neural está confusa. Em alguns casos, a aparência de um elefante a forçou a tomar uma cadeira para um sofá, e às vezes o sistema deixava de ver certos objetos, com o reconhecimento dos quais antes disso não havia problemas. Por exemplo, é uma série de livros. Além disso, as falhas ocorreram mesmo com objetos localizados longe do elefante.

No original, à esquerda, a rede neural corretamente e com alta confiança identificou muitos objetos localizados na sala cheia de várias coisas. Mas assim que o elefante foi adicionado (imagem à direita), o programa começou a falhar. A cadeira no canto inferior esquerdo se transformou em um sofá, a xícara ao lado desapareceu e o elefante se tornou uma cadeira.

No original, à esquerda, a rede neural corretamente e com alta confiança identificou muitos objetos localizados na sala cheia de várias coisas. Mas assim que o elefante foi adicionado (imagem à direita), o programa começou a falhar. A cadeira no canto inferior esquerdo se transformou em um sofá, a xícara ao lado desapareceu e o elefante se tornou uma cadeira.Erros de sistema semelhantes são completamente inaceitáveis para a mesma direção autônoma. O computador não poderá dirigir o carro se ele não notar os pedestres simplesmente porque, alguns segundos antes, ele viu um peru na berma da estrada.

Quanto ao próprio elefante, os resultados de seu reconhecimento também diferiram da tentativa de tentativa. O sistema então o determinou corretamente, às vezes chamado de ovelha, e nem percebeu.

"Se um elefante realmente aparecer na sala, provavelmente alguém notará", diz Rosenfeld. "E o sistema nem registrou sua presença."

Relacionamento próximo

Quando as pessoas vêem algo inesperado, elas olham melhor. Não importa o quão simples isso pareça, “olhe mais de perto”, isso tem consequências cognitivas reais e explica por que a IA é equivocada quando algo incomum aparece.

Ao processar e reconhecer objetos, as melhores redes neurais modernas transmitem informações através de si mesmas apenas na direção direta. Eles começam selecionando pixels na entrada, passando para curvas, formas e cenas e fazendo as suposições mais prováveis em cada estágio. Quaisquer equívocos nos estágios iniciais do processo levam a erros no final, quando a rede neural reúne seus "pensamentos" para adivinhar o que está vendo.

“Nas redes neurais, todos os processos estão intimamente interconectados, portanto sempre há a possibilidade de que qualquer recurso em qualquer lugar possa afetar qualquer resultado possível”, diz Totsosos.

A abordagem humana é melhor. Imagine que você teve uma rápida olhada em uma imagem que possui um círculo e um quadrado, um vermelho e o outro azul. Depois disso, você foi solicitado a nomear a cor do quadrado. Uma breve olhada pode não ser suficiente para lembrar as cores corretamente. Imediatamente vem o entendimento de que você não tem certeza e precisa procurar novamente. E, o que é muito importante, durante a segunda visualização, você já saberá o que precisa focar.

"O sistema visual humano diz:" Eu ainda não posso dar a resposta correta, então voltarei e verificarei onde o erro poderia ter ocorrido ", explica Totsotsos, que está desenvolvendo uma teoria chamada"

sintonia seletiva "que explica esse recurso da percepção visual.

A maioria das redes neurais não tem a capacidade de voltar. Esse recurso é muito difícil de projetar. Uma das vantagens das redes unidirecionais é que elas são relativamente fáceis de treinar - basta "passar" as imagens pelas seis camadas mencionadas e obter o resultado. Mas se as redes neurais devem “olhar atentamente”, elas também precisam distinguir entre uma linha tênue, quando é melhor voltar e quando continuar trabalhando. O cérebro humano alterna fácil e naturalmente entre processos tão diferentes. E as redes neurais precisam de uma nova base teórica para que possam fazer o mesmo.

Pesquisadores importantes de todo o mundo estão trabalhando nessa direção, mas também precisam de ajuda. Recentemente, o projeto Google AI

anunciou uma competição por classificadores de imagem de crowdsourcing que podem distinguir entre casos de distorção intencional da imagem. A solução que puder distinguir claramente a imagem do pássaro da imagem da bicicleta vencerá. Este será um primeiro passo modesto, mas muito importante.