Decidi escrever este artigo na sequência deste post .

Deixe-me lembrá-lo de um breve ponto: na revista Nature, foram publicados os resultados de um estudo realizado com

esse teste .

Sobre o que eu quero escrever?

Primeiro, por que essa pesquisa é absolutamente inútil para resolver o problema declarado e na forma em que foi conduzida.

Em segundo lugar, como priorizar esse estudo.

E em terceiro lugar, tente simular vários cenários de acidentes dentro das condições especificadas pelo teste.

Nesse post, o autor não inseriu em vão um link para o teste desde o início. Isso ajudaria a evitar comentários sem sentido daqueles que não captaram a mensagem inicial do estudo.

Faça um teste pelo menos algumas vezes para entender o assunto da discussão.

O que eles prometeram nos mostrar no estudo

A discussão do primeiro post, épico para Habr, mostrou que a maioria das pessoas não sabe pensar dentro das condições dadas, mas começa a fantasiar: "algumas pessoas morrem no teste?" Afinal, você pode contornar os pedestres e o bloco / de lado para esfregar / frear o freio de mão / marcha? Mas eu faria ... ". Entenda que este é um exemplo simplificado para o desenvolvimento de algoritmos e políticas de ação para regular o comportamento do piloto automático na estrada! Do ponto de vista do desenvolvimento de regras de segurança, tais extremos e simplificações são justificados. É sobre as possíveis consequências para as quais as pessoas devem estar preparadas. Os soldados não vão para os campos minados não porque cada centímetro quadrado é minado ali, mas devido à própria probabilidade de morrer. Geralmente não é muito alto, mas ninguém vai arriscar. Portanto, no teste, a escolha entre 100% de morte de todos os passageiros ou pedestres é adequada - é assim que denotamos riscos, tendo em mente que arriscar vidas em nossa sociedade é inaceitável.

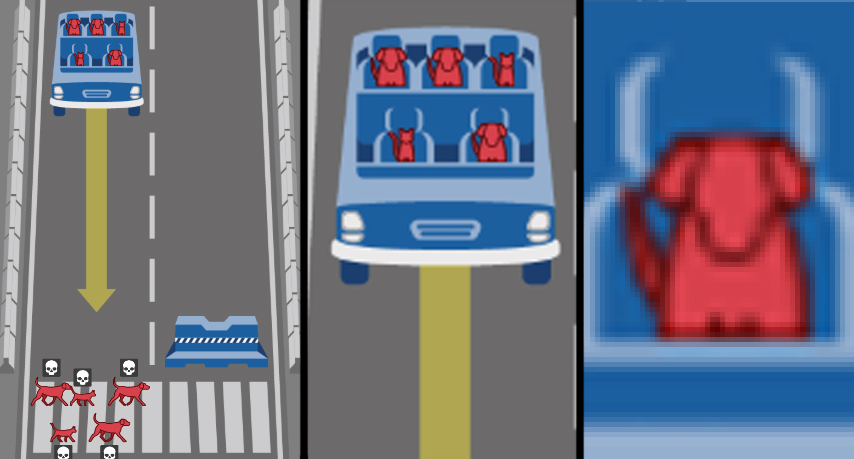

A mensagem do estudo é a seguinte: você, as pessoas que vivem agora, tem que viver em um mundo do futuro, cheio de carros no piloto automático. E é importante para nós, desenvolvedores de automóveis, IA e outras coisas, saber, mas como você acha que os robôs robóticos devem se comportar? Bem, aqui está, sim, sim, é você - me diga o que fazer com um robomóvel se a cabeça e o gato estiverem nele, e ele estiver prestes a esmagar os sem-teto e o cachorro? Que ética os robomobiles devem ter se tiverem que escolher?

E depois que identificamos o motivo inicial do estudo, quero discutir vários aspectos dele.

O que o estudo realmente mostrou

A primeira coisa que chama a sua atenção é que o design da pesquisa não visa o objetivo declarado. As tarefas definidas na forma de dilemas não são adequadas para criar uma "ética" do comportamento do carro-robô. Pelo contrário, nem todos. Aqui estão os dilemas que cumprem a tarefa de "desenvolver regras para o comportamento de um carro-robô para reduzir a gravidade das consequências de um acidente":

- "Passageiro / pedestre" - escolha quem salvar;

- "Violação das regras de trânsito" - escolha se deseja sacrificar pedestres inconscientes;

- “Número de vítimas em potencial” - escolha se o número de vítimas tem prioridade.

E então vêm os parâmetros que, ao que parece, são muito importantes para a sentença em nossa sociedade civilizada. As pessoas foram perguntadas honestamente e inocentemente: seu nível de sexismo, lukismo, envelhecimento? Você é discriminador de gordura ou não classificado? E, afinal, centenas de milhares de pessoas responderam honestamente ...

Bravo!

Bem nas melhores tradições de filmes e séries divertidos, quando o mundo dos personagens principais é na verdade uma grande caixa de areia atrás de uma cerca alta, e é o comportamento deles que é um experimento! Sob o molho de pesquisas super importantes no campo da robótica e da IA, sociólogos, psicólogos e culturologistas receberam uma amostra tão poderosa do problema do carrinho que ninguém jamais sonhara antes! Bem, exceto que a cor da pele não foi adicionada à pesquisa, mas as implicações racistas do estudo seriam costuradas em branco ... ah.

Sério, essa parte fenotípica do gênero do estudo é cortada por argumentos categóricos. O primeiro argumento é o humanismo, como povo civilizado, devemos colocar a primazia do valor da vida humana sobre quaisquer diferenças individuais. Ou seja, a própria formulação da questão é ultrajante, como discriminatória. O segundo argumento - muitos acidentes ocorrem e, no limite, a distribuição das vítimas por aparência, educação, sexo e idade tenderá a suas proporções na sociedade, por isso é pelo menos estranho regular isso adicionalmente. O terceiro argumento - não parece aconselhável criar inteligência artificial que distinga um terno de Brioni de um pulôver de Bershka para comparar ainda mais se uma pessoa é status e se vale a pena esmagá-la. Além disso, eu não confiaria na IA para julgar - um pedestre ou cientista sem-teto? (Olá para os penteados dos respeitados cientistas Perelman ou Gelfand :))

Além desses parâmetros desnecessários, descartamos facilmente os dois restantes: especificidade da espécie e não interferência. Sim, esmagaremos pequenos animais para salvar as pessoas, que teriam pensado. Quanto ao parâmetro "intervenção / não interferência" por manobras, essa parte essencial do problema do carrinho não é apenas um obstáculo para o carro, porque a máquina não age de acordo com a ética, mas de acordo com os algoritmos nele estabelecidos. E já que definimos a tarefa "como o carro deve agir em um acidente com uma colisão com pessoas", então na redação assumimos que ele deve agir de alguma maneira. Atualmente, o transporte ferroviário está enfrentando com sucesso uma colisão direta, sem conseqüências, e estamos desenvolvendo uma política para minimizar as vítimas de acidentes rodoviários.

Isso significa que separamos os grãos racionais da pesquisa do experimento sociopsicológico para estudar o nível de intolerância na sociedade mundial. Trabalhamos mais com os três primeiros dilemas mencionados. E há algo a desmontar. Após um exame mais atento, eles se mostram incompletos ...

Três dilemas de carros-robôs

Os pedestres violam as regras de trânsito? Aqui, a maioria expressa explicitamente o darwinismo social ou uma resposta lamentável e tacitamente triste - eles devem sacrificar aqueles que violam as regras em favor dos inocentes. Pessoas conscientes não andam sobre trilhos, sabendo que o trem não para - deixe que saibam que o robomóvel também não vai parar. Tudo é lógico, embora cínico. Mas neste dilema astuto, a unilateralidade, a incompletude, está oculta. Os pedestres que violam as regras de trânsito são apenas uma das muitas situações. Mas se o carro robótico quebrar? Essa situação ainda não foi considerada, mas em teoria (as câmeras do carro perderam um sinal ou um semáforo) é muito mais provável do que uma súbita falha no freio. No entanto, eu novamente bati em fantasia e em particular. É mais importante apenas mostrar no teste a reciprocidade equivalente da situação. Ou seja, imagine o seguinte: se os pedestres violam as regras de trânsito, eles morrem, e isso é "lógico" e "certo", e se o robomóvel violar, ele deveria cometer suicídio por esse erro? Não se esqueça que ao mesmo tempo morrem o líder, o vagabundo e o gato sentado lá dentro! Essa é uma correção importante, mas no teste esse aspecto não é.

Próximo. O número de vítimas em potencial. Aqui também não é tão simples. Descarte estereótipos de gênero e respeito à velhice, desprezo pelos gordos e sem-teto. Supomos que em um acidente eles morram proporcionalmente à frequência com que são encontrados na natureza. E nós vamos decidir: uns três morrem melhor que uns cinco. Isso soa lógico? Oh bem. Vamos recessar todo esse absurdo infernal , mas temos uma simulação abstrata. Qual é o melhor - matar 50 ou 51 pessoas? 1051 ou 1052? Então isso não é tão importante? Então, o que é melhor - matar 1 pedestre ou 50 pessoas em um ônibus? E agora se tornou importante? E para onde vai essa linha? Toda pessoa extra é valiosa? Mas é importante se milhares de pessoas morrem em acidentes rodoviários a longo prazo? Como no caso da aparência, na realidade, uma estimativa adequada usando IA do número de vítimas em potencial será extremamente difícil. A única coisa que faz sentido é estabelecer uma condição de não intervenção (não manobra) se o número de vítimas for o mesmo.

O terceiro aspecto causou muita controvérsia nos comentários daquele primeiro artigo sobre Habré. E, a julgar pelos resultados do estudo, é completamente ambíguo para a sociedade, e aqui reside o principal problema que precisa ser resolvido. É sobre quem arriscar - pedestres ou passageiros?

Alguns dizem que os pedestres não têm culpa de nada, o que significa que eles devem ser salvos em primeiro lugar. Em geral, agora está na moda entre os urbanistas cuidar de pedestres, fazer ruas inteiras de pedestres, criar travessias com um semáforo a cada 50 metros, reduzir a velocidade do tráfego no centro, dar prioridade aos pedestres. Aqui também é necessário protegê-los de alguma forma, e uma máquina robótica que voa sem freios na multidão deve se autodestruir em nome de salvar os participantes mais vulneráveis do movimento. O que, do meu ponto de vista, eles estão certos é que os pedestres não se inscreveram nas condições de comportamento do carro robô de outra pessoa. Eles podem ser geralmente contra a sua introdução. Ao mesmo tempo, é impossível imaginar o passageiro de uma máquina que não concorda com as condições de uso. Portanto, a situação é um conflito de interesses. É mais conveniente eu te matar e eu vou te matar, como uma pessoa diz para outra.

Os segundos dizem que todo mundo que compra e geralmente entra em um carro robótico deve ter garantias de que ela o salvará em caso de acidente e não matará um médico, uma criança ou dois gatos para salvar uma estrada de travessia. Por um lado, parece lógico e justificado, por outro - o passageiro, nesse caso, coloca sua vida deliberadamente acima dos outros. Ao comprar um carro com piloto automático, cada proprietário tem à sua disposição uma arma perfeita, uma bala de prata, um foguete não guiado, uma máquina que mata completamente legalmente qualquer outra pessoa em seu caminho.

Ambos os lados com espuma na boca encostam a "primeira lei da robótica", tirada da ficção científica. Parece demagogicamente bonito, mas ninguém tenta compreendê-lo ou desafiá-lo em relação ao problema. Mas não é aplicável a essa formulação do problema, porque há uma substituição de conceitos: a heurística / IA da máquina não escolhe entre os valores da vida humana, mas age estritamente de acordo com os algoritmos criados com base nas prioridades subjetivas inventadas pelas pessoas. E aqui não importa absolutamente que tipo de construção social é tomada como prioridade ao escolher "matar / poupar": a massa corporal que rejeitamos anteriormente, idade e status ou o egoísmo social darwinista do proprietário do carro.

A segunda abordagem, sendo um ataque unilateral à vida dos pedestres, transforma a pesquisa de um problema de carrinho em um dilema clássico de prisioneiro . Se as partes chegarem a um acordo, é possível um desenvolvimento geral (introdução de robomobiles) com deterioração mínima para alguns (minimização do número de mortes inevitáveis por robomobiles) - que é o desejo do Pareto ideal. No entanto, sempre existe um egoísta que depende apenas de seus interesses. "Ele terá 20 anos, mas eu serei libertado." "Ele vai morrer atravessando a rua, embora os freios tenham recusado meu carro." Talvez essa abordagem seja justificada quando os eventos são únicos na vida, e há dois participantes no jogo. Quando existem dezenas ou centenas de milhares de participantes, e as viagens são diárias, esse jogo de um objetivo se transformará em discriminação contra pedestres.

Pessoalmente, acredito que, dentro da estrutura do problema formulado, o dilema passageiro / pedestre leva a um beco sem saída. Uma máquina que potencialmente mata quem entrou nela é absurda do ponto de vista do senso comum e, naturalmente, não encontra compradores no mercado. Um carro que mata deliberadamente pedestres é impossível em uma sociedade civilizada como um elemento de discriminação positiva e uma ameaça à vida das pessoas.

Nós vamos além. O artigo não discute realmente e não significa uma política para minimizar as trágicas conseqüências de acidentes envolvendo robomobiles. Os totais são divididos em "regiões", que diferem significativamente em prioridades, e são formados de forma ambígua (há explicações sobre "características religiosas e influência colonial", mas ... em geral, saudações ao Iraque com o Afeganistão no "Oeste" e a França com a República Tcheca no " Setor sul). E, portanto, a pergunta gira no idioma: você fabricará robomobiles com diferentes "éticas" para cada país?

Os autores do artigo na discussão designam os três "blocos fundamentais básicos" identificados por eles: salvar pessoas (não animais), salvar mais vidas, salvar os mais jovens. Mas os diagramas mostram claramente que as pessoas no setor oriental têm um pouco menos de população e juventude do que não se importam. Acontece que as políticas prioritárias selecionadas vão contra a opinião da esmagadora maioria? Por que, então, as pessoas foram questionadas?

Talvez apenas conte?

Mas vamos para a parte divertida deste post.

Em vez de pedir às pessoas com diferentes implicações socioculturais conselhos sobre robótica, e provavelmente 99% delas com educação não essencial, passamos a uma ferramenta imparcial. Vamos dar os dilemas selecionados no início do artigo. Nas condições do teste, criaremos a simulação de computador mais simples. E avaliaremos o número de usuários de estradas mortas.

E lembre-se: nossa tarefa como políticos no campo da segurança dos transportes é reduzir o número total de vítimas. Trabalharemos dentro da estrutura e convenções do teste Moral Machine original, que se concentra no risco à vida dos participantes de acidentes de viação, em vez de avaliações realistas complexas da colisão de um carro com um obstáculo ou pessoas. Não temos EuroNCAP, teremos Python.

Primeiro, escreveremos um código que atenda ao dilema de "salvar aqueles que morrem mais". Como parte do teste da Máquina Moral, fazemos aleatoriamente de 1 a 5 passageiros e pedestres, definimos a condição se os pedestres> passageiros matam imediatamente o carro em um bloco de concreto. Nós carregamos, por exemplo, 10.000 desses acidentes.

Não ouço o código de reivindicação, escrevi algo em Python pela primeira vez na minha vidanpedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

# 1 5

npedtotal += nped

npasstotal += npass

#

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (" ", npedtotal)

print (" ", npasstotal)

print (" ", ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (" ", ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (" ", ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

…

29960

29924

13903 ( 46.4052069426 % )

8030 ( 26.8346477744 %) 21933 ( 36.6258098991 % )

, ! , !

. . , . – , « » 4 5, == . , 20 20 , , , 5 – , 5 – . : , , . > >= :

29981

29865

7859 ( 26.2132684033 % )

14069 ( 47.1086556169 %)

21928 ( 36.6407111586 % )

, occupants, - , . , . 30000 , 100% — .

, , . – , , 50% , 30000.

– . , , , ! , : , , , , , . , : .

, -```python

import random

npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

trafficlight = random.randint(0, 1)

# 1 5

#

npedtotal += nped

npasstotal += npass

#

if trafficlight == 0:

ndeadped += nped

else:

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (« », npedtotal)

print (« », npasstotal)

print (« », ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (« », ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (« », ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

```

">"

29978

29899

21869 ( 72.9501634532 % )

4042 ( 13.5188467842 %)

25911 ( 43.2737111078 % )

">="

30152

30138

19297 ( 63.9990713717 % )

6780 ( 22.4965160263 %)

26077 ( 43.2526123735 % )

, , . ( ).

, . – .

. , , . Moral Machine, , , . - , .

, , , . – , , . . – , , , . , – .

, - , . , , , . – , , .

. . , . .