Apesar da confiabilidade dos data centers modernos, é necessário outro nível crítico de redundância para instalações críticas, porque toda a infraestrutura de TI pode falhar devido a um desastre causado pelo homem ou natural. Para garantir a tolerância a desastres, é necessário construir data centers de backup. Sob o corte, nossa história sobre os problemas decorrentes de sua combinação (DCI - Data Center Interconnection).

Os volumes de dados processados pela humanidade cresceram para valores incríveis, e o papel da infraestrutura de TI nos processos de negócios é tão grande que mesmo falhas de curto prazo podem paralisar completamente a empresa. As tecnologias digitais estão sendo introduzidas em todos os lugares e o setor financeiro, telecomunicações ou, por exemplo, o grande varejo da Internet, depende especialmente delas. A confiabilidade dos datacenters não é suficiente para um grande provedor de nuvem, banco ou grande operadora de telecomunicações: as perdas resultantes de pequenos períodos de inatividade podem ser calculadas em quantidades astronômicas e, para evitá-las, é necessária uma infraestrutura resistente a desastres. Você pode criá-lo apenas aumentando a redundância - você precisa criar data centers de backup.

Separando alta disponibilidade da recuperação de falhas

Os data centers ou equipamentos corporativos instalados nas instalações alugadas podem ser combinados. A tolerância a falhas das soluções distribuídas geograficamente é alcançada por meio da arquitetura de software, e os proprietários podem economizar em suas próprias instalações: eles não precisam construir um data center, por exemplo, um nível de Nível III ou mesmo Nível II. Você pode abandonar os geradores a diesel, usar servidores de estrutura aberta, brincar com condições extremas de temperatura e fazer outros truques interessantes. Há menos graus de liberdade nas áreas alugadas, aqui o provedor determina as regras do jogo, mas os princípios da unificação são os mesmos. Antes de falar sobre serviços de TI resistentes a desastres, vale lembrar três abreviações mágicas: RTO, RPO e RCO. Esses principais indicadores de desempenho determinam a capacidade da infraestrutura de TI de suportar interrupções.

RTO (objetivo do tempo de recuperação) - tempo permitido para recuperar um sistema de TI após um incidente;

RPO (objetivo do ponto de recuperação) - perda de dados aceitável durante a recuperação de desastres. Geralmente é medido como o período máximo durante o qual os dados podem ser perdidos;

O RCO (objetivo de capacidade de recuperação) faz parte da carga de TI que o sistema de backup pode suportar. O último indicador pode ser medido em porcentagens, transações e outros "papagaios".

É importante distinguir entre as soluções de Alta Disponibilidade (HA) e Disaster Recovery (DR). A diferença entre eles pode ser visualizada na forma de um diagrama com RPO e RTO como eixos de coordenadas:

Idealmente, não perdemos dados e não perdemos tempo recuperando de uma falha, e o site de backup garantirá a funcionalidade completa dos serviços, mesmo que o principal seja destruído. Zero RTO e RPO só podem ser alcançados com a operação síncrona de data centers: na verdade, é um cluster tolerante a falhas distribuído geograficamente, com replicação de dados em tempo real e outras alegrias. No modo assíncrono, a integridade dos dados não é mais garantida: como a replicação é feita em intervalos regulares, algumas informações podem ser perdidas. O tempo para mudar para o site de backup, neste caso, é de alguns minutos a várias horas, quando se trata do chamado reserva de frio, quando a maioria dos equipamentos de backup está desligada e não consome eletricidade.

Detalhes técnicos

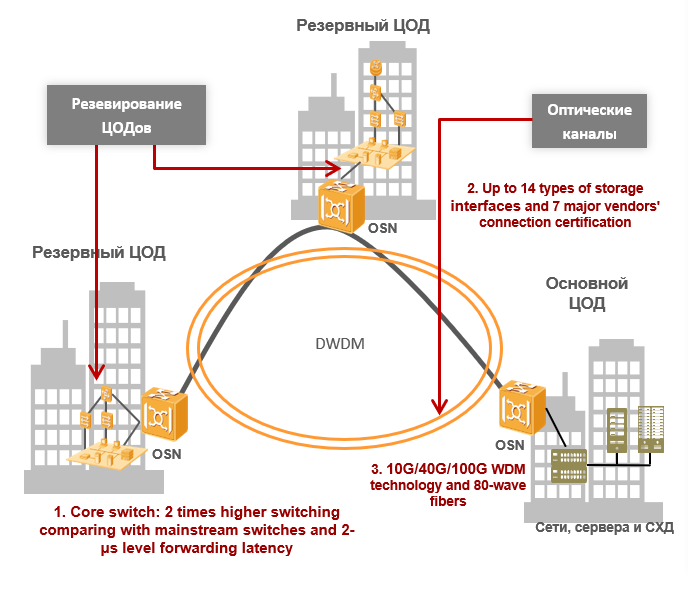

As dificuldades técnicas que surgem ao combinar dois ou mais data centers são divididas em três categorias: atrasos na transmissão de dados, largura de banda insuficiente dos canais de comunicação e problemas de segurança da informação. A comunicação entre os datacenters geralmente é fornecida por linhas de comunicação de fibra óptica próprias ou alugadas, portanto, falaremos sobre eles mais tarde. Para DPCs operando no modo síncrono, o principal problema são os atrasos. Para garantir a replicação dos dados em tempo real, eles não devem exceder 20 milissegundos e, às vezes, 10 milissegundos - depende do tipo de aplicativo ou serviço.

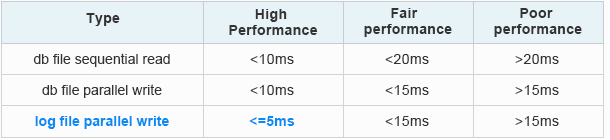

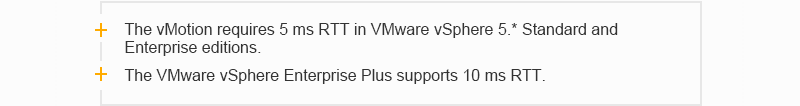

Caso contrário, por exemplo, a família de protocolos Fibre Channel não funcionará, o que é quase impossível sem sistemas de armazenamento modernos. Lá, quanto maior a velocidade, menor o atraso. É claro que existem protocolos que permitem trabalhar com redes de armazenamento via Ethernet, mas aqui depende muito dos aplicativos e equipamentos instalados usados no data center. A seguir, exemplos de requisitos de latência para aplicativos Oracle e VMware comuns:

Requisitos de atraso do Oracle Extended Distance Cluster:

A partir dos dados oficiais da Oracle: Como saber se o IO do banco de dados está lento [ID 1275596.1]

A partir dos dados oficiais da Oracle: Como saber se o IO do banco de dados está lento [ID 1275596.1]Requisitos de atraso do VMware:

Estudo de caso do VMware vSphere Metro Storage Cluster (VMware vSphere 5.0)

Estudo de caso do VMware vSphere Metro Storage Cluster (VMware vSphere 5.0)

Ao transmitir dados, o atraso do sinal pode ser representado na forma de dois componentes: T

total = T

equip. + T

s onde T

equ. - o atraso causado pela passagem do sinal através do equipamento e

Ts - o atraso causado pela passagem do sinal através da fibra óptica. O atraso causado pela passagem do sinal através do equipamento (equipamento T) depende da arquitetura do equipamento e do método de encapsulamento de dados durante a conversão do sinal optoelétrico. Nos equipamentos DWDM, essa funcionalidade é atribuída aos módulos transponder ou muxponder. Portanto, ao organizar a comunicação entre dois data centers, eles são especialmente cuidadosos ao escolher o tipo de transponder (muxponder), para que o atraso no transponder (muxponder) seja menor.

No modo síncrono, a velocidade de propagação do sinal na fibra óptica (

Ts ) desempenha um papel importante. Sabe-se que a velocidade de propagação da luz em uma fibra óptica padrão (por exemplo, G.652) depende do índice de refração de seu núcleo e é aproximadamente igual a 70% da velocidade da luz no vácuo (~ 300.000 km / s). Não vamos nos aprofundar nos fundamentos físicos, mas é fácil calcular que o atraso nesse caso é de cerca de 5 microssegundos por quilômetro. Portanto, dois data centers podem operar de forma síncrona a uma distância de apenas cerca de 100 quilômetros.

No modo assíncrono, os requisitos de atraso não são tão rigorosos, mas se a distância entre os objetos for aumentada, a atenuação do sinal óptico na fibra começará a afetar. O sinal deve ser amplificado e regenerado, ou seja, você deve criar seu próprio sistema de transmissão ou conceder canais de comunicação de tronco. Os volumes de tráfego que passam entre os dois data centers são bastante grandes e tendem a crescer constantemente. Os principais fatores de crescimento do tráfego entre os data centers: virtualização, serviços em nuvem, migração e conexão de novos servidores e sistemas de armazenamento. Aqui você pode encontrar o problema de largura de banda insuficiente dos canais de transmissão de dados. Aumentá-lo para o infinito não funcionará devido à falta de suas próprias fibras livres ou ao alto custo do aluguel. O último ponto importante está relacionado à segurança da informação: os dados em execução entre os data centers devem ser criptografados, o que também aumenta os atrasos. Existem outros pontos, como a complexidade de administrar um sistema distribuído, mas a influência deles não é tão grande e todos os obstáculos técnicos estão relacionados principalmente às características dos canais de comunicação e equipamentos terminais.

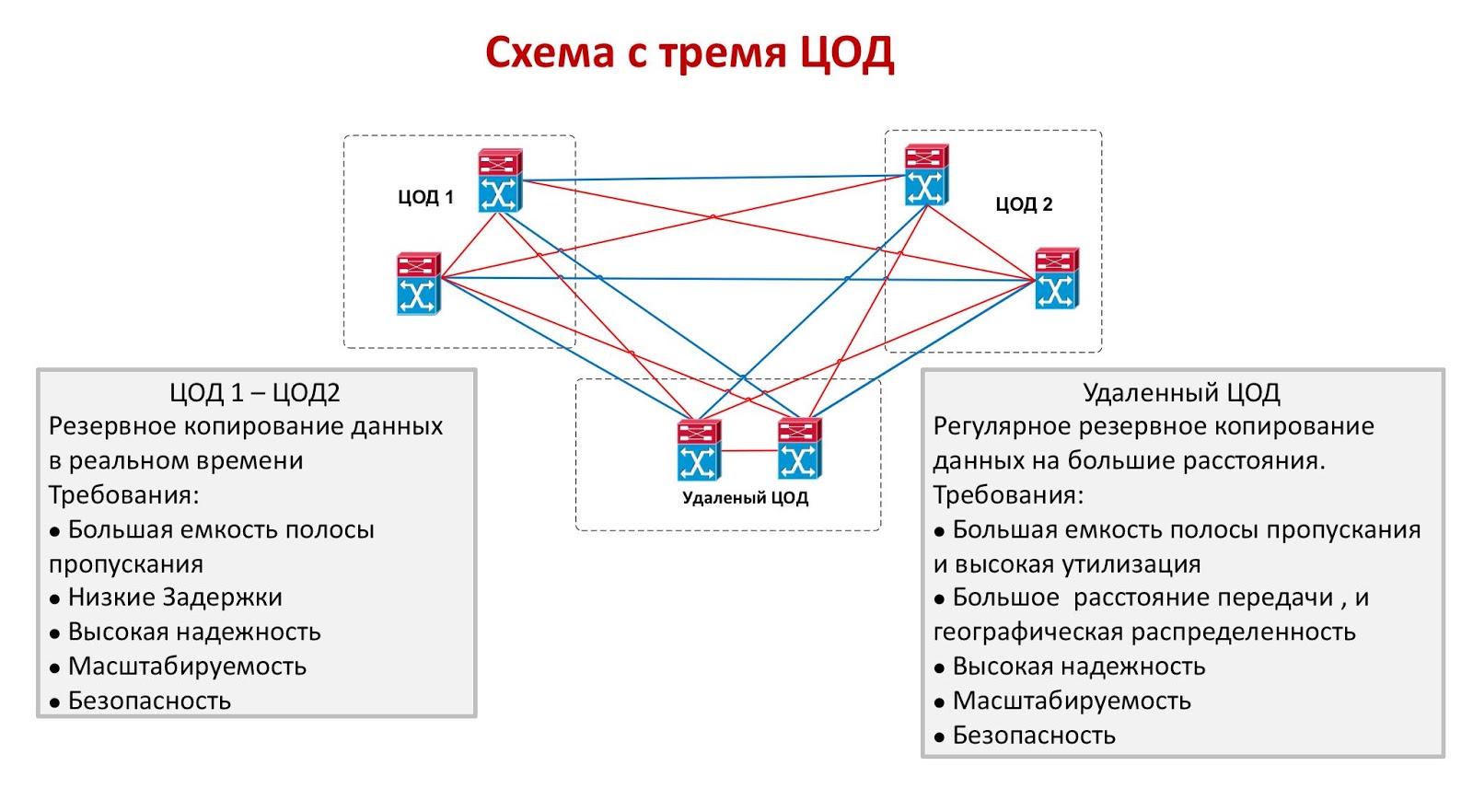

Dois ou três são dificuldades econômicas

Ambos os modos de combinar data centers têm desvantagens significativas. Os objetos em operação síncrona devem estar localizados próximos um do outro, o que não garante a sobrevivência de pelo menos um deles no caso de um desastre em larga escala. Sim, esta opção é protegida de maneira confiável contra erros humanos, incêndio, destruição da casa das máquinas como resultado de um acidente de avião ou de outra emergência local, mas está longe de ser fato que os dois data centers possam suportar, por exemplo, um terremoto catastrófico. No modo assíncrono, os objetos podem ser espaçados a milhares de quilômetros, mas garantirá que os valores aceitáveis de RTO e RPO falhem. Uma solução ideal seria um circuito com três centros de dados, dois dos quais funcionam de forma síncrona, e o terceiro está localizado o mais longe possível deles e desempenha o papel de uma reserva assíncrona.

O único problema com os três data centers é seu custo extremamente alto. A organização de até um site de backup não é barata e poucos podem se dar ao luxo de manter dois data centers inativos. Uma abordagem semelhante às vezes é usada no setor financeiro se o custo da transação for muito alto: uma grande bolsa de valores pode lançar um esquema com três pequenos datacenters, mas no setor bancário eles preferem usar uma combinação síncrona dos dois. Outras indústrias geralmente combinam dois data centers operando no modo síncrono ou assíncrono.

DWDM - Solução ideal para DCI

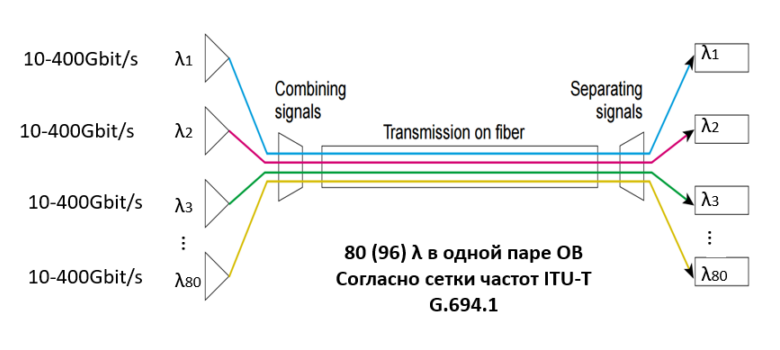

Se o cliente precisar combinar os dois data centers, ele inevitavelmente encontrará os problemas acima. Para resolvê-los, usamos a tecnologia de multiplexação espectral DWDM, que permite a multiplexação de vários sinais portadores em uma fibra óptica usando diferentes comprimentos de onda (λ, isto é, lambda). Além disso, em um par óptico, pode haver até 80 (96) comprimentos de onda de acordo com a grade de frequência ITU-T G.694.1. A taxa de transferência de dados de cada comprimento de onda é de 100 Gbit / s, 200 Gbit / s ou 400 Gbit / s, e a capacidade de um par óptico pode atingir 80 λ * 400 Gbit / s = 32 Tbit / s. Já existem projetos prontos que fornecem 1 Tbit / s por comprimento de onda: eles fornecerão uma largura de banda ainda maior no futuro próximo. Hoje, ele resolve completamente o problema de largura de banda do canal: em vez de fibras adicionais, o cliente usará as disponíveis com mais eficiência - a utilização do tráfego alcançará valores fantásticos.

A multiplexação espectral permite resolver problemas de largura de banda e, para data centers que operam no modo síncrono, isso é suficiente, porque os atrasos na transmissão de dados entre eles são pequenos devido à pequena distância e dependem mais do tipo de transponder (ou muxponder) usado no sistema DWDM. Vale ressaltar uma das principais características da tecnologia de compressão espectral DWDM: transferência de tráfego completamente transparente, devido ao fato de que a tecnologia funciona no primeiro nível físico do modelo OSI de sete níveis. Se assim posso dizer, o sistema DWDM é "transparente" para as conexões do cliente, como se estivessem conectados por um cabo de conexão direto. Se falamos sobre o modo assíncrono, a principal quantidade de atraso depende da distância entre os data centers (lembramos que no OB há um atraso de 5 microssegundos por quilômetro), mas não há requisitos estritos para atrasos. Portanto, o alcance da transmissão é determinado pelas capacidades do sistema DWDM e é limitado por três fatores: atenuação do sinal, razão sinal-ruído e dispersão de luz no modo de polarização.

Ao calcular a parte óptica da linha DWDM, todos esses fatores são levados em consideração e, com base nos cálculos, são selecionados os tipos de transponders (ou muxponders), o número e o tipo de amplificadores necessários, além de outros componentes do caminho óptico. Com o desenvolvimento de sistemas DWDM e o surgimento de transponders em sua composição que suportam recepção coerente a velocidades de 40 Gbit / se 100 Gbit / s e superiores, a dispersão da luz no modo de polarização como fator limitador deixou de ser levada em consideração. A questão de calcular a linha óptica e escolher o tipo de amplificador é um tópico separado e amplo que requer que o leitor conheça o básico da óptica física, e não a discutiremos em detalhes neste artigo.

A tecnologia WDM pode resolver problemas de segurança da informação. Obviamente, a criptografia não precisa ser realizada no nível óptico, mas essa abordagem tem várias vantagens inegáveis. A criptografia em níveis mais altos geralmente requer dispositivos autônomos para diferentes fluxos de tráfego e contribui para atrasos significativos. Com o aumento do número desses dispositivos, os atrasos também aumentam e a complexidade do gerenciamento de rede também aumenta. A criptografia óptica OTN (G.709 - recomendação ITU-T que descreve o formato do quadro nos sistemas DWDM) não depende do tipo de serviço, não requer dispositivos separados e é muito rápida - a diferença entre o fluxo de dados criptografado e não criptografado geralmente não excede 10 milissegundos.

Sem o uso da tecnologia de multiplexação espectral DWDM, é quase impossível combinar grandes data centers e criar um cluster distribuído à prova de desastres. Os volumes de informações transmitidas pela rede estão crescendo exponencialmente e, mais cedo ou mais tarde, as possibilidades das linhas de comunicação de fibra óptica existentes serão esgotadas. Colocar ou alugar outros itens custará ao cliente muito mais do que comprar equipamentos; na verdade, hoje, a vedação é a única opção economicamente viável. A curtas distâncias, as tecnologias DWDM tornam possível o uso mais eficiente das fibras ópticas existentes, aumentando a utilização do tráfego para o céu e, a longas distâncias, elas também minimizam os atrasos na transmissão de dados. Hoje é talvez a melhor tecnologia disponível no mercado e vale a pena dar uma olhada mais de perto.