Por várias semanas, o especialista em ciência da computação Siwei Lyu assistiu aos vídeos do deepfake criados por sua equipe com uma preocupação atormentadora. Esses filmes falsos feitos com o algoritmo de aprendizado de máquina mostraram celebridades fazendo coisas que não fariam. Eles pareciam estranhamente assustadores para ele, e não apenas porque ele sabia que eles eram falsos. "Eles parecem errados", lembra ele, "mas é muito difícil identificar exatamente o que causa essa impressão".

Mas uma vez em seu cérebro veio uma lembrança de infância. Como muitas outras crianças, ele jogava "peepers" com crianças. "Eu sempre perdia essas competições", diz ele, "porque, quando olhei para os rostos sem piscar, me senti muito desconfortável."

Ele percebeu que esses filmes falsos lhe causavam um desconforto semelhante: ele brincava de espionar essas estrelas de cinema, porque elas não abriam ou fechavam os olhos com tanta frequência quanto as pessoas reais.

Para descobrir o porquê, Luy, um professor da Albany University, e sua equipe estudaram cada etapa do software

DeepFake que criou esses vídeos.

Os programas do Deepfake capturam muitas imagens de uma pessoa específica na entrada - você, sua ex-namorada, Kim Jong-un - para que possam ser vistas de diferentes ângulos, com diferentes expressões faciais que dizem palavras diferentes. Os algoritmos aprendem como esse personagem se parece e depois sintetizam o conhecimento adquirido em um vídeo, mostrando como essa pessoa faz o que nunca fez.

Pornografia Stephen Colbert falando as palavras de John Oliver. Presidente

alerta sobre os perigos de vídeos falsos.

Esses vídeos parecem convincentes por alguns segundos na tela do telefone, mas são (ainda não) perfeitos. Eles podem ser vistos sinais de falsificação, por exemplo, de uma maneira estranha, olhos constantemente abertos, decorrentes das deficiências do processo de sua criação. Olhando para as entranhas do DeepFake, Lu percebeu que entre as imagens estudadas pelo programa, não havia tantas fotos de olhos fechados (porque você não mantém uma selfie na qual pisca?). "Isso se torna uma distorção", diz ele. Rede neural não entende piscar. Os programas também podem perder outros "sinais fisiológicos inerentes às pessoas", disse Luya, que descreve esse fenômeno - respirar na velocidade normal ou na presença de um pulso. Embora este estudo tenha se concentrado em comerciais criados usando software específico, é geralmente aceito que mesmo um grande conjunto de fotografias pode não ser capaz de descrever adequadamente a percepção física de uma pessoa, portanto, qualquer software treinado nessas imagens será imperfeito.

A revelação sobre piscar revelou muitos vídeos falsos. Mas algumas semanas depois que Lu e a equipe publicaram um rascunho do trabalho on-line, eles receberam uma carta anônima contendo links para os próximos vídeos falsos postados no YouTube, onde as estrelas abriram e fecharam os olhos de um modo mais normal. Criadores falsos evoluíram.

E isso é natural. Como Lu observou em

uma entrevista ao The Conversation, "pode-se adicionar piscar aos vídeos do deepfake, incluindo imagens com os olhos fechados no banco de dados ou usando vídeos para treinar". Sabendo qual é o sinal de falsificação, você pode evitá-lo - este é "apenas" um problema técnico. O que significa que vídeos falsos se envolverão em uma corrida armamentista entre criadores e reconhecedores. Pesquisas como o trabalho de Luy só podem complicar a vida de fabricantes falsos. "Estamos tentando elevar a fasquia", diz ele. "Queremos complicar esse processo, para torná-lo mais demorado".

Porque agora é muito simples. Faça o download do programa, pesquise fotos de celebridades no Google e alimente-os na entrada do programa. Ela os digere, aprende com eles. E embora ela ainda não seja completamente independente, com uma pequena ajuda, ela dá à luz e dá à luz algo novo e bastante real.

"Ela é muito embaçada", diz Lu. E ele não significa imagens. "Essa linha é entre verdade e falsidade", disse ele.

Isso simultaneamente irrita e não surpreende quem está vivo recentemente e está navegando na Internet. Mas isso preocupa especialmente os departamentos militar e de inteligência. Em particular, é por isso que os estudos de Lu, como alguns outros trabalhos, são financiados por um

programa da DARPA chamado MediFor - Media Forensics [mídia forense].

O projeto MediFor foi lançado em 2016, quando a agência notou um aumento na atividade dos fabricantes de falsificações. O projeto está tentando criar um sistema automatizado que estuda três níveis de sinais falsos e produz uma "avaliação da realidade" de uma imagem ou vídeo. No primeiro nível, são pesquisadas faixas digitais sujas - ruído de uma câmera de um determinado modelo ou artefato de compressão. O segundo nível é físico: a iluminação não está no rosto, o reflexo não parece com o que deveria parecer com esse arranjo da lâmpada. O último é semântico: comparando dados com informações reais confirmadas. Se, por exemplo, se afirmar que o vídeo que capturou o jogo de futebol foi filmado no Central Park às 14h de terça-feira, 9 de outubro de 2018, a condição do céu coincide com o arquivo meteorológico? Reúna todos os níveis e faça uma avaliação da realidade dos dados. A DARPA espera que até o final do MediFor existam protótipos de sistemas com os quais será possível organizar verificações em larga escala.

No entanto, o relógio está correndo (ou é apenas um som repetido criado por uma IA treinada em dados relacionados ao controle de tempo?) "Em alguns anos, você poderá encontrar coisas como fabricação de eventos", diz Matt Turek, gerente de programa da DARPA. "Não é apenas uma imagem ou vídeo editado, mas várias imagens ou clipes que tentam transmitir uma mensagem atraente."

O cientista da computação Juston Moore tem uma imagem mais clara do futuro potencial no Laboratório Nacional de Los Alamos. Digamos: informamos ao algoritmo que precisamos de um vídeo no qual Moore rouba uma farmácia; nós o apresentamos nas gravações de vídeo do sistema de segurança desta instituição; mande-o para a cadeia. Em outras palavras, ele está preocupado que, se os padrões de verificação de evidências não se desenvolverem (ou não puderem) paralelamente à fabricação de falsificações, será fácil substituir as pessoas. E se os tribunais não puderem confiar em dados visuais, pode acontecer que evidências reais sejam ignoradas.

Chegamos à conclusão lógica de que ver uma vez não será melhor do que ouvir cem vezes. "Pode acontecer que não confiemos em nenhuma evidência fotográfica", diz ele, "mas não quero viver em um mundo assim".

Um mundo assim não é tão incrível. E o problema, segundo Moore, vai muito além da substituição de indivíduos. “Algoritmos podem

criar imagens de pessoas que não pertencem a pessoas reais; eles podem alterar imagens estranhamente, transformando um

cavalo em uma zebra ”, diz Moore. Eles podem

remover partes de imagens e

remover objetos em primeiro plano

do vídeo .

Talvez não consigamos lidar com as falsificações mais rapidamente do que elas serão feitas. Mas talvez dê certo - e essa oportunidade fornece motivação para a equipe de Moore estudar métodos digitais para estudar evidências. O programa Los Alamos, que combina conhecimento de sistemas cibernéticos, sistemas de informação, biologia teórica e biofísica, é cerca de um ano mais novo que a agência DARPA. Uma abordagem se concentra na “compressibilidade”, nos casos em que a imagem contém menos informações do que parece. "Basicamente, construímos a ideia de que todos os geradores de imagens de IA têm um conjunto limitado de coisas que podem criar", diz Moore. "Portanto, mesmo que a imagem pareça bastante complicada para mim ou para você, você pode encontrar uma estrutura repetitiva nela". Ao reciclar pixels, não resta muito.

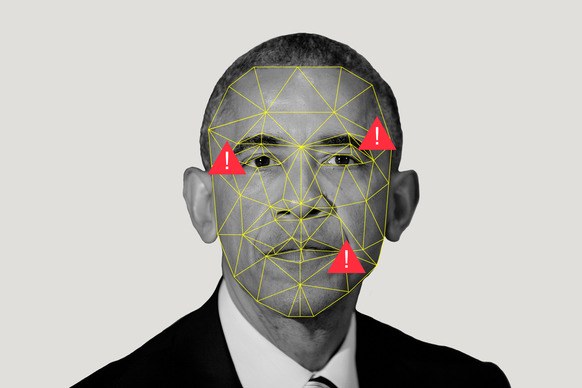

Eles também usam algoritmos de codificação esparsos para jogar o jogo com partidas. Digamos que temos duas coleções: um monte de imagens reais e um monte de imagens de IA criadas artificialmente. O algoritmo os estuda, criando o que Moore chama de "dicionário de elementos visuais", observando que imagens artificiais têm algo em comum e que imagens reais têm algo em comum. Se o amigo de Moore retweetar a imagem de Obama, e Moore considerar que a imagem foi criada usando AI, ele será capaz de direcioná-la através do programa e descobrir qual dicionário estará mais próximo.

Los Alamos, onde está localizado um dos supercomputadores mais poderosos do mundo, carrega recursos para este programa não apenas porque alguém pode substituir Moore por um assalto falso. A missão do laboratório é "resolver problemas de segurança nacional com a ajuda da excelência científica". Sua principal tarefa é a segurança nuclear, fornecendo garantias de que as bombas não explodirão quando não deveriam e explodir quando deveriam (por favor, não), além de assistência na não proliferação. Tudo isso requer um conhecimento geral de aprendizado de máquina, porque ajuda, como Moore diz, "a tirar grandes conclusões de pequenos conjuntos de dados".

Mas, além de tudo isso, empresas como Los Alamos devem ser capazes de acreditar em seus olhos - ou saber quando não precisam ser confiáveis. Porque, e se você vir imagens de satélite de como um país mobiliza ou testa armas nucleares? E se alguém falsificar as leituras do sensor?

É um futuro assustador que o trabalho de Moore e Lu deva ser idealmente evitado. Mas em um mundo onde tudo está perdido, ver não significa acreditar, mas medidas aparentemente absolutas podem ser falsas. Tudo digital está em dúvida.

Mas talvez "dúvida" seja a palavra errada. Muitas pessoas aceitam falsificações pelo valor de face (lembra-se da

foto de um tubarão em Houston?), Especialmente se o conteúdo corresponder às suas crenças. "As pessoas vão acreditar no que tendem a acreditar", diz Moore.

A probabilidade disso é maior para o público em geral que assiste às notícias do que no campo da segurança nacional. E, para evitar a disseminação de informações erradas entre nós, a DARPA oferece colaboração nas mídias sociais, na tentativa de ajudar os usuários a determinar que a credibilidade do vídeo em que Kim Jong-un dança macaroons é bastante baixa. Turek ressalta que as redes sociais podem espalhar a história refutando o vídeo tão rápido quanto o próprio vídeo.

Mas eles vão fazer isso? A exposição é um processo

problemático (embora não tão

ineficiente quanto o boato). E as pessoas precisam realmente mostrar os fatos antes que possam mudar de idéia sobre a ficção.

Mas mesmo que ninguém possa mudar a opinião das massas sobre a veracidade do vídeo, é importante que as pessoas que tomam decisões políticas e legais - sobre quem está transportando foguetes ou matando pessoas - tentem usar máquinas para separar a realidade aparente do sono da IA.