capítulos anteriores

Curvas de aprendizado

28 Diagnosticando viés e dispersão: curvas de aprendizado

Examinamos várias abordagens para a separação de erros em desvios e dispersões evitáveis. Fizemos isso avaliando a proporção ideal de erros, calculando erros na amostra de treinamento do algoritmo e na amostra de validação. Vamos discutir uma abordagem mais informativa: gráficos de curva de aprendizado.

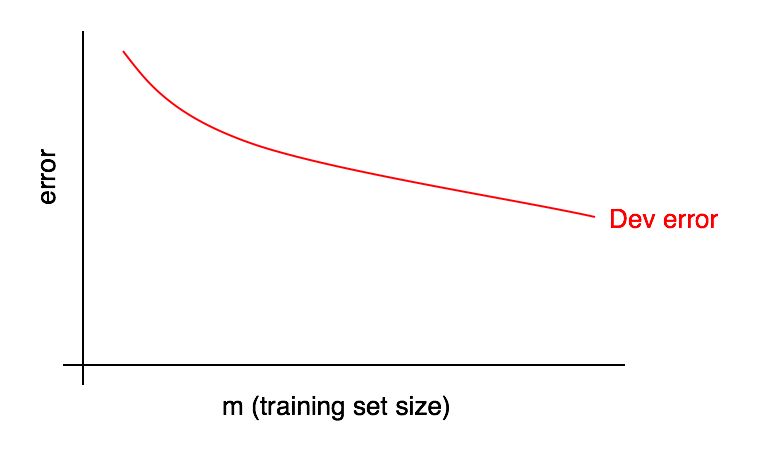

Os gráficos das curvas de aprendizado são dependências da parcela do erro no número de exemplos da amostra de treinamento.

À medida que o tamanho da amostra de treinamento aumenta, o erro na amostra de validação deve diminuir.

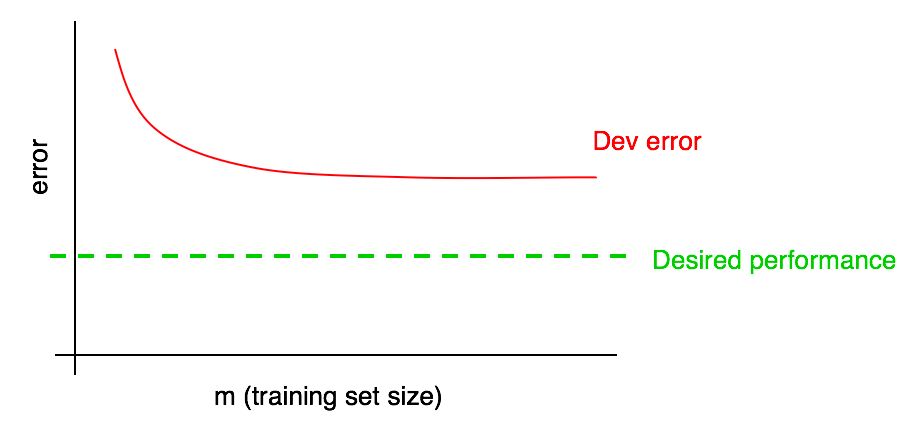

Frequentemente, focaremos em algum "compartilhamento de erros desejado" que esperamos que eventualmente atinja nosso algoritmo. Por exemplo:

- Se esperamos alcançar um nível de qualidade acessível ao homem, a parcela de erros humanos deve se tornar a "parcela desejada de erros"

- Se o algoritmo de aprendizado for usado em algum produto (como um fornecedor de imagens de gatos), podemos entender o nível de qualidade que você precisa alcançar para que os usuários obtenham o máximo benefício

- Se você trabalha em um aplicativo importante há muito tempo, pode ter uma compreensão razoável de qual progresso pode fazer no próximo trimestre / ano.

Adicione o nível de qualidade desejado à nossa curva de aprendizado:

Você pode extrapolar visualmente a curva de erro vermelho na amostra de validação e assumir o quanto mais próximo você poderia chegar do nível de qualidade desejado, adicionando mais dados. No exemplo mostrado na figura, parece provável que dobrar o tamanho da amostra de treinamento atingirá o nível de qualidade desejado.

No entanto, se a curva da fração do erro da amostra de validação atingir um platô (isto é, se transformar em uma linha reta paralela ao eixo da abcissa), isso indica imediatamente que a adição de dados adicionais não ajudará a alcançar a meta:

Uma análise da curva de aprendizado pode ajudá-lo a evitar desperdiçar meses coletando o dobro de dados de treinamento apenas para perceber que adicioná-los não ajuda.

Uma das desvantagens dessa abordagem é que, se você observar apenas a curva de erro na amostra de validação, poderá ser difícil extrapolar e prever com precisão como a curva vermelha se comportará se você adicionar mais dados. Portanto, há outro gráfico adicional que pode ajudar a avaliar o impacto de dados de treinamento adicionais na proporção de erros: um erro de aprendizado.

29 Cronograma de erros de aprendizagem

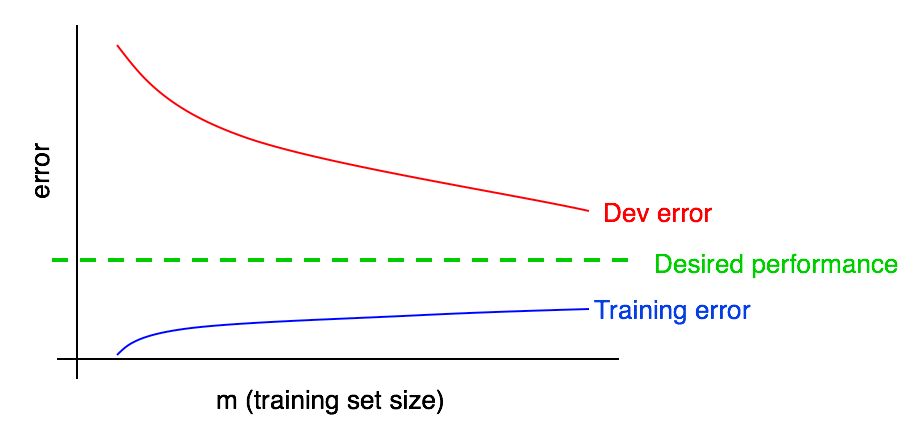

Os erros nas amostras de validação (e teste) devem diminuir à medida que a amostra de treinamento aumenta. Mas na amostra de treinamento, o erro na adição de dados geralmente aumenta.

Vamos ilustrar esse efeito com um exemplo. Suponha que sua amostra de treinamento consista em apenas 2 exemplos: Uma foto com gatos e outra sem gatos. Nesse caso, o algoritmo de aprendizado pode se lembrar facilmente dos dois exemplos da amostra de treinamento e mostrar 0% de erro na amostra de treinamento. Mesmo que os dois exemplos de treinamento sejam rotulados incorretamente, o algoritmo se lembrará facilmente de suas classes.

Agora imagine que seu conjunto de treinamento consiste em 100 exemplos. Suponha que um certo número de exemplos seja classificado incorretamente ou seja impossível estabelecer uma classe em alguns exemplos, por exemplo, em imagens borradas, quando mesmo uma pessoa não pode determinar se um gato está presente na imagem ou não. Suponha que o algoritmo de aprendizado ainda "lembre" a maioria dos exemplos de amostra de treinamento, mas agora é mais difícil obter uma precisão de 100%. Aumentando a amostra de treinamento de 2 para 100 exemplos, você descobrirá que a precisão do algoritmo na amostra de treinamento diminuirá gradualmente.

No final, suponha que seu conjunto de treinamento seja composto por 10.000 exemplos. Nesse caso, torna-se cada vez mais difícil para o algoritmo classificar idealmente todos os exemplos, especialmente se o conjunto de treinamento contiver imagens borradas e erros de classificação. Portanto, seu algoritmo funcionará pior em uma amostra de treinamento.

Vamos adicionar um gráfico de erro de aprendizado aos anteriores.

Você pode ver que a curva azul "Erros de aprendizado" cresce com um aumento na amostra de treinamento. Além disso, um algoritmo de aprendizado geralmente mostra melhor qualidade em uma amostra de treinamento do que em uma amostra de validação; portanto, a curva de erro vermelha na amostra de validação está estritamente acima da curva de erro azul na amostra de treinamento.

A seguir, vamos discutir como interpretar esses gráficos.

continuação