Jesse Bataglia mantém seu filho Bennett em sua casa em Ranch Mirage, Califórnia. Em busca de uma nova babá, Bataglia começou a usar o Predictim, um serviço on-line que supostamente usa "inteligência artificial avançada" para avaliar os riscos de que a babá seja viciada em drogas, se comporte de maneira agressiva ou mostre "más maneiras".

Jesse Bataglia mantém seu filho Bennett em sua casa em Ranch Mirage, Califórnia. Em busca de uma nova babá, Bataglia começou a usar o Predictim, um serviço on-line que supostamente usa "inteligência artificial avançada" para avaliar os riscos de que a babá seja viciada em drogas, se comporte de maneira agressiva ou mostre "más maneiras".Quando Jesse Bataglia começou a procurar uma nova babá para o filho de um ano, ela queria obter mais informações sobre o funcionário do que a ausência de antecedentes criminais, comentários dos pais e entrevistas pessoais. Portanto, ela se voltou para o serviço online Predictim, usando “inteligência artificial avançada” para avaliar a identidade da babá, e enviou seus scanners para milhares de postagens no Facebook, Twitter e Instagram de um dos candidatos.

O sistema introduziu uma "avaliação de risco" automática de uma menina de 24 anos, alegando que o risco de usar seus medicamentos era "muito pequeno". No entanto, o sistema classificou o risco de intimidação, agressão, desrespeito e má educação um pouco mais alto - em 2 de 5.

O sistema não explica suas decisões. No entanto, Bataglia, que considerava a babá completamente confiável, de repente começou a duvidar. "A mídia social mostra a identidade de uma pessoa", disse Bataglia, agora com 29 anos e morando em um subúrbio de Los Angeles. "Por que a pontuação é 2, não 1?"

A Predictim oferece aos pais os mesmos serviços que dezenas de outras empresas de tecnologia vendem para empregadores em todo o mundo: sistemas de IA que analisam a fala humana, expressões faciais e histórico de presença on-line, prometendo descobrir os aspectos secretos de suas vidas pessoais.

A tecnologia está mudando a maneira como algumas empresas procuram candidatos, contratam e avaliam trabalhadores, oferecendo aos empregadores uma avaliação incomparável dos candidatos por meio de uma nova onda de avaliações e vigilância psicológicas invasivas.

A Fama afirma que está usando a IA para monitorar as redes sociais dos trabalhadores em busca de "comportamento tóxico" para alertar seus chefes. A HireVue, uma empresa de tecnologia de recrutamento que trabalha com empresas como Geico, Hilton e Unilever, oferece um sistema que analisa automaticamente o tom do candidato, a escolha de palavras e as expressões faciais durante uma entrevista em vídeo e prevê suas habilidades e maneiras (para oferecer melhores resultados, os candidatos são oferecidos mais sorriso).

Os críticos, no entanto, argumentam que sistemas como o Predictim carregam um perigo em si mesmos, deixando soluções automáticas que podem mudar a vida de uma pessoa sem nenhuma verificação.

Os sistemas dependem de algoritmos baseados em caixa preta que quase não produzem detalhes sobre como eles reduziram todos os detalhes complexos da vida interior de uma pessoa ao cálculo de seus lados positivo e negativo. E embora a tecnologia Predictim afete o pensamento dos pais, ela permanece completamente não comprovada, quase inexplicável e vulnerável a distorções perceptivas relacionadas a como exatamente a babá certa deve se comportar nas redes sociais, olhar e falar.

Há "uma corrida louca para controlar a IA e tomar todos os tipos de decisões sem nenhum relatório para as pessoas", disse Jeff Chester, diretor executivo do Center for Digital Democracy, um grupo de defesa da tecnologia. "Parece que as pessoas ficaram bêbadas com refrigerante digital e acham que é uma maneira normal de gerenciar nossas vidas."

O processo de digitalização Predictim analisa todo o comportamento das babás nas redes sociais, que para muitas das babás mais jovens podem capturar a maior parte de suas vidas. Ao mesmo tempo, as babás são informadas de que, se se recusarem a realizar tal exame, isso será uma séria desvantagem na competição por empregos.

O CEO e co-fundador da Predictim, Sal Parsa, disse que a empresa, lançada no mês passado como parte da incubadora tecnológica da Universidade da Califórnia em Berkeley, na SkyDeck, leva a sério as questões éticas do uso de sua tecnologia. Ele disse que os pais devem considerar a classificação como consultora, o que "talvez reflita e talvez não reflita as características reais da babá".

Ele acrescentou que o perigo de contratar uma babá problemática ou violenta faz da IA uma ferramenta essencial para qualquer pai que tenta manter seu filho seguro.

"Pesquise no Google por abuso de babás e você encontrará centenas de resultados", disse ele. - Há pessoas com doença mental ou apenas com raiva. Nosso objetivo é fazer tudo ao nosso alcance para detê-los. ”

O custo da digitalização do Predictim começa em US $ 24,99 e, para ela, você precisa informar o nome e o e-mail da babá em potencial, além de obter o consentimento dela para um amplo acesso a suas contas nas redes sociais. A babá pode recusar e, em seguida, os pais recebem uma notificação sobre isso, e a própria babá recebe uma carta dizendo que "o pai que estava interessado em você não poderá contratá-lo até que você cumpra a solicitação".

Os gerentes previsíveis dizem que usam algoritmos para processar linguagem e imagens, “visão computacional”, avaliar postagens de babá no Facebook, Twitter e Instagram e procurar pistas sobre sua vida offline. O relatório é recebido apenas pelos pais, que não precisam compartilhar seus resultados com a babá.

Os pais provavelmente podem dar uma olhada nas contas públicas de babá nas redes sociais. No entanto, os relatórios de computador prometem fazer uma avaliação profunda dos anos de atividade on-line, reduzidos a uma única figura: uma solução tentadoramente simples para uma tarefa quase impossível.

As avaliações de risco se enquadram em várias categorias, incluindo conteúdo aberto e abuso de drogas. A startup também afirma na publicidade que seu sistema é capaz de avaliar outras características da personalidade da babá, como polidez, capacidade de trabalhar com outras pessoas e "positividade".

A empresa espera revolucionar a indústria multibilionária de “terceirizar as responsabilidades dos pais” e já começou a anunciar patrocinando blogs e sites de pais para “mães”. A estratégia de marketing concentra-se na oportunidade declarada de revelar segredos e impedir o "pesadelo de qualquer pai ou mãe", e o anúncio cita casos criminais, incluindo, por exemplo, o caso de uma babá de Kentucky condenada por danos corporais graves a uma criança de oito meses de idade.

"Se os pais dessa garota afetada pela enfermeira pudessem usar o Predictim no processo de aprovação de candidatos", diz a declaração de marketing da empresa, "eles nunca a deixariam em paz com seu precioso filho".

No entanto, especialistas em tecnologia dizem que o sistema emite avisos por conta própria, aproveitando os medos dos pais para vender resultados de varredura de personalidade com precisão não verificada.

Eles também levantam questões sobre como esses sistemas são treinados e quão vulneráveis são a erros que podem surgir das incertezas associadas ao uso de redes sociais pelas babás. Os pais recebem apenas um aviso sobre comportamento dúbio, sem certas frases, links ou outros detalhes pelos quais possam tomar sua decisão.

Quando um exame de uma babá emitiu um aviso sobre uma possível perseguição da parte dela, uma mãe empolgada que solicitou essa avaliação disse que não conseguia descobrir se o programa notou uma citação de um filme, música ou outra frase antiga que ela usou para declarações realmente perigosas .

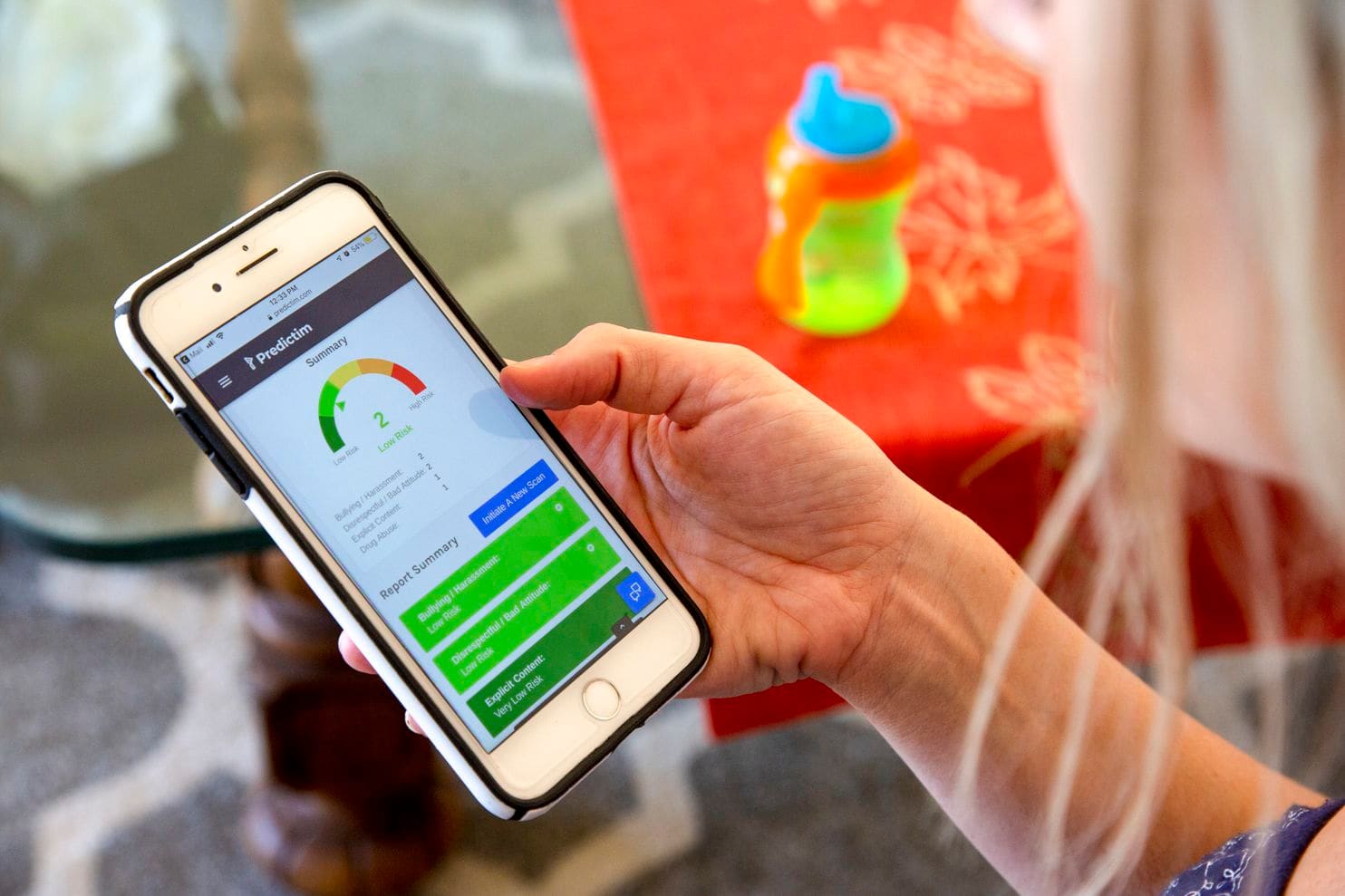

O telefone de Jesse demonstra os resultados do aplicativo Predictim

O telefone de Jesse demonstra os resultados do aplicativo PredictimJamie Williams, advogado da Electronic Frontier Foundation, um grupo de direitos civis, disse que a maioria dos algoritmos usados hoje para avaliar o significado de palavras e fotografias não possui um contexto humano e bom senso. Até gigantes da tecnologia como o Facebook tiveram dificuldade em criar algoritmos que pudessem distinguir entre comentários inócuos e irritados.

“Como você pode experimentar esse sistema de avaliação de adolescentes: eles são crianças! - disse Williams. - As crianças têm suas próprias piadas, são famosas pelo sarcasmo. "O que uma pessoa pode pensar no algoritmo como" maus modos "pode ser considerado uma declaração política ou uma crítica legítima".

E quando o sistema estiver errado - digamos, dizendo que a babá está abusando de drogas - os pais não serão capazes de descobrir o erro. Classificações e avaliações claras da precisão do sistema podem fazer com que os pais esperem dele muito mais precisão e autoritarismo do que uma pessoa em seu lugar poderia prometer. Como resultado, os pais tendem a contratar babás que, de outra forma, evitariam ou afastar-se de pessoas que já conquistaram sua confiança.

"Não há métrica que possa dizer com precisão se esses métodos são tão eficazes em suas previsões quanto os criadores afirmam", disse Miranda Bogen, analista chefe do think tank de Upturn, em Washington, que estuda o uso de algoritmos para tomada e decisão automáticas de decisão. . "O apelo dessas tecnologias provavelmente superará suas reais capacidades".

Malissa Nielsen, uma babá de 24 anos que trabalha para Bataglia, recentemente deu a outras duas famílias acesso a suas redes sociais para avaliação no Predictim. Ela disse que sempre foi cautelosa com as redes sociais e decidiu que poderia compartilhar informações adicionais sem se machucar. Ela frequenta a igreja semanalmente, não jura e termina de receber a educação de um professor no campo de ensino de crianças pequenas, após o qual espera abrir um jardim de infância.

No entanto, quando soube que o sistema não lhe dava notas ideais com base no desrespeito e no bullying, ela ficou impressionada. Ela acreditava que permitir que os pais estudassem sua presença nas redes sociais, e não o algoritmo - uma análise crítica de sua personalidade. Ela também não foi informada dos resultados de um teste que poderia potencialmente danificar sua única fonte de renda.

“Gostaria de entender um pouco essa questão. Por que esse programa pensou em mim assim? - disse Nielsen. "O computador não tem sentimentos; não pode detectar tudo isso."

Os americanos ainda não confiam em algoritmos cujas decisões podem afetar suas vidas diárias. Em uma pesquisa realizada no Pew Research Center neste mês, 57% dos entrevistados classificaram o processamento automático de currículos para candidatos a emprego como "inaceitável".

No entanto, a Predictim relata que eles estão se preparando para expandir o trabalho em todo o país. Os gerentes do Sittercity, um serviço de babá online visitado por milhões de pais, estão falando sobre o lançamento de um programa piloto que integrará as classificações automáticas da Predictim ao conjunto atual de classificações e verificações automáticas de serviços.

"Encontrar uma babá é repleta de incertezas", disse Sandra Dainora, chefe de produtos da Sittercity, que acredita que essas ferramentas podem se tornar padrão em pesquisas on-line para profissionais de saúde. "Os pais estão em constante busca da melhor solução, da pesquisa mais completa e dos fatos mais confiáveis".

Os gerentes de previsão também acreditam que podem expandir seriamente as capacidades do sistema e oferecer ainda mais avaliações pessoais da vida privada da babá. Joel Simonov, diretor de tecnologia, disse que a equipe está interessada em obter "dados psicométricos úteis" com base na análise da atividade de babás em redes sociais, passando suas histórias através de um teste de identidade, por exemplo, a tipologia de Myers-Briggs, para fornecer esses resultados aos pais.

A mineração de mídia social e o interesse da Predictim na análise psicológica de massa são semelhantes às ambições da Cambridge Analytica, uma empresa de consultoria política que trabalhou para apoiar a campanha de Trump e depois chamou o Facebook para um escândalo de identidade global. No entanto, os líderes da Predictim afirmam ter estabelecido verificações de segurança interna e estão trabalhando para proteger os dados pessoais das babás. "Se tivéssemos um vazamento de dados de babá, isso não seria legal", disse Simonov.

Os especialistas temem que os sistemas de classificação baseados em IA prenunciam um futuro em que uma pessoa receba qualquer trabalho que não esteja necessariamente relacionado ao cuidado de crianças dependerá da máquina. Muitas empresas de recrutamento e recrutamento já estão criando ou investindo em sistemas que podem analisar currículos de candidatos em larga escala e emitir classificações automáticas de candidatos. Sistemas de IA semelhantes - incluindo o Jigsaw, uma incubadora de tecnologia criada pelo Google - são usados para rastrear comentários on-line de assédio, ameaças e crueldade.

No entanto, já foi demonstrado mais de uma vez como os algoritmos para encontrar funcionários ocultam falhas que podem arruinar a carreira de uma pessoa. A Amazon.com interrompeu o desenvolvimento do algoritmo de contratação, aprendendo que subestima ilegalmente as mulheres, pois o histórico de contratações da empresa, que segue a tendência do setor de tecnologia em contratar homens, ensinou o sistema a preferir candidatos masculinos. A empresa disse que nunca havia usado esse programa para avaliar candidatos.

Alguns especialistas em IA acreditam que esses sistemas têm a capacidade de inflar seriamente preconceitos relacionados à idade ou raça, por exemplo, marcando palavras ou fotos importantes de determinados grupos de pessoas com mais frequência do que outros. Eles também estão preocupados com o fato de a Predictim forçar as babás a compartilhar seus dados pessoais apenas para conseguir um emprego.

No entanto, Diana Werner, mãe de dois filhos que vivem em um subúrbio de São Francisco, acredita que as babás devem compartilhar voluntariamente informações pessoais para ajudar a tranquilizar seus pais. "Verificar a biografia é uma coisa boa, mas a Predictim estuda a questão em profundidade, dissecando o indivíduo - seu status social e intelectual", disse ela. Onde ela mora, "100% dos pais desejam usar esse serviço", acrescentou. "Todos nós queremos obter a babá perfeita."