Nos últimos vinte anos, os data centers parecem cogumelos após a chuva, e isso é compreensível. Além dos indicadores quantitativos, os qualitativos também estão se desenvolvendo - novas formas, novas abordagens para a construção do meio ambiente. Uma dessas inovações se tornou data centers modulares. Pela primeira vez, os militares foram capazes de avaliar a eficácia das soluções baseadas em um contêiner padronizado, foram eles que foram pioneiros no uso de data centers construídos de forma modular. A rápida implantação do poder de computação e a capacidade de armazenar dados nos cantos mais remotos do mundo se tornaram uma panacéia para os militares do mundo, com o aumento diário do volume de informações geradas. Graças à Sun Microsystems, já em 2006, os data centers modulares foram disponibilizados para consumidores civis. Mas parece, quem os adquirirá? Nas condições da luta acirrada dos participantes do mercado de TI por alto desempenho de hardware, as vantagens da modularidade dos data centers, na maioria dos casos da vida civil, são impiedosamente riscadas por todo um espectro de desvantagens geradas por essa mesma modularidade. Mas, como o tempo demonstrou, nem tudo é tão claro sobre esse assunto, e o produto encontrou seu consumidor. Um desses consumidores, por mais surpreendente que fosse, era o CERN. A ideia da organização é um grande colisor de hádrons, cheio de dois novos data centers modulares. Uma decisão muito estranha? Isso e não apenas será discutido mais adiante.

O recipiente - tudo engenhoso é simples!

O recipiente - tudo engenhoso é simples!Até onde sabemos, essa idéia foi implementada com um contêiner pelos militares - para encher uma armação de metal com racks de servidor, integrar um sistema de refrigeração a ele e aqui está uma solução pronta. Porém, com todo o utilitarismo de um contêiner de dados, surgem questões de flexibilidade e a eficácia do funcionamento de seu preenchimento. A quantidade de hardware padrão instalado corresponde às tarefas executadas, porque a lista de pendências de personalização dos racks de servidor é muito limitada. Por um lado, o fator de forma do contêiner não permite que o administrador da rede implante nele, literal e figurativamente. Por outro lado, substituir o enchimento por um mais potente pode corromper os sistemas auxiliares de contêineres: suprimento de energia, refrigeração. Mesmo com a capacidade de aumentar facilmente as capacidades de sua estrutura de servidor pelo método de entrega de outro contêiner, o problema de aumentar a eficiência de um rack específico no módulo não pode ser resolvido de forma alguma, e isso limita muito o escopo desse projeto.

CERN seleciona um data center modular“Até o final de 2019, planejamos instalar dois novos data centers, cada um dos quais atenderá exclusivamente a seu próprio detector LHC. O detector relacionado ao experimento LHCb receberá seis módulos; o detector experimental ALISA servirá um data center de quatro contêineres. A necessidade de expandir a infraestrutura existente foi causada pela modernização desses detectores. Após a atualização, a quantidade de dados gerados pelos detectores aumentará significativamente ”, disse Niko Neufeld, vice-diretor de um dos projetos do CERN.

CERN seleciona um data center modular“Até o final de 2019, planejamos instalar dois novos data centers, cada um dos quais atenderá exclusivamente a seu próprio detector LHC. O detector relacionado ao experimento LHCb receberá seis módulos; o detector experimental ALISA servirá um data center de quatro contêineres. A necessidade de expandir a infraestrutura existente foi causada pela modernização desses detectores. Após a atualização, a quantidade de dados gerados pelos detectores aumentará significativamente ”, disse Niko Neufeld, vice-diretor de um dos projetos do CERN.

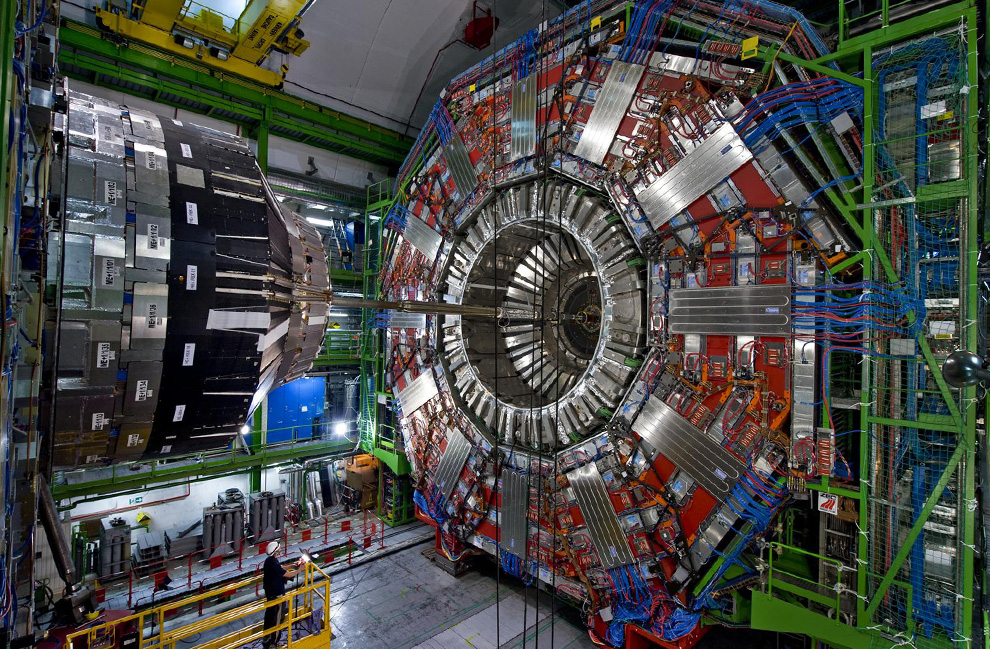

LHC (Large Hadron Collider) - um projeto sob os auspícios do CERN, é uma estrutura colossal localizada a uma profundidade de cerca de 100 metros no coração da Europa Ocidental, no território de dois estados - França e Suíça. Com um diâmetro de 8,5 km e um comprimento de cerca de 27 km, é difícil censurar o LHC por seu afastamento da civilização. O projeto em si é essencialmente o núcleo da ciência moderna, o motor de seu componente fundamental. Além disso, a infraestrutura de TI existente que atende ao LHC atende a todos os padrões modernos, incluindo data centers e backbones de fibra ótica, que a combinam com o mundo inteiro. Qual foi o objetivo da decisão dos cientistas nucleares europeus do CERN de aumentar a capacidade da infraestrutura de TI por meio de data centers modulares?

No momento, as necessidades do colisor são atendidas diretamente por até cinco data centers. Destes, quatro são atribuídos aos quatro sensores principais de cada uma das principais experiências: ATLAS, CMS, ALISA e LHCb. O quinto data center é o maior - é o hub central para processamento e armazenamento de dados coletados de todo o complexo científico do LHC.

“No momento, o detector central que serve o experimento LHCb registra os eventos que ocorrem nele com uma frequência de 1 MHz. Após a modernização, a frequência de fixação aumentará 40 vezes e imaginará 40.000.000 de registros por segundo”, continuou Nico.Não é de surpreender que novos tempos exijam novos equipamentos. Um aumento no fluxo de dados é uma tendência generalizada e não há nada para se surpreender com a modernização da infraestrutura de rede, mas por que os data centers modulares? A resposta não demorou a chegar.

“Isso é uma economia líquida. As especificidades dos detectores são explosões volumétricas e de curto prazo na geração de dados. A quantidade de dados gerados por essas explosões é conhecida com uma precisão muito alta; portanto, sabemos exatamente quanto espaço em disco para armazenamento de dados precisamos e essa quantidade será relevante até a fase extrema do experimento. Além disso, ao colocar os módulos do servidor o mais próximo possível dos sensores, reduzimos o comprimento das comunicações de fibra ótica necessárias para transferir 30 PB de dados em um curto período de tempo, o custo de estabelecer essas comunicações é muito impressionante. “- explicou Nico.De acordo com o esquema descrito pelo funcionário do CERN, a situação com a escolha da infraestrutura começou a ficar mais clara. O enorme fluxo de dados gerado pelos sensores LHC alcançará os centros de processamento e armazenamento de dados primários no menor tempo possível, após o que, aguardando a próxima partida do sensor, as informações coletadas fluirão gradualmente para o data center central sem sobrecarregar a infraestrutura de rede existente.

Vida após HiggsDe fato, toda essa estrutura megalítica, o LHC, foi criada com o objetivo de revelar / refutar a existência do bacia de Higgs. Em 2013, sinais indiretos de existência foram descobertos e o problema inicial foi resolvido. Os funcionários do CERN precisaram de um ano e meio de inatividade por colisão para modernizar os detectores existentes, o que poderia resolver novos problemas. No entanto, não se passaram mais de três anos a partir da data do novo lançamento e, no momento em que o LHC espera outra modernização, o desligamento do colisor deve durar de 2019 a 2021.

Como vemos aqui, a situação é que não faz sentido sobrecarregar o projeto com infraestrutura pesada e estacionária, porque após um curto estágio de coleta de dados estatísticos, há grandes chances de que ele simplesmente desapareça. Como mostra a prática, novos projetos ainda exigirão nova infraestrutura e outros equipamentos envolvidos. Os módulos instalados agora sempre podem ser facilmente movidos para outro local onde seu uso será mais racional.

“Agora, o sensor do projeto LHDb é atendido por um servidor localizado diretamente próximo a ele - no subsolo. Dois fatores nos impediram de modernizar este site: o espaço limitado pela masmorra e os problemas causados pela incapacidade de resfriar o servidor com eficiência ”, disse Nico.

A sala de servidores existente, mencionada por um funcionário do centro científico, está localizada a uma profundidade de 100 metros, nos momentos de pico de carga nos servidores, a quantidade de calor gerada por eles cria a necessidade da entrega de refrigerante aquecido para a superfície, onde pode transferir excesso de calor para a atmosfera e retornar ao fundo .

Alto custo para resfriar os servidores nos módulos claramente não é esperado. Dado o clima frio do sopé alpino, PUE - o coeficiente de eficiência do sistema de refrigeração será menor que 1,1 (apenas 10% da energia consumida pelo equipamento do servidor será resfriada).

Até março de 2019, todos os dez módulos deverão ocupar seus lugares de design. Perto do final do ano, as linhas de fibra óptica serão levadas aos data centers, somente depois que a infraestrutura estiver funcional. No entanto, ela será capaz de provar seus negócios nos primeiros três anos depois. O primeiro lançamento do maior colisor de hádrons, após a modernização, já está planejado para 2021.

“Mas a coisa mais incomum em nossos novos data centers é que não forneceremos uma fonte de energia de backup para eles. Por 6 anos de trabalho em um centro científico, nunca experimentamos uma queda de energia de emergência ”, resumiu Nico Newfield.

Obrigado por ficar conosco. Você gosta dos nossos artigos? Deseja ver materiais mais interessantes? Ajude-nos fazendo um pedido ou recomendando a seus amigos, um

desconto de 30% para os usuários da Habr em um análogo exclusivo de servidores básicos que inventamos para você: Toda a verdade sobre o VPS (KVM) E5-2650 v4 (6 núcleos) 10GB DDR4 240GB SSD 1Gbps da US $ 20 ou como dividir o servidor? (as opções estão disponíveis com RAID1 e RAID10, até 24 núcleos e até 40GB DDR4).

VPS (KVM) E5-2650 v4 (6 núcleos) 10GB DDR4 240GB SSD de 1Gbps até janeiro de graça quando pagar por um período de seis meses, você pode fazer o pedido

aqui .

Dell R730xd 2 vezes mais barato? Somente nós temos

2 TVs Intel Dodeca-Core Xeon E5-2650v4 128GB DDR4 6x480GB SSD 1Gbps 100 a partir de US $ 249 na Holanda e nos EUA! Leia sobre

Como criar um prédio de infraestrutura. classe usando servidores Dell R730xd E5-2650 v4 custando 9.000 euros por um centavo?