Esta é a segunda parte de uma introdução aos usuários do Kubernetes para VMware. Antes de passar para a parte prática, leia o artigo anterior

aqui .

A maneira mais fácil e rápida de conhecer o Kubernetes sem requisitos especiais é o GCP (Google Cloud Platform). Basta ter

acesso ao teste e aprender Kubernetes. Para confirmar o registro, você precisa fornecer informações no cartão de crédito. O GCP não deduzirá nada até você ativar o pagamento. Crie uma conta e continuaremos a explorar o fascinante mundo de Kubernetes.

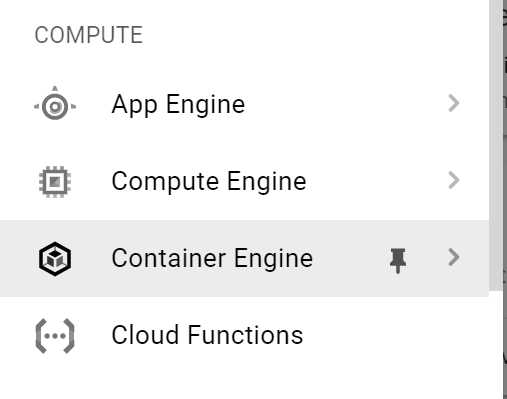

O primeiro passo é conectar-se ao GKE (Google Kubernetes Engine). No menu à esquerda, selecione

Container Engine .

Clique em

Criar cluster.

Preencha os campos:

- nome do cluster;

- área de acesso

- versão do Kubernetes;

- detalhes da imagem, etc.

O cluster será criado em alguns minutos. Quando estiver pronto, clique em Conectar. Um comando para conectar aparece. Nós vamos usá-lo. Copie.

A maneira mais fácil de se conectar ao cluster é através do

shell do

Google Cloud .

No canto superior direito, clique no ícone do shell.

Após alguns segundos, o shell iniciará na mesma página. Cole o comando que você copiou na etapa anterior.

Agora vamos ver as informações em nosso cluster usando o comando

kubectl cluster-info .

Para obter informações sobre nós, digite o

comando kubectl get no -o wide. Você verá uma lista de nós com informações sobre eles.

Agora, temos uma lista de todos os pods em funcionamento em nosso cluster K8s. Digite o

comando kubectl get po -o wide –all-namespaces .

Agora vamos nos conectar aos nós do cluster para descobrir suas configurações de rede. Para fazer isso, clique no menu principal à esquerda novamente e selecione

Compute Engine na lista suspensa. Como você pode ver na captura de tela abaixo, o cluster k8s é, em última análise, o número de máquinas virtuais.

Clique em

SSH para iniciar uma sessão com o nó selecionado. Uma nova caixa de diálogo será exibida. Verifique se o seu navegador não bloqueia pop-ups.

Verifique qual distribuição Linux é usada. Para fazer isso, digite

uname -a e

cat / etc / lsb-release .

Agora vamos verificar as configurações de rede usando o

ifconfig -a | mais Veja a

interface de ponte

cbr0 ? Este é o que mostramos no diagrama de rede acima.

Aqui também vemos a rede / 24 alocada para este nó - 10.40.1.0/24. A partir disso, nossos pods recebem seus endereços IP. Agora você pode correlacionar o diagrama de rede acima com a configuração real nos nós do cluster k8s. Legal, né?

Agora vamos voltar à janela do Google Cloud Shell e tentar implantar um aplicativo de teste. Dirija no

clone git https://github.com/hanymichael/NSX-CNA-Lab.git .

Com este comando, você clonará um dos meus aplicativos de teste no GitHub. Agora vá para a pasta do aplicativo e digite

kubectl create -f. para que todos os arquivos YAML sejam criados nesta pasta.

Agora, exibiremos a lista de pods e veremos seu status. Pode-se ver que todos têm o status de

ContainerCreating . Após alguns segundos, o status será alterado para Em

execução .

Existem duas implantações do meu aplicativo Web no K8s, cada uma com 4 réplicas. Agora vamos verificar os serviços associados a esta implantação usando o comando

kubectl get svc .

A última coisa a verificar é a entrada associada a este aplicativo. A captura de tela acima mostra que estamos nos conectando ao aplicativo através de um IP externo. Se verificarmos a seção com o balanceador, veremos o balanceador de carga associado à entrada.

Se você quiser acessar o próprio aplicativo, poderá criar um registro DNS para * .esxcloud.net no arquivo host local.

Agora abra uma nova guia no navegador e siga os links

sphinx-v1.esxcloud.net e

sphinx-v2.esxcloud.net . Veremos duas coisas:

- a versão do aplicativo é mostrada em cada link;

- após atualizar a página da web, o endereço IP do contêiner é alterado, o que significa que o balanceador está funcionando.

Agora você pode correlacionar a configuração do aplicativo com o diagrama abaixo e ver como tudo fica no Kubernetes.

Conclusão

Vimos que o Kubernetes, como qualquer sistema distribuído, tem muitas semelhanças (e algumas diferenças) com o vSphere, que é familiar para nós como usuários do VMware. Tentei explicar os conceitos básicos comparando o K8s e o vSphere. Espero que isso ajude você a conhecer rapidamente essa plataforma em nuvem incrivelmente poderosa que já está conquistando o mundo.

Nas postagens a seguir, começarei a aprofundar o desenvolvimento de nossa solução corporativa para o lançamento do Kubernetes dentro do data center. Acompanhe as novidades!

PS: Você também pode testar os recursos do Kubernetes em nosso serviço

KuberLine , depois de emitir um test drive.