Enquanto trabalhamos no relatório anual deste ano, decidimos evitar recontar as manchetes do ano anterior e, embora seja quase impossível ignorar absolutamente as memórias, queremos compartilhar com você o resultado de um pensamento claro e uma visão estratégica para o ponto em que todos nós vamos chegar no tempo mais próximo - o presente.

Deixando as palavras de introdução para trás, aqui estão nossas principais conclusões:

- A duração média do ataque DDoS caiu para 2,5 horas;

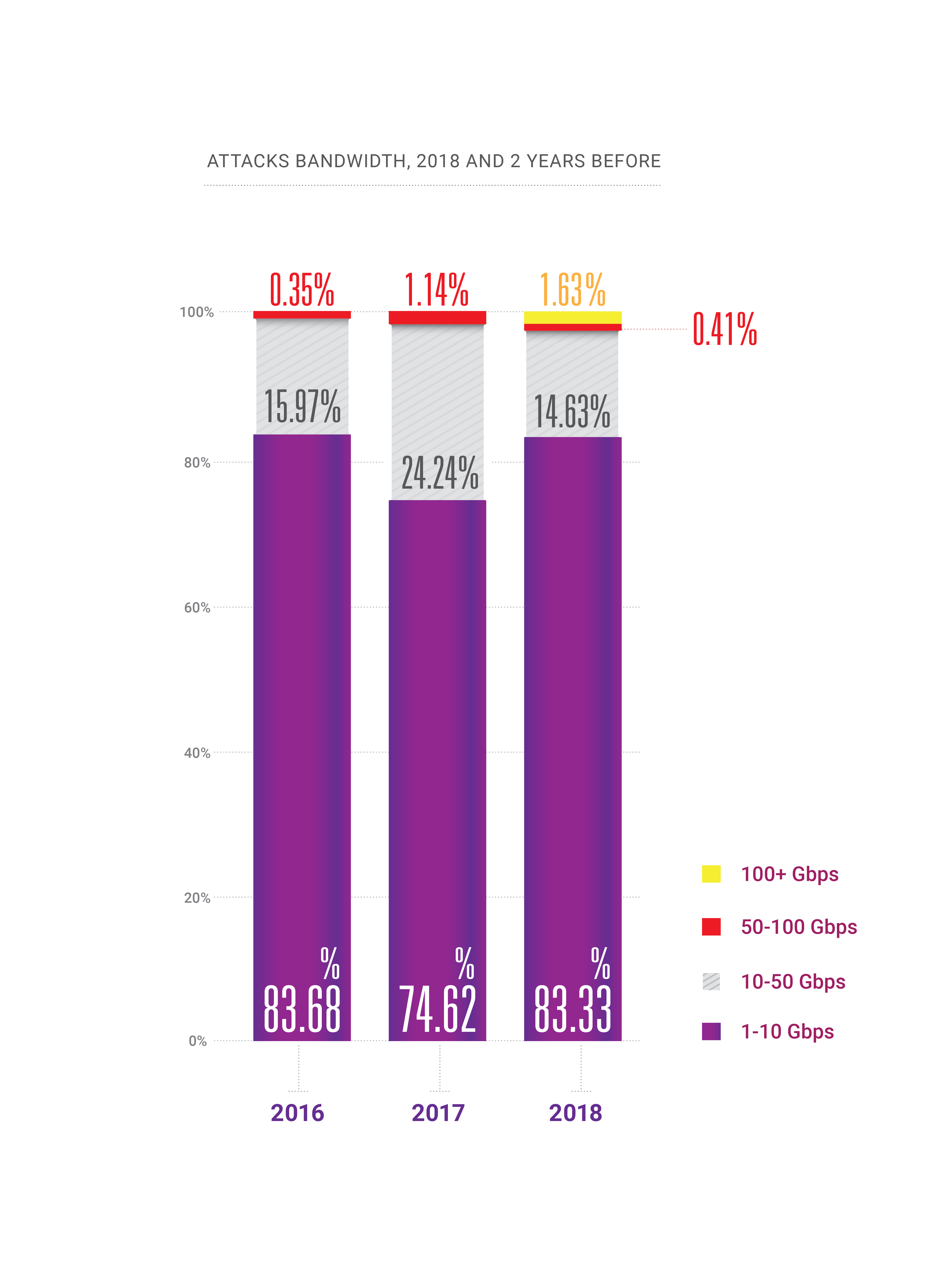

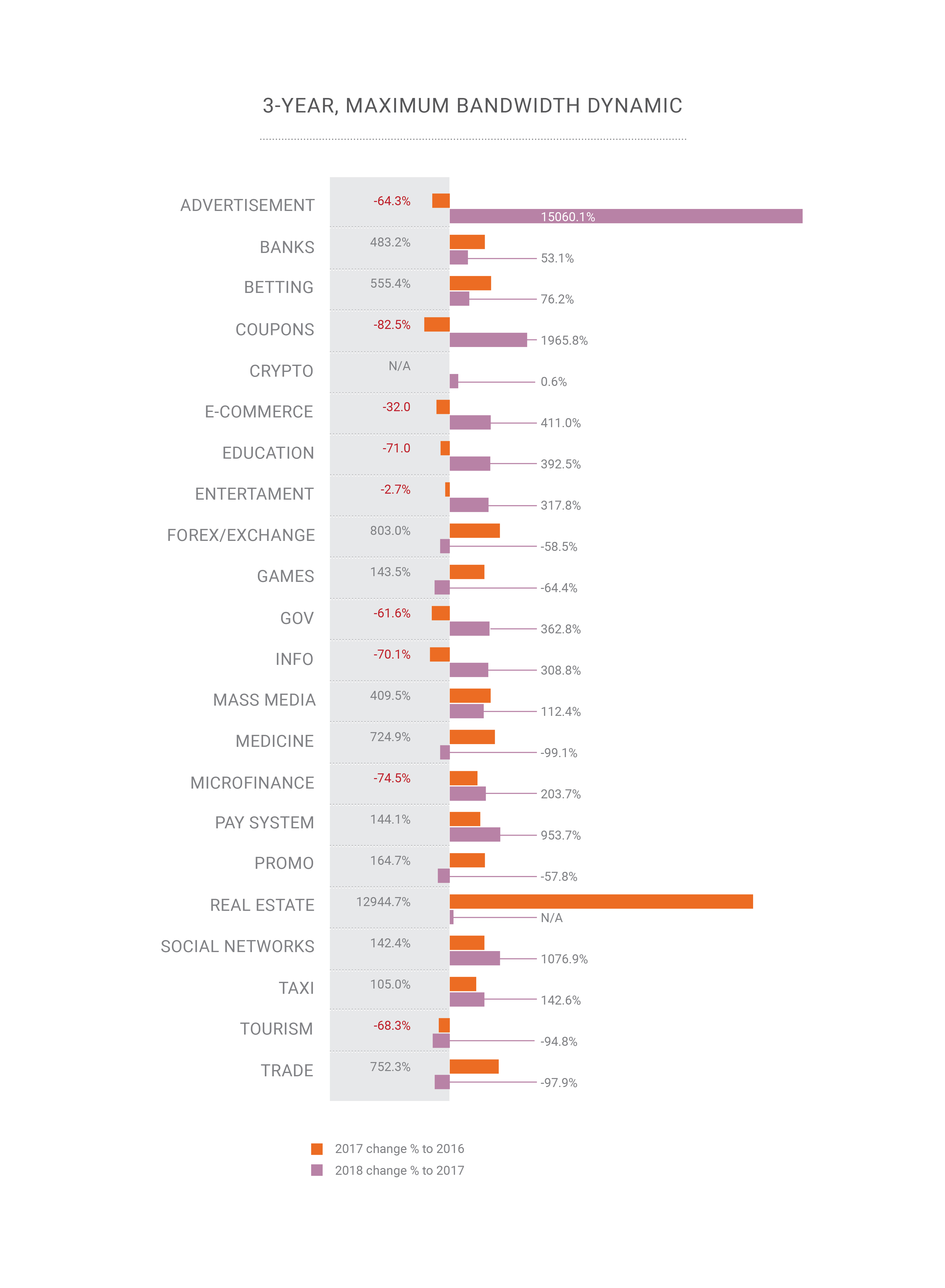

- Durante 2018, a capacidade apareceu para ataques a centenas de gigabits por segundo em um país ou região, levando-nos à beira da "teoria quântica da relatividade da largura de banda";

- A frequência dos ataques DDoS continua a crescer;

- O crescimento contínuo de ataques habilitados para HTTPS (SSL);

- O PC está morto: a maior parte do tráfego legítimo hoje vem de smartphones, o que é um desafio para os atores de DDoS hoje e seria o próximo desafio para as empresas de mitigação de DDoS;

- O BGP finalmente se tornou um vetor de ataque, 2 anos depois do que esperávamos;

- A manipulação do DNS se tornou o vetor de ataque mais prejudicial;

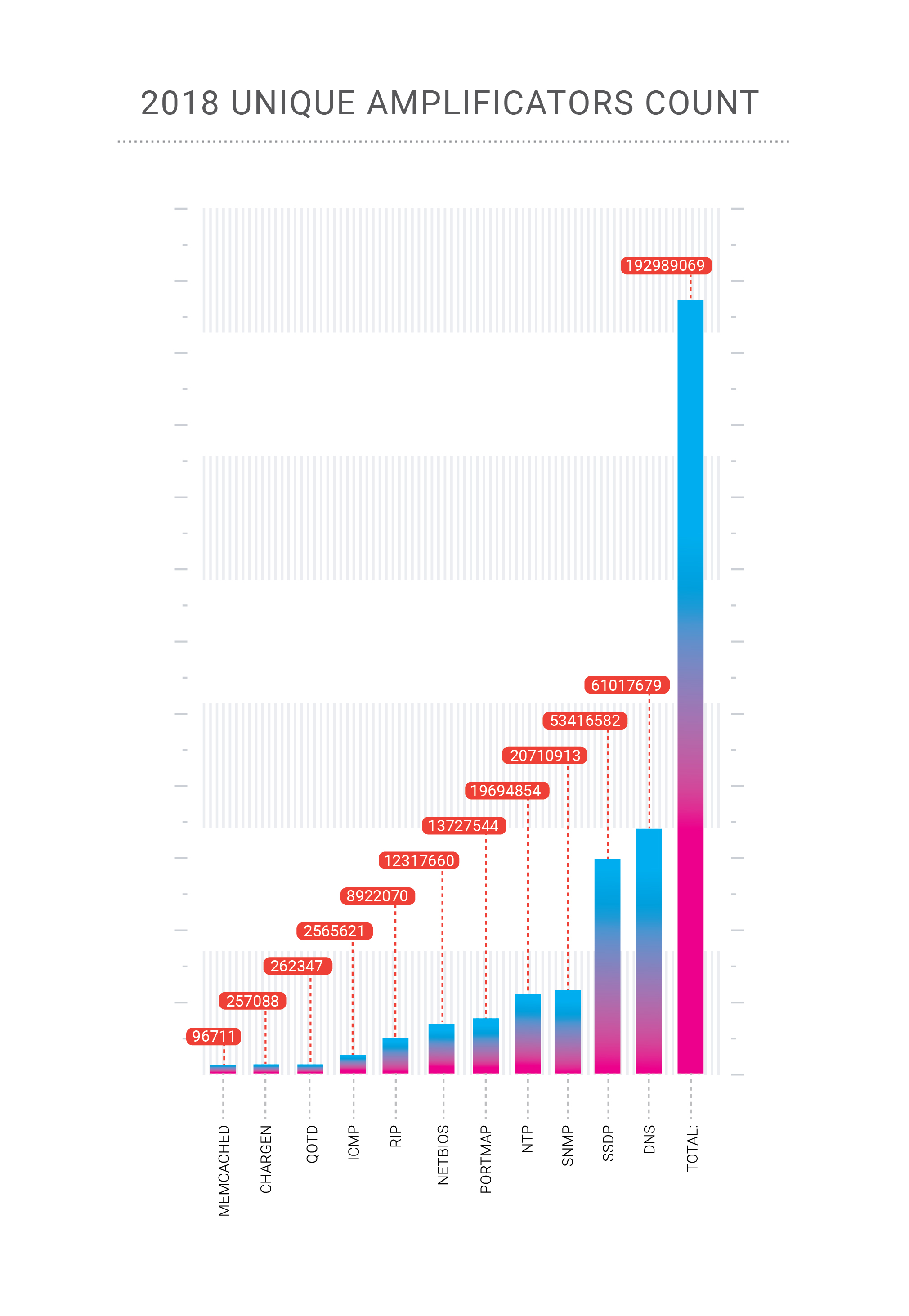

- Outros novos vetores de amplificação são possíveis, como o memcached & CoAP;

- Não existem mais "indústrias seguras" que sejam invulneráveis a ataques cibernéticos de qualquer tipo.

Neste artigo, tentamos escolher todas as partes mais interessantes do nosso relatório, embora, se você quiser ler a versão completa em inglês, o

PDF esteja disponível .

Retrospectiva

Em 2018, nossa empresa comemorou dois ataques recordes em sua rede. Os ataques de amplificação do Memcached, que descrevemos em detalhes durante o final de fevereiro de 2018, atingiram 500 Gbps no caso da plataforma de pagamento Qiwi, um cliente do Qrator Labs. Então, no final de outubro, recebemos um ataque de amplificação de DNS altamente concentrado em um de nossos clientes na Federação Russa.

A amplificação de DNS é um vetor de ataque DDoS antigo e conhecido, que é principalmente volumétrico e levanta dois problemas. No caso de um ataque de centenas de gigabits por segundo, há uma grande chance de sobrecarregar nosso canal upstream. Como combater isso? Obviamente, temos que distribuir essa carga entre muitos canais, o que leva à segunda questão - latência adicionada que resulta da alteração do fluxo de tráfego para o nosso ponto de processamento. Felizmente, mitigamos com sucesso esse ataque específico com apenas balanceamento de carga.

É aqui que o balanceamento de carga flexível demonstra seu verdadeiro valor e, como o Qrator Labs gerencia uma rede BGP anycast, o Radar está modelando a propagação do tráfego em nossa rede depois de ajustar o balanço de carga. O BGP é um protocolo de vetor de distância e conhecemos esses estados porque o gráfico de distância permanece estático. Analisando essas distâncias e considerando os LCPs e o Multipath de custo igual, podemos estimar o AS_path do ponto A ao ponto B com alta confiança.

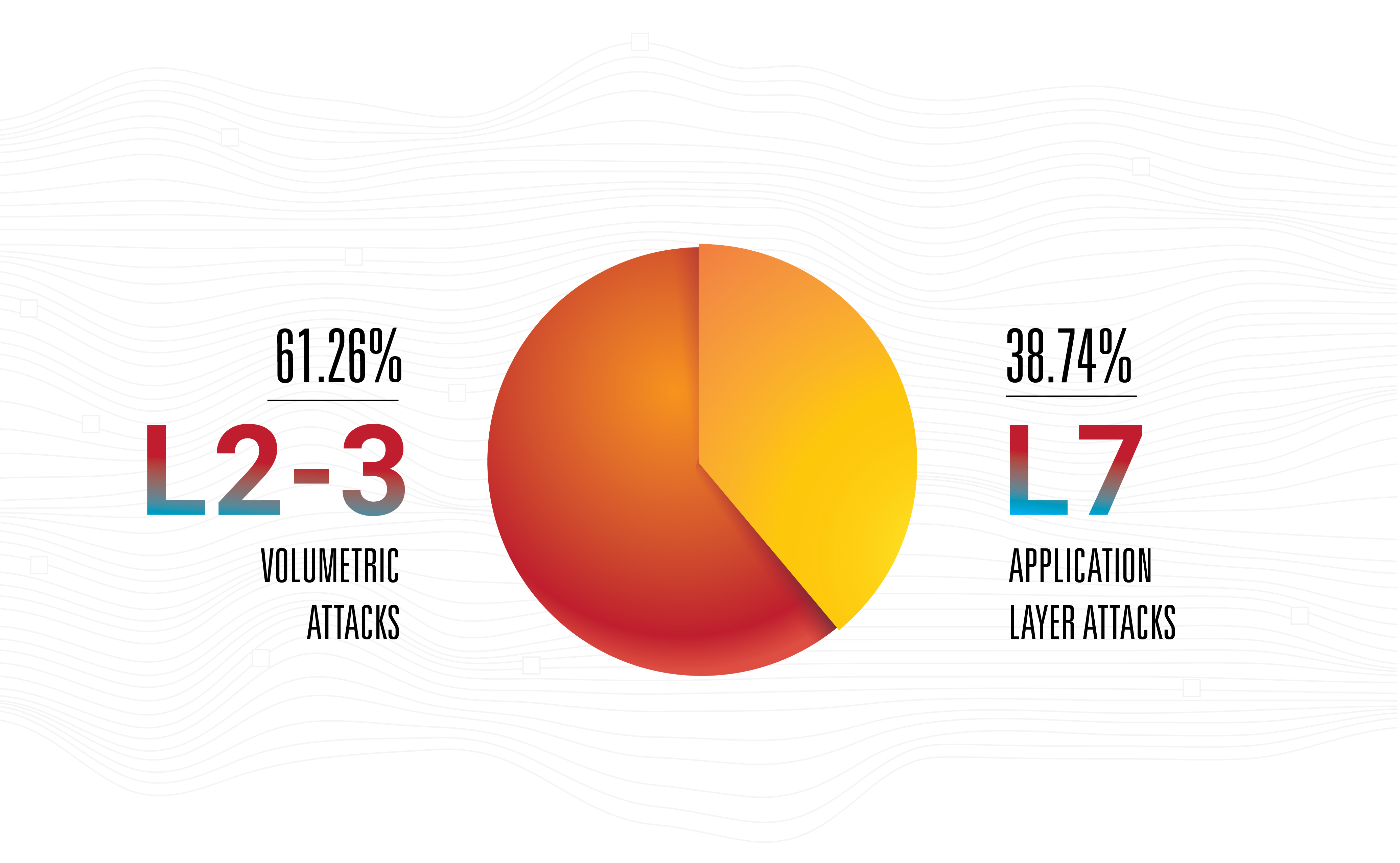

Isso não quer dizer que a amplificação seja a ameaça mais perigosa - não, os ataques na camada de aplicativos permanecem os mais eficazes, nervosos e invisíveis, pois a maioria deles é de baixa largura de banda.

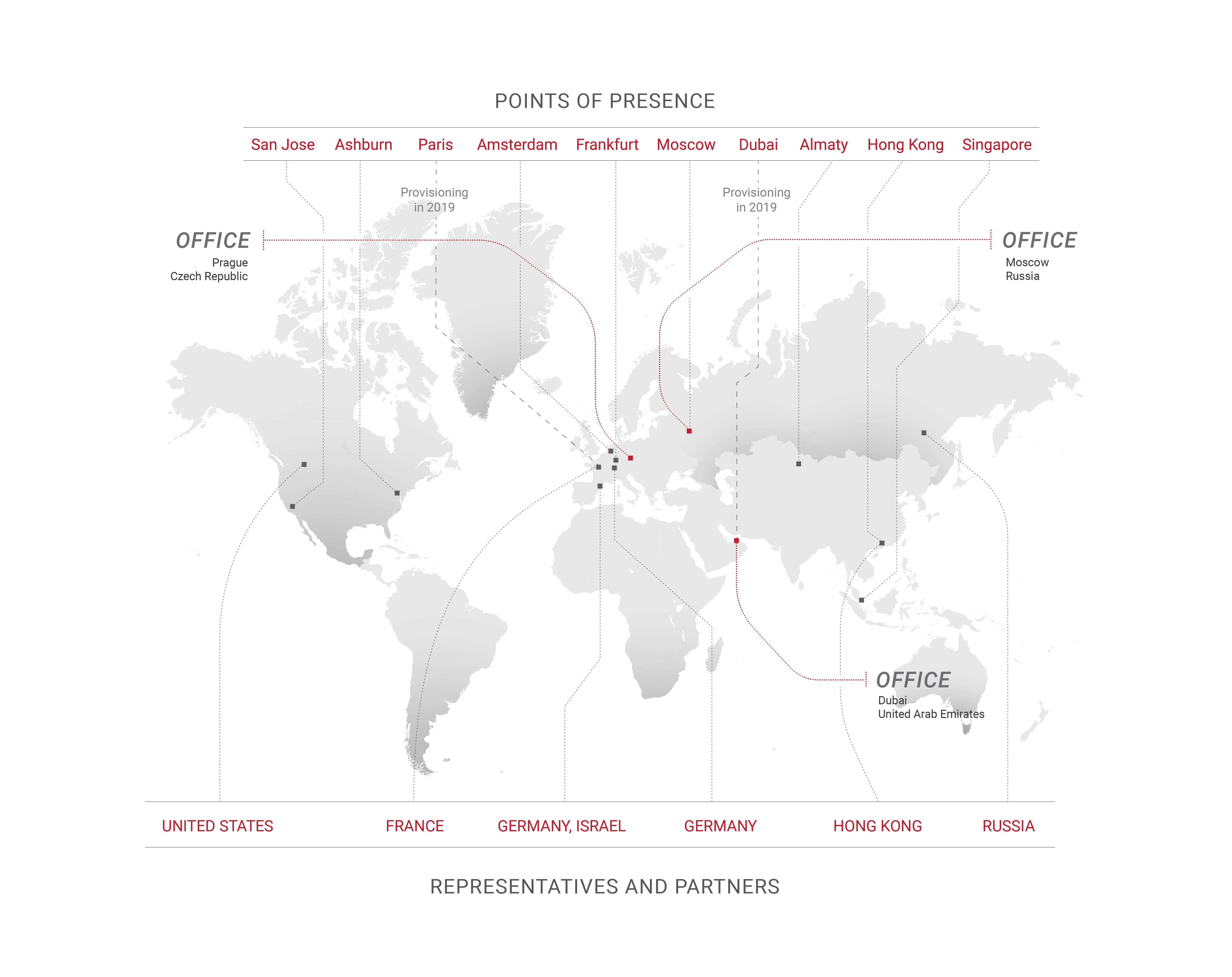

Esse é o principal motivo pelo qual o Qrator Labs atualiza as conexões com os operadores com base em pontos de presença, além de ampliar as áreas de presença. Hoje é um passo natural para qualquer operadora de rede, assumindo que seus números estejam crescendo. No entanto, da perspectiva dos atacantes, acreditamos que é comum coletar uma botnet medíocre e só depois nos concentrar em procurar a mais rica variedade de amplificadores disponíveis para atacar de todas as armas possíveis, na maior taxa de recarga possível. Os ataques híbridos estão aqui, crescendo em largura de banda, taxa de pacotes e frequência.

As botnets evoluíram significativamente em 2018 e seus mestres encontraram um novo emprego para elas - clique em fraude. Com o surgimento do aprendizado de máquina e dos mecanismos de navegação sem cabeçalho, a fraude de cliques se tornou muito mais fácil de realizar do que apenas alguns anos atrás.

Um site médio de hoje recebe de 50% a 65% de seu tráfego de dispositivos móveis, navegadores de smartphones e aplicativos. Para alguns serviços da Web, esse número é próximo de 90% ou 100%, enquanto um site somente para desktop atualmente é algo raro encontrado principalmente em ambientes corporativos ou em alguns casos limítrofes.

O PC está basicamente morto em 2019, o que torna algumas das abordagens usadas como perfeitas, como rastreamento de movimentos do mouse, totalmente inúteis para rastreamento e filtragem de bots. De fato, não apenas o PC (com todos os laptops brilhantes e as máquinas multifuncionais) raramente é a fonte de um grande compartilhamento de tráfego com determinados sites, mas muitas vezes está se tornando apenas um criminoso. Às vezes, apenas negar acesso ao que não é um navegador de smartphone adequado é suficiente para mitigar um ataque de botnet, causando ao mesmo tempo um impacto negativo nulo nos principais indicadores de desempenho dos negócios.

Os autores de botnet são usados para implementar ou imitar o comportamento dos navegadores de desktop em seu código malicioso, assim como os proprietários de sites acreditam que os navegadores de PC são realmente importantes. O último mudou recentemente; portanto, dentro de alguns anos, também deverá ocorrer uma mudança no primeiro.

Já dissemos que nada mudou significativamente durante 2018, mas as mudanças e o progresso mantiveram um ritmo constante. Um dos exemplos mais significativos é o Aprendizado de Máquina, onde as melhorias foram especialmente evidentes, principalmente na área de Redes Adversárias Generativas. Lenta, mas constantemente, a ML está alcançando o mercado de massa. O mundo do aprendizado de máquina tornou-se mais acessível e, até o final do ano, não está mais restrito aos acadêmicos.

Esperávamos ver os primeiros ataques DDoS baseados em ML (ou de outra forma relacionados) até o início de 2019, mas ainda não aconteceu. Esperamos esse desenvolvimento por causa do baixo custo dos dados gerados por ML no momento, mas aparentemente não é baixo o suficiente.

Se você pensa no estado atual da indústria "humana automatizada", colocar a neuro-rede em cima disso não é uma má idéia. Essa rede aprenderia o comportamento humano real no contexto do gerenciamento do conteúdo da página da web. Isso é algo que todos chamariam de "experiência do usuário de IA" e, é claro, uma rede equipada com um mecanismo de navegador poderia produzir um arsenal muito interessante para os dois lados, ataque e defesa.

Certamente, ensinar a rede é caro, mas distribuir e terceirizar esse sistema pode ser muito acessível e, possivelmente, gratuito, especialmente se forem considerados malware, aplicativos invadidos e assim por diante. Potencialmente, essa mudança poderia afetar todo o setor, da mesma forma que os GANs transformaram o que pensamos em "realidade visual" e "confiabilidade".

Como essa também é uma corrida entre os mecanismos de pesquisa com o Google e todos os outros que tentam fazer engenharia reversa dos algoritmos, poderia chegar a uma situação em que um bot imitaria não um ser humano aleatório, mas uma pessoa específica, como normalmente sentado atrás de um computador vulnerável selecionado. Versões do Captcha e Recaptcha podem servir como exemplos de como os invasores aprimoram suas ferramentas e técnicas de ataque.

Depois do memcached, houve muita conversa sobre a possibilidade de uma nova classe de arma de ataque DDoS - uma vulnerabilidade, um bot, um serviço comprometido, algo que poderia enviar eternamente dados específicos para um endereço específico escolhido pelo atacante. Um comando do invasor pode liberar um fluxo contínuo e perpétuo de tráfego, como syslog ou uma inundação maciça. Isso é apenas uma teoria. Não podemos dizer se esses servidores ou dispositivos realmente existem, mas se existirem, seria um eufemismo dizer que eles poderiam representar uma arma extremamente perigosa nas mãos erradas.

Em 2018, também vimos um interesse crescente na governança da Internet e nos serviços associados de todos os tipos de governos e organizações sem fins lucrativos em todo o mundo. Vemos isso como um desenvolvimento neutro até o ponto em que as liberdades fundamentais podem ser suprimidas, o que esperamos que não aconteça, especialmente nos países desenvolvidos.

Após anos coletando e analisando tráfego globalmente, o Qrator Labs agora está implementando o primeiro bloco de solicitação. Os modelos que usamos para prever comportamentos maliciosos nos permitem determinar com alta confiança se um usuário é legítimo ou não. Aderimos à nossa filosofia central de experiência ininterrupta do usuário, sem desafios ou captchas de JavaScript e, em 2019, esperamos alcançar a capacidade de impedir que a primeira solicitação maliciosa viole nossas defesas.

Mellanox

Escolhemos os switches 100G Mellanox como resultado de nossos testes internos nos anos anteriores. Ainda selecionamos equipamentos que atendem às nossas necessidades em situações específicas. Antes de tudo, os switches não devem descartar pacotes pequenos enquanto trabalham na taxa de linha - não pode haver nenhuma degradação. Segundo, gostamos do preço. No entanto, isso não é tudo. O custo é sempre justificado pela maneira como o fornecedor reage às suas especificações.

Os switches Mellanox funcionam no Switchdev, transformando suas portas em interfaces Linux comuns. Como parte do kernel Linux principal, o Switchdev é descrito na documentação como "um modelo de driver no kernel para dispositivos de switch que descarregam o plano de encaminhamento de dados do kernel". Essa abordagem é muito conveniente, pois todas as ferramentas que utilizamos estão disponíveis em uma API extremamente natural para todo programador, desenvolvedor e engenheiro de rede moderno. Qualquer programa que use a API de rede padrão do Linux pode ser executado no switch. Todas as ferramentas de monitoramento e controle de rede criadas para servidores Linux, incluindo os caseiros, estão disponíveis. Por exemplo, implementar alterações na tabela de rotas é muito mais confortável em comparação com o modo como foi feito antes do Switchdev. Até o nível do chip de rede, todo o código é visível e transparente, possibilitando aprender e fazer modificações, até o momento específico em que você precisa saber exatamente como o chip é construído, ou pelo menos a interface externa.

Um dispositivo Mellanox sob controle do Switchdev é a combinação que achamos mais adequada para as nossas necessidades, pois a empresa fornece suporte completo ao sistema operacional de código aberto já robusto pronto para uso.

Ao testar o equipamento antes de executá-lo na produção, descobrimos que algum tráfego encaminhado foi descartado. Nossa investigação mostrou que foi causado pelo tráfego em uma interface e foi roteada através do processador de controle, o que, obviamente, não era capaz de lidar com grandes volumes dele. Não sabíamos a causa exata desse comportamento, mas supusemos que ele estivesse vinculado ao tratamento de redirecionamentos do ICMP. Mellanox confirmou a causa do problema e pedimos que fizessem algo sobre isso. A Mellanox reagiu rapidamente, fornecendo uma solução funcional a curto prazo.

Bom trabalho, Mellanox!

Protocolos e código aberto

O DNS sobre HTTPS é uma tecnologia mais complexa que o DNS sobre TLS. Vemos o primeiro florescendo e o último sendo lentamente esquecido. É um exemplo claro de que "mais complexo" significa "mais eficiente", pois o tráfego de DoH é indistinguível de qualquer outro HTTPS. Já vimos isso com a integração de dados RPKI, quando foi inicialmente posicionada como uma solução anti-seqüestro e não acabou bem, mas depois reapareceu como uma arma poderosa contra erros como vazamentos estáticos e configurações incorretas de roteamento. Ruído transformado em sinal e agora o RPKI é suportado nos maiores IXs, o que é uma ótima notícia.

O TLS 1.3 chegou. O Qrator Labs, assim como o setor de TI em geral, acompanhou de perto o processo de desenvolvimento, desde o rascunho inicial até todas as etapas da IETF, para se tornar um protocolo compreensível e gerenciável que estamos prontos para oferecer suporte em 2019. O suporte já é evidente no mercado e queremos acompanhar a implementação desse protocolo de segurança robusto e comprovado. Não sabemos como os produtores de hardware de mitigação de DDoS se adaptarão às realidades do TLS 1.3, mas, devido à complexidade técnica do suporte ao protocolo, isso poderá levar algum tempo.

Também estamos seguindo o HTTP / 2. Por enquanto, o Qrator Labs não suporta a versão mais recente do protocolo HTTP, devido à base de código existente em torno deste protocolo. Erros e vulnerabilidades ainda são encontrados com bastante frequência no novo código; como provedor de serviços de segurança, ainda não estamos prontos para oferecer suporte a esse protocolo nos termos do SLA que concordamos com nossos consumidores.

A verdadeira questão de 2018 para o Qrator Labs era: “Por que as pessoas querem tanto o HTTP / 2? E foi objeto de intenso debate ao longo do ano. As pessoas ainda tendem a pensar no dígito "2" como a versão "mais rápida, mais forte e melhor", o que não é necessariamente o caso em todos os aspectos desse protocolo em particular. No entanto, o DoH recomenda HTTP / 2 e é aqui que os dois protocolos podem ter muito impulso.

Uma preocupação com o desenvolvimento dos conjuntos e recursos de protocolos da próxima geração é que geralmente depende muito de pesquisas acadêmicas, e o estado disso para o setor de mitigação de DDoS é bastante fraco. A Seção 4.4 do rascunho da IETF “Gerenciabilidade do QUIC”, que faz parte do futuro conjunto de protocolos do QUIC, pode ser vista como um exemplo perfeito disso: afirma que “as práticas atuais de detecção e mitigação de [ataques DDoS] geralmente envolvem passivas medição usando dados de fluxo de rede ”, sendo este último muito raramente um caso em ambientes empresariais da vida real (e apenas parcialmente para configurações de ISP) - e de alguma forma dificilmente um“ caso geral ”na prática - mas definitivamente um caso geral em trabalhos de pesquisa acadêmica que, na maioria das vezes, não são apoiados por implementações adequadas e testes no mundo real contra toda a gama de possíveis ataques DDoS, incluindo os da camada de aplicativos (que, devido ao progresso na implantação mundial do TLS, obviamente nunca poderiam ser manuseado com qualquer tipo de medição passiva). Definir tendência de pesquisa acadêmica adequada é outro desafio para os operadores de mitigação de DDoS em 2019.

O Switchdev atendeu plenamente às expectativas que expressamos um ano atrás. Esperamos que o trabalho contínuo para tornar o Switchdev ainda melhor se fortaleça nos próximos anos, pois a comunidade é forte e está crescendo.

O Qrator Labs está acompanhando a ativação do Linux XDP para ajudar a aumentar ainda mais a eficiência do processamento de pacotes. O descarregamento de alguns padrões de filtragem de tráfego mal-intencionado da CPU para a NIC e até mesmo para o comutador de rede parece bastante promissor, e esperamos continuar nossa pesquisa e desenvolvimento nessa área.

Mergulho profundo com bots

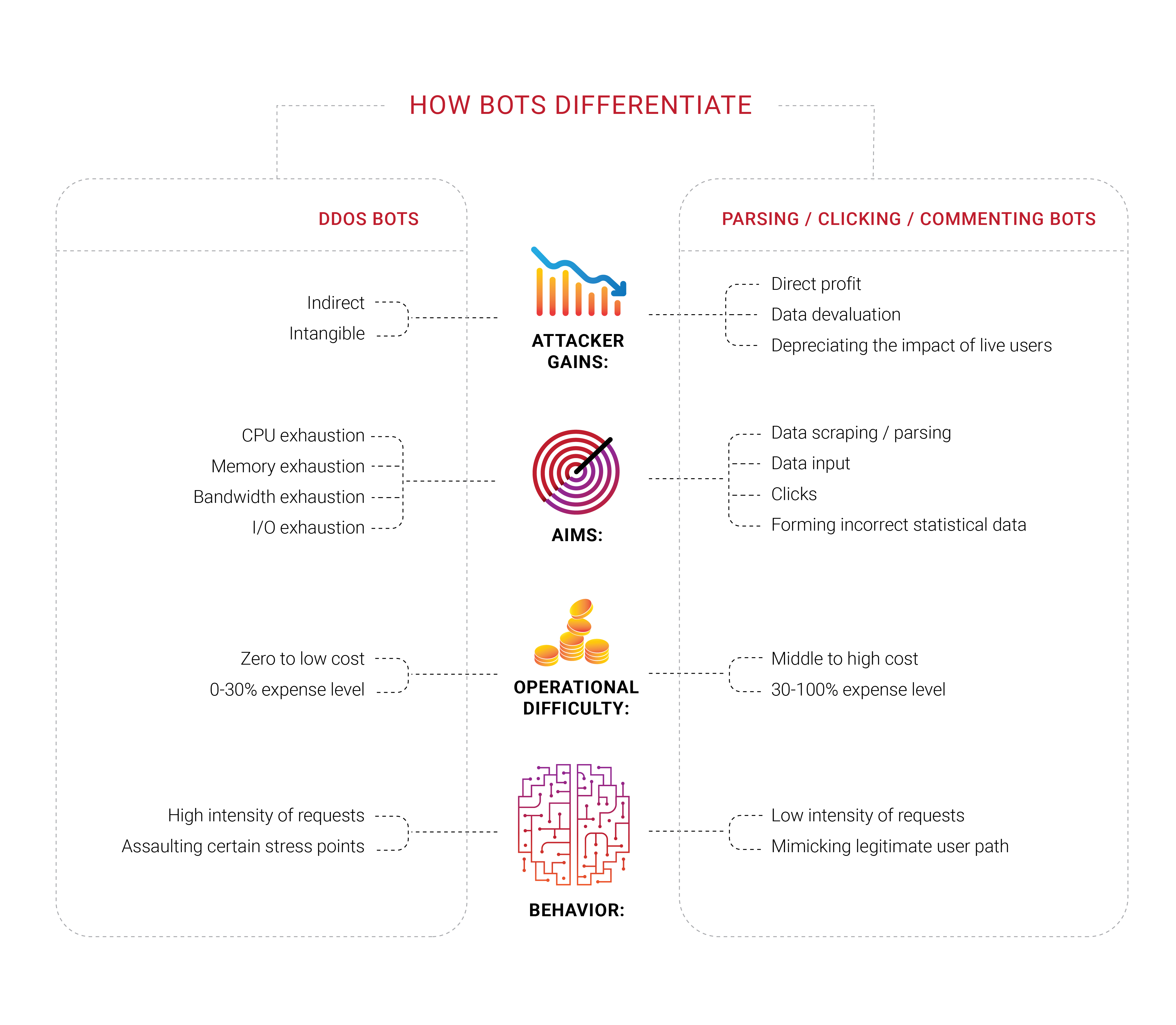

Muitas empresas buscam proteção contra bot, e não é surpresa que vimos grupos trabalhando em diferentes áreas desse campo em 2018. O que achamos interessante é que uma grande parte dessas empresas nunca sofreu um ataque DDoS direcionado, pelo menos uma negação típica de tentativa de serviço de drenar recursos finitos, como largura de banda ou capacidade da CPU. Eles se sentem ameaçados pelos bots, mas não conseguem distingui-los dos usuários reais ou determinar o que estão realmente fazendo. Eles apenas sabem que querem se livrar dos bots percebidos.

Os problemas com bots e raspadores também têm um importante componente econômico. Se 30% do tráfego é ilegítimo e originado por máquina, 30% dos custos de suporte a esse tráfego são desperdiçados. Hoje, isso pode ser visto como um imposto adicional inevitável sobre os negócios na Internet. É difícil diminuir o número exatamente para zero, mas os empresários preferem vê-lo o mais baixo possível.

A identificação se torna um problema significativo na internet de hoje, pois os melhores bots não precisam mais imitar os seres humanos - eles ocupam o mesmo espaço, como parasitas. Há algum tempo, repetimos que qualquer informação disponível publicamente, sem autorização ou autenticação, é e terminaria como propriedade comum - ninguém poderia impedir isso.

Em 2018, nos concentramos em questões de identidade e gerenciamento de bot. No entanto, o escopo mais amplo aqui é diferente; vivemos em uma época em que não há maneira exata de saber o motivo pelo qual um cliente solicita a resposta do servidor. Você leu certo: em última análise, toda empresa deseja que um cliente compre alguma coisa, esse é o motivo da existência e do objetivo; portanto, algumas empresas desejam examinar mais profundamente quem solicita o quê do servidor - se houver uma pessoa real por trás.

Não é de admirar que os proprietários de empresas aprendam com os técnicos que uma parte significativa do tráfego de seus sites é originada por bots, não por clientes.

Os seres humanos automatizados que mencionamos anteriormente também podem ter como alvo algum recurso de rede específico com um complemento de navegador instalado - e acreditamos que a maioria dessas extensões são instaladas propositadamente, para perseguir um objetivo específico, conhecido apenas pelos criadores dessas redes. Fraude de clique, manipulação de anúncios, análise - essas tarefas são realizadas com eficiência com a ajuda de seres humanos reais no ponto em que a automação falha. Imagine como a situação mudaria se o aprendizado de máquina fosse aplicado ao elo certo da cadeia.

Analisadores e raspadores, que fazem parte do problema mais amplo de bots, se tornaram um problema em que mergulhamos durante 2018, primeiramente graças aos nossos clientes, que nos abordaram com suas experiências e forneceram a opção de investigar mais o que estava acontecendo com seus recursos. Esses bots podem nem se registrar em métricas típicas, como a largura de banda ou a carga da CPU do servidor. No momento, estamos testando uma variedade de abordagens, mas, em última análise, está claro o que os clientes precisam - bloquear esses invasores em sua primeira solicitação.

Durante a epidemia de raspagem que vimos na Rússia e na CEI, ficou claro que os bots envolvidos são capazes de criptografia. Uma solicitação por minuto é uma taxa que pode facilmente passar despercebida sem a análise de solicitação do tráfego recebido. Na nossa humilde opinião, o cliente deve decidir o próximo passo depois de obter nossa análise e marcação. Quer bloqueá-los, deixá-los passar ou enganar (enganar) eles - não cabe a nós decidir.

No entanto, existem certos problemas com automações puras, ou "bots", como estamos acostumados a chamá-los. Se você tem certeza de que o bot mal-intencionado gerou uma solicitação específica, a primeira coisa que você decide fazer é bloqueá-la, sem enviar resposta do servidor. Chegamos à conclusão de que isso não faz sentido porque essas ações apenas fornecem mais feedback à automação, permitindo que ela se adapte e encontre uma solução alternativa. A menos que os bots tentem um ataque de negação de serviço, recomendamos não bloquear essas automações imediatamente, pois o resultado de tais jogos de gato e rato pode ser apenas uma grande perda de tempo e esforço.

Esse é o principal motivo pelo qual a Qrator Labs escolhe marcar tráfego suspeito e / ou malicioso e deixar a decisão sobre as próximas etapas para o proprietário do recurso, levando em consideração seu público, serviço e objetivos de negócios. Um exemplo é a extensão do navegador de bloqueio de anúncios. A maioria dos anúncios são scripts e, ao bloquear scripts, você não está necessariamente bloqueando anúncios e pode bloquear outra coisa, como um desafio de javascript. É fácil imaginar como isso poderia aumentar, resultando em perda de renda para um grande grupo de empresas da Internet.

Quando os atacantes são bloqueados e recebem o feedback de que precisam, eles podem se adaptar, aprender e atacar rapidamente. As tecnologias da Qrator Labs são construídas com base na filosofia simples de que a automação não pode receber nenhum feedback que possa usar: você não deve bloqueá-las nem passar por elas, apenas marcá-las. Depois que essas marcas são feitas, você deve considerar o objetivo real delas - O que elas querem? e Por que eles estão visitando esse recurso ou página da web específica? Talvez você possa alterar levemente o conteúdo da página da web de uma maneira que nenhum humano sentiria a diferença, mas a realidade do bot ficaria de cabeça para baixo? Se forem analisadores, poderão obter informações de análise enganosas na forma de dados incorretos.

Ao discutir esses problemas ao longo de 2018, rotulamos esses ataques como ataques simples de métricas de negócios. Seu site e servidores podem parecer bons, sem queixas dos usuários, mas você sente algo mudando ... como o preço de CPA de um anúncio que você recebe de alguma plataforma programática lentamente, mas direciona constantemente os anunciantes para outros lugares.

Matar os incentivos dos agressores é a única maneira de combater isso. Tentar parar os bots resulta apenas em perda de tempo e dinheiro. Se eles clicarem em algo de que você se beneficia, torne esses cliques ineficientes; se eles analisarem você, forneça informações não confiáveis que não serão distinguidas de dados legítimos e confiáveis.

Clickhouse

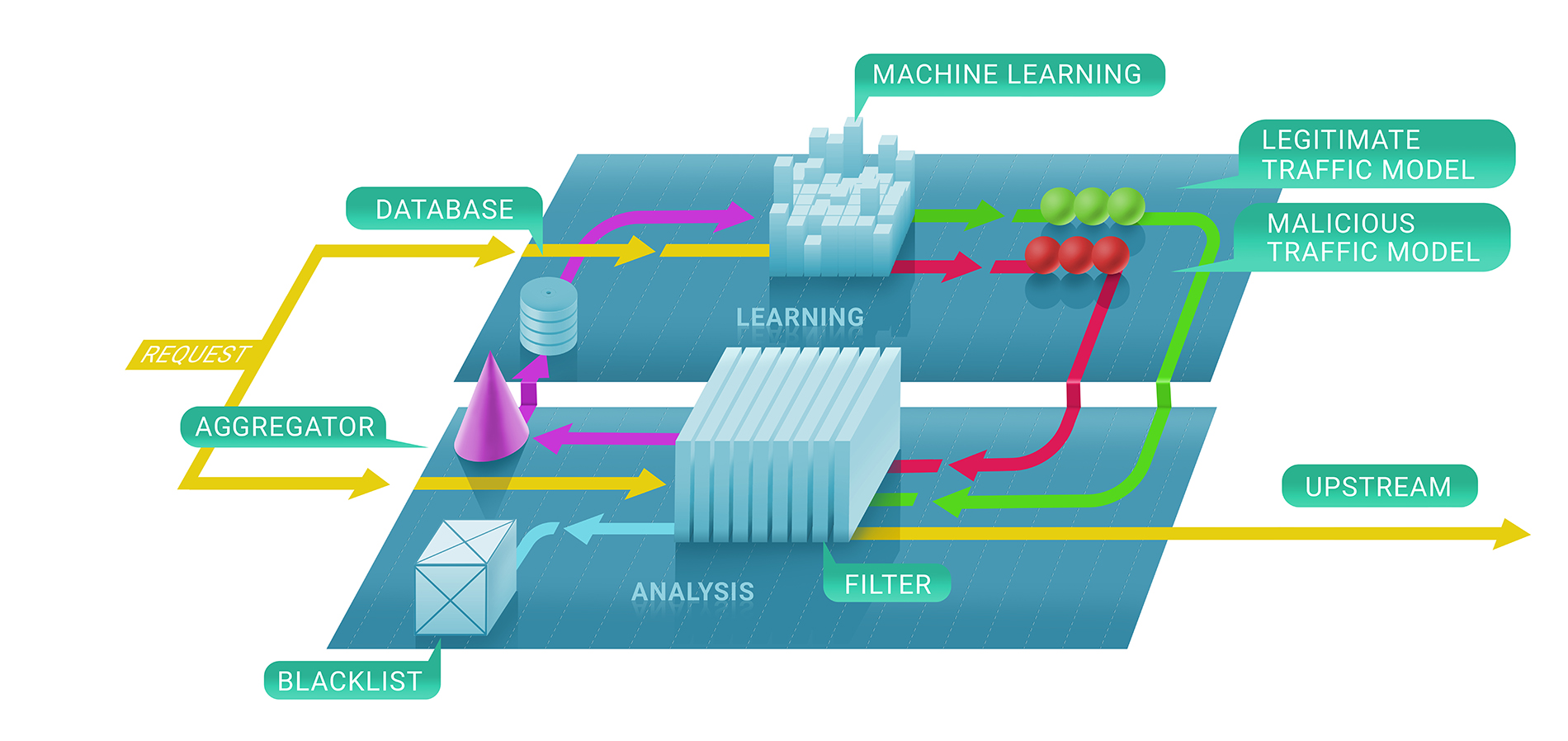

Em geral, o serviço de filtragem do Qrator Labs envolve dois estágios: primeiro, avaliamos imediatamente se uma solicitação é maliciosa com a ajuda de verificações sem estado e sem estado e, em segundo lugar, decidimos se manteremos ou não a fonte na lista negra e por quanto tempo. A lista negra resultante pode ser representada como a lista de endereços IP exclusivos.

Na primeira etapa desse processo, listamos técnicas de aprendizado de máquina para entender melhor o fluxo natural de tráfego de um determinado recurso, pois parametrizamos o serviço para cada cliente individualmente com base nos dados que coletamos.

É aí que entra a Clickhouse. Para entender precisamente por que um endereço IP foi proibido de se comunicar com um recurso, precisamos seguir o modelo de aprendizado de máquina para o Clickhouse DB. Ele funciona muito rápido com grandes blocos de dados (considere um ataque DDoS de 500 Gbps, continuando por algumas horas entre pausas) e os armazena de uma maneira que é naturalmente compatível com as estruturas de aprendizado de máquina que usamos no Qrator Labs. Mais logs e mais tráfego de ataque levam a resultados melhores e mais robustos de nossos modelos para refinar ainda mais o serviço em tempo real, sob os ataques mais perigosos.

Usamos o banco de dados Clickhouse para armazenar todos os logs de tráfego de ataques (ilegítimos) e padrões de comportamento de bot. Implementamos esta solução específica porque prometeu uma capacidade impressionante para processar conjuntos de dados em massa em um estilo de banco de dados, rapidamente. Usamos esses dados para análise e para construir os padrões que usamos na filtragem DDoS e, para aplicar o aprendizado de máquina, para melhorar os algoritmos de filtragem.

Uma vantagem significativa da Clickhouse, em comparação com outros bancos de dados, é que ele não lê toda a cadeia de dados - pode levar apenas o segmento necessário, muito menor, se você estiver armazenando tudo de acordo com as diretrizes.

Conclusão

Há algum tempo, convivemos com ataques multifatoriais que exploram vários protocolos de ataque para tornar um alvo indisponível.

As medidas de higiene digital e segurança atualizadas devem e realmente podem cobrir 99% dos riscos reais que uma entidade individual provavelmente encontrará, exceto casos extremos ou direcionados propositadamente, e evitar que um serviço “médio” da Internet enfrente problemas.

Por outro lado, os ataques DDoS são capazes de cortar a conexão à Internet de qualquer país do mundo, embora apenas alguns possam ser efetivamente direcionados externamente. Esse não é o caso no BGP, onde é possível desligar apenas alguns pontos em qualquer mapa que você queira desenhar.

O conhecimento da segurança da rede continua a crescer, o que é excelente. No entanto, uma vez que você olha para os números vinculados a amplificadores em redes ou opções para falsificar alguém - eles não estão diminuindo! Isso ocorre porque a cada ano a quantidade de tempo que os alunos passam na escola de segurança da Internet, ou seja, as pessoas que começam a se preocupar com a forma como escrevem código e criam seus aplicativos, não corresponde à quantidade de tempo necessária para garantir que não estejam criando vulnerabilidades que permita que alguém use esses recursos para organizar um ataque DDoS bem-sucedido ou pior.

Uma das descobertas mais significativas de 2018 foi que a maioria das pessoas ainda espera substancialmente mais da tecnologia do que pode ser entregue atualmente. Nem sempre foi esse o caso, mas agora vemos uma forte tendência a pedir demais, independentemente dos recursos de software ou hardware. As pessoas continuam esperando mais, o que provavelmente não mudará por causa das promessas feitas nas campanhas de marketing. No entanto, as pessoas estão comprando essas promessas, e as empresas acham que devem trabalhar para cumpri-las.

Talvez seja essa a natureza do progresso e da evolução. Atualmente, as pessoas se sentem frustradas e desapontadas por não terem o que estavam "garantidas" e o que pagavam. Portanto, é aqui que os problemas atuais se originam, onde não podemos comprar “totalmente” um dispositivo e todo o software que fará o que queremos, ou onde os serviços “gratuitos” têm um preço alto em termos de dados pessoais .

O consumismo nos diz que queremos algo e devemos pagar por isso com nossas vidas. Precisamos dos tipos de produtos ou serviços que se atualizam para nos vender melhores negócios no futuro com base nos dados que eles coletaram sobre nós de maneiras que talvez não gostemos? Poderíamos antecipar que, em 2019, após os casos Equifax e Cambridge Analytica, poderemos ver uma explosão final de aquisição e abuso de dados pessoais.

Após dez anos, não mudamos nossas crenças fundamentais sobre a arquitetura da rede interconectada. Essa é a razão pela qual continuamos apoiando os princípios mais fundamentais da rede de filtragem do Qrator Labs - BGP-anycast, a capacidade de processar tráfego criptografado, evitar captchas e outros obstáculos, mais visibilidade para usuários legítimos em comparação com os bots atacantes.

Observando o que continua acontecendo com especialistas e empresas de segurança cibernética no campo, queremos enfatizar outra questão: quando se trata de segurança, nenhuma abordagem ingênua, simples ou rápida é aplicável.

Essa é a principal razão pela qual o Qrator Labs não possui centenas ou mesmo dezenas de pontos de presença, em comparação com as CDNs. Ao manter um número menor de centros de lavagem, todos conectados aos ISPs da classe 1, obtemos uma verdadeira descentralização do tráfego. Essa também é a razão pela qual não tentamos criar firewalls, que são totalmente diferentes do que o Qrator Labs faz - conectividade.

Contamos histórias sobre captchas e testes e verificações de javascript há algum tempo e aqui estamos - as redes neurais estão se tornando extremamente úteis na solução do primeiro, e o último nunca foi um problema para o invasor qualificado e persistente.

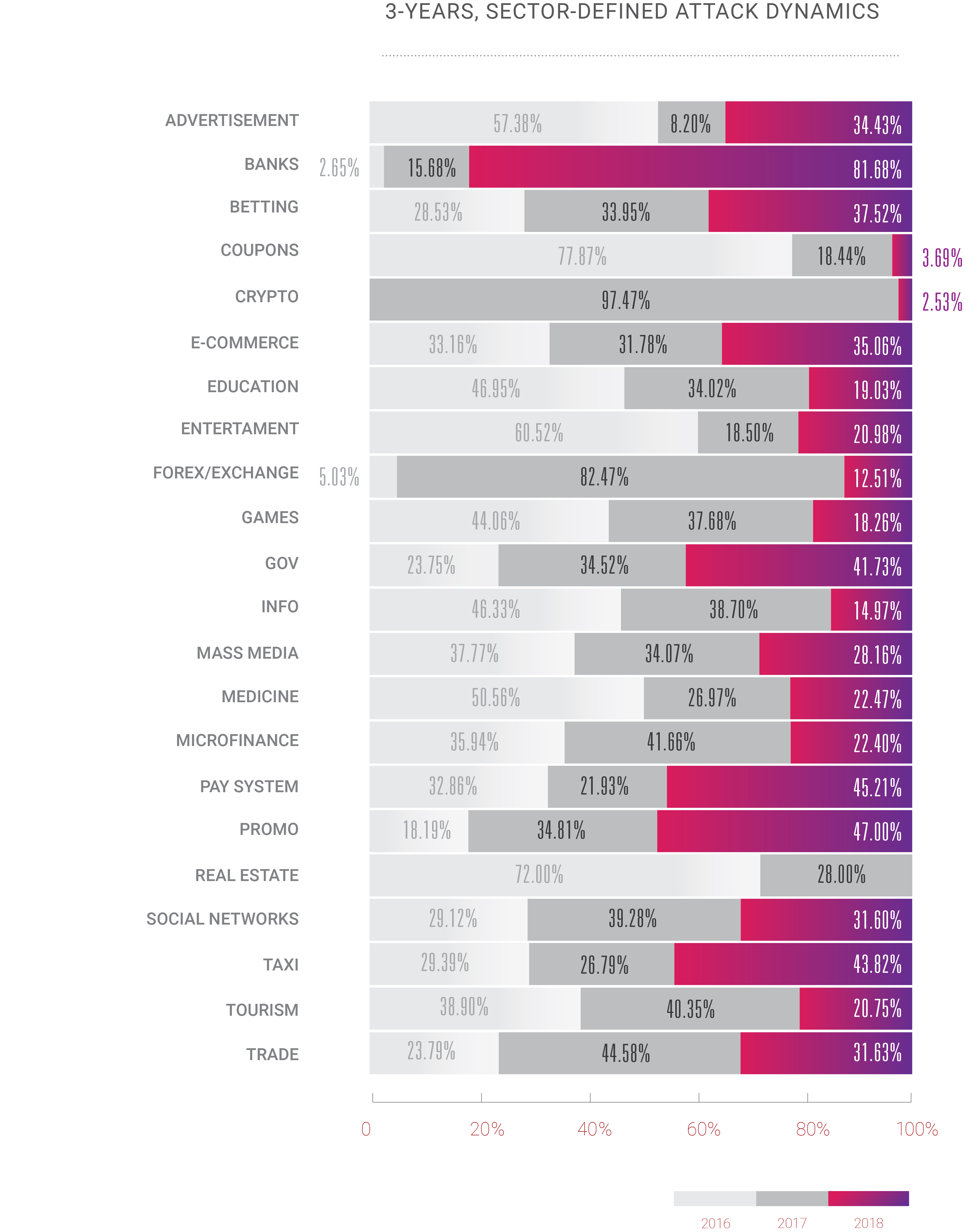

Este ano também sentimos uma mudança bastante empolgante: durante anos, o DDoS foi um problema para apenas um número limitado de áreas de negócios, geralmente aquelas onde o dinheiro está acima do nível da água: comércio eletrônico, negociação / ações, sistemas bancários / de pagamento. No entanto, com o crescimento contínuo da Internet, observamos agora ataques DDoS sendo aplicados a todos os outros serviços de Internet disponíveis. A era do DDoS começou com o aumento da largura de banda e o número de computadores pessoais em uso em todo o mundo; não é surpresa que em 2018, com microchips de silício em todos os dispositivos ao nosso redor, o cenário de ataques esteja evoluindo muito rápido.

Se alguém espera que essa tendência mude, provavelmente está enganado. Assim como nós, talvez, também somos. Ninguém pode dizer como a Internet realmente evoluirá e espalhará seu impacto e poder nos próximos anos, mas, de acordo com o que vimos em 2018 e continuamos observando em 2019, tudo vai se multiplicar. Até 2020, o número de dispositivos conectados na Internet deve exceder 30 bilhões, além do fato de que já ultrapassamos o ponto em que a humanidade gerou mais tráfego do que a automação criada. Então, em breve, teremos que decidir como gerenciar toda essa "inteligência", artificial ou não, uma vez que ainda estamos vivendo no mundo em que apenas um ser humano pode ser responsável por algo estar certo e errado.

2018 foi um ano de oportunidades para quem está do lado escuro. Vemos crescimento em ataques e hacks em termos de complexidade, volume e frequência. Os bandidos obtiveram algumas ferramentas poderosas e aprenderam como usá-las. Os mocinhos fizeram pouco mais do que apenas assistir a esses desenvolvimentos. Esperamos ver essa mudança este ano, pelo menos nas questões mais dolorosas.