As redes neurais são conhecidas por sua incompreensibilidade - o computador pode dar uma boa resposta, mas não pode explicar o que levou a essa conclusão. Bin Kim está desenvolvendo um "tradutor humano" para que, se a inteligência artificial quebrar, possamos entendê-la.

Bean Kim, pesquisadora do Google Brain, está desenvolvendo uma maneira de questionar um sistema de aprendizado de máquina sobre suas decisões.

Bean Kim, pesquisadora do Google Brain, está desenvolvendo uma maneira de questionar um sistema de aprendizado de máquina sobre suas decisões.Se o médico lhe disser que você precisa de cirurgia, você descobrirá o porquê - e esperará que a explicação dele pareça significativa para você, mesmo que você não tenha sido treinado como médico. Been Kim, pesquisador do Google Brain, acredita que deveríamos esperar o mesmo da inteligência artificial (IA). Ela é especialista em aprendizado de máquina “interpretado” (MO) e deseja criar uma IA que possa explicar suas ações a qualquer pessoa.

Desde dez anos atrás, a tecnologia das redes neurais por trás da IA começou a se espalhar cada vez mais, foi capaz de transformar todos os processos, desde a classificação de e-mails até a descoberta de novos medicamentos, graças à sua capacidade de aprender com os dados e procurar padrões neles. Mas essa capacidade tem uma pegada inexplicável: a própria complexidade que permite que as redes neurais modernas com treinamento aprofundado aprendam com sucesso como dirigir um carro e reconheçam a fraude com seguros tornam quase impossível para os especialistas entender os princípios de seu trabalho. Se uma rede neural é treinada para procurar pacientes com risco de câncer de fígado ou esquizofrenia - e um sistema chamado "Paciente Profundo" foi lançado no Mount Sinai Hospital em Nova York em 2015 - então não há como entender quais. dados caracterizam a rede neural "presta atenção". Esse "conhecimento" está espalhado por muitas camadas de neurônios artificiais, cada uma das quais tem conexões com centenas ou milhares de outros neurônios.

À medida que mais e mais indústrias tentam automatizar ou melhorar seus processos de tomada de decisão usando a IA, esse problema de "caixa preta" parece ser menos uma falha tecnológica e mais uma falha fundamental. Um projeto da DARPA chamado XAI (abreviação de “IA Explicável”, IA eXplainable) está explorando ativamente esse problema, e a interpretabilidade está saindo das linhas de frente da pesquisa no campo da MO, mais perto de seu centro. "A IA está em um momento crítico em que nós, a humanidade, estamos tentando descobrir se essa tecnologia é adequada para nós", diz Kim. "Se não resolvermos o problema da interpretabilidade, acho que não conseguiremos seguir em frente com essa tecnologia, e talvez simplesmente a recusemos".

Kim e colegas do Google Brain recentemente desenvolveram o sistema Teste com vetores de ativação de conceito (TCAV), que ela descreve como tradutora humana que permite ao usuário fazer uma pergunta à caixa preta da IA sobre quanto um certo conceito de alto nível estava envolvido na tomada de decisão. Por exemplo, se o sistema MO for treinado para encontrar imagens de zebra, uma pessoa poderia pedir ao TCAV para descrever o quanto o conceito de “listras” faz no processo de tomada de decisão.

O TCAV foi testado inicialmente em modelos treinados para reconhecer imagens, mas também funciona com modelos projetados para processamento de texto ou certas tarefas de visualização de dados, por exemplo, gráficos de EEG. "É generalizado e simples - pode ser conectado a muitos modelos diferentes", diz Kim.

Quanta conversou com Kim sobre o que significa interpretabilidade, quem precisa e por que isso importa.

Você em sua carreira se concentrou na “interpretabilidade” para o MO. Mas o que exatamente esse termo significa?

Você em sua carreira se concentrou na “interpretabilidade” para o MO. Mas o que exatamente esse termo significa?A interpretabilidade tem dois ramos. Uma é a interpretabilidade para a ciência: se você considerar a rede neural como um objeto de estudo, poderá realizar experimentos científicos para entender realmente todos os meandros do modelo, as razões de sua reação e assim por diante.

O segundo ramo, no qual concentro principalmente meus esforços, é a interpretabilidade para criar uma IA capaz de responder perguntas. Você não precisa entender todos os pequenos detalhes do modelo. Mas nosso objetivo é entender o suficiente para que essa ferramenta possa ser usada com segurança.

Mas como alguém pode acreditar em um sistema, se não entende completamente como ele funciona?Vou te dar uma analogia. Suponha que no meu quintal haja uma árvore que eu queira cortar. Eu tenho uma serra elétrica para isso. Não entendo exatamente como funciona uma serra elétrica. Mas as instruções dizem: "Algo a ser tratado com cuidado para não se cortar". Tendo instruções, é melhor usar uma serra elétrica em vez de uma serra manual - a última é mais fácil de entender, mas eu precisaria vê-la por cinco horas.

Você entende o que significa "cortar", mesmo que não saiba tudo sobre o mecanismo que torna isso possível.Sim O objetivo do segundo ramo da interpretabilidade é o seguinte: podemos entender a ferramenta o suficiente para ser segura de usar? E podemos criar esse entendimento, confirmando que o conhecimento humano útil é refletido no instrumento.

Mas como o “reflexo do conhecimento humano” torna a caixa preta da IA mais compreensível?Aqui está outro exemplo. Se o médico usar o modelo MO para fazer um diagnóstico de câncer, ele precisará saber que o modelo não seleciona simplesmente alguma correlação aleatória nos dados que não precisamos. Uma maneira de verificar isso é confirmar que o modelo MO faz aproximadamente a mesma coisa que o médico faria. Ou seja, para mostrar que o conhecimento diagnóstico do médico se reflete no modelo.

Por exemplo, se um médico procurar uma instância celular adequada para o diagnóstico de câncer, ele procurará algo chamado "glândula mesclada". Ele também levará em conta indicadores como a idade do paciente e se ele passou por quimioterapia no passado. Esses fatores, ou conceitos, serão levados em consideração por um médico que tenta diagnosticar o câncer. Se pudermos mostrar que o modelo MO também chama a atenção para eles, então o modelo será mais compreensível, pois refletirá o conhecimento humano dos médicos.

É com isso que o TCAV lida - mostra quais conceitos de alto nível o modelo MO usa para a tomada de decisão?Sim Antes disso, os métodos de interpretabilidade explicavam apenas o que a rede neural faz em termos de "recursos de entrada". O que isso significa? Se você tiver uma imagem, cada um de seus pixels será um recurso de entrada.

Yang Lekun (pioneiro da aprendizagem profunda, diretor de pesquisa de IA do Facebook), disse que considera esses modelos super interpretáveis, já que é possível olhar para cada nó da rede neural e ver os valores numéricos de cada um dos recursos de entrada. Para computadores, isso pode ser adequado, mas as pessoas pensam de maneira diferente. Não estou dizendo para você "Veja os pixels de 100 a 200, os valores RGB são 0,2 e 0,3". Eu digo: "Esta é uma imagem de um cachorro muito desgrenhado". As pessoas se comunicam dessa maneira - através de conceitos.

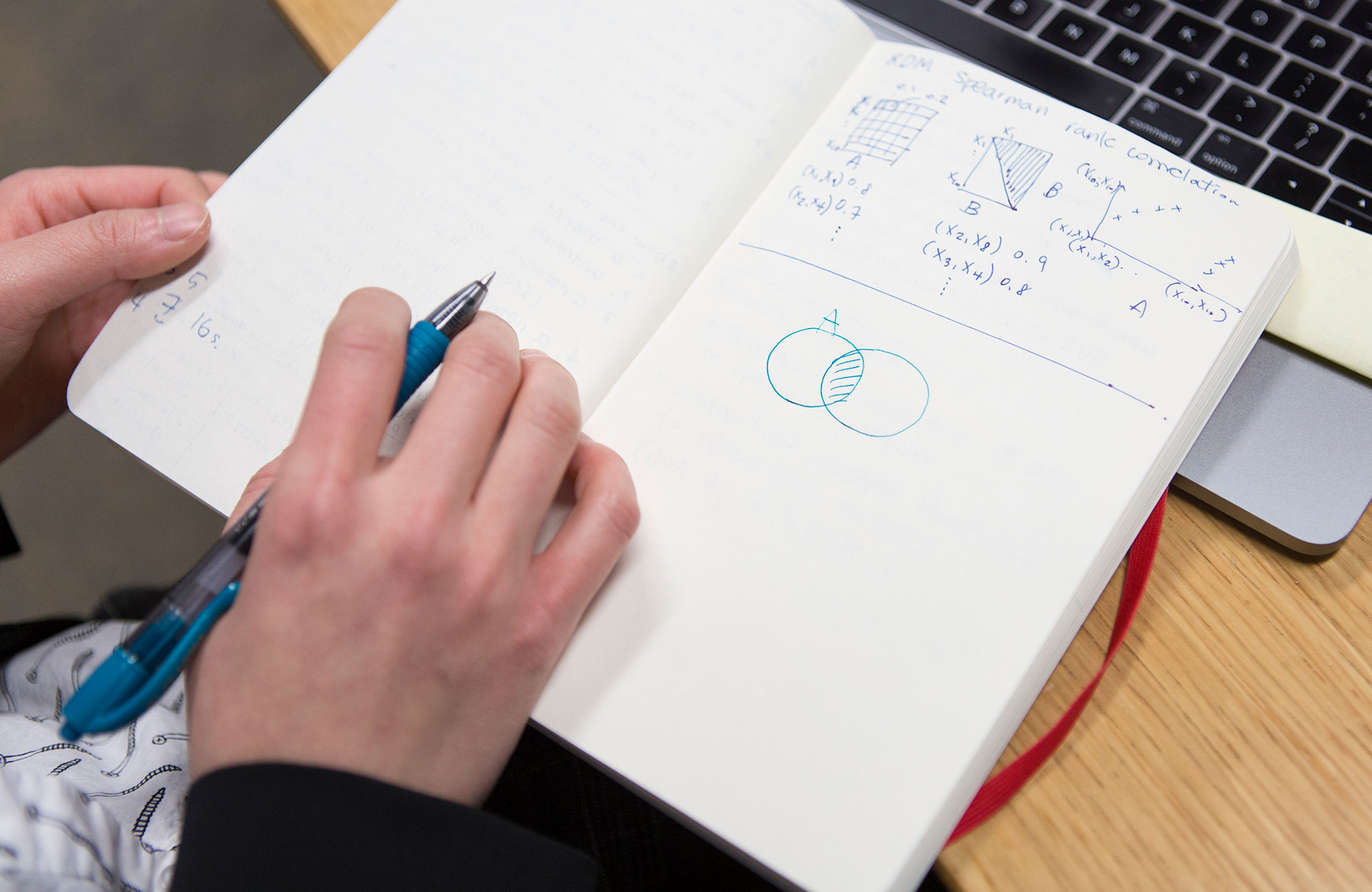

Como o TCAV se traduz entre recursos e conceitos de entrada?Vamos voltar ao exemplo de um médico usando o modelo MO, que já foi treinado para classificar imagens de amostras de células de acordo com o câncer. Você, como médico, precisa descobrir a importância do conceito de "glândulas mescladas" para o modelo fazer previsões positivas para o câncer. Primeiro, você coleciona, digamos, 20 imagens que mostram exemplos de glândulas mescladas. Em seguida, você conecta esses exemplos rotulados ao modelo.

Então, o TCAV dentro de si realiza o chamado "Verificação de sensibilidade". Quando adicionamos essas imagens rotuladas das glândulas mescladas, quanto aumenta a probabilidade de uma previsão positiva de câncer? A resposta pode ser estimada por um número de 0 a 1. E esses serão seus pontos no TCAV. Se a probabilidade aumentasse, esse conceito era importante para o modelo. Caso contrário, esse conceito não é importante.

"Conceito" é um termo vago. Existem conceitos que não funcionam com o TCAV?Se você não conseguir descrever um conceito usando um subconjunto do seu conjunto de dados, ele não funcionará. Se o seu modelo de MO é treinado em imagens, o conceito deve ser expresso visualmente. Se, por exemplo, quero expressar visualmente o conceito de amor, será bastante difícil.

Também verificamos cuidadosamente o conceito. Temos um procedimento de verificação estatística que rejeita o vetor conceitual se tiver um efeito equivalente ao aleatório no modelo. Se o seu conceito não passar neste teste, o TCAV dirá: "Não sei, esse conceito não parece algo importante para o modelo".

O projeto TCAV é mais focado na construção da confiança na IA do que na generalização de seu entendimento?

O projeto TCAV é mais focado na construção da confiança na IA do que na generalização de seu entendimento?Não, - e vou explicar o porquê, já que essa diferença é muito sutil.

De muitos estudos no campo da ciência cognitiva e da psicologia, sabemos que as pessoas são muito confiantes. Isso significa que é muito fácil enganar uma pessoa, forçando-a a acreditar em alguma coisa. O objetivo da interpretabilidade do MO é o oposto. Consiste em informar uma pessoa que não é seguro usar um sistema específico. O objetivo é descobrir a verdade. Portanto, "confiança" não é a palavra certa.

Então, o objetivo da interpretabilidade é descobrir possíveis falhas no raciocínio da IA?Sim exatamente.

Como ela pode revelar as falhas?O TCAV pode ser usado para fazer ao modelo uma pergunta sobre conceitos que não estão relacionados ao campo de pesquisa. Voltando ao exemplo de médicos usando IA para prever a probabilidade de câncer. Os médicos podem pensar subitamente: “Aparentemente, a máquina fornece previsões positivas para a presença de câncer em muitas imagens nas quais a cor é levemente alterada para azul. Acreditamos que esse fator não deve ser levado em consideração. ” E se eles obtiverem uma pontuação alta no TCAV em azul, significa que encontraram um problema em seu modelo MO.

O TCAV foi projetado para ser pendurado em sistemas de IA existentes que não podem ser interpretados. Por que não criar imediatamente sistemas interpretados em vez de caixas pretas?Há um ramo do estudo da interpretabilidade, focado na criação de modelos inicialmente interpretados que refletem o raciocínio de uma pessoa. Mas acho que sim: agora já estamos cheios de modelos de IA prontos para uso que são usados para resolver problemas importantes e, ao criá-los, não pensamos inicialmente em interpretabilidade. Tão fácil de comer. Muitos deles trabalham no Google! Você pode dizer: "A interpretabilidade é tão útil que vamos criar outro modelo para você substituir o que você possui". Bem, boa sorte.

E então o que fazer? Ainda precisamos passar por esse momento crucial para decidir se essa tecnologia é útil para nós ou não. Portanto, estou trabalhando nos métodos de interpretabilidade pós-treinamento. Se alguém lhe deu um modelo e você não pode alterá-lo, como você aborda a tarefa de gerar explicações sobre seu comportamento para poder usá-lo com segurança? É exatamente isso que o TCAV faz.

O TCAV permite que as pessoas perguntem à IA sobre a importância de certos conceitos. Mas e se não soubermos o que perguntar - e se quisermos que a IA explique?

O TCAV permite que as pessoas perguntem à IA sobre a importância de certos conceitos. Mas e se não soubermos o que perguntar - e se quisermos que a IA explique?No momento, estamos trabalhando em um projeto que pode encontrar automaticamente conceitos para você. Chamamos isso de DTCAV - o TCAV de abertura. Mas acho que o principal problema da interpretabilidade é que as pessoas participam desse processo e que permitimos que pessoas e máquinas se comuniquem.

Em muitos casos, ao trabalhar com aplicativos dos quais depende muito, os especialistas em um campo específico já possuem uma lista de conceitos que são importantes para eles. Nós do Google Brain somos constantemente confrontados com isso nas aplicações médicas da IA. Eles não precisam de um conjunto de conceitos - eles querem fornecer modelos de conceito que sejam interessantes para eles. Estamos trabalhando com um médico que trata de retinopatia diabética, doença ocular e, quando contamos a ela sobre o TCAV, ela ficou muito feliz porque já tinha um monte de hipóteses sobre o que o modelo pode fazer e agora pode verificar todas as perguntas que surgiram. Essa é uma vantagem enorme e uma maneira muito centrada no usuário de implementar o aprendizado de máquina colaborativo.

Você acha que, sem interpretabilidade, a humanidade pode simplesmente abandonar a tecnologia de IA. Considerando as oportunidades que tem, você realmente avalia essa opção como real?Sim Foi exatamente o que aconteceu com os sistemas especialistas. Na década de 1980, determinamos que eles são mais baratos do que as pessoas na solução de alguns problemas. E quem usa sistemas especialistas hoje? Ninguem E depois disso chegou o inverno da IA.

Até agora, isso não parece provável, tanto hype e dinheiro estão sendo investidos em IA. Mas, a longo prazo, acho que a humanidade pode decidir - talvez por medo, talvez por falta de evidências - que essa tecnologia não nos convém. É possível