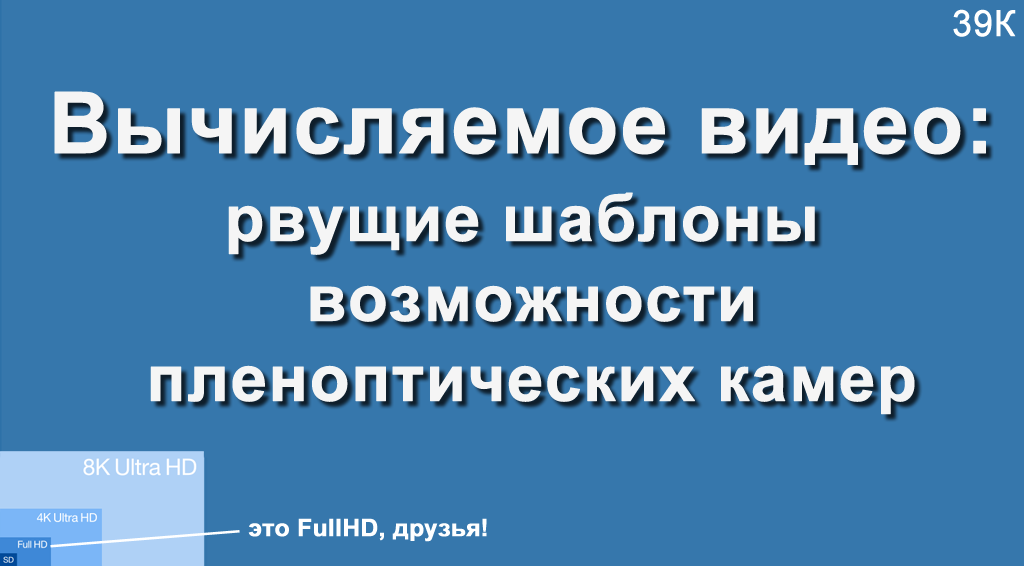

Algum tempo atrás, o autor teve a chance de dar uma palestra no VGIK, e havia muitas pessoas da câmara na platéia. A platéia foi questionada: “Com qual resolução máxima você filmou?”, E descobriu-se que cerca de uma terceira cena 4K ou 8 megapixels, o resto - não mais que 2K ou 2 megapixels. Foi um desafio! Eu tive que falar sobre a câmera com uma resolução de 755 megapixels (resolução bruta, para ser preciso, já que possui um 4K final) e que possibilidades encantadoras isso oferece para a filmagem profissional.

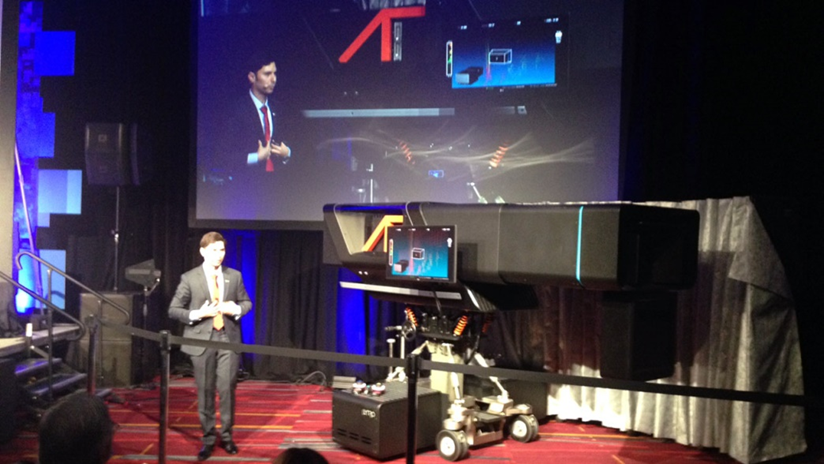

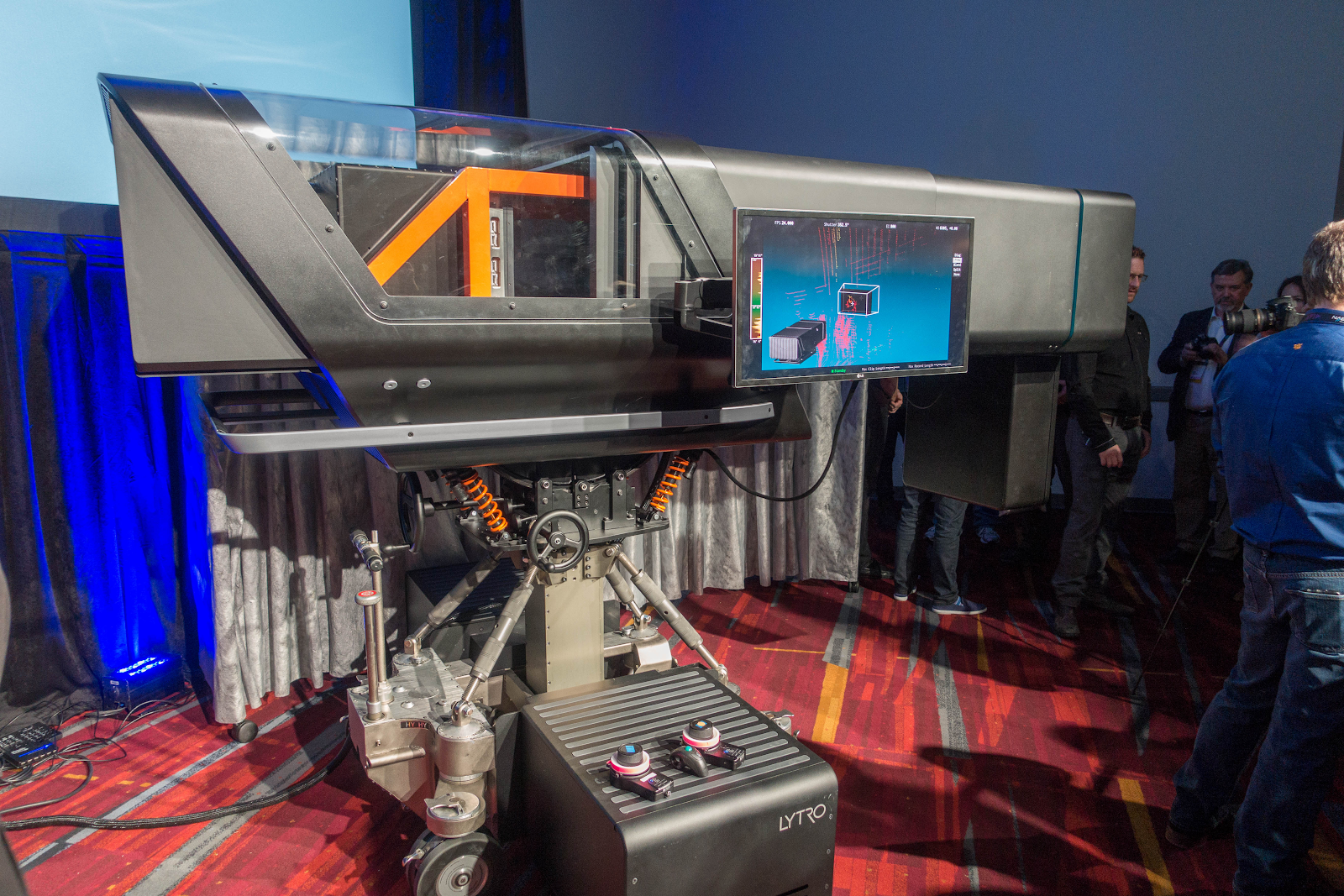

A câmera em si é assim (uma espécie de pequeno elefante):

Além disso, vou abrir um segredo terrível. Para tirar uma foto, procurávamos um ângulo melhor e uma pessoa maior. Por acaso senti esta câmera ao vivo, vou dizer que ela parece

muito maior. A imagem abaixo com Yon Karafin, com quem temos a mesma altura, reflete com mais precisão a escala do desastre:

Quem se importa, em princípio, com as capacidades do vídeo calculado sobre o qual eles raramente escrevem - toda a verdade está escondida! )

Discussões sobre as possibilidades dos plenópticos me lembram discussões sobre a primeira aeronave:

O que as pessoas disseram:

-

É muito caro ...SIM!-

É completamente impraticável e agora não compensa ...SIM!-

É perigoso usar ...-

Droga, sim!-

Parece miserável!-

Droga, SIM, mas voa, veja, LE-TA-ET !!!

Após 50 anos, esses experimentos deram origem a uma maneira fundamentalmente nova, conveniente e bastante segura de se mover pelos oceanos (e não apenas).

A situação é a mesma aqui. Absolutamente o mesmo! Agora, exige custos irracionais, inconveniente de usar e parece péssimo, mas é realmente VOAR! E estar ciente dos princípios e perspectivas emergentes - é simplesmente muito além da inspiração (pelo menos, seu humilde servo)!

O monstro na foto acima lembra um pouco as primeiras câmeras, que também eram grandes, com uma lente enorme e giravam em um quadro especial:

Fonte: Filmagem televisiva das Olimpíadas de 1936 no início da televisão

Fonte: Filmagem televisiva das Olimpíadas de 1936 no início da televisãoAqui se parece muito, também uma lente enorme (porque também não há luz suficiente), uma câmera pesada com uma suspensão especial, tamanhos enormes:

Fonte: Lytro pronta para mudar para sempre o cinema

Fonte: Lytro pronta para mudar para sempre o cinemaO interessante: a “mala” abaixo é um sistema de refrigeração líquida, em caso de falha da qual a câmera não pode tirar mais fotos.

O grande retângulo sob a lente (claramente visível na primeira foto acima) não é a luz de fundo, mas o lidar - um telêmetro a laser que fornece uma cena tridimensional na frente da câmera.

Um torniquete preto grosso no canto inferior esquerdo é um conjunto de cabos de fibra ótica com cerca de 4 centímetros de diâmetro, através dos quais a câmera envia um fluxo monstruoso de informações para um armazenamento especial.

Os participantes do tópico já reconheceram o

Lytro Cinema , dos quais 3 peças foram criadas. O primeiro, que geralmente aparece em todas as fotos, é fácil de reconhecer por um

lidar sob a lente. Após 1,5 anos, uma segunda câmara foi criada com problemas estruturais corrigidos do primeiro e dos dois lidares (e, infelizmente, quase ninguém escreve sobre isso). Além disso, o progresso no desenvolvimento, por exemplo, de lidares em 1,5 anos foi tão grande que dois lidares da segunda câmara deram 10 vezes mais pontos do que um lidar do primeiro. A terceira câmera deveria ter aproximadamente as mesmas características de resolução (para atender aos requisitos dos cineastas), mas ter metade do tamanho (o que é crítico para o uso prático). Mas ... mas mais sobre isso depois.

De qualquer forma, em todos os aspectos, reconhecendo o excelente papel que Lytro desempenhou na popularização da tecnologia de

tiro em

plenóptica , gostaria de observar que a luz não convergia para ela. Uma câmera semelhante foi feita no

Fraunhofer Institute ,

Raytrix , um produtor de câmeras plenópticas, existe com segurança e, novamente, não me foi permitido fotografar o Lytro Cinema, porque tinha muito medo de várias empresas chinesas que estavam trabalhando ativamente nessa direção (não consegui encontrar novas informações sobre elas).

Portanto, vamos anotar os pontos em todas as vantagens que os plenópticos oferecem e sobre os quais eles quase não escrevem. Mas justamente por isso é garantido o sucesso.

Em vez de introduzir

Somente em Habré e apenas Lytro é mencionado

em aproximadamente 300 páginas , portanto, seremos curtos.

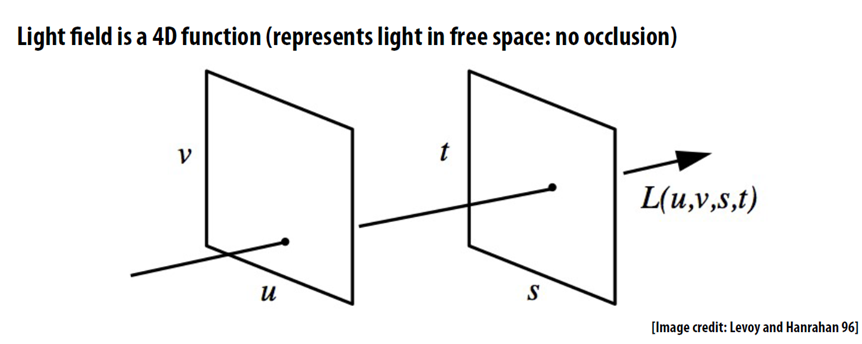

O conceito-chave para fotografar em plenóptica é o campo de luz, ou seja, não fixamos a cor do pixel em cada ponto, mas uma matriz bidimensional de pixels, transformando um quadro bidimensional miserável em um quadro quadridimensional normal (geralmente com muito pouca resolução em te até agora):

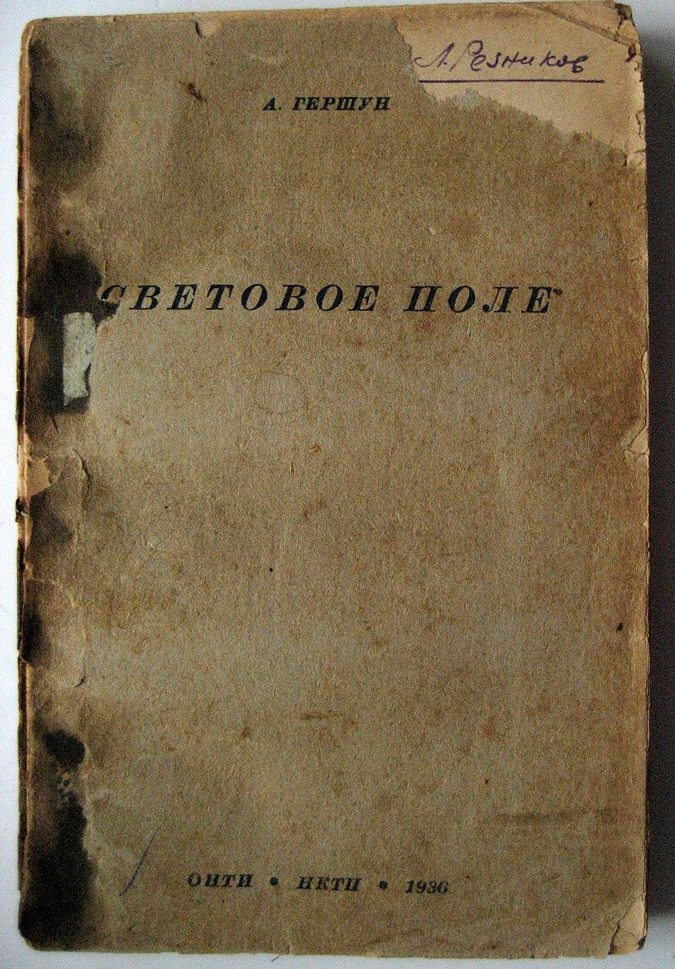

Na

Wikipedia em inglês , e

depois no russo em artigos sobre o campo de luz, diz-se que "A frase" campo de luz "foi usada

por A. Gershun em ... 1936." Para ser justo, observamos que essa não foi por

acaso “frase usada”, mas o nome de um

pequeno livro de 178 páginas , chamado “Campo de Luz”:

E mesmo naquela época, essas obras eram bastante aplicadas na natureza e o autor, seis anos depois, no auge da guerra em 1942, recebeu o Prêmio Stalin de segundo grau pelo método de blecaute.

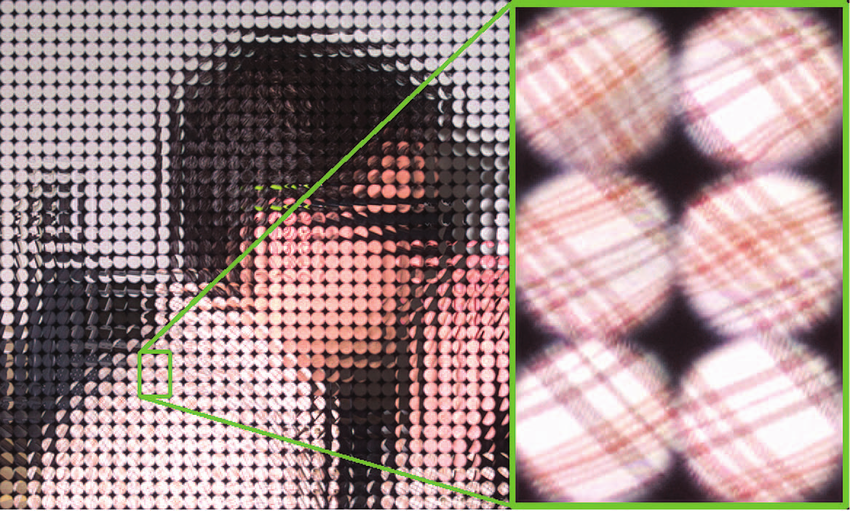

Na prática, fotografar um quadro quadridimensional do campo de luz fornece uma matriz de microlentes localizadas na frente do sensor da câmera:

Fonte: plenoptic.inf® (você pode clicar e ver em resolução total)

Fonte: plenoptic.inf® (você pode clicar e ver em resolução total)Na verdade, é precisamente porque temos um conjunto de microlentes com uma pequena distância entre eles que possibilitou a criação do Lytro Cinema, cujo sensor foi montado a partir de um conjunto de sensores cujas fronteiras caem na borda das lentes. Foi necessário arrefecimento líquido para arrefecer um maciço muito quente.

Fonte: Uso de câmeras plenópticas focadas para captura de imagens ricas

Fonte: Uso de câmeras plenópticas focadas para captura de imagens ricasComo resultado, temos a possibilidade mais famosa de câmeras plenópticas, sobre as quais apenas os preguiçosos não escreveram - para alterar a distância de foco após a tomada da foto (esses pássaros fofos não esperavam pelo foco):

Fonte: Lytro

Fonte: LytroE pouco foi escrito sobre a aparência dos plenópticos em uma resolução adequada para um filme (abre por clique):

Fonte: Assista Lytro Change Cinematography Forever

Fonte: Assista Lytro Change Cinematography ForeverAbro outro segredo: o foco calculado é a ponta do iceberg dos plenópticos. E os 90% de oportunidades restantes abaixo do nível de interesse dos jornalistas, na minha opinião, são ainda mais interessantes. Muitos deles são dignos de artigos separados, mas vamos pelo menos corrigir a injustiça e pelo menos chamá-los. Vamos lá!

Forma de abertura calculada

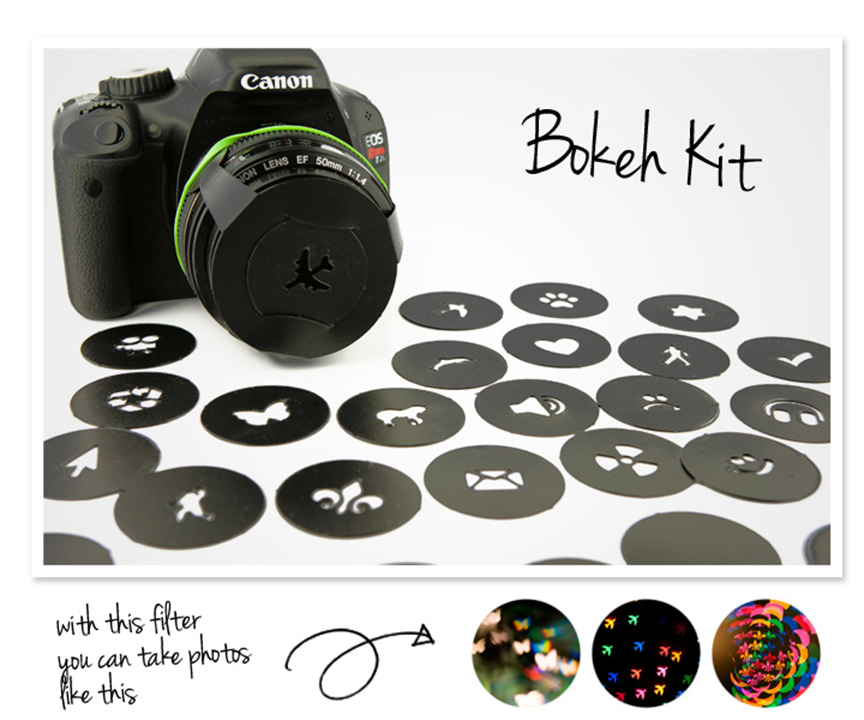

Como estamos falando de desfocagem, vale mencionar o chamado

efeito bokeh , no qual o brilho não é necessariamente redondo

Para os fotógrafos,

é lançado o chamado

Kit Bokeh , que permite obter brilho de várias formas:

Isso permite que você obtenha imagens bem bonitas, e a foto abaixo mostra claramente que os brilhos em forma de coração têm pedras em primeiro plano, apenas corações são menores. E está claro que tentar desfocar naturalmente de maneira semelhante no Photoshop é extremamente difícil, pelo menos é recomendável usar um mapa de profundidade:

Ao mesmo tempo, para os plenópticos “calcularem” uma abertura diferente é uma tarefa relativamente fácil:

Então! Calculamos a distância de foco, calculamos a forma da abertura, fomos mais longe, é mais interessante lá!

Estéreo Computado

Uma característica muito útil do sensor plenóptico, sobre o qual quase ninguém menciona, mas que já lhe dá uma segunda vida, é a capacidade de calcular uma imagem a partir de diferentes pontos. A localização do ponto é realmente determinada pelo tamanho da lente. Se a lente for pequena, o quadro poderá mudar ligeiramente para a esquerda e para a direita, como neste exemplo (que esta foto estéreo é visível se você olhar para o peito do pássaro mais próximo):

Fonte: Lytro

Fonte: LytroSe a lente for grande, como, por exemplo, o Lytro Cinema, o ponto de disparo poderá ser deslocado em 10 centímetros. Deixe-me lembrá-lo de que, entre nossos olhos, temos cerca de 6,5 centímetros, ou seja, com uma distância máxima de 10 cm, é possível filmar o plano geral (e será "tridimensional" do que se você olhar com os olhos)) e close-up (com qualquer paralaxe sem desconforto). De fato, isso significa que podemos gravar vídeo estéreo completo com uma lente. Além disso, não será apenas estéreo, mas estéreo com qualidade perfeita e que parece fantástico hoje - com uma distância variável entre os eixos ópticos das câmeras virtuais após o disparo. Tanto isso como outro - oportunidades absolutamente impensáveis que podem mudar cardealmente uma situação com a gravação em estéreo no futuro.

Como o futuro está de alguma forma no tiroteio tridimensional, vamos nos debruçar sobre esses dois pontos com mais detalhes. Não é segredo que hoje a maioria dos filmes em 3D, especialmente os blockbusters, não são removidos, mas convertidos em 3D. Isso é feito porque, ao fotografar, surge uma longa lista de problemas (abaixo faz parte da lista):

- Os quadros podem ser girados, deslocados verticalmente ou ampliados um em relação ao outro (não diga que isso é facilmente corrigido, veja com que frequência esses quadros entram nos lançamentos de filmes - isso é um horror silencioso ... e uma dor de cabeça). Portanto - o estéreo plenóptico está perfeitamente alinhado, mesmo que o operador decida ampliar o plano (devido à mecânica das duas câmeras, é extremamente difícil tornar a aproximação estritamente síncrona).

- Os quadros podem variar de cor , especialmente se a fotografia exigir uma pequena distância entre os eixos ópticos das câmeras e você precisar usar um separador de feixes (houve um post detalhado sobre isso). Acontece que, em uma situação em que, ao fotografar qualquer objeto de reflexo (o carro ao fundo em um dia ensolarado), estamos fadados ao entretenimento na pós-produção com a grande maioria das câmeras; no plenóptico, teremos uma imagem PERFEITA com qualquer brilho. Este é um feriado!

- Os quadros podem variar em nitidez - novamente, um problema perceptível nos separadores de feixe, que está completamente ausente nos plenópticos. Com que nitidez é necessária, com isso calcularemos, absolutamente PERFEITO a partir dos ângulos.

- Os quadros podem flutuar no tempo . Os colegas que trabalharam com o material de Stalingrado falaram sobre a discrepância entre os registros de data e hora das faixas por 4 quadros, e é por isso que o cracker ainda é relevante. Encontramos mais de 500 cenas com diferenças de horário em 105 filmes. Infelizmente, a diferença horária é difícil de detectar, especialmente em cenas com câmera lenta, e ao mesmo tempo é o artefato mais doloroso de acordo com nossas medidas. No caso dos plenópticos, teremos sincronização de horário PERFEITA.

- Outra dor de cabeça ao fotografar em 3D é paralaxes muito grandes que causam desconforto ao visualizar em uma tela grande, quando seus olhos podem divergir para os lados para objetos "além do infinito" ou convergir para alguns objetos em primeiro plano. O cálculo correto da paralaxe é um tópico difícil e separado do qual os operadores devem ter um bom comando, e um objeto que acidentalmente entra no quadro pode arruinar a tomada, tornando-a desconfortável. Com os plenópticos, nós mesmos escolhemos o paralaxe APÓS a gravação, para que qualquer cena possa ser calculada com paralaxe PERFEITO, além disso, a mesma cena já gravada pode ser facilmente calculada para telas grandes e telas pequenas. Essa é a chamada mudança de paralaxe, que geralmente é extremamente difícil e dispendiosa sem perda de qualidade, especialmente se você tiver objetos ou bordas translúcidas em primeiro plano.

Em geral, a capacidade de CALCULAR o som estéreo perfeito é a base real para a próxima onda de popularidade em 3D, pois nos últimos 100 anos cinco dessas ondas foram distinguidas. E, a julgar pelo progresso na projeção a laser e no plenóptico, um máximo de 10 anos (quando as principais patentes da Lytro expiram ou um pouco antes na China) nos aguardam um novo ferro e um novo nível de filmes 3D de qualidade.

Então! Eles obtiveram o som estéreo calculado perfeito de uma lente (a propósito, algo impossível para a maioria). E eles não apenas entenderam, mas também relataram a paralaxe após o fato, mesmo que o objeto esteja fora de foco em primeiro plano. Vamos mais fundo!

Ponto de Disparo Calculado

Alterar o ponto de disparo tem uma aplicação em vídeo 2D comum.

Se você estava no set ou ao menos viu fotografias, provavelmente prestou atenção nos trilhos pelos quais a câmera viaja. Geralmente, para uma cena, é necessário colocá-las em várias direções, o que leva um tempo perceptível. Os trilhos garantem o bom funcionamento da câmera. Sim, é claro, existe um

steadicam , mas em muitos casos os trilhos, infelizmente, não têm alternativa.

A capacidade de alterar o ponto de tiro no Lytro foi usada para demonstrar que existem rodas suficientes. De fato, quando a câmera se move, formamos um “tubo” virtual com um diâmetro de 10 cm no espaço, dentro do qual podemos mudar o ponto de disparo. E este tubo permite compensar pequenas flutuações. Isso é bem mostrado neste vídeo:

Além disso, às vezes você precisa resolver o problema inverso, ou seja, adicionar oscilações durante o movimento. Por exemplo, não havia dinâmica suficiente e o diretor decidiu fazer uma explosão. Não demora muito para aplicar um som, mas é aconselhável agitar a câmera de forma síncrona, e é melhor não apenas mover a imagem plana, ela ficará visível, mas agitá-la "honestamente". Com os plenópticos, o ponto de disparo pode ser sacudido completamente “honestamente” - com uma mudança no ponto de disparo, ângulo, desfoque de movimento, etc. Haverá uma ilusão completa de que a câmera tremeu violentamente, o que conduzia com suavidade e segurança sobre rodas. Concordo - uma oportunidade incrível! A próxima geração de steadicam mostrará milagres.

Obviamente, para que isso se torne realidade, você precisa esperar até que o tamanho da câmera plenóptica seja reduzido a um tamanho razoável. Mas, considerando quanto dinheiro está sendo investido em miniaturização e aumentando a resolução de sensores para smartphones e tablets, parece que a espera não é tão longa. E será possível criar uma nova câmera plenóptica! Todos os anos, fica cada vez mais fácil.

Então! O ponto de disparo foi calculado e, se necessário, movido, estabilizando ou desestabilizando a câmera. Vamos mais longe!

Iluminação Computada

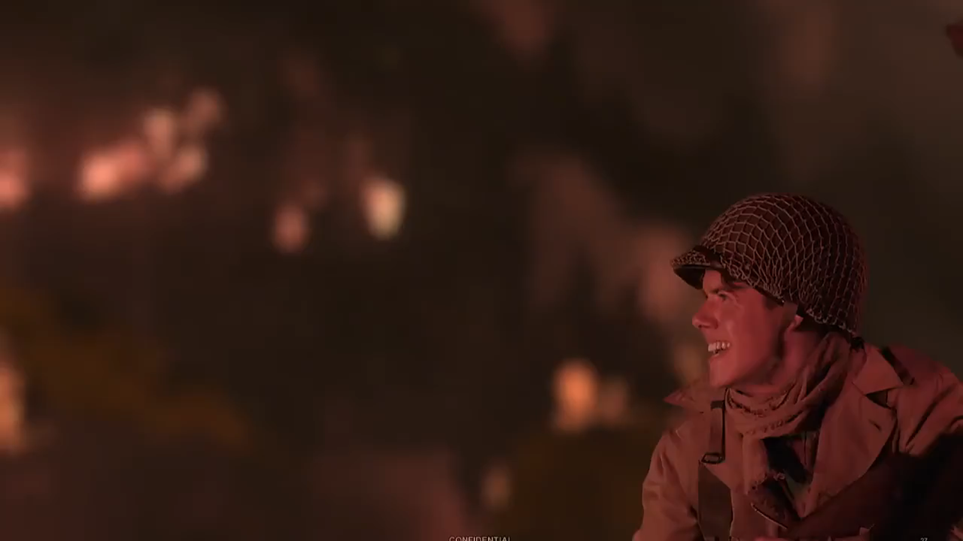

Desde que estamos falando de uma explosão nas proximidades ...

Às vezes, torna-se necessário alterar a iluminação do objeto, por exemplo, adicionar um flash de forma realista. Os estúdios de pós-produção sabem muito bem o que é um problema difícil, mesmo que as roupas de nosso personagem sejam relativamente simples.

Aqui está um exemplo de um vídeo com uma sobreposição de flash, levando em consideração as roupas, suas sombras etc. (abre por clique):

Fonte: Entrevista com Yon Karafin

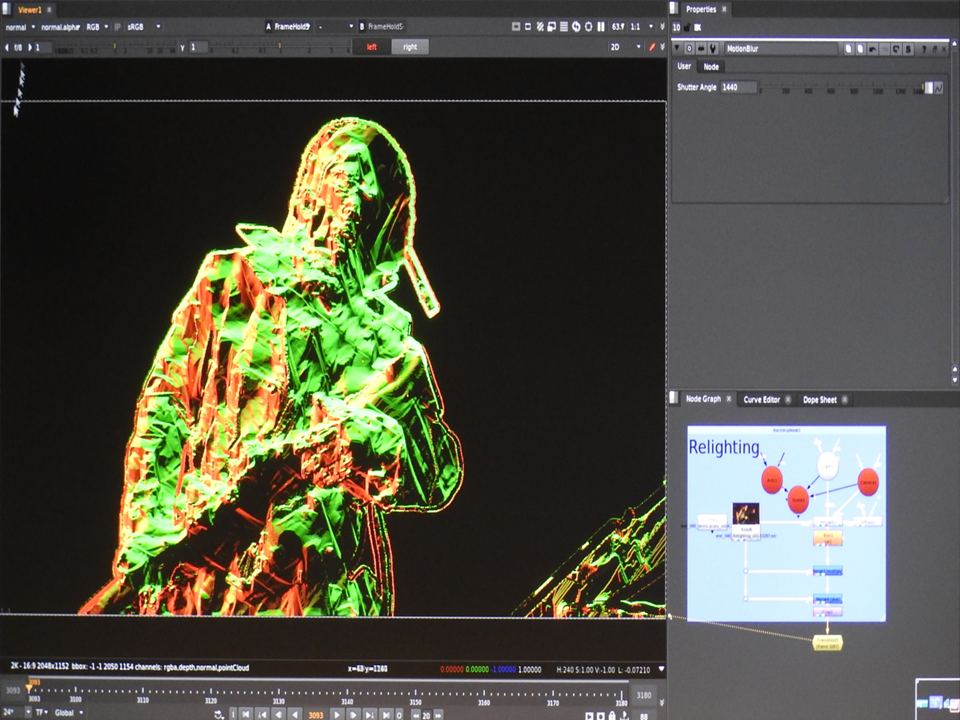

Fonte: Entrevista com Yon KarafinSob o capô, parece um plug-in da Nuke, que funciona com um modelo tridimensional completo do ator e coloca uma nova luz nele, levando em consideração o mapa normal, os materiais, o motion blur e assim por diante:

Fonte: Lytro Materials

Fonte: Lytro MaterialsEntão! A nova iluminação do objeto já capturado foi calculada. Vamos mais longe!

Resolução computada

Aqueles que experimentaram o primeiro Lytro notaram com frequência - sim, o brinquedo é legal, mas a resolução é completamente insuficiente para a fotografia normal.

Em

nosso último artigo sobre Habr, foi descrito como pequenas mudanças no ponto de disparo podem ajudar a aumentar significativamente a resolução. Pergunta: Esses algoritmos são aplicáveis aos plenópticos? Resposta: Sim! Além disso - os algoritmos de super resolução são mais fáceis de trabalhar em imagens plenópticas, uma vez que existe um mapa de profundidade, todos os pixels são capturados de uma só vez e as mudanças são conhecidas com muita precisão. Ou seja, a situação dos plenópticos é simplesmente mágica em comparação com as condições sob as quais os algoritmos de Super Resolução funcionam em 2D comum. O resultado é correspondente:

Fonte: Restauração de quadro plenóptico ingênuo, inteligente e de super resolução do Relatório Técnico da Adobe “Superresolution with Plenoptic Camera 2.0”

Fonte: Restauração de quadro plenóptico ingênuo, inteligente e de super resolução do Relatório Técnico da Adobe “Superresolution with Plenoptic Camera 2.0”O único grande problema (realmente grande!) É a quantidade de dados e a quantidade de computação necessária. No entanto, hoje é completamente realista carregar uma fazenda de computação à noite e obter amanhã o dobro da resolução onde for necessário.

Então - descobri a resolução calculada! Vamos mais longe!

Ambiente computado

Uma tarefa separada que surge no estágio de pós-produção, especialmente se for algum tipo de projeto fantástico ou de fantasia, é colar cuidadosamente os objetos capturados em uma cena tridimensional. Globalmente, não há grande problema. Hoje, a norma é a digitalização tridimensional da área de filmagem e tudo o que resta é combinar cuidadosamente o modelo da cena e a cena tridimensional para que não haja clássicos do gênero quando as pernas dos atores às vezes caem levemente no piso irregular pintado (esse batente não é muito visível na tela pequena, mas pode ser visto com clareza) no cinema, especialmente em algum lugar no IMAX).

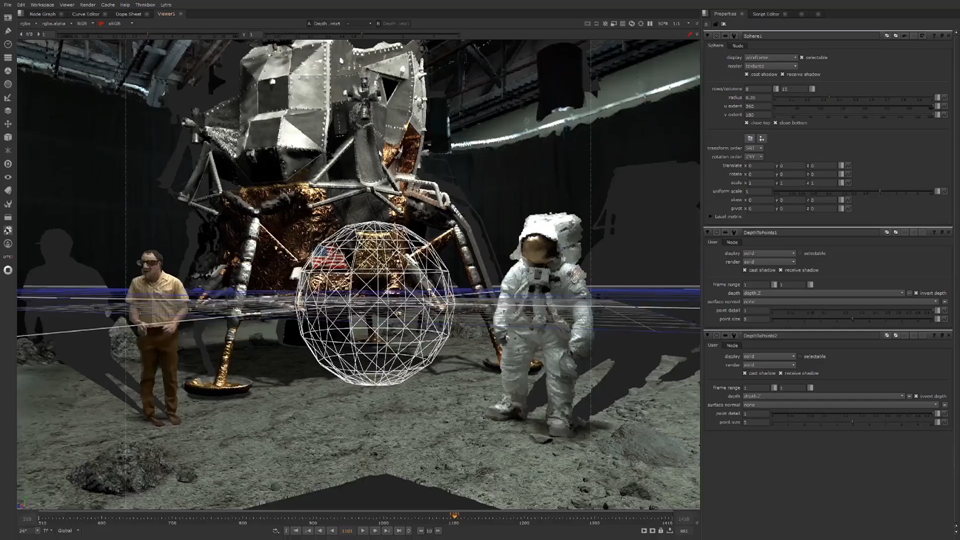

Não sem humor, para um exemplo da operação da câmera, foi usada a cena do disparo do pouso na lua ("sombras tridimensionais" são claramente visíveis em lugares que a câmera não vê):

Fonte: Lua | Lytro Teatro VR | Lightfield pós-produção

Fonte: Lua | Lytro Teatro VR | Lightfield pós-produçãoComo um vídeo multi-ângulo é filmado em uma câmera plenóptica por definição, a construção de um mapa de profundidade não é um grande problema. E se a câmera for combinada com o lidar - filmamos imediatamente uma cena tridimensional, que simplifica categoricamente a combinação de fotos e gráficos reais na próxima etapa.

Então, contamos a cena tridimensional (combinando dados lidar e dados plenópticos). Agora, você adivinhou, a renderização da pesquisa lunar será ainda melhor! Vá em frente.

Chave de croma calculada

Mas isso não é tudo!

A tecnologia usual de um set de filmagem moderno é

a tela verde , quando em locais onde o fundo de um computador deve ser colocado em escudos de madeira compensada ou faixas verdes. Isso é feito para que não haja problemas nas bordas translúcidas quando o fundo for alterado. 4 — ( ) .

, , , , . , , :

:

: Lytro , (

- — !), ( challenge), , ( , , ):

, ? . , , ( ). ,

.

« », . . , 2D . .

, , !

— . , , , , . , «» .

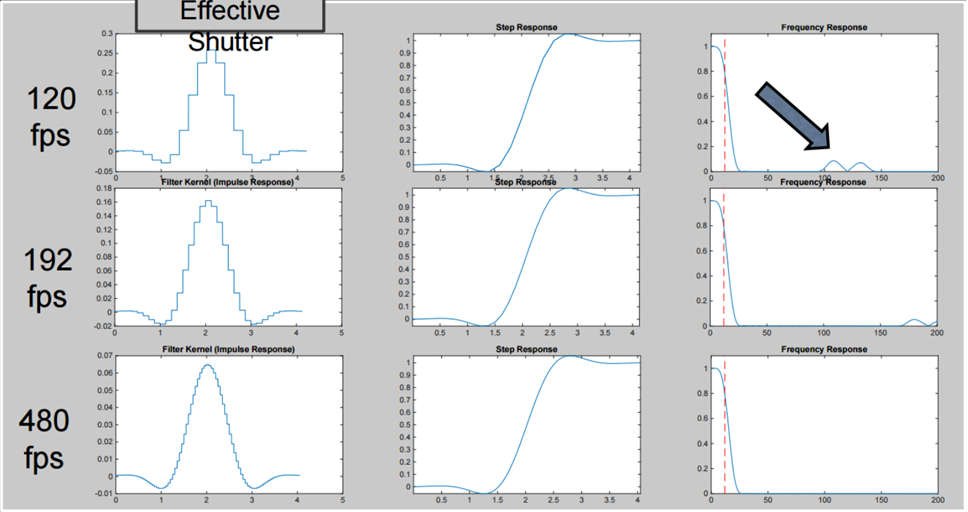

, «» «» , , , , , , ( Lytro Cinema 300 fps, , ):

«» , , , «» «» , ( , , ):

: https://vimeo.com/114743605

: https://vimeo.com/114743605, , :

: https://vimeo.com/114743605

: https://vimeo.com/114743605, . !

Normalmente, quando se trata de plenópticos hoje, há conversas típicas no estilo de

"O chefe se foi: o gesso é removido, o cliente está saindo!" Lytro comprou o Google a preço baixo no ano passado, os experimentos da Pelican Imaging não entraram em produção em massa e, em geral, tudo permaneceu apenas uma bela teoria ...

Fonte: Pelican Imaging: Módulos de câmera plenóptica para smartphones por 20 dólares

Fonte: Pelican Imaging: Módulos de câmera plenóptica para smartphones por 20 dólaresEntão lá vai você! Os rumores sobre a morte dos plenópticos são muito exagerados. Muito forte!

Pelo contrário, neste momento, os sensores plenópticos são produzidos e usados em uma escala

nunca antes vista na história.

A notória empresa do Google, sem muito alarde, lançou o Google Pixel 2 e o Google Pixel 3 com sensores plenópticos. Se você olhar para o telefone, poderá ver claramente que a câmera possui uma câmera:

No entanto, ao mesmo tempo, o telefone faz um desfoque muito bom do plano de fundo, em geral, não é pior do que os colegas de "dois olhos", "três olhos" e "quatro olhos" (concorda que a foto a seguir se beneficia especialmente desse efeito):

Fonte: AI Google Blog (você pode clicar e ver um tamanho maior, principalmente nas bordas do objeto em primeiro plano)

Fonte: AI Google Blog (você pode clicar e ver um tamanho maior, principalmente nas bordas do objeto em primeiro plano)Como eles fazem isso ?!

Uma fonte de milagres mágicos, inevitável nos últimos tempos, está sendo usada - magia infantil das redes neurais?

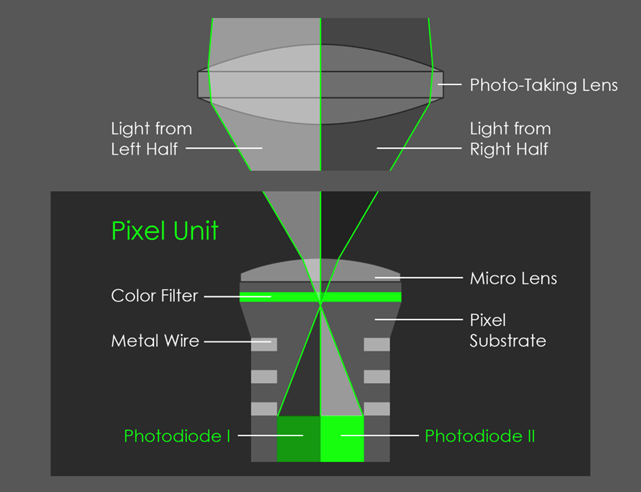

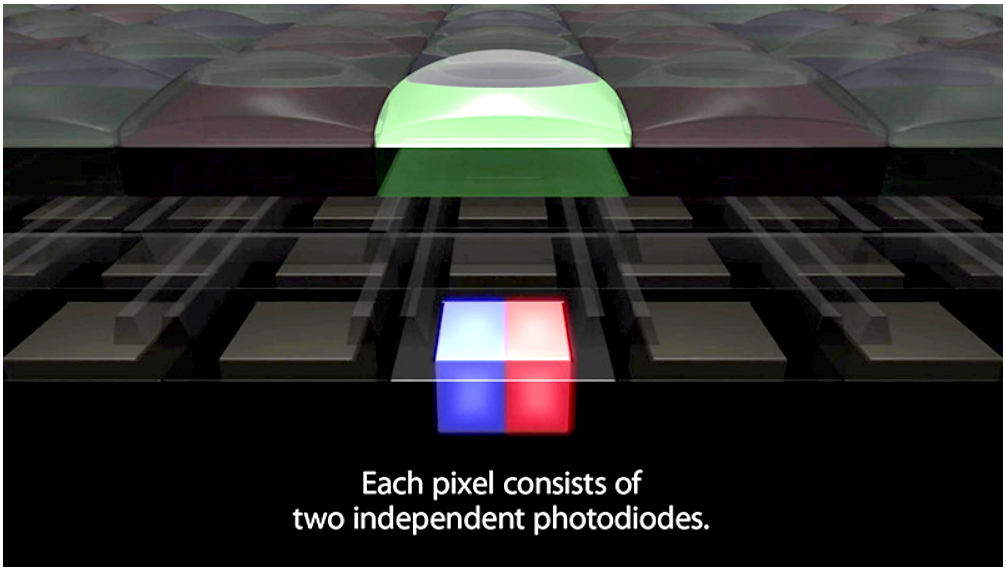

As redes neurais, especialmente no Pixel 3, também são usadas ativamente nessa tarefa, mas mais tarde. E o segredo da qualidade do efeito é que o sensor do smartphone é plenóptico, embora a lente cubra apenas dois pixels, como mostra a figura:

Fonte: AI Google Blog

Fonte: AI Google BlogComo resultado, obtemos uma imagem micro-estéreo, aqui uma mudança muito leve é visível no movimento (a imagem certa é animada e se move para cima e para baixo, porque o telefone foi mantido dessa maneira ao fotografar):

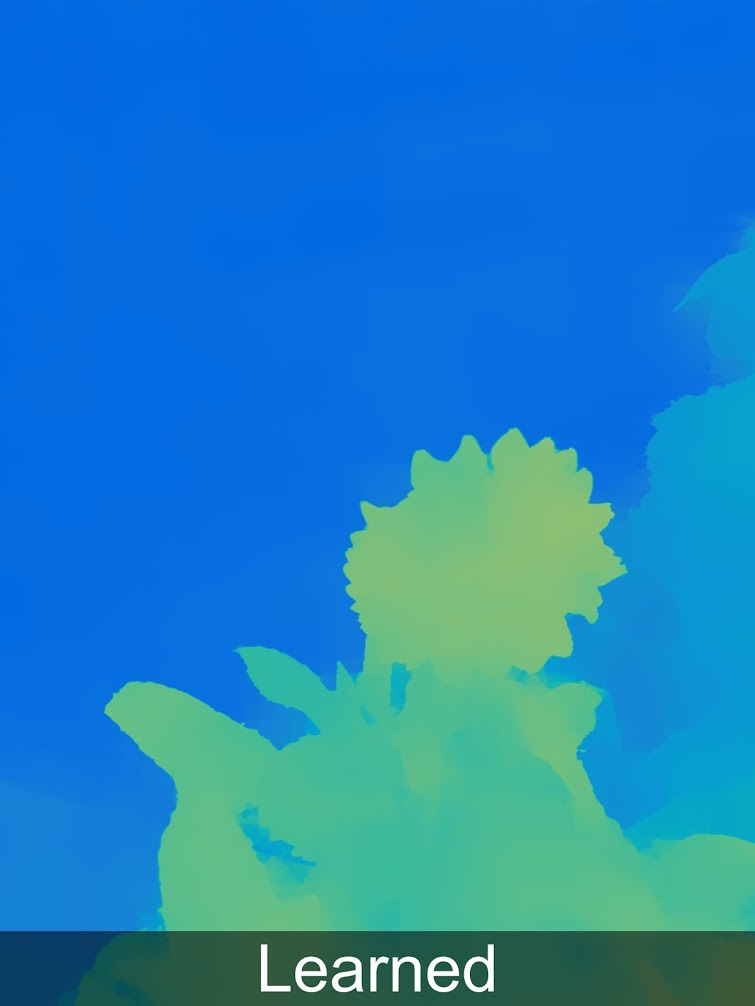

Mas mesmo essa mudança extremamente pequena é suficiente para criar um mapa de profundidade para a foto que está sendo tirada (sobre o uso de mudanças de subpixel

em um artigo anterior ):

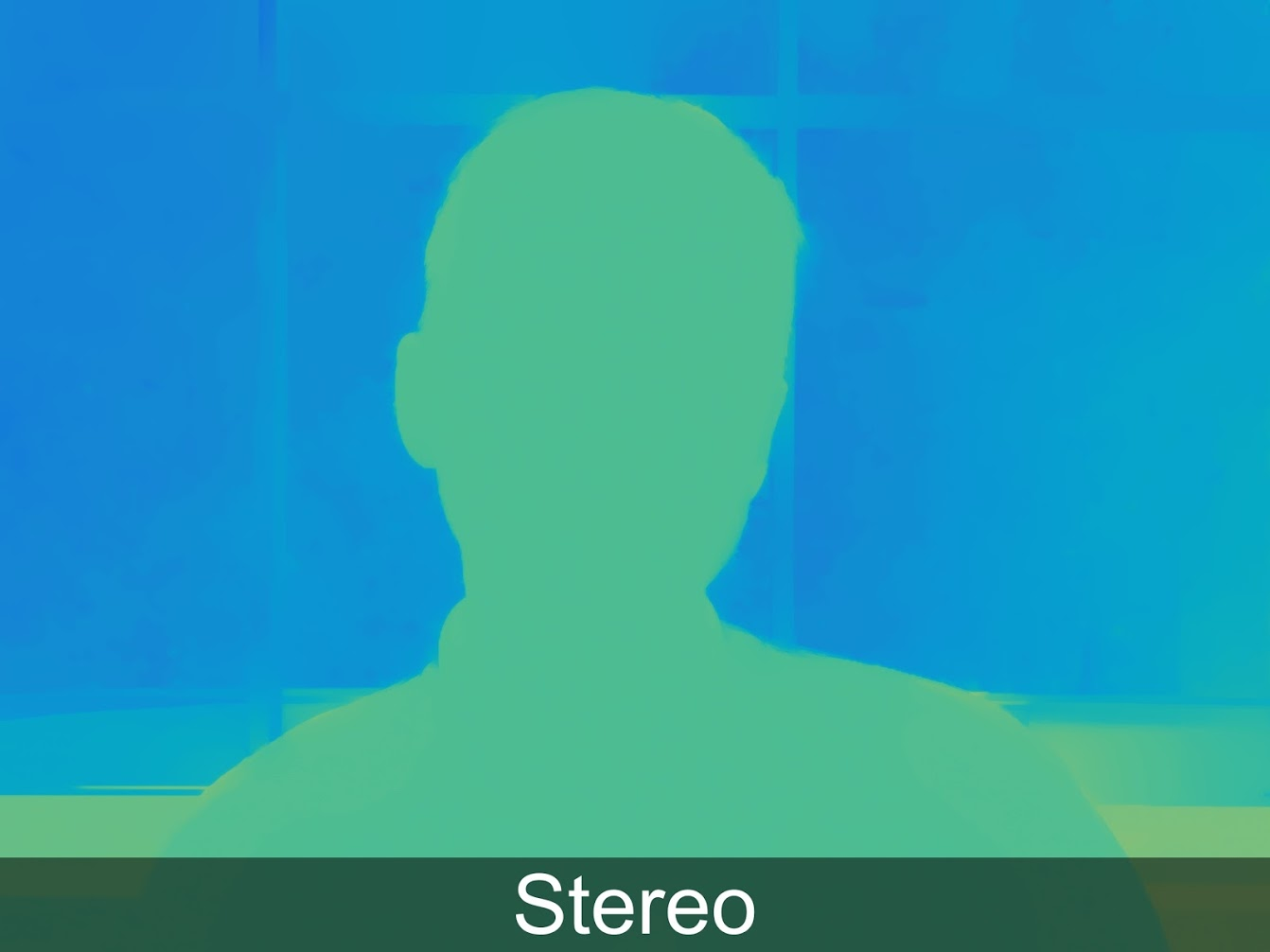

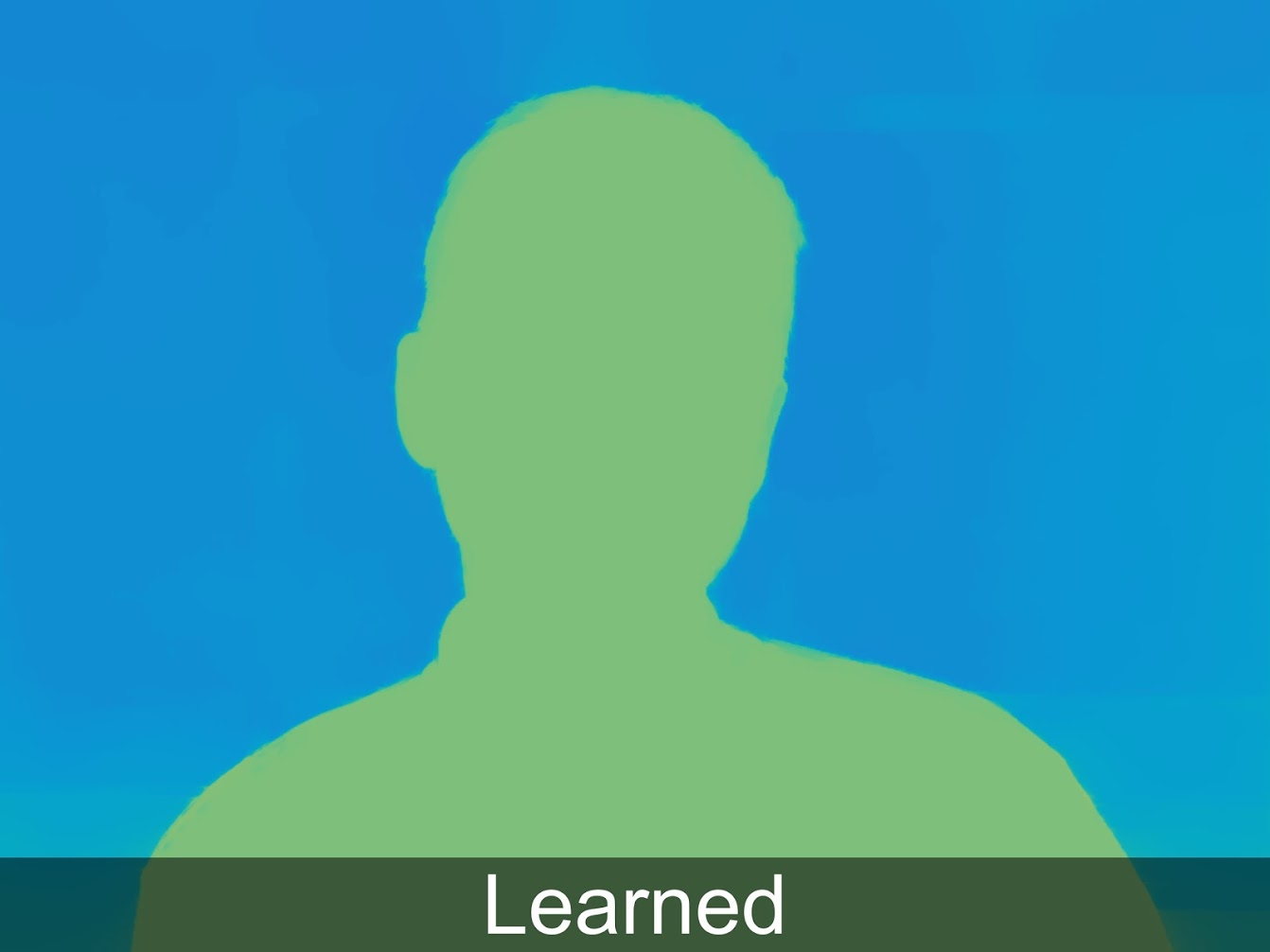

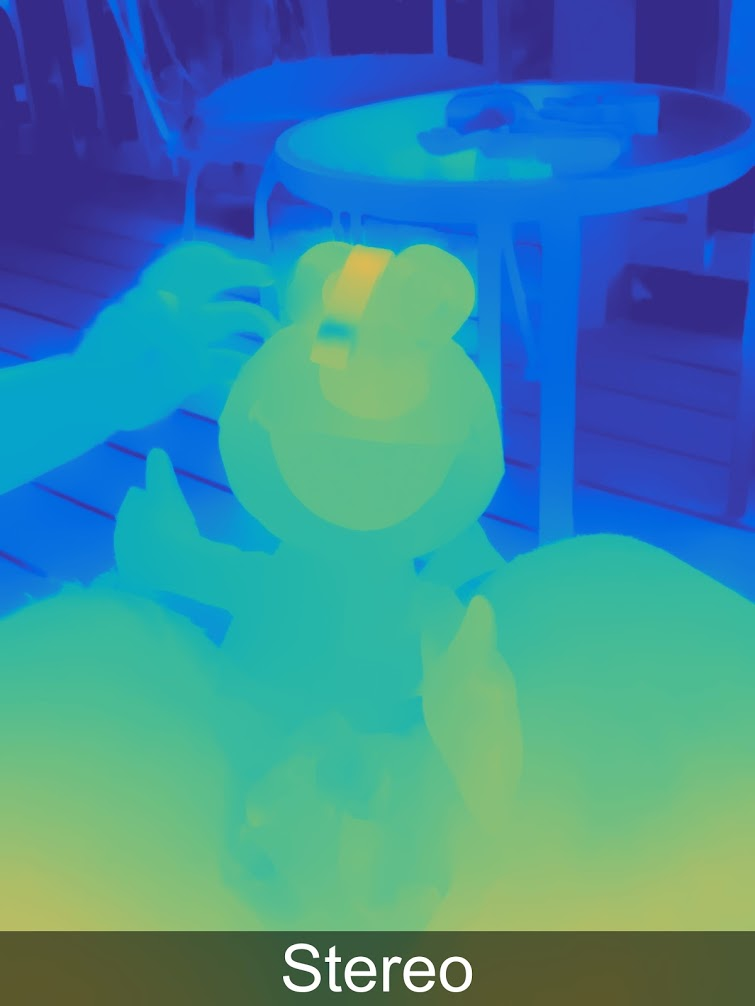

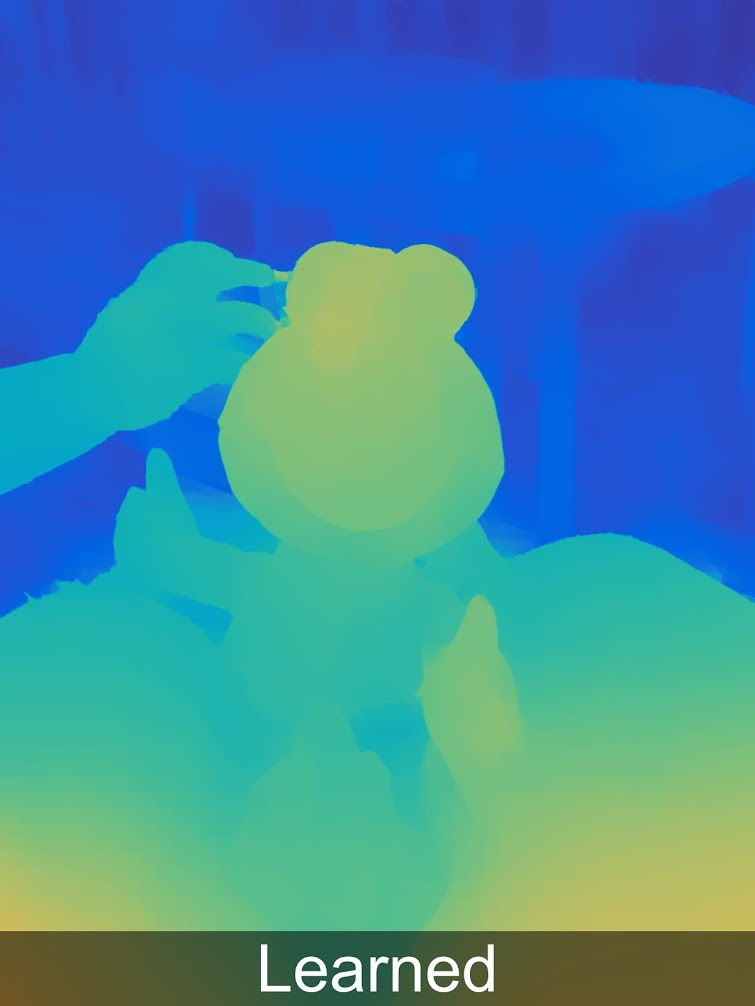

Ao mesmo tempo, com o uso do aprendizado de máquina, os resultados podem ser significativamente aprimorados e isso já está implementado no Pixel 3. No exemplo abaixo, Aprendido significa Estéreo + Aprendido, mais sobre isso, espero que haja uma postagem separada:

Para quem gosta de ver a profundidade em resolução total, há mais exemplos

em uma galeria especial .

É claramente visto que nem tudo é perfeito, e temos artefatos típicos para a construção de um mapa de profundidade a partir de estéreo (que, a propósito, também estão disponíveis nos colegas de dois olhos de Pixel), e um pouco de paralaxe. Mas já está claro que a qualidade da profundidade é suficiente para segmentar com segurança a imagem por profundidade e impor efeitos diferentes, adicionar objetos à cena com mais confiança e assim por diante. Os resultados da profundidade MEDIDA são uma ordem de magnitude melhor que os resultados baseados em várias suposições (redes arbitrariamente neurais).

Então, parabéns a todos que leram até este ponto! Você vive durante o lançamento de câmeras plenópticas em um produto de sucesso no mercado de massa, mesmo que você nem saiba!

A história não termina aí, é claro:

- Em primeiro lugar, é interessante que os plenópticos sejam "quase gratuitos", pois nas modernas câmeras de smartphones com uma miniaturização do sensor e um aumento na resolução, há uma falta catastrófica de fluxo luminoso, de modo que cada pixel é coberto com microlentes. Ou seja, esse sensor não custa mais (isso é muito importante!), Embora estejamos sacrificando um pouco a resolução que acabamos de aumentar devido a outra tecnologia . Como resultado da aplicação de duas tecnologias, o resultado se torna melhor em 2D (menos ruído, maior resolução, HDR) e, ao mesmo tempo, é complementado pela profundidade medida, ou seja, se torna 3D. O preço da emissão é um aumento dramático no número de cálculos por quadro. Mas para fotos isso já é possível hoje e já funciona em smartphones reais.

- Em segundo lugar, em uma conferência, um funcionário do Google disse que estava pensando em cobrir 4 pixels com uma lente, após o qual a qualidade do mapa de profundidade será dramaticamente mais alta, já que haverá 2 pares estéreo com uma base estéreo 1,4 vezes maior (duas diagonais), isso melhorará drasticamente a qualidade do mapa de profundidade, incluindo muitos artefatos estéreo nas bordas. Os concorrentes podem alcançar essa qualidade apenas colocando pelo menos três câmeras seguidas. Esse aumento na qualidade é importante para a RA.

- Em terceiro lugar, o Google não está mais sozinho, aqui está um exemplo de descrição de uma tecnologia semelhante no Vivo V11 Pro, veja você, você acabou de ver uma imagem semelhante:

Fonte: O que é a tecnologia Dual Pixel?

Fonte: O que é a tecnologia Dual Pixel?O recurso plenóptico também é usado no foco automático de câmeras profissionais, por exemplo, com a

Canon (google

DPAF - Foco automático duplo de pixel). Quem pensaria que uma piada teórica de 30 anos atrás - a capacidade de gravar estéreo com uma lente - seria a primeira aplicação em massa dos plenópticos ...

Em geral - o tópico foi para os produtos!

Ela já está voando! Você vê,

LE-TA-ET!

Resumir

Filmoptics no cinema

Acima, examinamos dois casos de uso de plenópticos - na produção de filmes e em smartphones. Esta não é uma lista completa, por exemplo, os plenópticos são muito relevantes em

microscopia - você pode fazer

micrografias estéreo calculadas com uma grande profundidade de campo "honesta"; O plenoptics é relevante para câmeras industriais, especialmente se você precisar tirar fotos de objetos translúcidos de vários níveis e assim por diante. Mas sobre isso de alguma forma outra hora.

Lembre-se de que o uso na produção de filmes é relevante:

- Distância de foco calculada

- Bokeh calculado

- Resolução computada

- Estéreo perfeito computado

- Ponto de Disparo Calculado

- Iluminação Computada

- Ambiente computado

- Tela verde calculada

- Obturador calculado

Nos próximos anos, com miniaturização e maior resolução de sensores, a tecnologia pode ser desenvolvida para criar uma câmera de filme prática e fundamentalmente nova, que permite remover o material para aplicar efeitos especiais mais rapidamente (sem uma tela verde) e com menos tomadas (mais momentos são mais fáceis de corrigir). Os novos recursos são tão interessantes que, quando o sensor plenóptico com uma resolução de filme adequada pode ser compactado, essas câmeras estão fadadas ao sucesso.

Quando essa câmera pode aparecer?Uma resposta cautelosa é nos próximos 10 anos.

De que depende o termo?De muitos fatores. Boa pergunta: qual será a situação com a capacidade de licenciar as patentes Lytro que o Google possui agora? Isso pode ser crítico. Felizmente, os principais expirarão em 10 anos (aqui não nos lembramos educadamente dos colegas chineses Lytro que podem acelerar o processo). Além disso, o trabalho com quantidades colossais de dados gerados pela câmera plenóptica deve ser simplificado: com nuvens modernas, isso está se tornando mais fácil e mais simples. Das boas notícias - ao mesmo tempo, graças ao Lytro, em um

programa de composição muito popular , usado em um grande número de estúdios para processamento estéreo, o formato de dados plenóptico foi suportado. Como se costuma dizer, Lytro morreu, mas a oportunidade de escrever plug-ins para a Nuke com suporte para vídeo plenóptico permaneceu conosco. Isso simplifica a “entrada” nesse mercado com um produto profissional, pois é importante que os estúdios possam trabalhar imediatamente com o formato de novas câmeras imediatamente, sem treinar pessoal e nos mesmos programas.

Plenoptika em smartphones

Se falamos de smartphones, tudo parece ainda melhor. O mais relevante para esse setor é a capacidade da câmera plenóptica de medir a profundidade com um único sensor (potencialmente rápido) e esse recurso em breve será uma mega demanda.

Quando essa câmera pode aparecer?Já existe. E amanhã, a tecnologia será repetida por outros fabricantes. Além disso, o principal fator do próximo estágio será a

realidade aumentada em smartphones e tablets, que hoje carecem de precisão e capacidade de "ver" uma cena tridimensional.

De que depende o termo?A capacidade de medir a distância com o sensor principal em tempo real provavelmente aparecerá em breve com o Google Pixel, já que o Google vem se desenvolvendo nessa direção há muito tempo (consulte o

Projeto Tango , que está fechado, mas cujo negócio continua vivo). E o

ARCore parece muito promissor, assim como o

ARKit concorrente. E o avanço, como você adivinha agora, não precisa esperar muito, já que o valor do pixel do sensor cai exponencialmente, eles chamam a velocidade média de 10 vezes em 10 anos e precisamos de uma queda de 2 vezes. Então conte por si mesmo. Não amanhã, mas não por muito tempo.

Em vez de uma conclusão

Lembre-se, no começo, estávamos conversando sobre uma palestra no VGIK? Devo dizer que não esperava a reação que foi no final. Para colocar em uma palavra, foi de luto. Se em duas palavras, então luto universal. E a princípio não entendi qual era o problema. O operador que veio depois da palestra explicou muito bem a situação para mim. Nem mesmo a arte da câmera estava diminuindo. Embora tenha havido um ótimo exemplo: um fragmento de filme por cerca de 6 segundos, quando uma pessoa se aproxima da porta do apartamento, bate, outra pessoa abre a porta, cumprimenta e avança levemente para pular, enquanto a câmera foca no corredor, depois no batente da porta, e instantaneamente foca na pessoa que a descobriu e depois na sala. E o operador precisa dominar a câmera perfeitamente, para que, com uma

profundidade de campo rasa semelhante ao cinema, opere magistralmente o zoom, lembrando a luz de fundo, a composição do quadro, a enjôo ao fotografar com as mãos e outras 1000 pequenas coisas importantes. Então aqui. Nem isso está se tornando mais fácil. Isso é bom mesmo. Menos tomadas serão estragadas devido ao fato de que o operador em algum lugar não teve tempo ou perdeu. Ele contou recentemente como ele gravou uma série em 4K para o canal. E o estoque da resolução acabou sendo grande. Como resultado, o diretor cortou os quadros na pós-produção e, em alguns lugares, apenas fragmentos do quadro foram usados para interrupções. Como resultado, a composição era simplesmente horrível e esse operador queria remover seu nome dos créditos.

Os recursos descritos acima das câmeras para cineastas significam a transferência de muitos efeitos do estágio de gravação para o estágio de pós-produção. E haverá uma grande tristeza se aqueles que processarem as cenas gravadas forem analfabetos em questões de composição, controle de distância do foco e assim por diante. Se eles são alfabetizados, essas são novas oportunidades fantásticas.

Assim, desejamos a todos nós mais competência, o que nem sempre é fácil neste mundo em rápida mudança!E Cartago vai ... todo o vídeo será tridimensional até o final do século!Agradecimentos

Gostaria de agradecer cordialmente:

- Laboratório de Computação Gráfica VMK Moscow State University MV Lomonosov por sua contribuição ao desenvolvimento de computação gráfica na Rússia e não apenas

- Nossos colegas do grupo de vídeos, graças aos quais você viu este artigo,

- pessoalmente Konstantin Kozhemyakov, que fez muito para tornar este artigo melhor e mais visual,

- Jon Karafin quando ele era o chefe do Light Field Video em Lytro, graças ao qual quase começamos a trabalhar para melhorar o produto deles (e não começamos por motivos fora do nosso controle ou de nós),

- Lytro por sua contribuição para a popularização dos campos de luz e de suas capacidades, o Google, que foi o alvo da queda, e outras empresas que fabricam produtos com base nessa tecnologia interessante,

- e, finalmente, muito obrigado a Sergey Lavrushkin, Roman Kazantsev, Ivan Molodetsky, Evgeny Kuptsov, Yegor Sklyarov, Evgeny Lyapustin e Denis Kondranin pelo grande número de comentários e correções sensatas que tornaram esse texto muito melhor!