“Computadores de alta velocidade não podem ficar sem ar”

Há um momento no filme Iron Man 2, em que Tony Stark assiste a um filme antigo de seu falecido pai, onde ele diz: “Estou limitado pela tecnologia do meu tempo, mas um dia você pode descobrir. E então você vai mudar o mundo. " É fantástico, mas a ideia que expressa é bastante real. As idéias dos engenheiros costumam estar muito à frente de seu tempo. Sempre houve gadgets em Star Trek, mas o resto do mundo teve que trabalhar várias décadas para criar tablets e e-books.

O conceito de refrigeração líquida se encaixa perfeitamente nessa categoria. A idéia em si existe desde a década de 1960, mas permaneceu radical em comparação com uma opção muito mais barata e segura para o resfriamento do ar. Levou mais de 40 anos até que o resfriamento líquido começou a se desenvolver nos anos 2000, e mesmo assim era principalmente uma prerrogativa dos entusiastas de PCs que procuravam dispersar suas CPUs muito além dos limites recomendados pela Intel e AMD.

Hoje, os sistemas de refrigeração líquida estão ganhando popularidade. Esse sistema para PCs pode ser comprado por menos de US $ 100, e a produção de artesanato voltada para aplicativos industriais e data centers (como CoolIT, Asetek, Green Revolution Computing, Ebullient) oferece refrigeração líquida (() para servidores. O ZhO é usado principalmente em supercomputadores, computação de alta velocidade ou outras situações em que é necessária uma enorme quantidade de energia do computador, e os processadores trabalham com quase 100% de carga, mas essas opções estão se tornando mais comuns.

Existem dois tipos populares de ZhO: resfriamento direto por chip e imersão. Com o resfriamento direto, o radiador é conectado à CPU, como um resfriador padrão, mas, em vez disso, dois tubos são conectados a ele. Um vem com água fria, um dissipador de calor que absorve o calor da CPU e o outro deixa quente. Em seguida, ele esfria e retorna à CPU em um loop fechado semelhante ao fluxo sanguíneo.

Durante o resfriamento por imersão, o equipamento é preenchido com líquido, o que, obviamente, não deve conduzir eletricidade. Essa abordagem é mais semelhante às piscinas de resfriamento de reatores nucleares. O resfriamento submerso continua sendo uma opção mais avançada e requer refrigerantes mais caros do que uma conexão direta, onde você pode usar água comum. Além disso, sempre existe o risco de vazamento. Portanto, de longe, a opção mais popular é a conexão direta.

Como um dos principais exemplos, considere o alfabeto. Quando essa empresa controladora do Google, em maio de 2018, introduziu processadores para o AI TensorFlow 3.0, o diretor Sundar Pichai disse que esses chips são tão poderosos que "pela primeira vez tivemos que instalar um resfriamento líquido em data centers". A Alphabet teve que pagar esse preço por um aumento de oito vezes na produtividade.

Por outro lado, os datacenters da Skybox anunciaram recentemente planos para criar um supercomputador enorme com 40.000 servidores da DownUnder GeoSolutions (DUG), projetado para exploração de petróleo e gás. Este projeto produzirá 250 petaflops de potência computacional, mais do que qualquer um existente, e espera-se que os servidores sejam resfriados por fluido quando imersos em tanques cheios de fluido dielétrico.

De qualquer forma, "o resfriamento líquido é o resfriamento do futuro, e sempre será", disse Craig Pennington, vice-presidente do departamento de design do operador de data center da Equinix. "Parece óbvio que esta é a abordagem correta, mas ninguém a aplicou."

Como o JO passou da arte esotérica na virada da computação para um método quase universalmente aceito nos data centers modernos? Como todas as tecnologias, isso aconteceu em parte como resultado da evolução, tentativa e erro e um grande número de soluções de engenharia. No entanto, para ZhO, os data centers atuais devem agradecer aos primeiros overclockers que são heróis desconhecidos desse método.

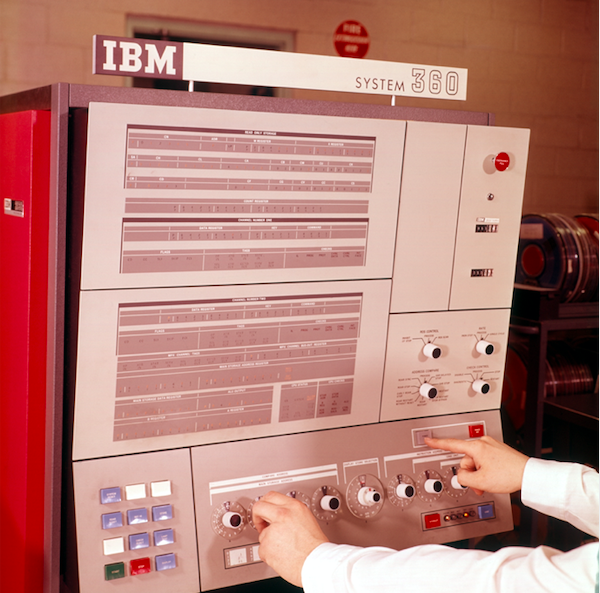

O painel de controle do sistema de processamento de dados do IBM System 360

O painel de controle do sistema de processamento de dados do IBM System 360O que queremos dizer com resfriamento líquido

O resfriamento líquido se tornou uma idéia popular em 1964, quando a IBM estudou a questão do resfriamento submersível para o mainframe System 360. Era um dos mainframes da empresa; As séries 700 e 7000 existem há mais de dez anos, e o System / 360 "iniciou a era da compatibilidade com computadores - pela primeira vez permitindo que diferentes máquinas da linha de produtos trabalhem juntas", como escrevem na IBM. O conceito era simples: a água gelada tinha que fluir através de um dispositivo que a resfria a uma temperatura abaixo da temperatura ambiente, e então a água seria alimentada diretamente no sistema. O circuito usado pela IBM agora é conhecido como resfriamento quando o dissipador de calor é montado atrás do mainframe. O dispositivo aspirava ar quente do mainframe com ventiladores e, em seguida, esse ar era resfriado pela água, como um radiador resfria o motor de um carro.

Desde então, os engenheiros aperfeiçoaram esse conceito básico e surgiram duas formas dominantes de VF: imersão e contato direto. Imersão é o que é; A eletrônica está em um banho líquido, que, por razões óbvias, não pode ser água. O líquido não deve conduzir eletricidade, ou seja, ser um isolador (empresas como a 3M até desenvolvem líquidos especificamente para isso).

Mas o mergulho tem muitos problemas e desvantagens. O servidor localizado no líquido pode ser alcançado apenas de cima. Portanto, portas externas devem estar localizadas lá. A colocação do servidor de gabinetes 1U em um rack seria impraticável; portanto, o servidor não pode ser colocado seqüencialmente. Um dielétrico, e geralmente mineral, é pequeno, muito caro e difícil de limpar em caso de vazamento. Serão necessários discos rígidos especiais e a alteração do data center exigirá investimentos significativos. Portanto, como no caso do supercomputador mencionado acima, é melhor fazer a imersão em um novo data center, em vez de refazer o antigo.

O contato direto da JO, por outro lado, é que o radiador (ou trocador de calor) está no chip, como um radiador comum. Em vez de um ventilador, ele usa dois canos de água - um trazendo água fria para resfriamento e o segundo soprando água quente aquecida pelo contato com o radiador. Essa forma de ZhO se tornou a mais popular, foi adotada por fabricantes como HP Enterprise, Dell EMC e IBM, bem como por fabricantes de gabinetes Chatsworth Systems e Schneider Electric.

O resfriamento direto usa água, mas é muito sensível à sua qualidade. Água da torneira não filtrada não deve ser usada. Basta olhar para a sua torneira ou chuveiro. Ninguém precisa de acúmulo de cálcio nos servidores. Pelo menos o resfriamento direto requer água destilada pura e, às vezes, sua mistura com anticongelante. A fabricação desse refrigerante é uma ciência em si mesma.

Ligação da Intel

Como passamos dos radiadores da IBM para os modernos e extravagantes sistemas de refrigeração? Mais uma vez, graças aos overclockers. Na virada do século, o resfriamento líquido começou a ganhar popularidade entre os overclockers de PC e amadores que montaram seus computadores que queriam aumentar sua velocidade além dos limites oficiais. No entanto, era uma arte esotérica sem desenhos padrão. Todo mundo fez algo diferente. A pessoa que montou tudo isso precisava ser tão

talentosa que a montagem dos produtos da IKEA parecia um absurdo completo. A maioria dos sistemas de refrigeração nem se encaixava nos gabinetes.

No início de 2004, a situação começou a mudar devido a mudanças internas nas políticas da Intel. Um engenheiro do centro de design de Hillsboro, Oregon - onde a maioria dos chips da empresa é projetada, apesar de estar sediada em Santa Clara, Califórnia - trabalha em um projeto de refrigeração especial há vários anos. O projeto custou à empresa US $ 1 milhão e teve como objetivo criar um resfriador de líquido para os processadores Intel. Infelizmente, a Intel estava prestes a desativá-lo.

O engenheiro esperava um resultado diferente. Para salvar o projeto, ele teve essa ideia na Falcon Northwest, uma empresa de Portland que construiu complementos de jogos para computadores. "O motivo foi porque a empresa pensou que o resfriamento líquido incentivava as pessoas a fazer overclock, e essa atividade foi proibida na época", disse Kelt Reeves, presidente da Falcon Northwest. E nessa posição, a Intel tinha sua própria lógica. Naquela época, varejistas sem princípios da Ásia estavam vendendo PCs com overclock sob o disfarce de mais poderosos, com pouca refrigeração e aos olhos do público, isso de alguma forma se transformou em um problema da Intel. Portanto, a empresa se opôs ao overclock.

No entanto, esse engenheiro do Oregon acreditava que, se ele conseguisse encontrar clientes e um mercado para um refrigerador desses, a Intel renderia. (Além disso, o produto Intel resultante era muito melhor em qualidade do que o disponível no mercado, disse Reeves). Portanto, após algumas persuasões e negociações internas entre as empresas, a Intel permitiu à Falcon vender sistemas de refrigeração - em particular porque a Intel já os produzia em milhares. O único problema foi que Falcon não pôde mencionar que a Intel estava envolvida. A Falcon concordou e logo se tornou o primeiro fabricante a fornecer sistemas de PC all-in-one totalmente selados.

Reeves observou que essa solução avançada de ZhO não era particularmente fácil de usar. Falcon teve que mudar o gabinete para caber no radiador e inventar uma placa de resfriamento para água. Mas com o tempo, fabricantes mais frios, como ThermalTake e Corsair, aprenderam o que a Intel estava fazendo e começaram a fazer melhorias consistentes. Desde então, vários produtos e fabricantes apareceram, por exemplo, CoolIT e Asetek, que fizeram ZhO especificamente para data centers. Alguns de seus produtos - por exemplo, tubos que não quebram, não quebram e não vazam com garantia de até sete anos - foram finalmente concedidos sob licença aos fabricantes de sistemas de refrigeração para o usuário final, e essa troca de tecnologia em ambas as direções se tornou a norma.

E, à medida que esse mercado cresce em diferentes direções, até a Intel finalmente mudou de idéia. Agora ela anuncia recursos de overclock para os processadores das séries K e X, e nem se preocupa em vender coolers regulares junto com a CPU superior para os jogadores.

"ZhO já é uma tecnologia comprovada - todo mundo está fazendo isso no lado do consumidor", disse Reeves. A Intel deixou de fornecer coolers regulares com as CPUs mais poderosas, porque elas precisam de JO; isso já foi comprovado e uma bênção da Intel foi recebida. Não acho que haja alguém que diga que soluções completas para isso não são confiáveis o suficiente ".

Refrigeração por imersão no data center. As caixas são preenchidas com fluido dielétrico que flui através dos tubos.

Refrigeração por imersão no data center. As caixas são preenchidas com fluido dielétrico que flui através dos tubos. Arrefecimento líquido dos centros de dados Skybox com imersão. Os trocadores de calor são imersos em equipamentos de informática e o fluido dielétrico não sai do tanque. Um circuito de água passa pelas salas e se aproxima de cada trocador de calor.

Arrefecimento líquido dos centros de dados Skybox com imersão. Os trocadores de calor são imersos em equipamentos de informática e o fluido dielétrico não sai do tanque. Um circuito de água passa pelas salas e se aproxima de cada trocador de calor.Fatos a favor da praticidade do resfriamento líquido

Durante muito tempo, os data centers tradicionais previam um piso elevado com pequenas aberturas pelas quais o ar frio subia, sugado pelos servidores. Isso foi chamado de CRAC, ou ar condicionado da sala de computadores. O problema é que agora não é suficiente soprar ar frio através das aberturas no chão.

A principal razão do recente boom no resfriamento de líquidos é a necessidade. Os processadores de hoje ficam muito quentes e os servidores estão próximos demais para que o ar os resfrie eficientemente, até o Google diz. A capacidade de calor da água é 3300 vezes maior que a do ar, e um sistema de resfriamento de água é capaz de bombear 300 litros de água por minuto, comparado a 20 metros cúbicos de ar por minuto.

Simplificando, a água pode esfriar com muito mais eficiência e em um espaço muito menor. Portanto, depois de muitos anos tentando reduzir o consumo de energia, os fabricantes de processadores podem dispersar a energia e torcer a tensão para obter o máximo desempenho - sabendo que o resfriamento líquido pode lidar com isso.

"Somos solicitados a resfriar chips cujo consumo de energia em breve ultrapassará 500 watts", disse Jeff Lyon, diretor da CoolIT. - Alguns processadores que ainda não entraram no mercado consumirão 300 watts cada. Tudo isso está se desenvolvendo a pedido de IA e aprendizado de máquina. A taxa de resfriamento simplesmente não é suficiente. ”

Lyon disse que a CoolIT está considerando expandir o sistema de refrigeração para chipsets, sistemas de controle de energia, chips de rede e memória. "Não haverá nada radical em lidar com a memória", acrescentou. - Existem opções de RAM com embalagem avançada, consumindo 18 watts por DIMM. Um DIMM típico consome 4-6 watts. Entre os sistemas com uma grande quantidade de memória, encontramos servidores com 16 ou mesmo 24 DIMMs instalados, o que significa muito calor. ”

Um por um, os fabricantes são confrontados com esses pedidos. A Equinix observa como a densidade média cresce de 5 kW para 7-8 kW e agora para 15-16 kW, com alguns equipamentos já mostrando uma densidade de 40 kW. “Portanto, a quantidade total de ar que precisa ser bombeada se torna muito grande. Isso não acontecerá instantaneamente, mas nos próximos anos haverá uma adoção fundamental do resfriamento de líquidos ”, disse Pennington, da Equinix.

Um pouco sobre refrigeração por imersão

O Green Revolution Cooling se concentra no resfriamento por imersão, e seu diretor Peter Poulin diz que, do ponto de vista da eficiência energética, o resfriamento por imersão é melhor do que o resfriamento direto por dois motivos. Primeiro, os fãs são removidos de todos os servidores. Somente isso reduz o consumo de energia em 15%, em média. E um cliente da empresa reduziu em 30%.

Há outra vantagem indireta na eliminação de fãs: o silêncio. Apesar de os servidores geralmente usarem ventiladores muito pequenos, os servidores são terrivelmente barulhentos e o fato de estar no data center é desagradável devido ao calor e ao ruído. O resfriamento líquido torna esses locais muito mais agradáveis de se trabalhar.

Outra vantagem é que é necessária muito pouca energia para suportar o sistema de refrigeração por imersão. Existem apenas três partes móveis: uma bomba para circular um refrigerador, uma bomba para movê-lo para uma torre de resfriamento e um ventilador da torre de resfriamento. Após a substituição do ar resfriado a líquido, o consumo de eletricidade pode cair para 5% do gasto com ar-condicionado. "Você obtém uma enorme redução no consumo de energia, o que permite fazer muitas outras coisas", disse Poulnin. "Dependendo do consumidor, o data center pode ser mais eficiente em termos de energia ou reduzir as emissões de carbono associadas à construção dos data centers".

Fatos a favor do resfriamento líquido por eficiência energética

O consumo de energia tem sido uma preocupação para o setor de data centers (a Agência de Proteção Ambiental dos EUA acompanha esse número há pelo menos dez anos). Os data centers de hoje são grandes empresas que consomem cerca de 2% de toda a eletricidade global e liberam tanto CO2 na atmosfera quanto o setor aéreo. Portanto, o interesse nesta questão não desaparece. Felizmente, o resfriamento líquido reduz as contas de eletricidade.

As primeiras economias são devido à desconexão do ar condicionado no data center. O segundo é a eliminação dos fãs. Cada rack de servidor possui muitos ventiladores que sopram ar, mas seu número pode ser reduzido para um número pequeno ou zero, dependendo da densidade.

E com a tecnologia de "refrigeração a seco", na qual não há congelamento, você pode obter economias ainda maiores. Inicialmente, o resfriamento conectado diretamente conduzia a água através de uma geladeira, que a resfriava de 15 a 25 graus Celsius. Mas, no final, descobriu-se que os refrigeradores de líquidos, que passavam a água através de uma longa sequência de canos e ventiladores, canos frios aquecidos por água quente e a difusão térmica natural, também esfriam a água a uma temperatura suficiente.

"Como esse processo é tão eficiente, você não precisa se preocupar em esfriar a água a uma temperatura baixa", diz Pennington. - A água morna ainda efetivamente retira todo o calor dos servidores. Você não precisa de um ciclo de compressão, basta usar refrigeradores a seco. ”

Refrigeradores a seco também economizam água. Um grande data center que usa geladeiras pode consumir milhões de litros de água por ano, mas um data center com refrigeradores a seco não consome água. Isso economiza energia e água, o que pode ser muito útil se o data center estiver localizado dentro da cidade.

"Não consumimos muita água", disse Pennington. - Se você projeta tudo cuidadosamente, obtém um sistema fechado. A água não entra e não sai, você só precisa adicionar água uma vez por ano para manter os tanques cheios. Você não adiciona água constantemente ao seu carro, é esse o caso conosco. "

A aceitação segue a eficácia

Um exemplo do mundo real: a Dell, mudando para refrigeração líquida, aumentou a eficiência energética (

PUE ) em 56%, de acordo com Brian Payne, vice-presidente de gerenciamento e marketing de produtos da PowerEdge Dell EMC.

PUE é a proporção da energia que precisa ser gasta no resfriamento do sistema e a energia necessária para operar o sistema [na verdade, essa é a proporção da energia total usada pelo data center e a energia gasta diretamente na alimentação da infraestrutura de TI / aprox. perev]. PUE igual a 3 significa que 2 vezes mais energia é gasta no resfriamento de um sistema do que na energia do sistema, e PUE = 2 significa que tanto a energia quanto o resfriamento são consumidos igualmente. O PUE não pode ser igual a 1, pois o resfriamento é necessário, mas os operadores do data center estão obcecados em tentar aproximar o valor o mais próximo possível de 1,0.Além de melhorar o PUE, o aumento no poder de computação que os clientes da Dell recebem pode chegar a 23%, e isso não sobrecarrega o sistema além da medida. "Com base nos investimentos em infraestrutura necessários, prevemos o retorno anual do sistema", diz Payne. - Eu compararia isso com a compra de um condicionador de ar mais energeticamente eficiente para o lar. Você investe um pouco, mas, com o tempo, sente os benefícios das contas de eletricidade. ”Como um adepto completamente diferente do resfriamento de líquidos, visite o centro de supercomputadores em Ohio, OSC. Este cluster emprega 1800 nós. Depois de mudar para a JO, como disse Doug Johnson, arquiteto-chefe de sistemas, o centro atingiu PUE = 1,5. O OSC usa um circuito externo, de modo que a água é removida do prédio e resfriada à temperatura ambiente, que em média é de 30 ° C no verão e muito menos no inverno. Os chips atingem 70 ° C e, mesmo que a água aqueça até 40 ° C, ainda permanece muito mais frio que os chips, e serve a seu objetivo.Como muitos dos primeiros a adotar a nova tecnologia, para a OSC tudo é novo. Há cinco anos, o centro não usava ZhO e hoje ocupa 25%. O centro espera que em três anos a barra cresça para 75% e, depois de alguns anos, eles mudem completamente para ZhO. Mas mesmo no estado atual, de acordo com Johnson, o resfriamento do centro requer quatro vezes menos energia do que antes da transição para ZhO e, em geral, essa solução reduziu o consumo total de energia em 2/3. "Acho que a porcentagem aumentará quando começarmos a integrar a GPU no sistema de refrigeração".Do ponto de vista do cliente, é preciso tempo e energia para avaliar uma nova tecnologia - é por isso que uma grande empresa como a Dell concordou em trabalhar com o CoolIT para anunciar ZhO. Não é de surpreender que, em primeiro lugar, entre as preocupações dos clientes permaneça a possibilidade de vazamento. No entanto, apesar de todas as flutuações, verifica-se que, no momento, eles têm pouca escolha se desejam obter o melhor desempenho."Sempre houve medo de vazamentos", diz Lyon, da CoolIT. - A situação mudou, e agora simplesmente não há outras opções. Computadores de alta velocidade não podem fazer exatamente isso. "