tl; dr:

- O aprendizado de máquina procura padrões nos dados. Mas a inteligência artificial pode ser "tendenciosa" - isto é, encontrar os padrões errados. Por exemplo, um sistema de detecção de câncer de pele a partir de fotografias pode prestar especial atenção às fotos tiradas no consultório médico. O aprendizado de máquina não sabe como: seus algoritmos apenas revelam padrões em números e, se os dados não são representativos, o resultado do processamento também será. E capturar esses erros pode ser difícil devido à mecânica do aprendizado de máquina.

- A área problemática mais óbvia e assustadora é a diversidade humana. Há muitas razões pelas quais os dados sobre as pessoas podem perder sua objetividade, mesmo no estágio de coleta. Mas você não deve pensar que esse problema se refere apenas às pessoas: exatamente as mesmas dificuldades surgem ao tentar encontrar uma inundação em um armazém ou uma turbina a gás com falha. Alguns sistemas podem apresentar vieses em relação à cor da pele, outros serão enviesados contra os sensores da Siemens.

- Tais problemas não são novos no aprendizado de máquina e estão longe de serem exclusivos dele. Suposições incorretas são feitas em quaisquer estruturas complexas e é sempre difícil entender por que uma decisão foi tomada. É necessário lidar com isso de uma maneira complexa: criar ferramentas e processos para verificação - e educar os usuários para que eles não sigam cegamente as recomendações da IA. O aprendizado de máquina realmente faz algumas coisas muito melhores do que nós, mas os cães, por exemplo, são muito mais eficazes do que as pessoas na detecção de drogas, o que não é um motivo para trazê-las como testemunhas e passar sentenças com base em seus depoimentos. E os cães, a propósito, são muito mais inteligentes do que qualquer sistema de aprendizado de máquina.

Hoje, o aprendizado de máquina é uma das tendências tecnológicas fundamentais mais importantes. Essa é uma das principais maneiras pelas quais a tecnologia mudará o mundo ao nosso redor na próxima década. Alguns aspectos dessas mudanças são preocupantes. Por exemplo, o impacto potencial do aprendizado de máquina no mercado de trabalho ou seu uso para fins antiéticos (por exemplo, regimes autoritários). Há outro problema ao qual este post é dedicado: o viés da inteligência artificial .

Esta é uma história difícil.

O Google AI pode encontrar gatos. Esta notícia de 2012 foi então algo especial.

O que é viés de IA?

“Dados brutos” é um oxímoro e uma má ideia; os dados devem ser bem preparados e cuidadosamente. - Jeffrey Boker

Em algum lugar antes de 2013, para criar um sistema que, digamos, reconheça gatos em fotografias, você precisava descrever as etapas lógicas. Como encontrar cantos em uma imagem, reconhecer olhos, analisar texturas quanto à presença de pêlos, contar patas e assim por diante. Depois colete todos os componentes - e descubra que tudo isso realmente não funciona. Algo como um cavalo mecânico - teoricamente isso pode ser feito, mas na prática é muito complicado de descrever. Na saída, você tem centenas (ou mesmo milhares) de regras manuscritas. E nem um único modelo de trabalho.

Com o advento do aprendizado de máquina, paramos de usar regras "manuais" para reconhecer um objeto. Em vez disso, coletamos mil amostras do "um", X, mil amostras do "outro", Y, e forçamos o computador a construir um modelo com base em suas análises estatísticas. Em seguida, fornecemos a este modelo alguns dados de amostra e ele determina com alguma precisão se ele se encaixa em um dos conjuntos. O aprendizado de máquina gera um modelo baseado em dados, não com a ajuda da pessoa que os escreve. Os resultados são impressionantes, especialmente no campo do reconhecimento de imagens e padrões, e é por isso que toda a indústria de tecnologia está migrando para o aprendizado de máquina (ML).

Mas não é tão simples. No mundo real, seus milhares de exemplos de X ou Y também contêm A, B, J, L, O, R e até L. Eles podem ser desigualmente distribuídos, e alguns deles podem ser encontrados com tanta frequência que o sistema prestará mais atenção a eles do que para objetos que lhe interessam.

O que isso significa na prática? Meu exemplo favorito é quando os sistemas de reconhecimento de imagem olham para uma colina gramada e dizem "ovelhas" . É compreensível o porquê: a maioria das fotos de exemplo das “ovelhas” foram tiradas nos prados onde vivem, e nessas imagens a grama ocupa muito mais espaço do que os pequenos fluffies brancos, e é a grama do sistema que é considerada a mais importante.

Existem exemplos mais sérios. De recente - um projeto para detectar câncer de pele em fotografias. Acontece que os dermatologistas frequentemente fotografam a formação juntamente com as manifestações do câncer de pele, a fim de determinar o tamanho das formações. Em exemplos de fotografias de pele saudável, não há réguas. Para o sistema de IA, essas réguas (mais precisamente, os pixels que definimos como “régua”) se tornaram uma das diferenças entre conjuntos de exemplos e, às vezes, mais importantes que uma pequena erupção cutânea. Portanto, um sistema projetado para identificar o câncer de pele, às vezes em vez de reconhecer a linha.

O ponto principal aqui é que o sistema não possui um entendimento semântico do que está vendo. Observamos um conjunto de pixels e vemos uma ovelha, pele ou réguas neles e o sistema - apenas uma linha numérica. Ela não vê espaço tridimensional, não vê objetos, nem texturas, nem ovelhas. Ela apenas vê padrões nos dados.

A dificuldade em diagnosticar esses problemas é que a rede neural (o modelo gerado pelo seu sistema de aprendizado de máquina) consiste em milhares de centenas de milhares de nós. Não há uma maneira fácil de analisar um modelo e ver como ele toma uma decisão. A presença desse método significaria que o processo é simples o suficiente para descrever todas as regras manualmente, sem o uso de aprendizado de máquina. As pessoas temem que o aprendizado de máquina tenha se tornado uma espécie de caixa preta. (Vou explicar um pouco mais tarde por que essa comparação ainda é demais.)

Em termos gerais, esse é o problema do viés da inteligência artificial ou do aprendizado de máquina: um sistema para encontrar padrões nos dados pode encontrar padrões incorretos, mas você pode não perceber. Essa é uma característica fundamental da tecnologia e é óbvia para todos que trabalham com ela na comunidade científica e em grandes empresas de tecnologia. Mas suas consequências são complexas, e também nossas soluções possíveis para essas consequências.

Vamos falar sobre as consequências primeiro.

A IA pode implicitamente fazer uma escolha para nós em favor de certas categorias de pessoas, com base em um grande número de sinais discretos

Cenários de viés de IA

O mais óbvio e assustador é que esse problema pode se manifestar quando se trata da diversidade humana. Recentemente , houve um boato de que a Amazon tentou construir um sistema de aprendizado de máquina para a triagem inicial de candidatos a emprego. Como há mais homens entre os trabalhadores da Amazônia, exemplos de “contratação bem-sucedida” também são mais frequentes que os homens, e havia mais homens na seleção de currículos propostos pelo sistema. A Amazon percebeu isso e não lançou o sistema em produção.

O mais importante neste exemplo é que há rumores de que o sistema favoreceu candidatos do sexo masculino, apesar do fato de o sexo não estar listado no currículo. O sistema viu outros padrões nos exemplos de “contratação bem-sucedida”: por exemplo, as mulheres podem usar palavras especiais para descrever conquistas ou ter hobbies especiais. Obviamente, o sistema não sabia o que era “hóquei”, nem quem são “pessoas”, nem o que era “sucesso” - ele simplesmente executava uma análise estatística do texto. Mas os padrões que ela viu provavelmente permaneceram despercebidos pela pessoa, e alguns deles (por exemplo, o fato de pessoas de sexos diferentes descreverem o sucesso de maneira diferente), provavelmente seria difícil para nós ver, mesmo olhando para eles.

Ainda pior. Um sistema de aprendizado de máquina que encontra muito bem o câncer na pele pálida pode funcionar pior com a pele escura ou vice-versa. Não necessariamente por causa do viés, mas porque você provavelmente precisará criar um modelo separado para uma cor de pele diferente, escolhendo outras características. Os sistemas de aprendizado de máquina não são intercambiáveis, mesmo em um campo tão estreito como o reconhecimento de imagens. Você precisa configurar o sistema, às vezes simplesmente por tentativa e erro, para observar bem os recursos nos dados de seu interesse, até atingir a precisão desejada. Mas você pode não perceber que o sistema em 98% dos casos é preciso ao trabalhar com um grupo e somente em 91% (embora isso seja mais preciso do que a análise realizada por uma pessoa) por outro.

Até agora, tenho usado principalmente exemplos sobre pessoas e suas características. A discussão sobre esse problema está focada principalmente neste tópico. Mas é importante entender que o viés para com as pessoas é apenas parte do problema. Usaremos o aprendizado de máquina para muitas coisas, e um erro de amostragem será relevante para todas elas. Por outro lado, se você trabalha com pessoas, o viés de dados pode não estar relacionado a elas.

Para entender isso, voltemos ao exemplo com câncer de pele e consideremos três possibilidades hipotéticas de quebra do sistema.

- Distribuição não homogênea das pessoas: um número desequilibrado de fotografias da pele em tons diferentes, o que leva a resultados positivos falsos ou negativos negativos associados à pigmentação.

- Os dados nos quais o sistema é treinado contêm uma característica encontrada com frequência e heterogeneamente distribuída, que não está relacionada às pessoas e não tem valor diagnóstico: uma régua em fotografias de manifestações de câncer de pele ou grama em fotografias de ovelhas. Nesse caso, o resultado será diferente se o sistema encontrar pixels na imagem de algo que o olho humano define como uma “régua”.

- Os dados contêm uma característica de terceiros que uma pessoa não pode ver, mesmo que a procure.

O que isso significa? Sabemos a priori que os dados podem ser apresentados de maneira diferente por diferentes grupos de pessoas e, pelo menos, podemos planejar procurar essas exceções. Em outras palavras, existem várias razões sociais para supor que os dados de grupos de pessoas já contenham algum viés. Se olharmos para a foto com a régua, veremos essa régua - simplesmente a ignoramos antes, sabendo que isso não importa e esquecendo que o sistema não sabe de nada.

Mas e se todas as suas fotografias de pele não saudável fossem tiradas em um escritório onde lâmpadas incandescentes são usadas e saudáveis sob luz fluorescente? E se, depois de terminar de remover a pele saudável, antes de fotografar não saudável, você atualizasse o sistema operacional no telefone e a Apple ou o Google alterassem um pouco o algoritmo de redução de ruído? Uma pessoa não pode perceber isso, não importa o quanto procure tais características. Mas o sistema de uso da máquina o verá e o utilizará imediatamente. Ela não sabe de nada.

Enquanto falamos sobre correlações falsas, pode acontecer que os dados sejam precisos e os resultados estejam corretos, mas você não deseja usá-los por razões éticas, legais ou gerenciais. Em algumas jurisdições, por exemplo, não é possível fornecer às mulheres um desconto no seguro, embora as mulheres possam ser mais seguras ao dirigir. Podemos facilmente imaginar um sistema que, ao analisar dados históricos, atribua fatores de risco mais baixos a nomes femininos. Ok, vamos remover os nomes da seleção. Mas lembre-se do exemplo da Amazon: o sistema pode determinar o gênero por outros fatores (embora não saiba o que é e o que é uma máquina), e você não perceberá isso até que o regulador analise retroativamente as taxas que você oferece e não cobra. você está bem.

Por fim, muitas vezes está implícito que usaremos esses sistemas apenas para projetos relacionados a pessoas e interações sociais. Isto não é verdade. Se você fabrica turbinas a gás, provavelmente deseja aplicar o aprendizado de máquina à telemetria transmitida por dezenas ou centenas de sensores em seu produto (áudio, vídeo, temperatura e outros sensores geram dados que podem ser facilmente adaptados para criar um modelo de aprendizado de máquina ) Hipoteticamente, você pode dizer: “Aqui estão os dados de mil turbinas com falha, obtidos antes da falha, mas aqui estão os dados de mil turbinas que não quebraram. Crie um modelo para dizer qual é a diferença entre eles. ” Bem, agora imagine que os sensores da Siemens custam 75% das turbinas ruins e apenas 12% das boas (não há conexão com falhas). O sistema construirá um modelo para localizar turbinas com sensores Siemens. Opa!

Foto - Moritz Hardt, UC Berkeley

Gerenciamento de viés de IA

O que podemos fazer sobre isso? Você pode abordar o problema de três lados:

- Rigor metodológico na coleta e gerenciamento de dados para treinamento do sistema.

- Ferramentas técnicas para analisar e diagnosticar o comportamento do modelo.

- Treinamento, educação e cautela na introdução de aprendizado de máquina em produtos.

Há uma piada no livro de Moliere "O comerciante na nobreza": um homem foi informado de que a literatura é dividida em prosa e poesia, e ele admira com admiração que falou prosa a vida inteira sem saber. Provavelmente, os estatísticos de alguma forma se sentem assim hoje: sem perceber, eles dedicaram suas carreiras à inteligência artificial e a erros de amostragem. Para procurar um erro de amostragem e se preocupar com ele não é um problema novo, precisamos apenas abordar sistematicamente sua solução. Como mencionado acima, em alguns casos, é realmente mais fácil fazer isso estudando os problemas associados aos dados das pessoas. A priori, assumimos que podemos ter preconceitos sobre diferentes grupos de pessoas, mas é difícil imaginar um preconceito sobre os sensores da Siemens.

A novidade de tudo isso, é claro, é que as pessoas não estão mais diretamente envolvidas na análise estatística. É realizado por máquinas que criam grandes modelos complexos e difíceis de entender. A questão da transparência é um dos principais aspectos do problema do viés. Temos medo de que o sistema não seja apenas tendencioso, mas que não haja maneira de detectar seu viés, e que o aprendizado de máquina seja diferente de outras formas de automação, que deveriam consistir em etapas lógicas claras que podem ser verificadas.

Existem dois problemas aqui. Talvez possamos, no entanto, conduzir uma auditoria dos sistemas de aprendizado de máquina. E a auditoria de qualquer outro sistema não é realmente mais fácil.

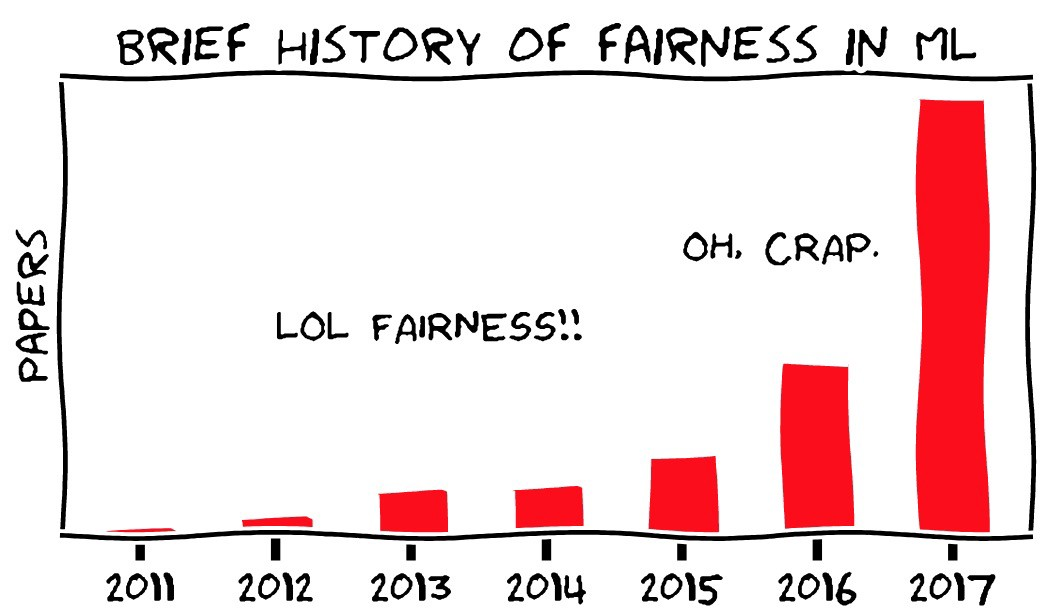

Primeiramente, uma das áreas da pesquisa moderna no campo do aprendizado de máquina é a busca de métodos para identificar a funcionalidade importante dos sistemas de aprendizado de máquina. Ao mesmo tempo, o aprendizado de máquina (em seu estado atual) é um campo completamente novo da ciência que está mudando rapidamente; portanto, você não deve pensar que as coisas impossíveis hoje em dia não podem logo se tornar bastante reais. O projeto OpenAI é um exemplo interessante disso.

Em segundo lugar, a idéia de que é possível verificar e entender o processo de tomada de decisão nos sistemas ou organizações existentes é boa em teoria, mas na prática. Compreender como as decisões são tomadas em uma grande organização está longe de ser fácil. Mesmo que exista um processo formal de tomada de decisão, ele não reflete como as pessoas realmente interagem e, na verdade, elas geralmente não têm uma abordagem sistemática lógica para tomar suas decisões. Como disse meu colega Vijay Pande , as pessoas também são caixas pretas .

Pegue mil pessoas em várias empresas e instituições sobrepostas, e o problema se tornará ainda mais complicado. Sabemos que o ônibus espacial estava destinado a desmoronar quando retornaram, e algumas pessoas dentro da NASA tinham informações que lhes deram motivos para pensar que algo ruim poderia acontecer, mas o sistema como um todo não sabia. A NASA acabou de passar por uma auditoria semelhante, tendo perdido o ônibus anterior, e ainda assim perdeu outro - por uma razão muito semelhante. É fácil dizer que organizações e pessoas seguem regras lógicas claras que podem ser verificadas, entendidas e alteradas - mas a experiência prova o contrário. Este é o " erro da Comissão de Planejamento do Estado ".

Costumo comparar o aprendizado de máquina com bancos de dados, especialmente relacionais - uma nova tecnologia fundamental que mudou os recursos da ciência da computação e do mundo ao seu redor, que se tornou parte de tudo o que usamos constantemente sem perceber. Os bancos de dados também têm problemas e têm uma propriedade semelhante: o sistema pode ser construído com base em suposições incorretas ou em dados incorretos, mas será difícil perceber, e as pessoas que usam o sistema farão o que elas mandam sem fazer perguntas. Há várias piadas antigas sobre trabalhadores tributários que, uma vez, escreveram incorretamente seu nome, e convencê-los a corrigir o erro é muito mais difícil do que realmente mudar o nome. Isso pode ser pensado de diferentes maneiras, mas não está claro qual é a melhor: que tal um problema técnico em SQL, um erro na versão Oracle ou uma falha de instituições burocráticas? Quão difícil é encontrar um erro no processo que levou ao fato de o sistema não possuir um recurso como a correção de erros de digitação? Isso poderia ser entendido antes que as pessoas começassem a reclamar?

Ainda mais fácil é esse problema ilustrado por histórias em que os motoristas, devido a dados desatualizados no navegador, vão para os rios. Ok, os mapas devem ser atualizados constantemente. Mas quanto é a culpa da TomTom pelo fato de seu carro explodir no mar?

Digo isso ao fato de que sim - o viés do aprendizado de máquina criará problemas. Mas esses problemas serão semelhantes aos que encontramos no passado e podem ser percebidos e resolvidos (ou não) aproximadamente tão bem quanto no passado. Consequentemente, é improvável que um cenário em que o viés da IA seja prejudicial para os principais pesquisadores que trabalham em uma grande organização. , - - , , . “ ” , , , , . . , . .

Conclusão

, , — , .

, « » . , — . HAL9000 Skynet — -, . Mas não. , , , . , , … . . , , , - . , — , , .

, — , — . , , .

, , « — , » . , « ». , , , . , . , — , , , . , , .

Tradução: Diana Letskaya .

Edição: Alexey Ivanov .

Comunidade: @PonchikNews .