Estamos falando de duas regras que também começam a perder relevância.

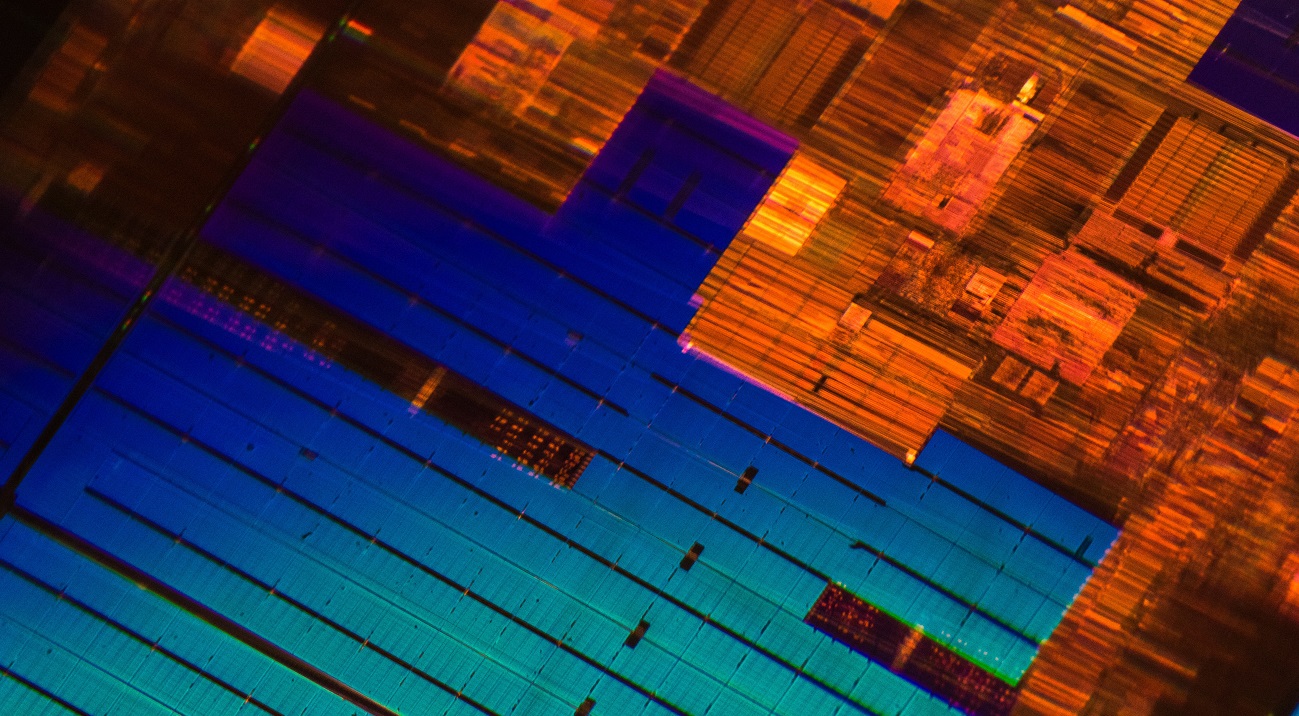

/ foto Laura Ockel Unsplash

/ foto Laura Ockel UnsplashA Lei de Moore foi formulada há mais de cinquenta anos atrás. Durante todo esse tempo, ele permaneceu justo. Ainda hoje, ao mudar de um processo tecnológico para outro, a densidade de transistores em um chip

aumenta aproximadamente duas vezes . Mas há um problema - a velocidade do desenvolvimento de novos processos tecnológicos está diminuindo.

Por exemplo, a Intel adia a produção em massa de seus processadores Ice Lake de 10 nanômetros há muito tempo. Embora a gigante de TI comece a enviar dispositivos no próximo mês, o anúncio da arquitetura ocorreu há cerca de

dois anos

e meio . Também em agosto do ano passado, a GlobalFoundries, fabricante de circuitos integrados que trabalhava com a AMD,

parou de desenvolver tecnologia de processo de 7 nm (

falamos sobre os motivos dessa decisão

em nosso blog sobre Habr).

Jornalistas e

executivos de grandes empresas de TI profetizam a morte pela lei de Moore há anos. Até o próprio Gordon

declarou certa vez que a regra que formulou deixaria de se aplicar. No entanto, a lei de Moore não é a única lei que perde relevância e sobre a qual fabricantes de processadores são iguais.

A lei de escala de Dennard

Foi formulado em 1974 por Robert Dennard, engenheiro e desenvolvedor de memória dinâmica DRAM, junto com colegas da IBM. A regra é a seguinte:

"Ao reduzir o tamanho do transistor e aumentar a velocidade do clock do processador, podemos aumentar facilmente seu desempenho".

A regra de Dennard fixou a redução na largura do condutor (tecnologia de processo) como o principal indicador de progresso no setor de tecnologia de microprocessador. Mas a lei de escala de Dennard deixou de ser aplicada por volta de 2006. O número de transistores nos chips continua a aumentar, mas esse fato

não fornece um aumento significativo no desempenho do dispositivo.

Por exemplo, representantes da TSMC (fabricante de semicondutores) afirmam que a mudança da tecnologia de processo de 7 nm para 5 nm

aumentará a velocidade do clock do processador em apenas 15%.

A razão para a desaceleração no crescimento da frequência é o vazamento de correntes, que Dennard não levou em consideração no final dos anos 70. Com uma diminuição no tamanho do transistor e um aumento na frequência, a corrente começa a aquecer o microcircuito com mais força, o que pode danificá-lo. Portanto, os fabricantes precisam equilibrar a energia alocada pelo processador. Como resultado, desde 2006, a frequência de chips de massa foi estabelecida em torno de 4-5 GHz.

/ foto de Jason Leung Unsplash

/ foto de Jason Leung UnsplashHoje, os engenheiros estão trabalhando em novas tecnologias que resolverão o problema e aumentarão o desempenho dos microchips. Por exemplo, especialistas da Austrália estão

desenvolvendo um transistor metal-ar, com frequência de várias centenas de gigahertz. O transistor consiste em dois eletrodos de metal que atuam como dreno e fonte e estão localizados a uma distância de 35 nm. Eles trocam elétrons entre si devido ao fenômeno de

emissão em campo .

Segundo os desenvolvedores, o dispositivo deles permitirá que você pare de "perseguir" a redução de processos tecnológicos e se concentre na construção de estruturas 3D de alto desempenho com um grande número de transistores em um chip.

Regra de Kumi

Foi

formulado em 2011 pelo professor de Stanford, Jonathan Koomey. Juntamente com colegas da Microsoft, Intel e Carnegie Mellon University, ele

analisou informações sobre o consumo de energia dos sistemas de computação começando com o computador ENIAC, construído em 1946. Como resultado, Kumi chegou à seguinte conclusão:

"O volume de cálculos por quilowatt de energia sob carga estática dobra a cada um ano e meio."

Ao mesmo tempo, ele observou que o consumo de energia dos computadores nos últimos anos também aumentou.

Em 2015, Kumi

voltou ao seu trabalho e complementou o estudo com novos dados. Ele descobriu que a tendência que ele descreveu desacelerou. O desempenho médio do chip por quilowatt de energia começou a dobrar aproximadamente a cada três anos. A tendência mudou devido às dificuldades associadas ao resfriamento dos chips (

página 4 ), pois, com a diminuição do tamanho dos transistores, fica mais difícil remover o calor.

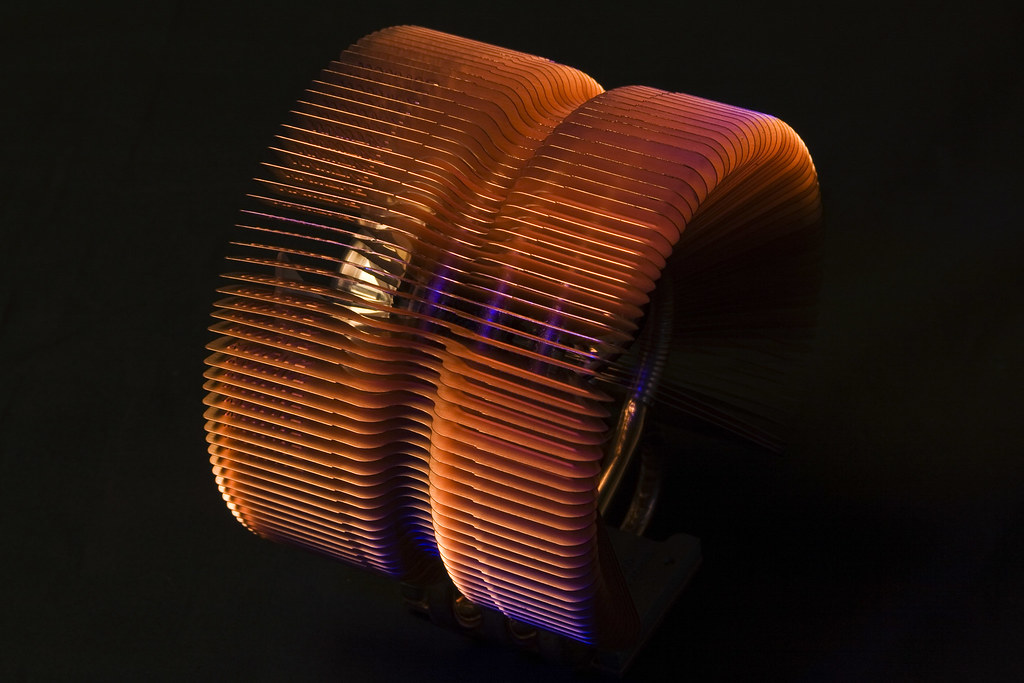

/ foto Derek Thomas CC BY-ND

/ foto Derek Thomas CC BY-NDNovas tecnologias de resfriamento de chips estão sendo desenvolvidas agora, mas não há necessidade de falar sobre sua implementação em massa. Por exemplo, desenvolvedores de uma universidade de Nova York sugeriram o

uso da impressão a laser 3D para aplicar uma fina camada condutora de calor de titânio, estanho e prata a um cristal. A condutividade térmica desse material é 7 vezes melhor que a de outras interfaces térmicas (pasta e polímeros térmicos).

Apesar de todos os fatores,

segundo Kumi , o limite teórico de energia ainda está longe. Ele se refere a um estudo do físico Richard Feynman, que em 1985 observou que o índice de eficiência energética dos processadores aumentaria 100 bilhões de vezes. Na época de 2011, esse número aumentou apenas 40 mil vezes.

O setor de TI está acostumado a um alto crescimento no poder da computação; portanto, os engenheiros estão procurando maneiras de estender a lei de Moore e superar as dificuldades ditadas pelas regras de Kumi e Dennard. Em particular, empresas e institutos de pesquisa estão procurando um substituto para a tecnologia tradicional de transistor e silício. Falaremos sobre algumas das alternativas possíveis na próxima vez.

Sobre o que escrevemos em um blog corporativo:

Nossos relatórios com o VMware EMPOWER 2019 em Habré: