O termo Big Data é estragado pelo exagero fantástico e moderno de coisas novas. À medida que a IA escraviza as pessoas e o blockchain constrói uma economia ideal - o big data permite que você saiba absolutamente tudo sobre todos e veja o futuro.

Mas a realidade, como sempre, é mais chata e pragmática. Não há mágica no big data - como não há lugar nenhum - simplesmente existem tantas informações e conexões entre dados diferentes que leva muito tempo para processar e analisar tudo da maneira antiga.

Novos métodos estão surgindo. Novas profissões estão com eles. O reitor

do departamento de análise de Big Data da GeekBrains, Sergey Shirkin, disse que tipo de profissão eles são, onde são necessários, o que precisam fazer e o que precisam ser capazes de fazer. Quais ferramentas são usadas e quanto elas geralmente pagam aos especialistas.

O que é Big Data?

A pergunta “como chamar big data” é bastante confusa. Mesmo em revistas científicas, as descrições diferem. Em algum lugar, milhões de observações são consideradas dados "normais" e, em outro lugar, centenas de milhares são chamadas de grandes, porque cada uma das observações possui mil sinais. Portanto, eles decidiram dividir os dados condicionalmente em três partes - pequena, média e grande - de acordo com o princípio mais simples: o volume que eles ocupam.

Dados pequenos são de alguns gigabytes. Médio - tudo sobre um terabyte. Big data é sobre um petabyte. Mas isso não removeu a confusão. Portanto, o critério é ainda mais simples: tudo o que não cabe no mesmo servidor é big data.

Dados pequenos, médios e grandes têm princípios operacionais diferentes. O big data geralmente é armazenado em um cluster em vários servidores ao mesmo tempo. Por isso, mesmo ações simples são mais complicadas.

Por exemplo, uma tarefa simples é encontrar o valor médio de uma quantidade. Se esses dados são pequenos, simplesmente adicionamos e dividimos pela quantidade. E no big data, não podemos coletar todas as informações de todos os servidores ao mesmo tempo. Isso é complicado. Geralmente, você não precisa extrair dados para si mesmo, mas envia um programa separado para cada servidor. Após o trabalho desses programas, resultados intermediários são formados e o valor médio é determinado por eles.

Sergey Shirkin

Sergey ShirkinQuais empresas de big data

O primeiro com big data começou a trabalhar com operadoras de telefonia móvel e mecanismos de busca. Os mecanismos de pesquisa tornaram-se cada vez mais solicitações, e o texto é mais pesado que os números. Trabalhar com um parágrafo de texto leva mais tempo do que com uma transação financeira. O usuário espera que o mecanismo de pesquisa conclua a solicitação em uma fração de segundo - é inaceitável que ele funcione mesmo por meio minuto. Portanto, os mecanismos de pesquisa começaram a trabalhar com paralelização ao trabalhar com dados.

Um pouco mais tarde, várias organizações financeiras e varejo se juntaram. As transações em si não são tão volumosas, mas o big data aparece devido ao fato de haver muitas transações.

A quantidade de dados está aumentando. Por exemplo, os bancos tinham muitos dados antes, mas nem sempre exigiam princípios de trabalho, como os grandes. Então, os bancos começaram a trabalhar mais com os dados dos clientes. Eles começaram a criar depósitos mais flexíveis, empréstimos, tarifas diferentes e começaram a analisar as transações mais de perto. Isso já exigia maneiras rápidas de trabalhar.

Agora, os bancos querem analisar não apenas informações internas, mas também informações externas. Eles querem receber dados do mesmo varejo, querem saber em que uma pessoa gasta dinheiro. Com base nessas informações, eles estão tentando fazer ofertas comerciais.

Agora todas as informações estão conectadas umas às outras. Varejo, bancos, operadoras de telecomunicações e até mecanismos de busca - todos estão interessados nos dados uns dos outros.

O que um especialista em Big Data deve ser

Como os dados estão localizados em um cluster de servidores, uma infraestrutura mais complexa é usada para trabalhar com eles. Isso coloca um grande fardo para a pessoa que trabalha com ela - o sistema deve ser muito confiável.

Tornar um servidor confiável é fácil. Mas quando existem vários deles, a probabilidade de queda aumenta proporcionalmente ao número e a responsabilidade do engenheiro de dados que trabalha com esses dados também cresce.

O analista deve entender que ele sempre pode receber dados incompletos ou até incorretos. Ele escreveu o programa, confiou nos resultados e descobriu que, devido à queda de um servidor em mil, parte dos dados foi desconectada e todas as conclusões estavam incorretas.

Tome, por exemplo, uma pesquisa de texto. Digamos que todas as palavras sejam organizadas em ordem alfabética em vários servidores (se falarmos de maneira simples e condicional). E um deles desconectado, todas as palavras da letra "K" desapareceram. A pesquisa parou de dar a palavra "Cinema". Todas as notícias desaparecem e o analista conclui que as pessoas não estão mais interessadas em cinemas.

Portanto, um especialista em big data deve conhecer os princípios do trabalho, desde os níveis mais baixos - servidores, ecossistemas, planejadores de tarefas - até os programas de mais alto nível - bibliotecas de aprendizado de máquina, análise estatística e muito mais. Ele deve entender os princípios de ferro, equipamentos de informática e tudo o que está configurado em cima disso.

De resto, você precisa saber tudo da mesma forma que quando trabalha com dados pequenos. Você precisa de matemática, precisa ser capaz de programar, e especialmente bom conhecer algoritmos de computação distribuídos, para poder aplicá-los aos princípios usuais de trabalhar com dados e aprendizado de máquina.

Quais ferramentas são usadas

Como os dados são armazenados no cluster, é necessária uma infraestrutura especial para trabalhar com eles. O ecossistema mais popular é o Hadoop. Muitos sistemas diferentes podem funcionar: bibliotecas especiais, planejadores, ferramentas para aprendizado de máquina e muito mais. Mas, antes de tudo, esse sistema é necessário para lidar com grandes quantidades de dados devido à computação distribuída.

Por exemplo, estamos procurando o tweet mais popular entre os dados quebrados em mil servidores. Em um servidor, apenas criamos uma mesa e é isso. Aqui podemos arrastar todos os dados para nós mesmos e recontar. Mas isso não está certo, porque há muito tempo.

Portanto, há um Hadoop com paradigmas de Map Reduce e a estrutura do Spark. Em vez de extrair dados para si mesmos, eles enviam seções do programa para esses dados. O trabalho é paralelo, em mil fios. Em seguida, temos uma seleção de milhares de servidores com base nos quais você pode escolher o tweet mais popular.

Map Reduce é um paradigma mais antigo, o Spark é mais recente. Com sua ajuda, os dados são extraídos dos clusters e os modelos de aprendizado de máquina são criados nele.

Quais profissões existem no campo de big data

As duas profissões principais são analistas e engenheiros de dados.

O analista trabalha principalmente com informações. Ele está interessado em dados tabulares, ele está envolvido em modelos. Suas responsabilidades incluem agregação, purificação, adição e visualização de dados. Ou seja, o analista é o elo entre informações brutas e negócios.

O analista possui duas áreas principais de trabalho. Primeiro, ele pode transformar as informações recebidas, tirar conclusões e apresentá-las de maneira compreensível.

A segunda é que os analistas desenvolvem aplicativos que funcionarão e produzirão o resultado automaticamente. Por exemplo, faça uma previsão no mercado de valores mobiliários todos os dias.

O engenheiro de dados é uma especialidade de nível inferior. Essa é uma pessoa que deve garantir o armazenamento, o processamento e a entrega de informações ao analista. Mas onde houver suprimento e limpeza - suas responsabilidades podem se sobrepor.

O engenheiro de dados faz todo o trabalho duro. Se os sistemas falharem ou um dos servidores desaparecer do cluster, ele será conectado. Este é um trabalho muito responsável e estressante. O sistema pode desligar nos fins de semana e depois do expediente, e o engenheiro deve tomar medidas imediatas.

Essas são duas profissões principais, mas existem outras. Eles aparecem quando algoritmos de computação paralela são adicionados a tarefas relacionadas à inteligência artificial. Por exemplo, um engenheiro de PNL. Este é um programador que está envolvido no processamento de linguagem natural, especialmente nos casos em que você não precisa apenas encontrar palavras, mas entender o significado do texto. Esses engenheiros escrevem programas para chatbots e sistemas de conversação, assistentes de voz e call centers automatizados.

Há situações em que é necessário classificar bilhões de fotos, fazer moderação, filtrar o excesso e encontrar um similar. Essas profissões se sobrepõem mais à visão computacional.

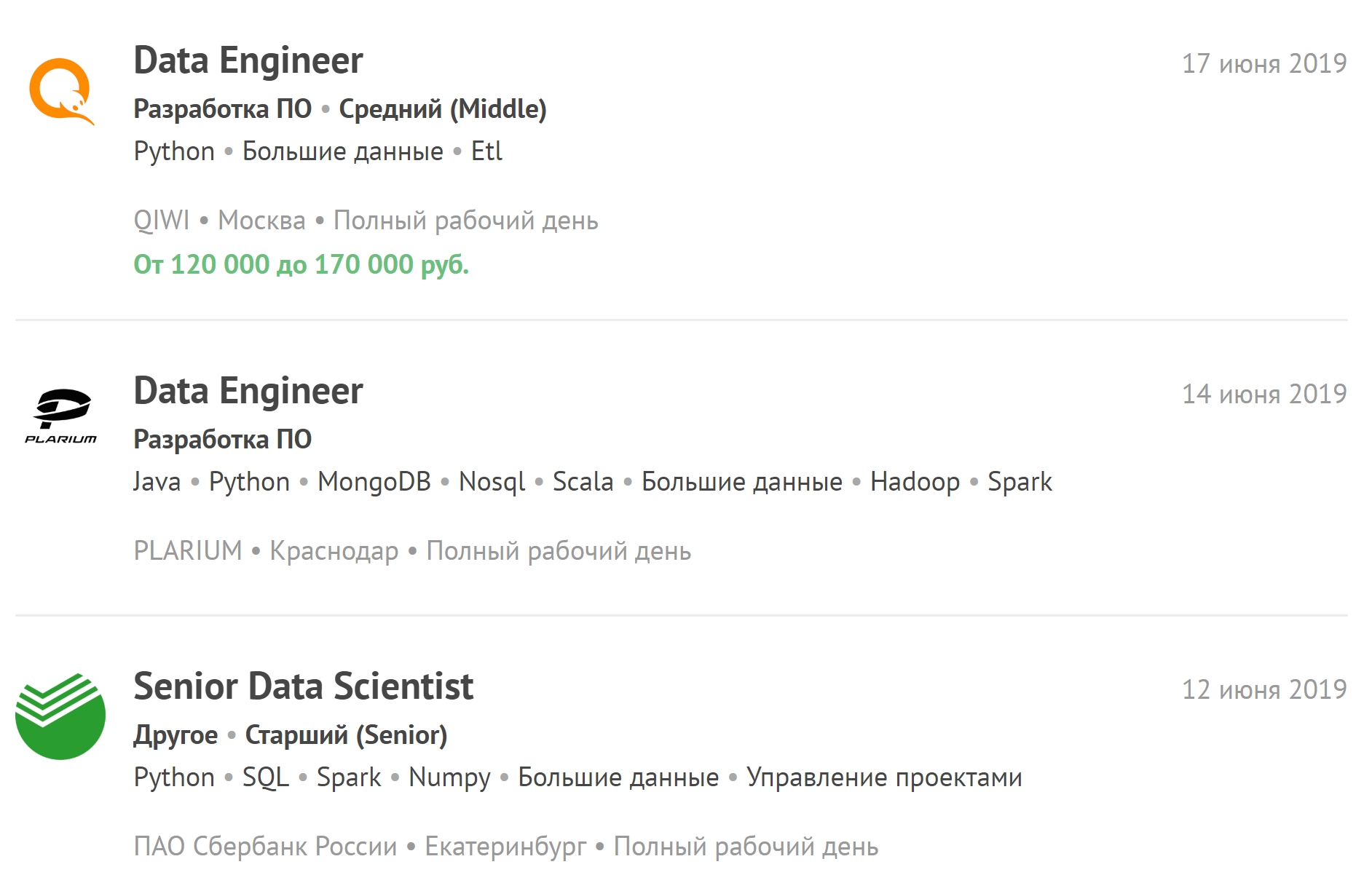

Você pode consultar as vagas mais recentes relacionadas ao big data e assinar novas vagas.

Quanto tempo leva o treinamento

Nós estudamos há um ano e meio. Eles são divididos em seis quartos. Em alguns, há ênfase na programação, em outros - no trabalho com bancos de dados e no terceiro - na matemática.

Por outro lado, por exemplo, da faculdade de IA, há menos matemática. Não existe uma ênfase tão forte na análise matemática e na álgebra linear. O conhecimento dos algoritmos de computação distribuída é necessário mais do que os princípios da análise analítica.

Mas um ano e meio é suficiente para um trabalho real com big data apenas se a pessoa tiver experiência com dados comuns e em geral em TI. Recomenda-se que os demais alunos após a graduação trabalhem com dados pequenos e médios. Somente depois disso, os especialistas poderão trabalhar com os grandes. Após o treinamento, você deve trabalhar como cientista de dados - aplicar o aprendizado de máquina em diferentes quantidades de dados.

Quando uma pessoa consegue um emprego em uma grande empresa - mesmo que tenha experiência - na maioria das vezes, não será permitido acessar grandes volumes de dados imediatamente, porque o preço de um erro é muito maior. Erros nos algoritmos podem não ser detectados imediatamente, e isso levará a grandes perdas.

Qual salário é considerado adequado para especialistas em big data

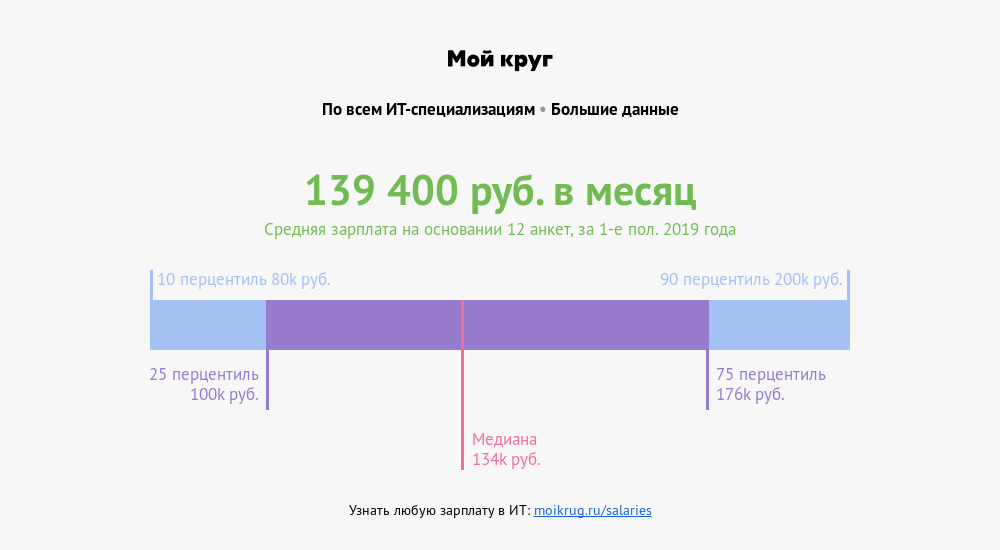

Agora, há uma escassez muito grande de pessoal entre os engenheiros de dados. O trabalho é difícil, muita responsabilidade recai sobre uma pessoa, muito estresse. Portanto, um especialista com experiência média recebe cerca de duzentos mil. Junior - de cem a duzentos.

Um analista de dados pode ter um salário inicial um pouco menor. Mas não há trabalho além do tempo de trabalho, e ele não será chamado fora do horário comercial devido a casos de emergência.

De acordo com o cultivador de salário “My Circle”, o salário médio de especialistas cujas profissões estão associadas ao big data é de 139.400 rublos . Um quarto dos especialistas ganha mais de 176.000 rublos. Um décimo - mais de 200.000 rublos.

Como se preparar para entrevistas

Não há necessidade de se aprofundar em apenas um assunto. Nas entrevistas, eles fazem perguntas sobre estatística, aprendizado de máquina, programação. Eles podem perguntar sobre estruturas de dados, algoritmos e casos da vida real: o servidor travou, um acidente aconteceu - como corrigi-lo? Pode haver perguntas sobre a área de assunto - algo mais próximo dos negócios.

E se uma pessoa é muito profunda em uma matemática e, durante a entrevista, não realizou uma tarefa simples de programação, as chances de encontrar um emprego são reduzidas. É melhor ter um nível médio em cada direção do que se mostrar bem em uma e falhar completamente na outra.

Há uma lista de perguntas feitas em 80% das entrevistas. Se isso for aprendizado de máquina, eles definitivamente perguntarão sobre a descida do gradiente. Se estatísticas - você precisará falar sobre correlação e teste de hipóteses. A programação provavelmente dará uma pequena tarefa de média complexidade. E você pode facilmente colocar as mãos em tarefas - basta resolvê-las mais.

Onde ganhar experiência por conta própria

O Python pode ser

acessado no

Pitontutyu , trabalhar com o banco de dados - no

SQL-EX . Existem tarefas para as quais, na prática, eles aprendem a fazer solicitações.

Matemática Superior -

Mathprofi . Lá você pode obter informações claras sobre análise matemática, estatística e álgebra linear. E se estiver ruim com o currículo escolar, ou seja,

youclever.org .

A computação distribuída funcionará apenas na prática. Em primeiro lugar, isso requer infraestrutura e, em segundo lugar, os algoritmos podem rapidamente se tornar obsoletos. Agora algo novo está aparecendo constantemente.

Que tendências a comunidade discute

Outra área está ganhando força gradualmente, o que pode levar a um rápido aumento na quantidade de dados - a Internet das Coisas (IoT). Dados desse tipo vêm dos sensores de dispositivos conectados em uma rede, e o número de sensores no início da próxima década deve atingir dezenas de bilhões.

Os dispositivos são muito diferentes - de eletrodomésticos a veículos e máquinas industriais, um fluxo contínuo de informações que exigirá infraestrutura adicional e um grande número de especialistas altamente qualificados. Isso significa que, em um futuro próximo, haverá uma grande escassez de engenheiros de dados e analistas de big data.