Recentemente, descrevi, graças a quais robôs amanhã começarão MUITO melhor a pensar (um post sobre

aceleração de hardware de redes neurais ). Hoje veremos por que os robôs em breve serão muito melhores para ver. Em algumas situações, muito melhor que uma pessoa.

Falaremos sobre câmeras de profundidade que gravam vídeos, em cada pixel armazenado não a cor, mas a distância do objeto neste momento. Essas câmeras existem há mais de 20 anos, mas nos últimos anos a velocidade de seu desenvolvimento aumentou muitas vezes e já podemos falar sobre a revolução. E multi-vetor. O rápido desenvolvimento está ocorrendo nas seguintes áreas:

- Luz estruturada de uma câmera , ou uma câmera de luz estrutural, quando houver um projetor (geralmente infravermelho) e uma câmera que registra a luz estrutural do projetor;

- Câmeras Time of Flight , ou câmeras baseadas na medição do atraso na luz refletida;

- Profundidade das câmeras estéreo - a direção clássica e, talvez, a mais famosa de criar profundidade a partir do estéreo;

- Câmera de campo leve - também são câmeras de campo leve ou câmeras plenópticas, sobre as quais havia um post detalhado separado;

- E, finalmente, as câmeras baseadas na tecnologia Lidar , especialmente os novos Lidars de Estado Sólido , que funcionam sem falhas cerca de 100 vezes mais que os lidares convencionais e produzem a imagem retangular usual.

Quem se importa com a aparência, bem como uma comparação de diferentes abordagens e a aplicação atual e de amanhã - seja bem-vindo!

Então! Analisaremos as principais direções do desenvolvimento de câmaras de profundidade ou princípios realmente diferentes para medir a profundidade. Com seus prós e contras.

Método 1: Câmera de luz estruturada

Vamos começar com um dos métodos mais simples, antigos e relativamente baratos para medir a luz estruturada em profundidade. Esse método apareceu essencialmente imediatamente, assim que as câmeras digitais apareceram, ou seja, há mais de 40 anos e simplificou bastante um pouco mais tarde, com o advento dos projetores digitais.

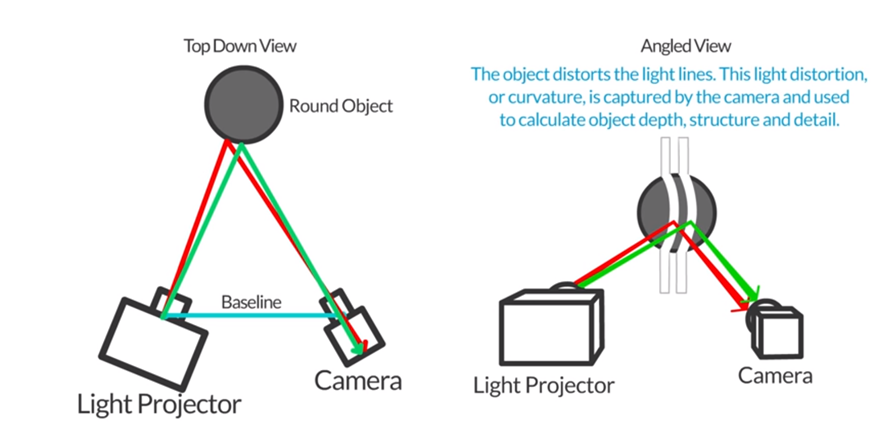

A ideia básica é extremamente simples. Colocamos ao lado do projetor, que cria, por exemplo, listras horizontais (e depois verticais) e ao lado da câmera, que tira uma foto com listras, conforme mostrado nesta figura:

Fonte: Autodesk: Digitalização 3D com luz estruturada

Fonte: Autodesk: Digitalização 3D com luz estruturadaComo a câmera e o projetor estão deslocados um do outro, as tiras também serão deslocadas na proporção da distância do objeto. Medindo esse deslocamento, podemos calcular a distância do objeto:

Fonte: http://www.vision-systems.com/

Fonte: http://www.vision-systems.com/De fato, com o projetor mais barato (e o preço começa em 3.000 rublos) e um smartphone, você pode medir a profundidade das cenas estáticas em uma sala escura:

Fonte: Autodesk: Digitalização 3D com luz estruturada

Fonte: Autodesk: Digitalização 3D com luz estruturadaÉ claro que, neste caso, um monte de problemas terá que ser resolvido - isso é calibração do projetor, calibração da câmera do telefone, reconhecimento de mudança de faixa e assim por diante, mas todas essas tarefas são capazes até mesmo para alunos avançados do ensino médio que aprendem programação.

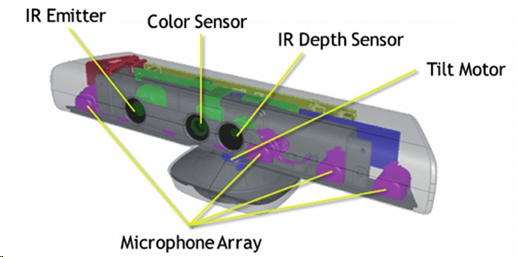

Esse princípio de medir a profundidade se tornou o mais conhecido quando, em 2010, a Microsoft lançou o

sensor de profundidade

MS Kinect por US $ 150, que na época era revolucionário e barato.

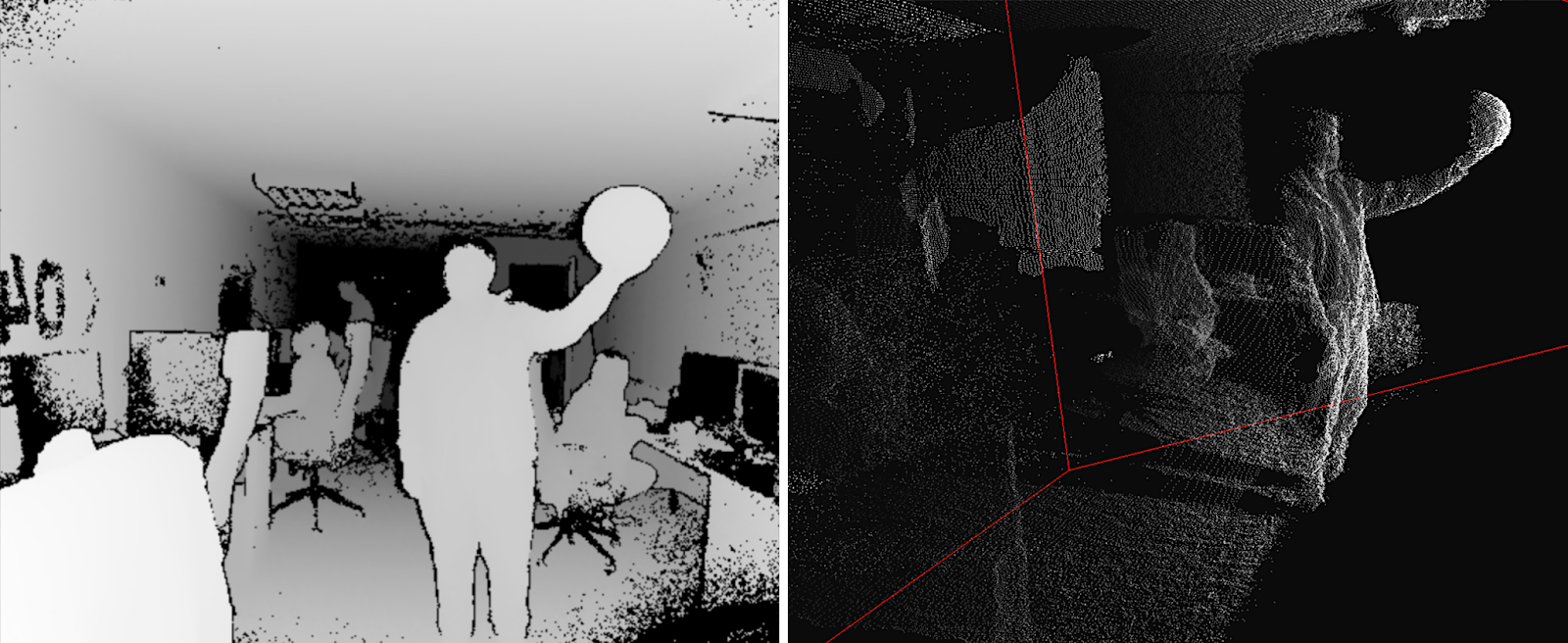

Fonte: Reconstrução de objetos parcialmente ocluídos usando vários sensores Kinect

Fonte: Reconstrução de objetos parcialmente ocluídos usando vários sensores KinectApesar de, além de medir a profundidade com um projetor de infravermelho e uma câmera de infravermelho, o Kinect também gravou vídeo RGB comum, tinha quatro microfones com redução de ruído e podia se ajustar a uma pessoa em altura, inclinando-se para cima ou para baixo automaticamente, foi imediatamente integrado ao interior processamento de dados, que emitiu para o console imediatamente um mapa de profundidade pronto:

Fonte: Implementação de botões naturais da interface do usuário usando Kinect

Fonte: Implementação de botões naturais da interface do usuário usando KinectNo total, foram vendidos cerca de 35 milhões de dispositivos, tornando o Kinect a primeira câmera de profundidade de massa da história. E se você considerar que certamente havia câmeras de profundidade antes, mas elas geralmente eram vendidas no máximo em centenas e custavam pelo menos uma ordem de magnitude mais cara - essa foi uma revolução que proporcionou grandes investimentos nessa área.

Uma razão importante para o sucesso foi que, quando a Microsoft lançou o Xbox 360, já havia alguns jogos que usavam ativamente o Kinect como sensor. A decolagem foi rápida:

Além disso, o Kinect até conseguiu entrar no Guinness Book of Records como o gadget mais vendido da história. É verdade que a Apple logo expulsou a Microsoft deste lugar, mas mesmo assim. Para um novo sensor experimental que funciona, além do dispositivo principal, para se tornar o dispositivo eletrônico mais vendido na história, isso é simplesmente uma grande conquista:

Nas palestras, gosto de perguntar à platéia de onde vêm todos esses milhões de clientes. Quem eram todas essas pessoas?

Como regra geral, ninguém adivinha, mas às vezes, especialmente se o público é mais velho e mais experiente, eles dão a resposta correta: as vendas foram conduzidas por pais americanos, que viram com prazer que seus filhos podiam brincar no console e não se sentar no sofá com um espólio espesso, e pulando na frente da TV. Foi um avanço !!! Milhões de mães e pais correram para pedir um dispositivo para seus filhos.

Em geral, quando se trata de reconhecimento de gestos, as pessoas geralmente acreditam ingenuamente que apenas os dados de uma câmera 2D são suficientes. Afinal, eles viram muitas demos lindas! A realidade é muito mais grave. A precisão do reconhecimento de gestos de um fluxo de vídeo 2D de uma câmera e a precisão do reconhecimento de gestos de uma profundidade de câmera diferem por uma ordem de magnitude. De uma câmera de profundidade, ou melhor, de uma câmera RGB combinada com uma câmera de profundidade (a última é importante), é possível reconhecer os gestos com muito mais precisão e a um custo menor (mesmo se a sala estiver escura) e isso trouxe sucesso à primeira câmera de profundidade de massa.

Sobre o Kinect no Habré na época eles escreveram

muito , muito brevemente como isso funciona.

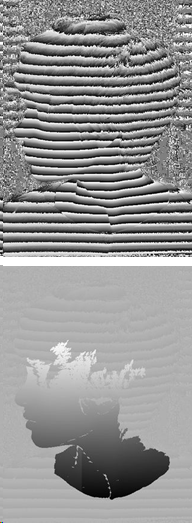

Um projetor de infravermelho fornece um conjunto de pontos pseudo-aleatórios no espaço, cujo deslocamento determina a profundidade em um determinado pixel:

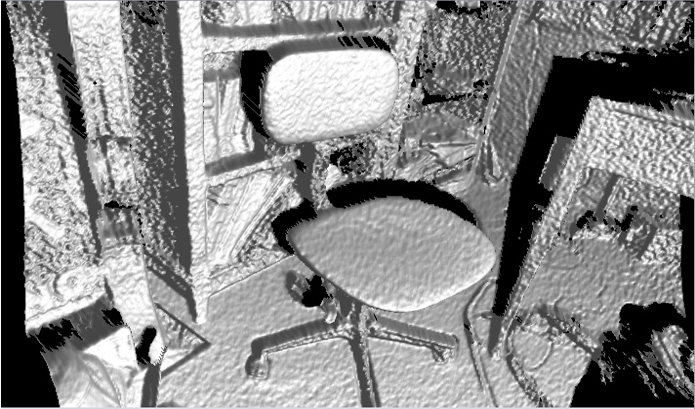

Fonte: Estruturas planares com detecção de profundidade: detecção de configurações de móveis de escritório

Fonte: Estruturas planares com detecção de profundidade: detecção de configurações de móveis de escritórioA resolução da câmera é declarada como 640x480, mas realmente existe algo em torno de 320x240 com filtragem bastante forte e a imagem em exemplos reais se parece com esta (ou seja, bastante assustadora):

Fonte: Reconstrução de objetos parcialmente ocluídos usando vários sensores Kinect

Fonte: Reconstrução de objetos parcialmente ocluídos usando vários sensores KinectAs “sombras” dos objetos são claramente visíveis, pois a câmera e o projetor estão afastados o suficiente. Pode-se observar que mudanças de vários pontos do projetor são realizadas para prever a profundidade. Além disso, há filtragem (difícil) por vizinhos imediatos, mas ainda assim o mapa de profundidade é bastante barulhento, especialmente nas fronteiras. Isso leva a um ruído bastante perceptível na superfície dos objetos resultantes, que deve ser suavizado adicional e não trivialmente:

Fonte: Biblioteca Java J4K para o Kinect SDK da Microsoft

Fonte: Biblioteca Java J4K para o Kinect SDK da MicrosoftNo entanto, apenas US $ 150 (

hoje já são US $ 69 , embora

esteja melhor perto de US $ 200 , é claro) - e você "vê" a profundidade!

Realmente existem

muitos produtos em série.

A propósito, em fevereiro deste ano, um novo

Azure Kinect foi anunciado:

Fonte: Microsoft anuncia o Azure Kinect, disponível para pré-encomenda agora

Fonte: Microsoft anuncia o Azure Kinect, disponível para pré-encomenda agoraSuas entregas para desenvolvedores nos EUA e na China devem começar em 27 de junho, ou seja, literalmente agora. Dos recursos, além da visivelmente melhor resolução de RGB e melhor qualidade de câmeras de profundidade (eles prometem

1024x1024 a 15 FPS e 512x512 a 30 FPS e maior qualidade é

claramente visível na demo , a câmera ToF), é declarado

claramente o suporte à colaboração de vários dispositivos

prontos para

uso , menos exposição a o sol, o erro é inferior a 1 cm a uma distância de 4 metros e 1-2 mm a uma distância de menos de 1 metro, o que parece extremamente interessante, por isso esperamos, esperamos:

Fonte: Apresentando o Azure Kinect DK

Fonte: Apresentando o Azure Kinect DKO próximo produto em

massa , onde uma câmera de profundidade foi realizada sob uma luz estruturada, não era um console de jogos, mas ... (rolo de bateria) corretamente -

iPhone X !

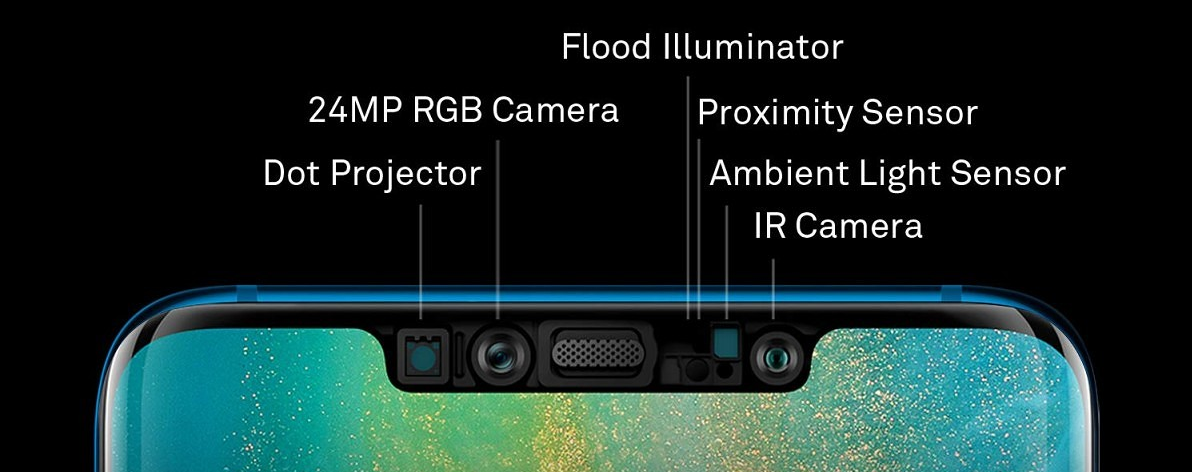

Sua tecnologia Face ID é uma câmera de profundidade típica com um projetor de ponto infravermelho e uma câmera infravermelha (a propósito, agora você entende por que eles estão nas bordas da franja, espaçados o mais longe possível um do outro - esta é uma

base estéreo ):

A resolução do mapa de profundidade é ainda menor que a do Kinect - cerca de 150x200. É claro que, se você disser: "Nossa resolução é de cerca de 150x200 pixels ou 0,03 megapixels", as pessoas dirão breve e sucintamente: "É uma merda!" E se você disser

“Projetor de ponto: mais de 30.000 pontos invisíveis são projetados em seu rosto” , as pessoas dizem: “Uau, 30 mil pontos invisíveis, legal!”. Algumas loiras perguntam se sardas aparecem de pontos invisíveis. E o tópico irá para as massas! Portanto, a segunda opção foi previdente na publicidade. A resolução é pequena por três razões: primeiro, os requisitos de miniatura, segundo, consumo de energia e, terceiro, preços.

No entanto, esta é outra câmera de profundidade sob uma luz estruturada, que já foi utilizada em uma série de milhões de cópias e já foi repetida por outros fabricantes de smartphones,

por exemplo, (surpresa-surpresa!) Huawei (que ultrapassou a Apple nas vendas de smartphones no ano passado). Somente a Huawei tem uma câmera à direita e o projetor à esquerda, mas também, é claro, ao longo das bordas da "franja":

Fonte: Atualização Huawei Mate 20 Pro permite que os usuários adicionem uma segunda face para desbloqueio facial

Fonte: Atualização Huawei Mate 20 Pro permite que os usuários adicionem uma segunda face para desbloqueio facialAo mesmo tempo, 300.000 pontos são declarados, ou seja

, 10 vezes mais que a Apple , a câmera frontal é melhor

e a fonte é maior . Existe um exagero em relação a 300 mil - é difícil dizer, mas a Huawei demonstra uma ótima

digitalização em 3D de objetos com uma câmera frontal . Testes independentes são

mais assustadores , mas esse é claramente o começo do tópico, e a infância da tecnologia de câmeras em profundidade com eficiência energética em miniatura e anúncios de câmeras no final deste ano já é notavelmente melhor em desempenho.

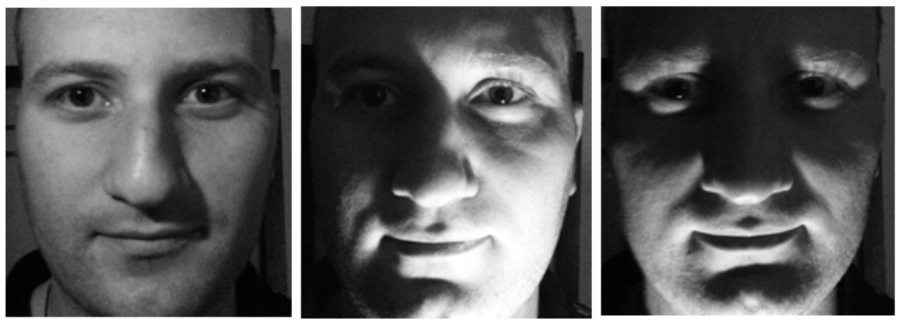

Ao mesmo tempo, é compreensível por que a tecnologia de identificação de rosto foi usada em telefones. Em primeiro lugar, agora você não pode enganar o detector mostrando uma foto do seu rosto (ou vídeo do tablet). Em segundo lugar, o rosto muda muito quando a iluminação muda, mas sua forma não muda, o que nos permite identificar com mais precisão a pessoa junto com os dados da câmera RGB:

Fonte: foto da mesma pessoa da TI

Fonte: foto da mesma pessoa da TIObviamente, o sensor infravermelho tem problemas inerentes. Primeiro, nosso projetor relativamente fraco brilha ao sol uma ou duas vezes, para que essas câmeras não funcionem na rua. Mesmo na sombra, se a parede branca de um prédio estiver iluminada pelo sol, você poderá ter grandes problemas com o Face ID. O nível de ruído no Kinect também rola mesmo quando o sol está coberto de nuvens:

Fonte: esta e as próximas duas fotos

Fonte: esta e as próximas duas fotos -

materiais Basler AGOutro grande problema é reflexão e reflexão. Como a luz infravermelha também é refletida, para fotografar uma chaleira de aço inoxidável cara, uma mesa envernizada ou uma sombra de vidro com Kinect será problemática:

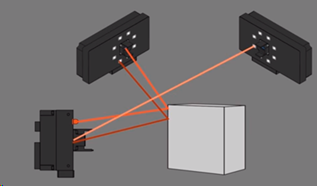

E, finalmente, duas câmeras fotografando um objeto podem interferir uma na outra. Curiosamente, no caso de luz estruturada, você pode fazer o projetor piscar e entender onde estão nossos pontos e onde não, mas esta é uma história separada e bastante complicada:

Agora você sabe como quebrar o FaceID ...

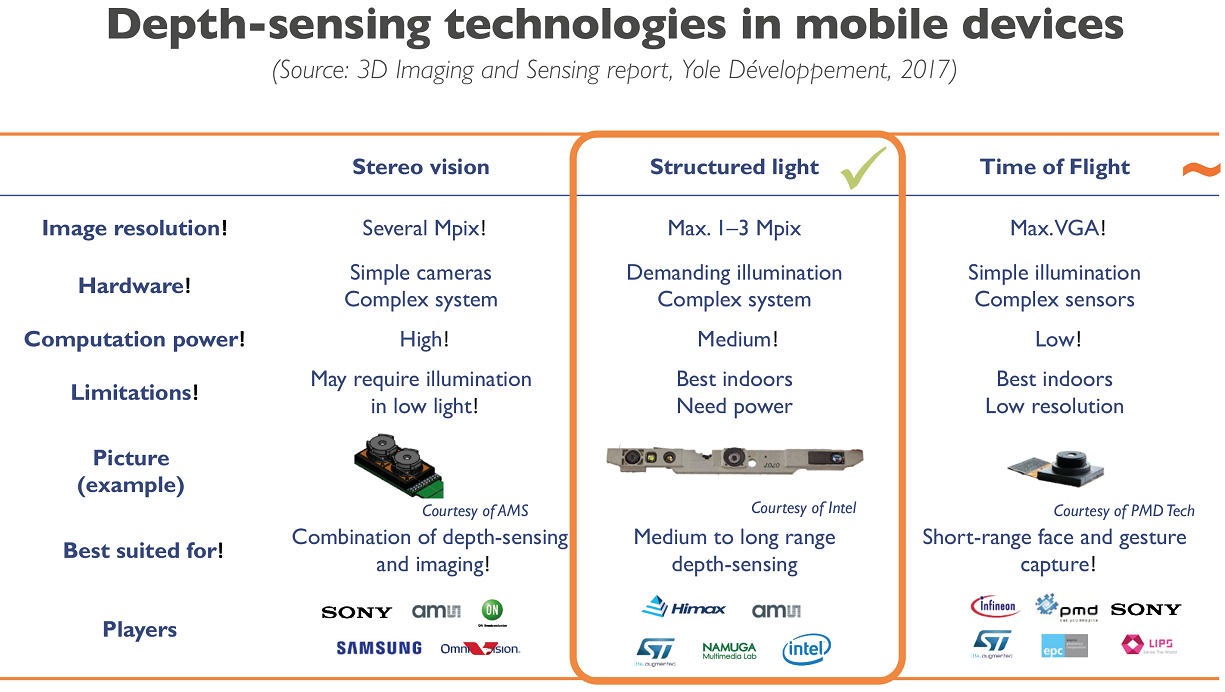

No entanto, para dispositivos móveis, a luz estruturada parece o compromisso mais razoável hoje:

Fonte: Empresas de smartphones lutam para acompanhar o desempenho e os custos da câmera 3D da Apple

Fonte: Empresas de smartphones lutam para acompanhar o desempenho e os custos da câmera 3D da ApplePara luz estruturada, o baixo custo de um sensor convencional é tal que seu uso na maioria dos casos é mais do que justificado. O que deu vida a um grande número de startups operando de acordo com a fórmula: sensor barato + software complexo = resultado bastante aceitável.

Por exemplo, nosso ex-aluno de graduação

Maxim Fedyukov , envolvido em reconstrução em 3D desde 2004, criou a

Texel , cujo principal produto é uma plataforma com 4 câmeras Kinect e software que transforma uma pessoa em um monumento em potencial em 30 segundos. Bem, ou uma estatueta de mesa. Este é quem tem dinheiro suficiente. Ou você pode enviar fotos de amigos baratas e alegres do seu modelo 3D para seus amigos (por algum motivo, o caso mais popular por algum motivo). Agora eles enviam suas plataformas e software para o exterior do Reino Unido para a Austrália:

Fonte: Criando um modelo 3D de uma pessoa em 30 segundosComo bailarina, eu não suporto lindamente, então só olho pensativamente para a barbatana de um passado de natação de tubarão:

Fonte: materiais do autor

Fonte: materiais do autorEm geral, um novo tipo de sensor gerou novos projetos de arte. No inverno, vi um filme VR bastante curioso filmado com o Kinect. Abaixo está uma visualização interessante da dança, também feita com o Kinect (parece que foram usadas 4 câmeras) e, ao contrário do exemplo anterior, eles não brigaram com barulho, mas acrescentaram detalhes divertidos:

Fonte: Uma apresentação de dança capturada com um sensor Kinect e visualizada com software 3D

Fonte: Uma apresentação de dança capturada com um sensor Kinect e visualizada com software 3DQuais tendências podem ser observadas na área:

- Como você sabe, os sensores digitais das câmeras modernas são sensíveis à radiação infravermelha; portanto, é necessário usar filtros de bloqueio especiais para que o ruído infravermelho não estrague a imagem (até a direção do disparo artístico na faixa infravermelha aparece, inclusive quando o filtro é removido do sensor). Isso significa que grandes quantias de dinheiro são investidas em miniaturização, maior resolução e sensores mais baratos, que podem ser usados como infravermelho (com um filtro especial ).

- Da mesma forma, os algoritmos para o processamento de mapas de profundidade estão melhorando rapidamente, incluindo os métodos da chamada filtragem cruzada, quando os dados de um sensor RGB e os dados ruidosos por profundidade permitem obter um ótimo vídeo de profundidade juntos. Ao mesmo tempo, usando abordagens de redes neurais, torna-se possível aumentar drasticamente a velocidade de obtenção de um bom resultado.

- Todas as principais empresas, especialmente fabricantes de smartphones, trabalham nessa área.

Como resultado:

- Podemos esperar um aumento dramático na resolução e precisão do disparo de câmeras com profundidade de luz estruturada nos próximos 5 anos.

- Haverá uma redução (embora mais lenta) no consumo de energia dos sensores móveis, o que simplificará o uso de sensores da próxima geração em smartphones, tablets e outros dispositivos móveis.

De qualquer forma, o que estamos vendo agora é a infância da tecnologia. Os primeiros produtos em massa nos quais a depuração da produção e o uso de um novo tipo de dados incomum estão sendo lançados - vídeo com profundidade.

Método 2: Câmera do Tempo de Voo

A próxima maneira de obter profundidade é mais interessante. Baseia-se na medição do atraso da luz de ida e volta (ToF -

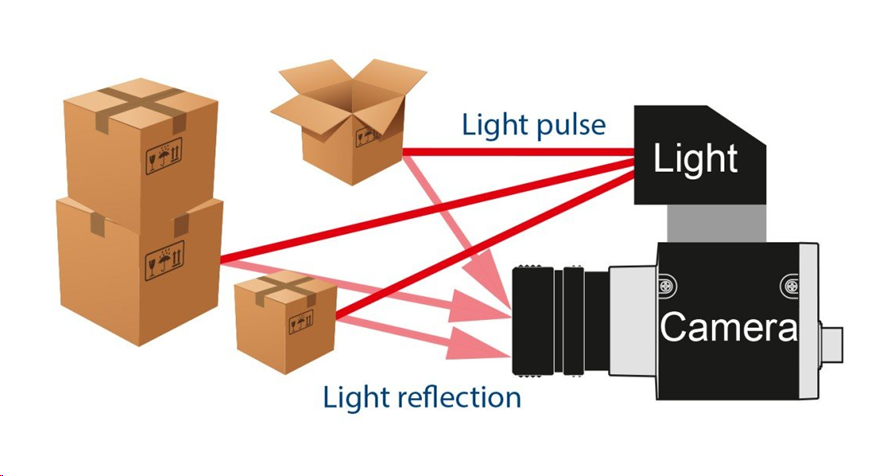

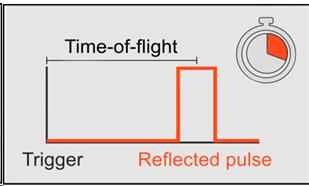

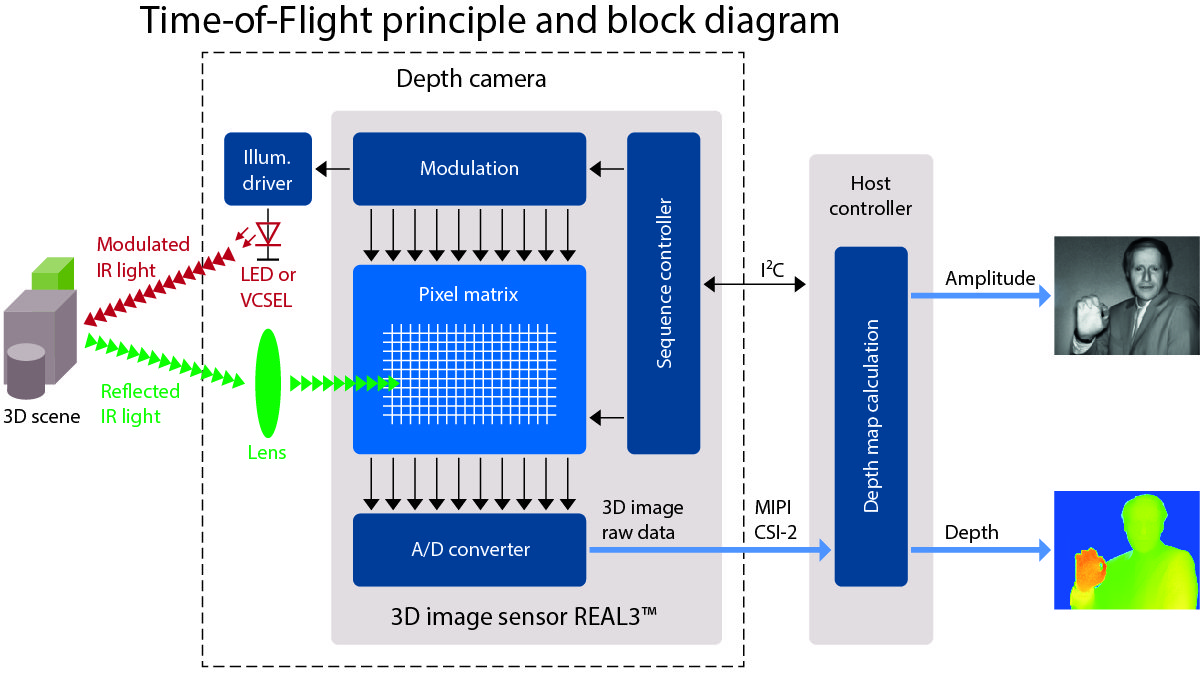

Time-of-Flight ). Como você sabe, a velocidade dos processadores modernos é alta e a velocidade da luz é pequena. Em um ciclo de clock do processador a 3 GHz, a luz consegue voar apenas 10 centímetros. Ou 10 medidas por metro. Muito tempo, se alguém estava envolvido na otimização de baixo nível. Assim, instalamos uma fonte de luz pulsada e uma câmera especial:

Fonte: Câmera Basler de tempo de voo (ToF)

Fonte: Câmera Basler de tempo de voo (ToF)De fato, precisamos medir o atraso com o qual a luz retorna a cada ponto:

Fonte: Câmera Basler de tempo de voo (ToF)

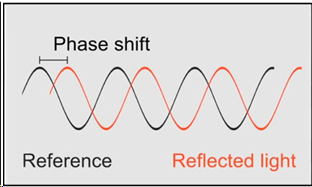

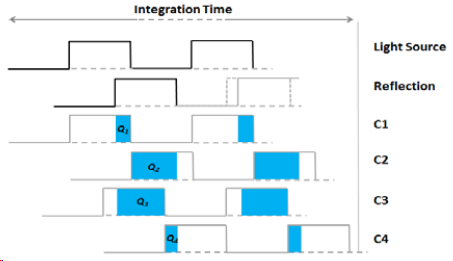

Fonte: Câmera Basler de tempo de voo (ToF)Ou, se tivermos vários sensores com diferentes tempos de acumulação de carga, sabendo o deslocamento do tempo em relação à fonte de cada sensor e o brilho do flash, podemos calcular o deslocamento e, consequentemente, a distância do objeto e aumentando o número de sensores, aumentamos a precisão:

Fonte: Câmera de tempo de voo de Larry Li - uma introdução

Fonte: Câmera de tempo de voo de Larry Li - uma introduçãoO resultado é um esquema da câmera com iluminação infravermelha por LED ou, menos comumente, por laser (

VCSEL ):

Fonte: Uma descrição muito boa do ToF em allaboutcircuits.com

Fonte: Uma descrição muito boa do ToF em allaboutcircuits.comNesse caso, a imagem é obtida em uma resolução bastante baixa (porque precisamos colocar vários sensores com tempos de pesquisa diferentes próximos um do outro), mas potencialmente com FPS alto. E os problemas estão principalmente nos limites dos objetos (o que é típico para todas as câmeras de profundidade). Mas sem as “sombras” típicas da luz estruturada:

Fonte: Vídeo da Basler AG

Fonte: Vídeo da Basler AGEm particular, foi esse tipo de câmera (ToF) que testou ativamente o Google no projeto

Google Tango , que foi bem representado

neste vídeo . O significado era simples - combinar os dados do giroscópio, acelerômetro, câmera RGB e câmera de profundidade, criando uma cena tridimensional na frente do smartphone:

Fonte: Projeto Tango do Google agora está dimensionado para smartphones

Fonte: Projeto Tango do Google agora está dimensionado para smartphonesO projeto em si não foi (na minha opinião, estava um pouco adiantado), mas criou pré-requisitos importantes para criar uma onda de interesse na realidade aumentada de realidade aumentada - e, consequentemente, desenvolver sensores que possam trabalhar com ele. Agora, todas as suas realizações são

lançadas no

ARCore do Google.

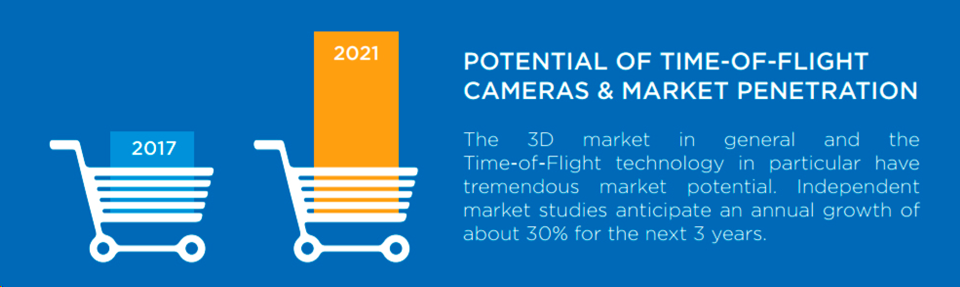

Em geral, o volume de mercado das câmeras ToF cresce cerca de 30% a cada 3 anos, o que é um crescimento bastante exponencial e poucos mercados crescem tão rápido:

Fonte: Potencial de câmeras de tempo de voo e penetração no mercado

Fonte: Potencial de câmeras de tempo de voo e penetração no mercadoUm fator importante do mercado hoje é o rápido (e também exponencial) desenvolvimento de robôs industriais, para os quais as câmeras ToF são a solução ideal. Por exemplo, se o seu robô empacota caixas, com uma câmera 2D comum, determinar que você está começando a obstruir o papelão é uma tarefa extremamente não trivial. E para uma câmera ToF, é trivial "ver" e processá-la. E muito rápido. Como resultado, vemos um

boom nas câmeras ToF industriais :

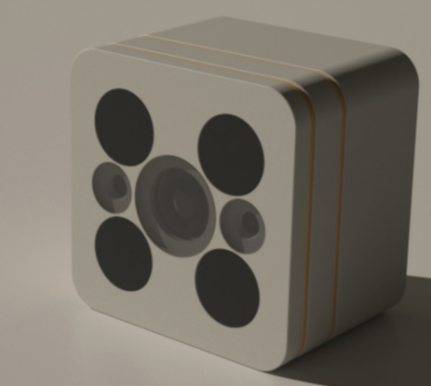

Naturalmente, isso também leva ao aparecimento de produtos caseiros usando câmeras de profundidade. Por exemplo, uma câmera de segurança com uma unidade de vídeo noturno e uma câmera de profundidade ToF da alemã

PMD Technologies , que desenvolve câmeras 3D há

mais de 20 anos :

Fonte: Detecção de profundidade de tempo de vôo em 3D traz mágica para a nova câmera doméstica Smart Lighthouse

Fonte: Detecção de profundidade de tempo de vôo em 3D traz mágica para a nova câmera doméstica Smart LighthouseLembra da capa de invisibilidade em que Harry Potter estava escondido?

Fonte: Capa da invisibilidade de Harry Potter ganha uma história de origem e pode em breve existir na vida real

Fonte: Capa da invisibilidade de Harry Potter ganha uma história de origem e pode em breve existir na vida realReceio que a câmera alemã a detecte uma ou duas vezes. E será difícil colocar uma tela com uma foto na frente de uma câmera (essa não é uma proteção que distraia você):

Fonte: Fragmento do filme “Missão Impossível: Protocolo Fantasma”

Fonte: Fragmento do filme “Missão Impossível: Protocolo Fantasma”Parece que, para as novas câmeras de CFTV, a magia não infantil de Hogwarts será necessária para enganá-las com uma câmera de profundidade ToF, capaz de gravar esse vídeo em completa escuridão:

Fingir ser uma parede, uma tela e outras maneiras de se proteger do fato de que a câmera ToF + RGB combinada detectará um objeto estranho se torna tecnicamente mais difícil do que o normal.

Outra aplicação massiva e pacífica para câmeras de profundidade é o reconhecimento de gestos. Em um futuro próximo, você pode esperar televisores, consoles e aspiradores de pó robóticos capazes de perceber não apenas os comandos de voz como alto-falantes inteligentes, mas também o descuidado "limpe!" com um aceno de mão. Então, o controle remoto (também conhecido como preguiçoso) para a TV inteligente se tornará completamente desnecessário e a ficção científica ganhará vida. Como resultado, o que

foi fantástico em 2002 tornou-se experimental em 2013 e, finalmente,

em série em 2019 (embora as pessoas não saibam que há uma câmera de profundidade no interior,

que diferença faz, como essa mágica funciona? ):

Fonte: artigo , experimentos e produtos

Fonte: artigo , experimentos e produtosE a linha completa de aplicativos é ainda mais ampla, é claro:

Fonte: vídeo dos sensores de profundidade da Terabee (a propósito, que tipo de mouse eles correm no chão por 2 e 3 vídeos? Vê-los? Brincadeirinha, é poeira no ar - a taxa pelo tamanho pequeno do sensor e pela proximidade da fonte de luz com o sensor)

Fonte: vídeo dos sensores de profundidade da Terabee (a propósito, que tipo de mouse eles correm no chão por 2 e 3 vídeos? Vê-los? Brincadeirinha, é poeira no ar - a taxa pelo tamanho pequeno do sensor e pela proximidade da fonte de luz com o sensor)A propósito - nas famosas "lojas sem caixas" do Amazon Go, também há muitas câmeras embaixo do teto:

Fonte: Por dentro da loja de conveniência sem vigilância da Amazon

Fonte: Por dentro da loja de conveniência sem vigilância da AmazonAlém disso, como o

TechCrunch escreve:

"Eles são aumentados por câmeras de detecção de profundidade separadas (usando uma técnica de tempo de voo , ou pelo que entendi da Kumar) que se misturam ao fundo como o resto, todas em preto fosco". Ou seja, o milagre de determinar de que prateleira o iogurte é retirado é fornecido, entre outras coisas, pelas misteriosas câmeras ToF pretas foscas (uma boa pergunta, estão na foto):

Infelizmente, muitas vezes é difícil encontrar informações diretas. Mas existe um indireto. Por exemplo, havia uma empresa

Softkinetic , que desde 2007 desenvolve câmeras ToF. 8 anos depois, eles foram

comprados pela Sony (que, aliás, está pronta para conquistar novos mercados com a marca

Sony Depthsensing ). Portanto, um dos

principais funcionários da Softkinetic agora trabalha apenas no Amazon Go. Que coincidência! Dentro de alguns anos, quando a tecnologia for apresentada e as principais patentes forem registradas, os detalhes provavelmente serão revelados.

Bem, como sempre, os chineses inflamam.

O Pico Zense , por exemplo, apresentou na CES 2019 uma linha muito impressionante de câmeras ToF, incluindo para uso externo:

Eles prometem uma revolução em todos os lugares. Os caminhões serão carregados mais densos devido ao carregamento automatizado, os caixas eletrônicos serão mais seguros, devido às câmeras de profundidade em cada um, a navegação dos robôs se tornará mais fácil e precisa, as pessoas (e, principalmente, as crianças!) Serão contadas uma ordem de magnitude melhor no fluxo, novos simuladores de fitness aparecerão. a capacidade de controlar a correção dos exercícios sem um instrutor e assim por diante. Naturalmente, câmeras chinesas baratas de uma nova geração de profundidade já estão prontas para toda essa magnificência. Pegue e construa!

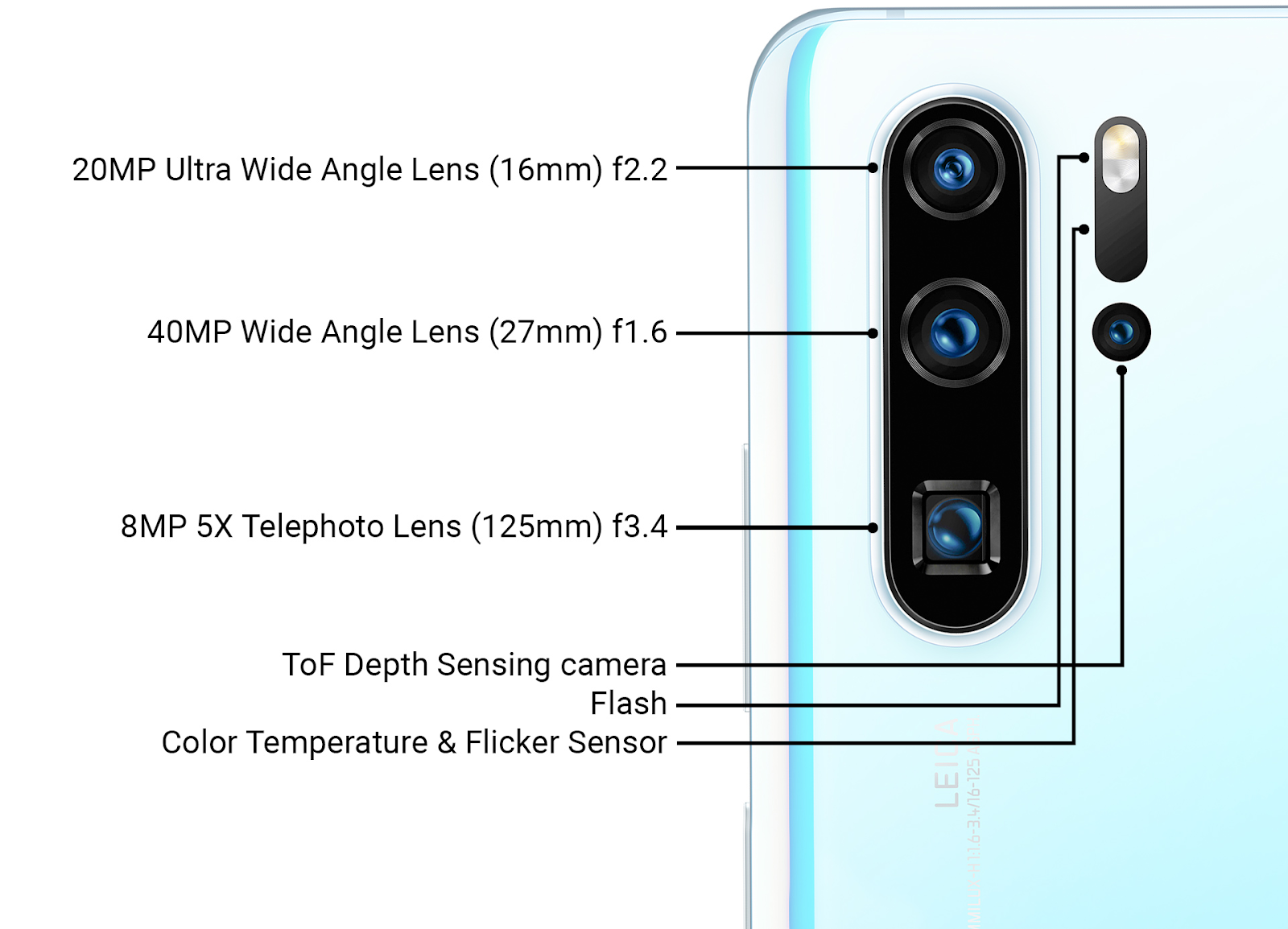

Curiosamente, o Huawei P30 Pro serial mais recente possui um sensor ToF ao lado das câmeras principais, ou seja, a Huawei sofredora é mais capaz de fazer a Apple produzir sensores de luz frontais estruturados e, aparentemente, com mais sucesso o Google (Projeto Tango, que

foi fechado ) implementou uma câmera ao lado das principais câmeras ToF:

Fonte: Ars Technica Huawei nova revisão de tecnologia no final de março de 2019

Fonte: Ars Technica Huawei nova revisão de tecnologia no final de março de 2019Os detalhes do uso, é claro, não são divulgados, mas, além de acelerar o foco (o que é importante para as três câmeras principais com lentes diferentes), esse sensor pode ser usado para aumentar a qualidade de desfocar o fundo das fotos (simulando uma pequena

profundidade de campo ).

Também é óbvio que a próxima geração de sensores de profundidade ao lado das câmeras principais será usada nas aplicações de RA, o que aumentará a precisão do RA desde o atual "cool, mas muitas vezes com erros" para um nível de trabalho em massa. E, obviamente, à luz dos sucessos chineses, a grande questão é quanto o Google desejará suportar o hardware revolucionário chinês no

ARCore . As guerras de patentes podem desacelerar significativamente o mercado de tecnologia. O desenvolvimento desta história dramática, veremos literalmente nos próximos dois anos.

Subtotais

Cerca de 25 anos atrás, quando as primeiras portas automáticas apareceram, observei pessoalmente como tios respeitáveis aceleravam periodicamente na frente de tais portas. Consegue abrir ou não tem tempo? Ela é grande, pesada, de vidro! Sobre a mesma coisa que observei recentemente durante uma visita a professores bastante respeitáveis em uma fábrica automática na China. Eles ficaram um pouco atrás do grupo para ver o que aconteceria se você ficasse no robô, carregando partes pacificamente e tocando uma melodia agradável e tranquila no caminho. Eu também me arrependo, não pude resistir ... Sabe, para! Talvez sem problemas. Talvez como um homem morto. Sensores de profundidade funcionam!

Fonte: Por dentro do novo campus da Huawei Technology

Fonte: Por dentro do novo campus da Huawei TechnologyO hotel também trabalhava como robôs de limpeza, que eram algo assim:

Ao mesmo tempo, eles sofreram bullying com mais força do que robôs na fábrica. Não é tão duro quanto no

desumano em todos os sentidos da

Bosstown Dynamics , é claro. Mas eu pessoalmente assisti como eles subiram na estrada, o robô tentou contornar uma pessoa, a pessoa se moveu, bloqueando a estrada ... Uma espécie de gato e rato. Em geral, parece que quando veículos não tripulados aparecem nas estradas, na primeira vez em que são cortados com mais frequência do que o habitual ... Oh, pessoas-pessoas ... Hmmm ... No entanto, estávamos distraídos.

Resumindo os pontos principais:

- Devido a outro princípio de operação, podemos posicionar a fonte de luz na câmera ToF o mais próximo possível do sensor (mesmo sob a mesma lente). Além disso, muitos modelos industriais têm LEDs localizados ao redor do sensor. Como resultado, as “sombras” no mapa de profundidade são radicalmente reduzidas ou até desaparecem. I.e. trabalho simplificado com objetos geométricos complexos, o que é importante para robôs industriais.

- Como a iluminação pulsada, via de regra, permanece infravermelha - todas as desvantagens da câmera infravermelha descritas na última seção são preservadas: exposição ao sol, dificuldades quando duas câmeras trabalham lado a lado etc. No entanto, os robôs industriais costumam trabalhar em ambientes fechados e estão sendo desenvolvidas câmeras com iluminação a laser.

- Infelizmente, os sensores ToF são mais difíceis de "desviar" a melhoria geral dos sensores das câmeras RGB, portanto, seu desenvolvimento é mais lento, mas surpreendentemente confiante e as notícias sobre a introdução das câmeras ToF são MUITO MUITO e o que (não) existe (somente em smartphones anunciaram a integração de sensores e sensores). Samsung, Google Pixel e Sony Xperia ...).

- A nova Sony promete que 2 em 8 câmeras de telefone (!!!) serão câmeras de profundidade ToF (!), Ou seja, câmeras de profundidade estarão nos dois lados do telefone:

Fonte: Hexa-cam Sony phone revela especificações da câmera

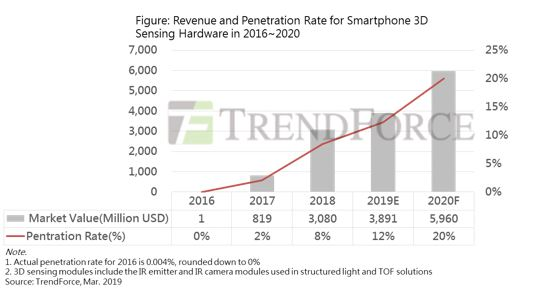

- Como resultado, encontraremos muitas coisas interessantes nessa área, mesmo no próximo ano! E no próximo ano, até 20% dos novos telefones estarão com câmeras de profundidade (luz estruturada + ToF). Como em 2017 apenas a Apple estava no mercado em um esplêndido isolamento com "30 mil pontos", e agora eles não estão colocando menos de 300 mil, o tópico claramente foi bem:

Fonte: Crescimento limitado do mercado de detecção 3D de smartphones em 2019; Apple será o principal promotor do crescimento em 2020

Você ainda duvida da revolução em andamento?

Esta foi a primeira parte! Uma comparação geral será no segundo.

Na próxima série, aguarde:

- Método 3, clássico: profundidade do estéreo;

- Método 4, newfangled: profundidade de plenoptics;

- Método 5, de crescimento rápido: lidares, incluindo Lidares de Estado Sólido;

- Alguns problemas ao processar vídeo com profundidade;

- E, finalmente, uma breve comparação de todos os 5 métodos e conclusões gerais.

Cartago deve estar quebrado ... O vídeo inteiro será tridimensional até o final do século!Fique atento! (Se eu tiver tempo suficiente, descreverei novas câmeras, incluindo testes do Kinect novo, até o final do ano.)

Parte 2AgradecimentosGostaria de agradecer cordialmente:

- Laboratório de Computação Gráfica VMK Moscow State University MV Lomonosov por sua contribuição para o desenvolvimento de computação gráfica na Rússia em geral e trabalhar com câmeras de profundidade em particular,

- Microsoft, Apple, Huawei e Amazon para produtos baseados em câmeras de grande profundidade,

- Texel para o desenvolvimento de produtos russos de alta tecnologia com câmeras de profundidade,

- pessoalmente Konstantin Kozhemyakov, que fez muito para tornar este artigo melhor e mais visual,

- e, finalmente, muito obrigado a Roman Kazantsev, Evgeny Lyapustin, Yegor Sklyarov, Maxim Fedyukov, Nikolai Oplachko e Ivan Molodetsky pelo grande número de comentários e correções sensatas que tornaram este texto muito melhor!