Hoje, o Google anunciou um

rascunho de RFC do padrão REP (Robots Exclusion Protocol) , disponibilizando simultaneamente seu analisador de arquivos robots.txt sob a Licença Apache 2.0. Até hoje, não havia um padrão oficial para o REP (Robots Exclusion Protocol) e o robots.txt (este era o mais próximo a ele), o que permitia aos desenvolvedores e usuários interpretá-lo à sua maneira. A iniciativa da empresa visa reduzir as diferenças entre implementações.

Um rascunho do novo padrão pode ser visualizado

no site da IETF , e o repositório está disponível no Github em

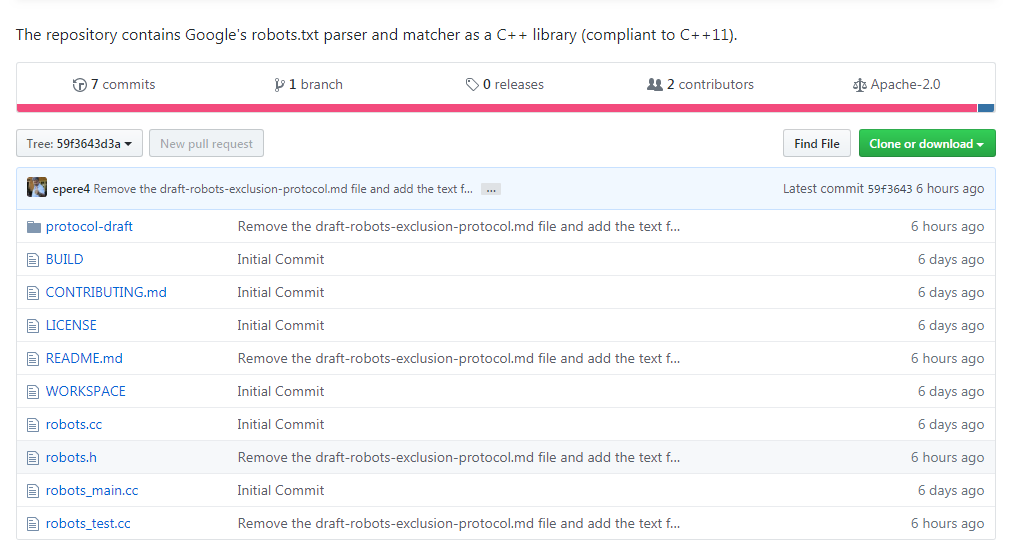

https://github.com/google/robotstxt .

O analisador é o código-fonte que o Google usa como parte de seus sistemas de produção (com exceção de edições menores - como arquivos de cabeçalho limpos que são usados apenas dentro da empresa) - os arquivos robots.txt são analisados exatamente como o Googlebot (incluindo como ele trata caracteres Unicode em padrões). O analisador é escrito em C ++ e consiste basicamente em dois arquivos - você precisa de um compilador compatível com C ++ 11, embora o código da biblioteca remonta aos anos 90, e você encontrará ponteiros brutos e

strbrk nele . Para montá-lo, é recomendável usar o

Bazel (o suporte ao CMake está planejado para o futuro próximo).

A própria idéia do robots.txt e do padrão pertence a Martain Coster, que o criou em 1994 -

segundo a lenda , o motivo foi a aranha de busca Charles Strauss, que "deixou cair" o servidor Bonfire usando um ataque DoS. Sua idéia foi escolhida por outros e rapidamente se tornou o padrão de fato para os envolvidos no desenvolvimento de mecanismos de busca. Aqueles que queriam fazer a análise às vezes tinham que fazer engenharia reversa do Googlebot, incluindo o Blekko, que escreveu seu

próprio analisador para Perl para seu mecanismo de pesquisa.

O analisador não ficou sem momentos divertidos: veja, por exemplo,

quanto trabalho foi desaprovado no processamento .