Na

primeira parte deste texto, examinamos as câmeras de profundidade com base nas medições de luz estrutural e atraso da luz de ida e volta, que usam principalmente iluminação infravermelha. Eles funcionam muito bem em ambientes fechados, a distâncias entre 10 centímetros e 10 metros, e o mais importante - são muito baratos. Daí a enorme onda de seu uso atual em smartphones. Mas ... Assim que saímos, o sol, mesmo através das nuvens, ilumina a luz infravermelha e seu trabalho se deteriora acentuadamente.

Como Steve Blank diz (

por outro motivo , no entanto): "Se você quer sucesso, saia do prédio". Abaixo, falaremos sobre câmeras de profundidade trabalhando ao ar livre. Hoje, esse tópico é fortemente dirigido por carros autônomos, mas, como veremos, não apenas.

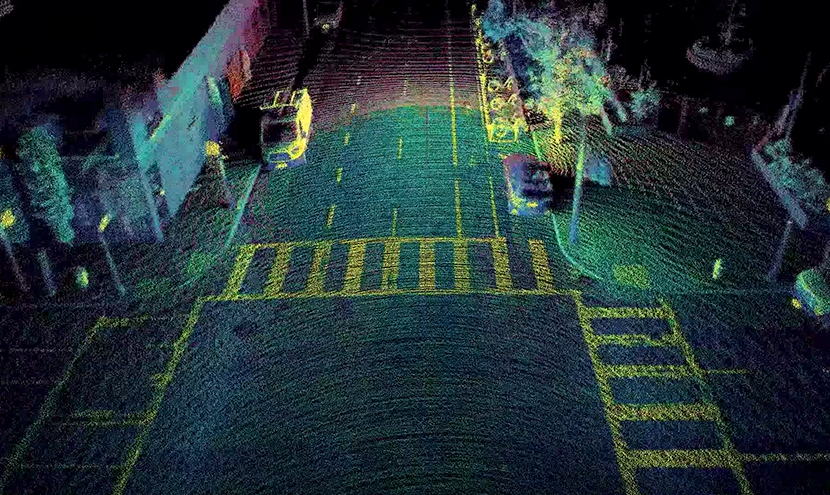

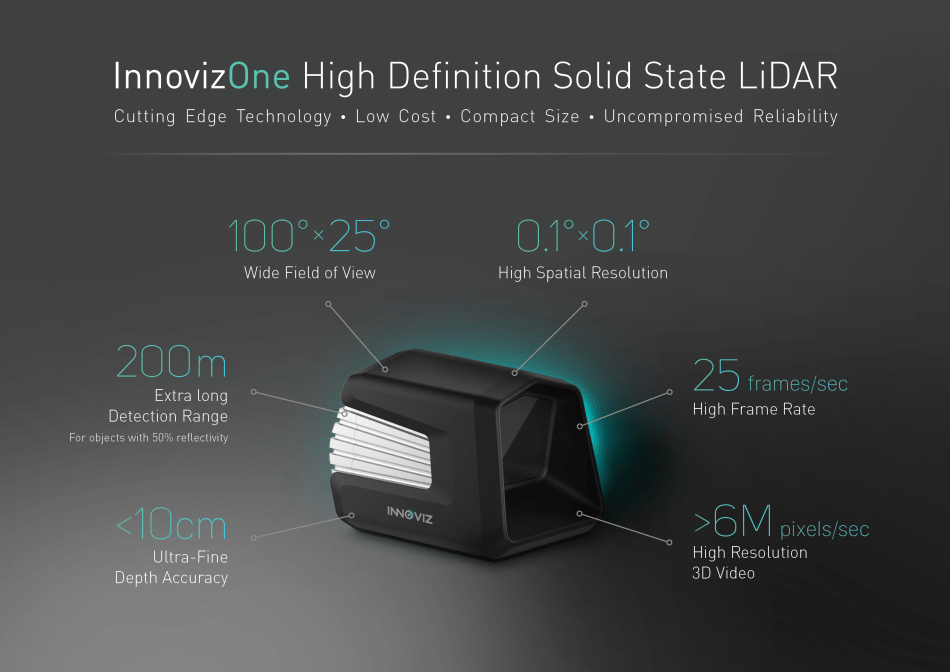

Fonte: Innoviz prevê carros autônomos produzidos em massa com LiDAR de estado sólido

Fonte: Innoviz prevê carros autônomos produzidos em massa com LiDAR de estado sólidoEntão, câmeras de profundidade, ou seja, dispositivos que gravam vídeo, em cada pixel cuja distância até a cena objeto, trabalhando sob a luz do sol!

Quem se importa - bem-vindo ao kat!

Vamos começar com os clássicos atemporais ...

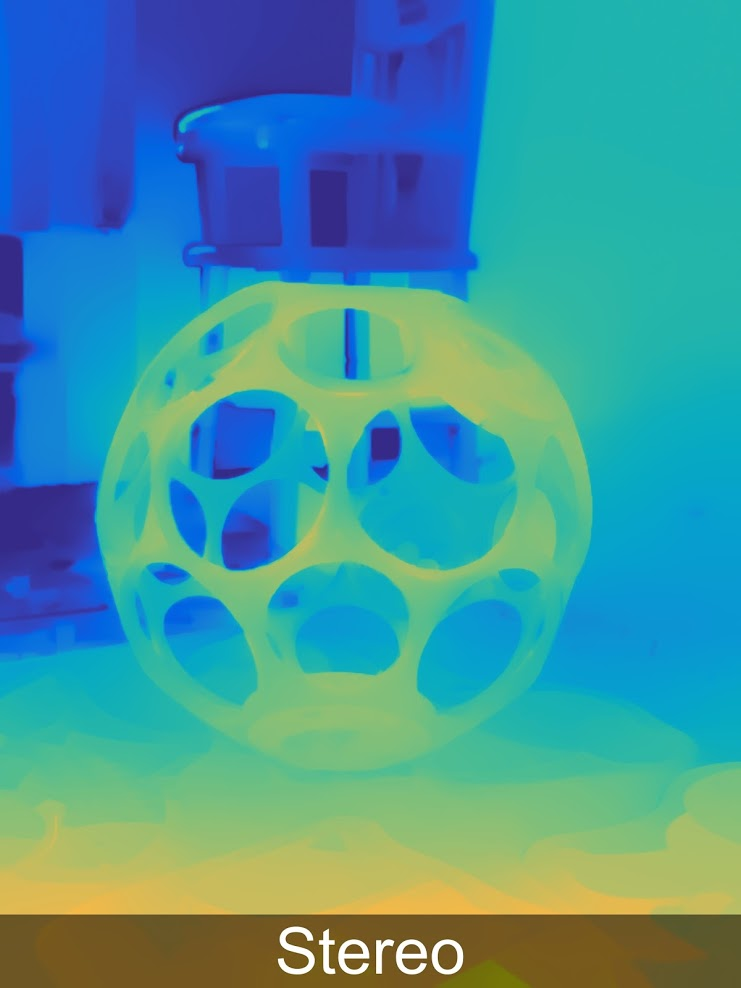

Método 3: Profundidade da câmera estéreo

A construção de um mapa de profundidade a partir de estéreo é bem conhecida e tem sido usada há

mais de 40 anos . Abaixo está um exemplo de uma câmera compacta por US $ 450, que pode ser usada para controlar gestos, além de fotografias profissionais ou capacetes VR:

Fonte

FonteA principal vantagem dessas câmeras é que a luz do sol não apenas as incomoda, mas vice-versa, melhora seus resultados e, como resultado, o uso ativo dessas câmeras para todos os tipos de caixas de rua, por exemplo, é um ótimo exemplo de como fotografar um modelo tridimensional de um antigo forte em alguns minutos:

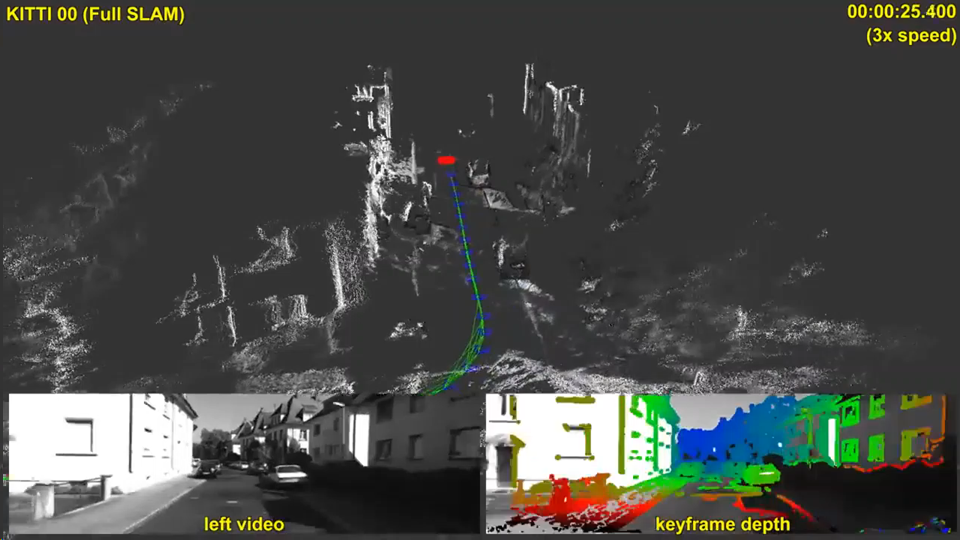

Um exemplo de uso na rua da câmera ZEDO dinheiro notável na tradução da construção da profundidade do estéreo para um novo nível foi influenciado, é claro, pelo tópico dos carros autônomos. Dos 5 métodos considerados para a construção de um vídeo de profundidade, apenas dois - este e o próximo (estéreo e plenóptico) não interferem no sol e não interferem nos carros vizinhos. Ao mesmo tempo, os plenópticos são muitas vezes mais caros e menos precisos em longas distâncias. Pode acontecer de qualquer maneira, é difícil fazer previsões, mas, neste caso, vale a pena concordar com Elon Musk - dos cinco métodos em estéreo, os melhores têm perspectivas. E os resultados atuais são muito encorajadores:

Fonte: SLAM direto em larga escala com câmeras estéreo

Fonte: SLAM direto em larga escala com câmeras estéreoMas é interessante que, ao que parece, não veículos não tripulados (dos quais existem poucos até agora), mas dispositivos muito mais massivos, onde um mapa de profundidade estéreo está sendo construído agora, terão uma influência ainda mais forte no desenvolvimento da construção de profundidade a partir de estéreo, a saber ... Isso mesmo! Smartphones!

Há três anos, simplesmente houve o boom dos smartphones "de dois olhos", nos quais praticamente todas as marcas foram observadas, porque a qualidade das fotos tiradas com uma câmera e a qualidade das fotos tiradas com duas diferiam drasticamente, mas do ponto de vista do aumento do preço de um smartphone, isso não era tão significativo:

Além disso, no ano passado, o processo foi ainda mais longe: “Você tem 2 câmeras no seu smartphone? Sucks! Eu tenho

três quatro !!! ”:

Fonte: Samsung Galaxy A8 e A9

Fonte: Samsung Galaxy A8 e A9O futuro de seis olhos da Sony foi mencionado na primeira parte. Em geral, os smartphones com vários olhos estão ganhando popularidade entre os fabricantes.

As causas fundamentais deste fenômeno são simples:

- A resolução dos telefones com câmera está aumentando e o tamanho da lente é pequeno. Como resultado, apesar dos inúmeros truques, o nível de ruído aumenta e a qualidade diminui, especialmente ao fotografar no escuro.

- Além disso, na segunda câmera, podemos remover o chamado filtro Bayer da matriz, ou seja, uma câmera será preto e branco e a segunda cor. Isso aumenta a sensibilidade em preto e branco em cerca de 3 vezes. I.e. a sensibilidade de 2 câmeras cresce condicionalmente, não 2, mas 4 vezes (!). Existem inúmeras nuances, mas esse aumento na sensibilidade é realmente claramente visível a olho nu.

- Entre outras coisas, quando um par estéreo aparece, temos a oportunidade de alterar programaticamente a profundidade de campo, ou seja, desfoque o fundo, do qual muitas fotos se beneficiam significativamente (escrevemos sobre isso no segundo semestre aqui ). Essa opção de novos modelos de smartphones rapidamente se tornou extremamente popular.

- Com um aumento no número de câmeras, também é possível usar outras lentes - maior angular (foco curto) e, inversamente, foco longo, o que pode melhorar significativamente a qualidade ao "aproximar" de objetos.

- Curiosamente, um aumento no número de câmeras nos aproxima do tema de um campo de luz rarefeito, que possui muitas de suas características e vantagens; no entanto, essa é uma história diferente.

- Também observamos que aumentar o número de câmeras permite aumentar a resolução por métodos de recuperação de resolução .

Em geral, existem tantas vantagens que, quando as pessoas estão cientes delas, começam a se perguntar por que pelo menos duas câmeras não foram configuradas por um longo tempo.

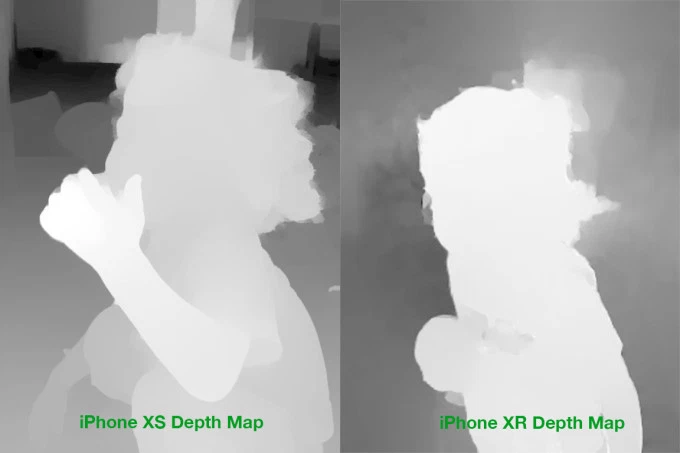

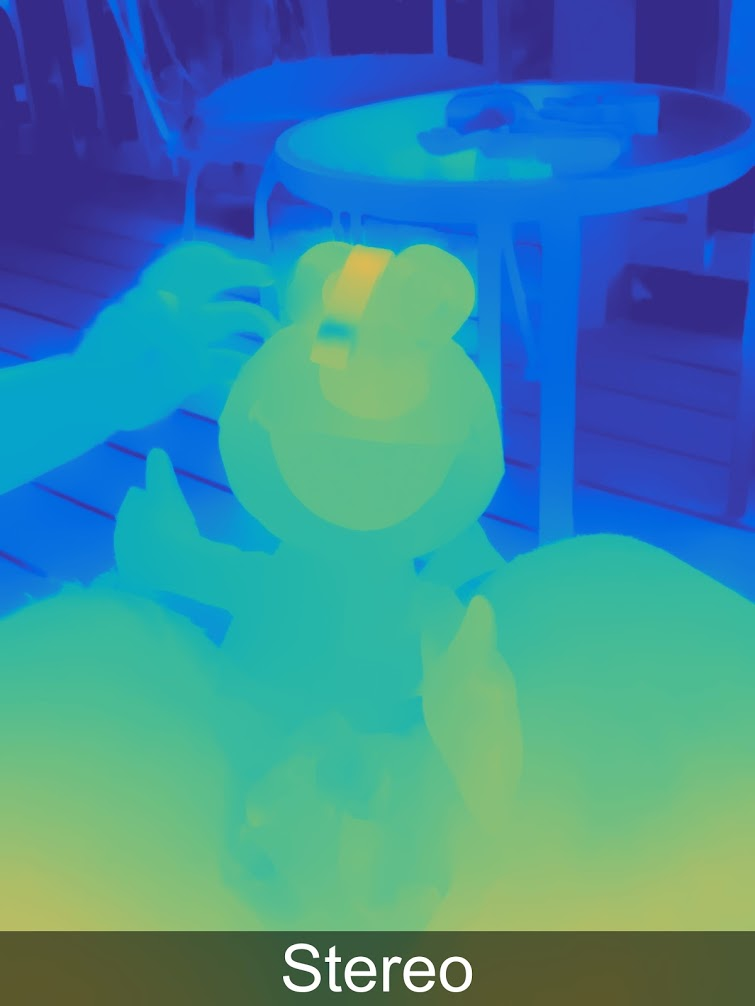

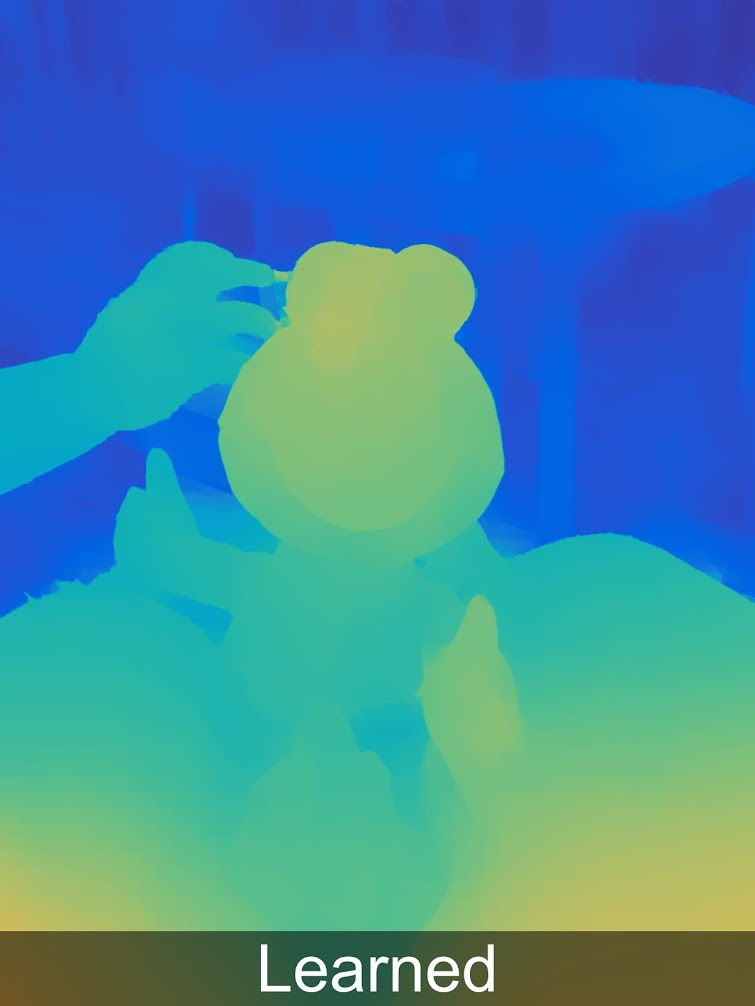

E então acontece que nem tudo é tão simples. Para usar significativamente câmeras adicionais para melhorar a imagem (e não apenas mudar para uma câmera com uma lente diferente), somos obrigados a construir um chamado mapa de disparidade, que é diretamente convertido em um mapa de profundidade. E essa é uma tarefa não trivial, para a qual a solução dos smartphones acabou de chegar. E mesmo agora, os mapas de profundidade são geralmente de qualidade bastante duvidosa. Ou seja, antes que a correspondência exata "pixel na imagem direita e pixel à esquerda" ainda precise sobreviver. Por exemplo, aqui estão exemplos reais de mapas de profundidade para o iPhone:

Fonte: Comparação do iPhone XS e XR Depth Map

Fonte: Comparação do iPhone XS e XR Depth MapMesmo a olho nu, os problemas de massa são claramente visíveis ao fundo, nas fronteiras, fico em silêncio sobre cabelos

translúcidos . Portanto, existem numerosos problemas que surgem ao transferir cores de uma câmera em preto e branco para outra colorida e durante o processamento posterior.

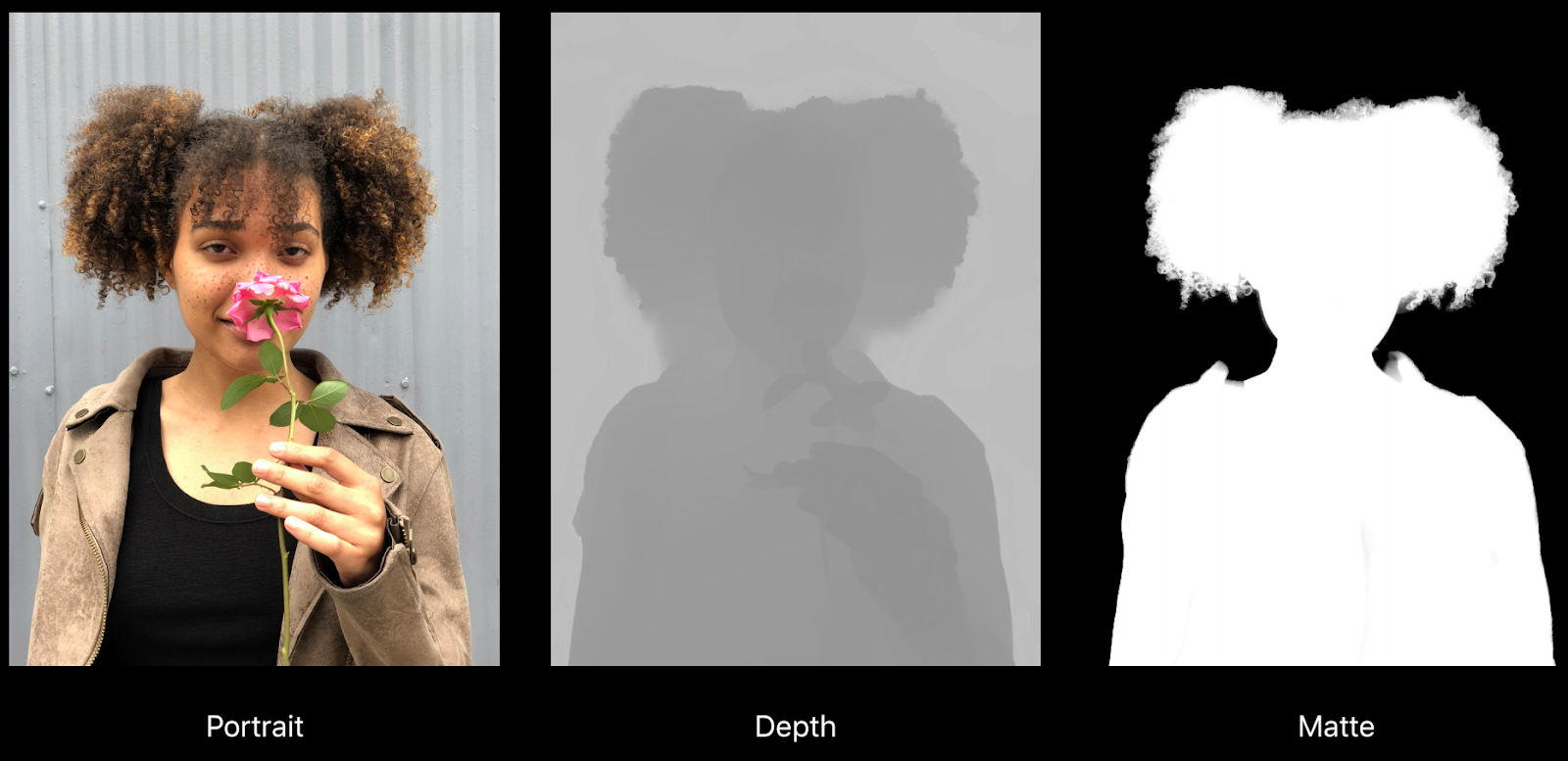

Por exemplo, aqui está um bom exemplo de um relatório sobre "Criação de efeitos de foto e vídeo usando profundidade" da Apple:

Fonte: Criando efeitos de foto e vídeo • Usando Depth, Apple, WWDC18

Fonte: Criando efeitos de foto e vídeo • Usando Depth, Apple, WWDC18Você pode ver claramente como a profundidade é de buggy sob o cabelo e, de fato, contra qualquer fundo mais ou menos uniforme, mas mais importante: no mapa de fosqueamento direito, o colar foi para o fundo (ou seja, ficará embaçado). Outro problema é a resolução real da profundidade e o mapa de fosqueamento é significativamente menor que a resolução da imagem, o que também afeta a qualidade durante o processamento:

No entanto, tudo isso é um problema de crescimento. Se há quatro anos atrás não havia dúvida de efeitos sérios no vídeo, o telefone simplesmente "não os puxava", mas hoje o processamento de vídeo com profundidade é mostrado a si mesmo nos principais telefones seriais (foi na mesma apresentação da Apple):

Fonte: Criando efeitos de foto e vídeo • Usando Depth, Apple, WWDC18

Fonte: Criando efeitos de foto e vídeo • Usando Depth, Apple, WWDC18Em geral, o tópico de telefones multi-multi-celulares e, como resultado, o tópico de obter profundidade do estéreo em telefones celulares - conquista as massas sem brigar:

Fonte: "encontrado nestes da sua internet"

Fonte: "encontrado nestes da sua internet"Principais conclusões:

- Profundidade estéreo - em termos de custo do equipamento - a maneira mais barata de obter profundidade, já que as câmeras agora são baratas e continuam a ficar mais baratas rapidamente. A dificuldade é que o processamento adicional consome muito mais recursos do que em outros métodos.

- Em telefones celulares, você não pode aumentar o diâmetro da lente, enquanto a resolução aumenta rapidamente. Como resultado, o uso de duas ou mais câmeras pode melhorar significativamente a qualidade da foto, reduzir o ruído em condições de pouca luz e aumentar a resolução. Como hoje em dia um telefone celular geralmente é escolhido pela qualidade da câmera, essa é uma vantagem extremamente tangível. Construir um mapa de profundidade é um bônus secundário imperceptível.

- As principais desvantagens da construção de profundidade a partir do estéreo:

- Assim que a textura desaparece ou simplesmente se torna menos contrastante, o ruído aumenta acentuadamente em profundidade, como resultado, mesmo em objetos simples, a profundidade geralmente é pouco usada (erros graves são possíveis).

- Além disso, a profundidade é pouco determinada em objetos finos e de tamanho pequeno (dedos "cortados" ou mesmo mãos, colunas afundadas etc.)

- Assim que o poder do ferro permitir que você construa um mapa de profundidade para vídeo, a profundidade dos smartphones dará um poderoso impulso ao desenvolvimento do AR (em algum momento, completamente inesperado para o público, a qualidade dos aplicativos de AR em todos os novos modelos de telefone, incluindo os orçados, subitamente se tornará visivelmente mais alta e uma nova onda ocorrerá) . Totalmente inesperado!

O próximo método é menos trivial e famoso, mas muito legal. Me encontre!

Método 4: Câmeras de profundidade de campo claro

O tópico dos plenópticos (do latim plenus - full e optikos - visual) ou campos de luz ainda é relativamente pouco conhecido pelas massas, embora os profissionais tenham começado a estudá-lo muito densamente. Seções separadas foram alocadas para artigos sobre Light Field em muitas conferências importantes (o autor já foi atingido pelo número de pesquisadores asiáticos na Conferência Internacional de Multimídia e Expo do IEEE, que estão intimamente envolvidos neste tópico).

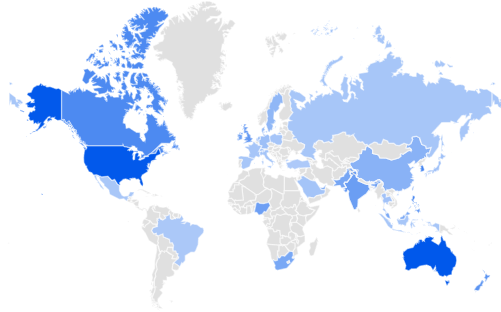

O Google Trends diz que os Estados Unidos e a Austrália lideram o interesse em Light Field, seguidos por Cingapura e Coréia. Grã-Bretanha A Rússia está em 32 lugar ... Corrigiremos o atraso da Índia e da África do Sul:

Fonte: Google Trends

Fonte: Google TrendsSeu humilde servo, há algum tempo, fez um

artigo detalhado sobre Habré com uma descrição detalhada de como ele funciona e o que dá, então vamos ver brevemente.

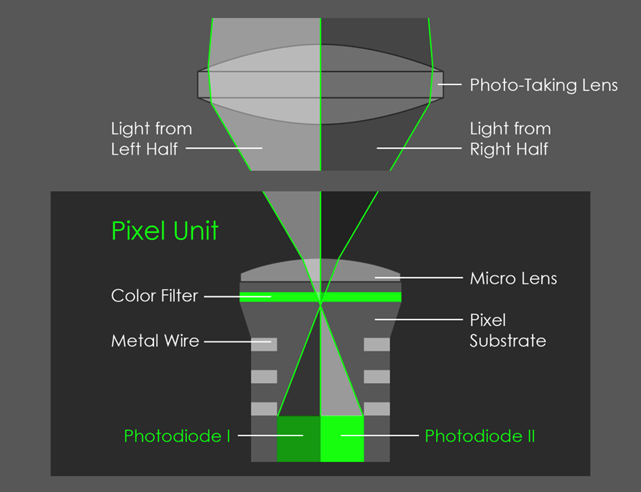

A idéia principal é tentar corrigir em cada ponto não apenas a luz, mas uma matriz bidimensional de raios de luz, tornando cada quadro quadridimensional. Na prática, isso é feito usando uma matriz de microlentes:

Fonte: plenoptic.inf® (recomendado para clicar e ver em resolução total)

Fonte: plenoptic.inf® (recomendado para clicar e ver em resolução total)Como resultado, temos

muitas novas oportunidades , mas a resolução está caindo seriamente. Tendo resolvido muitos problemas técnicos complicados, eles aumentaram radicalmente a resolução no

Lytro (comprada pelo Google), onde no Lytro Cinema a resolução do sensor da câmera foi aumentada para 755 megapixels de dados RAW e parecia volumosa como as primeiras câmeras:

Fonte: NAB: É revelada a nova câmera Lytro Light Field que poderia trazer grandes mudanças no trabalho de efeitos visuais

Fonte: NAB: É revelada a nova câmera Lytro Light Field que poderia trazer grandes mudanças no trabalho de efeitos visuaisÉ interessante que mesmo os profissionais regularmente avaliam incorretamente a queda de resolução das câmeras plenópticas, porque subestimam o quão bem podem trabalhar nos algoritmos de

super resolução que realmente restauram perfeitamente muitos detalhes das micro-mudanças de imagem no campo de luz (preste atenção a agulhas de tricô embaçadas e oscilações em segundo plano) :

Fonte: Restauração de quadro plenóptico ingênuo, inteligente e de super resolução do Relatório Técnico da Adobe “Superresolution with Plenoptic Camera 2.0”

Fonte: Restauração de quadro plenóptico ingênuo, inteligente e de super resolução do Relatório Técnico da Adobe “Superresolution with Plenoptic Camera 2.0”Tudo isso seria de interesse relativamente teórico se o Google não implementasse os plenópticos no Pixel 2

cobrindo com uma lente 2 pixels :

Fonte: AI Google Blog

Fonte: AI Google BlogComo resultado, formou-se um micro estereopar, que permitiu avaliar a profundidade com que o Google, fiel às novas tradições, adicionou redes neurais e, de maneira geral, observou-se:

Mais exemplos de profundidade em resolução total

em uma galeria especial .

Curiosamente, a profundidade é armazenada pelo Google (como Huawei e outros) na própria imagem, para que você possa extraí-la e ver:

Fonte: Três recursos secretos do novo aplicativo de câmera do Google que vão explodir sua mente

Fonte: Três recursos secretos do novo aplicativo de câmera do Google que vão explodir sua menteE então você pode transformar a foto em tridimensional:

Fonte: Três recursos secretos do novo aplicativo de câmera do Google que vão explodir sua mente

Fonte: Três recursos secretos do novo aplicativo de câmera do Google que vão explodir sua menteVocê pode experimentar isso de forma independente no site

http://depthy.me , onde você pode enviar sua foto. Curiosamente, o site

está disponível na fonte , ou seja, o processamento em profundidade pode ser aprimorado, há muitas oportunidades para isso, agora os algoritmos de processamento mais simples são aplicados lá.

Pontos-chave:

- Em uma das conferências do Google, foi anunciado que talvez quatro pixels seriam cobertos com uma lente. Isso reduzirá a resolução direta do sensor, mas melhorará drasticamente o mapa de profundidade. Em primeiro lugar, devido ao aparecimento de estereótipos em duas direções perpendiculares e, em segundo lugar, devido ao fato de que a base estéreo aumentará condicionalmente em 1,4 vezes (duas diagonais). Isso também significa uma melhoria acentuada na precisão da profundidade à distância.

- O próprio Plenoptics (também é uma fotografia calculada) permite:

- A mudança "honesta" do foco e da profundidade de campo após o disparo é a capacidade mais conhecida dos sensores plenópticos.

- Calcular a forma da abertura.

- Calcular a iluminação da cena.

- Mude um pouco o ponto de disparo, incluindo o recebimento de estéreo (ou quadro de vários ângulos) com uma lente.

- Calcule a resolução, porque usando a complexidade computacional pesada dos algoritmos de Super Resolução, você pode realmente restaurar o quadro.

- Calcular um mapa de transparência para bordas translúcidas.

- E, finalmente, construa um mapa de profundidade, que é importante hoje.

- Potencialmente, quando a câmera principal do telefone pode criar um mapa de profundidade de alta qualidade em tempo real, paralelamente ao disparo, isso cria uma revolução . Isso depende em grande parte do poder de computação a bordo (é isso que nos impede de fazer mapas de profundidade de resolução melhor e mais alta em tempo real hoje). Isso é mais interessante para o AR, é claro, mas haverá muitas oportunidades para alterar as fotos.

E, finalmente, passamos ao último neste método de revisão de medição de profundidade.

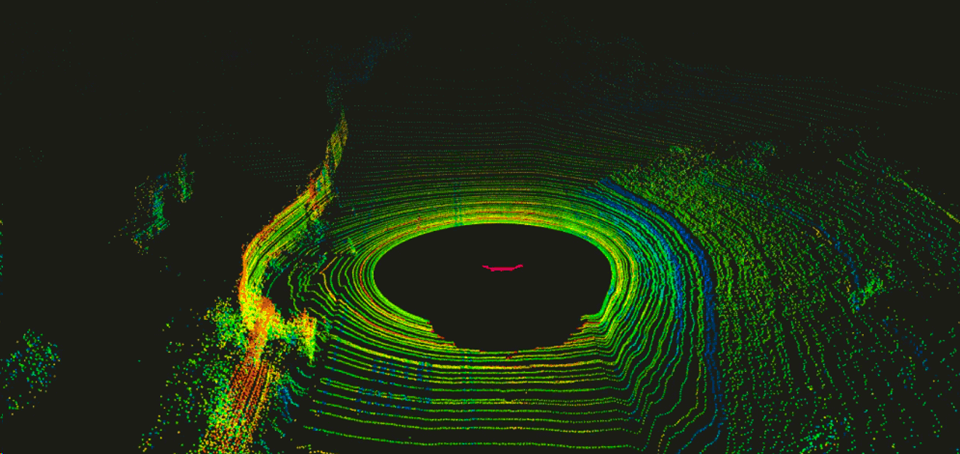

Método 5: câmeras em tecnologias lidar

Em geral, os

telémetros a laser estão firmemente entrincheirados em nossas vidas, são baratos e oferecem alta precisão. Os primeiros lidares (do LIDaR -

Light Identification Detection and Ranging ), construídos como feixes de dispositivos semelhantes girando em torno de um eixo horizontal, foram usados primeiro pelos militares e depois testados em pilotos automáticos de carros. Eles provaram ser muito bons lá, o que causou um poderoso aumento nos investimentos na região. Inicialmente, os lidares giravam, dando uma imagem semelhante várias vezes por segundo:

Fonte: Uma introdução ao LIDAR: o principal sensor autônomo do carro

Fonte: Uma introdução ao LIDAR: o principal sensor autônomo do carroEra desconfortável, pouco confiável devido às partes móveis e bastante caro.

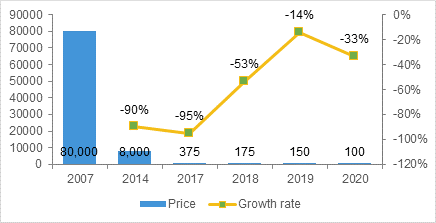

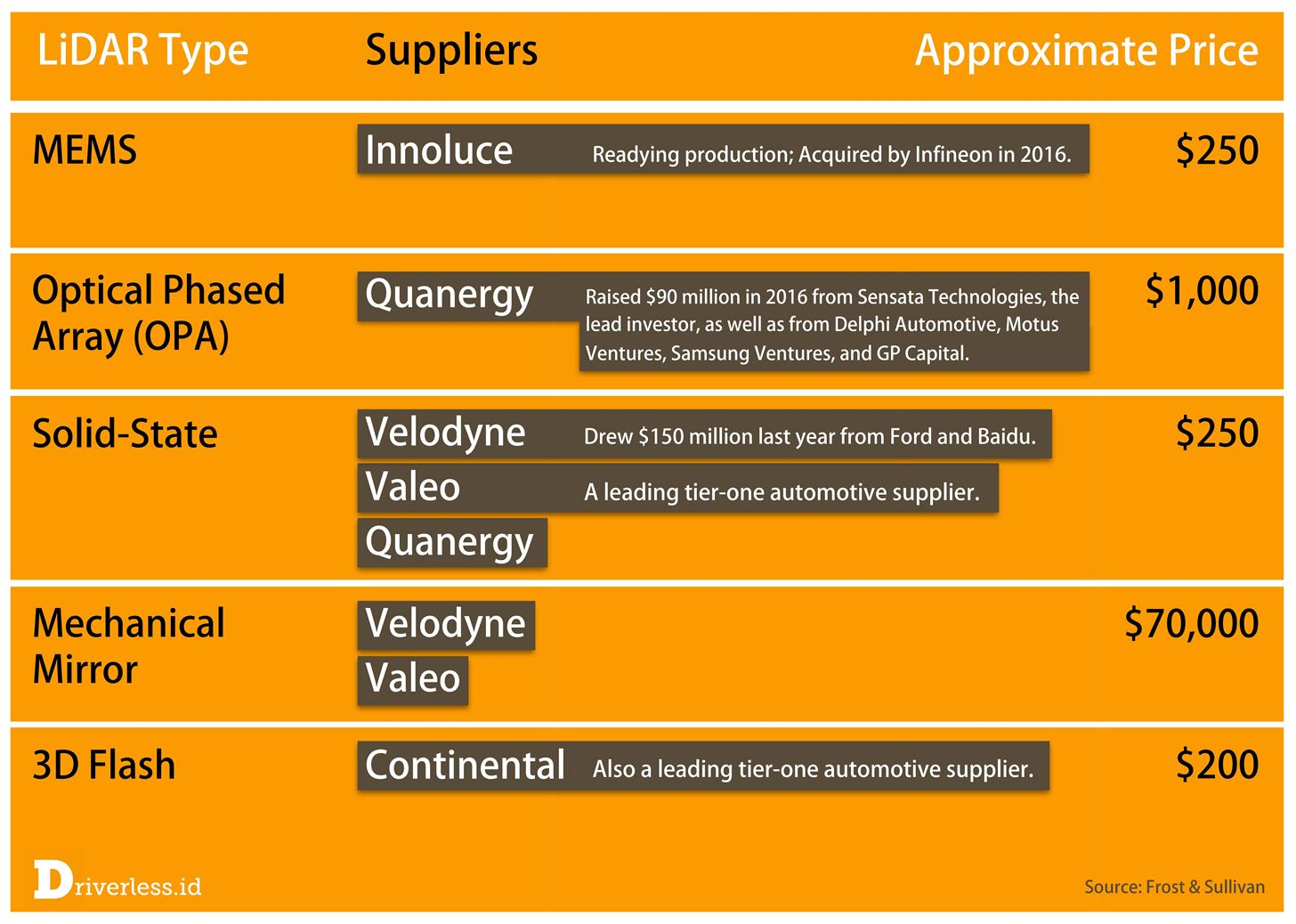

Tony Ceba em suas palestras fornece dados interessantes sobre a taxa de redução no custo dos lidares. Se os lidares custarem US $ 70 mil para as primeiras máquinas autônomas do Google (por exemplo, o

HDL-64E especializado usado nas primeiras máquinas custará 75 mil):

Fonte: Este e o próximo, do estacionamento aos parques - Bellevue e a interrupção do transporte

Fonte: Este e o próximo, do estacionamento aos parques - Bellevue e a interrupção do transporteEntão, na produção em massa, novos modelos das próximas gerações ameaçam reduzir significativamente o preço abaixo de US $ 1000:

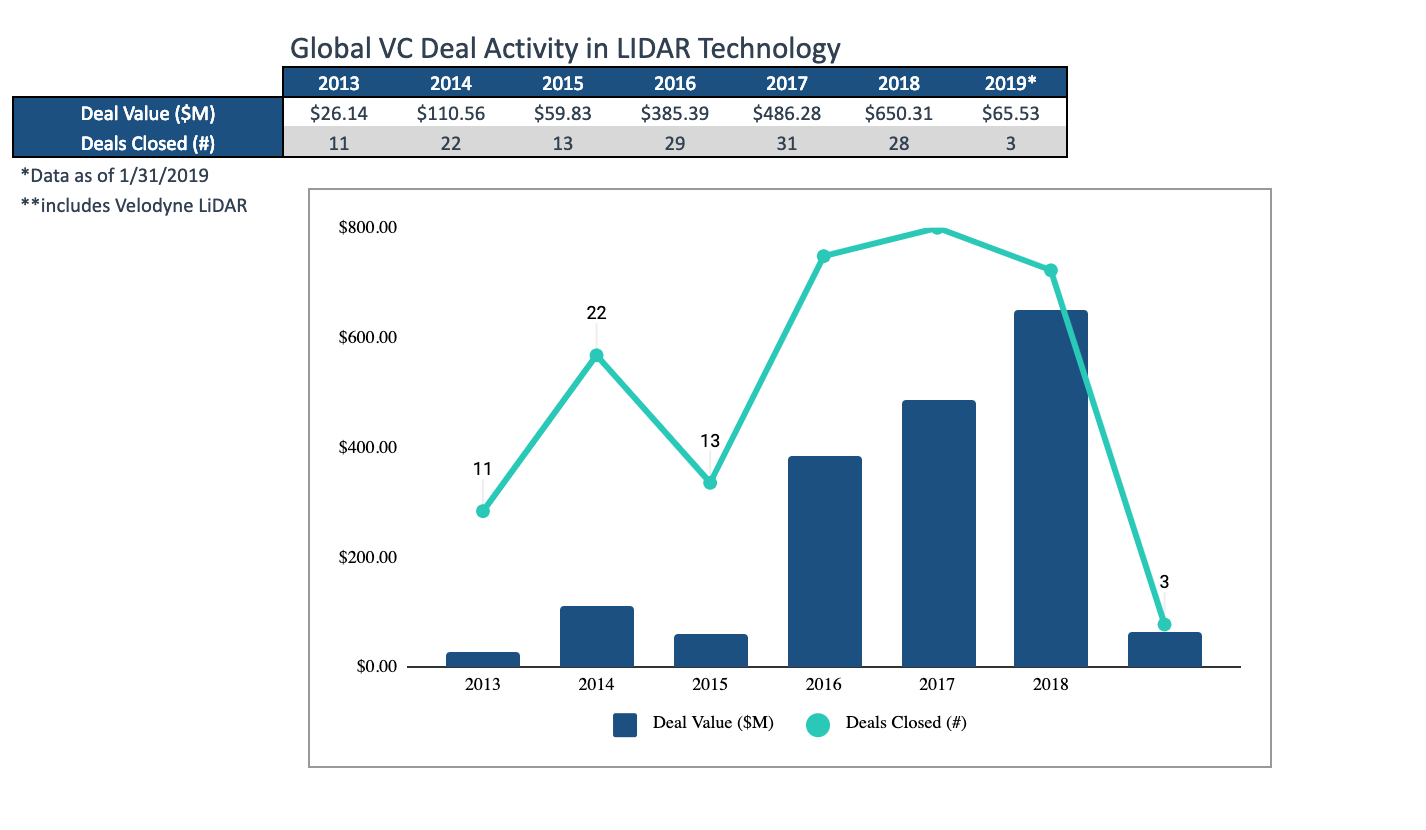

Pode-se argumentar sobre o exemplo de Tony (a promessa de uma startup não é o custo final), mas há um boom de pesquisas nessa área, o rápido aumento na produção, o surgimento de produtos completamente novos e uma queda geral nos preços são indiscutíveis. Um pouco mais tarde, em 2017, a previsão para uma queda nos preços era a seguinte (e chegará o momento da verdade quando eles serão massivamente colocados em carros):

Fonte: LiDAR conclui a detecção do triunvirato

Fonte: LiDAR conclui a detecção do triunviratoEm particular, há relativamente pouco tempo, vários fabricantes lançaram imediatamente o chamado

Solid State Lidar , que basicamente não possui partes móveis que mostrem uma confiabilidade radicalmente mais alta, especialmente ao agitar,

reduzir custos , etc. Eu recomendo assistir este vídeo, onde o dispositivo deles é explicado em 84 segundos muito claramente:

Fonte: Sensor Lidar de estado sólidoO que é importante para nós é que o Solid State Lidar fornece uma imagem retangular, ou seja, de fato, começa a funcionar como uma câmera de profundidade "normal":

Fonte: Innoviz prevê carros autônomos produzidos em massa com LiDAR de estado sólido

Fonte: Innoviz prevê carros autônomos produzidos em massa com LiDAR de estado sólidoO exemplo acima fornece um vídeo de aproximadamente 1024x256, 25 FPS, 12 bits por componente. Esses lidares serão montados sob a grade do capô (à medida que o dispositivo aquece bem):

Fonte: Estado sólido LiDAR Magna Electronics

Fonte: Estado sólido LiDAR Magna ElectronicsComo de costume, os chineses estão acesos, que agora estão em primeiro lugar no mundo na produção de veículos elétricos e que claramente buscam o primeiro lugar no mundo em carros autônomos:

Fonte: Alibaba, RoboSense lança veículo não tripulado usando LIDAR de estado sólido

Fonte: Alibaba, RoboSense lança veículo não tripulado usando LIDAR de estado sólidoEm particular, seus experimentos com um "pixel" não quadrado de profundidade são interessantes; se você faz um processamento conjunto com uma câmera RGB, pode aumentar a resolução e esse é um compromisso bastante interessante (a "quadratura" dos pixels é importante, de fato, apenas para uma pessoa):

Fonte: MEMS Lidar para veículos sem motorista dá outro grande passo

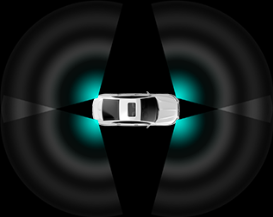

Fonte: MEMS Lidar para veículos sem motorista dá outro grande passoOs lidares são montados em esquemas diferentes, dependendo do custo do kit e da potência do sistema de bordo, que precisará processar todos esses dados. Consequentemente, as características gerais do piloto automático também mudam. Como resultado, carros mais caros terão mais facilidade em transportar estradas empoeiradas e mais fácil "esquivar" carros entrando em carros nos cruzamentos laterais, os mais baratos só ajudarão a reduzir o número de (numerosos) engarrafamentos estúpidos:

Fonte: Descrição RoboSense RS-LiDAR-M1

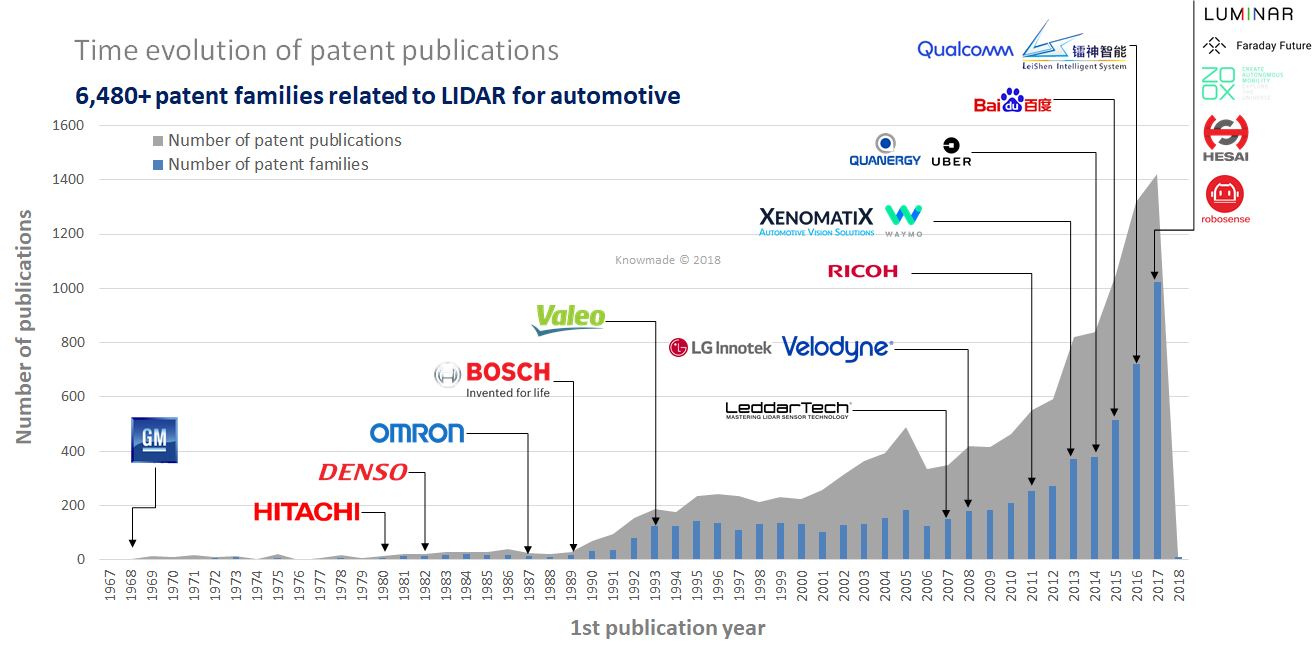

Fonte: Descrição RoboSense RS-LiDAR-M1Observe que, além dos preços baixos no estado sólido, prometem mais algumas áreas nas quais os lidares estão se desenvolvendo. Prever algo aqui é uma tarefa ingrata, pois muito dependerá não das possíveis características de engenharia da tecnologia, mas, por exemplo, das patentes. Como várias empresas já estão envolvidas no estado sólido, o tópico parece mais promissor. Mas não dizer nada sobre o resto seria injusto:

Fonte: Este gargalo de LiDAR 2017 está causando uma corrida do ouro nos dias modernos

Fonte: Este gargalo de LiDAR 2017 está causando uma corrida do ouro nos dias modernosSe falarmos de lidares como câmeras, vale a pena mencionar outro recurso importante que é significativo ao usar lidares de estado sólido. Por sua natureza, eles funcionam como câmeras com um

obturador em movimento já esquecido, que introduz distorções visíveis ao fotografar objetos em movimento:

Fonte: Qual é a diferença entre uma persiana global (global) e uma persiana ?

Fonte: Qual é a diferença entre uma persiana global (global) e uma persiana ?Considerando que tudo muda rapidamente na estrada, especialmente na auto-estrada a uma velocidade de 150 km / h, esse recurso de lidares distorce muito os objetos, incluindo aqueles que voam rapidamente em nossa direção ... Incluindo em profundidade ... Observe que os dois métodos anteriores obter profundidade não é um problema.

Fonte: Animação agradável da Wikipedia mostrando distorção do carroEsse recurso, associado a um baixo FPS, requer a adaptação de algoritmos de processamento, mas, em qualquer caso, devido à sua alta precisão, inclusive a longas distâncias, os lidares não têm concorrentes em particular.Curiosamente, por sua natureza, os lidares funcionam muito bem em áreas pares e piores nas bordas, e os sensores estéreo são ruins em áreas pares e relativamente bons nas bordas. Além disso, os lidares fornecem um FPS relativamente pequeno e as câmeras são muito maiores. Como resultado, eles se complementam, o que também foi usado nas câmeras Lytro Cinema (na foto perto da câmera há uma lente plenóptica iluminada com 300 FPS e o quadrado preto de

Fonte: Animação agradável da Wikipedia mostrando distorção do carroEsse recurso, associado a um baixo FPS, requer a adaptação de algoritmos de processamento, mas, em qualquer caso, devido à sua alta precisão, inclusive a longas distâncias, os lidares não têm concorrentes em particular.Curiosamente, por sua natureza, os lidares funcionam muito bem em áreas pares e piores nas bordas, e os sensores estéreo são ruins em áreas pares e relativamente bons nas bordas. Além disso, os lidares fornecem um FPS relativamente pequeno e as câmeras são muito maiores. Como resultado, eles se complementam, o que também foi usado nas câmeras Lytro Cinema (na foto perto da câmera há uma lente plenóptica iluminada com 300 FPS e o quadrado preto de Malevich Lidar abaixo ): Fonte: Lytro pronta para mudar para sempre o cinema : estréia protótipo de cinema e curta-metragem na NAB

Fonte: Lytro pronta para mudar para sempre o cinema : estréia protótipo de cinema e curta-metragem na NAB, ( ) , .

- — , 1.5 (

10 6 , ):

: Techcrunch

: Techcrunch— 1.5-2 , . .

:

- :

- :

- ,

- ,

- o obturador em funcionamento e a necessidade de compensá-lo durante o processamento,

- lidares próximos interferem entre si, o que não é tão fácil de compensar.

- No entanto, estamos observando como, literalmente, em 2 anos, surgiu essencialmente um novo tipo de câmeras de profundidade com excelentes perspectivas e um enorme mercado potencial. Nos próximos anos, podemos esperar uma redução séria nos preços, incluindo o surgimento de pequenos lidares universais para robôs industriais.

Processamento de vídeo com profundidade

Em poucas palavras, considere por que a profundidade não é tão fácil de manusear.

Abaixo está um exemplo de dados brutos em profundidade de uma linha muito boa de

câmeras Intel RealSense . Nos dedos deste vídeo, você pode avaliar facilmente "a olho nu" a operação da câmera e os algoritmos de processamento:

Fonte: doravante - os materiais do autor

Fonte: doravante - os materiais do autorProblemas típicos de câmeras de profundidade são claramente visíveis:

- Os dados são instáveis em valor, os pixels “ruídos” em profundidade.

- Ao longo dos limites de uma largura bastante grande, os dados também são muito barulhentos (por essa mesma razão, os valores de profundidade ao longo das bordas geralmente mascaram para não interferir no trabalho).

- Ao redor da cabeça, você pode ver muitos pixels “andando” (aparentemente, a proximidade da parede na parte traseira + do cabelo começa a influenciar).

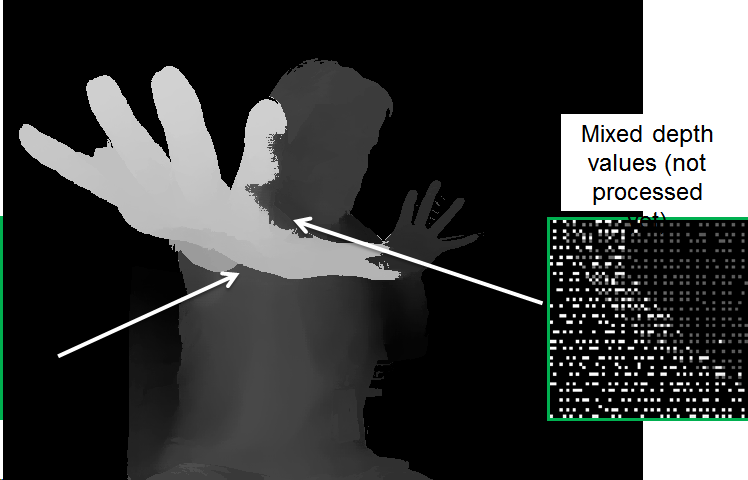

Mas isso não é tudo. Se olharmos para os dados mais de perto, fica claro que em alguns lugares os dados mais profundos “brilha” nos mais próximos:

Isso ocorre porque, para a conveniência do processamento, a imagem é reduzida à imagem da câmera RGB e, como os limites não são determinados com precisão, torna-se necessário processar especialmente essas "sobreposições"; caso contrário, surgem problemas, como "buracos" em profundidade no braço:

Ao processar, há muitos problemas, por exemplo:

- "Vazamento" de profundidade de um objeto para outro.

- Instabilidade de profundidade ao longo do tempo.

- Alias (a formação de uma "escada"), quando a supressão do ruído em profundidade leva à discretização dos valores de profundidade:

No entanto, é claro que a imagem melhorou bastante. Observe que algoritmos mais lentos ainda podem melhorar significativamente a qualidade.

Em geral, o

processamento de vídeo em profundidade é um tópico enorme e separado, que até agora não está envolvido em tantas pessoas, mas que está rapidamente ganhando popularidade. O mercado anterior, que ela mudou completamente - é a conversão de filmes de 2D para 3D. O resultado da construção manual do estéreo a partir de vídeo 2D melhorou tão rapidamente, mostrou um resultado muito mais previsível, causou menos dor de cabeça e menor custo que no cinema 3D, após quase 100 anos de gravação (!), Eles rapidamente pararam de fotografar quase completamente e só começaram a converter . Havia até uma especialidade separada - o

artista de profundidade , e os

estereógrafos da velha escola estavam em choque ("ka-ak-a-ak?"). E o papel principal dessa revolução foi desempenhado pelo rápido aprimoramento dos algoritmos de processamento de vídeo. Talvez algum dia encontrarei tempo para escrever sobre isso uma série separada de artigos, porque meu material é em grandes quantidades.

Aproximadamente o mesmo pode ser esperado em um futuro próximo para câmeras de profundidade de robôs, smartphones e carros autônomos.

Acorde! A revolução está chegando!Em vez de uma conclusão

Há alguns anos, seu humilde servidor trouxe uma comparação de diferentes abordagens para obter vídeos com profundidade em um único prato. Em geral, durante esse período, a situação não mudou. A separação aqui é bastante arbitrária, pois os fabricantes estão bem cientes das desvantagens das tecnologias e tentam compensá-las (às vezes com muito sucesso). No entanto, em geral, ele pode ser usado para comparar diferentes abordagens:

Fonte: materiais do autor

Fonte: materiais do autorVamos passar por cima da mesa:

- Por resolução, a profundidade do estéreo está na liderança, mas tudo depende muito da cena (se for monofônico, a coisa é um cano).

- Em termos de precisão , os lidares estão além da concorrência, a situação com os plenópticos é a pior, a propósito.

- Pela complexidade do processamento - apenas o ToF e os lidares obtêm a “profundidade” diretamente, a obtenção de profundidade do estéreo e dos plenópticos requer muitos cálculos não triviais.

- De acordo com o FPS, as câmeras ToF são estruturalmente boas e, em um futuro próximo, quando o ferro for puxado, elas serão capturadas com câmeras estéreo (capazes de fornecer até 300 fps). Até agora, Lidaram apenas sonha.

- De acordo com os resultados em condições de pouca luz, espera-se que o aparelho de som e os plenópticos percam.

- Ao trabalhar ao ar livre - o ToF e as câmeras de luz estruturada não funcionam bem.

Ao mesmo tempo, é importante entender bem a situação em mercados específicos. Por exemplo, a abordagem plenóptica parece claramente atrasada. No entanto, se for o melhor para o AR (e isso ficará claro nos próximos 3-4 anos), ele ocupará seu devido lugar em

todos os telefones e tablets. Observa-se também que os lidares de estado sólido têm a melhor aparência (os mais "verdes"), mas essa é a tecnologia mais nova e esses são os seus próprios riscos, principalmente os de patente (no campo, existem muitas patentes novas que não expirarão em breve):

Fonte: LiDAR: Uma Visão Geral do Cenário das Patentes

Fonte: LiDAR: Uma Visão Geral do Cenário das PatentesNo entanto, não esquecemos - o mercado de sensores de profundidade para smartphones está planejado em

US $ 6 bilhões no próximo ano

, e não pode ser inferior a 4, já que no ano passado foi de mais de 3 bilhões. É uma quantia enorme de dinheiro que não somente irá para o retorno do investimento (para os investidores mais bem-sucedidos), mas também para desenvolver novas gerações de sensores. Ainda não há um crescimento semelhante nos lidares, mas, de acordo com todas as indicações, ele irá literalmente nos próximos 3 anos. E então este é um processo exponencial comum de avalanche, que já aconteceu mais de uma vez.

O futuro próximo das câmeras de profundidade parece extremamente interessante!

Cartago deve estar quebrado ... O vídeo inteiro será tridimensional até o final do século!Fique atento!

Quem não leu - a

primeira parte do texto !

AgradecimentosGostaria de agradecer cordialmente:

- Laboratório de Computação Gráfica VMK Moscow State University MV Lomonosov por sua contribuição ao desenvolvimento de computação gráfica na Rússia e não apenas

- Google, Apple e Intel para ótimas soluções compactas e todos os fabricantes de lidar para um progresso rápido,

- pessoalmente Konstantin Kozhemyakov, que fez muito para tornar este artigo melhor e mais visual,

- e, finalmente, muito obrigado a Roman Kazantsev, Eugene Lyapustin e Yegor Sklyarov por um grande número de comentários e correções sensatas que tornaram esse texto muito melhor!