Um dos principais eventos no campo da linguística de computador e do aprendizado de máquina em 2018 foi o

lançamento do BERT do Google AI, que foi reconhecido como o melhor relatório do ano, de acordo com a filial norte-americana da Association of Computer Linguistics (NACL). Neste artigo, falaremos sobre esse modelo de linguagem e seus recursos.

Para quem nunca ouviu falar antes, o BERT é uma rede neural baseada no método de preparação preliminar de representações contextuais de palavras, ou seja, utiliza um modelo de linguagem bidirecional e também permite analisar sentenças inteiras. Nesse caso, as palavras que vêm depois do dado e do passado também são levadas em consideração. Esse método permite obter resultados com uma ampla margem de estado da arte em uma ampla variedade de tarefas de processamento de linguagem natural (PNL), mas requer grande poder de computação.

Do discurso formal ao diálogo

O BERT foi originalmente ensinado em 104 idiomas da Wikipedia (multilíngue). Além da versão multilíngue, o Google lançou o BERT com base na Wikipedia em inglês e o BERT em chinês.

No laboratório de sistemas neurais e de aprendizado profundo, usamos o BERT para melhorar os componentes da PNL do DeepPavlov, uma biblioteca interativa de código aberto para o desenvolvimento de um assistente interativo virtual e análise de texto com base no TensorFlow e Keras. Treinamos o modelo BERT na Wikipedia russa - RuBERT, melhorando significativamente a qualidade dos modelos russos. Além disso, eles integraram o BERT em soluções para três tarefas populares da PNL: classificação de texto, marcação de sequência e respostas a perguntas. Você pode ler mais sobre os modelos BERT do DeepPavlov nas últimas publicações do nosso blog:

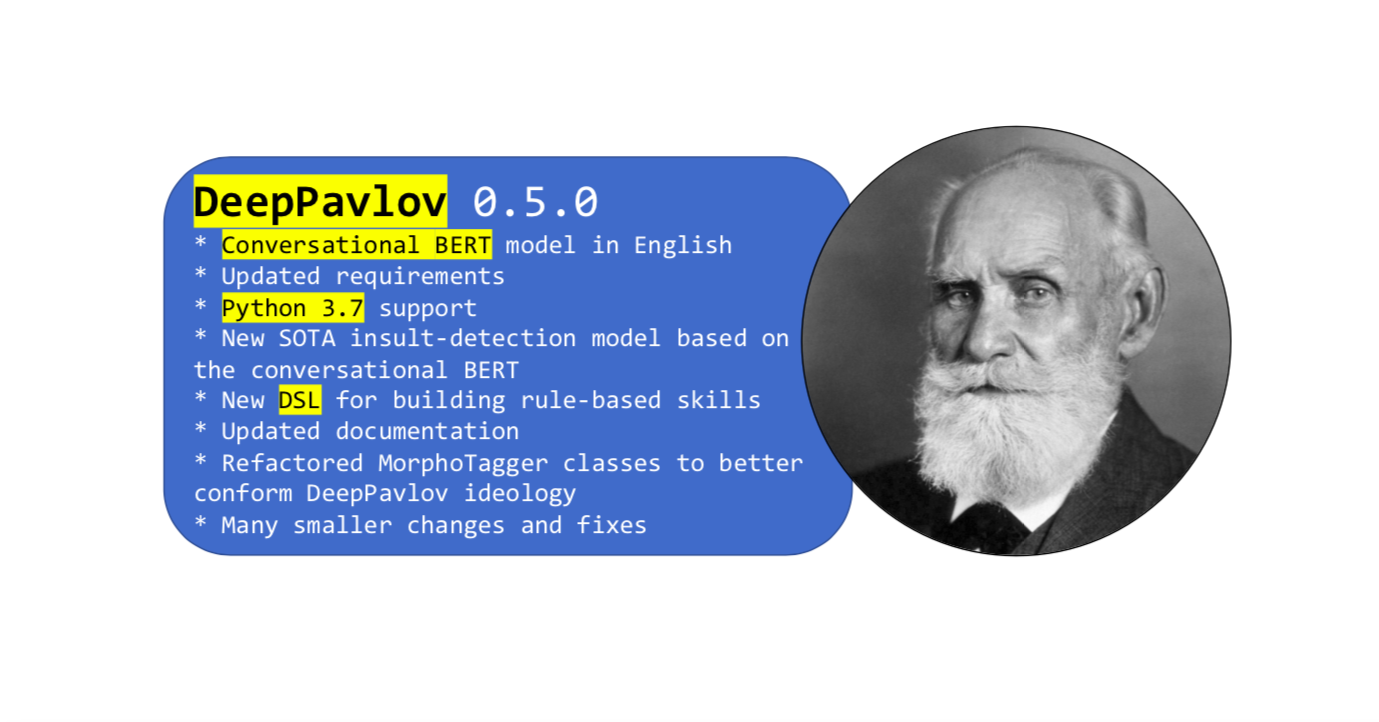

Mais recentemente, uma nova versão da biblioteca

O principal recurso desta atualização foi o BERT, treinado no vocabulário das redes sociais em inglês. A linguagem formal da Wikipedia é diferente da fala coloquial comum, enquanto que para resolver alguns problemas, você só precisa ter um.

O BERT conversacional foi treinado em inglês usando dados abertos do Twitter, Reddit, DailyDialogues, OpenSubtitles, debates, blogs e comentários nas notícias do Facebook. Esses dados foram usados para construir o vocabulário dos sub-símbolos em inglês na versão em inglês do BERT como uma inicialização do BERT falado em inglês. Como resultado, o BERT falado mostrou resultados de ponta em tarefas que apresentavam dados sociais.

Como usar o BERT de conversação no DeepPavlov

Você pode usar o novo modelo de

detecção de insultos baseado no BERT falado em inglês. Ou qualquer outro modelo baseado em BERT, usando um

guia simples da documentação.

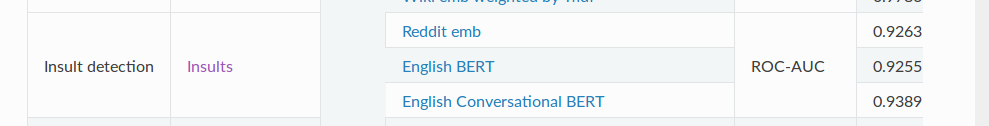

O modelo de

detecção SOTA

Insult contém uma tarefa de classificação binária para detectar abusos. Para a métrica ROC-AUC (medição de desempenho para a tarefa de classificação em várias configurações de limite), este modelo mostra um valor de 93,89 nos dados em comparação com o BERT usual - 92,55.

E finalmente

Então, isso é quase tudo o que queremos contar sobre nosso BERT de conversação. E não esqueça que o DeepPavlov tem um

fórum - faça suas perguntas sobre a biblioteca e os modelos. Estar no negócio!