Separamos as cartas antigas e encontramos um artigo que Ilya Segalovich iseg escreveu para a revista Internet World em 2002. Nele, ele compara a Internet e os mecanismos de busca com as maravilhas do mundo, reflete sobre as tecnologias de busca e relembra sua história. Apesar da carga de trabalho, Ilya escreveu um artigo em tempo recorde e até forneceu um glossário de termos suficientemente detalhado, o que é especialmente interessante de se ler hoje. Não conseguimos encontrar uma versão eletrônica da revista com o artigo, então hoje a publicamos em nosso blog, cujo primeiro autor, aliás, foi Ilya.

Centenas de

mecanismos de

pesquisa foram escritos no mundo e, se você contar as funções de pesquisa implementadas em vários programas, precisará acompanhar milhares. E não importa como o processo de pesquisa seja implementado, não importa em que modelo matemático ele se baseie, as idéias e programas que implementam a pesquisa são bastante simples. Embora essa simplicidade, aparentemente, pertença à categoria da qual eles dizem "simples, mas funciona". De um jeito ou de outro, mas foram os mecanismos de busca que se tornaram uma das duas novas maravilhas do mundo, dando ao Homo Sapiens acesso ilimitado e instantâneo às informações. O primeiro milagre, obviamente, pode ser considerado a Internet como tal, com suas capacidades de comunicação universal.

Mecanismos de pesquisa históricos

Existe uma crença generalizada de que cada nova geração de programas é mais perfeita que a anterior. Digamos, antes que tudo fosse imperfeito, mas agora

a inteligência quase

artificial reina em toda parte. Outro ponto de vista extremo é que "tudo o que é novo é bem esquecido e velho". Penso que, no que diz respeito aos motores de busca, a verdade está algures no meio.

Mas o que realmente mudou nos últimos anos? Nem algoritmos ou estruturas de dados, nem modelos matemáticos. Embora eles também. O paradigma do uso de sistemas mudou. Simplificando, uma dona de casa, procurando um ferro mais barato, e um graduado em um colégio interno na esperança de encontrar um emprego como mecânico de automóveis, foi fisgado na tela com a linha de pesquisa. Além da aparência de um fator impossível na era pré-Internet - um fator da demanda total por mecanismos de busca - mais algumas mudanças se tornaram aparentes. Em primeiro lugar, ficou claro que as pessoas não apenas “pensam com palavras”, mas também “buscam palavras”. Na resposta do sistema, eles esperam ver a palavra digitada na string de consulta. E a segunda: é difícil “treinar novamente um buscador” para “treinar novamente para procurar”, assim como é difícil treinar novamente para falar ou escrever. Os sonhos dos anos 60 e 80 sobre o refinamento iterativo das consultas, sobre a compreensão da linguagem natural, sobre a busca por significado, sobre a geração de uma resposta coerente a uma pergunta dificilmente podem resistir ao teste cruel da realidade agora.

Algoritmo + Estrutura de dados = Mecanismo de pesquisa

Como qualquer programa, o mecanismo de pesquisa opera com estruturas de dados e executa um algoritmo. A variedade de algoritmos não é muito grande, mas é. Além dos computadores quânticos, que prometem uma inovação mágica na "complexidade algorítmica" da pesquisa e sobre a qual o autor quase nada sabe, existem quatro classes de algoritmos de pesquisa. Três em cada quatro algoritmos requerem "indexação", processamento preliminar de documentos, o que cria um arquivo auxiliar, ou seja, o "índice", projetado para simplificar e acelerar a pesquisa em si. Estes são algoritmos de

arquivos invertidos, árvores de sufixos, assinaturas . Em um caso degenerado, não há etapa preliminar de indexação e a pesquisa é executada pela exibição seqüencial de documentos. Essa pesquisa é chamada

direta .

Pesquisa direta

Sua versão mais simples é familiar para muitos, e não há programador que não escreveria esse código pelo menos uma vez na vida:

Apesar de sua aparente simplicidade, a pesquisa direta vem se desenvolvendo intensamente nos últimos 30 anos. Um número considerável de idéias foi apresentado, reduzindo o tempo de pesquisa às vezes. Esses algoritmos são descritos em detalhes em uma variedade de literatura, existem seus resumos e comparações. Boas revisões dos métodos de pesquisa direta podem ser encontradas em livros didáticos como

Sedgwick ou

Cormen . Deve-se ter em mente que novos algoritmos e suas opções aprimoradas aparecem constantemente.

Embora olhar para todos os textos diretamente seja uma tarefa bastante lenta, você não deve pensar que algoritmos de pesquisa direta não são usados na Internet. O mecanismo de busca norueguês Fast (www.fastsearch.com) usou um

chip que implementa a lógica de pesquisa direta de expressões regulares simplificadas e colocou 256 desses chips em uma placa. Isso permitiu à Fast atender a um número bastante grande de solicitações por unidade de tempo.

Além disso, existem muitos programas que combinam a pesquisa de índice para encontrar um bloco de texto com uma pesquisa direta adicional dentro do bloco. Por exemplo, o

vislumbre é muito popular, inclusive no Runet.

Em geral, algoritmos diretos têm características distintivas em que todos ganham. Por exemplo, possibilidades ilimitadas para pesquisa aproximada e difusa. De fato, qualquer indexação está sempre associada à simplificação e normalização de termos e, conseqüentemente, à perda de informações. A pesquisa direta funciona diretamente nos documentos originais sem distorção.

Arquivo invertido

Essa estrutura simples de dados, apesar de seu nome estrangeiro misterioso, é intuitivamente familiar para qualquer pessoa alfabetizada e qualquer programador de banco de dados que nem sequer tenha lidado com a pesquisa de texto completo. A primeira categoria de pessoas sabe o que é, de acordo com as "concordâncias" - listas exaustivas ordenadas alfabeticamente de palavras de um texto ou pertencentes a um autor (por exemplo, "Concordância com versos de A. S. Pushkin", "Dicionário-concordância de jornalismo de F. M. Dostoevsky" ) Os últimos lidam com um formulário ou outro da lista invertida sempre que criam ou usam o "índice de banco de dados por campo-chave".

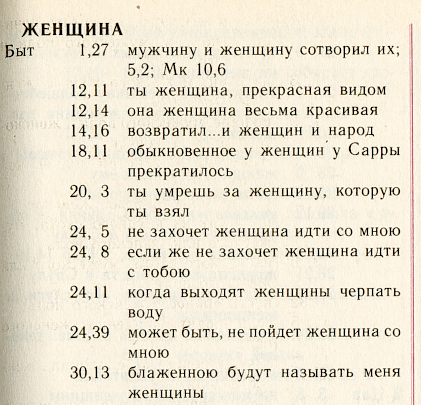

Ilustraremos essa estrutura com a ajuda da maravilhosa concordância russa -

"Symphony" , emitida pelo Patriarcado de Moscou no texto da tradução sinodal da Bíblia.

Esta é uma lista alfabética de palavras. Para cada palavra, todas as “posições” nas quais essa palavra ocorre são listadas. O algoritmo de busca consiste em encontrar a palavra certa e carregar na memória uma lista já expandida de posições.

Para economizar espaço em disco e acelerar a pesquisa, geralmente use dois truques. Em primeiro lugar, você pode economizar nos detalhes da própria posição. De fato, quanto mais detalhada for essa posição, por exemplo, no caso de "Symphony", é "livro + capítulo + verso", mais espaço será necessário para armazenar o arquivo invertido.

Na versão mais detalhada, no arquivo invertido, você pode armazenar o número da palavra e o deslocamento em bytes desde o início do texto, a cor e o tamanho da fonte e muito mais. Mais frequentemente, eles simplesmente indicam apenas o número do documento, digamos, um livro da Bíblia e o número de usos dessa palavra nele. É uma estrutura tão simplificada que é considerada fundamental na teoria clássica de recuperação de informação - Recuperação de Informação (RI).

O segundo (não relacionado ao primeiro) método de compactação: organizar as posições para cada palavra em ordem crescente de endereços e para cada posição armazenar não o endereço completo, mas a diferença do anterior. Aqui está a aparência dessa lista para nossa página, supondo que lembremos da posição até o número do capítulo:

: [.1],[+11],[0],[+2],[+4],[+2],[+4],..Além disso, algum método simples de empacotamento é imposto ao método da diferença de armazenamento de endereços: por que alocar um número "enorme" fixo de bytes para um número inteiro pequeno, porque você pode alocar quase tantos bytes quanto ele merece. Aqui é apropriado mencionar os códigos de Golomb ou a função interna da popular linguagem Perl:

pack(“w”) .

Na literatura, há também uma artilharia mais pesada de algoritmos de empacotamento da maior variedade: aritmética, Huffman, LZW, etc. O progresso nessa área é contínuo. Na prática, eles raramente são usados nos mecanismos de busca: o ganho é pequeno e a energia do processador é gasta ineficientemente.

Como resultado de todos os truques descritos, o tamanho do arquivo invertido, em regra, é de 7 a 30% do tamanho do texto de origem, dependendo dos detalhes do endereço.

Listado no Red Book

Propostas repetidas que não sejam algoritmos de pesquisa direta e invertida e estruturas de dados. Antes de tudo, são árvores com sufixo (veja livros de

Manber e

Gonnet ), além de

assinaturas .

O primeiro deles funcionava na Internet, sendo um algoritmo patenteado do sistema de busca

OpenText . Encontrei índices de sufixo nos mecanismos de pesquisa domésticos.

O segundo - o método de assinatura - é uma conversão de documento para bloquear tabelas dos

valores de hash de suas palavras - a "assinatura" e a visualização seqüencial das "assinaturas" durante a pesquisa.

Nenhum dos métodos foi amplamente adotado e, portanto, não merecia uma discussão detalhada neste breve artigo.

Modelos matemáticos

Cerca de 3 em 5 mecanismos e módulos de pesquisa operam sem nenhum modelo matemático. Mais precisamente, seus desenvolvedores não se propõem a implementar um modelo abstrato e / ou desconhecem sua existência. O princípio aqui é simples: se apenas o programa encontrar alguma coisa. De qualquer forma. E então o usuário descobrirá.

No entanto, assim que se trata de melhorar a qualidade da pesquisa, sobre uma grande quantidade de informações, sobre o fluxo de consultas do usuário, além de coeficientes empiricamente afixados, é útil operar com algum tipo de aparato teórico simples.

O modelo de busca é uma certa simplificação da realidade, com base na qual é obtida uma fórmula (que não é mais necessária por ninguém), que permite ao programa tomar uma decisão: qual documento é considerado encontrado e como classificá-lo. Após a adoção do modelo, os coeficientes geralmente adquirem significado físico e se tornam mais compreensíveis para o próprio desenvolvedor, e a escolha deles se torna mais interessante.

Toda a variedade de modelos de recuperação tradicional de informações (RI) é geralmente dividida em três tipos: teoria dos conjuntos (booleano, conjuntos nebulosos, booleano estendido),

algébrica (vetor, vetor generalizado, rede latente-semântica, rede neural) e probabilística.

A família de modelos booleanos, de fato, é a primeira que vem à mente de um programador que implementa a pesquisa de texto completo. Existe uma palavra - um documento é considerado encontrado, não - não encontrado. Na verdade, o modelo booleano clássico é uma ponte que liga a teoria da recuperação de informações à teoria da pesquisa e manipulação de dados.

As críticas ao modelo booleano, bastante justas, consistem em sua extrema rigidez e inadequação para classificação. Portanto, em 1957, Joyce e Needham (Joyce e Needham)

sugeriram levar em consideração as características de frequência das palavras para que "... a operação de comparação fosse a razão da distância entre os vetores ...".

O modelo vetorial foi implementado com sucesso em 1968 pelo pai fundador da ciência da recuperação de informações Gerard Salton (Gerard Salton)

* no mecanismo de busca SMART (Recuperador Automático Mágico de Texto de Salton). A classificação neste modelo é baseada em uma observação estatística natural de que quanto maior a frequência local de um termo em um documento (TF) e mais "rara" (ou seja, a

ocorrência de retorno em documentos ) de um termo em uma coleção (IDF), maior o peso desse documento em relação ao termo .

* Gerard Salton (Sahlman) 1927-1995. Ele é Selton, ele é Zalton e até Zalman, ele é Gerard, Gerard, Gerard ou até Gerald, dependendo do gosto do tradutor e dos erros de digitação.

http://www.cs.cornell.edu/Info/Department/Annual95/Faculty/Salton.html

http://www.informatik.uni-trier.de/~ley/db/indices/a-tree/s/Salton:Gerald.html

http://www.cs.virginia.edu/~clv2m/salton.txt

A designação IDF foi introduzida por Karen Sparck-Jones (Karen Spark-Jones) em 1972 em um

artigo sobre o

termo especificidade . A partir de agora, a designação TF * IDF é amplamente usada como sinônimo para o modelo vetorial.

Finalmente, em 1977, Robertson e Sparck-Jones (

Robertson e Spark-Jones) substanciaram e implementaram um

modelo probabilístico (

proposto em 1960), que também lançou as bases para uma família inteira.

A relevância neste modelo é considerada como a probabilidade de que este documento possa ser do interesse do usuário. Isso implica a presença de um conjunto inicial de documentos relevantes já selecionado, selecionado pelo usuário ou recebido automaticamente, sob alguma hipótese simplificada. A probabilidade de ser relevante para cada documento subseqüente é calculada com base na razão entre a ocorrência de termos no conjunto relevante e o restante da parte "irrelevante" da coleção. Embora os modelos probabilísticos tenham alguma vantagem teórica, porque organizam documentos em ordem decrescente de “probabilidade de serem relevantes”, na prática eles não receberam muita distribuição.

Não vou entrar em detalhes e escrever fórmulas volumosas para cada modelo. Seu resumo, juntamente com a discussão, ocupa de forma condensada 35 páginas no livro

"Modern Information Search" . É importante observar apenas que em cada uma das famílias o modelo mais simples procede da suposição das palavras independência e possui uma condição de filtragem simples: documentos que não contêm palavras de consulta nunca são encontrados. Os modelos avançados ("alternativos") de cada uma das famílias não consideram a palavra de consulta independente, mas, além disso, permitem localizar documentos que não contêm uma única palavra da consulta.

Pesquisa "por sentido"

A capacidade de localizar e classificar documentos que não contêm palavras da consulta é frequentemente considerada um sinal de inteligência artificial ou uma busca por significado e, a priori, se relacionam às vantagens do modelo. A questão de saber se isso é verdade ou não, deixaremos fora do escopo deste artigo.

Por exemplo, descreverei apenas um, talvez o modelo mais popular que funcione por significado. Na teoria da recuperação de informações, esse modelo é chamado

de indexação latente-semântica (em outras palavras, revelando significados ocultos). Este modelo algébrico é baseado na decomposição singular de uma matriz retangular associando palavras a documentos. O elemento da matriz é uma resposta de frequência, refletindo o grau de conexão da palavra e do documento, por exemplo, TF * IDF. Em vez da matriz milionésima-dimensional original, os autores do

método Furnas e

Deerwester sugeriram o uso de

50-150 "significados ocultos" correspondentes aos primeiros

componentes principais de sua decomposição singular .

Uma decomposição singular de uma matriz real A dos tamanhos m * n é chamada de decomposição da forma A = USV, onde U é a matriz ortogonal dos tamanhos m * m, V é a matriz ortogonal dos tamanhos n * n, S é a matriz diagonal dos tamanhos m * n, cujos elementos são s ij = 0 se i não for igual aj es ii = s i > = 0. As quantidades si são chamadas números singulares da matriz e são iguais aos valores aritméticos das raízes quadradas dos valores próprios correspondentes da matriz AA T. Na literatura inglesa, a decomposição singular é comumente chamada de decomposição SVD .

Foi

provado há muito tempo que, se deixarmos os primeiros k números singulares em consideração (igualar o restante a zero), obteremos a aproximação mais próxima possível da matriz inicial da classificação k (em certo sentido, sua “interpretação semântica mais próxima da classificação k”). Ao diminuir a classificação, filtramos detalhes irrelevantes; aumentando, tentamos refletir todas as nuances da estrutura dos dados reais.

As operações de busca ou localização de

documentos semelhantes são bastante simplificadas, pois cada palavra e cada documento está associado a um vetor relativamente curto de significados k (linhas e colunas das matrizes correspondentes). No entanto, devido à baixa significância dos "significados", ou

por algum outro motivo, o uso do LSI na testa para pesquisa não ganhou distribuição. Embora para fins auxiliares (filtragem automática, classificação, separação de coleções, abaixamento preliminar de dimensões para outros modelos), esse método parece encontrar aplicação.

Avaliação da qualidade

A verificação de consistência mostrou que a sobreposição de documentos relevantes entre dois avaliadores é da ordem de 40%, em média ... recordação entre avaliadores e precisão de cerca de 65% ... Isso implica um limite superior prático no desempenho do sistema de recuperação de 65% ...

Donna harman

O que aprendemos, e não aprendemos, do TREC

Tradução"... uma verificação de estabilidade mostrou que a sobreposição de documentos relevantes entre dois avaliadores é em média de aproximadamente 40% ... a precisão e a integridade medidas entre avaliadores são de cerca de 65% ... Isso impõe um limite superior prático à qualidade da pesquisa na região de 65% ..."

Qualquer que seja o modelo, o mecanismo de pesquisa precisa de "ajuste" - uma avaliação da qualidade da pesquisa e ajuste dos parâmetros. A avaliação da qualidade é uma ideia fundamental para a teoria da pesquisa. Pois é graças à avaliação da qualidade que podemos falar sobre a aplicabilidade ou inaplicabilidade de um modelo específico e até discutir seus aspectos teóricos.

Em particular, uma das limitações naturais da qualidade da pesquisa é a observação feita na epígrafe: as opiniões dos dois "avaliadores" (especialistas emitindo um veredicto sobre a relevância) em média não coincidem em grande medida! Isso também implica o limite superior natural da qualidade da pesquisa, porque a qualidade é medida em comparação com a opinião do avaliador.

Geralmente, dois parâmetros são medidos para avaliar a qualidade de uma pesquisa:

- precisão - a proporção de material relevante em uma resposta do mecanismo de pesquisa

- integridade (recall) - a proporção de documentos relevantes encontrados no número total de documentos de cobrança relevantes

Esses parâmetros foram usados e são usados regularmente para selecionar modelos e seus parâmetros no âmbito da conferência de avaliação de recuperação de texto (TREC)

* criada pelo Instituto Americano de Padrões (NIST). A partir de 1992, um consórcio de 25 grupos, até o ano 12 de sua existência, a conferência acumulou material significativo no qual os mecanismos de pesquisa ainda são aprimorados. Para cada conferência regular, um novo material está sendo preparado (a chamada “trilha”) em cada uma das áreas de interesse. A "faixa" inclui uma coleção de documentos e solicitações. Vou dar exemplos:

- Rastrear solicitações aleatórias (

ad hoc ) - presente em todas as conferências

- Pesquisa multilíngue

- Roteamento e filtragem

- Pesquisa de alta precisão (com uma única resposta, realizada dentro do prazo)

- interação do usuário

- "Caminho" em linguagem natural

- Respostas para as "perguntas"

- Pesquise textos "sujos" (recém digitalizados)

- Pesquisa por voz

- Pesquise em um estojo muito grande (20 GB, 100 GB etc.)

- WEB corps (em conferências recentes, é representado por uma seleção para o domínio .gov)

- Pesquisa distribuída e mesclar resultados de pesquisa de diferentes sistemas

* Os materiais da conferência estão disponíveis publicamente em trec.nist.gov/pubs.html .Não apenas pesquisa

Como você pode ver nos "caminhos" do TREC, a pesquisa em si está intimamente ligada a várias tarefas que compartilham uma ideologia comum (classificação, roteamento, filtragem, anotação) ou são parte integrante do processo de pesquisa (agrupar resultados, expandir e restringir consultas, feedback, Anotação "dependente de consulta", interface de pesquisa e idiomas de consulta). Não existe um único mecanismo de pesquisa que não precise resolver na prática pelo menos uma dessas tarefas.

Frequentemente, a presença de uma ou outra propriedade adicional é um argumento decisivo na competição dos mecanismos de busca. Por exemplo, breves anotações que consistem em citações informativas do documento, com as quais alguns mecanismos de pesquisa acompanham os resultados de seus trabalhos, os ajudam a permanecer meio passo à frente da concorrência.

É impossível contar sobre todas as tarefas e como resolvê-las. Por exemplo, considere a "extensão de consulta", que geralmente é feita participando da pesquisa de termos associados. A solução para esse problema é possível de duas formas - local (dinâmica) e global (estática). Técnicos locais confiam no texto da consulta e analisam apenas os documentos encontrados nele. As “extensões” globais podem operar com tesauros, tanto a priori (linguístico) quanto construídas automaticamente em toda a coleção de documentos. De acordo com a opinião geralmente aceita, as modificações globais de consulta nos tesauros funcionam de maneira ineficiente, reduzindo a precisão da pesquisa. Uma abordagem global mais bem-sucedida é baseada em classificações estáticas criadas manualmente, como diretórios WEB. Essa abordagem é amplamente usada nos mecanismos de pesquisa da Internet nas operações de restrição ou expansão de consultas.

Freqüentemente, a implementação de recursos adicionais é baseada nos mesmos princípios ou modelos ou modelos muito semelhantes à pesquisa em si. , , , ( – TF*IDF), .

(relevance feedback),

() , .

, ,

«Term Vector Database» , «» ( ).

, . . , (, , ), . , (,

) , . , , :

—

—

( ): ,

— (

- )

—

(,

):

«», ,

— () (, )

—

:

—

,

. - (LSI, ), - , .

“Things that work well on TREC often do not produce good results on the web… Some argue that on the web, users should specify more accurately what they want and add more words to their query. We disagree vehemently with this position. If a user issues a query like «Bill Clinton» they should get reasonable results since there is a enormous amount of high quality information available on this topic”

Sergei Brin, Larry Page

The Anatomy of a Large-Scale Hypertextual Web Search Engine

Tradução«, TREC, … , , , . . « », , ...»

«I was struck when a Google person told me at SIGIR that the most recent Google ranking algorithm completely ignores anything discovered at TREC, because all the good Ad Hoc ranking algorithms developed over the 10 years of TREC get trashed by spam»

Mark Sanderson

Tradução« , - Google , TREC, , « » ...»

, : ?

, , , - , ( , . .) .

(off-page) , ́ , . , , , , – .

C , -. , «» , .

, ,

, « » , , .

, , , , , . (

– ), . .

.

. , 1999-2000 . ( ) , .

( ) , . ,

. 1998 .

, , . 1998

PageRank – , , . , (, , 80- ), .

, PageRank, ( , ) –

HITS ,

- . , (. . ) , .

, , , . , , : , . . , : (,

www.teoma.com ), ..,

.

.

, . , Google Fast, . : «» , , 100 , 30% – . .

, , : , .. , , , « ».

. : ; – .

– , , , . . : , , , , . . , .

, , , : , , .

, , . - .

Udi Manber ( ) ( agrep) 1994

, Andrei Broder ( ) 1997-

«» ( shingles, «», «»). .

(

). , , , . (, , 9) , , , 25. , . , – , , , , ( ) : ! 25 !

, , .. : « » ! . ( ; , 0%; .)

,

,

- ,

. , (

), -.

. , . .

, , . , 1997 ( Inktomi) 32- (Linux, Solaris, FreeBSD, Win32) . AltaVista, «» 64- Alpha.

(, , c)

. . , , , , . Pruning ( . , ) , . pruning, , .

– , , . , .

, (, - )

. , , , , : , .

, , , . , , , . , , , 2-4 , , , , . .

(assesor, ) – , , .

(boolean, , , ) – , , .

– , , – .

– , .

(off-page, ) – , , .

(doorways, hallways) – , ( ). .

(tagging, part of speech disambiguation, ) – c ; « ».

(duplicates) – , , ; (near duplicates, -), , .

– , , .

(inverted file, , , ) – , , , .

(index, ) – . .

(citation index) – () , , , .

(indexing, ) – ( ) – , .

(Information Retrieval, IR) – , . , . , . « », , . , , (), , , .

(cloaking) – , ( ) , , .

– . .

- – , . .

(lemmatization, ) – , .

– . .

– , .

(inverted document frequency, IDF, , ) – ( ); «» , , .

– , , , , . – , .

– . .

– , () .

– , , .

(similar document search) – , , .

(search engine, SE, - , , , , «», «») – , , .

(query, ) – .

(polysemy, homography, , , ) — .

(recall, ) – , , .

- (near-duplicates, ) – . .

(pruning) – .

– , ( ).

- – . .

(term specificity, term discriminating power, , ) – . , . , .

(regualr expression, pattern, «», «», «») – , , , . . – , .

(relevance, relevancy) – .

(signature, ) – - . - .

(inflection) – , , (), . , . (declension), – (conjugation).

(derivation) – . , .

– . .

(spam, , ) – .

– . PageRank .

– .

- (stop-words) – , , / .

, (suffix trees, suffix arrays, PAT-arrays) – , , (trie). «», ( ) . , – , . , , .

(tokenization, lexical analysis, , ) – , , , , .

(precision) — .

- (hash-value) – - (hash-function), (, ) .

() (document frequency, , ) – , .

(term frequency, TF) – .

– (shingle) – - .

PageRank – () , — . .

TF*IDF – ; , – .

Modern Information Retrieval

Baezo-Yates R. and Ribeiro-Neto B.

ACM Press Addison Wesley, 1999

The Connectivity Server: fast access to linkage information on the Web

K. Bharat, A. Broder, M. Henzinger, P. Kumara, and S. Venkatasubramanian

WWW7, 1998

http://www7.scu.edu.au/programme/fullpapers/1938/com1938.htm

The Anatomy of a Large-Scale Hypertextual Web Search Engine

S.Brin and L. Page

WWW7, 1998

http://www7.scu.edu.au/programme/fullpapers/1921/com1921.htm

Syntactic Clustering of the Web

Andrei Z. Broder, Steven C. Glassman, Mark S. Manasse

WWW6, 1997

Indexing by Latent Semantic Analysis

S. Deerwester, ST Dumais, GW Furnas, TK Landauer, R. Harshman

JASIS, 1990

http://citeseer.nj.nec.com/deerwester90indexing.html

The approximation of one matrix by another of lower rank

C. Eckart, G. Young

Psychometrika, 1936

Description and performance analysis of signature file methods

C. Faloutsos, S. Christodoulakis

ACM TOIS 1987

FAST PMC — The Pattern Matching Chip

http://www.fast.no/product/fastpmc.html

www.idi.ntnu.no/grupper/KS-grp/microarray/slides/heggebo.pdf ( , web.archive.org – . .)

Information retrieval using a Singular Value Decomposition Model of Latent Semantic Structure

GW Furnas, S. Deerwester, ST Dumais, TK Landauer, RA Harshman, LA Streeter, and KE Lochbaum

ACM SIGIR, 1988

Glimpse, Webglimpse, Unix-based search software…

http://webglimpse.org

Examples of PAT applied to the Oxford English Dictionary

Gonnet G.

University of Waterloo, 1987

What we have learned, and not learned, from TREC

Donna Harman

http://irsg.eu.org/irsg2000online/papers/harman.htm

The Thesaurus Approach to Information Retrieval

T. Joyce and RM Needham

American Documentation, 1958

Authoritative Sources in a Hyperlinked Environment

Jon M. Kleinberg

JACM, 1998

http://citeseer.nj.nec.com/87928.html

An efficient method to detect duplicates of Web documents with the use of inverted index

S. Ilyinsky, M. Kuzmin, A. Melkov, I. Segalovich

WWW2002, 2002

Suffix Arrays: A New Method for On-line String Searches

U. Manber, G. Myers

1st ACM-SIAM Symposium on Discrete Algorithms, 1990

Finding similar files in a large file system

U. Manber

USENIX Conference, 1994

ME Maron and JL Kuhns

On relevance, probabilistic indexing and information retrieval

Journal of the ACM, 1960

Open Text Corporation

http://www.opentext.com

SE Robertson and Sparck Jones K.

Relevance Weighting of Search Terms

JASIS, 1976

Algorithms in C++, Robert Sedgewick

Addison-Wesley, 1992

A Statistical Interpretation of Term Specificity and Its Application in Retrieval

Karen Sparck Jones

Journal of Documentation, 1972

The Term Vector Database: fast access to indexing terms for Web pages

R. Stata, K. Bharat, F. Maghoul

WWW9, 2000

http://www9.org/w9cdrom/159/159.html

Natural Language Information Retrieval

Tomek Strzalkowski (ed.)

Kluwer Academic Publishers, 1999

: , . , . , .

, 2000

https://www.ozon.ru/context/detail/id/33769775/

- . .. , .., ..

- , 1995