Olá pessoal. Antes do início do curso de Aprendizado de Máquina, resta pouco mais de uma semana. Antecipando o início das aulas, preparamos uma tradução útil que será de interesse de nossos alunos e de todos os leitores do blog. Vamos começar.

É hora de se livrar das caixas pretas e construir fé no aprendizado de máquina!Em seu livro

“Interpretable Machine Learning”, Christoph Molnar destaca perfeitamente a interpretação do Machine Learning usando o seguinte exemplo: Imagine que você é um especialista em Ciência de Dados e, em seu tempo livre, tentando prever onde seus amigos irão nas férias de verão com base nos dados do Facebook e twitter. Portanto, se a previsão estiver correta, seus amigos o considerarão um assistente que pode ver o futuro. Se as previsões estiverem erradas, não prejudicará nada além da sua reputação como analista. Agora imagine que não era apenas um projeto divertido, mas os investimentos foram atraídos para ele. Digamos que você queira investir em imóveis onde seus amigos possam relaxar. O que acontece se as previsões do modelo falharem? Você vai perder dinheiro. Desde que o modelo não tenha um impacto significativo, sua interpretabilidade não importa muito, mas quando há consequências financeiras ou sociais associadas às previsões do modelo, sua interpretabilidade assume um significado completamente diferente.

Aprendizado de máquina explicado

Interpretar é explicar ou mostrar em termos compreensíveis. No contexto de um sistema de ML, interpretabilidade é a capacidade de explicar sua ação ou mostrá-la de uma

forma legível por humanos .

Muitas pessoas apelidaram os modelos de aprendizado de máquina de "caixas pretas". Isso significa que, apesar de podermos obter uma previsão precisa deles, não podemos explicar ou entender claramente a lógica de sua compilação. Mas como você pode extrair insights do modelo? Que coisas devem ser lembradas e que ferramentas precisamos para fazer isso? Essas são questões importantes que vêm à mente quando se trata de modelar a interpretabilidade.

Importância da Interpretabilidade

A pergunta que algumas pessoas fazem é:

por que não ficar contente por termos um resultado concreto do trabalho do modelo, por que é tão importante saber como essa decisão foi tomada? A resposta está no fato de que o modelo pode ter um certo impacto nos eventos subsequentes no mundo real. A interpretabilidade será muito menos importante para modelos projetados para recomendar filmes do que para modelos usados para prever os efeitos de um medicamento.

"O problema é que apenas uma métrica, como a precisão da classificação, é uma descrição inadequada da maioria das tarefas do mundo real." (

Doshi Veles e Kim 2017 )

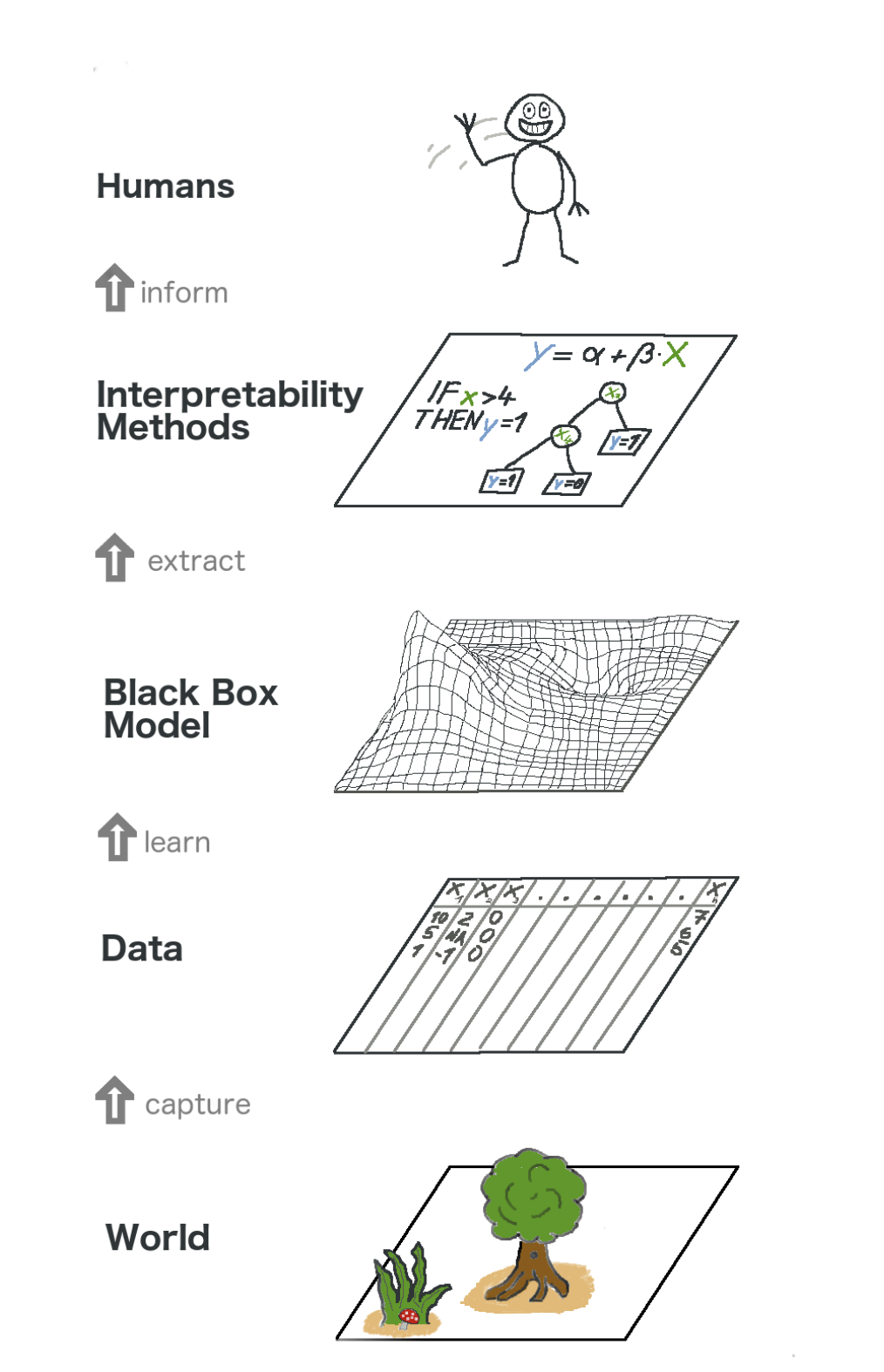

Aqui está uma visão geral sobre o aprendizado de máquina explicável. Em certo sentido, capturamos o mundo (ou melhor, informações dele), coletando dados brutos e os usando para previsões futuras. Em essência, a interpretabilidade é apenas outra camada do modelo que ajuda as pessoas a entender todo o processo.

O texto da imagem de baixo para cima: Mundo -> Obtenção de informações -> Dados -> Treinamento -> Modelo da caixa preta -> Extrato -> Métodos de interpretação -> Pessoas

O texto da imagem de baixo para cima: Mundo -> Obtenção de informações -> Dados -> Treinamento -> Modelo da caixa preta -> Extrato -> Métodos de interpretação -> PessoasAlguns dos

benefícios que a interpretabilidade traz são:

- Confiabilidade

- Conveniência de depuração;

- Informações sobre recursos de engenharia;

- Gerenciando a coleta de dados para características

- Informações sobre tomada de decisão;

- Construindo confiança.

Métodos de interpretação de modelos

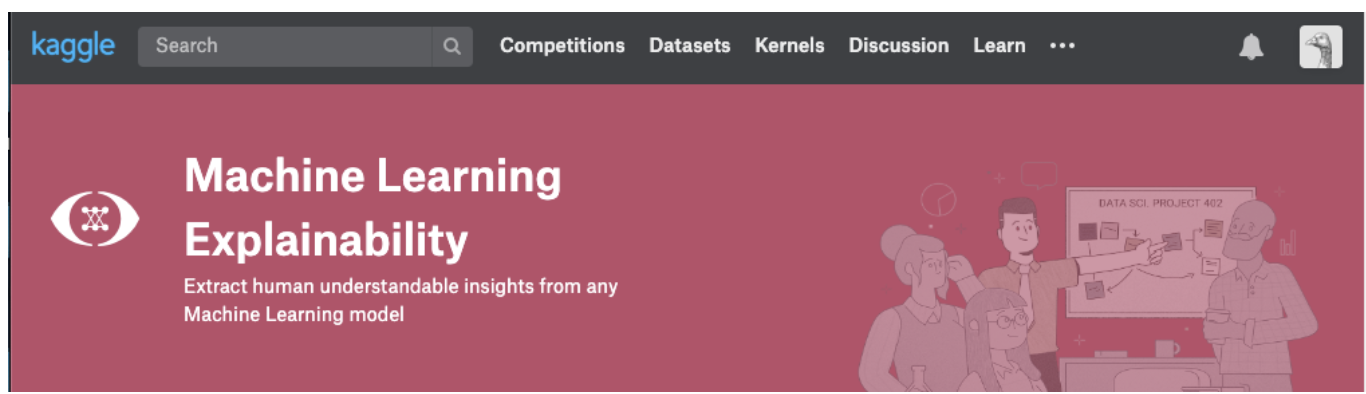

Uma teoria faz sentido apenas enquanto pudermos colocá-la em prática. Caso você realmente queira lidar com esse tópico, tente o curso de Explicabilidade do Machine Learning do Kaggle. Nele, você encontrará a correlação correta da teoria e do código para entender os conceitos e poder colocar em prática os conceitos de interpretabilidade (explicabilidade) dos modelos para casos reais.

Clique na imagem abaixo para ir diretamente para a página do curso. Se você deseja obter uma visão geral do tópico primeiro, continue lendo.

Informações que podem ser extraídas de modelos

Para entender o modelo, precisamos das seguintes informações:

- Os recursos mais importantes no modelo;

- Para qualquer previsão específica do modelo, o efeito de cada atributo individual em uma previsão específica.

- A influência de cada recurso em um grande número de previsões possíveis.

Vamos discutir alguns métodos que ajudam a extrair as informações acima do modelo:

Importância da permutação

Quais recursos o modelo considera importantes? Quais sintomas têm mais impacto? Esse conceito é chamado de importância dos recursos, e a Importância da Permutação é um método amplamente usado para calcular a importância dos recursos. Isso nos ajuda a ver em que ponto o modelo produz resultados inesperados, ajuda a mostrar aos outros que nosso modelo funciona exatamente como deveria.

A Importância da Permutação funciona para muitas avaliações do scikit-learn. A ideia é simples: reorganize ou embaralhe arbitrariamente uma coluna no conjunto de dados de validação, deixando todas as outras colunas intactas. Um sinal é considerado "importante" se a precisão do modelo cair e sua mudança causar um aumento nos erros. Por outro lado, um recurso é considerado "sem importância" se o embaralhamento de seus valores não afetar a precisão do modelo.

Como isso funciona?

Considere um modelo que prevê se um time de futebol receberá ou não o prêmio "Homem do jogo", com base em determinados parâmetros. Este prêmio é dado ao jogador que demonstra as melhores habilidades do jogo.

A Importância da Permutação é calculada após o treinamento do modelo. Então, vamos treinar e preparar o modelo

RandomForestClassifier , designado como

my_model , nos dados de treinamento.

A Importância da Permutação é calculada usando a biblioteca

ELI5 . O ELI5 é uma biblioteca em Python que permite visualizar e depurar vários modelos de aprendizado de máquina usando uma API unificada. Possui suporte interno para várias estruturas de ML e fornece maneiras de interpretar o modelo de caixa preta.

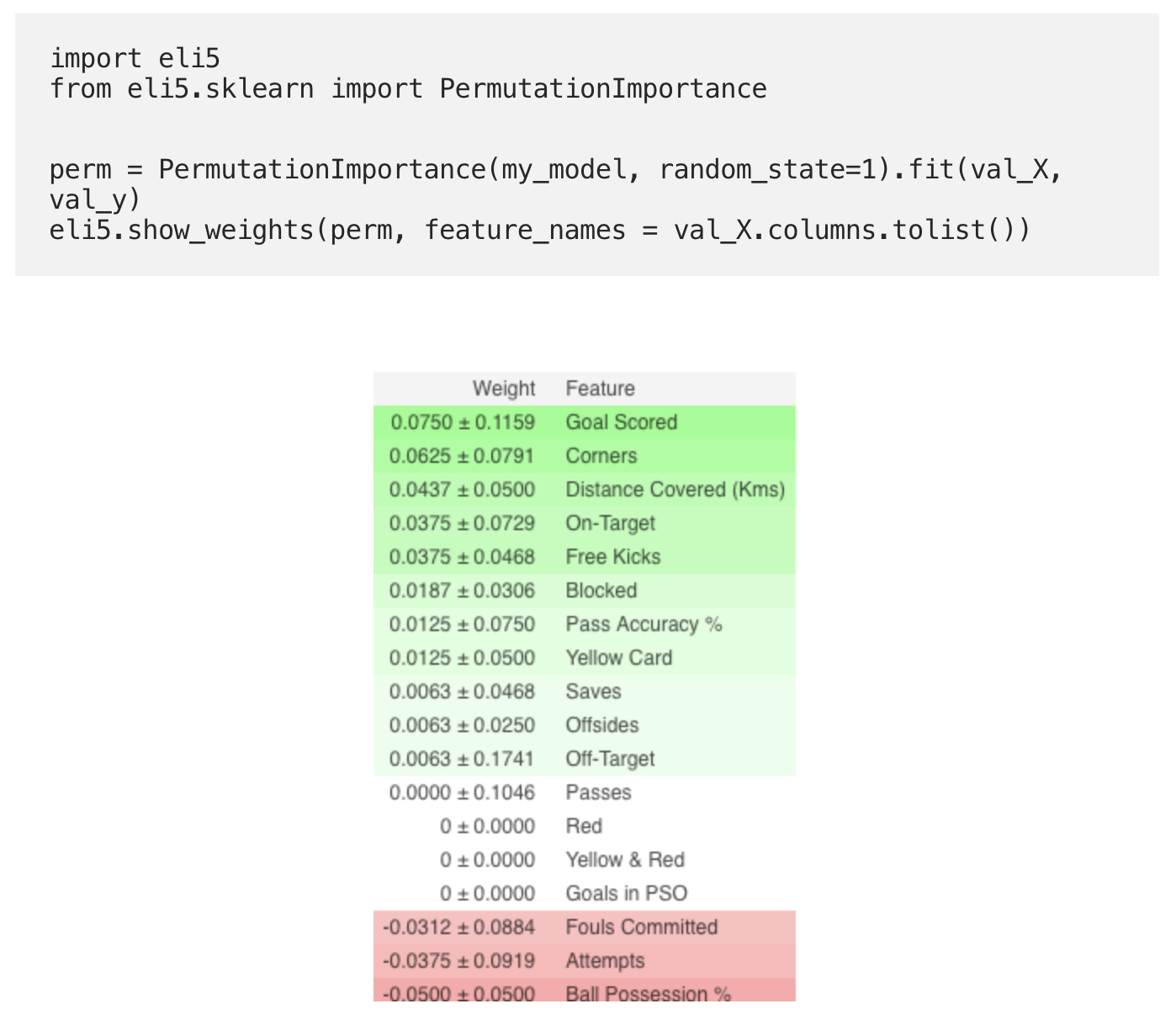

Cálculo e visualização de importância usando a biblioteca ELI5:

(Aqui

val_X ,

val_y denotam conjuntos de validação, respectivamente)

Interpretação

- Os sinais acima são os mais importantes, abaixo são os menos. Neste exemplo, o sinal mais importante foram os gols marcados.

- O número após ± reflete como a produtividade mudou de uma permutação para outra.

- Alguns pesos são negativos. Isso se deve ao fato de que, nesses casos, as previsões para os dados embaralhados se mostraram mais precisas que os dados reais.

Prática

E agora, para ver o exemplo completo e verificar se você entendeu tudo corretamente, vá para a página do Kaggle usando o

linkEntão a primeira parte da tradução chegou ao fim. Escreva seus comentários e conheça o curso!

Leia a segunda parte .