Dedico este post àquelas pessoas que mentiram em certificados, por causa das quais quase instalamos estrelinhas em nossos corredores.

As histórias têm mais de quatro anos, mas estou publicando agora, porque a NDA terminou. Então percebemos que carregamos o data center (que arrendamos) quase completamente e que sua eficiência energética não melhorou muito. A hipótese anterior era de que quanto mais forte for preenchido, melhor, porque o engenheiro é distribuído a todos. Mas aconteceu que estávamos nos enganando a esse respeito e, com uma boa carga, houve perdas em algum lugar. Trabalhamos em muitas áreas, mas nossa valente equipe começou a esfriar.

A vida real do data center é um pouco diferente do projeto. Aparafusar constantemente do departamento de serviço para aumentar a eficiência e otimizar as configurações para novas tarefas. Aqui, adote uma postura mítica do meio. Na prática, ela não existe, a distribuição de carga é desigual, em algum lugar denso, em algum lugar vazio. Então tive que reconfigurar algo para melhorar a eficiência energética.

Nosso compressor de data center é necessário para uma variedade de clientes. Portanto, no meio dos racks habituais de dois e quatro quilowatts, pode haver um total de 23 quilowatts ou mais. Consequentemente, os aparelhos de ar condicionado foram instalados para resfriá-los e, através de racks menos potentes, o ar simplesmente passava.

A segunda hipótese era que os corredores quente e frio não se misturam. Após as medições, posso dizer que isso é uma ilusão, e a aerodinâmica real difere do modelo em quase tudo.

Pesquisa

Primeiro começamos a observar as correntes de ar nos corredores. Por que você chegou lá? Como eles entenderam que o data center foi projetado para cinco a seis kW por rack, eles sabiam que na verdade eram de 0 a 25 kW. É quase impossível regular tudo isso com ladrilhos: as primeiras medições mostraram que elas passam quase igualmente. E ladrilhos de 25 kW não existem, eles devem estar não apenas vazios, mas com vácuo líquido.

Compramos um anemômetro e começamos a medir os fluxos entre os racks e os racks acima. Em geral, é necessário trabalhar com ele de acordo com o GOST e vários padrões difíceis de alcançar sem parar o salão. Não estávamos interessados em precisão, mas na imagem fundamental. Ou seja, eles mediram aproximadamente.

Ao medir 100% do ar que sai dos ladrilhos, 60% entram nas prateleiras, o resto voa. Isso se deve ao fato de haver racks pesados de 15 a 25 kW, nos quais é construído o resfriamento.

Não podemos retirar e apagar os aparelhos de ar condicionado, pois estarão muito quentes nos racks quentes na área dos servidores superiores. Neste momento, entendemos que é necessário isolar algo de algo, para que o ar não salte de uma linha para outra e que ocorra a troca de calor no bloco.

Paralelamente, nos perguntamos se é financeiramente conveniente.

Ficamos surpresos ao descobrir que geralmente temos o consumo de energia do data center, mas simplesmente não podemos calcular os fancoils para uma sala específica. Ou seja, analiticamente, podemos, mas na verdade - não. E não podemos avaliar a economia. A tarefa se torna mais interessante e mais interessante. Se economizarmos 10% da energia dos aparelhos de ar condicionado - quanto dinheiro pode ser reservado para o isolamento? Como contar?

Fomos aos engenheiros de automação que finalizaram o sistema de monitoramento. Graças à galera: eles tinham todos os sensores, bastava adicionar o código. Eles começaram a exibir separadamente chillers, UPS, iluminação. Com o novo Pribluda, foi possível observar como a situação está mudando nos elementos do sistema.

Experiências com cortinas

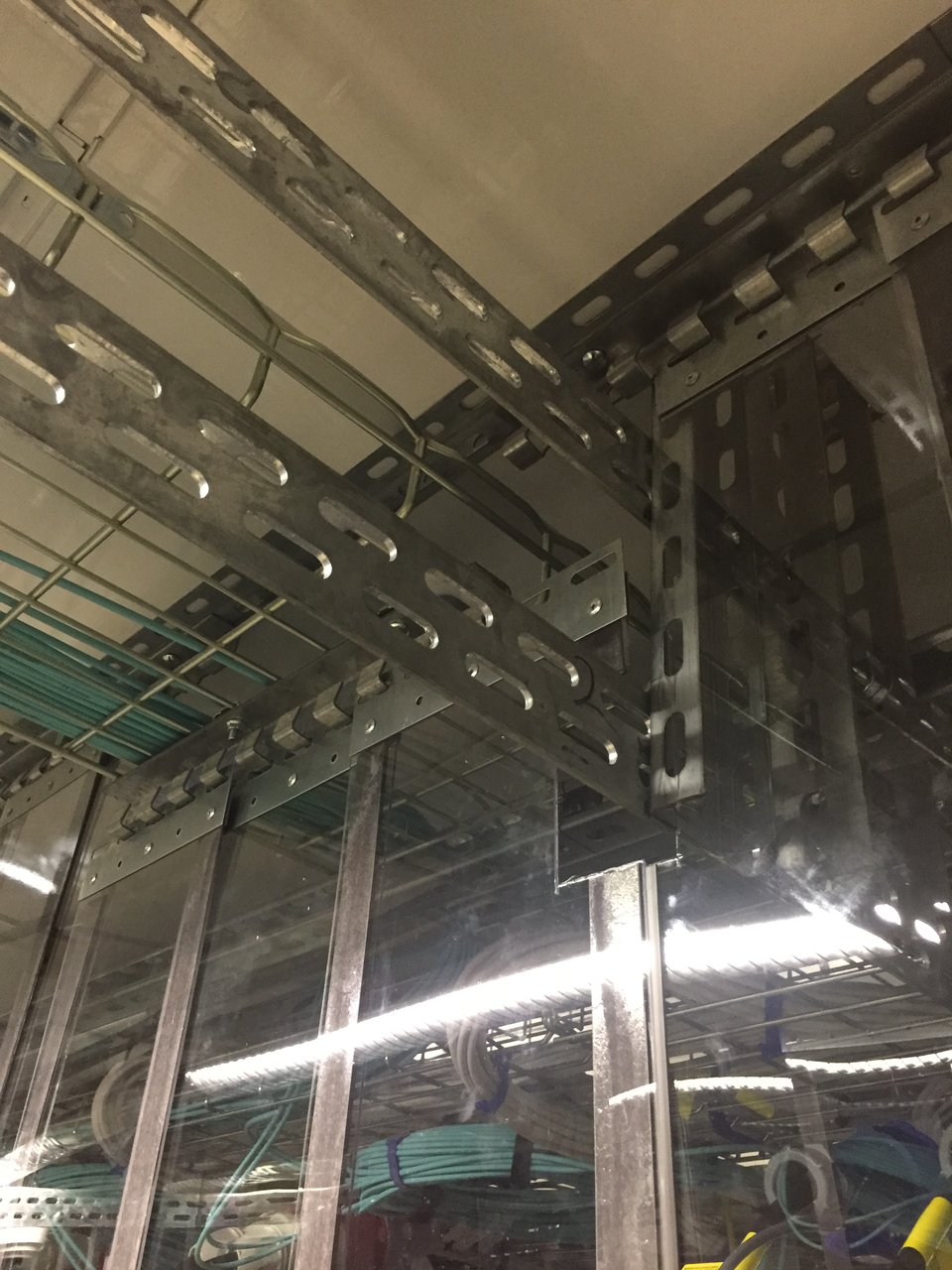

Paralelamente, iniciamos experimentos com cortinas (cercas). Decidimos conectá-los aos pinos das bandejas de cabos (não há mais nada de qualquer maneira), pois eles devem ser leves. Com copas ou pentes decididos rapidamente.

A emboscada é que, antes disso, trabalhamos com vários fornecedores. Todo mundo tem soluções para seus próprios data centers de empresas, mas para o data center comercial não há soluções prontas em essência. Nossos clientes vêm e vão constantemente. Somos um dos poucos data centers “pesados”, sem limite de largura de rack, com capacidade de aceitar esses servidores de debulha de até 25 kW. Nenhum planejamento de infraestrutura com antecedência. Ou seja, se usarmos sistemas modulares para armazenar em cache os fornecedores - sempre haverá brechas por dois meses. Ou seja, um mashroom nunca será, em princípio, eficiente em termos de energia.

Decidimos fazer isso sozinhos, já que temos nossos próprios engenheiros.

A primeira coisa que eles pegaram foram fitas de geladeiras industriais. Estes são ranhos de polietileno tão flexíveis que você pode enfrentar. Você provavelmente os viu em algum lugar na entrada do departamento de carnes do maior supermercado. Eles começaram a procurar materiais não tóxicos e incombustíveis. Encontrado, comprado em duas linhas. Velada, começou a assistir o que acontece.

Eles entenderam que não seria muito. Mas acabou muito diretamente, não muito geralmente. Eles começam, como macarrão, a flutuar nas correntes. Encontraram fitas magnéticas como ímãs de geladeira. Eles os colaram nessas tiras, colados um no outro, a parede acabou sendo moderadamente monolítica.

Eles começaram a descobrir o que aconteceria no corredor.

Fomos aos construtores, mostrando o projeto deles. Eles olham, dizem: suas cortinas são algo muito pesado. 700 kg em todo o corredor. Dizem, gente boa, para o inferno. Mais precisamente, para a equipe SCS. Considere-os quanto macarrão eles têm nas bandejas, porque 120 kg por metro quadrado é o máximo.

O SCS diz: Lembre-se, um grande cliente veio até nós? Ele tem dezenas de milhares de portos em um salão. Nas bordas, o mashzola ainda é normal, mas não sai mais perto da cruz: as bandejas caem.

Mais construtores pediram um certificado para o material. Observo que antes disso trabalhávamos na liberdade condicional do fornecedor, uma vez que era apenas um teste. Nos voltamos para esse fornecedor e dizemos: OK, pronto para entrar na versão beta, vamos pegar todos os pedaços de papel. Eles enviam algo de um padrão não muito estabelecido.

Dizemos: escute, onde você conseguiu esse pedaço de papel? Eles: nos enviaram pelo nosso fabricante chinês em resposta a solicitações. Em um pedaço de papel, essa coisa não queima.

Nesse momento, percebemos que era hora de parar e verificar os fatos. Vamos para as meninas da segurança contra incêndios do data center, elas nos chamam de laboratório que verifica a combustibilidade. É dinheiro e termos bastante terrestres (embora tenhamos amaldiçoado tudo até produzirmos a quantidade certa de pedaços de papel). Lá, dizem os cientistas: traga o material, faremos testes.

Em conclusão, foi escrito que restavam cerca de 50 gramas de cinza de um quilograma de substância. O resto queima intensamente, drena e suporta muito bem a queima de uma poça.

Entendemos - é bom que eles não tenham comprado. Eles começaram a procurar outro material.

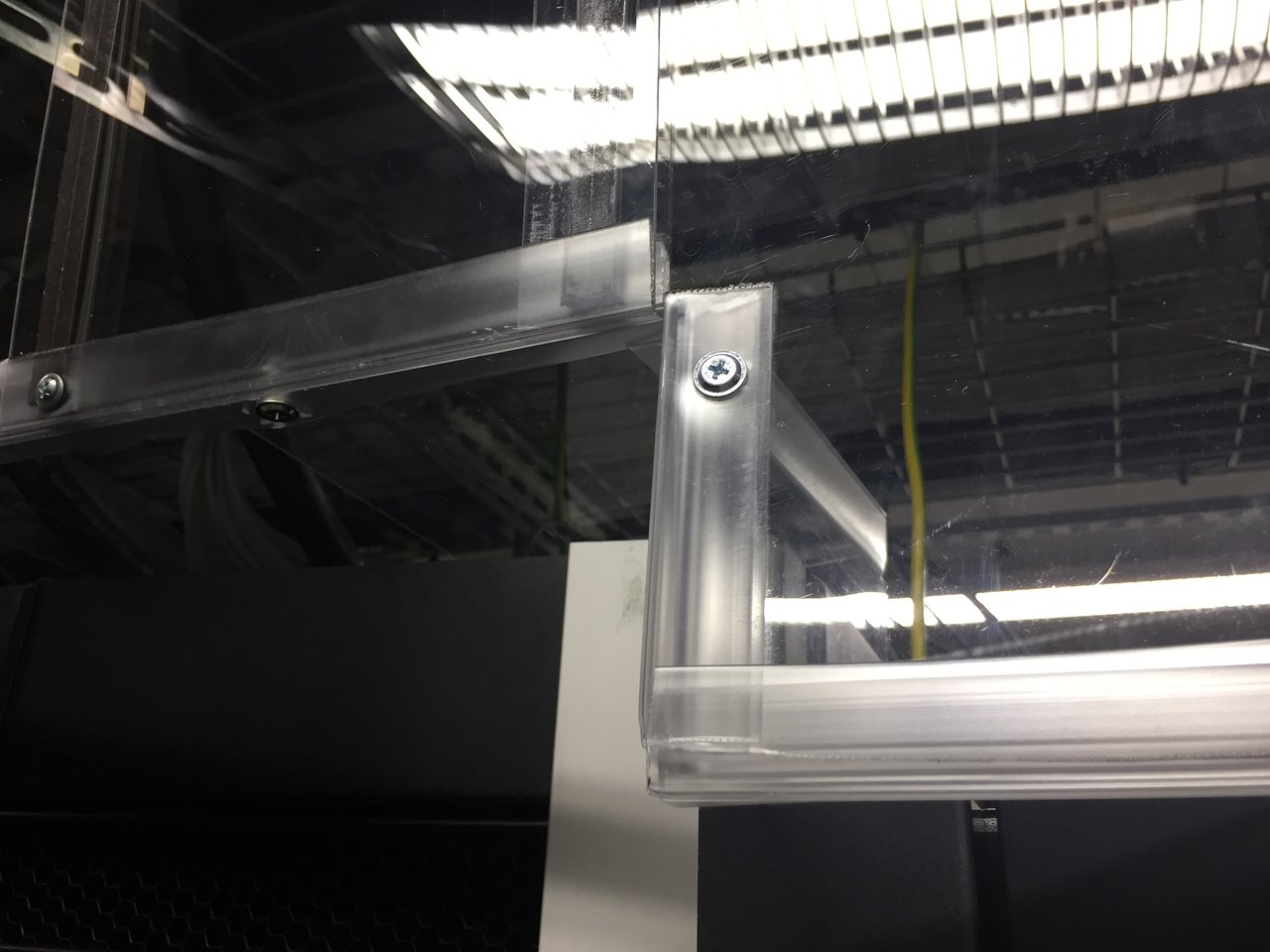

Policarbonato encontrado. Acabou sendo mais difícil. Folha transparente - dois mm, portas - a partir de quatro milímetros. De fato, é plexiglás. Juntamente com o fabricante, iniciamos uma conversa sobre segurança contra incêndio: forneça um certificado. Eles mandam. Assinado pelo mesmo instituto. A gente liga lá, a gente fala: bem, porque, pessoal, vocês conferiram isso?

Eles dizem: sim, eles fizeram. No começo, queimaram em casa e depois trouxeram apenas para testes. Cerca de 930 gramas de cinzas permanecem em um quilograma de material (se queimadas com um queimador). Derrete e pinga, mas a poça não queima.

Verifique imediatamente nossos ímãs (eles estão em um revestimento de polímero). Surpreendentemente, eles queimam mal.

Assembléia

A partir disso, começamos a coletar. O policarbonato é bonito porque é mais leve que o polietileno, que dobra muito pior. É verdade que eles trazem folhas de 2,5 por 3 metros, e o fornecedor não se importa com o que fazer com isso. E precisamos de 2,8 largos de 20 a 25 centímetros. Portas foram enviadas para escritórios que cortam a folha como deveriam. E as lamelas foram cortadas sozinhas. O processo de corte em si custa o dobro da folha.

Aqui está o que aconteceu:

Conclusão - o sistema de cache compensa em menos de um ano. Economizamos isso de 200 a 250 kW continuamente na potência da bobina do ventilador. Quanto mais em chillers, quanto exatamente - não sabemos. Servidores sugam a uma velocidade constante, sopram fancoils. E o chiller é ligado e desligado com um pente: é difícil extrair dados dele. É impossível parar o mashroom para testes.

Estamos satisfeitos que ao mesmo tempo houvesse uma regra para colocar racks 5x5 em módulos, para que o consumo médio fosse de seis kW no máximo. Ou seja, o calor não é concentrado pela ilha, mas distribuído por todo o salão. Mas há uma situação em que 10 peças de racks de 15 quilowatts estão por perto, mas em frente há um rack de cem horas. Ele está com frio Equilibrado.

Onde não há rack, você precisa de uma cerca no chão.

E também temos alguns clientes isolados com grades. Eles também tinham vários recursos.

Eles cortam em lamelas, porque a largura das estantes não é fixa e a frequência do pente dos elementos de fixação é determinada: sempre serão três ou quatro cm à direita ou à esquerda. Se você tiver um bloco de 600 sob o balcão, com uma probabilidade de 85%, ele não aumentará. E lamelas curtas e longas coexistem e permanecem juntas. Às vezes, cortamos a lamela com a letra G ao longo dos contornos das prateleiras.

Sensores

Antes de reduzir a potência das bobinas do ventilador, era necessário configurar um monitoramento de temperatura muito preciso em diferentes pontos do salão, para não surpreender. Então havia sensores sem fio. Com fio - em cada linha, você precisa pendurar suas próprias coisas para atravessar esses sensores e, às vezes, cabos de extensão nele. Se transforma em uma guirlanda. Que pena. E quando esses fios entram nas células dos clientes, os seguranças ficam imediatamente excitados e pedem para explicar com um certificado o que é removido por esses fios. Os nervos da segurança devem ser protegidos. Por alguma razão, eles não tocam em sensores sem fio.

E mais prateleiras vêm e vão. O sensor no ímã é mais fácil de montar, porque cada vez que ele deve ser pendurado mais alto ou mais baixo. Se os servidores estiverem no terço inferior do rack - você precisará pendurá-lo e não de acordo com os metros padrão e meio do chão na porta do rack no corredor frio. É inútil medir lá, é necessário medir o que está no ferro.

Um sensor em três racks - mais frequentemente você não pode travar. A temperatura não é diferente. Eles temiam que houvesse um puxão de ar pelas prateleiras - isso não aconteceu. Mas ainda damos um pouco mais de ar frio do que os valores calculados. Fizemos janelas nas lamelas 3, 7 e 12, acima do balcão, fazemos um buraco. Colocamos um anemômetro ao contornar: parecemos que o fluxo vai para onde necessário.

Depois, penduraram cordas brilhantes: uma prática antiga para atiradores de elite. Parece estranho, mas permite detectar um possível problema mais rapidamente.

Engraçado

Enquanto estávamos fazendo tudo isso em silêncio, um fornecedor veio produzir um engenheiro para data centers. Ele diz: vamos nos falar sobre eficiência energética. Eles chegam, começam a falar sobre o salão não ideal, as correntes de ar. Nós assentimos compreensivamente. Porque nós temos três anos como estabelecido.

Penduram três sensores em cada rack. As imagens de monitoramento estão machucadas, lindas. Mais da metade dessa solução em preço é software. No nível de alerta no Zabbix, mas proprietário e muito caro. A emboscada é que eles têm sensores, software e, em seguida, procuram um contratado no local: não há fornecedores de gaiolas.

Acontece que suas mãos são cinco a sete vezes mais caras do que nós.

Referências