Reconhecendo a importância da inteligência artificial, a Intel está dando outro passo nessa direção. Há um mês, na conferência Hot Chips 2019, a empresa lançou oficialmente dois chips especializados projetados para treinamento e inferência de redes neurais. Os chips foram nomeados Intel Nervana NNP-

T (processador de rede neural) e Intel Nervana NNP-

I, respectivamente. Sob o corte, você encontrará as características e esquemas de novos produtos.

Intel Nervana NNP-T (crista da primavera)

O tempo de treinamento da rede neural, juntamente com a eficiência energética, é um dos principais parâmetros do sistema de IA, que determina o escopo de sua aplicação. O poder de computação usado nos maiores modelos e conjuntos de treinamento dobra a cada três meses. Ao mesmo tempo, um conjunto limitado de cálculos é usado em redes neurais, principalmente convoluções e multiplicação de matrizes, o que abre um grande escopo para otimizações. Idealmente, o dispositivo de que precisamos deve ser equilibrado em termos de consumo, comunicação, poder de computação e escalabilidade.

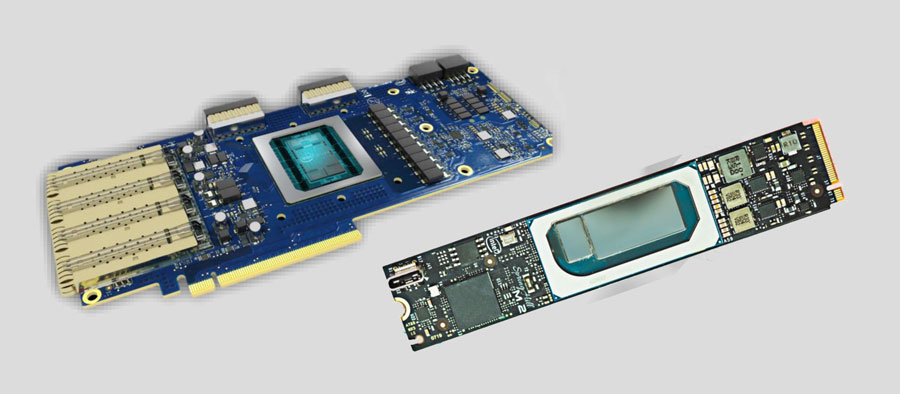

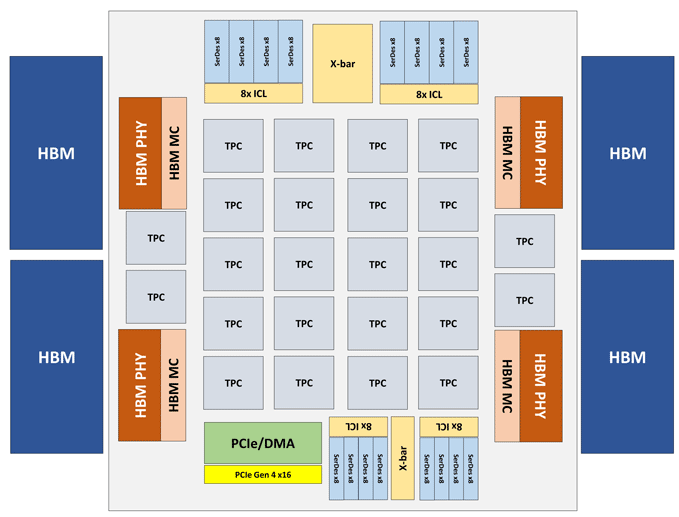

O módulo Intel Nervana NNP-T é fabricado na forma de uma placa PCIe 4.0 x16 ou OAM. O principal elemento de computação do NNP-T é o TPC (Tensor Processing Cluster) de 24 peças, fornecendo até 119 desempenho de TOPS. Um total de 32 GB de memória HBM2-2400 é conectado através de 4 portas HBM. A bordo, há também uma unidade de serialização / desserialização em 64 linhas, interfaces SPI, I2C, GPIO. A quantidade de memória distribuída no chip é de 60 MB (2,5 MB por TPC).

Arquitetura TPC (Tensor Processing Cluster)

Arquitetura TPC (Tensor Processing Cluster)Outras especificações de desempenho do Intel Nervana NNP-T.

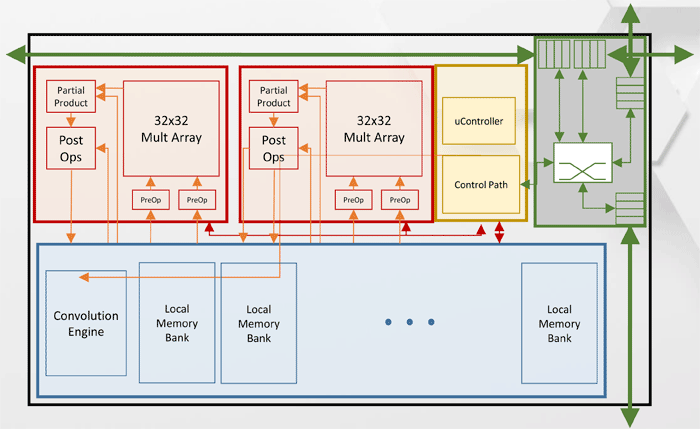

Como você pode ver no diagrama, cada TPC possui dois núcleos de multiplicação de matriz 32x32 com suporte ao BFloat16. Outras operações são executadas no formato BFloat16 ou FP32. No total, até 8 placas podem ser instaladas em um host, a escalabilidade máxima - até 1024 nós.

Intel Nervana NNP-I (Spring Hill)

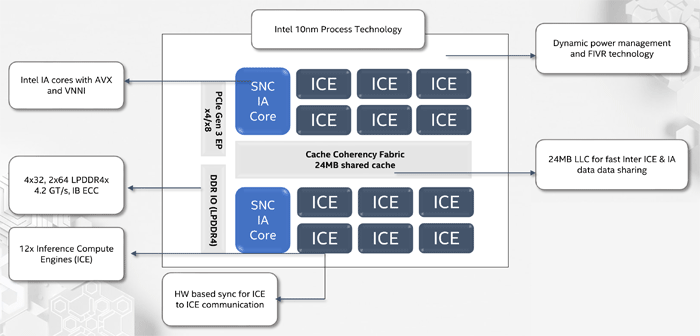

Ao projetar o Intel Nervana NNP-I, o objetivo era fornecer a máxima eficiência energética com inferência na escala de grandes data centers - cerca de 5 TOP / W.

O NNP-I é um SoC, fabricado de acordo com a tecnologia de processo de 10 nm e inclui dois núcleos x86 padrão com suporte para AVX e VNNI, além de 12 núcleos especializados do Inference Compute Engine (ICE). O desempenho máximo é de 92 TORS, TDP - 50 watts. A quantidade de memória interna é de 75 MB. Estruturalmente, o dispositivo é fabricado na forma de uma placa de expansão M.2.

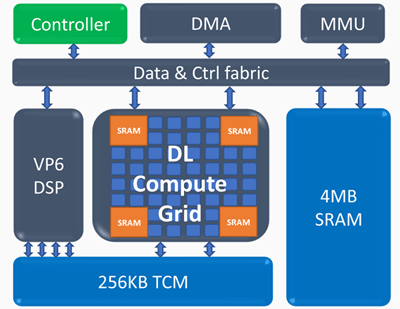

Arquitetura do Inference Compute Engine (ICE)

Arquitetura do Inference Compute Engine (ICE)Elementos principais do Inference Compute Engine:

Grade de computação de aprendizado profundo- 4k MAC (int8) por ciclo

- suporte escalável para FP16, INT8, INT 4/2/1

- grande quantidade de memória interna

- operações não-lineares e pooling

Processador vetorial programável- alto desempenho - 5 VLIW 512 b

- suporte estendido a NN - FP16 / 16b / 8b

Os seguintes indicadores de desempenho do Intel Nervana NNP-I foram obtidos: em uma rede ResNet de 50 camadas, foi alcançada uma velocidade de 3600 inferências por segundo com um consumo de energia de 10 W, ou seja, a eficiência energética é de 360 imagens por segundo em termos de Watt.