Na Microsoft, nossa missão é capacitar todas as pessoas e organizações do planeta a alcançar mais. A indústria da mídia exemplifica essa missão. Vivemos em uma época em que mais conteúdo está sendo criado e consumido de mais maneiras e em mais dispositivos do que nunca. No IBC 2019, tivemos o prazer de compartilhar as mais recentes inovações em que estamos trabalhando e como elas podem ajudar a transformar seus fluxos de trabalho de mídia. Continue lendo para saber mais.

Este artigo

em nosso blog .

Video Indexer adiciona suporte para animação e conteúdo multilíngue

Disponibilizamos nosso premiado

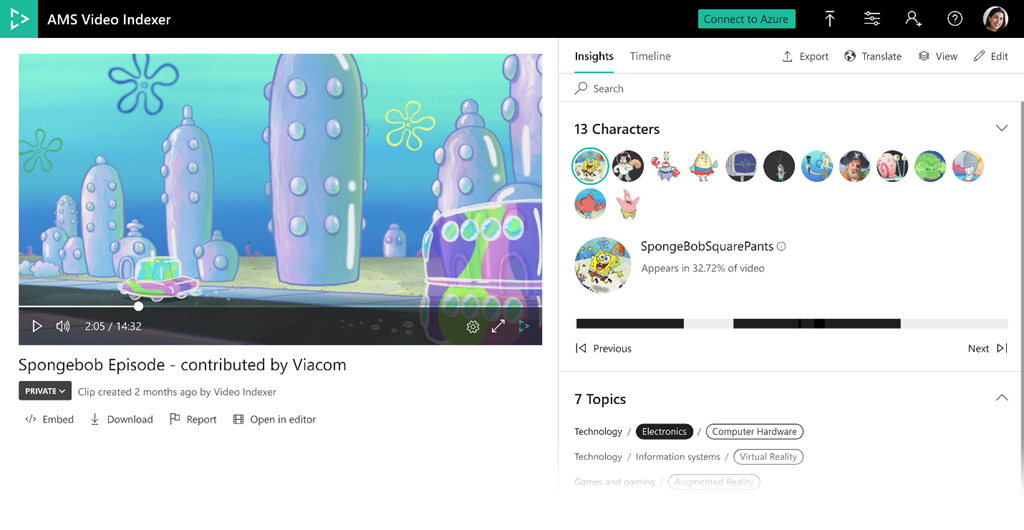

Indexador de Vídeo dos Serviços de Mídia do Azure geralmente disponível no IBC no ano passado e este ano está ficando ainda melhor. O Video Indexer extrai automaticamente informações e metadados, como palavras faladas, rostos, emoções, tópicos e marcas de arquivos de mídia, sem que você precise ser um especialista em aprendizado de máquina. Nossos últimos anúncios incluem visualizações de dois recursos altamente solicitados e diferenciados para reconhecimento de caracteres animados e transcrição de fala multilíngue, além de várias adições aos modelos existentes disponíveis hoje no Video Indexer.

Reconhecimento de personagem animado

Conteúdo animado ou desenho animado é um dos tipos de conteúdo mais populares, mas os modelos de visão de IA padrão criados para rostos humanos não funcionam bem com eles, especialmente se o conteúdo tiver caracteres sem recursos humanos. Nesta nova solução de visualização, o Video Indexer une forças ao serviço Azure Custom Vision da Microsoft para fornecer um novo conjunto de modelos que detectam e agrupam automaticamente caracteres animados e permitem que os clientes os etiquetem e os reconheçam facilmente através de modelos de visão personalizados integrados. Esses modelos são integrados em um único pipeline, o que permite a qualquer pessoa usar o serviço sem nenhuma habilidade anterior de aprendizado de máquina. Os resultados estão disponíveis no portal do Video Indexer sem código ou na API REST para fácil integração com seus próprios aplicativos.

Criamos esses modelos de personagens animados em colaboração com clientes selecionados que contribuíram com conteúdo animado real para treinamento e teste. O valor da nova funcionalidade é bem articulado por Andy Gutteridge, diretor sênior de estúdio e tecnologia de pós-produção da Viacom International Media Networks, que foi um dos contribuidores de dados: "A adição de detecção animada confiável baseada em IA nos permitirá descubra e catalogue metadados de caracteres de nossa biblioteca de conteúdo de maneira rápida e eficiente. Mais importante, ele dará às nossas equipes criativas o poder de encontrar o conteúdo desejado instantaneamente, minimizar o tempo gasto no gerenciamento de mídia e permitir que eles se concentrem na peça criativa. ”

Para começar com o reconhecimento de personagens animados,

visite nossa página de documentação .

Identificação e transcrição multilíngue

Alguns recursos de mídia, como notícias, assuntos atuais e entrevistas, contêm áudio com falantes usando diferentes idiomas. A maioria dos recursos de fala para texto existentes exige que o idioma de reconhecimento de áudio seja especificado com antecedência, o que é um obstáculo para a transcrição de vídeos multilíngues. Nosso novo recurso de identificação automática de idiomas falados para vários conteúdos utiliza a tecnologia de aprendizado de máquina para identificar os diferentes idiomas usados em um ativo de mídia. Uma vez detectados, cada segmento de idioma passa por um processo de transcrição automática no idioma identificado e todos os segmentos são integrados novamente em um arquivo de transcrição que consiste em vários idiomas.

A transcrição resultante está disponível como parte da saída JSON do Video Indexer e como arquivos de legenda. A transcrição da saída também é integrada à Pesquisa do Azure, permitindo que você pesquise imediatamente nos vídeos os diferentes segmentos de idioma. Além disso, a transcrição em vários idiomas está disponível como parte da experiência do portal do Video Indexer, para que você possa visualizar a transcrição e o idioma identificado por tempo, ou pular para os locais específicos no vídeo de cada idioma e ver a transcrição em vários idiomas como legendas. como um vídeo é reproduzido. Você também pode traduzir a saída em 54 idiomas diferentes através do portal e da API.

Leia mais sobre a nova opção multilíngue e como usá-la no Video Indexer

em nossa documentação .

Modelos adicionais atualizados e aprimorados

Também estamos adicionando novos e aprimorando modelos existentes no Video Indexer, incluindo:

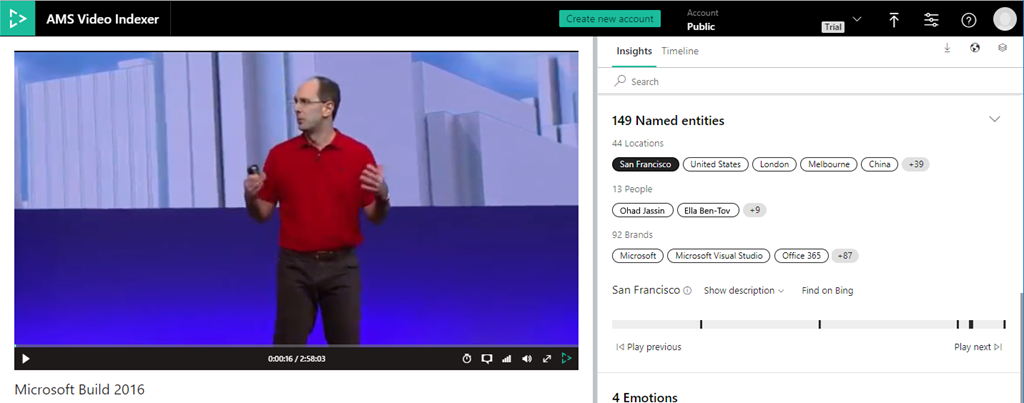

Extração de entidades de pessoas e locais

Ampliamos nossos recursos atuais de detecção de marca para incorporar nomes e locais conhecidos, como a Torre Eiffel em Paris ou o Big Ben em Londres. Quando estes aparecem na transcrição gerada ou na tela via reconhecimento óptico de caracteres (OCR), é criada uma percepção específica. Com esse novo recurso, você pode revisar e pesquisar todas as pessoas, locais e marcas que apareceram no vídeo, juntamente com seus prazos, descrição e um link para nosso mecanismo de pesquisa do Bing para obter mais informações.

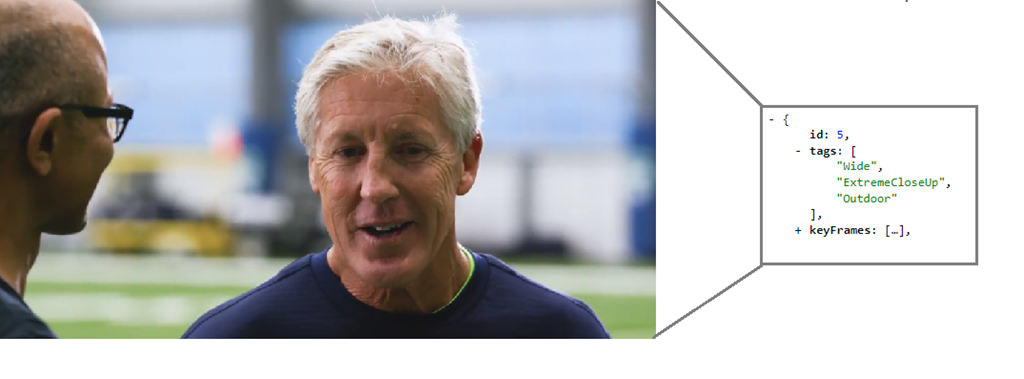

Modelo de detecção de tiro editorial

Esse novo recurso adiciona um conjunto de "tags" nos metadados anexados a uma captura individual nos insights JSON para representar seu tipo editorial (como cena ampla, cena média, close-up, close-up extremo, dois tiros, várias pessoas, ao ar livre interno, etc.). Essas características do tipo tomada são úteis ao editar vídeos em clipes e trailers, bem como ao procurar um estilo específico de tomadas para fins artísticos.

Explore e leia mais

Explore e leia mais sobre a detecção de tipo de foto editorial no Video Indexer.

Granularidade expandida do mapeamento IPTC

Nosso modelo de dedução de tópicos determina o tópico de vídeos com base na transcrição, reconhecimento óptico de caracteres (OCR) e celebridades detectadas, mesmo que o tópico não seja explicitamente declarado. Mapeamos esses tópicos inferidos para quatro taxonomias diferentes: Wikipedia, Bing, IPTC e IAB. Com esse aprimoramento, agora incluímos a taxonomia IPTC de nível 2.

A vantagem de aproveitar esses aprimoramentos é tão fácil quanto reindexar sua biblioteca atual do Video Indexer.

Nova funcionalidade de transmissão ao vivo

Também estamos apresentando dois novos recursos de transmissão ao vivo na visualização dos Serviços de Mídia do Azure.

A transcrição ao vivo sobrecarrega seus eventos ao vivo com a IA

Usando o Azure Media Services para transmitir um evento ao vivo, agora você pode obter um fluxo de saída que inclui uma faixa de texto gerada automaticamente, além do conteúdo de vídeo e áudio. Essa faixa de texto é criada usando a transcrição ao vivo baseada em AI do áudio do feed de contribuição. Os métodos personalizados são aplicados antes e depois da conversão de fala em texto para melhorar a experiência do usuário final. A faixa de texto é empacotada no IMSC1, TTML ou WebVTT, dependendo de você estar entregando no DASH, HLS CMAF ou HLS TS.

Codificação linear ao vivo para canais over-the-top (OTT) 24/7

Usando nossas APIs v3, você pode criar, gerenciar e transmitir canais ao vivo para serviços OTT e tirar proveito de todos os outros recursos dos Serviços de Mídia do Azure, como VOD (live to video on demand), empacotamento e gerenciamento de direitos digitais (DRM).

Para experimentar esses recursos de visualização, visite a página

Comunidade dos Serviços de Mídia do

Azure .

Novos recursos de embalagem

Suporte para faixas de descrição de áudio

O conteúdo de transmissão freqüentemente possui uma faixa de áudio que contém explicações verbais da ação na tela, além do áudio normal do programa. Isso torna a programação mais acessível para espectadores com deficiência visual, especialmente se o conteúdo for altamente visual. O novo

recurso de descrição de áudio permite que um cliente anote uma das faixas de áudio para ser a faixa de descrição de áudio (AD), que por sua vez pode ser usada pelos players para tornar a faixa do AD detectável pelos espectadores.

Inserção de metadados ID3

Para sinalizar a inserção de anúncios ou eventos de metadados personalizados em um player do cliente, as emissoras geralmente usam metadados cronometrados incorporados no vídeo. Além dos modos de sinalização SCTE-35,

agora também oferecemos suporte ao ID3v2 ou outros esquemas personalizados definidos por um desenvolvedor de aplicativos para uso pelo aplicativo cliente.

Os parceiros do Microsoft Azure demonstram soluções de ponta a ponta

O Bitmovin está

lançando sua Codificação de Vídeo Bitmovin e o Bitmovin Video Player no Microsoft Azure. Agora, os clientes podem usar essas soluções de codificação e player no Azure e aproveitar funcionalidades avançadas, como codificação em 3 passagens, suporte a codec AV1 / VVC, legendas ocultas em vários idiomas e análises de vídeo pré-integradas para QoS, anúncio e rastreamento de vídeo.

O Evergent está mostrando sua Plataforma de Gerenciamento do Ciclo de Vida do Usuário no Azure. Como fornecedora líder de soluções de gerenciamento de receita e ciclo de vida do cliente, a Evergent utiliza o Azure AI para permitir que provedores de serviços de entretenimento premium melhorem a aquisição e retenção de clientes, gerando pacotes e ofertas direcionados em pontos críticos do ciclo de vida do cliente.

A Haivision mostrará seu serviço inteligente de nuvem de roteamento de mídia, o SRT Hub, que ajuda os clientes a transformar fluxos de trabalho de ponta a ponta, começando com a ingestão usando o

Azure Data Box Edge e a transformação do fluxo de trabalho de mídia usando Hublets da Avid, Telestream, Wowza e Cinegy e Make.tv .

O SES desenvolveu um conjunto de serviços de mídia de nível de transmissão no Azure para seus clientes de serviços de mídia gerenciados e conectividade por satélite. O SES mostrará soluções para serviços de reprodução totalmente gerenciados, incluindo reprodução principal, reprodução localizada e detecção e substituição de anúncios e codificação ao vivo multicanal de alta qualidade 24x7 no Azure.

O SyncWords está disponibilizando sua tecnologia de automação de legendas e ferramentas baseadas na nuvem fáceis de usar no Azure. Essas ofertas tornarão mais fácil para as organizações de mídia adicionar recursos automatizados de legenda oculta e legendagem em idiomas estrangeiros aos fluxos de trabalho de processamento de vídeo offline e em tempo real no Azure.

A empresa global de serviços de design e tecnologia

Tata Elxsi integrou o TEPlay, sua plataforma OTT SaaS, ao Azure Media Services para fornecer conteúdo OTT a partir da nuvem. A Tata Elxsi também trouxe o FalconEye, sua solução de monitoramento de qualidade da experiência (QoE), focada em métricas e análises acionáveis, para o Microsoft Azure.

A Verizon Media está disponibilizando sua plataforma de streaming em versão beta no Azure. A Verizon Media Platform é uma solução OTT gerenciada de nível empresarial, incluindo DRM, inserção de anúncios, sessões personalizadas um a um, substituição dinâmica de conteúdo e entrega de vídeo. A integração traz fluxos de trabalho simplificados, suporte e escala globais e acesso a uma variedade de recursos exclusivos disponíveis no Azure.