A idéia de inteligência artificial há muito preocupa a humanidade. Os autômatos receberam muita atenção nos mitos da Grécia antiga, e o exemplo mais famoso é a mulher artificial Pandora, criada por Zeus. Golens místicos são encontrados na cultura judaica. E incríveis bonecas karakuri ocupam um lugar importante no épico japonês.

No século XVII, alguns filósofos ponderaram a possibilidade de "colocar a mente" em objetos inanimados. Muitas teorias foram apresentadas. Por exemplo, René Descartes acreditava no dualismo da mente e do corpo. Seus pontos de vista rejeitaram a possibilidade de mecanização da inteligência.

Leibniz tinha outras opiniões. Ele acreditava que todo pensamento humano pode ser representado matematicamente usando símbolos elementares. Para isso, ele propôs a Characteristica Universalis, o simbolismo dos conceitos necessários para a descrição do conhecimento.

Inteligência artificial e autômatos têm sido destaque na ficção desde tempos imemoriais. Um exemplo é o "Frankenstein, ou Modern Prometheus", de Mary Shelley, e o "Rossum Universal Robots", de Karel Chapek. Graças a eles, em 1921 a palavra "robô" apareceu na literatura.

Esses eram os pré-requisitos filosóficos para o surgimento da IA. Agora vamos falar sobre cientistas específicos e seus trabalhos, graças aos quais a inteligência artificial da ficção se tornou realidade. Uma história relativamente concreta e factual começou relativamente recentemente. O famoso teste de Turing foi realizado pela primeira vez em 1950, mas apenas seis anos depois, em 1956, a IA começou a se formar como uma disciplina separada. Vamos ver como foi.

Primeiros passos

O número de artigos científicos relacionados à inteligência artificial aumentou bastante nas décadas de 1950 e 1960. Porém, anteriormente, havia estudos afetando esse tópico. Bertrand Russell e Alfred North Whitehead publicaram Os Princípios da Matemática em 1913. Na mesma época, George Bull apresentou suas leis de pensamento . Então, os fundamentos da lógica matemática foram lançados.

Talvez tudo tenha começado no momento em que um garoto incompreensível de 15 anos entrou no escritório de Rudolf Karnap. Karnap já se tornou um filósofo influente e lecionou na Universidade de Chicago. Ele publicou A sintaxe lógica da linguagem. O menino veio sem permissão e indicou erros neste trabalho. Rudolph ficou chocado. O visitante era incomum. Além disso, ele nem se apresentou e imediatamente fugiu. Após meses de busca, Rudolph finalmente encontrou seu visitante em uma universidade local. Acabou sendo Walter Harry Pitts .

Três anos antes (sim, aos 12), Walter escreveu uma carta a Bertrand Russell, apontando os problemas encontrados nos Princípios acima mencionados. Russell ficou tão impressionado que convidou o garoto para se formar na Universidade de Cambridge, no Reino Unido. Walter, embora tenha crescido em uma família disfuncional, não se atreveu a se mudar de Detroit. No entanto, quando Russell chegou a Chicago para dar palestras, Pitts fugiu para casa para estudar com ele. Ele não se tornou aluno da Universidade de Chicago, mas participou diligentemente de palestras. (A vida de Walter Pitts é geralmente muito brilhante e interessante, apesar de sua curta duração. Recomendo a leitura por conta própria - aprox. Tradutor ).

Em 1942, Walter Pitts encontrou-se com Warren McCallock . McCullock convidou Pitts para ficar em sua casa. Eles estavam convencidos da correção da teoria de Leibniz , que sugeria a possibilidade de "mecanização" do pensamento humano. E eles tentaram criar um modelo para neurobiologia do sistema nervoso humano. Eles publicaram seu artigo principal sobre o mesmo em 1943, chamando-o de "O cálculo lógico de idéias relacionadas à atividade nervosa ". Este documento fez uma contribuição inestimável para o campo da inteligência artificial. Os cientistas propuseram um modelo simples conhecido como neurônio matemático McCullock-Pitts . Ela ainda está estudando em cursos de aprendizado de máquina. As idéias que os cientistas propuseram são a base de quase toda a IA moderna.

Warren McCallock e Walter Pitts

A cibernética de Norbert Weiner e a teoria da informação de Claude Shannon foram publicadas em 1948. A cibernética é um estudo de "controle e comunicação em um organismo vivo e em uma máquina". A teoria da informação é a medida da quantidade de informações, seu armazenamento e transmissão. Ambos os trabalhos tiveram um grande impacto na IA.

A cibernética forneceu um estudo direto da inteligência biológica e mecânica. E a teoria da informação influenciou a matemática básica.

Depois de alguns anos, Alan Turing realizou o teste de Turing . Ele descreveu um método para determinar se uma máquina é inteligente. Teste simplificado é o seguinte: uma pessoa se comunica com um computador e uma pessoa. Com base nas respostas às perguntas, ele deve determinar com quem está falando: uma pessoa ou um programa de computador. A tarefa de um programa de computador é enganar uma pessoa, forçando-a a fazer a escolha errada. ”

Embora o teste de Turing seja muito limitado para testar sistemas inteligentes modernos, foi um avanço real na época. O nome de Alan Turing chegou à imprensa, tornando a indústria mais popular.

Teste de Turing

Em 1956, foi realizada uma conferência em Dartmouth, com o tema de estudar os conceitos de "mecanização" da inteligência. Mais tarde, os participantes desta conferência se tornarão personalidades de destaque no campo da IA. O mais famoso foi Marvin Minsky , que em 1951 criou a primeira máquina de rede neural, SNARC. Ele se tornará o nome mais famoso do mundo da inteligência artificial nas próximas décadas.

Claude Shannon também participou da conferência. E o futuro ganhador do Nobel, Herbert A. Simon e Allen Newell, fizeram sua estréia com o seu “ Logic-Theorist ”. Posteriormente, ele resolverá 38 dos 52 primeiros teoremas dos Princípios de Matemática de Russell.

John McCarthy - também um dos pioneiros da inteligência artificial - cunhou o nome "Inteligência Artificial". Os participantes concordaram com este termo. Este foi o nascimento da IA.

Desenvolvimento da indústria (1956–1974)

Rede semântica

Graças a esta conferência, o interesse pela IA aumentou e muitos desenvolvimentos interessantes surgiram. Em 1959, Newell e Simon criaram o "Common Problem Solver", que teoricamente poderia resolver qualquer problema formalizado. E James Slagle criou um programa heurístico SAINT (Symbical Automatic INTegrator) que resolveu os problemas de integração simbólica no cálculo. Esses programas foram impressionantes.

Depois de criar o teste de Turing, a naturalidade do idioma tornou-se uma área importante da IA. O programa de Daniel Bobrow STUDENT foi capaz de resolver problemas de palavras no ensino médio. Um pouco mais tarde, apareceu o conceito de rede semântica - um mapa de vários conceitos e as relações entre eles (como na figura). Vários programas bem-sucedidos foram criados nessa rede. Em 1966, Joseph Weisenbaum criou a ELIZA. Um interlocutor virtual pode conduzir conversas realistas com as pessoas.

Em conexão com um desenvolvimento tão ativo da indústria de IA, os cientistas fizeram declarações extremamente ousadas:

- Newell e Simon, 1958: "Em 10 anos, o computador digital se tornará o campeão mundial de xadrez". E "dentro de 10 anos, um computador digital descobrirá e provará um novo teorema matemático importante".

- Simon GA, 1965: "As máquinas serão capazes de realizar qualquer trabalho que uma pessoa possa fazer por 20 anos".

- Marvin Minsky, 1967: "Em uma geração ... o problema de criar" inteligência artificial "será substancialmente resolvido".

- Marvin Minsky, 1970: "Em três a oito anos, teremos uma máquina com a inteligência geral de uma pessoa comum".

De uma forma ou de outra, o dinheiro entrou na indústria. O Escritório de Projetos de Pesquisa Avançada (ARPA, mais tarde renomeado DARPA) alocou US $ 2,2 milhões à equipe do MIT. O então presidente da DARPA decidiu que eles deveriam “financiar pessoas, não projetos” e criou uma cultura de pesquisa livre. Isso permitiu que os pesquisadores realizassem qualquer projeto que considerassem correto.

Arrefecimento temporário (1974-1980)

Em 1969, Marvin Minsky e Seymour Papert publicaram seu livro Perceptrons . Nele, eles mostraram as limitações fundamentais dos perceptrons e destacaram a incapacidade dos perceptrons em controlar o esquema elementar do XOR. Isso levou a uma mudança no interesse dos pesquisadores de inteligência artificial para a área de computação simbólica, que é oposta às redes neurais.

A abordagem alternativa da IA simbólica ganhou um crescimento explosivo. Mas essa abordagem não produziu resultados significativos. Na década de 1970, ficou claro que os pesquisadores de IA estavam excessivamente otimistas em relação à IA. Os objetivos que eles prometeram ainda não foram alcançados e sua conquista parecia ser uma questão de um futuro muito distante.

Os pesquisadores perceberam que descansam contra a parede. A IA foi aplicada a tarefas simples. Mas os cenários reais eram muito complexos para esses sistemas. O número de possibilidades que os algoritmos tiveram que explorar acabou sendo astronômico. Isso levou ao problema de uma explosão combinatória . E então surgiu a pergunta clássica "como tornar um computador inteligente". Era um problema de senso comum .

Tudo isso levou ao fato de os investidores estarem decepcionados com a tecnologia. Assim, o financiamento da IA desapareceu e a pesquisa cessou. A DARPA também não pôde mais apoiar uma cultura de pesquisa de hackers devido a mudanças na legislação. Os patrocinadores congelaram o financiamento de pesquisas no campo da inteligência artificial. Portanto, o período 1974-1980. chamado " IA de inverno ".

Renascimento

Em 1981, o governo japonês começou a investir seriamente em pesquisas no campo da inteligência artificial. O país destinou US $ 850 milhões para o projeto de computador de quinta geração. Ele pretendia desenvolver IA. Os supostos computadores tiveram que se comunicar, traduzir outras línguas, reconhecer imagens. Esperava-se que os computadores fossem a base para a criação de dispositivos que possam simular o pensamento.

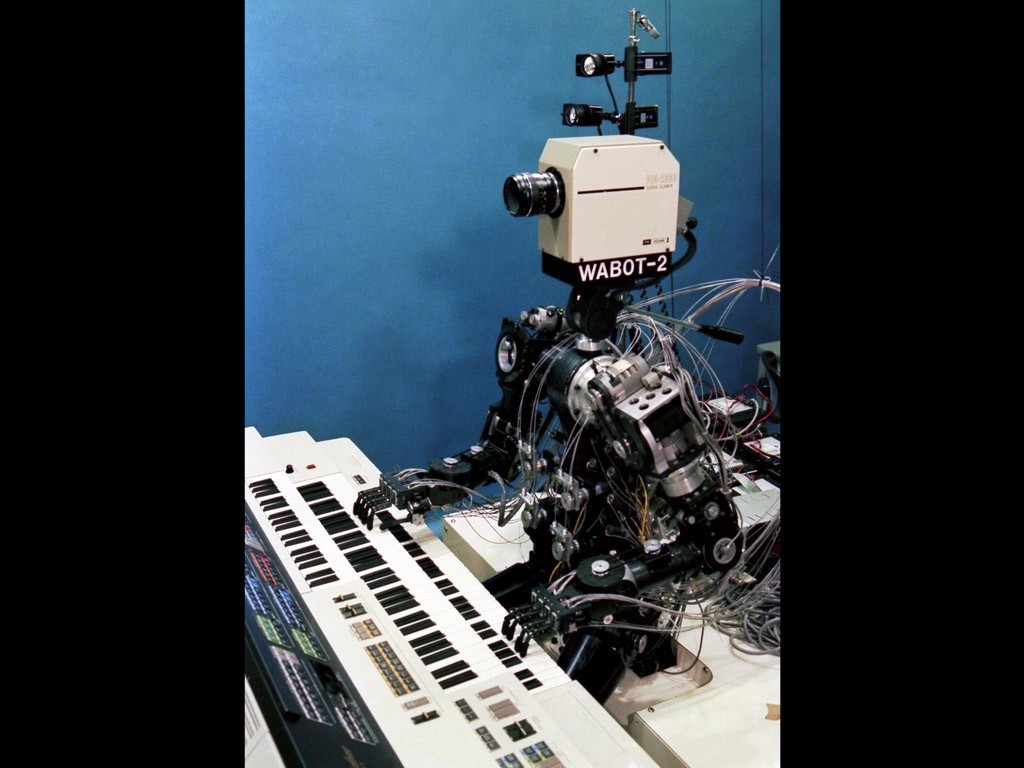

Wabot-2

Pesquisa no Japão parecia promissora. Em 1980, o robô Wabot-2 foi desenvolvido na Universidade de Waseda. Ele podia se comunicar com as pessoas, ler partituras e tocar o órgão eletrônico. O sucesso dos japoneses obrigou outros governos e empresas privadas a voltar o olhar para a IA novamente.

Nesse ponto, surgiu a questão do conexionismo. Em 1982, Hopfield criou uma nova forma de rede neural capaz de estudar e processar informações. Jeffrey Hinton e David Rumelhart popularizaram a auto-distinção inversa. Essa tecnologia foi fenomenal e permanece vital no aprendizado de máquina até hoje.

A IA obteve sucesso comercial na forma de "sistemas especialistas". Esses sistemas tinham um conhecimento profundo de um tópico específico. A Universidade Carnegie Mellon (CMU) lançou um sistema especialista chamado XCON em 1980. Foi usado na Digital Equipment Corporation. Até 1986, a empresa economizava US $ 40 milhões anualmente.

Segundo inverno

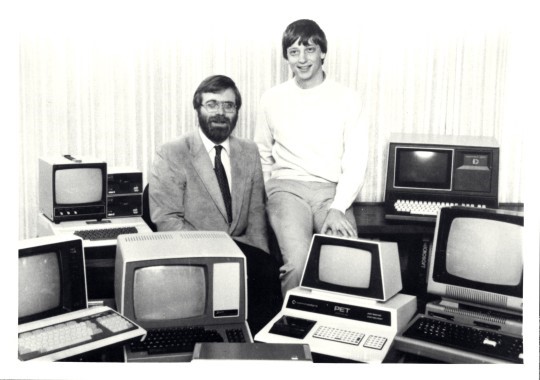

A revolução do PC mudou o curso do desenvolvimento da IA

No final dos anos 80, o sucesso da indústria de IA foi ofuscado pela revolução dos computadores. Apple e IBM produziram computadores cada vez mais poderosos ao mesmo tempo. Os computadores de mesa se tornaram mais baratos e mais poderosos que as máquinas Lisp de inteligência artificial. Uma indústria inteira no valor de meio bilhão de dólares foi destruída em uma noite. Os sucessos da IA em sistemas especializados, como a máquina XCON, provaram ser muito caros.

Há problemas com sistemas especializados. Eles não podiam aprender. Eles eram "frágeis" (ou seja, poderiam cometer erros graves se recebessem dados incomuns). O escopo prático dos sistemas especialistas tornou-se limitado. A nova liderança da DARPA decidiu que a IA não é a “próxima onda”. E redirecionou investimentos para projetos que, do ponto de vista deles, deveriam trazer resultados imediatos.

Em 1991, os objetivos de um projeto de computador no Japão não haviam sido alcançados. Os cientistas subestimaram as dificuldades que tiveram que enfrentar. Mais de 300 empresas de IA fecharam, faliram ou foram compradas até o final de 1993. Na verdade, foi o fim da primeira onda de uso comercial de inteligência artificial.

Fluxo fresco

Quando os ecos da revolução dos computadores começaram a diminuir, as pessoas tiveram a oportunidade de usar grande poder de computação. Com a onipresença dos computadores, o número de bancos de dados diversos aumentou. Foi tudo muito legal em termos de desenvolvimento de IA.

Novas tecnologias resolveram problemas e removeram barreiras que interferiam nos cientistas. Usando o poder crescente da computação, os pesquisadores expandiram os limites do possível. Dos bancos de dados que se tornaram Big Data, foi possível extrair cada vez mais conhecimento. As possibilidades para o uso prático da IA tornaram-se mais aparentes.

Um novo conceito chamado " agente inteligente " foi estabelecido na década de 1990. O Intelligent Agent (IA) é um sistema que executa independentemente a tarefa emitida pelo usuário por longos períodos de tempo. Havia uma esperança de que um dia seremos capazes de ensinar a IA a interagir uns com os outros. Isso levaria à criação de sistemas universais e mais "inteligentes".

Na comunidade da IA, diferentes opiniões sobre o uso da matemática no campo da inteligência artificial vagaram. Alguns achavam que a inteligência era complexa demais para ser descrita com símbolos matemáticos. Na sua opinião, as pessoas raramente são guiadas pela lógica ao tomar decisões. Seus oponentes objetaram que as cadeias lógicas são o caminho a seguir.

G. Kasparov brinca com Deep Blue

Muito em breve, em 1997, o supercomputador IBM Deep Blue derrotou Garry Kasparov. Naquele momento, Kasparov era o campeão mundial de xadrez. De acordo com Newell e Simon, o que deveria acontecer em 1968, finalmente aconteceu em 1997.

Os computadores modernos de xadrez são muito mais fortes do que qualquer pessoa. A classificação Elo mais alta já alcançada por humanos é 2.882. Para computadores, o número mais comum é de 3.000 Elo. O maior já registrado foi acima de 3.350.

Em 2005, Stanford desenvolveu um robô para direção autônoma. Ele venceu o DARPA Grand Challenge dirigindo 211 km por uma trilha inexplorada do deserto.

Jeopardy

Em fevereiro de 2011, a IBM decidiu testar seu IBM Watson no questionário Jeopardy. O computador foi capaz de derrotar os dois maiores campeões do Jeopardy por uma margem significativa.

Com o desenvolvimento de avalanche da Internet e das redes sociais, a quantidade de informações aumentou. As empresas de TI precisavam fazer algo com os dados recebidos. E o uso da IA se tornou uma necessidade, não um entretenimento.

Agora, o Google classifica os SERPs usando o Machine Learning. O YouTube seleciona vídeos recomendados usando algoritmos ML, recomenda produtos da Amazon da mesma maneira. O feed de notícias do Facebook é gerado por um computador inteligente. E mesmo o Tinder encontra pessoas usando algoritmos ML.

Graças à revolução dos computadores, a tecnologia da IA se tornou nossa ferramenta indispensável. E agora a humanidade está ansiosa, esperando a criação de super máquinas. E embora os efeitos da inteligência artificial às vezes sejam controversos, o desenvolvimento adicional dessa tecnologia é inevitável.

O que mais é útil para ler no blog do Cloud4Y

→ O computador vai te deixar gostoso

→ IA ajuda a estudar animais na África

→ O verão está quase no fim. Quase nenhum dado vazou

→ 4 maneiras de economizar em backups na nuvem

→ IoT, nevoeiro e nuvens: fale sobre tecnologia?

Assine o nosso canal Telegram para não perder outro artigo! Escrevemos não mais do que duas vezes por semana e apenas a negócios.