Ao longo de sua história, dos primeiros robôs de Asimov ao AlphaGo, a IA teve altos e baixos. Mas, de fato, sua história está apenas começando.

A inteligência artificial ainda é muito jovem. No entanto, muitos eventos significativos já ocorreram nesta área. Alguns deles atraíram a atenção da cultura, outros geraram uma onda de explosão, percebida apenas pelos cientistas. Aqui estão alguns pontos-chave que tiveram o maior impacto na IA.

1. Isaac Asimov mencionou pela primeira vez as " Três Leis da Robótica " (1942)

A história de Azimov "

Round dance " marca a primeira aparição nas histórias deste famoso escritor de ficção científica das "três leis da robótica":

- Um robô não pode prejudicar uma pessoa ou, por inação, permitir que uma pessoa seja prejudicada.

- Um robô deve obedecer a todas as ordens dadas por uma pessoa, exceto nos casos em que essas ordens sejam contrárias à Primeira Lei.

- O robô deve cuidar de sua segurança na medida em que não contradiga a Primeira ou a Segunda Lei.

Na história "Round dance", o robô Speedy é colocado em uma posição em que a terceira lei está em conflito com as duas primeiras. As histórias de Azimov sobre robôs fizeram os fãs da NF pensarem, incluindo cientistas, sobre a possibilidade de pensar em máquinas. Até hoje, as pessoas se envolvem em exercícios intelectuais, aplicando as leis de Asimov à IA moderna.

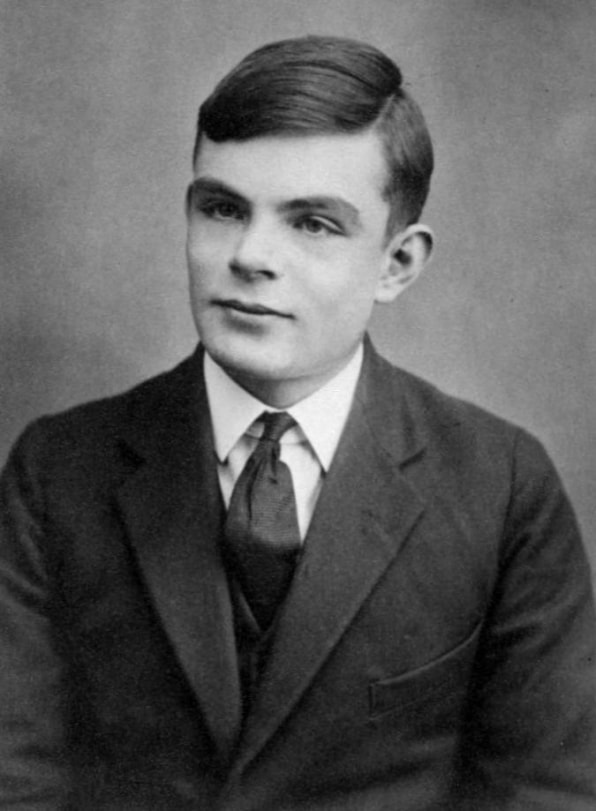

2. Alan Turing propôs seu "Jogo da Imitação" (1950)

Alan Turing descreveu o primeiro princípio de medir o grau de racionalidade de uma máquina em 1950.

Alan Turing descreveu o primeiro princípio de medir o grau de racionalidade de uma máquina em 1950.Proponho considerar a pergunta "Os carros podem pensar?" Assim começou o influente trabalho de pesquisa de Turing de 1950, que desenvolveu um sistema de crenças para raciocinar sobre a mente da máquina. Ele perguntou se uma máquina pode ser considerada inteligente se pode imitar o comportamento humano.

Essa questão teórica deu origem ao famoso "Jogo de Simulação" [mais tarde será chamado de "

Teste de Turing " / aprox. transl.], um exercício no qual uma pessoa-pesquisador deve determinar com quem se correspondeu - com um computador ou uma pessoa. Na época de Turing, não havia máquinas capazes de passar neste teste; não existem hoje. No entanto, seu teste deu uma maneira simples de determinar se a mente estava no carro. Ele também ajudou a moldar a filosofia da IA.

3. Conferência de AI de Dartmouth (1956)

Em 1955, cientistas de todo o mundo já haviam formado conceitos como redes neurais e linguagem natural, mas ainda não havia conceitos unificadores que abrangem várias variedades de inteligência de máquina. John McCarthy, professor de matemática no Dartmouth College, cunhou o termo "inteligência artificial" para reuni-los.

McCarthy liderou o grupo que solicitou um subsídio para organizar uma conferência de IA em 1956. Muitos pesquisadores importantes da época foram convidados para Dartmouth Hall no verão de 1956. Os cientistas discutiram várias áreas potenciais do estudo de IA, incluindo aprendizado e pesquisa, visão, raciocínio lógico, linguagem e razão, jogos (em particular xadrez), interações humanas com máquinas inteligentes, como robôs pessoais.

O consenso geral dessas discussões foi que a IA tem um tremendo potencial para beneficiar as pessoas. O campo geral das áreas de pesquisa, cujo desenvolvimento pode ser influenciado pela inteligência das máquinas, foi descrito. A conferência organizou e inspirou a pesquisa em IA por muitos anos.

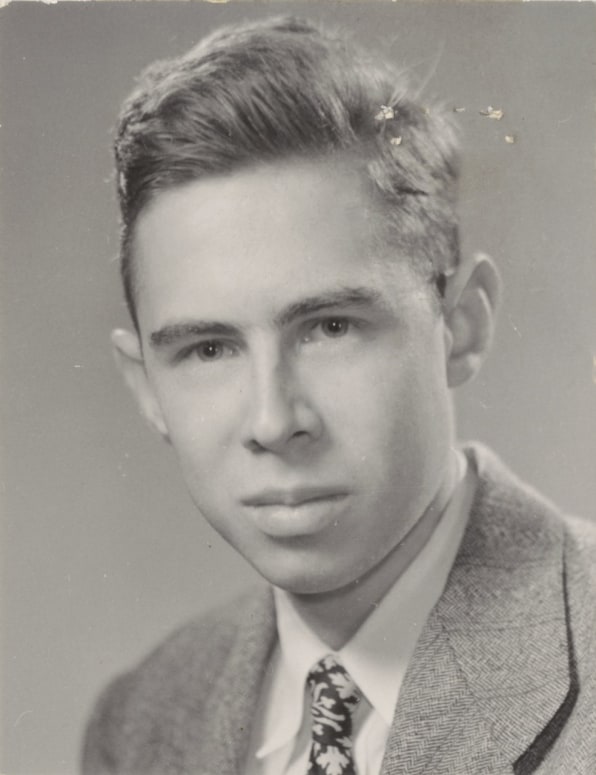

4. Frank Rosenblatt cria o perceptron (1957)

Frank Rosenblatt criou uma rede neural mecânica no Cornell Aeronautics Laboratory em 1957

Frank Rosenblatt criou uma rede neural mecânica no Cornell Aeronautics Laboratory em 1957O componente básico da rede neural é chamado de "

perceptron " [este é apenas o

primeiro e primitivo tipo de neurônio artificial / aprox. transl.]. Um conjunto de dados de entrada cai no nó que calcula o valor de saída e fornece uma classificação e nível de confiança. Por exemplo, os dados de entrada podem analisar vários aspectos da imagem com base nos dados de entrada e no "voto" (com um certo nível de confiança) para saber se há uma face nela. Então, o nó conta todas as "vozes" e o nível de confiança e fornece consenso. Nas redes neurais de hoje, rodando em computadores poderosos, bilhões de estruturas semelhantes estão trabalhando juntas.

No entanto, os perceptrons existiam mesmo antes do advento de computadores poderosos. No final da década de 1950, um jovem pesquisador psicólogo Frank Rosenblatt criou um modelo eletromecânico do perceptron chamado Mark I Perceptron, que é armazenado hoje na Smithsonian Institution. Era uma rede neural analógica, composta por uma rede de elementos fotossensíveis conectados por fios a bancos de nós contendo motores elétricos e resistores rotativos. Rosenblatt desenvolveu o “algoritmo perceptron”, que controlava a rede, que gradualmente ajustava a força dos sinais de entrada para que, como resultado, os objetos fossem identificados corretamente - na verdade, ele era treinado.

Os cientistas discutiram sobre a importância dessa máquina até os anos 80. Ela desempenhou um papel importante na criação da personificação física da rede neural, que até então existia principalmente na forma de um conceito científico.

5. A AI enfrenta seu primeiro inverno (década de 1970)

Durante a maior parte de sua história, a IA existiu apenas em pesquisa. Durante grande parte da década de 1960, as agências governamentais, em particular a DARPA, investiram dinheiro em pesquisa e praticamente não exigiram um relatório de investimento. Pesquisadores de IA geralmente exageram o potencial de seu trabalho para continuar recebendo financiamento. Tudo mudou no final da década de 1960 e no início da década de 1970. Dois relatórios - um do Conselho Consultivo da ALPAC para o governo dos EUA em 1966 e o segundo da Lighthill para o governo britânico em 1973 - avaliaram pragmaticamente o progresso da pesquisa em IA e deram uma previsão muito pessimista sobre o potencial dessa tecnologia. Ambos os relatórios questionaram a existência de progresso tangível em várias áreas da pesquisa em IA. Lighthill em seu relatório argumentou que a IA para tarefas de reconhecimento de fala seria extremamente difícil de ser dimensionada para tamanhos que poderiam ser úteis ao governo ou às forças armadas.

Como resultado, os governos dos Estados Unidos e da Grã-Bretanha começaram a cortar fundos para a pesquisa em IA para universidades. A DARPA, que financiou a pesquisa de IA sem problemas nos anos 60, começou a exigir prazos claros dos projetos e uma descrição detalhada dos resultados esperados. Como resultado, começou a parecer que a IA não correspondia às expectativas e nunca poderia atingir o nível das capacidades humanas. O primeiro "inverno" da IA durou todas as décadas de 1970 e 80.

6. A chegada do segundo inverno da IA (1987)

A década de 1980 começou com o desenvolvimento e os primeiros sucessos de "

sistemas especialistas " que armazenavam grandes quantidades de dados e emulavam o processo de tomada de decisão pelas pessoas. A tecnologia foi originalmente desenvolvida na Universidade Carnegie Mellon para a Digital Equipment Corporation e, em seguida, outras empresas começaram a implementá-la rapidamente. No entanto, sistemas especialistas exigiam equipamentos especializados caros, e isso se tornou um problema quando energia semelhante e estações de trabalho mais baratas da Sun Microsystems, bem como computadores pessoais da Apple e IBM começaram a aparecer. O mercado de sistemas de computadores especializados entrou em colapso em 1987, quando os principais fabricantes de equipamentos o deixaram.

O sucesso dos sistemas especialistas no início dos anos 80 inspirou a DARPA a aumentar o financiamento para a pesquisa em IA, mas logo mudou novamente e a agência reduziu a maior parte desse financiamento, deixando apenas alguns programas. Novamente, o termo “inteligência artificial” na comunidade de pesquisa tornou-se quase proibido. Para que não fossem percebidos como sonhadores impraticáveis em busca de financiamento, os pesquisadores começaram a usar outros nomes para trabalhos relacionados à SS - “ciência da computação”, “aprendizado de máquina” e “analítica”. Este segundo inverno da IA continuou até os anos 2000.

7. IBM Deep Blue vence Kasparov (1997)

A IBM Deep Blue derrotou o melhor jogador de xadrez do mundo, Garry Kasparov, em 1997.

A IBM Deep Blue derrotou o melhor jogador de xadrez do mundo, Garry Kasparov, em 1997.A conscientização pública da IA melhorou em 1997, quando o computador de xadrez Deep Blue da IBM derrotou o então campeão mundial Garry Kasparov. Dos seis jogos realizados no estúdio de televisão, o Deep Blue venceu em dois, Kasparov em um e três terminaram empatados. No início daquele ano, Kasparov derrotou a versão anterior do Deep Blue.

O computador Deep Blue tinha poder computacional suficiente e utilizou o "método de força bruta", ou pesquisa exaustiva, avaliando 200 milhões de movimentos possíveis por segundo e escolhendo o melhor. As habilidades das pessoas estão limitadas a avaliar apenas cerca de 50 movimentos após cada movimento. O trabalho do Deep Blue foi semelhante ao trabalho da IA, mas o computador não pensou em estratégias e não aprendeu o jogo, como os sistemas que o seguiram poderiam fazer.

No entanto, a vitória do Deep Blue sobre Kasparov retornou impressionantemente a IA ao círculo da atenção do público. Algumas pessoas ficaram fascinadas. Outros não gostaram que a máquina vencesse um especialista em xadrez. Os investidores ficaram impressionados: a vitória de US $ 10 da Deep Blue aumentou o valor das ações da IBM, levando-as ao máximo desse tempo.

8. Rede neural vê gatos (2011)

Em 2011, cientistas de universidades de todo o mundo conversaram sobre redes neurais e as criaram. O programador do Google

Jeff Dean conheceu o professor de TI de Stanford,

Andrew Eun, naquele ano. Juntos, eles conceberam a criação de uma grande rede neural, fornecida pelo enorme poder de computação dos servidores do Google, que poderia alimentar um enorme conjunto de imagens.

A rede neural que eles criaram trabalhava em 16.000 processadores de servidor. Eles forneceram a ela 10 milhões de quadros aleatórios e sem rótulo de vídeos do YouTube. Dean e Eun não pediram à rede neural para fornecer informações específicas ou para marcar essas imagens. Quando uma rede neural funciona dessa maneira, aprendendo sem um professor, ela naturalmente tenta encontrar padrões nos dados e formar classificações.

A rede neural processou as imagens por três dias. Em seguida, ela produziu três imagens borradas, indicando imagens visuais que encontrava repetidamente nos dados de treinamento - o rosto de uma pessoa, o corpo de uma pessoa e um gato. Este estudo foi um grande avanço no uso de redes neurais e aprendizado de não professores em visão computacional. Também marcou o início do projeto Google Brain.

9. Joffrey Hinton lançou redes neurais profundas (2012)

A pesquisa de Joffrey Hinton reavivou o interesse pela aprendizagem profunda

A pesquisa de Joffrey Hinton reavivou o interesse pela aprendizagem profundaUm ano após o avanço, Dean e Un, professor da Universidade de Toronto, Joffrey Hinton, e dois de seus alunos criaram uma rede neural para visão computacional, AlexNet, para participar do concurso de reconhecimento de imagem ImageNet. Os participantes tiveram que usar seus sistemas para processar milhões de imagens de teste e identificá-las com a maior precisão possível. AlexNet venceu a competição com uma porcentagem de erros duas vezes e meia menor que a do competidor mais próximo. Em cinco versões da legenda da imagem fornecidas pela rede neural, apenas em 15,3% dos casos não houve opção correta. O registro anterior foi de 26% dos erros.

Essa vitória mostrou de maneira convincente que redes neurais profundas rodando em GPUs, onde melhores que outros sistemas, podem determinar e classificar imagens com precisão. Esse evento, talvez mais do que outros, influenciou o reavivamento do interesse em redes neurais profundas e deu a Hinton o apelido de "padrinho da aprendizagem profunda". Juntamente com outros gurus da IA, Yoshua Benjio e Jan Lekun, Hinton recebeu o tão esperado Prêmio Turing em 2018.

10. AlphaGo vence o campeão mundial em go (2016)

Em 2013, pesquisadores da startup britânica DeepMind publicaram um artigo descrevendo como uma rede neural aprendeu a jogar e vencer em 50 jogos antigos da Atari. Impressionado com isso, o Google comprou a empresa por US $ 400 milhões, mas a fama principal do DeepMind ainda estava à frente.

Alguns anos depois, cientistas do DeepMind, agora dentro da estrutura do Google, passaram dos jogos da Atari para uma das mais antigas tarefas de IA - o jogo de tabuleiro japonês. Eles desenvolveram a rede neural AlphaGo, capaz de jogar e aprender enquanto joga. O programa realizou milhares de jogos contra outras versões do AlphaGo, aprendendo com perdas e vitórias.

E funcionou. O AlphaGo derrotou o melhor jogador do mundo,

Lee Sedola , por 4-1 em uma série de jogos em março de 2016. O processo foi filmado para um documentário. Ao vê-lo, é difícil não notar a tristeza com que Sedol percebeu a perda. Parecia que todas as pessoas estavam perdidas, e não apenas uma pessoa.

Os recentes avanços no campo das redes neurais profundas mudaram tanto o campo da IA que sua história real, talvez, esteja apenas começando. Estamos aguardando muitas esperanças, entusiasmo e impaciência, mas agora está claro que a IA afetará todos os aspectos da vida no século XXI - e talvez até mais do que a Internet ao mesmo tempo.