Resolver problemas de radiação foi um "ponto de virada na história da eletrônica espacial"

Phobos-Grunt

Phobos-Grunt , um dos projetos espaciais mais ambiciosos da Rússia moderna, caiu no oceano no início de 2012. Esta nave espacial deveria pousar na superfície da surda lua marciana Phobos, coletar amostras de solo e trazê-las de volta para a Terra. Mas, em vez disso, ele ficou desamparado por várias semanas em

baixa órbita terrestre (DOE) devido à falha do computador de bordo antes de dar partida nos motores, que deveriam enviar o navio para Marte.

Em um

relatório subseqüente

, as autoridades russas culparam partículas carregadas pesadas em raios cósmicos galácticos que colidiram com os chips SRAM e causaram a falha do chip devido à corrente excessiva fluindo através dele. Para lidar com esse problema, os dois processadores em execução no computador, o computador, iniciaram uma reinicialização. Depois disso, a sonda entrou no modo de espera segura para comandos da Terra. Infelizmente, nenhuma instrução foi recebida.

As antenas de comunicação deveriam atingir o modo de operação de design após o navio deixar o DOE. No entanto, ninguém previu a recusa, por causa da qual a sonda não teria atingido esse estágio. Após uma colisão com partículas, Phobos-Grunt estava em um estranho impasse. A partida dos motores a bordo deveria acionar a implantação de antenas. Os motores só podiam ser iniciados com um comando da Terra. E esse comando não pôde vir, porque as antenas não foram implantadas. O erro do computador levou ao colapso da missão, que estava se preparando por várias décadas. Em particular, os membros da equipe de ONGs são os responsáveis pela supervisão. Lavochkin, o fabricante do dispositivo. Durante o desenvolvimento, foi mais fácil listar o que estava funcionando no computador do que o que não estava funcionando. No entanto, todos os pequenos erros que cometeram se tornaram um lembrete brutal de que o desenvolvimento de computadores de classe espacial é terrivelmente complicado. Depois que você tropeça, e bilhões de dólares são queimados.

Os desenvolvedores simplesmente subestimaram as dificuldades dos computadores no espaço.

O que é tão lento?

O Curiosity, o amado veículo todo-o-terreno marciano, roda em dois processadores BAE RAD750 com uma frequência de clock de até 200 MHz. Possui 256 Mb de RAM e um SSD de 2 Gb. Na véspera de 2020, o RAD750 é o mais avançado processador de classe espacial de núcleo único. Hoje é o melhor que podemos enviar para o espaço profundo.

Infelizmente, porém, comparado ao smartphone em nosso bolso, o desempenho do RAD750 só pode causar pena. Seu circuito é baseado no PowerPC 750, um processador que a IBM e a Motorola introduziram em 1997 como rival do Intel Pentium II. Isso significa que o equipamento espacial tecnologicamente mais avançado disponível no espaço atualmente pode lançar o primeiro Starcraft (1998) sem problemas; no entanto, ele terá problemas diante de algo mais exigente em termos de poder de computação. Esqueça jogar Marte em Crysis.

Ao mesmo tempo, o RAD750 custa cerca de US $ 200.000. Mas você não pode simplesmente instalar o seu iPhone e acabar com ele? Em termos de velocidade, os iPhones, por várias gerações, deixaram o RAD750 e custaram apenas US $ 1.000 cada, o que é muito menos que US $ 200.000. A equipe Phobos-Grunt tentou fazer algo semelhante. Eles tentaram aumentar a velocidade e economizar, mas no final foram longe demais.

O chip de memória Phobos Grunt SRAM, danificado por partículas carregadas pesadas, foi identificado como WS512K32V20G24M. Ele era bem conhecido na indústria espacial, porque em 2005 esses chips foram

testados no acelerador de partículas no Laboratório Nacional Brookhaven por T. Page e J. Benedetto para testar como eles se comportam quando expostos à radiação. Os pesquisadores descreveram esses chips como "extremamente vulneráveis" e suas falhas ocorreram mesmo com a exposição mínima à energia disponível em Brookhaven. O resultado não foi surpreendente, uma vez que o WS512K32V20G24M não foi projetado para o espaço. Eles foram desenvolvidos para a aviação militar. No entanto, eles eram mais fáceis de encontrar e mais baratos que os chips de memória de classe espacial, então os desenvolvedores do Phobos-Grunt decidiram pegá-los.

"A descoberta da presença de vários tipos de radiação no espaço se tornou um dos pontos de viragem mais importantes na história da eletrônica espacial, juntamente com a compreensão do efeito dessa radiação na eletrônica e o desenvolvimento de tecnologias de fortalecimento de chips e redução de danos", disse Tyler Lovely, pesquisador do laboratório de pesquisa da Força Aérea dos EUA. As principais fontes dessa radiação são os raios cósmicos, os processos solares e os cinturões de prótons e elétrons localizados nos limites do campo magnético da Terra, conhecido como o

cinturão de radiação de Van Allen . Das partículas que colidem com a atmosfera da Terra, 89% são prótons, 9% são partículas alfa, 1% são núcleos mais pesados, 1% são elétrons livres. Sua energia pode atingir 10

19 eV. Usar chips que não são adequados para o espaço em uma sonda que precisa percorrer o espaço por vários anos significa pedir problemas. O jornal Krasnaya Zvezda

escreveu que 62% dos chips usados no Phobos-Grunt não se destinam ao uso no espaço. O esquema da sonda para 62% consistia no sentimento "vamos estragar um iPhone lá".

A radiação se torna um problema

Hoje, os raios cósmicos são um dos principais fatores levados em consideração ao criar computadores de classe espacial. Mas esse nem sempre foi o caso.

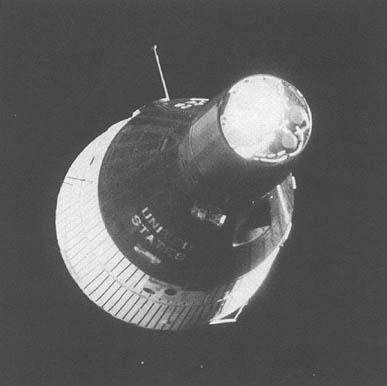

O primeiro computador entrou no espaço a bordo de um dos veículos Gemini na década de 1960. Para obter permissão para pilotar, eu tive que passar por mais de cem testes diferentes. Os engenheiros testaram como se comporta em resposta a vibrações, vácuo, temperaturas extremas e assim por diante. Nenhum desses testes levou em consideração os efeitos da radiação. E, no entanto, o computador de bordo "Gemini" funcionou muito bem, sem problemas. Isso porque ele era grande demais para recusar. Literalmente. Até 19,5 KB de memória estavam contidos em uma caixa de

11 litros e pesavam 12 kg . E o computador inteiro pesava 26 kg.

Na indústria de computadores, o progresso do processador normalmente é reduzir o tamanho dos componentes e aumentar a velocidade do clock. Tornamos os transistores cada vez menores, passando de 240 nm para 65 nm, depois para 14 nm e já para 7 nm, para smartphones modernos. Quanto menor o transistor, menor a tensão necessária para ligá-lo e desligá-lo. Portanto, a radiação praticamente não afetou os antigos processadores com grandes componentes - mais precisamente, os chamados

distúrbios solitários . A voltagem criada pela colisão com a partícula era muito pequena para afetar a operação de um computador suficientemente grande. Mas quando as pessoas que aspiravam ao espaço começaram a reduzir o tamanho dos componentes para empurrar mais transistores por chip, as partículas criadas pela tensão se tornaram suficientes para causar problemas.

Mais comumente, os engenheiros para melhorar o desempenho dos processadores aumentam sua velocidade de clock. Na Intel 386SX, sob cujo controle a automação trabalhava na cabine de controle do ônibus espacial, ela trabalhava a uma frequência de 20 MHz. Os processadores modernos no pico podem atingir até 5 GHz. A frequência do relógio determina o número de ciclos de processamento que o processador é capaz por unidade de tempo. O problema da radiação é que uma colisão com uma partícula pode arruinar os dados na memória do processador (cache L1 ou L2) por um curto período de tempo. Acontece que a cada segundo uma partícula carregada tem um número limitado de oportunidades para criar problemas. Nos processadores com uma pequena velocidade de clock, esse número era bastante pequeno. Porém, com o aumento da frequência, o número desses instantes de tempo em um segundo aumentou, o que tornou os processadores mais sensíveis à radiação. Portanto, os processadores com maior resistência à radiação são quase sempre mais lentos que os comerciais. A principal razão pela qual os processadores cósmicos funcionam tão lentamente é porque quase todos os métodos que podem acelerar os tornam mais vulneráveis.

Felizmente, esse problema pode ser contornado.

Lidamos com radiação

"Anteriormente, a radiação era minimizada por um processo de semicondutor modificado", diz Roland Weigand, engenheiro VISI / ASIC da Agência Espacial Européia. "Foi o suficiente para pegar o núcleo comercial do processador e aplicar um processo que aumenta a resistência à radiação". Essa tecnologia de proteção contra radiação de fabricação usava materiais como safira ou arseneto de gálio, que não reagiam tanto à radiação, diferentemente do silício. Os processadores fabricados dessa maneira funcionavam bem em ambientes com alta radiação, por exemplo, no espaço, mas para sua produção era necessário reequipar toda a fábrica.

“Para aumentar o desempenho, tive que usar processadores cada vez mais avançados. Dado o custo de uma moderna fábrica de semicondutores, mudanças especiais no processo de fabricação deixaram de ser práticas para um nicho de mercado como o espaço ”, diz Weigand. Como resultado, isso forçou os engenheiros a usar processadores comerciais sujeitos a distúrbios únicos. "Para reduzir esse efeito, tivemos que mudar para outras tecnologias para aumentar a resistência à radiação - o que chamamos de proteção contra radiação projetada", acrescenta Weigand.

A proteção do projeto permitiu que os fabricantes usassem o processo de fabricação CMOS padrão. Esses processadores de classe espacial podem ser produzidos em fábricas comerciais, reduzindo o custo para um razoável e permitindo que os desenvolvedores de missões espaciais acompanhem um pouco as ofertas comerciais. A radiação foi tratada com o gênio da engenharia, e não apenas as propriedades físicas do material. "Por exemplo, a redundância modular tripla (TMI) é uma das maneiras mais populares de proteger um chip da radiação; em outros aspectos, é completamente padrão", explicou Weigand. "Três cópias idênticas de cada informação são mantidas na memória o tempo todo." No estágio de leitura, todos os três são lidos e a versão correta é escolhida pela maioria. ”

Se todas as três cópias forem iguais, as informações serão consideradas corretas. O mesmo acontece quando duas cópias são iguais e uma difere delas - a cópia correta é escolhida pela maioria dos votos. Mas quando todas as três cópias são diferentes, o sistema registra um erro. A idéia é armazenar as mesmas informações em três endereços de memória diferentes, localizados em três locais diferentes no chip. Para estragar os dados, duas partículas devem colidir simultaneamente com os locais onde são armazenadas duas cópias da mesma partícula de informação, o que é extremamente improvável. A desvantagem dessa abordagem é a disponibilidade de trabalho redundante para o processador. Ele precisa fazer cada operação três vezes, o que significa que ele atingirá apenas um terço de sua velocidade.

Portanto, a idéia mais recente veio para aproximar ainda mais o desempenho dos processadores de classe espacial de seus equivalentes comerciais. Em vez de proteger todo o sistema em um chip da radiação, os engenheiros decidem onde essa proteção é mais relevante. E onde você pode recusar? Isso altera significativamente as prioridades de design. Os processadores espaciais mais antigos eram insensíveis à radiação. Os novos processadores são sensíveis a isso, mas foram projetados para lidar automaticamente com todos os erros que a radiação pode causar.

Por exemplo, o LEON GR740 é o mais recente processador de classe espacial da Europa. Espera-se que ele experimente 9 distúrbios únicos por dia enquanto estiver na órbita geoestacionária da Terra. O truque é que todos eles serão retidos pelo sistema e não levarão a erros operacionais. O GR740 foi projetado para que um erro funcional não ocorra mais de uma vez a cada 300 anos. E mesmo neste caso, ele pode simplesmente reiniciar.

Europa escolhe abertura

A linha LEON SPARC de processadores de classe espacial é a escolha mais popular da Europa para aplicações espaciais. "Na década de 90, quando a especificação SPARC foi escolhida, ela estava profundamente embutida no setor", diz Weigand. "A Sun Microsystems o utilizou em suas estações de trabalho de sucesso." Segundo ele, os principais motivos da transição para o SPARC foram o suporte de software e a abertura da plataforma. “Arquitetura aberta significava que todos poderiam usá-la sem problemas de licenciamento. Isso foi importante porque em um nicho tão restrito quanto o espaço, o custo das licenças é distribuído entre um pequeno número de dispositivos, o que aumenta seriamente o custo ”, explica ele.

Como resultado, a ESA aprendeu com uma experiência amarga com problemas de licenciamento. O primeiro processador SPARC espacial europeu - ERC32, usado até hoje - usava processadores comerciais. Foi baseado em uma arquitetura aberta, mas o circuito do processador era proprietário. “Isso levou a problemas. Geralmente, não há acesso aos códigos-fonte dos sistemas proprietários, por isso é difícil fazer alterações no projeto que são necessárias para aprimorar a proteção contra radiação ", diz Weigand. Portanto, na próxima etapa, a ESA começou a trabalhar em seu próprio processador, LEON. "O projeto dele estava completamente sob nosso controle e finalmente tivemos a oportunidade de usar todas as tecnologias de proteção contra radiação que desejávamos".

O mais recente desenvolvimento da linha de processadores LEON é o GR740 de quatro núcleos, operando a uma frequência de cerca de 250 MHz. (Weigand diz que espera que os primeiros embarques sejam entregues até o final de 2019). O GR740 é

fabricado usando a tecnologia de processo de 65 nm . Este é um sistema baseado em chip projetado para computação de alta velocidade de uso geral com base na arquitetura SPARC32. “O objetivo de criar o GR740 era alcançar maior velocidade e a capacidade de adicionar dispositivos adicionais ao circuito integrado, mantendo a compatibilidade com os processadores europeus de classe espacial anteriores”, diz Weigand. Outra característica do GR740 é o seu avançado sistema de tolerância a falhas. O processador pode lidar com um número significativo de erros causados pela radiação e ainda garantir a operação ininterrupta do software. Cada unidade e função GR740 são otimizadas para a velocidade mais alta. Isso significa que os componentes sensíveis a distúrbios únicos são adjacentes a outros que podem lidar facilmente com isso. E todos os componentes sensíveis são usados em um circuito que reduz o efeito de erros por meio de redundância.

Por exemplo, alguns gatilhos no GR740 são CORFIBs comerciais regulares. Eles foram escolhidos para uso neste chip porque ocupam menos espaço, aumentando assim a densidade computacional. A desvantagem é que eles estão sujeitos a distúrbios únicos, mas descobriram isso com a ajuda de blocos de TMI. Cada informação lida nesses gatilhos é confirmada votando entre todos os módulos localizados o suficiente para que um evento não afete vários bits. Esquemas semelhantes são implementados para caches de processador L1 e L2, consistindo em células SRAM, também sujeitas a distúrbios únicos. Quando esses esquemas começaram a influenciar muito o desempenho, os engenheiros da ESA mudaram para os gatilhos SKYROB resistentes a perturbações. No entanto, eles ocupam o dobro do espaço que o CORELIB. Ao tentar aumentar o poder de computação dos computadores no espaço, você sempre precisa fazer alguns compromissos.

Até agora, o GR740 passou por vários testes de radiação muito bem. O chip foi queimado com íons pesados com

transferência linear de energia (LET), atingindo 125 MeV * cm

2 / mg, e eles funcionaram sem uma única falha. Para ter algo para comparar, os próprios chips SRAM, devido aos quais o Phobos-Grunt caiu, falharam apenas cerca de 0,375 MeV * cm

2 / mg quando partículas com LET atingiram. O GR740 resistiu a radiação 300 vezes mais poderosa. Além de imunidade quase completa a distúrbios únicos, o GR740 pode absorver até 300 roubar radiação durante sua vida útil. Durante os testes, a equipe de Weigand chegou a irradiar um dos processadores até 293 graus, mas, apesar disso, o chip funcionou, como sempre, sem mostrar sinais de degradação.

Ainda assim, testes que mostram a verdadeira dose máxima de ionização que o GR740 é capaz de absorver ainda precisam ser realizados. Todas essas figuras juntas indicam que esse processador, trabalhando na órbita geoestacionária da Terra, deve produzir um erro funcional a cada 350 anos. Em órbita baixa, esse período aumenta para 1310 anos. E mesmo esses erros não matam o GR740. Ele só precisa reiniciar.

America escolhe soluções patenteadas

“Os processadores de classe espacial que estão sendo desenvolvidos nos Estados Unidos tradicionalmente se baseiam em tecnologias proprietárias como o PowerPC, pois as pessoas tinham mais experiência em trabalhar com eles e eram suportadas por todos os tipos de software”, disse Lovelie, dos laboratórios de pesquisa da Força Aérea dos EUA. Afinal, a história da computação espacial começou com processadores digitais desenvolvidos pela IBM para as missões Gemini na década de 1960. E a IBM trabalhou com tecnologia proprietária.

Até hoje, os processadores BAE RAD são baseados no PowerPC, que nasceu graças ao trabalho do consórcio IBM, Apple e Motorola. Os processadores que operam nos computadores da cabine do ônibus espacial e do telescópio Hubble foram fabricados com base na arquitetura x86 fornecida pela Intel. Tanto o PowerPC quanto o x86 eram tecnologias proprietárias. Continuando essa tradição, o projeto mais recente nessa área também se baseia em tecnologia fechada.

O Computador de Voo Espacial de Alta Velocidade ( HPSC ) difere do PowerPC e x86 por ser mais conhecido como processadores de desktop. E o HPSC é baseado na arquitetura ARM que funciona hoje na maioria dos smartphones e tablets.O HPSC foi desenvolvido pela NASA, o laboratório de pesquisa da Força Aérea dos EUA e a Boeing, responsável pela produção. O HPSC é baseado nos processadores ARM Cortex A53 de quatro núcleos. Ele terá dois desses processadores conectados pelo barramento AMBA, que no final fornecerá um sistema de oito núcleos. Portanto, sua velocidade estará em algum lugar na área de smartphones de médio porte em 2018, como o Samsung Galaxy J8 ou placas de desenvolvimento como HiKey Lemaker ou Raspberry Pi. É verdade que esses indicadores são dados antes da proteção contra radiação - ela reduzirá sua velocidade em mais de duas vezes. No entanto, não precisamos mais ler as manchetes maçantes de que 200 processadores do rover Curiosity não alcançarão um iPhone. Após o lançamento do HPSC, apenas três ou quatro desses chips serão necessários para comparar em velocidade com um iPhone."Como ainda não temos um HPSC real para testes, só podemos fazer suposições razoáveis sobre seu desempenho", diz Lovelie. O primeiro parâmetro cuidadosamente estudado foi a frequência do relógio. Os processadores comerciais de oito núcleos do Cortex A53 geralmente são executados em frequências de 1,2 GHz (no caso do HiKey Lemaker) a 1,8 GHz (como o Snapdragon 450). Para descobrir qual seria a frequência do relógio HPSC após a proteção contra radiação, a Lovely comparouvários processadores de classe espacial com suas contrapartes comerciais. "Decidimos que seria razoável esperar uma diminuição semelhante no desempenho", diz ele. Lovely avaliou a velocidade do relógio HPSC em 500 MHz. E ainda será uma velocidade excepcionalmente alta para um chip de classe espacial. Se essa frequência é realmente essa, o HPSC será o campeão em frequência de clock entre os processadores de classe espacial. No entanto, o aumento da potência da computação e da freqüência do relógio no espaço geralmente se transforma em sérios problemas.Hoje, o mais poderoso processador protegido contra radiação é o BAE RAD5545. Trata-se de uma máquina de quatro núcleos de 64 bits, fabricada pelo processo de fabricação de 45 nm, operando com uma frequência de clock de 466 MHz e potência dissipada de até 20 W; e 20 watts é decente. O Quad Core i5 no MacBook Pro de 13 "dissipa 28 watts. Ele pode aquecer a caixa de alumínio a temperaturas muito altas, até aquelas que começam a causar problemas para os usuários. Durante uma alta carga computacional, os ventiladores ligam imediatamente para resfriar todo o sistema. Mas apenas em os ventiladores não ajudarão em nada o espaço, porque não há ar que possa soprar em um chip quente. A única maneira possível de remover o calor da sonda é a radiação, e isso leva tempo.É claro que os tubos de calor ajudarão a remover o calor processador, mas esse calor deve eventualmente ir a algum lugar.Algumas missões têm um orçamento de energia muito limitado e simplesmente não podem pagar processadores tão poderosos como o RAD5545. Portanto, o GR740 europeu de energia dissipada é de apenas 1,5 watts. Não é o mais rápido disponível, mas o mais eficaz. Apenas fornece a quantidade máxima de computação por watt. Um HPSC de 10 W fica próximo a ele em segundo lugar, mas nem sempre.“Cada núcleo do HPSC possui seu próprio módulo de um único fluxo de comandos, vários fluxos de dados, OKMD(Dados múltiplos de instrução única, SIMD). A tecnologia OKMD tem sido frequentemente usada em computadores comerciais e computadores móveis desde os anos 90. Ajuda os processadores a lidar melhor com o processamento de imagem e som nos videogames. Digamos que precisamos clarear a imagem. Tem muitos pixels, e cada um deles tem um brilho que precisa ser aumentado em dois. Sem o OKMD, o processador precisará executar todo esse somatório sequencialmente, um pixel após o outro. Usando OKMD, esse problema pode ser paralelo. O processador aceita vários pontos de dados - os valores de brilho de todos os pixels da imagem - e executa a mesma instrução com eles, adicionando um empate a todos ao mesmo tempo. E como o processador Cortex A53 foi projetado para smartphones e tablets que lidam com uma grande quantidade de conteúdo de mídia, o HPSC também é capaz disso."Isso é especialmente benéfico em tarefas como compressão de imagem, processamento ou visão estéreo", diz Lovely. - Em aplicativos que não usam esse recurso, o HPSC funciona um pouco melhor que o GR740 e outros processadores de espaço rápido. Mas quando pode ser usado, o chip está seriamente à frente de seus rivais. "Trazendo a ficção científica de volta à exploração espacial

Os desenvolvedores de chips dos EUA tendem a ser mais poderosos, mas também mais exigentes em processadores de energia, uma vez que as missões da NASA, tanto robóticas quanto tripuladas, geralmente são em maior escala do que seus colegas europeus. Na Europa, não há planos para o futuro próximo de enviar pessoas ou veículos todo-o-terreno do tamanho de um carro para a lua ou Marte. Hoje, a ESA concentra-se em sondas e satélites, geralmente trabalhando com um orçamento limitado de energia; portanto, escolher algo mais leve e mais eficiente em termos de energia, como o GR740, faz mais sentido. O HPSC foi originalmente projetado para levar as ambições de ficção científica da NASA a lugares.Por exemplo, em 2011, o Game Changing Development Program da NASA encomendou um estudo sobre a aparência das solicitações de computação no espaço em 15 a 20 anos. Uma equipe de especialistas de vários centros da agência compilou uma lista de tarefas que processadores avançados poderiam resolver em missões tripuladas e robóticas. Uma das primeiras tarefas que eles identificaram foi o monitoramento constante do status do equipamento. Essa tarefa se resume à presença de sensores que monitoram constantemente o status dos componentes críticos. A aquisição de dados de alta frequência de todos esses sensores requer processadores rápidos. Um computador lento provavelmente lidaria com a tarefa se os dados chegassem a algum lugar a cada 10 minutos, mas se você precisar verificar todos os equipamentos várias vezes por segundo para obter eficiência,assemelhando-se ao monitoramento em tempo real, seu processador deve funcionar muito rápido. Tudo isso precisa ser desenvolvido para que os astronautas possam se sentar em frente ao painel de controle, que mostraria o estado real da nave, capaz de emitir alertas de voz e belos gráficos. Para suportar esses gráficos, computadores rápidos também são necessários.No entanto, os objetivos de ficção científica não terminam com os cockpits. Os astronautas que exploram outros mundos provavelmente têm um sistema de realidade aumentada incorporado em seus capacetes. Seu ambiente será complementado por vídeo gerado por computador, sons e dados de GPS. Em teoria, a realidade aumentada melhorará a eficácia dos pesquisadores, marcará áreas que vale a pena explorar e alertará sobre situações potencialmente perigosas. Obviamente, incorporar a realidade aumentada em um capacete é apenas uma das várias possibilidades. Entre as outras opções mencionadas no estudo estão dispositivos portáteis, como smartphones, e algo vagamente descrito como "outras possibilidades de exibição de informações". Tais avanços computacionais exigirão processadores de classe espacial mais rápidos.Além disso, esses processadores devem melhorar as missões robóticas. Um dos principais exemplos é pousar em um terreno difícil. A escolha de um local para o pouso na superfície é sempre um compromisso entre segurança e valor científico. O lugar mais seguro é um avião plano, sem pedras, colinas, vales e afloramentos de rochas. Do ponto de vista científico, o local mais interessante será geologicamente diversificado, o que significa uma abundância de pedras, colinas, vales e afloramentos de rochas. Uma maneira de resolver esse problema é o chamado. Navegação em Terreno (NOM). Os veículos todo-o-terreno equipados com o sistema NOM serão capazes de reconhecer sinais importantes, ver possíveis perigos e contorná-los, o que pode reduzir o raio de aterrissagem para 100 m.O problema é que os processadores de classe espacial existentes hoje em dia são muito lentos para processar imagens a essa velocidade.Uma equipe da NASA lançou o teste de desempenho NOM na RAD 750 e descobriu que a atualização de uma única câmera demorava cerca de 10 segundos. Infelizmente, se você cair na superfície marciana, 10 segundos são muitos. Para pousar um veículo todo-o-terreno em um local com um raio de 100 m, as atualizações da câmera devem ser processadas a cada segundo. Para um pouso exato no local por metro, você precisará de 10 atualizações por segundo.Entre outros desejos computacionais da NASA estão algoritmos que podem prever desastres iminentes com base em leituras de sensores, gráficos inteligentes, autonomia avançada etc. Tudo isso está além das capacidades dos atuais processadores de classe espacial. Portanto, no estudo, os engenheiros da NASA fornecem suas estimativas do poder de computação necessário para suportar essas tarefas. Eles descobriram que o monitoramento das condições do navio e o desembarque em condições difíceis exigiria de 10 a 50 GOPS (gigaoperations per second). Os consoles futuristas de voo de ficção científica com visores modernos e gráficos avançados exigirão de 50 a 100 GOPS. O mesmo vale para capacetes de realidade aumentada ou outros dispositivos; eles também consomem de 50 a 100 GOPS.Idealmente, os futuros processadores espaciais poderão suportar facilmente todos esses projetos. Hoje, o HPSC, operando em dissipação de energia de 7 a 10 watts, é capaz de fornecer 9 a 15 GOPS. Isso já poderia possibilitar pouso extremo, mas o HPSC foi projetado para que esse número possa aumentar significativamente. Antes de tudo, esses 15 GOPS não incluem as vantagens de desempenho recebidas do OKMD. Em segundo lugar, esse processador pode funcionar em conjunto com outros HPSC e dispositivos externos, por exemplo, processadores FPGA ou GPU especializados. Portanto, a espaçonave do futuro pode ter vários processadores distribuídos trabalhando em paralelo, e chips especializados podem lidar com certas tarefas, como processamento de imagens ou sinais.Independentemente de onde vão os sonhos da humanidade sobre o espaço profundo, os engenheiros já sabem em que estágio de desenvolvimento está o atual poder de computação. O LEON GR740 deve ser disponibilizado para a ESA ainda este ano e, depois de passar alguns testes adicionais, deve estar pronto para voar em 2020. A fase de produção do HPSC, por sua vez, deve começar em 2012 e terminar em 2022. Levará vários meses para testar em 2022.A NASA deve receber chips HPSC prontos para uso até o final de 2022. Isso significa que, sem levar em conta outros fatores que complicam o progresso, pelo menos o silício cósmico está se movendo para o futuro a uma velocidade que lhe permitirá se preparar para o retorno das pessoas à lua até 2024.