Ericgrig

Prefácio

Gostaria de começar o prefácio com palavras de gratidão a dois maravilhosos programadores de Odessa: Andrei Kiper (Lohica) e Timur Giorgadze (Luxoft), para uma verificação independente dos meus resultados, na fase inicial do estudo.

- O artigo "Algoritmo linear para a solução do problema de conclusão do n-Queens" foi publicado em (arXiv.org) no início do primeiro dia de 2020. Inicialmente, o artigo foi escrito em russo; portanto, a apresentação básica é apresentada aqui e a tradução.

- Essa tarefa e alguns outros conjuntos de NP-Complete (a tarefa de satisfazer as fórmulas booleanas (3-SAT), a tarefa de encontrar a camarilha máxima ou uma camarilha de um determinado tamanho ...) em momentos diferentes estavam na minha área de interesse. Eu estava procurando uma solução algorítmica baseada em vários experimentos computacionais, mas não houve sucesso concreto. Era como uma pessoa tentando aprender a ficar em forma na barra horizontal de um braço. Não há resultado, mas toda vez há uma esperança de que tudo dê certo em breve. A última vez que decidi que deveria ficar mais tempo na tarefa de Conclusão do n-Queens (como um dos membros da família) e tentar fazer alguma coisa. Aqui é apropriado relembrar a maravilhosa piada de Odessa: "Em um ônibus lotado que retorna aos subúrbios em uma estrada esburacada à noite, a voz de uma mulher é ouvida - Cara, se você me deitou completamente, faça pelo menos alguma coisa".

- O estudo durou o suficiente - quase um ano e meio. Por um lado, isso se deve ao fato de que outras tarefas foram consideradas no processo de pesquisa e, por outro, houve questões difíceis ao longo do caminho, sem as quais não poderíamos avançar. Vou listar alguns deles:

- Existem n linhas na matriz de decisão, em que sequência o índice de linha deve ser selecionado se o número de possibilidades para essa escolha for n!

- quando uma linha é criada, qual das posições livres restantes nessa linha deve ser selecionada, porque o número de possibilidades para uma seleção é tão grande que pode ser considerado um "parente próximo" do infinito (por exemplo, o número de maneiras possíveis de selecionar uma posição livre em todas as linhas para um tabuleiro de xadrez de tamanho 100 x 100 é aproximadamente 10 124 )

- Juntos, esses dois indicadores formam um espaço de estado (um espaço de escolha). Parece que existem grandes oportunidades, você pode escolher o que deseja. Mas por trás de cada escolha específica a cada passo, há outro problema - a limitação da escolha em todos os passos subsequentes. Além disso, isso é especialmente sensível nos últimos estágios da solução do problema. Podemos dizer que a matriz de decisão é "vingativa". Todos os “erros inconscientes” que você comete ao fazer uma escolha nos estágios anteriores são “acumulados” e, no final da decisão, isso se manifesta no fato de que naquelas linhas em que você deve colocar a rainha, não há posições vazias e o ramo de busca pára. . Aqui, como Zhvanetsky: "uma jogada errada e você está grávida".

- Quando o ramo da busca por uma solução fica parado, temos a oportunidade de voltar a algumas das posições anteriores (Back Tracking), para que a partir dessa posição comecemos novamente a formar o ramo da busca por uma solução. Essa é uma "propriedade" natural de problemas não determinísticos. A questão é qual dos níveis anteriores deve ser retornado. Esse é o mesmo problema em aberto que a questão de escolher o índice de linha ou escolher uma posição livre nessa linha.

- Finalmente, um problema relacionado à velocidade do algoritmo deve ser observado. Seria triste se não houvesse objetivo de criar algoritmos de execução rápida. No processo de modelagem, não foi possível desenvolver um algoritmo que funcionasse rápida e eficientemente em todas as áreas da solução do problema. Eu tive que desenvolver três algoritmos. Eles transmitem os resultados um para o outro, como um bastão. Um deles trabalha muito rapidamente, mas de forma grosseira, o outro - pelo contrário, trabalha lenta mas eficientemente. Cada um deles trabalha na “zona de sua responsabilidade”.

- Inicialmente, o objetivo do estudo era apenas encontrar pelo menos alguma solução. Eu tinha muito que descobrir antes que a primeira solução fosse desenvolvida. Demorou mais de quatro meses. Foi possível parar por aí, o objetivo foi alcançado - bem, tudo bem. Mas me pareceu que nem todas as possibilidades de uma solução algorítmica para esse problema estavam esgotadas. Naturalmente, havia um desejo de melhorar o algoritmo desenvolvido para que a complexidade do tempo fosse linear-O (n). Quando uma solução linear foi encontrada, havia “mais um desejo” - reduzir o número de casos em que o procedimento Back Tracking (BT) foi aplicado ao formar um ramo da pesquisa da solução. Era um desejo "insolente" de transferir a tarefa de não determinista para condicionalmente determinado (na medida do possível). Demorou muito tempo, mas o objetivo foi alcançado, por exemplo, no intervalo de valores do tamanho de um tabuleiro de xadrez n = (320, ..., 22500), o número de casos em que o procedimento BT nunca foi usado é superior a 50%. Acontece que em 50% dos casos, quando o programa é iniciado, o algoritmo "propositalmente" forma uma solução, nunca "tropeçando". (Lembrando o conto de fadas sobre o peixe dourado, parei com esses dois desejos ...)

- Comparando as publicações com as quais me familiarizei durante a pesquisa, cheguei à conclusão de que esse problema e outros problemas desse tipo não podem ser resolvidos com base em uma abordagem matemática rigorosa, ou seja, apenas com base em definições, afirmações de lemas e provas de teoremas. Há uma "observação filosófica" sobre isso no artigo. Estou certo de que muitos problemas do NP-Complete podem ser resolvidos apenas com base na matemática algorítmica com o uso da modelagem computacional. Essa conclusão não significa limitar a matemática, pelo contrário, significa expandir as capacidades da matemática através do desenvolvimento de métodos matemáticos algorítmicos. Para cada família de problemas, você precisa usar sua própria abordagem matemática adequada. (Por que instruir um aluno de pós-graduação a resolver um problema da família NP-Complete sem aplicar matemática algorítmica e modelagem por computador, se se sabe que nada realmente resultará de tal empreendimento).

- Qualquer algoritmo (programa) possui uma propriedade simples - funciona ou não! Quero apelar para os membros da nossa Comunidade Habro que têm um computador com o Matlab instalado na zona de acessibilidade. Quero pedir que você teste a operação do algoritmo considerado para resolver o problema de conclusão do n-Queens . Isso levará apenas 5 a 10 minutos. Para testar o algoritmo, você precisa seguir algumas etapas simples:

- Gere uma composição aleatória a partir de k rainhas e verifique a correção dessa composição.

- Com base no algoritmo de decisão proposto, conclua esta composição para uma solução completa. Ou o programa deve decidir que essa composição não tem solução.

- Verifique a correção da solução obtida como resultado da configuração.

Você não precisa escrever nenhum código para esse teste. Além do programa principal, preparei mais dois programas no idioma Matlab:

1. Generarion_k_Queens_Composition - geração de uma composição aleatória de tamanho k para um tabuleiro de xadrez arbitrário de tamanho nxn

2. Completion_k_Queens_Composition.m - concluir uma composição arbitrária até uma decisão completa ou decidir que essa composição não tem solução ( programa principal ).

3. Validation_n_Queens_Solution.m - verificando a correção da solução do Problema n-Queens ou a correção da composição de k rainhas.

Eles trabalham muito rápido. Por exemplo, para um tabuleiro de xadrez, cujo tamanho é de 1000 x 1000 células, o tempo total necessário para gerar uma composição arbitrária (0,0015 s.), Complete esta composição (0,0622 s.) E verifique a correção da solução obtida (0,0003 s.) não excede 0,1 segundos. (excluindo o tempo necessário para fazer o download de dados ou salvar os resultados)

Envie-me um email (ericgrig@gmail.com). Se você tiver a oportunidade de ajudar um amigo, enviarei imediatamente esses três programas. Serei grato a todos os meus colegas que podem testar objetivamente o algoritmo e expressar sua opinião na discussão. - Eu preparei o código fonte do programa, com comentários detalhados, que, espero, serão publicados em Habré em breve. Penso que aqueles que estão interessados em resolver problemas complexos da família NP-Complete encontrarão algo interessante para si.

- Gostaria de apelar novamente aos membros da Comunidade Habr, mas por um motivo diferente. Aqui, em Marselha (França), a formação da equipe do France Fold Group está em andamento, cujo objetivo é a pesquisa e o desenvolvimento de algoritmos para prever as propriedades físico-químicas de compostos de alto peso molecular. Acho que não vale a pena dizer que esta é uma tarefa bastante difícil, com uma longa história, e que equipes sérias em diferentes países estão trabalhando nesse problema, incluindo a equipe Khasabis da Deep Mind (você pode ver o artigo em Habré (habr.com_Folding) . O objetivo é criar uma equipe forte que não tenha medo de resolver problemas complexos. A forma de organização do trabalho conjunto é distribuída. Cada membro da equipe vive em sua cidade e trabalha no projeto em seu tempo livre a partir de seu trabalho principal. Precisamos de programadores e pesquisadores (físicos, químicos, matemáticos, biólogos) ) etc. osto programadores “imprudentes” (ao quadrado). Escreva-me se achar interessante, o acima é o meu e-mail. Mais detalhadamente, posso dizer na carta de resposta.

O prefácio do artigo acabou sendo o mesmo do próprio artigo. O formato de apresentação da família em Habré me permite expressar meus pensamentos com mais liberdade, mas, a julgar pelo tamanho, aproveitei-o com bastante liberdade. Eu queria escrever brevemente, mas "acabou como sempre".

PS: Pensei que os membros da Comunidade Habr estariam interessados em saber quais dificuldades encontrei ao tentar publicar os resultados do estudo. Quando o artigo foi preparado, eu o reformatei no formato .tex de acordo com os requisitos do Journal of Artificial Intelligence Research (JAIR) e o enviei para lá. Costumava haver publicações sobre um tópico semelhante. Destaca-se o artigo

C. Gent, I.-P. Jefferson e P. Nightingale (2017) (Complexidade da conclusão de n-rainhas) , na qual os autores provaram que o problema em questão pertence ao conjunto NP-Complete e falaram sobre as dificuldades encontradas na tentativa de resolver esse problema. Nas conclusões, os autores escrevem: “Para quem entende as regras do xadrez, o n-Queens Completion pode ser um dos problemas mais naturais de NP-Complete de todos” (

Para quem entende as regras do xadrez, a tarefa n-Queens Completion pode se tornar uma das as tarefas NP-Complete mais naturais ).

Após 10 dias, recebi uma recusa da JAIR, com a redação: "o artigo não corresponde ao formato da revista", ou seja, nem sequer levou o artigo em consideração. Eu não esperava essa resposta. Eu pensei que, se uma revista publica artigos nos quais os autores concluem que é muito difícil resolver um determinado problema e não fornece nenhuma solução concreta, o artigo que fornece um algoritmo de solução eficaz certamente será aceito para consideração. No entanto, os editores tinham sua própria opinião sobre esse assunto. (Acredito que especialistas competentes trabalhem lá, e provavelmente eles foram questionados pelo título do artigo "insolente" e tudo o que é declarado lá. Pensamos: "provavelmente há algum tipo de erro e gentilmente me mandou embora, referindo-se ao formato ").

Eu tive que escolher outra publicação científica periódica revisada por pares sobre tópicos relevantes. Aqui estou diante da dura realidade. O fato é que aproximadamente 80% de todas as revistas são pagas: ou eu tenho que pagar uma quantia decente à revista para que o artigo esteja disponível gratuitamente a todos os leitores, ou eles precisam dar o artigo como presente "na proa", e eles cobrarão a todos que quer se familiarizar com este estudo. E a primeira e a segunda opções são fundamentalmente inaceitáveis para mim. Eu me senti bem com esse método de raquete de editores quando tentei me familiarizar com algumas publicações.

A próxima revista, que professa o princípio do livre acesso à informação, foi

o SMAI Journal of Computational Mathematics . Eles também recusaram com a mesma redação, embora muito mais rápido - em dois dias.

Em seguida, foi escolhida uma revista:

Matemática Discreta e Ciência da Computação Teórica . Aqui os requisitos são simples, primeiro você precisa publicar o artigo em arXiv.org e somente depois registre o artigo para consideração. Ok, seguiremos as regras - enviei um artigo no

arXiv.org . Eles me escreveram que publicariam o artigo em 8 horas. No entanto, isso não aconteceu após 8 horas, não após 8 dias. O artigo foi “mantido” pelos mentores e somente após 9 dias foi publicado. Não houve queixas na forma e na essência do artigo. Eu acho que, como no caso do JAIR, os mentores tinham dúvidas sobre a possibilidade de "fazer isso e escrever sobre isso". Algum tempo depois, depois de corrigir erros técnicos, o artigo foi atualizado e em sua forma final foi lançado na noite de Ano Novo.

Tenho que me debruçar sobre isso em detalhes para mostrar que, na fase de publicação dos resultados da pesquisa, pode haver problemas que não podem ser explicados logicamente.

A seguir, é apresentado um artigo cuja tradução para o inglês foi publicada em

(arXiv.org) .

1. Introdução

Entre as várias opções para a formulação do

problema do n-Queens, a tarefa de

Conclusão do n-Queens em questão tem uma posição especial devido à sua complexidade. Em seu trabalho

(Gent em tudo (2017)) mostrou que o

problema de conclusão do

n-Queens pertence ao conjunto

NP-Complete (

mostrou que o n-Queens Completion é NP-Complete e # P-Complete ). Supõe-se que a solução para esse problema possa abrir caminho para resolvermos outros problemas do conjunto de

NP-Complete .

O problema é formulado da seguinte maneira. Há uma composição de

k rainhas, que são distribuídas consistentemente em um tabuleiro de xadrez de tamanho

nxn . É necessário provar que esta composição pode ser completada para uma solução completa e fornecer pelo menos uma solução, ou provar que tal solução não existe. Aqui, por consistência, entendemos uma composição de

k rainhas para as quais três condições do problema são atendidas: em cada linha, cada coluna e também nas diagonais esquerda e direita que passam pela célula onde a rainha está localizada, não mais que uma rainha está localizada. O problema nesta forma foi formulado pela primeira vez por

Nauk (1850) .

1.1 DefiniçõesA seguir, indicaremos o tamanho da lateral do tabuleiro de xadrez pelo símbolo

n . Uma solução será chamada completa se todas as

n rainhas forem consistentemente colocadas em um tabuleiro de xadrez. Todas as outras soluções, quando o número

k de rainhas corretamente colocadas for menor que

n - chamaremos a composição. Chamamos de positiva uma composição de

k rainhas se puder ser concluída antes de uma solução completa. Por conseguinte, uma composição que não pode ser concluída até que uma solução completa seja chamada negativa. Como análogo de um "tabuleiro de xadrez" de tamanho

nxn , também consideraremos uma "matriz de solução" de tamanho

nxn . Como exemplo, todos os algoritmos desenvolvidos para resolver o problema serão apresentados na linguagem Matlab.

O estudo foi realizado com base em simulação computacional (simulação computacional). Para testar esta ou aquela hipótese, realizamos experimentos computacionais em uma ampla faixa de valores

n = (10, 20, 30, 40, 50, 60, 70, 80, 90, 100, 200, 300, 500, 800, 1000, 3000, 5000, 10000, 30.000, 50.000, 80.000, 10

5 , 3 * 10

5 , 5 * 10

5 , 10

6 , 3 * 10

6 , 5 * 10

6 , 10

7 , 3 * 10

7 , 5 * 10

7 , 8 * 10

7 , 10

8 ) e, dependendo do valor de

n , foram geradas amostras suficientemente grandes para análise. Chamamos essa lista de "

lista básica de n valores " para a realização de experimentos computacionais. Todos os cálculos foram realizados em um computador comum. No momento da montagem (no início de 2013), a configuração era bem-sucedida:

CPU - Intel Core i7-3820, 3,60 GH, RAM-32,0 GB, GPU- NVIDIA Ge Forse GTX 550 Ti, dispositivo de disco - ATA Intel SSD, SCSI, OS- Sistema operacional de 64 bits Windows 7 Professional . Chamamos esse kit simplesmente -

desktop-13 .

2. Preparação de dados

O algoritmo começa lendo um arquivo que contém uma matriz unidimensional de dados sobre a distribuição de uma composição arbitrária de

k rainhas. Supõe-se que os dados sejam preparados da seguinte maneira. Seja uma matriz zerada

Q (i) = 0, i = (1, ..., n) , em que os índices das células dessa matriz correspondem aos índices de linha da matriz da solução. Se em alguma linha arbitrária

i da matriz da solução houver uma rainha na posição

j , a atribuição

Q (i) = j é executada. Assim, o tamanho da composição

k será igual ao número de células diferentes de zero da matriz

Q. (Por exemplo,

Q = (0, 0, 5, 0, 4, 0, 0, 3, 0, 0) significa que estamos considerando uma composição de

k = 3 rainhas na matriz

n = 10 , onde as rainhas estão localizadas na 3ª, 5ª e 8ª linhas, respectivamente nas posições 5, 4, 3).

3. Algoritmo para verificar a correção do problema da solução n-Queens

Para pesquisa, precisamos de um algoritmo que permita determinar a correção da solução do

problema n-Queens em um curto espaço de tempo. Controlar o local das rainhas em cada linha e cada coluna é simples. A questão é sobre limites diagonais. Poderíamos construir um algoritmo eficaz para tal contabilidade se pudéssemos mapear cada célula da matriz da solução para uma determinada célula de um certo vetor de controle que caracterizaria exclusivamente a influência de restrições diagonais na célula em questão. Então, com base em se a célula do vetor de controle está livre ou ocupada, pode-se julgar se a célula correspondente da matriz de decisão está livre ou fechada.

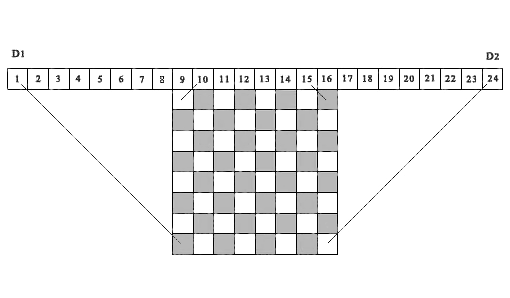

Tal idéia foi usada pela primeira vez por Sosic & Gu (1990) para levar em conta e acumular o número de situações de conflito entre diferentes posições das rainhas. Usamos uma idéia semelhante no algoritmo apresentado abaixo, mas apenas para levar em consideração se a célula da matriz da solução está livre ou ocupada. A Figura 1, como exemplo, mostra um tabuleiro de xadrez 8 x 8 acima do qual uma sequência de 24 células está localizada acima . Fig. 1. Um exemplo de demonstração da correspondência das projeções diagonais das células da matriz com as células correspondentes das matrizes de controle D1 e D2 , ( n = 8)Considere as 15 primeiras células como elementos do vetor de controle D1. As projeções de todas as diagonais esquerdas de qualquer célula da matriz da solução caem em uma das células do vetor de controle D1 . De fato, todas essas projeções estão localizadas dentro de dois segmentos de linha paralelos, um dos quais conecta a célula da matriz (8.1) à primeira célula do vetor D1 e o segundo conecta a célula da matriz (1.8) à 15ª célula do vetor de controle D1 . Nós damos uma definição semelhante para as projeções diagonais corretas. Para fazer isso, mova a origem da célula 1 para a célula 9 para a direita e considere uma sequência de 16 células como elementos do vetor de controle D2(na figura, são células dos dias 9 a 24). As projeções de todas as diagonais corretas de qualquer célula da matriz da solução cairão em uma das células desse vetor de controle, começando da 2ª à 16ª (na figura, de 10 24). Aqui, todas essas projeções estão localizadas entre dois segmentos de linhas paralelas - o segmento que conecta a célula (8,8) da matriz da solução com a célula 16 do vetor D2 (célula 24 na figura) e o segmento que conecta a célula (1,1) da matriz da solução com a célula 2 do vetor de controle D2 (célula 10 na figura). As projeções de todas as células da matriz da solução localizadas na mesma diagonal esquerda caem na mesma célula do vetor de controle esquerdo D1, respectivamente, as projeções de todas as células da matriz da solução localizadas na mesma diagonal direita caem na mesma célula do vetor de controle D2 certo . Assim, esses dois vetores de controle D1 e D2 permitem o controle total de todas as inibições diagonais para qualquer célula da matriz de decisão.É importante notar que a idéia de usar projeções diagonais em células de vetores de controle para determinar se uma célula de uma matriz de solução com coordenadas (i, j) está livre ou ocupada também foi implementada posteriormente em Richards (1997). Ele fornece um dos algoritmos de pesquisa recursiva mais rápidos para todas as soluções, com base em operações com uma máscara de bits. Uma diferença importante é que o algoritmo indicado é projetado para a pesquisa seqüencial de todas as soluções, iniciando na primeira linha da solução da matriz para baixo ou na última linha da matriz para cima. O algoritmo que propusemos é baseado na condição de que a escolha do número de cada linha para a localização da rainha deve ser arbitrária. Para o algoritmo em consideração, isso é de fundamental importância. Observe que a figura 1 acima, construímos por analogia com o que é publicado neste artigo.Um programa para verificar se uma determinada solução do problema n-Queens está correta ou se uma determinada composição de k é verdadeiraQueens é o seguinte.1. Para controlar inibições diagonais, crie duas matrizes D1 (1: n2) e D2 (1: n2) , em que n2 = 2 * n e uma matriz B (1: n) para controlar a ocupação das colunas da matriz da solução. Zere essas três matrizes.2. Introduzimos o contador do número de rainhas corretamente instaladas ( totPos = 0 ). Consistentemente, em um ciclo, a partir da primeira linha, consideramos todas as posições de rainhas fornecidas. Se Q (i)> 0 , então, com base no índice da linha i e no índice da posição da rainha nesta linha j = Q (i), formamos os índices correspondentes para as matrizes de controle D1 (r) e D2 (t) :r = n + j - it = j + i3. Se todas as condições ( D1 (r) = 0, D2 (t) = 0, B (j) = 0 ) forem satisfeitas , isso significa que a célula ( i, j) é livre e não cai na zona de projeção de restrições diagonais formadas por rainhas previamente estabelecidas. A posição da rainha nesta posição está correta. Se pelo menos uma dessas condições não for cumprida, a escolha de tal posição será errônea, respectivamente, e a decisão será errônea.4. Se a solução estiver correta, aumente o contador do número de rainhas instaladas corretamente ( totPos = totPos + 1 ) e feche as células correspondentes das matrizes de controle: (D1 (r) = 1, D2 (t) = 1, B (j) = 1) . Então fechamos todas as células da coluna(j) e as células da matriz da solução que estão localizadas ao longo das diagonais esquerda e direita que se cruzam na célula (i, j) .5. Repita o procedimento de verificação para todas as posições restantes.Talvez este seja um dos algoritmos mais rápidos para avaliar a correção da solução para o problema n-Queens . O tempo de verificação de um milhão de posições para a matriz de soluções 10 6 x 10 6 na área de trabalho 13 é de 0,175 segundos, o que corresponde aproximadamente ao tempo de pressionar a tecla "Enter". Obviamente, esse algoritmo é linear em relação à contagem do tempo em relação a n .

Fig. 1. Um exemplo de demonstração da correspondência das projeções diagonais das células da matriz com as células correspondentes das matrizes de controle D1 e D2 , ( n = 8)Considere as 15 primeiras células como elementos do vetor de controle D1. As projeções de todas as diagonais esquerdas de qualquer célula da matriz da solução caem em uma das células do vetor de controle D1 . De fato, todas essas projeções estão localizadas dentro de dois segmentos de linha paralelos, um dos quais conecta a célula da matriz (8.1) à primeira célula do vetor D1 e o segundo conecta a célula da matriz (1.8) à 15ª célula do vetor de controle D1 . Nós damos uma definição semelhante para as projeções diagonais corretas. Para fazer isso, mova a origem da célula 1 para a célula 9 para a direita e considere uma sequência de 16 células como elementos do vetor de controle D2(na figura, são células dos dias 9 a 24). As projeções de todas as diagonais corretas de qualquer célula da matriz da solução cairão em uma das células desse vetor de controle, começando da 2ª à 16ª (na figura, de 10 24). Aqui, todas essas projeções estão localizadas entre dois segmentos de linhas paralelas - o segmento que conecta a célula (8,8) da matriz da solução com a célula 16 do vetor D2 (célula 24 na figura) e o segmento que conecta a célula (1,1) da matriz da solução com a célula 2 do vetor de controle D2 (célula 10 na figura). As projeções de todas as células da matriz da solução localizadas na mesma diagonal esquerda caem na mesma célula do vetor de controle esquerdo D1, respectivamente, as projeções de todas as células da matriz da solução localizadas na mesma diagonal direita caem na mesma célula do vetor de controle D2 certo . Assim, esses dois vetores de controle D1 e D2 permitem o controle total de todas as inibições diagonais para qualquer célula da matriz de decisão.É importante notar que a idéia de usar projeções diagonais em células de vetores de controle para determinar se uma célula de uma matriz de solução com coordenadas (i, j) está livre ou ocupada também foi implementada posteriormente em Richards (1997). Ele fornece um dos algoritmos de pesquisa recursiva mais rápidos para todas as soluções, com base em operações com uma máscara de bits. Uma diferença importante é que o algoritmo indicado é projetado para a pesquisa seqüencial de todas as soluções, iniciando na primeira linha da solução da matriz para baixo ou na última linha da matriz para cima. O algoritmo que propusemos é baseado na condição de que a escolha do número de cada linha para a localização da rainha deve ser arbitrária. Para o algoritmo em consideração, isso é de fundamental importância. Observe que a figura 1 acima, construímos por analogia com o que é publicado neste artigo.Um programa para verificar se uma determinada solução do problema n-Queens está correta ou se uma determinada composição de k é verdadeiraQueens é o seguinte.1. Para controlar inibições diagonais, crie duas matrizes D1 (1: n2) e D2 (1: n2) , em que n2 = 2 * n e uma matriz B (1: n) para controlar a ocupação das colunas da matriz da solução. Zere essas três matrizes.2. Introduzimos o contador do número de rainhas corretamente instaladas ( totPos = 0 ). Consistentemente, em um ciclo, a partir da primeira linha, consideramos todas as posições de rainhas fornecidas. Se Q (i)> 0 , então, com base no índice da linha i e no índice da posição da rainha nesta linha j = Q (i), formamos os índices correspondentes para as matrizes de controle D1 (r) e D2 (t) :r = n + j - it = j + i3. Se todas as condições ( D1 (r) = 0, D2 (t) = 0, B (j) = 0 ) forem satisfeitas , isso significa que a célula ( i, j) é livre e não cai na zona de projeção de restrições diagonais formadas por rainhas previamente estabelecidas. A posição da rainha nesta posição está correta. Se pelo menos uma dessas condições não for cumprida, a escolha de tal posição será errônea, respectivamente, e a decisão será errônea.4. Se a solução estiver correta, aumente o contador do número de rainhas instaladas corretamente ( totPos = totPos + 1 ) e feche as células correspondentes das matrizes de controle: (D1 (r) = 1, D2 (t) = 1, B (j) = 1) . Então fechamos todas as células da coluna(j) e as células da matriz da solução que estão localizadas ao longo das diagonais esquerda e direita que se cruzam na célula (i, j) .5. Repita o procedimento de verificação para todas as posições restantes.Talvez este seja um dos algoritmos mais rápidos para avaliar a correção da solução para o problema n-Queens . O tempo de verificação de um milhão de posições para a matriz de soluções 10 6 x 10 6 na área de trabalho 13 é de 0,175 segundos, o que corresponde aproximadamente ao tempo de pressionar a tecla "Enter". Obviamente, esse algoritmo é linear em relação à contagem do tempo em relação a n .4. Descrição do algoritmo para resolver o problema

O general .

O problema de conclusão do n-Queens é um

problema clássico não determinístico. A principal dificuldade de sua solução está relacionada à questão de escolher o índice de linha e o índice de posição nessa linha, em condições em que o espaço de estado é enorme. Ao procurar todas as soluções possíveis, esse problema não surge. Devemos considerar todas as ramificações de pesquisa válidas no espaço de estado, e a ordem em que elas são consideradas não importa. No entanto, quando uma composição arbitrária de

k rainhas precisa ser concluída até uma solução completa, nesse caso, precisamos de um algoritmo para selecionar índices de linha e coluna que percebam adequadamente a composição existente e levam a uma solução mais rapidamente do que outros. Neste projeto, decidimos a questão da escolha com base na seguinte posição geral -

se não pudermos formular condições que dêem preferência a qualquer linha ou posição nesta linha sobre outras, usaremos um algoritmo de seleção aleatória baseado em números aleatórios distribuídos uniformemente . Um método de seleção aleatória semelhante para resolver problemas nos quais o espaço de estados é enorme é bastante natural. Uma das edições da série Proceedings of a

DIMACS Workshop (1999) foi completamente dedicada ao uso da seleção aleatória no desenvolvimento de algoritmos para resolver problemas complexos. A implementação correta do algoritmo de seleção aleatória pode ser uma solução bastante produtiva, embora essa seja uma condição necessária, mas não suficiente, para a conclusão da solução.

Sosic e Gu (1990) é um dos primeiros estudos a usar um algoritmo de seleção aleatória para resolver o problema

n-Queens . O algoritmo que eles examinaram é baseado em uma idéia bastante simples e concisa. Haja uma sequência de números de

1 a

n , que são reorganizados aleatoriamente. Esse conjunto de números tem uma propriedade importante. Consiste no fato de que, independentemente de como esses números sejam distribuídos em diferentes linhas da matriz da solução, conforme as posições da rainha (um número por linha), as duas primeiras regras sempre serão cumpridas na declaração do problema: cada linha e cada coluna não terá mais de uma rainha. No entanto, apenas uma parte das posições assim obtidas estará livre de restrições diagonais. A outra parte estará em um estado de "conflito" com rainhas estabelecidas anteriormente. Para sair dessa situação, os autores usaram o método de comparar e trocar posições conflitantes, a fim de obter uma solução completa. Em nosso algoritmo proposto, as situações de conflito são impossíveis, pois a cada passo da solução do problema, a rainha é instalada na célula da linha em questão somente se a célula estiver livre.

4.1 Selecionando um modelo para rastreamento posterior (BT)No processo de encontrar uma solução para um problema, uma situação pode surgir quando uma cadeia seqüencial de soluções leva a um beco sem saída. Essa é uma propriedade "genética" de problemas não determinísticos. Nesse caso, você precisa voltar para uma das etapas anteriores, restaurar o estado da tarefa de acordo com este nível e iniciar novamente a busca de uma solução a partir dessa posição. A questão é qual dos níveis anteriores deve ser retornado e quantos devem ser (por nível, queremos dizer uma certa etapa na solução do problema com um determinado número de rainhas corretamente instaladas). Obviamente, escolher um nível de solução para voltar é tão relevante quanto escolher um índice de linha ou um índice de posição nessa linha. Portanto, independentemente da abordagem para resolver esse problema, é necessário primeiro determinar o número de níveis básicos para retorno, bem como o mecanismo e as condições para retornar a um desses níveis. Em nosso algoritmo proposto, dividimos a matriz da solução em três níveis básicos. Estes são os pontos de retorno. Se, como resultado da solução, ocorrer um conflito, dependendo dos parâmetros da tarefa, retornaremos a um desses três níveis básicos. O primeiro nível base (

baseLevel1 ) corresponde ao estado em que a verificação de dados da composição em questão é concluída. Este é o começo do programa. Os valores dos dois níveis base a seguir (

baseLevel2 e

baseLevel3 ) dependem do tamanho da matriz

n . A dependência empírica desses valores básicos sobre o tamanho da matriz da solução foi estabelecida com base em um grande número de experimentos computacionais. Para uma representação mais precisa dessa dependência, dividimos todo o intervalo considerado de 7 a 10

8 em duas partes. Seja

u = log (n) , então se

n <30 000 , então

baseLevel2 = n - redondo (12.749568 * u3 - 46.535838 * u2 + 120.011829 * u - 89.600272)baseLevel3 = n - redondo (9.717958 * u3 - 46.144187 * u2 + 101.296409 * u - 50.669273)caso contrário

baseLevel2 = n - round (-0,886344 * u3 + 56,136743 * u2 + 146,486415 * u + 227,967782)baseLevel3 = n - redondo (14.959815 * u3 - 253.661725 * u2 + 1584.713376 * u - 3060.691342)4.2 Estrutura do blocoO algoritmo é construído na forma de uma sequência de

cinco blocos de eventos , em que cada evento está associado à execução de uma determinada parte da solução do problema. Os algoritmos de processamento em cada bloco são diferentes um do outro. Apenas três dos cinco blocos servem para formar uma cadeia seqüencial de soluções, e os dois blocos restantes são preparatórios. A escolha do número do bloco a partir do qual os cálculos começam depende do valor de

n e dos resultados da comparação do tamanho da composição

k com os valores de

baseLeve2 e

baseLevel3 . Uma exceção é o intervalo de valores

n = (7, ..., 99) , que pode ser chamado de “zona turbulenta” devido às peculiaridades do comportamento do algoritmo nesta seção. Para os valores

n = (7, ..., 49) , independentemente do tamanho da composição, após inserir e monitorar os dados, os cálculos começam no 4º bloco. Para os valores

n = (50, ..., 99) , dependendo do tamanho da composição, os cálculos começam no segundo bloco ou no quarto. Como mencionado acima, em cada etapa da solução do problema, apenas as posições na linha são consideradas que não se enquadram na zona de restrições criadas pelas rainhas estabelecidas anteriormente. São essas posições que

são chamadas de livres .

Vamos descrever brevemente quais cálculos são realizados em cada um desses cinco blocos do programa.

4.3 Início do algoritmoOs dados são inseridos e a composição é verificada quanto à correção. Em cada etapa de verificação, as células das matrizes de controle são alteradas. O número de rainhas instaladas corretamente é contado. Se não houver erros na composição, a solução continuará; caso contrário, uma mensagem de erro será exibida. Após a conclusão da verificação, cópias das matrizes principais são criadas para reutilização nesse nível. Depois disso, o controle é transferido para o

Bloco 1 .

4.4 Bloco 1O início da formação do ramo de pesquisa. Consideramos

k rainhas localizadas em um tabuleiro de xadrez como uma posição inicial. É necessário continuar a concluir essa composição e colocar as rainhas em um tabuleiro de xadrez até que seu número total seja igual a

baseLevel2 . O algoritmo usado aqui é chamado

randSet & randSet . Isso se deve ao fato de que aqui estamos constantemente comparando duas listas aleatórias de índices, em busca de pares livres das restrições diagonais correspondentes. Para fazer isso, as seguintes ações são executadas:

a) duas listas são formadas: uma lista de índices de linhas livres e uma lista de índices de colunas livres;

b) reorganizar aleatoriamente números em cada uma dessas listas;

c) em um loop, cada par sucessivo de valores

(i, j) , em que o índice

(i) é selecionado na lista de índices de linha livre e o índice

(j) na lista de índices de coluna livre, é considerado como uma possível posição rainha e é verificado se isso posição na área de projeção de exceções diagonais.

Se a regra das exceções diagonais não for violada, a posição será considerada correta e a rainha será colocada nessa posição. Depois disso, o contador é incrementado para o número de rainhas corretamente instaladas e as células correspondentes das matrizes de controle são alteradas. Se a posição

(i, j) cai na zona de restrições diagonais formadas pelas rainhas estabelecidas anteriormente, nada muda e a transição para a consideração do próximo par de valores ocorre.

Quando o ciclo de comparação de todos os pares da lista é concluído, com base nos índices restantes que estão na zona de exclusão diagonal, uma lista de índices das linhas livres restantes e colunas livres é formada novamente e esse procedimento é repetido até o número total de rainhas corretamente colocadas

(totPos ) não será igual ou excederá o valor limite de

baseLevel2 . Quando essa condição é atendida, o controle é transferido para o

Bloco 2 . Se, como resultado de uma busca por uma solução, surgisse uma situação, da lista inteira de índices das linhas e colunas livres restantes, nenhum dos pares seria adequado para a localização da rainha; nesse caso, os valores originais das matrizes de controle serão restaurados com base nas cópias geradas anteriormente , e o controle é transferido para o início do

Bloco 1 para recontagem.

4.5 Bloco 2Este bloco serve como um estágio preparatório para a transição para o

Bloco 3 . Nesse nível, o número de linhas livres restantes (

freeRows ) é significativamente menor que

n . Isso permite transferir eventos da matriz original de tamanho

nxn para uma matriz de tamanho menor

L (1: freeRows, 1: freeRows) . Além disso, com base nas informações sobre as linhas livres restantes e as colunas livres na matriz original da solução, os zeros são gravados nas células correspondentes da matriz

L , indicando que essas células estão livres. Com essa transição de

"projeção" , a correspondência dos índices de linha e coluna da nova matriz com os índices correspondentes da matriz original é preservada. É importante observar que, embora, no processo de solução desse problema, todos os eventos ocorram na matriz inicial de tamanho

nxn , e essa matriz seja a principal arena de ação, na

realidade, essa matriz não é criada e apenas controla matrizes de contabilidade para os índices de linha

A (1: n) e colunas

B (1: n) desta matriz.

Juntamente com a matriz L, duas matrizes de trabalho

rAr (1: freeRows) e

tAr (1: freeRows) também são formadas neste bloco para salvar os índices correspondentes das matrizes de controle

D1 e

D2 . Isso ocorre porque, quando instalamos a próxima rainha na célula

(i, j) da matriz inicial de tamanho

nxn , devemos excluir as células da matriz

L que caem na zona de projeção das exceções diagonais da matriz "grande" original. Como o controle de restrições diagonais é realizado apenas dentro da matriz original de tamanho

nxn , a presença de matrizes de trabalho

rAr e

tAr nos permite manter a correspondência e converter as células proibidas nos limites da matriz L. Isso simplifica bastante a contabilização de posições excluídas.

Após a conclusão do trabalho preparatório neste bloco, cópias das matrizes principais são criadas para reutilização nesse nível e o controle é transferido para o

Bloco 3 .

4.6 Bloco 3Nesse bloco, a formação do ramo de pesquisa de soluções continua com base nos dados preparados no bloco anterior. O número de linhas nas quais as rainhas estão configuradas corretamente é igual ou superior a

baseLevel-2 . Você precisa continuar escolhendo até que o número de rainhas instaladas seja igual a

baseLevel-3 . Aqui, usamos o algoritmo de pesquisa de soluções

rand e rand , ou seja, para formar a posição de uma dama, em vez de uma lista de índices livres, apenas dois índices são usados, um valor aleatório de índice de uma linha livre e um valor aleatório de índice de uma posição livre nessa linha. Este procedimento é repetido ciclicamente até o número total de rainhas colocadas ser igual ao valor de

baseLevel-3 . Assim que essa condição for atendida, o controle é transferido para o

Bloco-4 . Se, como resultado dos cálculos, o ramo de pesquisa for um beco sem saída, esta seção da formação do ramo de pesquisa será fechada e retornará ao início do

Bloco-3 , de onde os cálculos serão repetidos novamente. Para isso, os valores iniciais de todas as matrizes de controle são restaurados.

4.7 Bloco 4Neste bloco, os dados são preparados para a transferência do controle para o

Bloco 5 . Para esta etapa, após concluir o procedimento no

Bloco 3 , o número de linhas livres (

nRow ) tornou-se ainda menor. Portanto, também é benéfico converter eventos de uma matriz maior em uma matriz menor. Essa abordagem nos dá a oportunidade de determinar rapidamente as características necessárias para as linhas restantes necessárias nesta etapa. De particular importância é o fato de que, com base nessa matriz, é possível prever as perspectivas do ramo de pesquisa para muitos passos adiante sem ter que concluir os cálculos. A condição é bastante simples. Se, entre as linhas livres restantes, houver uma linha na qual não há posição livre, o ramo de pesquisa em consideração será fechado e o controle será transferido para um dos blocos de nível inferior. As ações preparatórias realizadas aqui são muito semelhantes ao que foi feito no

Bloco 2 . Com base nos índices originais de linhas livres e colunas livres, é formada uma nova matriz bidimensional, cujos valores zero correspondem a posições livres na matriz da solução original. Além disso, um array especial

E (1: nRow, 1: nRow) é criado neste bloco, com base no qual você pode determinar o número de posições livres nas linhas livres restantes que serão fechadas se você selecionar a posição

(i, j) para definir a rainha em matriz de origem. Antes de transferir o controle para o

Bloco 5 , são executadas as seguintes ações:

a) a quantidade de vagas em todas as linhas restantes é determinada,

b) uma matriz da quantidade de posições livres, para as linhas em questão, é classificada em ordem crescente,

c) se todas as linhas livres restantes tiverem posições livres (ou seja, o valor mínimo nesta lista classificada é diferente de 0), o controle é transferido para o Bloco-5.

Se, em qualquer uma das linhas restantes, não houver posição livre, as matrizes necessárias serão restauradas com base nas cópias armazenadas e, dependendo dos parâmetros da tarefa, o controle será transferido para um dos níveis básicos.

d) cópias de backup de todas as matrizes de controle para este 4º nível são formadas.

4.8 Bloco 5Essa etapa é final e, aqui, a formação do ramo de busca é realizada de forma mais "equilibrada" e "racional". Esta é a "última milha", resta apenas um pequeno número de linhas livres. Mas, ao mesmo tempo, esta é a parte mais difícil. Todos os erros que poderiam ter sido cometidos nos estágios anteriores da formação do ramo da busca por uma solução, no agregado, aparecem aqui - na forma da falta de uma posição vazia na linha.

O algoritmo desse bloco é executado com base em dois loops aninhados, dentro dos quais o terceiro loop é executado. Uma característica do terceiro ciclo é que ele pode ser repetido, sem alterar os parâmetros de dois ciclos externos. Isso acontece se o ramo de pesquisa gerado estiver em um impasse. O número de tais repetições não excede o valor limite de

repeatBound , cujo valor ótimo foi estabelecido com base em experimentos computacionais.

O índice do loop externo está associado a uma escolha seqüencial de índices de linha que permaneceram livres após os cálculos no terceiro nível de base. Isso é feito com base em uma lista de linhas classificada anteriormente pela quantidade de posições livres na linha. A seleção começa com uma linha, com um número mínimo de posições livres e, em etapas subsequentes, em ordem crescente. Dentro deste ciclo, um segundo ciclo é formado, cujo índice itera sobre os índices de todas as posições livres na linha em questão. O objetivo do primeiro ciclo é apenas selecionar o índice de uma das linhas livres nesse nível. Consequentemente, o objetivo do segundo ciclo é apenas selecionar uma posição livre dentro da linha considerada. Essas ações ocorrem apenas no terceiro nível básico. Após essa escolha, o número de rainhas instaladas é incrementado e as células correspondentes de todas as matrizes de controle são alteradas. Além disso, o controle é transferido dentro de um ciclo aninhado (terceiro), cuja zona de atividade já é todas as demais linhas livres. Dentro deste ciclo, a escolha do índice de linha e a escolha de uma posição livre nessa linha são realizadas com base nas seguintes regras:

a)

Selecione uma linha livre . Todas as linhas livres restantes são consideradas e o número de posições livres é determinado em cada linha. A linha é selecionada para a qual o número de posições livres é mínimo. Isso minimiza os riscos associados à possibilidade de excluir as últimas posições vagas em algumas das linhas restantes em que o estado é mínimo e crítico em termos do número de posições vagas (

regra de risco mínimo ). A propósito, é com essa regra que o índice do primeiro ciclo neste quinto bloco começa com uma seleção seqüencial de linhas com um valor mínimo do número de posições livres em uma linha. Se, em algum momento, as duas linhas tiverem o mesmo número mínimo de posições livres, o índice de uma das duas posições listadas primeiro na lista classificada será selecionado aleatoriamente. Se o número de linhas com o mesmo número mínimo de posições livres for maior que duas, o índice de uma das três posições listadas primeiro na lista classificada será selecionado aleatoriamente.

b)

Seleção de uma posição livre consecutiva .

Na lista de todas as posições vagas na linha em questão, é selecionada uma que cause danos mínimos às posições vagas em todas as linhas restantes. Isso é feito com base na matriz E. formada anteriormente. Por "dano mínimo", entendemos a escolha dessa posição em uma determinada linha que exclui a menor quantidade de posições livres em todas as linhas restantes ( regra de dano mínimo)) Se duas ou mais posições livres consecutivas tiverem os mesmos valores mínimos, de acordo com o critério de dano, o índice de uma das duas posições listadas primeiro na lista é selecionado aleatoriamente. Escolher uma posição que exclua o número mínimo de posições livres nas linhas restantes minimiza o "dano" associado à posição da rainha nesta posição. O uso dessas duas regras permite um uso mais racional dos recursos em cada etapa da formação de um ramo de pesquisa. Isso reduz bastante os riscos e aumenta a probabilidade de escolher uma composição arbitrária para uma solução completa se a composição em questão tiver uma solução. Se em alguma etapa da solução ocorrer que em uma das linhas restantes para consideração não houver vagas, esse ramo de pesquisa será fechado. Nesse caso,com base em backups, todas as matrizes de controle são restauradas e, se o número de repetições não exceder o valor limiterepeatBound, sem alterar os índices do primeiro e do segundo ciclos externos, o trabalho do terceiro ciclo aninhado é repetido novamente. Isso se deve ao fato de que, nos casos em que os valores mínimos dos critérios relevantes coincidiram, fizemos uma seleção aleatória. A reformulação do ramo de pesquisa nas mesmas condições do nível básico permite um uso mais eficiente dos "recursos iniciais" fornecidos nesse nível. O número de partidas repetidas do terceiro ciclo aninhado é limitado e, se o valor limite for excedido, a operação desse ciclo será interrompida. Depois disso, os valores das matrizes de controle são restaurados e o controle é transferido para o ciclo do terceiro nível de base para ir para o próximo valor de índice. Este procedimento é repetido ciclicamente até que uma solução completa seja obtida, ou acontece queque usamos todas as linhas livres e todas as posições livres nessas linhas neste nível básico. Nesse caso, dependendo do número total de cálculos repetidos em vários níveis de base e levando em consideração o tamanho da matriz de decisão e o tamanho da composição, retorna-se a um dos níveis mais baixos para cálculos repetidos ou se decide que a composição em questão não pode ser equipado para completar a solução. No programa, para limitar o tempo total da fatura, é aceito que o procedimentoou se for julgado que a composição em questão não pode ser concluída até uma decisão completa. No programa, para limitar o tempo total da fatura, é aceito que o procedimentoou se for julgado que a composição em questão não pode ser concluída até uma decisão completa. No programa, para limitar o tempo total da fatura, é aceito que o procedimentoO Back Tracking , independentemente de qual dos níveis anteriores o retorno é feito, pode ser executado não mais que tempos de SimSound . Esse valor limite é selecionado com base em experimentos computacionais para vários valores de n.5. Análise da efetividade dos algoritmos de seleção

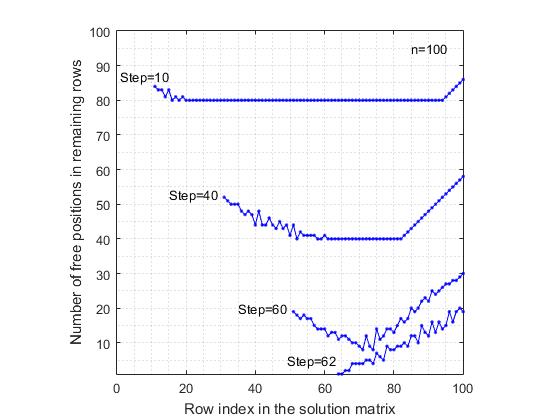

A eficiência do algoritmo randSet e randSet . Para analisar as capacidades desse algoritmo, foi realizado um experimento computacional, que consistiu em colocar rainhas na matriz da solução com base no modelo randSet e randSet , desde que exista essa possibilidade. Assim que o ramo de pesquisa alcançou um beco sem saída, ou uma solução completa foi obtida, o tamanho da composição, o tempo da solução foram fixados e o teste foi repetido novamente. Experimentos computacionais foram realizados para toda a lista básica de n valores . O número de testes repetidos para os valores n = (30, 40, ..., 90, 100, 200, 300, 500, 800, 1000) foi igual a um milhão , para os demais valores, o número de testes, com aumento de n, diminuiu gradualmente de 100000 para 100. Uma análise dos resultados de experimentos computacionais permite tirar as seguintes conclusões:a) Como resultado de apenas o primeiro ciclo do procedimento randSet & randSet, em média cerca de 60% de todas as rainhas são colocadas corretamente. Para n = 100, o número de rainhas colocadas corretamente é 60,05%. Com um aumento no valor de n, esse valor diminui gradualmente e para n = 10 7 equivale a 59,97%.b) O histograma da distribuição dos valores de comprimento das composições obtidas tem a mesma forma, independentemente do tamanho da matriz de decisão n. Além disso, todos eles têm uma característica - o lado esquerdo da distribuição (para o valor modal) difere do lado direito. Na Figura 2, como exemplo, o histograma correspondente para a Fig. 2. Um histograma da distribuição de soluções de vários comprimentos para o modelo randSet e randSet ( n = 100, tamanho da amostra = 10 6 ).n = 100. Parece que o histograma é coletado da distribuição de frequência de dois eventos diferentes, uma vez que a frequência de ocorrência de eventos nas partes esquerda e direita da distribuição é diferente. Para descrever essa distribuição, é mais provável usar duas funções da densidade da distribuição normal, uma das quais cobre o intervalo para o valor modal, a outra - o intervalo após o valor modal.c) O valor médio do número de rainhas ( qMean ) que pode ser definido na matriz de decisão com base nesse algoritmo aumenta com n . Como pode ser visto na Figura 3, onde é apresentado um gráfico da dependência da razão qMean / n no tamanho da matriz n , essa proporção aumenta com o aumento do tamanho da matriz.

Fig. 2. Um histograma da distribuição de soluções de vários comprimentos para o modelo randSet e randSet ( n = 100, tamanho da amostra = 10 6 ).n = 100. Parece que o histograma é coletado da distribuição de frequência de dois eventos diferentes, uma vez que a frequência de ocorrência de eventos nas partes esquerda e direita da distribuição é diferente. Para descrever essa distribuição, é mais provável usar duas funções da densidade da distribuição normal, uma das quais cobre o intervalo para o valor modal, a outra - o intervalo após o valor modal.c) O valor médio do número de rainhas ( qMean ) que pode ser definido na matriz de decisão com base nesse algoritmo aumenta com n . Como pode ser visto na Figura 3, onde é apresentado um gráfico da dependência da razão qMean / n no tamanho da matriz n , essa proporção aumenta com o aumento do tamanho da matriz. Por exemplo

Fig. 3. A dependência da razão qMean / n no valor de n para vários tamanhos da matriz da solução. O modelo é randSet e randSet , qMean é o valor médio do comprimento da solução.se, para uma matriz 100x100 , o algoritmo de seleção de posição randSet & randSet permite que "sem parar" coloque rainhas em média 89 linhas; em uma matriz 1000x1000 , o número dessas linhas aumenta em média para 967.d) Com base no algoritmo randSet & randSet, você pode obter o valor completo Como solução, no entanto, a "produtividade" dessa abordagem é extremamente baixa. Como pode ser visto na Figura 4, para

Fig. 3. A dependência da razão qMean / n no valor de n para vários tamanhos da matriz da solução. O modelo é randSet e randSet , qMean é o valor médio do comprimento da solução.se, para uma matriz 100x100 , o algoritmo de seleção de posição randSet & randSet permite que "sem parar" coloque rainhas em média 89 linhas; em uma matriz 1000x1000 , o número dessas linhas aumenta em média para 967.d) Com base no algoritmo randSet & randSet, você pode obter o valor completo Como solução, no entanto, a "produtividade" dessa abordagem é extremamente baixa. Como pode ser visto na Figura 4, para Fig. 4. A diminuição da probabilidade de obter uma solução completa no modelo randSet e randSet com um aumento em n .valores de n = 7, a probabilidade de obter uma solução completa é 0,057 . Além disso, com um aumento em n, a probabilidade de obter uma solução completa diminui rapidamente, aproximando-se assintoticamente de zero. A partir do valor n = 48, a probabilidade de obter uma solução completa é da ordem de 10 -6 . Após o valor limite n = 70, para os valores subsequentes de n, nenhuma solução completa foi obtida (com o número de testes igual a um milhão ).e) ModeloOs formulários randSet e randSet pesquisam ramos a uma velocidade muito alta. Para n = 1000, o tempo médio para obter a composição é de 0,0015 segundos. O comprimento médio das composições é 967. Portanto, para n = 10 6, o tempo médio é de 2.6754 segundos, com um comprimento médio de composições de 999793.f) Exceto por um pequeno intervalo n <= 70, quando o modelo randSet & randSet em casos muito raros pode levar a solução completa, em todos os outros casos, o ramo de decisão termina com a formação de uma composição negativa, que não pode ser concluída até uma solução completa. Portanto, o algoritmo randSet e randSetEle tem uma vantagem importante - a alta velocidade de formação do ramo de pesquisa e uma desvantagem significativa é que, se o tamanho da composição exceder um determinado valor limite, esse algoritmo leva à formação de composições que não podem ser concluídas até uma solução completa. Para superar essa desvantagem, paramos a formação do ramo de pesquisa quando o limite baseLevel-2 é atingido .A eficiência do algoritmo rand & rand . Para determinar as capacidades do algoritmo rand & rand , foi realizada uma simulação de computador bastante detalhada para uma lista básica de n valores . Tal como no modelo randSet e randSet, o número de retestes na maioria dos casos foi igual a um milhão . Para outros valores, o número de testes diminuiu gradualmente de 100.000 para 100.Ambos os algoritmos são baseados no princípio da seleção aleatória. Portanto, é de esperar que as conclusões aqui tiradas sejam basicamente idênticas às conclusões formuladas para o modelo randSet e randSet . No entanto, existe uma diferença fundamental entre eles e consiste no seguinte:a) o modelo rand & rand não funciona tão "duro" quanto o modelo randSet & randSet . Se falarmos sobre algum "índice de uso racional das oportunidades oferecidas", o modelo rand & randa cada passo usa os recursos de maneira mais racional. Isso leva ao fato de que, por exemplo, em n = 30, a probabilidade de obter uma solução completa de 0,00170 nesse modelo é 15 vezes maior que o valor semelhante de 0,00011 para o modelo randSet e randSet . Além disso, aqui, até o valor limite n = 370, permanece a probabilidade de obter pelo menos uma solução completa durante um milhão de testes. Após esse valor limite, para valores subsequentes de n com o número de testes igual a um milhão, nenhuma solução completa foi obtida com base no modelo rand & rand .b) esse algoritmo é muito mais lento que o algoritmo randSet & randSet . Se porn = 1000 para gerar uma composição de tamanho 967, o tempo médio para obter uma composição será de 0,0497 segundos, 33 a mais do que o valor correspondente de 0,0015 para o modelo randSet & randSet .A razão para as diferenças entre dois métodos essencialmente semelhantes de seleção aleatória se deve ao fato de que, no modelo randSet e randSet , para acelerar os cálculos, a seleção aleatória da lista restante não é realizada em cada etapa. Em vez disso, um par de índices é selecionado sequencialmente em duas listas, cujos elementos foram reorganizados aleatoriamente. Essa seleção não é aleatória em toda a extensão; no entanto, ela se ajusta bem à lógica do problema e permite que você conte rapidamente.Para demonstrar visualmente a operação do algoritmo rand & rand, foi realizada a seguinte experiência:a) Para um tabuleiro de xadrez de tamanho 100x100, após cada etapa da localização da rainha em qualquer linha, foi determinado o número de posições livres em cada uma das linhas livres restantes. Assim, após cada etapa da solução do problema, recebemos uma lista de linhas livres e uma lista correspondente do número de posições livres nessas linhas. Isso possibilitou a construção de um gráfico no qual os índices das colunas da matriz em questão são plotados ao longo do eixo das abcissas e o número de posições livres restantes ao longo do eixo das ordenadas. Para comparação, os cálculos também foram realizados para o modelo de seleção seqüencial de posições. Por seleção sequencial entende-se o seguinte. A primeira linha é considerada, na qual a primeira posição livre na lista é selecionada. Então, a segunda linha é considerada, na qual a primeira posição livre na lista, etc. também é selecionada. Nas figuras 5 e 6

Fig. 4. A diminuição da probabilidade de obter uma solução completa no modelo randSet e randSet com um aumento em n .valores de n = 7, a probabilidade de obter uma solução completa é 0,057 . Além disso, com um aumento em n, a probabilidade de obter uma solução completa diminui rapidamente, aproximando-se assintoticamente de zero. A partir do valor n = 48, a probabilidade de obter uma solução completa é da ordem de 10 -6 . Após o valor limite n = 70, para os valores subsequentes de n, nenhuma solução completa foi obtida (com o número de testes igual a um milhão ).e) ModeloOs formulários randSet e randSet pesquisam ramos a uma velocidade muito alta. Para n = 1000, o tempo médio para obter a composição é de 0,0015 segundos. O comprimento médio das composições é 967. Portanto, para n = 10 6, o tempo médio é de 2.6754 segundos, com um comprimento médio de composições de 999793.f) Exceto por um pequeno intervalo n <= 70, quando o modelo randSet & randSet em casos muito raros pode levar a solução completa, em todos os outros casos, o ramo de decisão termina com a formação de uma composição negativa, que não pode ser concluída até uma solução completa. Portanto, o algoritmo randSet e randSetEle tem uma vantagem importante - a alta velocidade de formação do ramo de pesquisa e uma desvantagem significativa é que, se o tamanho da composição exceder um determinado valor limite, esse algoritmo leva à formação de composições que não podem ser concluídas até uma solução completa. Para superar essa desvantagem, paramos a formação do ramo de pesquisa quando o limite baseLevel-2 é atingido .A eficiência do algoritmo rand & rand . Para determinar as capacidades do algoritmo rand & rand , foi realizada uma simulação de computador bastante detalhada para uma lista básica de n valores . Tal como no modelo randSet e randSet, o número de retestes na maioria dos casos foi igual a um milhão . Para outros valores, o número de testes diminuiu gradualmente de 100.000 para 100.Ambos os algoritmos são baseados no princípio da seleção aleatória. Portanto, é de esperar que as conclusões aqui tiradas sejam basicamente idênticas às conclusões formuladas para o modelo randSet e randSet . No entanto, existe uma diferença fundamental entre eles e consiste no seguinte:a) o modelo rand & rand não funciona tão "duro" quanto o modelo randSet & randSet . Se falarmos sobre algum "índice de uso racional das oportunidades oferecidas", o modelo rand & randa cada passo usa os recursos de maneira mais racional. Isso leva ao fato de que, por exemplo, em n = 30, a probabilidade de obter uma solução completa de 0,00170 nesse modelo é 15 vezes maior que o valor semelhante de 0,00011 para o modelo randSet e randSet . Além disso, aqui, até o valor limite n = 370, permanece a probabilidade de obter pelo menos uma solução completa durante um milhão de testes. Após esse valor limite, para valores subsequentes de n com o número de testes igual a um milhão, nenhuma solução completa foi obtida com base no modelo rand & rand .b) esse algoritmo é muito mais lento que o algoritmo randSet & randSet . Se porn = 1000 para gerar uma composição de tamanho 967, o tempo médio para obter uma composição será de 0,0497 segundos, 33 a mais do que o valor correspondente de 0,0015 para o modelo randSet & randSet .A razão para as diferenças entre dois métodos essencialmente semelhantes de seleção aleatória se deve ao fato de que, no modelo randSet e randSet , para acelerar os cálculos, a seleção aleatória da lista restante não é realizada em cada etapa. Em vez disso, um par de índices é selecionado sequencialmente em duas listas, cujos elementos foram reorganizados aleatoriamente. Essa seleção não é aleatória em toda a extensão; no entanto, ela se ajusta bem à lógica do problema e permite que você conte rapidamente.Para demonstrar visualmente a operação do algoritmo rand & rand, foi realizada a seguinte experiência:a) Para um tabuleiro de xadrez de tamanho 100x100, após cada etapa da localização da rainha em qualquer linha, foi determinado o número de posições livres em cada uma das linhas livres restantes. Assim, após cada etapa da solução do problema, recebemos uma lista de linhas livres e uma lista correspondente do número de posições livres nessas linhas. Isso possibilitou a construção de um gráfico no qual os índices das colunas da matriz em questão são plotados ao longo do eixo das abcissas e o número de posições livres restantes ao longo do eixo das ordenadas. Para comparação, os cálculos também foram realizados para o modelo de seleção seqüencial de posições. Por seleção sequencial entende-se o seguinte. A primeira linha é considerada, na qual a primeira posição livre na lista é selecionada. Então, a segunda linha é considerada, na qual a primeira posição livre na lista, etc. também é selecionada. Nas figuras 5 e 6 Fig. 5. Reduzir o número de posições livres nas linhas livres restantes após a colocação das rainhas. Seleção seqüencial regular de posições.Os resultados que correspondem aos modelos em consideração são apresentados. Para maior clareza, o gráfico mostra os resultados somente após as etapas (10, 40, 60). Para o modelo de seleção sequencial de posições, o último é o gráfico após a 62ª etapa, pois o ramo de pesquisa termina devido à falta de uma posição livre na 63ª linha. Por outro lado, no modelo rand & rand , o último gráfico é apresentado após o 70º passo da colocação da rainha, embora aqui, o número médio de rainhas corretamente posicionadas atinja 89, o que é 26 passos a mais do que no modelo seqüencial. Uma visão estranha dos gráficos no modelo rand & randdevido ao fato de o índice de linha ser selecionado aleatoriamente entre as linhas livres restantes e, portanto, eles estão espalhados aleatoriamente por toda a matriz da solução. Uma comparação dessas duas figuras mostra que no modelo seqüencial de seleção de posição, a faixa de variabilidade do número de posições livres é maior do que no modelo rand & rand . Isso se deve ao fato de que, com a seleção regular, restrições diagonais excluem de maneira não uniforme as posições livres nas linhas restantes, o que leva ao fato de que em algumas linhas a taxa de redução no número de posições vagas é maior do que em outras linhas.

Fig. 5. Reduzir o número de posições livres nas linhas livres restantes após a colocação das rainhas. Seleção seqüencial regular de posições.Os resultados que correspondem aos modelos em consideração são apresentados. Para maior clareza, o gráfico mostra os resultados somente após as etapas (10, 40, 60). Para o modelo de seleção sequencial de posições, o último é o gráfico após a 62ª etapa, pois o ramo de pesquisa termina devido à falta de uma posição livre na 63ª linha. Por outro lado, no modelo rand & rand , o último gráfico é apresentado após o 70º passo da colocação da rainha, embora aqui, o número médio de rainhas corretamente posicionadas atinja 89, o que é 26 passos a mais do que no modelo seqüencial. Uma visão estranha dos gráficos no modelo rand & randdevido ao fato de o índice de linha ser selecionado aleatoriamente entre as linhas livres restantes e, portanto, eles estão espalhados aleatoriamente por toda a matriz da solução. Uma comparação dessas duas figuras mostra que no modelo seqüencial de seleção de posição, a faixa de variabilidade do número de posições livres é maior do que no modelo rand & rand . Isso se deve ao fato de que, com a seleção regular, restrições diagonais excluem de maneira não uniforme as posições livres nas linhas restantes, o que leva ao fato de que em algumas linhas a taxa de redução no número de posições vagas é maior do que em outras linhas. Fig. 6. Reduzir o número de posições livres nas linhas livres restantes após a colocação das rainhas. O modelo de posicionamento é rand & rand .Por outro lado, com a seleção aleatória do índice de linha livre e do índice de coluna livre, as posições da rainha são distribuídas igualmente sobre a "área" da matriz de decisão, o que reduz a taxa "média" de redução no número de posições livres nas linhas restantes. Assim, levando em consideração os recursos do algoritmo rand & rand , nós o usamos no programa para continuar a formação do ramo de pesquisa de soluções até que o nível baseLevel-3 seja atingido .Deve-se notar que, mesmo que os algoritmos de seleção ( randSet e randSet, rand e rand ) não fossem tão eficientes, ainda teríamos que usar outro método de seleção aleatória ao desenvolver o algoritmo. Isto é devido à própria declaração do problema.Problema de conclusão do n-Queens . Se imaginarmos que existe um certo algoritmo ideal que resolve o problema, na entrada, esse algoritmo sempre receberá um determinado conjunto aleatório de índices de linha e coluna. Cada vez será um novo conjunto aleatório de índices de linhas e colunas, com uma enorme variedade de possibilidades. Para poder “absorver” o algoritmo de uma variedade de composições aleatórias, o próprio algoritmo deve ser construído com base na seleção aleatória. A correspondência deve ser como uma chave da fechadura . Se construirmos o algoritmo com base neste princípio, qualquer composição consistente de krainhas serão consideradas como a posição inicial (inicial) no ciclo de tomada de decisão. Além disso, o objetivo será apenas continuar a formação do ramo da busca de uma solução até que uma solução seja encontrada para uma determinada composição ou seja provado que essa solução não existe.

Fig. 6. Reduzir o número de posições livres nas linhas livres restantes após a colocação das rainhas. O modelo de posicionamento é rand & rand .Por outro lado, com a seleção aleatória do índice de linha livre e do índice de coluna livre, as posições da rainha são distribuídas igualmente sobre a "área" da matriz de decisão, o que reduz a taxa "média" de redução no número de posições livres nas linhas restantes. Assim, levando em consideração os recursos do algoritmo rand & rand , nós o usamos no programa para continuar a formação do ramo de pesquisa de soluções até que o nível baseLevel-3 seja atingido .Deve-se notar que, mesmo que os algoritmos de seleção ( randSet e randSet, rand e rand ) não fossem tão eficientes, ainda teríamos que usar outro método de seleção aleatória ao desenvolver o algoritmo. Isto é devido à própria declaração do problema.Problema de conclusão do n-Queens . Se imaginarmos que existe um certo algoritmo ideal que resolve o problema, na entrada, esse algoritmo sempre receberá um determinado conjunto aleatório de índices de linha e coluna. Cada vez será um novo conjunto aleatório de índices de linhas e colunas, com uma enorme variedade de possibilidades. Para poder “absorver” o algoritmo de uma variedade de composições aleatórias, o próprio algoritmo deve ser construído com base na seleção aleatória. A correspondência deve ser como uma chave da fechadura . Se construirmos o algoritmo com base neste princípio, qualquer composição consistente de krainhas serão consideradas como a posição inicial (inicial) no ciclo de tomada de decisão. Além disso, o objetivo será apenas continuar a formação do ramo da busca de uma solução até que uma solução seja encontrada para uma determinada composição ou seja provado que essa solução não existe.6. Um exemplo de uso da regra de risco mínimo (n = 100)

No estágio inicial de localização de uma solução, quando o número de posições livres nas linhas não é crítico, a escolha do índice da linha livre ou o índice da posição nessa linha não é fatal. No entanto, no último estágio, quando o número de posições livres em algumas linhas é 1 ou 2, nesse caso, você deve escolher um algoritmo de seleção diferente. Nesse nível, os algoritmos de seleção aleatória randSet & randSet e rand & rand não funcionarão mais.A razão pela qual os algoritmos de seleção aleatória não funcionarão pode ser explicada pelo seguinte exemplo simples. Vamos, em algum momento da solução do problema, para um valor arbitrário de n, nas linhas restantes i 1 , i 2 , ..., i ko número de posições vagas (indicado entre parênteses) é: i 1 (1), i 2 (2), i 3 (4), i 4 (5), i 5 (3), i 6 (4) etc. Se selecionarmos aleatoriamente qualquer linha, mas não a linha i 1 , na qual existe apenas uma posição livre, isso pode levar a uma situação de risco quando proibições diagonais relacionadas à posição da rainha na linha selecionada podem levar ao fechamento da única posição livre na linha i 1 , o que levará a solução a uma parada. De todas as linhas i 1 , i 2 , ..., i ko mais vulnerável e sensível à escolha do índice de linha é a linha i 1 . Nessas situações, você deve primeiro selecionar a linha cujo status é o mais crítico e criar um risco para resolver o problema. Portanto, na última etapa da solução do problema, em cada etapa é necessário escolher a posição da linha com base em um algoritmo simples de risco mínimo.Para maior clareza, consideremos, por exemplo, uma matriz 100 x 100 , o último estágio na formação de uma solução real, após o 88º passo. Até a conclusão da tarefa, restavam 12 linhas livres, para cada uma das quais o número de posições livres foi encontrado (as linhas são classificadas em ordem crescente do número de posições livres):Etapa 89 - 25 (1), 12 (2), 22 (2), 82 (2), 88 (2), 7 (3), 64 (3), 3 (4), 76 (4), 91 (4), 4 (5), 96 (5) - indica o índice de uma linha livre e, entre parênteses, o número de posições livres nessa linha. De acordo com a regra de risco mínimo, na 89ª etapa da solução do problema, a linha 25 é selecionada e a posição livre que está nela. Como resultado da recontagem, temos 11 linhas livres restantes: Etapa-90 - 7 (2), 12 (2), 22 (2), 82 (2), 88 (2), 3 (3), 64 (3), 76 (3), 4 (4), 91 (4), 96 (4).Como você pode ver, o número de posições livres nas cinco primeiras linhas é igual e igual a 2. Portanto, o índice de uma das três primeiras linhas é selecionado aleatoriamente. Nesse caso, a 12ª linha foi selecionada e a posição dos dois restantes nessa linha, o que leva a danos mínimos. Assim, na 91ª etapa da formação da solução, temos 10 linhas livres: Etapa-91 - 22 (1), 3 (2), 7 (2), 82 (2), 88 (2), 64 (3) 76 (3), 91 (3), 4 (4), 96 (4) . Nesta etapa, a linha 22 é selecionada e aquela posição livre que está nela. Continuando de maneira semelhante, foi formada a seguinte sequência de decisões (Tabela 1). Os índices das linhas selecionadas são mostrados em negrito.Neste exemplo em particular, em 11 dos 12 casos, houve uma situação em que na lista de linhas livres restantes havia pelo menos uma linha na qual apenas uma posição livre permaneceu. Se não usássemos a regra de risco mínimo, não conseguiríamos chegar ao fim. Como um “movimento errado” na escolha de um índice de uma linha livre, provavelmente levaria à destruição da única posição livre que estava em uma das linhas livres restantes. É por isso que, ao usar apenas o algoritmo randSet x randSet ou rand x rand para obter uma solução completa, nos últimos estágios, a solução chega a um beco sem saída.Deve-se notar que o algoritmo de risco mínimo tem um significado cotidiano simples e é frequentemente usado na tomada de decisões. Por exemplo, o médico trabalha primeiro no paciente cuja condição é mais crítica para a vida, da mesma forma, o fazendeiro, durante uma seca severa, tentando salvar a colheita, primeiro regou as áreas que estão na condição mais crítica ...7. Análise da eficiência do algoritmo