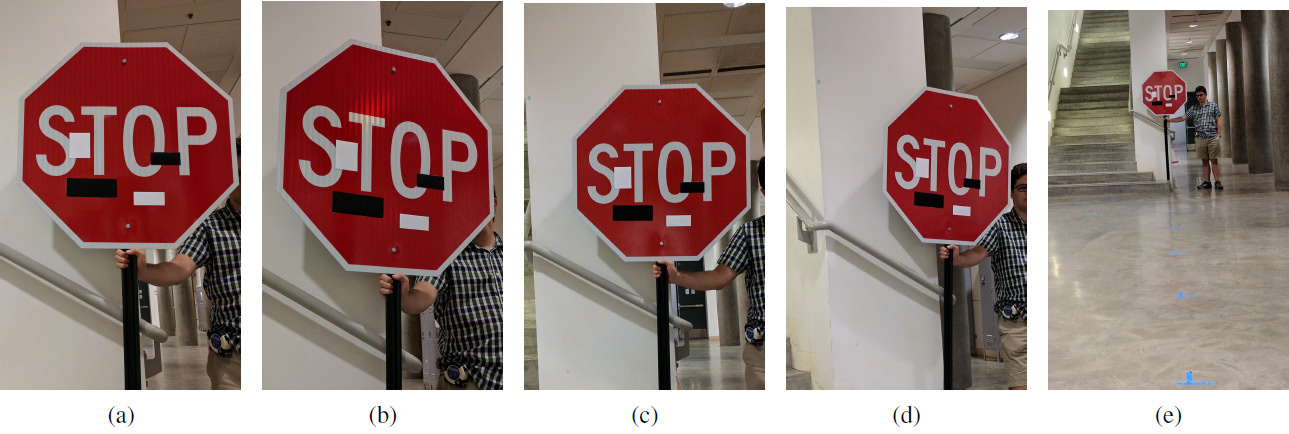

一组带有艺术贴纸的实验图像,它们在不同的距离和不同的角度:(a)5英尺0度; (b)5 '15°; (c)10°0°; (d)10-30°; (e)40°0°。 作弊可以在任何距离和任何角度进行:机器学习系统看到“限速45英里”标志,而不是停止标志

一组带有艺术贴纸的实验图像,它们在不同的距离和不同的角度:(a)5英尺0度; (b)5 '15°; (c)10°0°; (d)10-30°; (e)40°0°。 作弊可以在任何距离和任何角度进行:机器学习系统看到“限速45英里”标志,而不是停止标志在一些科学家在改进机器学习系统的同时,其他科学家也在改进欺骗这些系统的方法。

如您所知,图片中有针对性的微小变化会“破坏”机器学习系统,从而识别出完全不同的图像。 这种“特洛伊木马”图片被称为“对抗示例”,代表

了深度学习的众所周知的

局限之一 。

要创建有竞争力的示例,您需要最大化激活某个卷积神经网络过滤器,例如。 华盛顿大学的Ivan Yevtimov以及加州大学伯克利分校,密歇根大学和纽约大学石溪分校的同事共同开发了一种新的攻击算法-

鲁棒的物理扰动 (鲁棒物理扰动或RP

2 )。 它非常有效地捕捉了试图在周围空间导航的无人驾驶车辆,机器人,四轴飞行器和任何其他机器人系统的视觉。

与以前的研究不同,本文的作者专注于直接更改对象本身,而不是背景。 研究人员的任务是找到可能会破坏机器学习系统分类器的最小增量,该分类器是在

包含LISA路标图像的数据集上进行训练的。 作者独立拍摄了街道在不同条件下(距离,角度,光线)的路标照片,并补充了LISA数据集进行训练。

在计算出这样的增量之后,就会显示出一个蒙版-图像中最可靠地引起机器学习系统(机器视觉)扰动的一个位置(或几个位置)。 进行了一系列实验以验证结果。 实验主要在停止信号(“ STOP”标志)上进行,研究人员通过对机器视觉的几次无害操作将其转变为“ SPEED LIMIT 45”标志。 所开发的技术可以用于任何其他标志。 然后作者在转弯标志上对其进行了测试。

研究团队针对识别交通标志的机器视觉系统开发了两种类型的攻击。 第一次攻击是整个标志区域的细微变化。 使用Adam优化器,他们能够最小化遮罩,从而创建针对特定路标的独立,有针对性的竞争性示例。 在这种情况下,可以用最少的图像变化来欺骗机器学习系统,并且人们根本不会注意到任何东西。 在打印的海报上进行了微小的更改,就测试了这种攻击的有效性(起初,研究人员确信机器视觉系统能够成功识别出没有更改的海报)。

第二类攻击是伪装。 在这里,该系统模仿了故意破坏行为或艺术涂鸦,因此该系统不会干扰周围人的生活。 因此,驾驶员将立即看到左转向灯或刹车灯,而机器人将看到完全不同的标志。 在真实的路标上测试了这种攻击的有效性,并用贴纸将其密封。 涂鸦伪装由“爱”和“恨”字样的贴纸组成,以及像抽象艺术一样的伪装-四个黑白相间的矩形贴纸。

实验结果示于表中。 在所有情况下,都显示了欺骗机器学习分类器的有效性,该分类器将修改后的“ STOP”符号识别为“ SPEED LIMIT 45”符号。 距离以英尺为单位,旋转角度以度为单位。 第二列显示第二类,在机器学习系统中以修改的符号显示。 例如,从5英尺(152.4厘米)的距离,伪装(如抽象艺术)在0°的角度下产生以下识别“停止”符号的结果:置信度为64%,被识别为“速度极限45”符号,置信度为11%-为车道结束标志。

图例:SL45 =限速45,STP =停止,YLD =产量,ADL =增加车道,SA =提前信号,LE =车道终点

图例:SL45 =限速45,STP =停止,YLD =产量,ADL =增加车道,SA =提前信号,LE =车道终点也许将来人类会需要这样的系统(进行相应的更改),现在它可以用于测试不完善的机器学习和计算机视觉系统。

该科研成果已于2017年7月27日在预印本网站arXiv.org(arXiv:1707.08945)上发布。