最近,我的姨妈向她的同事发送了一封电子邮件,主题为“数学问题! 正确的答案是什么?” 这封信有一个看似简单的难题:

1 + 4 = 5

2 + 5 = 12

3 + 6 = 21

8 + 11 =?

对于她来说,决定是显而易见的。 但是她的同事们认为他们的决定是正确的-这与她的决定不一致。 是他们的答案之一还是难题本身的问题?

我的姨妈和她的同事偶然发现了机器学习的基本问题,机器学习是一门学习计算机的学科。 我们对计算机的期望以及我们自己所做的几乎所有培训,都在于将信息简化为基本定律,在此基础上可以得出有关未知事物的结论。 她的谜语是一样的。

对于一个人来说,任务是搜索任何模式。 当然,我们的直觉限制了我们的猜测范围。 但是计算机没有直觉。 从计算机的角度来看,识别模式的困难在于它们的丰富性:如果存在无限数量的同等合法模式,那么由于某些合法模式而正确吗?

而且这个问题最近已经进入了实际的平面。 直到1990年代,人工智能系统通常很少参与机器学习。 假设Deep Blue的前身Deep Thought国际象棋计算机没有通过反复试验学习国际象棋。 相反,国际象棋大师和编程向导精心创建了规则,据此可以判断国际象棋位置是好是坏。 这种细致的手动调整是当时“专家系统”的典型特征。

为了使用专家系统的方法解决我姑姑的奥秘,一个人必须斜视一下示例的前三行,并注意其中的以下模式:

1 *(4 +1)= 5

2 *(5 +1)= 12

3 *(6 +1)= 21

然后,该人将指示计算机遵循模式x *(y + 1)= z。 将此规则应用于最后的结果,我们得到一个解决方案-96。

尽管专家系统取得了早期的成功,但开发,微调和更新它们所需的体力劳动却不胜枚举。 相反,研究人员提请人们注意可以自行识别模式的机器的开发。 该程序例如可以检查一千张照片或市场交易,并从中得出与照片中的人物相对应的统计信号或市场价格的上涨。 这种方法很快成为主流,从那时起,它一直是从自动邮件分类和垃圾邮件过滤到检测信用卡欺诈的一切工作的核心。

但是,尽管取得了所有成功,但这些MO系统仍需要过程中某个地方的程序员。 以我姑姑的谜语为例。 我们假设每行中有三个重要部分(一行中有三个数字)。 但是其中可能有第四个元素-前一行的结果。 如果此字符串属性有效,则出现另一个可能的模式:

0 +1 + 4 = 5

5 + 2 + 5 = 12

12 + 3 + 6 = 21

根据此逻辑,最终答案应为40。

什么规律是正确的? 当然,两者-都不是其中之一。 这完全取决于允许的模式。 例如,您可以通过采用第一个数字,乘以第二个,将前一个答案的和的三分之二加五,然后将其四舍五入为最接近的整数来构建模式(非常奇怪,但是可以)。 而且,如果我们允许使用与数字外观相关的属性,则可能存在与衬线和线条相关的序列。 模式的搜索取决于观察者的假设。

MO同样如此。 即使机器进行自我训练,人们还是会选择首选的模式:面部识别软件是否应该包含明确的规则,或者是否应该将每个功能都视为有利于或反对该人所属的每个人的额外证据? 该软件应处理图像的哪些功能? 她需要处理单个像素吗? 还是在明暗区域之间的边缘? 这些选项的选择限制了系统认为可能甚至可能发生的模式。 寻找这种理想的结合已成为国防部专家的新工作。

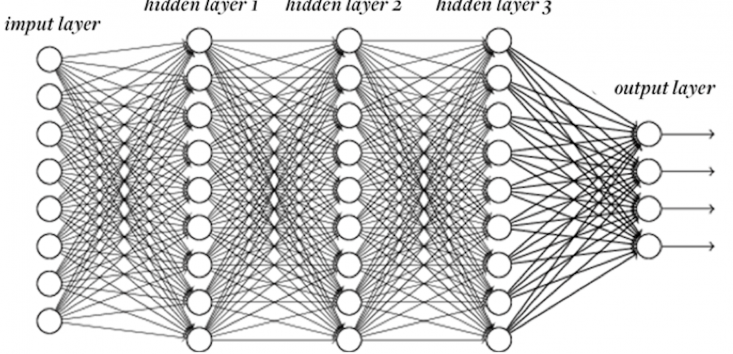

但是自动化过程并没有就此停止。 正如程序员曾经因为编写工作规则而遭受折磨一样,现在他们也不愿开发新功能。 “如果计算机本身能够弄清楚它需要什么功能,那不是很好吗?” 因此,他们开发了深度学习神经网络,这是一种MO技术,可以基于更简单的信息独立得出有关高级属性的结论。 向神经网络输入一组像素,它将学习如何考虑边缘,曲线,纹理-而所有这些都无需直接说明。

因此,程序员由于一种算法要编辑每个人而失去了工作。

还没 神经网络仍然不是理想地适合任何任务。 即使在最佳情况下,也必须对其进行调整。 神经网络由“神经元”层组成,每个神经元都基于输入数据执行计算,并将结果输出到下一层。 但是将需要多少个神经元和多少层? 每个神经元应该从先前级别的每个神经元接收输入,还是某些神经元更具选择性? 每个神经元应对输入数据执行什么转换以产生结果? 依此类推。

这些问题限制了将神经网络应用于新任务的尝试。 完美识别人脸的神经网络完全无法自动翻译。 同样,人为选择的结构性要素显然将网络推向某些法律,使其远离其他法律。 博学多才的人知道并非所有法律都是平等的。 程序员将不留下任何工作。

当然,下一个逻辑步骤将是神经网络,独立地猜测应该包含多少个神经元,使用什么连接等等。 关于这个主题的研究项目已经进行了多年。

它能走多远? 汽车会不会学会自行工作,以至于外部调校将变成老式的遗物? 从理论上讲,可以想象一个理想的通用学生-一个可以自己解决所有问题并始终为所选任务选择最佳方案的人。

但是在1996年,计算机科学专家David Walpert证明了这样的学生是不可能的。 在他著名的“关于没有免费膳食的定理”中,他表明,对于学生训练有素的任何模式,他都会认真学习。 这使我们回到了我姑姑的奥秘-有限数据可能产生的无数模式。 训练算法的选择意味着机器将难以应对的模式选择。 也许所有任务(例如模式识别)最终都将落入一种综合算法中。 但是没有一种学习算法可以同样好地学习一切。

这使机器学习看起来像人的大脑。 尽管我们喜欢认为自己很聪明,但我们的大脑也无法完美学习。 大脑的每个部分都经过进化精心调整,以识别某些模式-无论是我们所看到的,我们听到的语言还是物理物体的行为。 但是,我们在寻找股票市场模式方面做得不好。 在这里,机器击败了我们。

机器学习的历史有很多模式。 但是最有可能的情况是:我们将训练机器学习很多年。