人工智能(AI)系统正在普及。 在这方面,律师和立法者讨论了如何监管此类系统的问题,谁将对其行为负责。 这个问题需要仔细研究并采取一种平衡的方法,因为AI系统能够生成大量数据,并用于各种功能的应用程序-从医疗系统和汽车自动驾驶仪到预测犯罪和计算潜在罪犯。 同时,科学家们正在努力创造一种具有推理能力的“强大的AI”,由此产生了一个问题,即如何确定其行为中是否存在意图-或将行为识别为无意识的。

有很多方法可以使AI系统实现问责制和责任;有关此主题的一些研究已经发表。 在一项新的

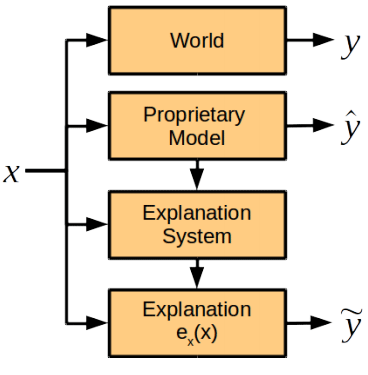

研究论文中 ,来自哈佛大学和美国剑桥大学的计算机科学,认知科学专家和律师讨论了未来AI问责制的一个组成部分,即AI解释性说明的作用,即评估人工智能系统如何解释其行为。 科学家得出的结论是,用于解释动作的模块应与通用AI系统分开。

科学著作的作者描述了试图向AI系统解释其动作时出现的所有问题。

首先,应在系统开发阶段提供这种机会,否则AI可能会拒绝或无法解释其行为。

其次,AI系统使用复杂的专有算法或自身在学习过程中开发的方法来处理大量数据。 因此,当试图以最完整的方式来解释她的行为时,她会产生太多人无法理解的数据。 或者-就像另一个极端-将会提供一个过于简单的模型,无法反映AI的真实意图和行动动机。 此外,人工智能系统的操作算法可能是开发公司的知识产权,因此有必要提供一种解释性说明的汇编方法,以便确定系统起作用的原因,但不给出底层算法。

研究人员认为,在不揭示构成AI系统功能基础的算法和规则的情况下进行解释是可能的。 如果发生事件,系统应提供以下问题的答案:

- 影响决定的主要因素是什么?

- 某个因素的变化会导致决策的变化吗?

- 为什么两个类似的案件导致不同的解决方案?

对此类问题的答案不一定需要公开专有秘密和内部系统算法,但与此同时,它们也可以清楚地了解其动机。

科学家们争论在哪种情况下要求AI解释其行为是适当的。 实际上,在解释的利益大于收据价格的情况下,这是必需的:“我们认为,在三种情况下,公司认为有必要从决策者那里获得解释。 这些是道德,社会或法律上的原因,”该论文的主要作者菲纳莱·多西·韦莱兹(Finale Doshi-Velez)解释说。

同时,不应在每种情况下都要求AI进行字面上的解释。 如上所述,这增加了发布商业秘密的风险,并给AI系统开发人员带来了额外的负担。 换句话说,对人类的持续问责制将抑制这些系统的发展,包括在对人类重要的领域。

与普遍认为AI系统是黑匣子(其成因是人类无法理解的)相反,科学著作的作者确信可以开发出正常功能的模块来解释AI的行为。 该模块将被集成到系统中,但是独立于决策算法而工作,不服从它们。

科学家认为,对于动作的解释中有些要点是人们容易提出的,而对于机器来说则是困难的,反之亦然。

比较人类的能力和AI来解释 | 人 | 人工智能 |

|---|

| 好处 | 可以解释后路行为 | 可重复性,缺乏社会压力 |

| 缺点 | 可能不准确和不可靠,感到社会压力 | 需要说明模块的初步编程,其他分类法和存储系统的扩展 |

但是,专家组建议首先为AI系统设置相同的标准,以解释当前为人们设定的AI行为(该标准在美国法律中有明确规定:特别是在严格责任,离婚和歧视的情况下,做出行政决定并由法官和陪审团解释其决定-尽管每种情况下解释性说明的详细程度有很大不同)。

但是,科学家们说,如果人工智能行动的原因超出了人类的理解范围,那么为了在将来解释人工智能,可以为他们的解释性注释开发另一个标准。

该科学文章于2017年11月3日在预印本网站arXiv.org(arXiv:1711.01134v1)上发布。