2017年5月,Google Brain研究人员推出了

AutoML项目,该项目使机器学习模型的设计自动化。 AutoML实验表明,该系统可以生成性能非常好的小型神经网络-与人类专家设计和训练的神经网络相当。 但是,起初,AutoML仅限于小型科学数据集,例如CIFAR-10和Penn Treebank。

Google工程师想知道-如果我们为AI生成器添加更严格的任务会怎样? 在某些重要任务中,例如对

ImageNet中的对象进行分类(这是机器视觉中最著名的大规模数据集),这个AI系统是否能够生成比人造AI更好的AI? 因此存在一个几乎无需人工干预即可创建的

NASNet神经网络。

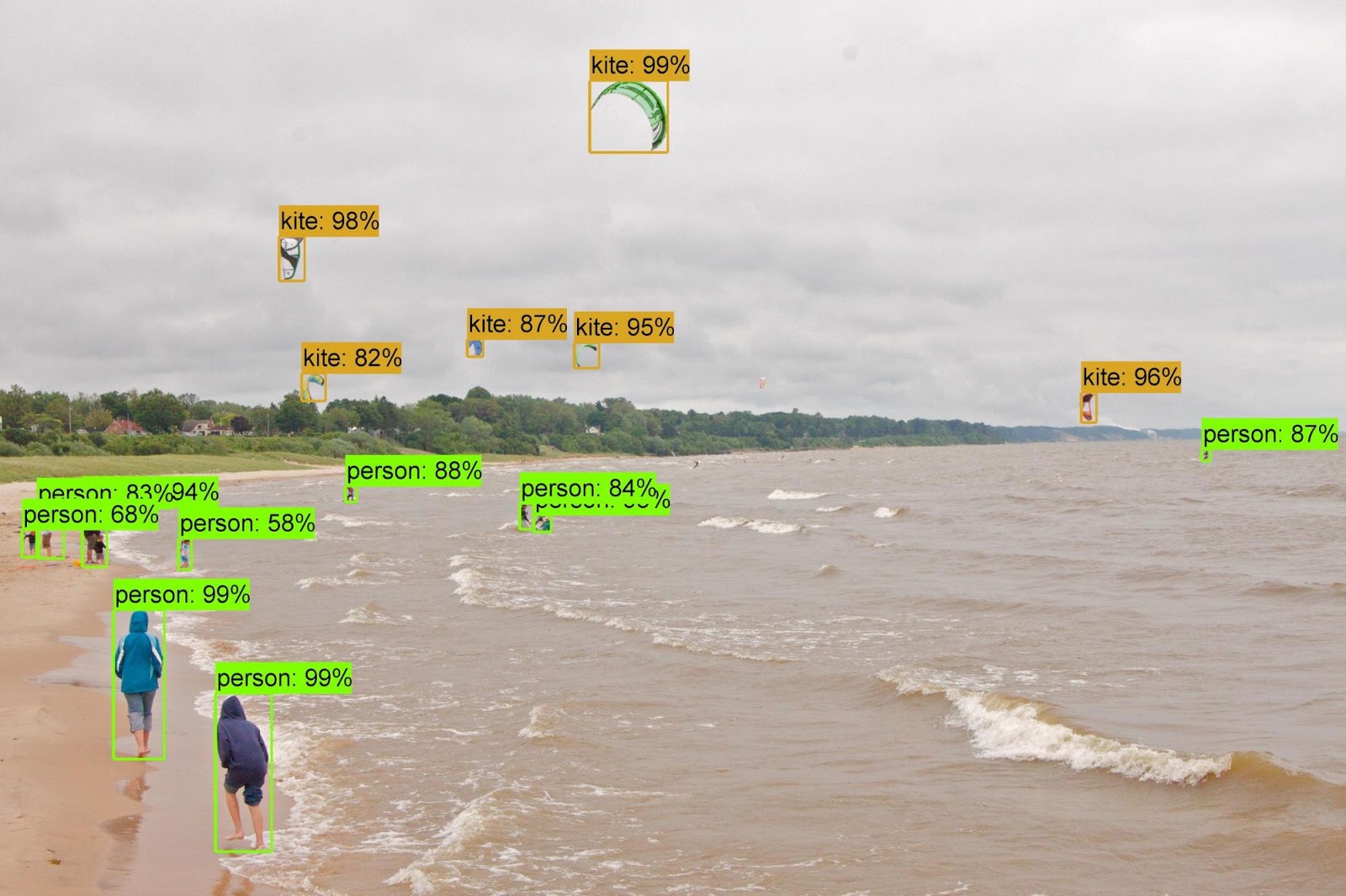

事实证明,人工智能可以应付神经网络的设计和训练,这并不比人类差。 从ImageNet数据集中对对象进行分类并从

COCO数据集中定义对象的任务是“

学习可伸缩体系结构以实现可伸缩图像识别”项目的一部分。

AutoML项目的开发人员

说 ,这项任务并非易事,因为新数据集比系统以前使用的数据集大了几个数量级。 我必须更改一些AutoML操作算法,包括重新设计搜索空间,以便AutoML可以找到最佳层,并在创建最终版本的神经网络之前对其进行多次复制。 此外,开发人员探索了CIFAR-10的神经网络体系结构的选项-并将最成功的体系结构手动转移到ImageNet和COCO任务。

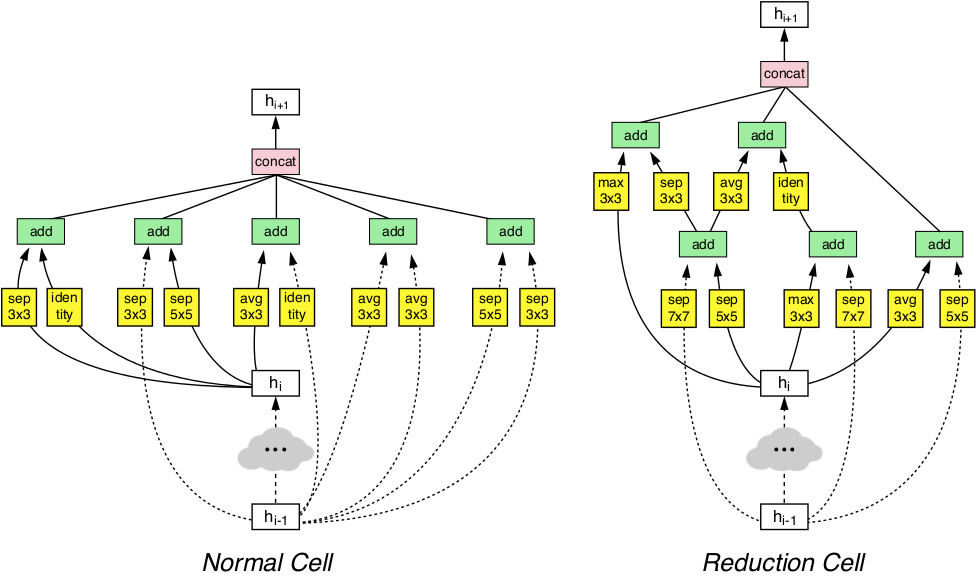

通过这些操作,AutoML系统能够检测到最有效的CIFAR-10神经网络层,并同时在ImageNet和COCO任务中表现出色。 发现的这两层被组合在一起,形成了一个名为NASNet的创新架构。

NASNet体系结构由两种类型的层组成:普通层(左)和约简层(右)。 这两个层是由AutoML生成器设计的。

NASNet体系结构由两种类型的层组成:普通层(左)和约简层(右)。 这两个层是由AutoML生成器设计的。基准显示,自动生成的AI在对象的分类和定义方面超过了人类专家创建和培训的所有其他机器视觉系统。

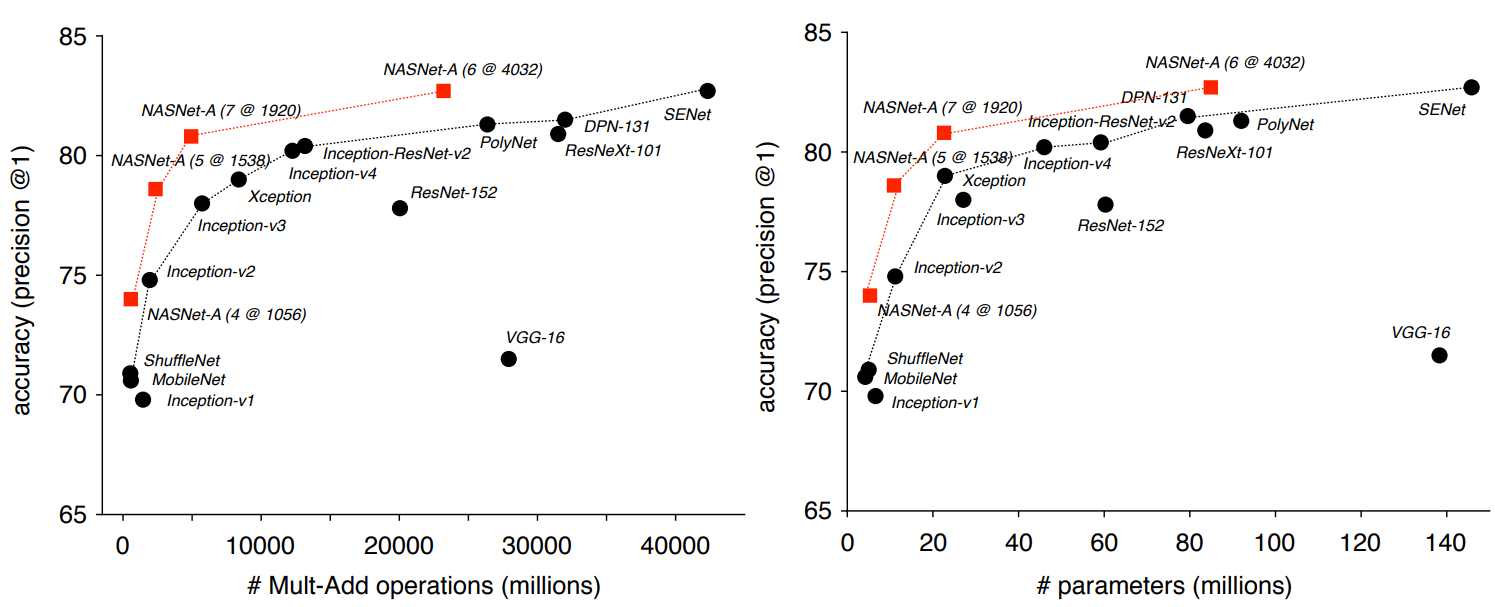

因此,在基于ImageNet的分类任务中,NASNet神经网络在测试集上显示出82.7%的预测准确性。 该结果高于Inception系列以前设计的所有机器视觉模型。 NASNet系统的结果比所有已知的机器视觉神经网络至少高出1.2个百分点,其中包括尚未出版于科学出版社但已发布在arXiv.org预印本网站上的最新成果。

研究人员强调,NASNet可以扩展,因此适合在计算资源薄弱的系统上工作,而不会损失太多准确性。 即使在CPU较弱,内存资源有限的手机上,神经网络也能正常工作。 作者说,微型版本的NASNet显示出74%的准确性,比已知的用于移动平台的最高质量的神经网络高3.1个百分点。

当从ImageNet分类器获取的属性转移到对象识别并与

Faster-RCNN框架结合使用时,无论是在大型模型还是在简化版本的移动平台上,该系统在COCO对象识别问题中均显示出最佳结果。 大型模型的mAP结果为43.1%,比最接近的竞争对手高4个百分点。

作者在TensorFlow的

Slim和

对象检测存储库中打开了NASNet的源代码,因此每个人都可以在自己的工作中体验新的神经网络。

该科学文章已于2017年12月1日在预印本网站arXiv.org(arXiv:1707.07012v3,第三版)上发布。