自主武器-无需人工干预即可进行攻击的杀手机器人-这是非常危险的工具。 毫无疑问。 正如他在

致联合国的公开

信 (Ilon Musk)中所说,穆斯塔瓦·苏莱曼(Mustava Suleiman)是在他的领导下签署的

。 佩雷夫 ]和其他作者,自动武器可以成为“恐吓武器,暴君和恐怖分子可以对无辜人口使用的武器,可以被黑客攻击并使其以不良方式工作的武器”。

但是,这并不意味着联合国就应该像信件的作者所呼吁的那样,对进一步研究这类武器实行预防性禁令。

首先,有时需要使用危险的工具来实现有价值的目标。 记得

卢旺达发生的

种族灭绝大屠杀,当时世界一无所获。 如果在1994年存在自主武器,也许我们就不会站在一边。 如果人道主义干预的成本只能用金钱来衡量,则似乎很容易获得公众对此类干预的支持。

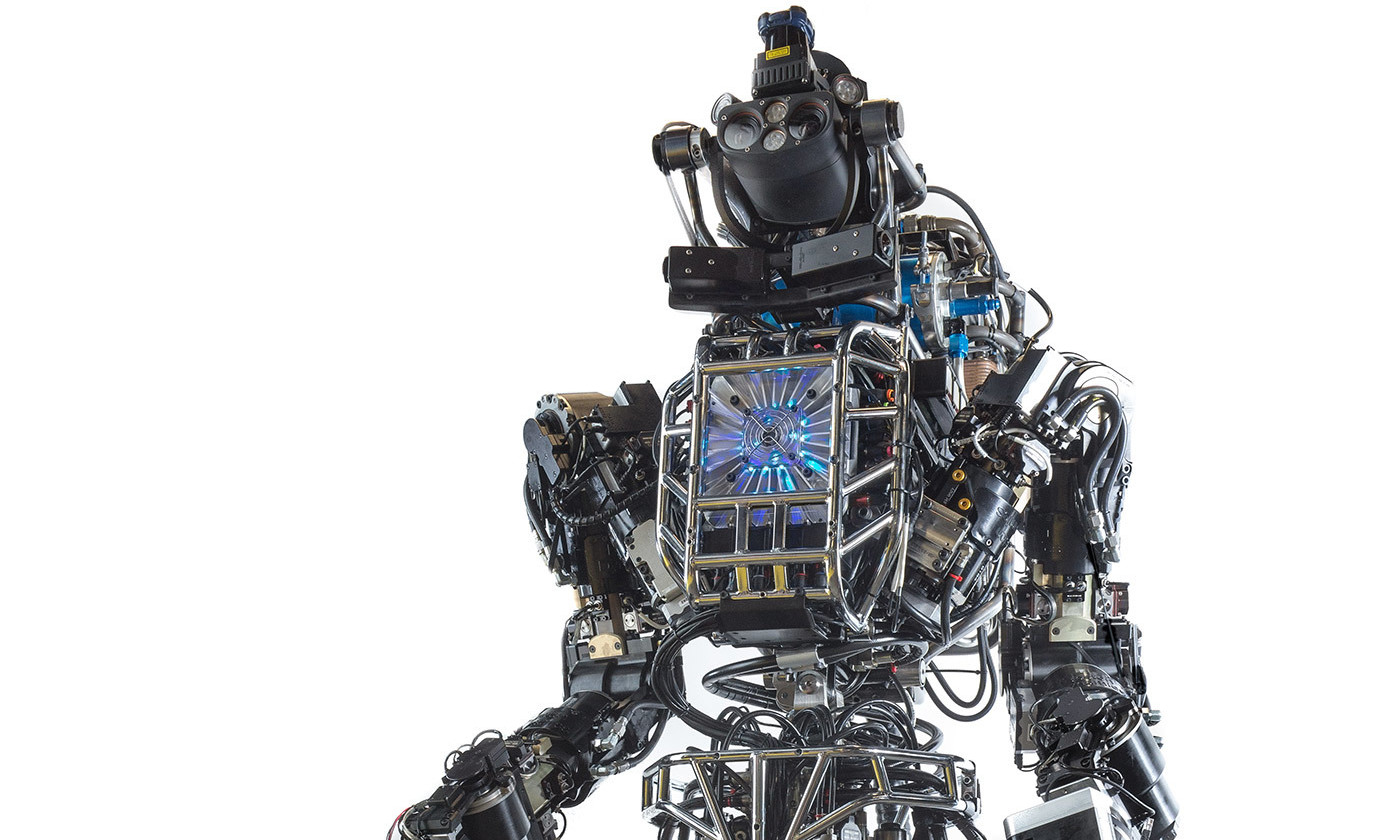

其次,天真地相信我们可以享受AI的最新突破所带来的好处,而不必经历它们的某些缺点。 假设联合国对任何自动武器技术实行预防性禁令。 我们还非常乐观地假设,世界所有军队将遵守这一禁令,并取消自动武器计划的发展。 即使那样,我们仍然要为此担心。 机器人可以很容易地变成一种自动武器系统:您可以教它移动行人,而不是绕着行人走。

一般而言,即使有时我们看不到并无法完全实现,人工智能技术仍然非常有用,并且已经渗透到我们的生活中。 鉴于这种渗透,认为仅仅通过禁止自主武器的发展就可以禁止滥用技术是短视的。 也许正是世界各地的军队开发的先进且选择性运行的自动武器系统,可以有效地对付较粗糙的自动武器,这些武器可以通过对看似和平的AI技术进行重新编程来轻松开发,例如相同的机器人。

此外,在国际一级简单禁止的想法为考虑自主武器提供了过于简化的方法。 这种概念没有认识到各国之间以及彼此之间的行动和协议的因果关系的悠久历史,而这种历史和因果通过成千上万的小小的行动和疏忽导致了这种技术的发展。 尽管有关自动武器的辩论主要在联合国一级进行,但一般公民,士兵或程序员都可以原谅,因为他们对自动武器造成的损害不承担道德义务。 但这是一个非常危险的假设,可能导致灾难。

所有与自动武器技术有某种联系的人都应该进行尽职调查,我们每个人都必须认真考虑他的作为或不作为对这种技术的潜在危害做出了哪些贡献。 这并不意味着国家和国际机构没有发挥重要作用。 如果我们想消除自动武器的潜在危险,就必须强调这一点,那就是必须提高个人责任感,而这种宣传应达到做出决定的最低水平。 首先,对自动武器的发展进行详细而彻底的讨论非常重要,这包括所有在各级作出决定的人的行动的后果。

最后,有时有人争辩说,自主武器之所以危险是不是因为该工具本身具有危险性,而是因为它可以变得独立并开始为自己的利益而行动。 这是一个错误的错误,此外,禁止发展自动武器也无助于防止这种危险。 如果超级智能对人类构成威胁,那么我们迫切需要寻找有效应对这种威胁的方法,并且不管自动武器技术是否会得到进一步发展,都必须这样做。

致《联合国某些常规武器公约》的公开信

随着一些公司创造与人工智能和机器人技术有关的技术,这些技术可以重定向到自主武器的开发,因此,我们对发出这种警报负有特殊责任。 我们热烈欢迎联合国会议通过关于通过“致命性常规武器公约”的决定,该决定是关于任命致命性自动武器系统的政府专家组(政府专家组,GGE)的。 我们的许多研究人员和工程师随时准备提供技术建议以帮助解决此问题。

我们欢迎印度任命阿曼德·辛格·吉尔大使为政府间专家小组主席。 我们要求参加GGE的缔约国积极努力寻找防止此类军备竞赛的方法,保护公民免受滥用,并避免这些技术造成的不稳定影响。 我们遗憾的是,原定于2017年8月举行的GGE第一次会议由于一些国家未向联合国提供财政捐助而被取消。 我们敦促各缔约国在将于11月举行的GGE第一次会议上加倍努力。

详细的自主武器有可能引发军事第三次革命。 它的发展之后,将有可能以前所未有的规模进行军事冲突,而且时间比人们所能想象的短。 它可以成为恐吓的武器,是暴君和恐怖分子可以用来对付无辜人口的武器,可以被砍伐并以不良方式工作的武器。 我们还有一点时间。 打开此潘多拉盒之后,将很难关闭它。 因此,我们要求各缔约国寻找办法保护我们所有人免受这些威胁。