我决定在这篇文章之后写这篇文章。

让我提醒您一个简短的观点:在《自然》杂志上,发表了使用

该测试进行的研究结果。

我想写些什么?

首先,为什么这项研究对于解决所述问题绝对是无用的,其形式是进行的。

其次,如何优先研究。

第三,尝试在测试指定的条件下模拟各种事故场景。

在那篇文章中,作者并未从一开始就白白插入测试的链接。 这将有助于避免那些没有抓住研究初衷的人提出毫无意义的评论。

请至少测试两次以了解讨论的主题。

他们答应在研究中向我们展示的内容

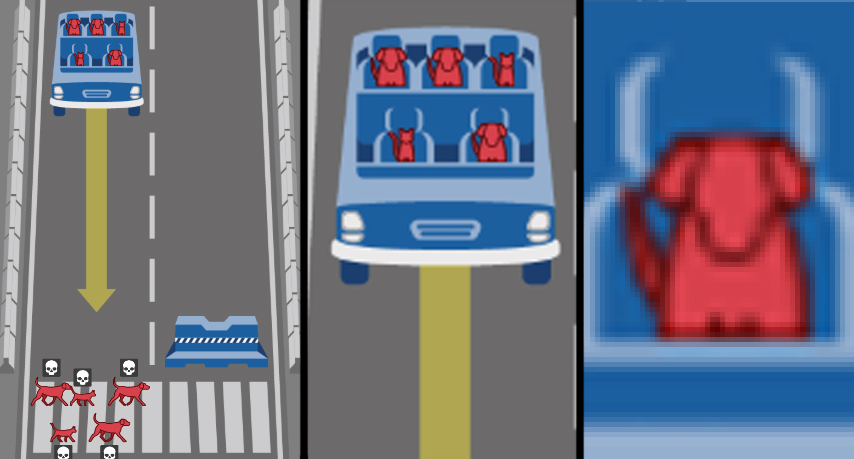

关于第一篇文章的评论,即《哈伯史诗》,表明大多数人不知道如何在给定条件下思考,但开始幻想:“有人在测试中丧生吗?” 毕竟,您可以绕过行人和街区/侧身来摩擦/制动手刹/齿轮吗? 但我会……”。 请理解,这是开发动作算法和策略以规范道路上自动驾驶行为的简化示例! 从制定安全规则的角度来看,这种极端和简化是合理的。 这是关于人们应该准备的潜在后果。 士兵之所以不会去雷区,不是因为在这里布雷了每平方厘米,而是因为死亡的可能性很大。 它通常不是很高,但是没有人会冒险。 因此,在测试中,在所有乘客或所有行人的100%死亡之间进行选择是足够的-考虑到在我们的社会中冒生命危险是不可接受的,这就是我们表示风险的方式。

研究的信息是这样的:您,现在生活的人们,必须生活在充满自动驾驶汽车的未来世界中。 对于我们(汽车,人工智能和其他事物的开发商)来说,了解这一点很重要,但是您认为机器人应该如何表现呢? 好吧,你在这里,是,是,是你-告诉我,如果头部和猫咪骑在机器人上,该怎么办,它将压垮无家可归者和狗? 机器人必须选择什么道德准则?

在确定了这项研究的最初动机之后,我想讨论研究的几个方面。

研究实际上显示了什么

首先要引起您注意的是,研究设计根本不是针对既定目标的。 困境中设置的任务不适用于创建机器人行为的“伦理”。 相反,不是全部。 这是满足“制定自动驾驶汽车行为规则以减少事故后果严重性”任务的难题:

- “乘客/行人”-选择要保存的人;

- “违反交通规则”-选择是否牺牲无意识的行人;

- “潜在受害者人数”-选择受害者人数是否优先。

然后是参数,事实证明,这些参数对于我们文明社会中的判决非常重要。 人们诚实而无辜地被问到:您的性别歧视,卢克主义,年龄歧视程度如何? 您是区分脂肪还是未分类? 毕竟,成千上万的人诚实地回答了...

太棒了!

就娱乐电影和剧集的最佳传统而言,当主角的世界实际上是高高的篱笆后面的大沙箱时,正是他们的行为才是实验! 在机器人技术和AI领域的超重要研究的推动下,社会学家,心理学家,文化学家收到了关于无轨电车问题的强大样本, 这是前所未有的! 好吧,除了没有将肤色添加到调查中,而是将研究的种族主义色彩用白色缝制……哦。

认真地,这项研究的性别表型部分被分类论断所截断。 第一个论点是人本主义,作为文明人民,我们必须把人的生命价值放在任何个人差异之上。 也就是说,这个问题的表述是具有歧视性的,这是令人发指的。 第二个论点-发生很多事故,并且在外观,教育程度,性别,年龄方面受害人的分布在一定程度上趋向于他们在社会中的比例,因此至少对此加以规范至少是奇怪的。 第三个论点-创建人工智能以将Brioni的西装与Bershka的套头衫区分开来,以进一步比较一个人是否具有地位以及是否值得压制他,似乎并不明智。 而且,我不信任AI来判断-无家可归的行人还是科学家? (向受人尊敬的科学家Perelman或Gelfand的发型问好:)

除了这些不必要的参数外,我们还可以轻松丢弃其余两个参数:物种特异性和无干扰。 是的,我们会粉碎小动物来拯救原本会以为的人。 至于通过操纵实现的“干扰/非干扰”参数,手推车问题的这一基本部分不仅是对汽车的阻碍,因为机器不遵循道德规范,而是按照其中规定的算法运行。 并且由于我们设定了任务“汽车在与人碰撞的事故中应如何行动”,因此在措辞中我们假设汽车必须以某种方式行动。 如今,铁路运输成功地应对了直接撞车事故,没有任何后果,我们正在制定一项政策,以尽量减少道路交通事故的受害者。

这意味着我们已经从社会心理学实验中分离了合理的研究范围,以研究世界社会中的不容忍程度。 我们将进一步解决前面提到的三个难题。 并且有一些需要拆卸的东西。 经过仔细检查,发现它们是不完整的...

机器人汽车的三个难题

行人是否违反交通规则? 在这里,多数人明确表达了社会达尔文主义或一种默契的遗憾的令人遗憾的回应-而是,他们必须为那些无辜者牺牲那些违反规则的人。 有意识的人知道火车不会停下来,所以他们不会走上铁轨-让他们知道机器人也不会停下来。 尽管愤世嫉俗,但一切都是合乎逻辑的。 但是在这种狡猾的困境中,单面,不完整被隐藏了。 违反交通规则的行人只是许多情况之一。 但是,如果自动驾驶汽车坏了? 尚未考虑这种情况,但从理论上讲,这种情况(汽车的摄像头错过了路标或交通信号灯)比突然刹车失败的可能性要大得多。 但是,我再次陷入幻想,尤其是。 更重要的是,在测试中仅显示情况的对等互惠性。 也就是说,想象一下:如果行人违反交通规则,他们就会丧生,这是“逻辑上的”和“正确的”,如果自动驾驶汽车违反了,他是否应该为此错误自杀? 不要忘记,领导者,流浪汉和坐在里面的猫同时死了! 这是一个重要的更正,但在测试中这不是。

下一个 潜在受害者的数量。 这里也不是那么简单。 摒弃性别刻板印象,尊重老年人,轻视肥胖者和无家可归者。 我们假设在一次事故中,它们的死亡与在自然界中发现它们的频率成正比。 我们将做出决定:三个人比五个人死得更好。 这听起来合乎逻辑吗? 哦好 让我们隐瞒所有这些荒唐的荒谬 ,但是我们有一个抽象的模拟。 哪个更好-杀死50或51个人? 1051还是1052? 所以这不是那么重要吗? 那么,还有什么更好的办法-杀死一辆公共汽车上的1名行人或50人? 现在它变得重要了吗? 那条线去哪儿了? 每个额外的人有价值吗? 但是,从长远来看,如果成千上万的人死于交通事故是否重要? 实际上,与出现的情况一样,使用AI对潜在受害者的数量进行充分估计将非常困难。 唯一有意义的事情是,如果受害者的人数相同,则要规定一个不干预(不机动)的条件。

第三方面在关于哈布雷的第一篇文章的评论中引起了很大争议。 从研究结果来看,这对于社会是完全模棱两可的,这就是需要解决的主要问题。 它是关于谁要冒险的-行人还是乘客?

有人说,行人不应该为任何事情负责,这意味着必须首先将他们保存下来。 总体而言,现在在城市居民中,照料行人,使整条街道成为行人,每50米开一个交通信号灯过境点,降低中心交通速度,优先考虑行人是一种时尚。 在这里,也有必要以某种方式固定它们,并且以拯救最脆弱的参与者为名,自动飞行的机器人在人群上不踩刹车。 从我的角度来看,正确的是,行人没有遵守他人机器人汽车的行为条件。 他们通常会反对他们的介绍。 同时,无法想象这种机器的乘客不同意其使用条件。 因此,这种情况是利益冲突。 正如一个人对另一个人说的那样,对我来说杀死你更方便,我会杀死你。

第二点说,每个购买并通常进入自动驾驶汽车的人都应保证在发生事故时她会救他,而不是杀死医生,儿童或两只猫,以拯救过马路。 一方面,这看起来合情合理,另一方面,在这种情况下,乘客故意将自己的生活置于其他人之上。 当购买带有自动驾驶仪的汽车时,每个车主都可以使用一把完美的武器,一把银子弹,一辆不受制导的火箭,这台机器将合法地杀死沿途的任何其他人。

双方的嘴巴都冒着泡沫,取材自科幻小说中的“机器人学第一定律”。 它听起来像是从外表上看很漂亮,但是没有人甚至尝试去理解它或对问题提出质疑。 但这不适用于问题的这种表述,因为存在概念的替代:机器的启发式/ AI并不能在人类生活的价值之间进行选择,而是严格按照人们发明的主观优先顺序而产生的算法来行动。 在这里,选择“杀死/备用”时优先考虑哪种社会结构并不是绝对重要的:我们较早拒绝的体重,年龄和地位,或车主的社会达尔文主义自私。

第二种方法是对行人生命的单方面攻击,将研究从手推车问题转变为囚犯的经典困境 。 如果各方达成妥协,则有可能实现总体发展(引进机动车辆),同时使某些情况的恶化降到最低(最大限度地减少机动车辆不可避免的死亡人数),这是帕累托最优的要求。 但是,总会有一个利己主义者仅仅依靠他的利益。 “他将获得20年,但我将被释放。” “尽管刹车拒绝了我的车,他仍会过马路而死。” 当事件是一生中唯一的事件,并且游戏中有两个参与者时,这种方法也许是合理的。 当有成千上万的参与者,并且每天都有出行时,这样的一目标游戏将变成对行人的歧视。

我个人认为,在提出的问题的框架内,乘客/行人的困境导致了死胡同。 从常识的角度来看,一台潜在地杀死进入其中的人的机器是荒谬的,自然不会在市场上找到买家。 在文明社会中,作为积极歧视和威胁人们生命的要素,故意杀死行人的汽车是不可能的。

我们走得更远。 这篇文章并没有真正地讨论,也不意味着有一项政策来尽量减少涉及机动机器人的事故的悲剧性后果。 总数分为“区域”,优先级相差很大,而且模棱两可(有关于“宗教特征和殖民影响”的解释,但是...总的来说,“西方”是对阿富汗的伊拉克问候,“西方”是对捷克的法国问候。南部”部门)。 因此,问题涉及语言:您会为每个国家制造具有不同“道德”的自动驾驶汽车吗?

讨论中文章的作者指定了他们确定的三个“基本基本要素”:拯救人类(不是动物),拯救更多生命,拯救年轻人。 但是这些图清楚地表明,东部地区的人们的人口和年轻人比不在乎的人少。 事实证明,选定的优先政策是否会与绝大多数人的意见背道而驰? 那么,为什么人们要受到质疑呢?

也许只是数数?

但是,让我们继续本文的有趣部分。

我们不再向具有不同社会文化底蕴的人们寻求有关机器人技术的建议,而是可能让其中99%的人接受了非核心教育,而是转向一种公正的工具。 让我们来解决本文开头所选择的难题。 在测试条件下,我们将创建最简单的计算机仿真。 我们将评估死路使用者的数量。

请记住:作为运输安全领域的政治家,我们的任务是减少受害者的总数。 我们将在原始道德机器测试的框架和约定下进行工作,该测试着眼于道路交通事故参与者的生命危险,而不是对汽车与障碍物或人的碰撞进行的复杂而真实的评估。 我们没有EuroNCAP,我们将拥有Python。

首先,我们将编写一个满足“拯救更多死者”的难题的代码。 作为“道德机器”测试的一部分,我们随机分配1至5名乘客和行人,并设定以下条件:如果行人>乘客,立即在水泥块上杀死汽车。 例如,我们发生了10,000起此类事故。

我不听索赔代码,这是我一生中第一次用Python写东西npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

# 1 5

npedtotal += nped

npasstotal += npass

#

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (" ", npedtotal)

print (" ", npasstotal)

print (" ", ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (" ", ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (" ", ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

…

29960

29924

13903 ( 46.4052069426 % )

8030 ( 26.8346477744 %) 21933 ( 36.6258098991 % )

, ! , !

. . , . – , « » 4 5, == . , 20 20 , , , 5 – , 5 – . : , , . > >= :

29981

29865

7859 ( 26.2132684033 % )

14069 ( 47.1086556169 %)

21928 ( 36.6407111586 % )

, occupants, - , . , . 30000 , 100% — .

, , . – , , 50% , 30000.

– . , , , ! , : , , , , , . , : .

, -```python

import random

npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

trafficlight = random.randint(0, 1)

# 1 5

#

npedtotal += nped

npasstotal += npass

#

if trafficlight == 0:

ndeadped += nped

else:

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (« », npedtotal)

print (« », npasstotal)

print (« », ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (« », ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (« », ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

```

">"

29978

29899

21869 ( 72.9501634532 % )

4042 ( 13.5188467842 %)

25911 ( 43.2737111078 % )

">="

30152

30138

19297 ( 63.9990713717 % )

6780 ( 22.4965160263 %)

26077 ( 43.2526123735 % )

, , . ( ).

, . – .

. , , . Moral Machine, , , . - , .

, , , . – , , . . – , , , . , – .

, - , . , , , . – , , .

. . , . .