在选择数据中心时,具有竞争力的价格一直是客户的“争论之王”。 这些价格是由什么组成的? 首先想到的是IT设备和电力的成本,但是在价格结构中,很大一部分是由冷却服务器,存储系统(SHD)和网络设备的成本构成的。 例如,具有多个处理器的服务器发出的热能高达600 W或更多,必须有效地将其除去,并且必须向服务器的通风口的入口提供冷空气。

在本文中,我们将向您介绍Selectel数据中心的气候控制技术,并告诉您该领域的新产品如何降低数据中心的运营成本,并间接降低客户帐户中的金额。

3个服务市场-3个散热要求

粗略估计,在数据中心服务市场中,主要分为三个部分。 首先是托管,然后是IaaS基础架构-专用服务器加上云存储,然后是第三部分-云服务器(VPC,VPS,VMware Cloud),包括公共云,私有云和混合云。

不管看起来多么令人惊讶,但是每个细分市场的客户对气候系统都有不同的要求。 要求最苛刻的客户正在数据中心中放置自己的设备(托管)。 其中有许多具有多年实践经验的IT经理,并对服务器机房中的温度应保持保守的想法。 10-15年前,在寒冷的走廊中提供+ 18°C的要求确实很关键。 但是现代服务器和存储可以稳定地在+ 27°C的温度下工作。

顺便说一下,数据中心服务器机房的特定温度范围是由ASHRAE(美国供暖,制冷和空调工程师协会)的建议严格规定的,该建议在包括俄罗斯在内的世界各地得到了指导。 建议的温度范围会随时间变化,在2000年代初的某个地方实际上是16-20°C,然后是18-22°C,今天,用于冷却服务器的建议空气温度已经是20-27°C。

Selectel技术总监Kirill Malevanov指出:“ Selectel在其数据中心内努力将空气温度保持在根据ASHRAE所建议的平均下限附近,平均约为23°C。”

对于数据中心业务,可以得出以下哪些结论? 使用空调进行昂贵的制冷应主要用于分配用于主机托管服务的服务器机房。 因此,对于用于IaaS服务的服务器机房,对于云服务器,甚至更多,您可以使用能够最大程度地利用环境制冷的设备-甚至可以简单地向外部吹送服务器。

同时,由于Selectel拥有多个数据中心,并且在不同的地区,因此有操作的自由。 换句话说,即使在设计,数据中心建设和气候设备选择阶段,也可以考虑所选服务领域的制冷需求。 在运营的后期,要实现气候系统的现代化,并在提供这些服务时考虑到总拥有成本的降低。

什么是PUE?

数据中心效率的主要指标是自2007年以来在数据中心行业中使用的电源使用效率(PUE)比率。 这个系数是多少:

换句话说,PUE越接近1,则数据中心越完美。 但是,原则上不可能达到1.0的值,因为这对应于永动机的能量效率水平。 顺便说一下,术语PUE的完整定义可以在文档

PUE,度量的综合检查(PDF)中找到 。

实际上,PUE值在1.10和1.15之间被认为是极好的。 例如,根据出版物,对于Google数据中心,一年中不同地区和不同时间的所有数据中心的PUE平均值为1.12。

接下来,我们将仔细研究选定Selectel数据中心的冷却系统。

“花1”-氟利昂

第一个Tsvetochnaya 1数据中心于2008年投入运营,当时托管服务在市场中占主导地位。 此外,这是圣彼得堡的中心-自由空间的状况在某种程度上受到了限制。 因此,在数据中心“花1”中,安装了用于氟利昂数据中心的经典工业空调,至今仍在运行。

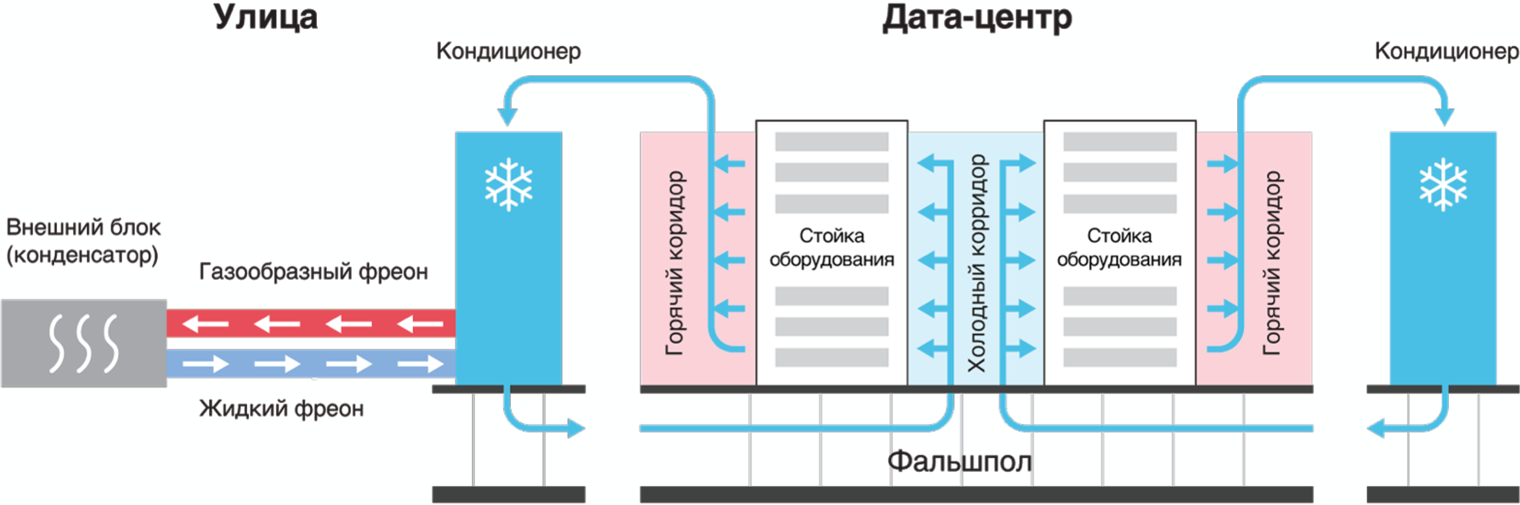

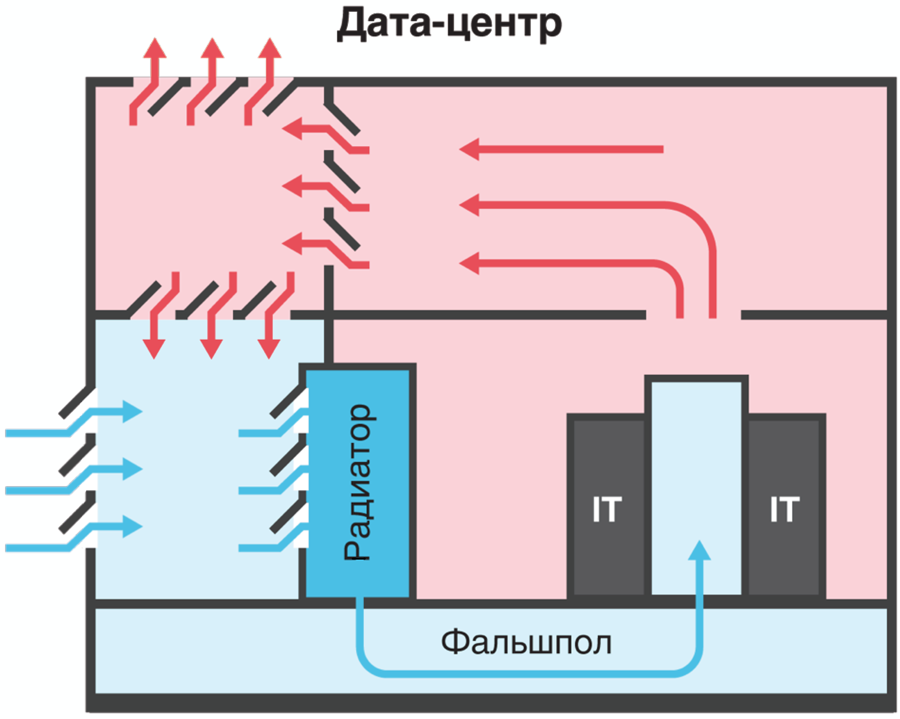

这种空调的工作原理是基于氟利昂向各种聚集状态的转变。 高架地板下的冷空气通过计算机设备被提供给所谓的“冷通道”,热空气进入服务器机房(“热通道”),再从那里被吸入空调热交换器,冷却后重新馈送到服务器和存储系统。

数据中心空调制冷

数据中心空调制冷传统空调的效率非常不理想,因此,Flower 1数据中心的能效系数按现代标准PUE = 1.7相当高。 但是考虑到这里提供托管服务,在整个数据中心进行彻底现代化之前,完全有可能忍受这种情况。

检查数据中心“花1”中的空调

检查数据中心“花1”中的空调“ Dubrovka 1”,“ Berzarina 1”,“ Flower 2”-冷水机

Selectel的下一种冷却技术于2010年进行了测试,当时在列宁格勒地区的Dubrovka村建造了Dubrovka 1数据中心。 在该程序中,这是公司实践中的首次应用冷水机冷却系统。

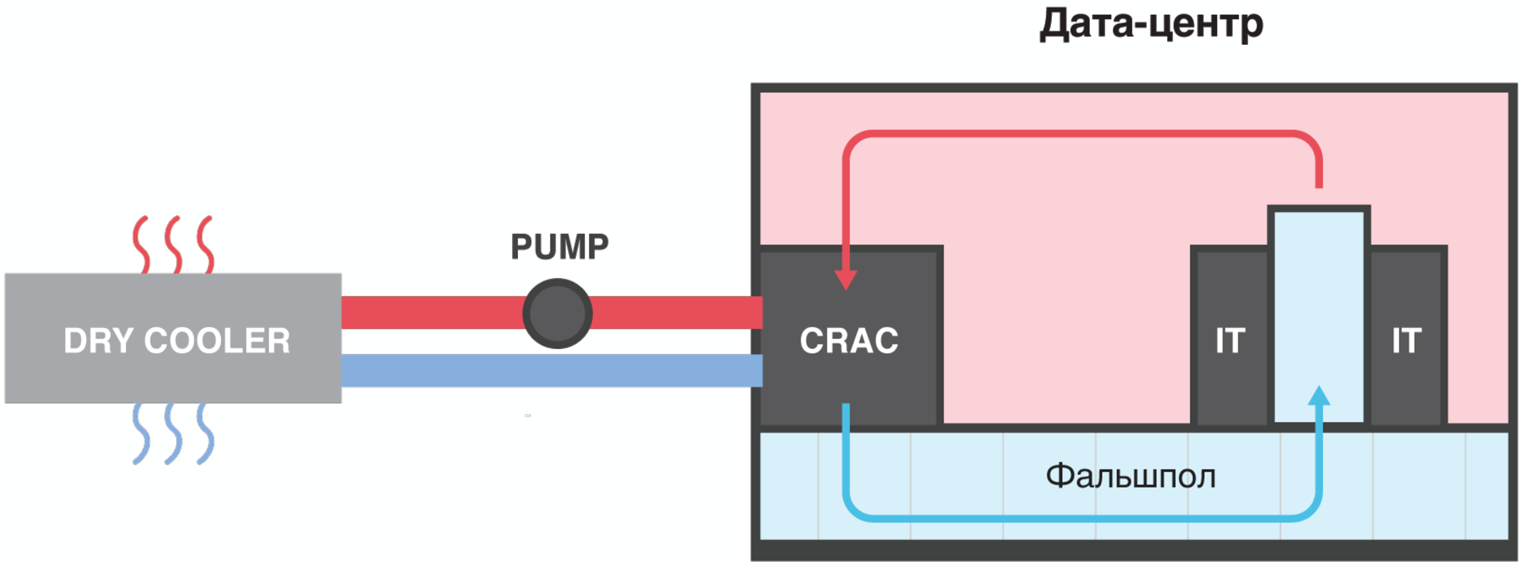

制冷机系统和氟利昂空调之间的区别在于,非冷冻乙二醇溶液在室内机和室外机之间的管道中循环,该溶液始终保持液态且不会进入气态。 溶液被泵送通过服务器机房中的空调,在此被空调的热辐射器加热,再从那里被泵入外部外部热交换器(称为冷却器)。

在冷却器中,乙二醇溶液使用外部空气和额外的冷凝单元进行冷却。 然后,将已冷却的乙二醇溶液再次送入数据中心服务器机房内的空调中。 在这种情况下,计算机设备的冷却是按照传统方案进行的:冷空气从下方通过活动地板从地板供应到“冷通道”,热空气则进入公共休息室,并进一步进入热交换器。

数据中心冷水机

数据中心冷水机具有冷热通道的方案最多可节省5%的能源,因此隔离冷热池(走廊和空气存储)非常重要。

与空调相比,冷却器回路的能源效率更高,这是由于以下事实:冷却器的外部压缩机和冷凝器单元仅在+ 12°C以上的环境温度下才被激活,并且随着乙二醇冷却剂温度的升高,室外机的风扇逐渐开启。 这与常规汽车的发动机冷却系统的工作原理非常相似。

根据冷却器方案,Selectel建立了三个数据中心的冷却系统-Dubrovka 1(2010),Berzarina 1(2011)和Flower 2(2015)。 在Tsvetochnaya 2数据中心的情况下,考虑到Dubrovka 1数据中心在5年的运行中积累的有关许多维护细节的运行经验。 事实证明,尽管操作原理在外观上很简单,但是冷却器系统在操作上相当反复无常,需要仔细维护并遵守法规。 您可以在

我们公司的博客文章 Berzarina 1数据中心中阅读有关冷却器系统操作的更多信息。

Flower Center 2数据中心中的冷通道

Flower Center 2数据中心中的冷通道“ Dubrovka 3”,“ Berzarina 2”-自然冷却

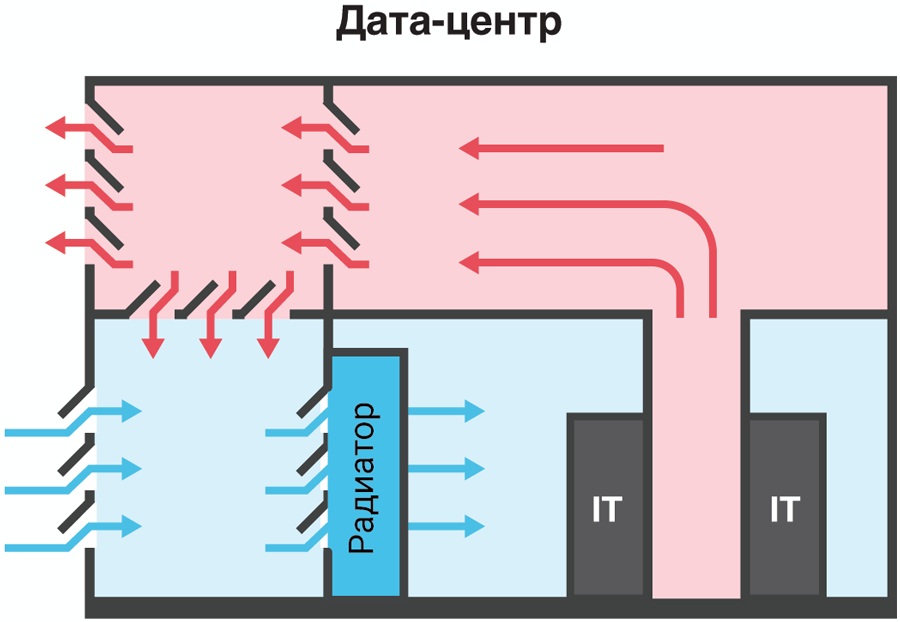

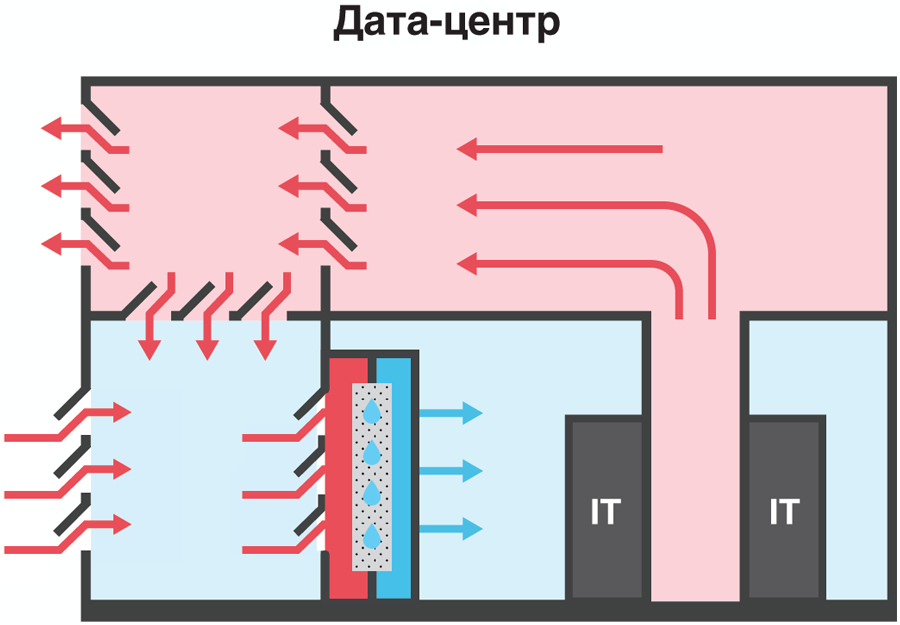

Selectel在向直接自然冷却方案过渡的过程中,采取了提高冷却系统能效的下一步措施。 经典的直接自然冷却的工作原理是排除热交换器,并且由于外部空气的吹扫而导致计算设备的冷却。

外部空气经过过滤器,在那里清除了灰尘,然后进入机舱。 在冬季,根据需要,将冷空气用来自混合室中服务器的暖空气预稀释,以保持吹塑设备的恒定温度。

直接自然冷却,带后冷却功能,无高架地板

直接自然冷却,带后冷却功能,无高架地板如上所述,现代服务器和存储系统可在高达+ 27°C的寒冷走廊温度下可靠运行。 考虑到列宁格勒地区的气候,即使在7月,长期平均日温度也为+ 20°C,这样的解决方案似乎非常可行。 但是,鉴于2010年列宁格勒地区的温度记录为+ 37.8°C,因此不可能完全依靠自然的怜悯。 顺便说一下,“ 2018年炎热的夏天”证实了这些计算的正确性。

因此,于2013年投入使用的Dubrovka 3数据中心在夏季炎热的情况下使用直接自然冷却和额外的冷却装置(ABHM,吸收式制冷机)。 外部空气通过过滤器,然后通过ABXM热交换器。 在服务器机房的冷走廊中,高架地板下方供应空气。

根据高架地板自然冷却方案冷却数据中心

根据高架地板自然冷却方案冷却数据中心正如操作经验所表明的那样,这种解决方案无需在ABCM开启至+ 21°C的环境温度下即可工作,这实际上意味着ABCM仅在夏季运行。 因此,这是一个相当节能的解决方案,PUE约为1.25。

ABCHM的一个重要优点是环境安全,因为它可以在不使用氟利昂的情况下在普通水上工作。 ABXM的缺点包括巨大的外部热交换器,但是由于将Dubrovka 3数据中心放置在几乎干净的场地中,因此,对于ABXM设备的面积而言,这并不是特别的作用。

带有ABHM的数据中心“ Dubrovka 3”的冷却系统

带有ABHM的数据中心“ Dubrovka 3”的冷却系统自2013年以来,带后冷的直接自然冷却系统已显示出很高的效率,并将在莫斯科Berzarina 2数据中心的建设中重新实施。 但是,由于空间有限,后冷却单元将使用绝热系统实现。

关于预订的几句话

传统上,根据至少N + 1的方案来保留Tier III数据中心中的冷却系统。 这意味着必须始终至少有一个制冷单元库存,如果其中一个系统发生事故或维修(定期维护),该制冷单元将投入运行。 因此,在Dubrovka 1数据中心中,当需要3台时,使用4台通风机进行自然冷却;在Dubrovka 3数据中心中,三台ABHM机器(其中一台已关闭且处于待机状态)可以启动。

顺便说一句,Selectel在其数据中心内力求尽可能严格地满足N + 1冗余的要求,并且库存中没有一个,而是两个冗余冷却系统。 例如,在数据中心“花1”和“花2”中,分别有2个备用空调和一个冷却器。

Flower Center 1数据中心(在中心)的服务器机房中的空调

Flower Center 1数据中心(在中心)的服务器机房中的空调“ Berzarina 2”-即将投入使用

2018年11月,新的Berzarina 2数据中心在莫斯科投入运营,这是该公司实践中首次采用采用绝热系统进行后冷却的自然冷却方案。 如果外部空气太热-夏季莫斯科的温度经常超过23°C-则将打开绝热冷却系统。

数据中心“ Berzarina 2”中具有后冷却绝热系统的自然冷却

数据中心“ Berzarina 2”中具有后冷却绝热系统的自然冷却绝热冷却技术基于水在气流路径中以细小液滴的形式雾化,从而可以通过蒸发水来冷却空气。 当使用喷雾型加湿器时,与其他冷却系统相比,冷却过程本身的能源成本很小。 可湿性屏障的复杂蜂窝状结构以所供应的空气的方式不允许水的微滴进一步进入数据中心的管道。 同时,湿度水平保持在IT设备可接受的值之内。

绝热系统“世界上有许多有趣的冷却系统解决方案可以节省能源。 但是,不可能尝试所有新产品-您需要获得融资,进行设计,然后完成设备的购买,设备的准备和调试。 交付,安装,调整和磨合的阶段都是非常漫长的过程。 因此,气候系统在开始工作至少十年后,在运营已建成的数据中心的过程中很少进行根本的现代化。 Selectel技术总监Kirill Malevanov总结道,有趣的新产品已经进入新的数据中心,它们将在其中持续10-15年。