datacenterknowledge.com

datacenterknowledge.com去年,实施了目前最大的基于RAIDIX的存储安装。 RIKEN计算科学研究所(日本)部署了一个由11个故障转移群集组成的系统。 该系统的主要目的是用于HPC基础结构(HPCI)的存储,该存储是作为学术信息(基于SINET网络)的大规模学术交流的一部分而实现的。

该项目的显着特征是其总容量为65 PB,其中系统的可用容量为51.4 PB。 为了更好地理解此值,我们添加了6512个磁盘,每个磁盘10 TB(在安装时是最新的)。 好多

该项目的工作全年进行,此后,系统稳定性的监视持续了大约一年。 所获得的指标满足规定的要求,现在我们可以为我们谈谈这项记录和重大项目的成功。

RIKEN Institute计算中心的超级计算机

在ICT行业,RIKEN研究所主要以其传奇的“ K-计算机”(源自日本的“ kei”,意为10万亿)而闻名,该计算机在发布时(2011年6月)被认为是世界上功能最强大的超级计算机。

超级计算机可以帮助计算科学中心实施复杂的大规模研究:它可以对气候,天气条件和分子行为进行建模,计算和分析核物理中的反应,地震预测等等。 超级计算机的能力还用于更多的“日常”和应用研究-搜索油田和预测股市趋势。

这样的计算和实验会生成大量数据,其价值和重要性不能被高估。 为了充分利用这一点,日本科学家开发了一个单一信息空间的概念,来自不同研究中心的HPC专业人员将可以访问所接收的HPC资源。

高性能计算基础架构(HPCI)

HPCI在SINET(科学信息网)的基础上运行,SINET是在日本大学和研究中心之间交换科学数据的骨干网。 目前,SINET汇集了约850个研究所和大学,为影响核物理,天文学,大地测量学,地震学和计算机科学的研究提供了巨大的信息交流机会。

HPCI是一个独特的基础架构项目,在日本的大学和研究中心之间形成了高性能计算领域的统一信息交换系统。

通过以可访问的形式结合“ K”超级计算机和其他研究中心的功能,科学界在使用超级计算机计算创建的有价值数据时会获得明显的收益。

为了向HPCI环境提供有效的联合用户访问权限,对存储的访问速度提出了很高的要求。 并且由于K计算机的“高生产率”,RIKEN计算科学研究所的存储集群的计算得出的工作量至少为50 PB。

HPCI项目基础结构建立在Gfarm文件系统之上,该文件系统具有较高的性能,并将分散的存储群集组合到单个共享空间中。

Gfarm文件系统

Gfarm是由日本工程师开发的开源分布式文件系统。 Gfarm是高级工业科学技术研究院(AIST)的发展成果,并且该系统的名称是指Grid Data Farm使用的体系结构。

该文件系统结合了许多看似不兼容的属性:

- 体积和性能上的高可扩展性

- 支持多个研究中心的单一名称空间的远程网络分布

- POSIX API支持

- 并行计算所需的高性能

- 资料储存安全性

Gfarm使用来自多个服务器的存储资源来创建虚拟文件系统。 数据由元数据服务器分发,并且分发方案本身对用户隐藏。 我必须说,Gfarm不仅由存储集群组成,而且还包括使用相同服务器资源的计算网格。 该系统的操作原理类似于Hadoop:提交的工作“降低”到数据所在的节点。

文件系统架构是不对称的。 角色分配明确:存储服务器,元数据服务器,客户端。 但是同时,所有三个角色都可以由同一台机器执行。 存储服务器存储许多文件副本,元数据服务器以主从模式运行。

项目工作

Core Micro Systems是日本RAIDIX的战略合作伙伴和独家供应商,它在RIKEN计算科学中心进行了实施。 为实施该项目,花费了大约12个月的艰苦工作,不仅Core Micro Systems的员工,而且Reydix团队的技术专家都参与其中。

同时,过渡到另一个存储系统似乎不太可能:现有系统具有很多技术约束,使向任何新品牌的过渡变得复杂。

在冗长的测试,检查和改进中,RAIDIX在处理如此大量的数据时始终显示出高性能和高效率。

关于改进,值得多讲一点。 不仅需要创建存储系统与Gfarm文件系统的集成,还需要扩展软件的某些功能。 例如,为了满足技术规范的既定要求,有必要尽快开发和实施自动直写技术。

系统本身的部署是系统的。 Core Micro Systems的工程师认真,准确地进行了测试的每个阶段,从而逐渐增加了系统的规模。

2017年8月,系统容量达到18 PB时,完成了第一个部署阶段。 同年10月,实施了第二阶段,该阶段的容量上升到创纪录的51 PB。

解决方案架构

该解决方案是通过RAIDIX存储系统和Gfarm分布式文件系统的集成创建的。 与Gfarm结合使用,可以使用11个双控制器RAIDIX系统创建可扩展存储。

通过8 x SAS 12G连接到Gfarm服务器。

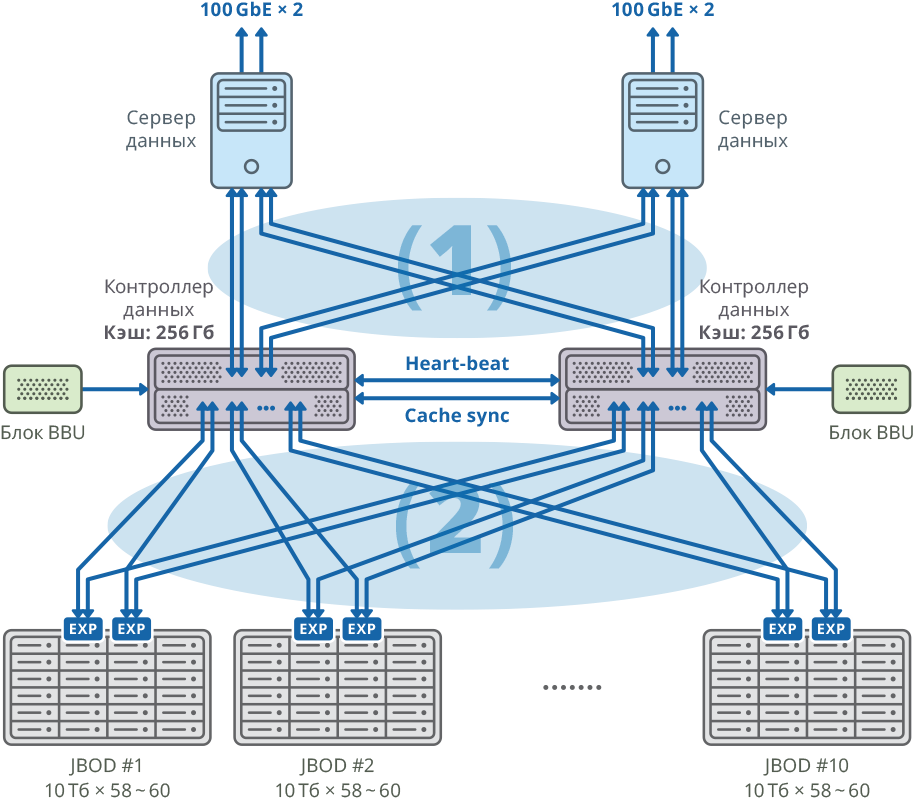

图 1.每个节点都有一个单独的数据服务器的集群映像

图 1.每个节点都有一个单独的数据服务器的集群映像(1)48Gbps×8个SAN Mesh连接; 带宽:384Gbps

(2)48Gbps×40网格FABRIC连接; 带宽:1920Gbps

双控制器平台配置

| 中央处理器 | 英特尔至强E5-2637-4个 |

| 主机板 | 与支持PCI Express 3.0 x8 / x16的处理器型号兼容 |

| 内部缓存 | 每个节点256 GB |

| 底盘 | 2U |

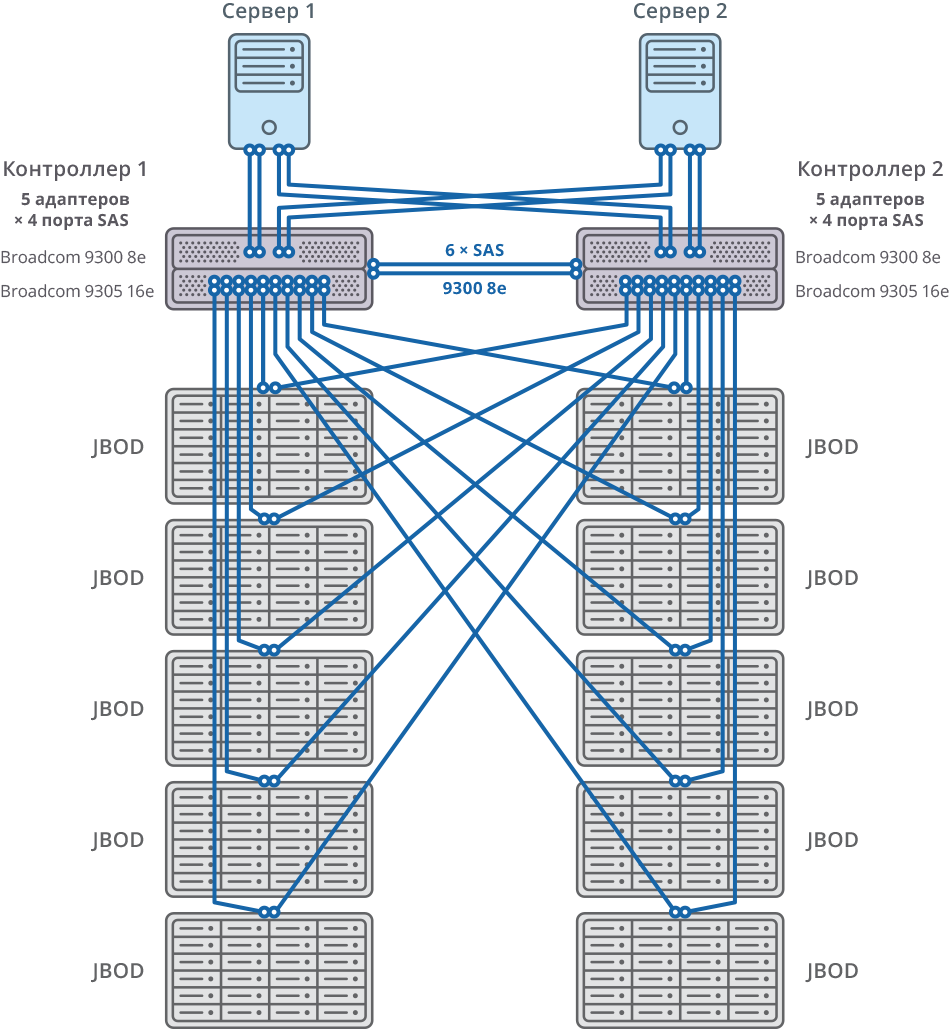

| SAS控制器,用于连接磁盘架,服务器和写入缓存同步 | Broadcom 9305 16e,9300 8e |

| 硬碟 | HGST氦气10TB SAS硬盘 |

| 心跳同步 | 以太网1 GbE |

| CacheSync同步 | 6个SAS 12G |

故障转移群集的两个节点都通过每个节点的20个SAS 12G端口连接到10个JBOD(每个磁盘10 TB的60个磁盘)。 在这些磁盘架上,创建了58个10TB RAID6阵列(8个数据磁盘(D)+ 2个奇偶校验磁盘(P)),并为“热交换”分配了12个磁盘。

10 JBOD => 58×RAID6(8个数据磁盘(D)+ 2个奇偶校验磁盘(P)),580个HDD + 12个HDD的LUN用于“热插拔”(占总容量的2.06%)

每个群集592个HDD(10TB SAS / 7.2k HDD)* HDD:HGST(MTBF:250万小时)

图 2.具有10个JBOD连接图的故障转移群集

图 2.具有10个JBOD连接图的故障转移群集通用系统和连接图

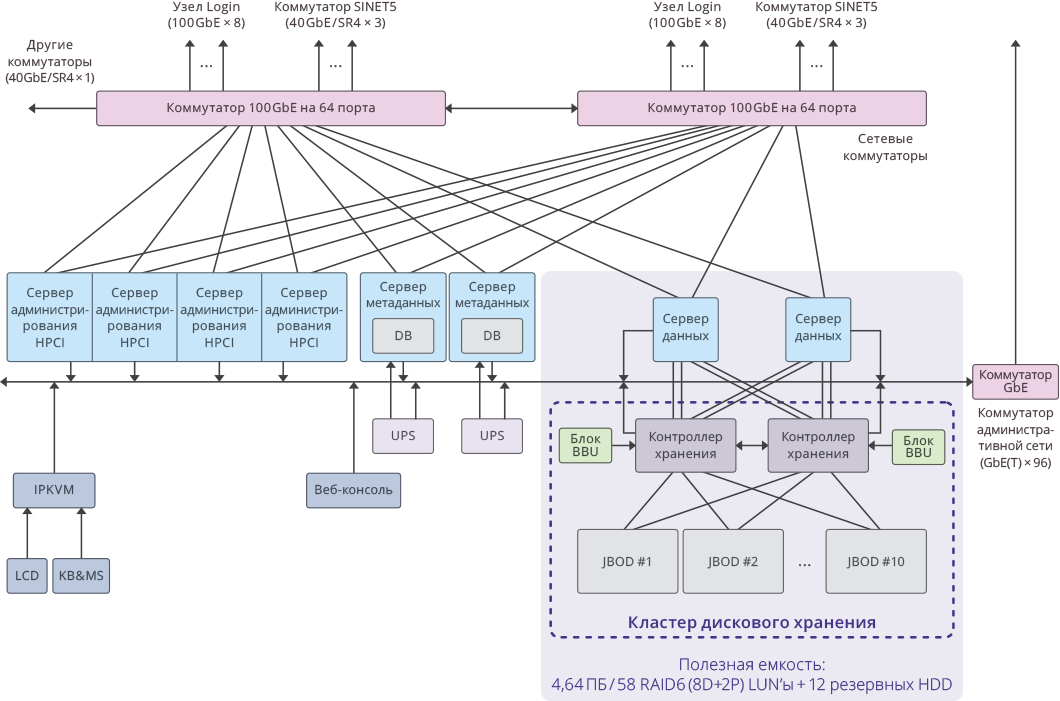

图 3. HPCI系统内单个群集的映像

图 3. HPCI系统内单个群集的映像关键项目指标

每个群集的可用容量: 4.64 PB ((RAID6 / 8D + 2P)LUN×58)

整个系统的总可用容量: 51.04 PB (4.64 PB×11个群集)。

系统总容量: 65 PB 。

系统性能为:写入17 GB / s ,读取22 GB / s 。

11个RAIDIX存储系统上群集的磁盘子系统的总性能: 250 GB / s 。