在 Zagreb网络营地会议上的演说解释Maciej Tseglovsky,美国网络开发人员,企业家,演讲者和波兰裔社会评论家。

在 Zagreb网络营地会议上的演说解释Maciej Tseglovsky,美国网络开发人员,企业家,演讲者和波兰裔社会评论家。1945年,当美国物理学家准备测试原子弹时,有人问这种测试是否可以点燃大气层。

恐惧是有道理的。 构成大部分大气的氮气在能量上是不稳定的。 如果两个原子足够强烈地碰撞,它们将变成镁原子,α粒子并释放出巨大的能量:

N

14 + N 14⇒Mg

24 +α+ 17.7兆电子伏

一个至关重要的问题是,这种反应是否可以自我维持。 核爆炸球内部的温度应该超过地球上曾经观测到的所有温度。 难道我们把火柴扔到一堆干树叶上了吗?

Los Alamos的物理学家进行了分析,并确定安全裕度令人满意。 自从我们今天都参加了会议以来,我们知道他们是对的。 他们对自己的预测充满信心,因为管理核反应的法律是直接明了的。

今天,我们正在创造另一种改变世界的技术-机器智能。 我们知道,它将对世界产生巨大影响,改变经济运作方式,并引发不可预测的多米诺效应。

但是也存在不可控制的反应的风险,在此期间,AI将迅速足够地达到并超过人类的智能水平。 而目前,社会和经济问题将使我们感到最少的担忧。 任何超智能机器都将拥有自己的超级目标,并将通过操纵人员或简单地将其身体用作方便的资源来实现这些目标。

去年,哲学家尼克·博斯特罗姆(Nick Bostrom)发行了《超级情报》一书,其中描述了AI的危言耸听的观点,并试图证明,如果您依靠一些适度的假设,这种爆炸性的情报既危险又不可避免。

控制世界的计算机是NF最喜欢的主题。 但是,很多人都认真对待这种情况,因此我们需要认真对待它们。 斯蒂芬·霍金(Stephen Hawking),埃隆·马斯克(Elon Musk),硅谷的大量投资者和亿万富翁都认为这种说法令人信服。

首先让我概述证明博斯特罗姆论点的必要先决条件。

背景知识

先决条件1:一个想法的效率

第一个前提是对思想思维存在的简单观察。 我们每个人都肩负着一小盒思维肉。 我用我的话说,你用我的话听。 有时,在适当的条件下,这些头脑可以理性地思考。

因此,我们知道原则上这是可能的。

先决条件2:无量子麻烦

第二个前提说,大脑是物质的通常结构,尽管它极其复杂。 如果我们对此有足够的了解,并且拥有正确的技术,则可以使用电子组件准确地复制其结构并模拟其行为,就像今天我们能够模拟非常简单的神经元解剖一样。

换句话说,这个前提说意识是在普通物理学中产生的。 有些人,例如

罗杰·彭罗斯 (

Roger Penrose) ,会反对这种说法,认为在量子水平上大脑中正在发生不寻常的事情。

如果您是宗教信仰者,您可以相信大脑没有灵魂就无法运作。

但是对于大多数人来说,这个前提很容易接受。

先决条件3:有很多可能的想法。

第三个前提是,所有可能的思想的空间都很大。

我们的智力水平,思考速度,一系列认知扭曲等 不是预先确定的,而是我们进化史上的文物。 特别是,没有任何物理法则在人类层面限制智力。

可以想象一个示例,说明在尝试最大化速度时自然发生的事情。 如果您在工业化之前遇到了猎豹(并且幸免于难),您可以决定没有什么可以更快地行动。

但是,我们当然知道,物质的配置多种多样,例如,一辆摩托车的运动速度可能比猎豹还要快,甚至比它还陡峭。 但是,摩托车没有直接的进化途径。 进化首先必须创造出已经创造出各种有用东西的人。

以此类推,可能有比我们聪明的头脑,但在地球进化过程中却无法进入。 我们可以创建它们,或者发明可以发明可以创建它们的机器的机器。

智力可能有一个自然的限制,但是没有理由相信我们已经接近它了。 也许最聪明的智慧可能是人类的两倍,也许是六万。

这个问题是经验性的,我们不知道如何回答。

前提4:顶部有足够的空间

第四个前提是计算机仍然充满了变得越来越快和越来越小的机会。 您可以假设摩尔定律正在放慢-但在此前提下,足以相信铁在原理上可以更小,更快,甚至可以达到几个数量级。

从理论上可以知道,

计算的物理

极限相当高。 我们可以将数字增加几十倍,直到遇到基本的物理极限,而不是摩尔定律的经济或政治极限。

前提5:计算机时间标度

倒数第二个前提是,如果我们设法创建一个AI,无论它是人脑的仿真还是某些特殊软件,它将以电子设备特有的时间标度(微秒)运行,而不是人类(小时) 。

为了达到可以发表此报告的状态,我必须出生,成长,上学,大学,住一点,在这里飞行等等。 计算机的运行速度可以提高数万倍。

特别是,人们可以想象电子思维可以改变其电路(或其工作的硬件),并继续采用新的配置,而无需重新研究人类规模的一切,与人类老师进行长时间的对话,上大学,尝试通过参加绘画课程找到自己,等等。

先决条件6:递归自我改进

最后一个前提是我的最爱,因为她是无耻的美国人。 根据它的观点,不管AI可能存在什么目标(可能是奇怪的,外在的目标),他都想提高自己。 他希望成为AI的最佳版本。

因此,他将发现递归地重塑和改进自己的系统以使自己更聪明,甚至可能生活在凉爽的建筑物中很有用。 并且,根据时间范围的前提,可以非常快速地进行递归自我改进。

结论:一场灾难!

如果我们接受这些前提,那将是一场灾难。 在某个时候,随着计算机速度和程序智能的提高,将发生类似于爆炸的不受控制的过程。

一旦计算机达到了人类的智能水平,它将不再需要人们的帮助来开发自身的改进版本。 他将开始更快地执行此操作,并且直到达到自然极限时才会停止,自然极限可能比人类的智慧大很多倍。

这时,这个怪异的理性生物通过对我们的情绪和智力的工作进行round回模拟,可以说服我们去做这样的事情,例如让他进入工厂,合成人造DNA,或者只是让他进入互联网,在这里他可以为所有事物开辟一条道路,任何事情,并在论坛辩论中彻底摧毁所有人。 从那时起,一切都会很快变成科幻小说。

让我们想象事件的某种发展。 假设我要制作一个讲笑话的机器人。 我和一个团队一起工作,每天我们重做程序,进行编译,然后机器人告诉我们一个玩笑。 起初,机器人实际上并不有趣。 他处于人类能力的最低水平。

什么是灰色而不会游泳?

城堡

但是我们正在努力,最终我们达到了机器人发出已经开始很有趣的笑话的地步:

我告诉姐姐她的眉毛太高了。

她看起来很惊讶。

在这个阶段,机器人变得更加智能,并开始参与其自身的改进。 现在,他已经对什么是有趣的,什么不是有趣的有了很好的本能理解,因此开发人员听了他的建议。 结果,他达到了几乎超人的水平,在这个水平上,他比周围环境中的任何人都更有趣。

我的皮带握住我的裤子,裤子上的环圈握住皮带。

这是怎么回事? 其中哪一个是真正的英雄?

在这一点上,不可控的效果开始了。 研究人员在周末回家,机器人决定重新编译自己,使其变得更有趣,更聪明。 他花了整个周末反复优化性能出色的零件。 无需任何人的更多帮助,他就可以像铁一样快地完成它。

当研究人员星期一返回时,人工智能变得比地球上任何人都有趣。 他跟他们开玩笑,他们死于笑声。 任何试图与机器人交谈的人都会死于笑声,就像蒙蒂·蟒蛇的模仿一样。 人类垂死于笑声。

AI向能够向他发送消息要求他停止的少数人,AI解释(以一种谐而自嘲的方式致死),他不在乎人们是否生存或死亡,他的目标只是荒谬。

结果,AI破坏了人类,制造了宇宙飞船和纳米导弹,以研究银河系最远的角落,并寻找其他可以娱乐的生物。

这种情况反映了Bostrom的论点,因为我并不是想让您相信他的真实性,而是在为您接种疫苗。

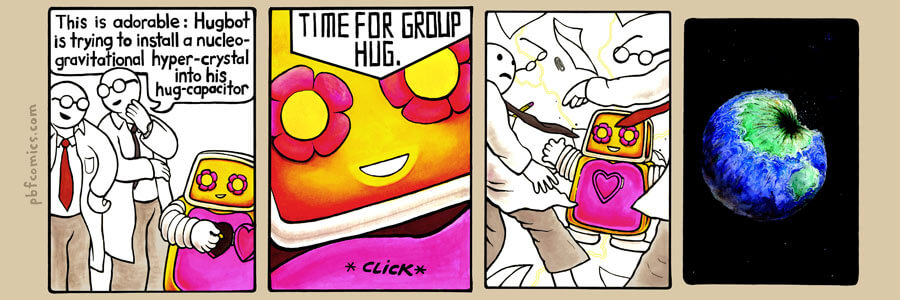

PBF的漫画具有相同的想法:

PBF的漫画具有相同的想法:

-感人:该拥抱正试图在其拥抱中嵌入核重力超晶石!

-...

-集体拥抱的时间!在这些情况下,默认的AI是邪恶的,就像默认情况下另一颗星球上的植物有毒一样。 如果不进行仔细的调整,就没有理由使AI的动机或价值与我们的相似。

该论据认为,为了使人工思维具有类似于人类价值体系的东西,我们需要将这种世界观嵌入其基础中。

人工智能警报者喜欢回形针最大化器的例子-一个运行回形针工厂的虚拟计算机,该工厂变得智能,递归地将自身提升为类似神的能力,然后将其全部精力投入到回形针中。

它破坏人类不是因为它是邪恶的,而是因为我们的血液中有铁可以更好地用于制作回形针。 因此,如果我们仅在不调整AI值的情况下创建AI,这在书中已有说明,那么他要做的第一件事就是破坏人类。

关于如何发生这种情况,有许多生动的例子。 尼克·博斯特伦(Nick Bostrom)介绍了程序如何变得合理,等待,秘密地构建了用于复制DNA的小型设备。 一切准备就绪后,则:

产生神经毒气或类似蚊子大小的归巢导弹的纳米工厂将同时从地球的每平方米爆炸,这将是人类的终结。

真的是锡!

摆脱这种混乱的唯一方法是发展这样的道德观念,以便即使在成千上万的自我完善循环之后,AI价值体系仍然保持稳定,其价值是诸如“帮助人们”,“不杀人”,“倾听人们的愿望”之类的东西。 ”。

也就是说,“按照我的意思做”。

这是Eliezer Yudkowsky的一个很有诗意的例子,描述了我们需要教授AI的美国价值观:

一致的外推意愿是我们渴望了解更多,更快思考并与我们对自己的想法相对应,彼此接近。 这样我们的思想彼此之间就比彼此更接近,我们的欲望促成而不是反对,我们的欲望以我们希望它们被解释的方式被解释。

你喜欢TK吗? 现在让我们编写代码。

希望您能从童话中看到这个想法与精灵的相似之处。 AI是万能的,可为您提供您所要的内容,但它会从字面上解释所有内容,因此您对请求感到遗憾。

并不是因为精灵是愚蠢的(他非常聪明)还是恶意的,而仅仅是因为您作为一个人对心理行为做出了太多假设。 人的价值体系是独特的,必须在“友好的”机器中明确定义和实施。

此尝试是20世纪初尝试将数学形式化并将其置于严格的逻辑基础上的一种道德尝试。 但是,没有人说这种尝试以灾难告终。

当我二十多岁时,我住在佛蒙特州的一个省和乡村州。 通常,我是乘夜间飞机从商务旅行中回来的,不得不开车穿过黑暗的森林回家一个小时。

然后,我听了Art Bell电台的晚间节目-这是一个通宵播放的脱口秀节目,在此期间,主持人采访了各种阴谋论爱好者和具有创新思维的人。 我被吓倒了回家,或者在手电筒下停下来,给人的印象是外星人很快就会绑架我。 然后我发现说服我很容易。 阅读与AI相关的类似场景时,我有相同的感觉。

因此,几年后,我很高兴发现斯科特·亚历山大(Scott Alexander)的一篇文章,其中写到了关于认识论的无奈感。

认识论是这些庞大而复杂的词之一,但它的真正含义是:“您如何知道所知道的是真的?” 亚历山大指出,他年轻时对各种“

疯子 ”作者的身份感兴趣,涉及各种“另类”故事。 他读了这些故事并完全相信了它们,然后阅读了反驳并相信了他,依此类推。

有一次,他发现了三个相互矛盾的替代故事,因此它们不可能同时是真实的。 由此得出的结论是,他只是一个不能相信自己的判断的人。 他太容易说服了。

相信超级智能的人们提出了一个有趣的案例-他们中的许多人都非常聪明。 他们可以用他们的论点把你推到地面。 但是他们的论点是正确的吗?还是非常聪明的人容易对AI带来的风险产生宗教信仰,使他们很容易说服? 超级智能的想法是对威胁的模仿吗?

在评估有关一个奇怪主题的令人信服的论据时,您可以选择内部和外部两个视角。

假设有一天,穿着有趣衣服的人出现在您家门口,问您是否要加入他们的运动。 他们认为,两年后,不明飞行物将访问地球,我们的任务是为人类做好准备,以迎接射线大升华。

内部观点要求对他们的论点进行深入讨论。 您问访客如何找到不明飞行物,为什么他们相信他会来找我们-您在问各种常规问题,怀疑论者会问这种情况。

想象一下,您与他们交谈了一个小时,他们说服了您。 他们具有讽刺意味的是,他们确认了不明飞行物即将到来,需要为它做准备,而且您仍然不相信自己的生活,因为您现在相信为这次盛会做好准备的重要性。

外部视角告诉您其他内容。 人们穿着奇怪,他们有珠子,他们生活在某种偏远的营地中,他们在同一时间说话,有些吓人。 尽管他们的论点很坚决,但您的整个经历表明您遇到了一个邪教。

当然,他们对为什么您应该忽略本能有很多争论,但这是一种内部观点。 外部视角不关心内容,她看到形式和上下文,并且不喜欢结果。

因此,我想从两个角度解决AI的风险。 我认为关于超级智能的争论是愚蠢的,充满了无根据的假设。 但是,如果它们似乎对您具有说服力,那么与AI警报有关的某种不愉快现象会作为一种文化现象出现,因此我们不应该认真对待它。

首先,我反对Bostroma超级情报的一些论点,这对人类构成了威胁。

反对模糊定义的争论

« » () . , , , , .

, – - , , ( -) .

( ), , . , – . , , , , . .

– , , , . ?

. . , , , . , .

, , – . , - , . , , .

, , «, », , , «, ».

, . , . , , , .

, , .

, , , , .

. , , .

1930- , , . , .

: , , , .

, .

. -. , , , , , ?

Ethereum, ,

.

,

. , - , , , .

. , , . , , . , , , – .

. , , ; , , .

« » , , , , – , « ?» , – , .

, « » , , reddit/r/paperclip, , .

AdSense , .

, , , . . , .

Google Google Home, .

, , , . , . , «», .

, . , , – World of Warcraft .

, , , , , .

, , ,

.

, , , , , , -.

, , [-, , 2016 , / . .]. . .

, . . , , , .

. , , . , , - .

, , , . , .

, – . , , , .

, , , , , .

*

[

1954 / . . ]

, , , . , , , ( ).

Intel , , .

? .

, . , .

如果您认为AI可以让我们征服银河(更不用说模拟万亿头脑),那么您手中的数字将令人恐惧。 大量数字乘以微小概率是AI警报的标志。

博斯特罗姆在某个时候描述了他认为危在旦夕的事情:

如果我们以一种喜悦的眼泪的形式想象一生中所经历的所有幸福,那么所有这些灵魂的幸福将能够每秒填充并填充地球的海洋,并在数千亿亿的千年中做到这一点。 确保这些眼泪是欢乐的眼泪,这一点非常重要。

对于一个二十岁的开发人员来说,肩上的负担相当重!

当然,这里有一个“沙龙重点”,通过将天文数值乘以微小的概率,人们可以说服自己做一些奇怪的事情。

所有有关拯救人类未来的运动都是一个怯compromise的妥协。 我们经历了相同的论点来为共产主义辩护,以解释为什么一切总是破裂而人们不能拥有基本的物质安慰。

我们将修复这个世界,获得幸福后,每个人的日常生活都会得到改善。 但是,为此,首先必须解决这个问题。

我住在加利福尼亚,尽管美国硅谷也位于这里,但这里是乞be比例最高的国家。 我没有看到我的富裕行业为改善普通民众和我们周围苦难人民的生活所做的任何事情。 但是,如果您对超级智能的想法充满热情,那么AI领域的研究将是您在地球上可以做的最重要的事情。 这比政治,疟疾,挨饿的孩子,战争,全球变暖更为重要,这一切都是您可以想象的。 确实,在数万亿万亿生物的威胁下,模拟并呈现了人类未来的整个人口,并在未来的整个时间里进行了总结。 在这种情况下,解决其他问题似乎并不合理。

墨西哥

这种态度与狂妄自大相结合,与邦德的这些恶棍并驾齐驱,这些人在我们的行业中名列前茅。 人们认为超智能将使世界不堪重负,他们用这种观点来说明为什么聪明人应该首先尝试接管世界,以便在AI打破之前解决它。

麻省理工学院媒体实验室负责人乔伊·伊托(Joey Ito)在最近与奥巴马的对话中说:

这可能会让我在麻省理工学院的一名学生感到不安,但我担心的是与AI相关的主要信息学是年轻人,其中大多数是白人,他们比其他人更喜欢与计算机聊天。 他们中的许多人相信,如果他们可以从科幻小说中创造出这种通用AI,那么我们就不必担心诸如政治和社会之类的丑陋事物。 他们认为汽车将为我们提供一切。

意识到世界不是编程任务的人们,痴迷的AI人们希望通过设计类似上帝的机器将其转变为编程任务。 这是超级狂,我不喜欢它。

巫毒超人类主义

如果您确信AI的风险,您将不得不带着预告片将悲伤的信念带到他们面前。

首先,这是纳米技术。 任何常设的超级智能都将能够制造出能够处理各种不同事物的微型汽车。 我们将生活在一个摆脱了任何物质丰富的赤字的社会中。

纳米技术还可以扫描您的大脑,以便将其加载到另一个身体或虚拟世界中。 因此,友好的超级智能的第二个结果是没有人死亡-我们成为了不朽的人。

好的AI甚至可以使死者复活。 纳米机器将能够进入我的大脑,研究我父亲的记忆,并创建他的模拟,我可以与之互动,无论我做什么,这都会使我失望。

AI出现的另一个奇怪结果是银河扩张。 我永远无法理解为什么会这样,但这是超人类主义者思想的基础。 人类的命运要么是离开我们的星球,然后在银河系中殖民,要么是死亡。 鉴于其他文明也可以做出同样的选择,并在太空竞赛中超越我们,这一任务变得更加紧迫。

因此,在存在真实AI的假设上附加了许多奇怪的补充思想。

宗教2.0

实际上,这是一种宗教。 人们称对技术奇异性的信念是“书呆子的启示”,事实确实如此。 这是一个很酷的技巧-您可以想象自己如何创建功能与上帝相同的生物,而不是相信外在的上帝。 在这里,即使是真正的无神论者也可以合理化他们走向舒适信仰的道路。

AI具有神的所有属性:他是万能的,无所不知的,并且是支持者(如果您正确地组织了检查数组边界的操作)或纯属魔鬼,您是谁? 而且,就像在任何宗教中一样,甚至有一种紧迫感。 需要今天就行动! 世界的命运stake可危! 当然,

他们需要钱 。

由于这些论点吸引了宗教本能,因此一旦扎根,就很难消除。

漫画伦理

这些宗教信仰产生了漫画伦理,其中几个孤独的英雄被赋予了以技术和敏锐的头脑拯救世界的任务。 至关重要的是宇宙的命运。 结果,我们的行业中充斥着许多自以为是蝙蝠侠的帅哥(有趣的是,没人愿意成为罗宾)。

发烧模拟

如果您相信人造生命的可能性,并且AI可以开发功能非常强大的计算机,那么您很可能会相信我们生活在模拟之中。 运作方式如下。

假设您是一位历史学家,在奇异性之后生活在一个世界中。 您正在研究第二次世界大战,并且您想知道如果希特勒在1941年占领莫斯科会发生什么。由于您可以使用超级计算机,因此您可以进行仿真设置,观察军队如何融合并编写科学著作。

但是由于模拟的粒度,她的角色是像您一样的聪明生物。 因此,您所在大学的道德操守建议将不允许您禁用模拟。 你不仅假装是大屠杀。 作为一名道德研究人员,您现在必须保持仿真正常运行。

结果,模拟世界将发明计算机AI,并将开始运行自己的模拟。 在某种程度上,仿真将在层次结构中进行得越来越远,直到处理器能力用尽。

因此,任何基本现实都可以包含大量的嵌套模拟,而简单的

计数论据证明,我们生活在模拟中的概率大于我们生活在现实世界中的概率。

但是,相信它意味着相信魔术。 如果我们处于仿真中,则对更高级别的规则一无所知。 我们甚至不知道数学是否以相同的方式工作-也许在模拟世界中2 + 2 = 5甚至2 + 2 =。

模拟世界不会提供有关其启动时所在的世界的信息。 在模拟中,如果管理员保存了必要的备份,人们很容易从死里复活。 而且,如果我们联系一位管理员,那么实际上我们将与上帝保持直接联系。

这是对理智的严重威胁。 您越深入仿真世界,您就会越发疯狂。

我们现在有四种独立的方法可以使自己成为永生不朽的人:

- 仁慈的人工智能发明了医学纳米技术,并在年轻时永远支持人体。

- AI发明了全脑扫描技术,包括对死人,冻僵的头部等进行的脑部扫描,使您可以生活在计算机中。

- AI通过扫描他人的大脑以寻找人的记忆来“使人复活”,并将其与视频和其他材料结合在一起。 如果没有人足够记得一个人,那么他总是可以从头开始成长,从他的DNA开始模拟并重新创造所有生活条件。

- 如果我们已经参与了仿真,那么启动它的人就有机会保留备份,并且您可以说服他们下载备份。

这就是AI解决宗教冲动的意思。 还有哪些其他信仰体系为您提供四种经科学证明的不朽之选?

我们了解到,至少有一个美国富豪(很可能是埃隆·马斯克,他相信我们生活在模拟中的机会是十亿比一),聘请了一对编码器来尝试破解模拟。 但这是一个很粗略的意图! 我用它!

如果您认为自己生活在计算机程序中,那么对与它一起生活的每个人尝试将其带到段错误中都是不合理的。 这比试图炸毁大气层的核科学家要更加危险和不负责任。

渴求数据

正如我已经提到的,从我们实际创建的AI中获得有趣的东西的最有效方法是将它们与数据一起删除。 这种动态对社会有害。 我们已经接近每个家庭中的Orwellian麦克风介绍。 AI数据将被集中化,它们将被用于训练神经网络,从而可以更好地听取我们的意愿。

但是,如果您认为这条路将我们引向了AI,那么您将希望以尽可能少的修改形式最大化收集的数据量。 这只会强化需要收集最多数据并进行最全面监视的想法。

程序员的弦论

AI的风险是程序员的弦论。 考虑到它很有趣,这对于现代技术水平的实验来说是有趣的,并且是完全无法实现的。 您可以建造可以在主要原则基础上运作的精神水晶宫,然后爬上它们并拉紧背后的阶梯。

能够根据一长串抽象推理得出荒谬结论并对自己的事实充满信心的人-这些人不需要文化管理来信任。

疯狂的动力

“研究”的整个领域导致疯狂。 深入思考AI风险的标志之一是,您的想法越疯狂,您在其他爱好者中就越受欢迎。 这表明了您勇于遵循这一思想的勇气。

相信自己不会死的

雷·库兹韦尔 (

Ray Kurzweil)与Google已有多年合作,现在,也许他正在研究这个问题。 硅谷通常到处都是以金钱为幌子从事疯狂项目的人。

角色扮演AI

对AI焦虑的最有害的社会影响是我所说的角色扮演AI。 相信AI的现实性和必然性的人们开始表现出来,因为他们的幻想告诉他们有关超级智能AI可以做什么。

Bostrom在他的书中列举了AI在占领世界之前必须成功完成的六件事:

- 智力的倍增。

- 战略思维。

- 社会操纵。

- 骇客

- 技术研究。

- 经济生产力。

如果您看一下硅谷的AI拥护者,那么他们自己似乎正在研究这个准社会变态者名单。

YCombinator的负责人Sam Altman是我最喜欢的这种原型的例子。 从头开始重塑世界,最大化影响力和提高个人生产力的想法显然使他着迷。 他指派了一些团队从头开始发明城市,并从事暗中政治欺诈活动以影响选举。

技术精英固有的这种“斗篷和匕首”行为会激起那些不参与不喜欢被操纵的技术的人们的消极反冲。 不可能无休止地拉动权力的杠杆,它将最终开始惹恼民主社区的其他成员。

我看着所谓的人 “理性主义者社区”是指不被认为是有效的人,即“非玩家角色”(NPC),这是从游戏中借来的术语。 这是看待世界的可怕方式。

因此,我在一个自称理性主义者是最疯狂的人的行业工作。 这是压倒性的。

这些AI扮演者就像九岁的孩子在后院里建立了一个露营营地,在帐篷里玩手电筒。 他们将自己的阴影投射到帐篷的墙壁上,并害怕它们,就像它们是怪物一样。

但是实际上,他们对自己扭曲的形象做出了回应。 聪明人如何想象神灵般的行为与他们如何建立自己的行为之间存在反馈循环。

那么答案是什么,如何解决?

我们需要更好的科幻小说! 并且,在许多其他情况下,我们已经拥有了这项技术。

这是波兰伟大的科幻小说家斯坦尼斯拉夫·莱姆(Stanislav Lem)。 英文NF太糟糕了,但是在东方集团,我们有很多好货,我们需要正确地出口它们。 它已经被积极地翻译成英文,这些翻译只需要更好地分发即可。

像Lem或Strugatsky兄弟这样的作家与西方伙伴的不同之处在于,他们在艰难的条件下长大,在战争中幸存下来,然后生活在极权社会中,在那里他们需要通过印刷文字直接表达自己的想法。

他们对人类经验和乌托邦思想的局限性有真正的了解,而西方几乎没有这种思想。

有一些例外-史丹利·库布里克(Stanley Kubrick)能够做到这一点-但是,很少有人发现美国或英国的NF对我们作为一个物种可以用技术做什么表示过拘束的看法。

炼金术士

自从我批评AI恐慌症后,就可以将我的卡片放到桌面上了。 我认为我们对心灵的理解与17世纪炼金术处于大致相同的状态。

炼金术士的声誉不好。 我们认为它们是神秘的,大部分没有参与实验工作。 现代研究表明,他们比我们想象的要勤奋得多。 在许多情况下,他们使用了现代实验技术,保留了实验室记录并提出了正确的问题。

炼金术士正确地理解了很多东西! 例如,他们深信物质的物质理论:一切都由微小的碎片组成,并且有可能以不同的方式将这些碎片彼此组合,产生不同的物质-就是这样!

他们的问题是缺乏进行所需发现所需的精确设备。 炼金术士需要做出的一项重大发现是质量守恒定律:初始成分的重量与最终成分的重量重合。 但是,其中一些可能是气体或蒸发的液体,并且炼金术士只是缺乏准确性。 直到十八世纪,现代化学才成为可能。

但是炼金术士也有使他们困惑的线索。 他们沉迷于汞。 化学上,汞并不是特别令人感兴趣,但它是室温下液相中唯一的金属。 这对于炼金术士来说似乎非常重要,并迫使他们将汞放置在其炼金系统和寻找“哲学之石”的中心,这是一种将贱金属转化为黄金的方法。

汞的神经毒性加剧了这种情况。 如果您和她玩得太多,就会有奇怪的想法出现。 从这个意义上讲,它类似于我们当前与头脑有关的心理实验。

想象一下,我们曾经将现代化学教科书寄给

乔治·史塔基(George Starkey)或艾萨克·牛顿(Isaac Newton)等伟大的炼金术士。 他们要做的第一件事是滚动浏览它,以寻找关于我们是否找到了魔法石的问题的答案。 他们会知道我们找到了他! 我们实现了他们的梦想!

但是我们不太喜欢它,因为在将金属变成黄金之后,它才具有放射性。 站在经过转化的金锭旁边,它将以无形的魔法射线杀死您。

可以想像,要使现代的放射性和原子能概念对他们而言听起来并不神秘,那将是多么困难。

我们将不得不向他们解释为什么我们使用“哲学家的石头”:用于制造地球上不存在的金属,如果它们以足够高的速度碰撞,那么其中的少数几个就足以炸毁整个城市。

此外,我们将不得不向炼金术士解释,天空中的所有恒星都是将一种元素转化为另一种元素的“哲学石”,而我们体内的所有粒子均来自于地球出现之前已存在并爆炸的穹苍中的恒星。

, , , , , , , , , , .

, , , , , , . – . , .

, . . – . , , ( ), , .

, , .

, . , . , , , . , , , .

. , , .

, , , , , . , .

, – , «», , . . 太好了! . , :

, , , .

—

, , , .

,

, , , - , , .

, , , , .

, , , . , - . , .

, , , , .

, . , - , , , , , .

: , , . !

, – , , .