OpenAI的我们发现,梯度噪声标度是一种简单的统计方法,可以预测在众多任务中学习中立网络的并行性。 由于梯度通常对于更复杂的任务而言会变得嘈杂,因此可用于同时处理的数据包大小的增加在将来会很有用,并且将消除AI系统的潜在限制之一。 在一般情况下,这些结果表明,不应将神经网络的训练视为一门神秘的艺术,并且可以赋予它准确性和系统化的知识。

在过去的几年中,人工智能研究人员通过并行化数据,将大数据包分解为多台计算机,在加速神经网络学习方面越来越成功。 研究人员已经成功地使用了数万个单元进行

图像分类和

语言建模 ,甚至使用了数百万个玩过Dota 2

的强化学习代理 。如此大的包装可以增加有效地教授一种模型的计算能力,并且是一种推动AI

培训增长的力量。 但是,对于太大的数据包,算法收益会迅速下降,并且不清楚为什么这些限制对于某些任务会更大,而对于其他任务会更小。

梯度噪声缩放比例(通过训练方法求平均值)解释了各种问题的关键数据包大小变化的大部分(r 2 = 80%),相差六个数量级。 包装尺寸以图片,标记(对于语言模型)或观察结果(对于游戏)的数量来衡量。

梯度噪声缩放比例(通过训练方法求平均值)解释了各种问题的关键数据包大小变化的大部分(r 2 = 80%),相差六个数量级。 包装尺寸以图片,标记(对于语言模型)或观察结果(对于游戏)的数量来衡量。我们发现,通过测量梯度噪声标度,通过简单的统计数字确定网络梯度中的信噪比,我们可以近似预测最大数据包大小。 启发式地,噪声标度从模型的角度(在训练的特定阶段)测量数据的变化。 当噪声规模较小时,对大量数据的并行学习很快变得多余,而当噪声规模较大时,我们可以在大型数据集上学习很多。

这种统计数据被广泛用于

确定 样本 的 大小, 建议将 其用于 深度 学习 ,但并未系统地用于现代神经网络训练。 我们已经确认了对上图中描绘的各种机器学习任务的这一预测,包括模式识别,语言建模,Atari和Dota游戏。 特别是,我们训练了旨在解决各种大小的数据包中的每个问题的神经网络(分别调整每个问题的学习速度),并将学习加速度与噪声级所预测的进行了比较。 由于大型数据包通常需要仔细且昂贵的调整或特殊的学习速度计划,才能使训练有效,而且要事先知道上限,因此在训练新模型时可以获得明显的优势。

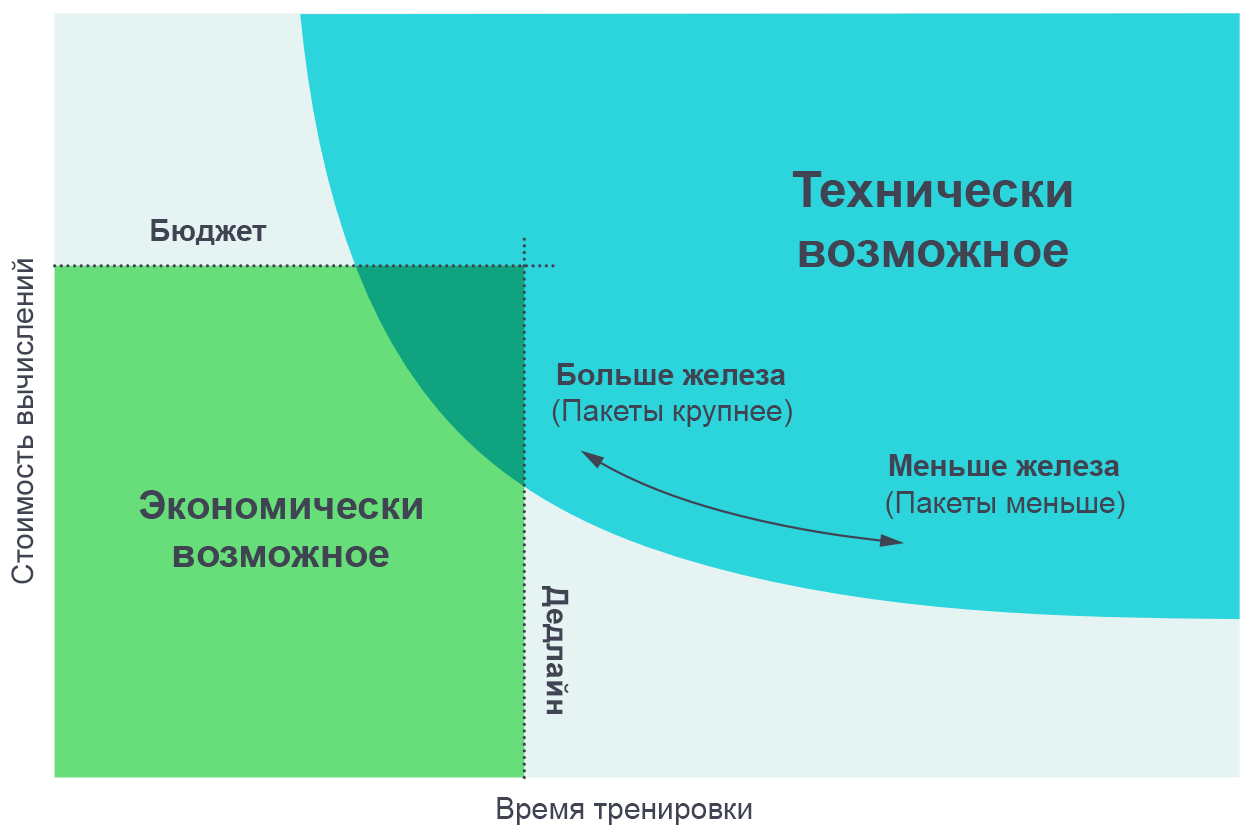

我们发现将这些实验的结果可视化是有用的,因为这是实际训练时间与训练所需的总计算量(与其金钱成本成比例)之间的折衷。 在非常小的数据包上,将数据包大小加倍可以使训练速度提高一倍,而无需使用额外的计算能力(我们运行的单个线程的运行速度是两倍,而工作线程的速度要快两倍)。 在非常大的数据模型上,并行化不会加速学习。 中间弯曲处的曲线和梯度噪声标度可预测确切发生弯曲的位置。

并行处理数量的增加使您可以在合理的时间内训练更复杂的模型。 帕累托边界图是可视化算法和比例比较的最直观方法。

并行处理数量的增加使您可以在合理的时间内训练更复杂的模型。 帕累托边界图是可视化算法和比例比较的最直观方法。通过为任务分配目标(例如,在Atari的Beam Rider游戏中为1000点)并观察训练神经网络以达到不同数据包大小的目标所需的时间,我们可以获得这些曲线。 考虑到我们设定目标的各种值,结果与我们模型的预测非常准确地吻合。

[

带有原始文章的页面显示了实现既定目标所需的经验和培训时间之间折衷的交互式图表 ]

梯度噪声标度的模式

我们在梯度噪声的规模上遇到了几种模式,在此基础上,我们可以对未来的AI训练做出假设。

首先,在我们学习过程中的实验中,噪声等级通常会增加一个数量级或更多。 显然,这意味着网络在培训的一开始就学习了问题的更多“明显”特征,然后研究了更小的细节。 例如,在对图像进行分类的任务中,神经网络可以首先学习识别小比例尺的特征(例如大多数图像上显示的边缘或纹理),然后再将这些小东西进行比较,从而创建更通用的概念,例如猫或狗。 为了全面了解各种面孔和纹理,神经网络需要查看少量图像,因此噪点范围较小; 一旦网络对更大的对象有了更多的了解,它将能够在不考虑重复数据的情况下同时处理更多的图像。

我们看到一些

初步迹象表明 ,类似的效果也适用于处理相同数据集的其他模型-在功能更强大的模型中,梯度噪声标度更高,但这仅是因为它们的损耗较小。 因此,有证据表明,训练过程中增加噪声等级不仅是收敛的产物,而且是由于模型的改进所致。 如果是这样,那么我们可以期望将来改进的模型会产生较大的噪声,并且更适合并行化。

其次,客观上更复杂的任务更适合并行化。 在与老师一起教学的背景下,从MNIST到SVHN和ImageNet的过渡中看到了明显的进步。 在强化训练的背景下,从Atari Pong到

Dota 1v1和

Dota 5v5的过渡中可以看到明显的进步,并且最佳数据包的大小相差10,000倍。 因此,随着AI处理日益复杂的任务,预计模型将处理日益庞大的数据集。

后果

数据并行化程度严重影响了AI功能的开发速度。 加速学习可以创建功能更强大的模型并加快研究速度,从而缩短每次迭代的时间。

在较早的研究“

人工智能和计算 ”中,我们看到训练最大模型的计算每3.5个月翻一番,并指出这种趋势是基于经济学(希望在计算上花钱)和算法能力并行化的。 最后一个因素(算法可并行性)更难预测,其局限性尚未得到充分研究,但我们目前的结果代表了其系统化和数值表达方面的进步。 特别是,我们有证据表明,更复杂的任务或针对已知任务的更强大的模型将允许与数据进行更多并行处理。 这将是支持与学习相关的计算呈指数增长的关键因素。 而且,我们甚至没有考虑并行模型领域的

最新发展 ,这可以使我们通过将其添加到现有并行数据处理中来进一步增强并行化。

训练计算领域及其可预测的算法基础的持续增长表明,未来几年AI功能可能会爆炸性增长,并强调有必要对这种系统

的安全和

负责任使用进行早期

研究 。 制定AI政策的主要困难将是决定如何使用此类措施来预测未来AI系统的特征,并利用这些知识来创建规则,以使社会最大化其实用性并最小化这些技术的危害。

OpenAI计划进行严格的分析以预测AI的未来,并积极应对该分析提出的挑战。