神经网络以其不可理解性而闻名-计算机可以给出一个很好的答案,但无法解释是什么导致了这一结论。 Bin Kim正在开发一种“人工翻译器”,以便在人工智能崩溃时我们可以理解它。

Google Brain的研究员Bean Kim正在开发一种对机器学习系统的决策提出质疑的方法。

Google Brain的研究员Bean Kim正在开发一种对机器学习系统的决策提出质疑的方法。如果医生告诉您您需要手术,那么您将想找出原因-即使您没有接受过医生培训,也希望他的解释对您而言很有意义。 Google Brain的研究人员Been Kim认为,我们应该能够从人工智能(AI)中获得相同的期望。 她是“解释性”机器学习(MO)的专家,并且希望创建一个可以向任何人解释其动作的AI。

自从十年前以来,人工智能背后的神经网络技术开始越来越广泛地传播,由于它具有从数据中学习并查找其中的模式的能力,它能够改变从电子邮件分类到寻找新药的所有过程。 但是,这种能力有一个莫名其妙的地方:非常复杂,使得经过深入培训的现代神经网络能够成功学习如何驾驶汽车并识别保险欺诈,使专家几乎无法理解其工作原理。 如果训练神经网络来搜索有肝癌或精神分裂症风险的患者-并且这种名为“深层患者”的系统于2015年在纽约西奈山医院启动,那么就无法了解哪个系统数据具有神经网络“关注”的功能。 这种“知识”分布在人工神经元的许多层中,每一层都与成百上千的其他神经元有联系。

随着越来越多的行业尝试使用AI自动化或改善其决策流程,这个“黑匣子”问题似乎不再是技术缺陷,而更多是基本缺陷。 DARPA的一个名为XAI(可扩展AI(Explanable AI)的缩写,可扩展AI)的项目正在积极探索这一问题,而可解释性正从MO领域的研究前沿转移到更接近其中心。 “人工智能正处于关键时刻,我们人类正在努力弄清楚这项技术是否适合我们,”金说。 “如果我们不解决可解释性问题,我认为我们将无法继续使用这项技术,也许我们会拒绝它。”

Kim和Google Brain的同事最近开发了“概念激活向量测试(TCAV)”系统,她将其描述为一种人工翻译器,允许用户向AI黑匣子询问有关决策中涉及多少高层概念。 例如,如果对MO系统进行了训练以查找斑马图像,则一个人可以要求TCAV描述“条纹”概念对决策过程的影响。

TCAV最初在经过训练可识别图像的模型上进行了测试,但它也可与为文字处理或某些数据可视化任务(例如EEG图)设计的模型一起使用。 Kim说:“它通用且简单-可以连接到许多不同的模型。”

Quanta与Kim讨论了可解释性的含义,需要的人以及它的重要性。

您在职业生涯中一直专注于MO的“可解释性”。 但是这个术语到底是什么意思?

您在职业生涯中一直专注于MO的“可解释性”。 但是这个术语到底是什么意思?可解释性有两个分支。 一个是科学的可解释性:如果您将神经网络视为研究的对象,那么您可以对其进行科学实验,以真正了解模型的整体来龙去脉,其反应的原因等等。

我主要集中精力的第二个分支是创建可回答问题的AI的可解释性。 您无需了解模型的每个细节。 但是我们的目标是要足够了解,以便可以安全地使用此工具。

但是,如果人们不完全了解系统的工作原理,又该如何相信它呢?我给你一个比喻。 假设我的院子里有一棵我想砍的树。 我为此用电锯。 我不完全了解电锯的工作原理。 但是指示说:“要谨慎对待,不要割伤自己。” 有指示后,我最好用链锯代替手锯-后者更容易理解,但是我必须看五个小时。

即使您对使之成为可能的机制一无所知,您也了解“削减”的含义。是的 可解释性第二个分支的目的如下:我们能否充分理解该工具以使其安全使用? 通过确认有用的人类知识已反映在仪器中,我们可以建立这种理解。

但是,“人类知识的反思”如何使人工智能的黑匣子更容易理解?这是另一个例子。 如果医生使用MO模型诊断癌症,医生将需要知道该模型不会简单地在我们不需要的数据中选择一些随机相关性。 验证这一点的一种方法是确认MO模型所做的事情与医生所做的大致相同。 即,表明该模型反映了医生的诊断知识。

例如,如果医生搜索适合的细胞实例进行癌症诊断,他将寻找一种叫做“合并腺体”的东西。 他还将考虑诸如患者年龄以及过去是否接受过化疗等指标。 尝试诊断癌症的医生将考虑这些因素或概念。 如果我们能够证明MO模型也引起了他们的注意,那么该模型将更加易于理解,因为它将反映出医生的人类知识。

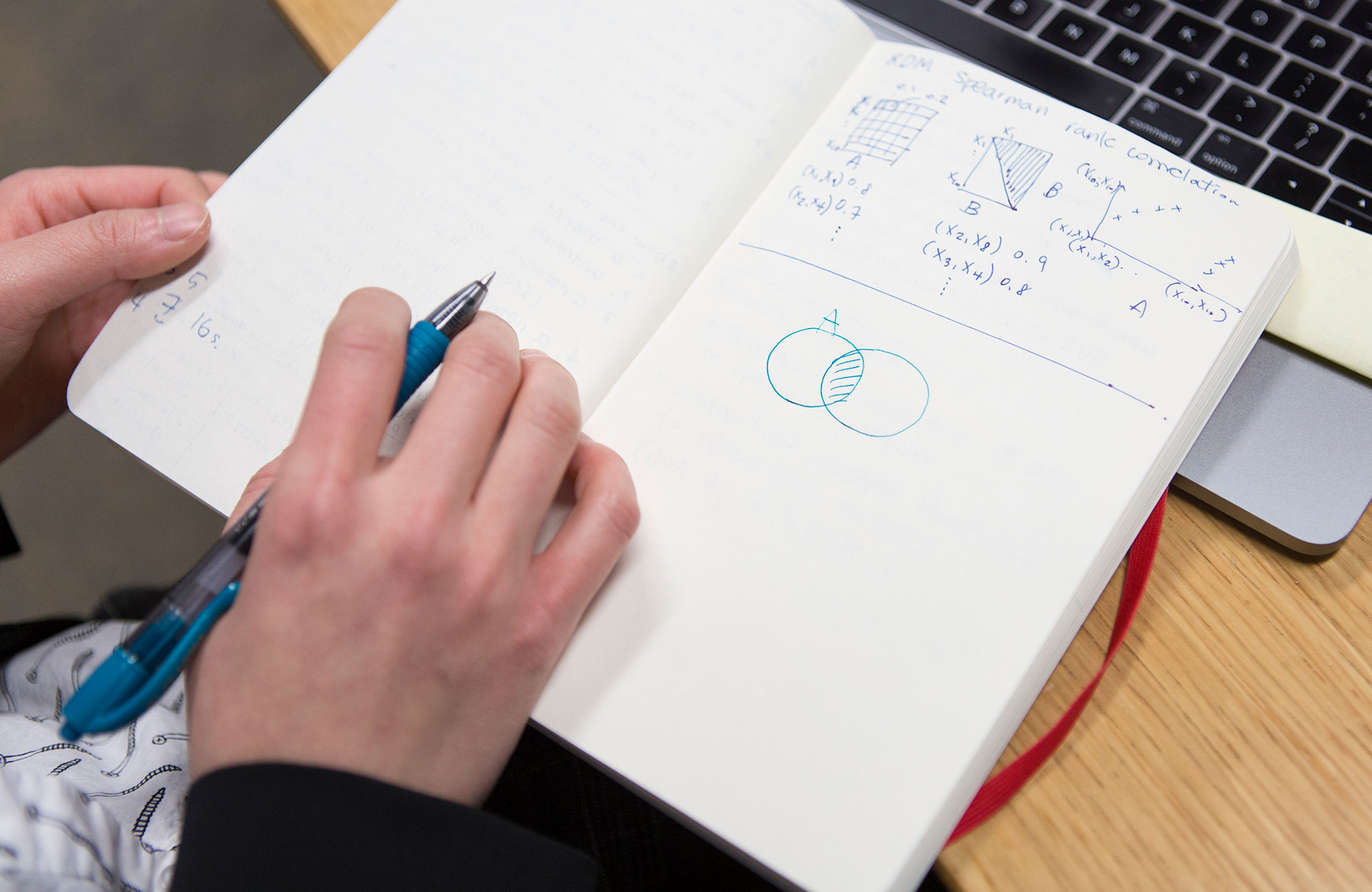

这就是TCAV所处理的-显示MO模型用于决策的哪些高级概念?是的 在此之前,可解释性方法仅根据“输入特征”解释了神经网络的功能。 这是什么意思? 如果您有图像,则其每个像素将是一种输入功能。

Yang Lekun (深度学习的先驱,Facebook的AI研究总监)表示,他认为这些模型是超级可解释的,因为您可以查看神经网络的每个节点并查看每个输入功能的数值。 对于计算机,这可能是合适的,但人们的想法有所不同。 我不是在告诉您“看像素从100到200,它们的RGB值为0.2和0.3。” 我说:“这是一只毛茸茸的狗的形象。” 人们通过概念交流这种方式。

TCAV如何在输入功能和概念之间转换?让我们回到使用MO模型的医生的示例中,该模型已经受过训练,可以根据癌症对细胞样本的图像进行分类。 作为一名医生,您需要了解“合并腺体”的概念对于模型做出积极的癌症预测有多重要。 首先,您要收集20张显示合并腺体示例的图像。 然后,将这些带有标签的示例连接到模型。

然后,内部的TCAV进行所谓的 “灵敏度检查”。 当我们添加这些合并的腺体的标记图像时,癌症预测阳性的可能性会增加多少? 可以用0到1的数字来估算答案。这将是您在TCAV中的要点。 如果可能性增加,则此概念对于模型很重要。 如果不是,则此概念并不重要。

“概念”是一个模糊的术语。 是否有任何不适用于TCAV的概念?如果您无法使用数据集的子集来描述一个概念,那么它将无法正常工作。 如果您的MO模型经过图像训练,则应该以视觉方式表达这一概念。 例如,如果我想在视觉上表达爱的概念,那将很难做到。

我们还仔细检查了这个概念。 我们有一个统计验证程序,如果它对模型具有等效的效果,则拒绝该概念向量。 如果您的概念没有通过此测试,那么TCAV会说:“我不知道,这个概念看起来对模型来说并不重要。”

TCAV项目是否更着重于建立AI信任而不是概括其理解?

TCAV项目是否更着重于建立AI信任而不是概括其理解?不,-我将解释原因,因为这种差异非常微妙。

从认知科学和心理学领域的许多研究中,我们知道人们非常信任。 这意味着通过强迫一个人相信某件事来欺骗他是很容易的。 MO的可解释性目标相反。 它包括通知一个人使用特定系统是不安全的。 目的是发现真相。 因此,“信任”不是正确的词。

因此,可解释性的目标是发现AI推理中的潜在缺陷?是的,完全正确。

她如何揭露这些缺陷?TCAV可用于向模型提出有关与研究领域无关的概念的问题。 回到医生使用AI预测癌症可能性的例子。 医生可能会突然想到:“很显然,对于许多颜色略微变为蓝色的图像,该机器对癌症的存在给出了积极的预测。 我们认为,不应考虑这一因素。” 而且,如果他们获得较高的蓝色TCAV分数,则意味着他们在MO模型中发现了问题。

TCAV被设计为挂在无法解释的现有AI系统上。 为什么不立即制作解释系统而不是黑匣子呢?可解释性研究的一个分支,侧重于创建反映人的推理的最初解释的模型。 但我是这样认为的:现在我们已经充满了现成的AI模型,这些模型已经用于解决重要问题,并且在创建它们时,我们最初并未考虑可解释性。 这么容易吃。 他们中的许多人都在Google上工作! 您可以说:“可解释性非常有用,我们可以创建另一个模型来替换您拥有的模型。” 好吧,祝你好运。

然后该怎么办? 在确定此技术是否对我们有用时,我们仍然需要经历这一关键时刻。 因此,我正在研究训练后的可解释性方法。 如果有人给您一个模型而您不能更改它,您如何处理生成其行为解释的任务,以便可以安全地使用它? 这正是TCAV所做的。

TCAV使人们可以向AI询问某些概念的重要性。 但是,如果我们不知道要问什么,该怎么办?如果我们想让AI解释一下呢?

TCAV使人们可以向AI询问某些概念的重要性。 但是,如果我们不知道要问什么,该怎么办?如果我们想让AI解释一下呢?目前,我们正在研究一个可以自动为您找到概念的项目。 我们称之为DTCAV-开幕式TCAV。 但是我认为,可解释性的主要问题是人们参与了这一过程,并且我们允许人与机器进行交流。

在许多情况下,当使用依赖程度很高的应用程序时,特定领域的专家已经有了对他们来说很重要的概念列表。 Google Brain一直在AI的医疗应用中面对这一问题。 他们不需要一组概念-他们想提供他们感兴趣的概念模型。 我们正在与一位治疗糖尿病性视网膜病,眼病的医生合作,当我们向她介绍TCAV时,她感到非常高兴,因为她已经对模型可以做什么做了很多假设,现在她可以检查所有出现的问题了。 这是实现协作式机器学习的巨大优势,并且是一种以用户为中心的方式。

您认为,如果没有可解释性,人类只能放弃AI技术。 考虑到它有什么机会,您是否真的将这种选择评估为真实?是的 这正是专家系统发生的情况。 在1980年代,我们确定它们在解决某些问题上比人们便宜。 今天谁在使用专家系统? 没有人 之后,人工智能的冬天来了。

到目前为止,这似乎不太可能,因此在AI上投入了大量的炒作和金钱。 但是从长远来看,我认为人类可以(也许出于恐惧,也许是由于缺乏证据)决定这项技术不适合我们。 有可能