“高速计算机离不开空气”

电影《钢铁侠2》中有一瞬间,托尼·史塔克(Tony Stark)观看了已故父亲的一部老电影,他说:“我受到当时技术的限制,但是总有一天你可以弄清楚这一点。 然后您将改变世界。” 太棒了,但是它表达的想法是真实的。 工程师的想法通常远远超前于他们的时代。 星际迷航》上一直有小玩意儿,但世界其他地区已经工作了数十年,才能制作平板电脑和电子书。

液体冷却概念非常适合此类。 这个主意自1960年代就已经存在,但与更便宜,更安全的空气冷却选件相比,它仍然是激进的。 液态冷却在2000年代开始出现发展已经花费了40多年的时间,即使那时,主要还是PC发烧友的特权,他们希望散布其CPU的数量远远超过Intel和AMD建议的限制。

今天,液体冷却系统越来越受欢迎。 这种用于PC的系统的价格不到100美元,面向工业应用和数据中心(如CoolIT,Asetek,Green Revolution Computing,Ebullient)的手工艺品为服务器服务器提供了液体冷却()。 ZhO主要用于超级计算机,高速计算或其他需要大量计算机功能且处理器工作负载接近100%的情况,但这种选择正变得越来越普遍。

ZhO有两种流行的类型:直接芯片冷却和浸没。 在直接冷却的情况下,散热器像标准冷却器一样连接到CPU,但与其连接的是两条管道。 一个带有冷水,另一个是吸收CPU热量的冷却散热器,另一个则很热。 然后,它冷却并以类似于血液流动的闭环形式返回到CPU。

在浸入式冷却期间,设备充满液体,显然,液体不应导电。 这种方法最类似于核反应堆的冷却池。 潜水冷却仍然是一个更高级的选择,并且比起直接连接(您可以使用普通水)进行连接,需要更多昂贵的冷却剂。 此外,始终存在泄漏的风险。 因此,到目前为止,最流行的选择是直接连接。

作为主要示例之一,请使用Alphabet。 当这家Google的母公司于2018年5月推出TensorFlow 3.0 AI时,董事Sundar Pichai表示这些芯片是如此强大,以至于“我们第一次必须在数据中心中安装液冷”。 Alphabet必须付出这个代价才能将生产率提高八倍。

另一方面,Skybox数据中心最近宣布了计划,用DownUnder GeoSolutions(DUG)的40,000台服务器创建一个大型超级计算机,该服务器专门用于石油和天然气勘探。 该项目将产生250 petaflops的计算能力,超过任何现有的计算能力。预计将这些服务器浸入装有电介质的储罐中时,将通过流体冷却。

无论如何,“液体冷却是未来的冷却,而且永远都是。” Equinix数据中心运营商设计副总裁Craig Pennington说。 “看来这显然是正确的方法,但是没有人应用它。”

JO如何从计算时代的深奥艺术变成现代数据中心几乎被普遍接受的方法? 像所有技术一样,这部分是由于不断发展,反复试验和大量工程解决方案而发生的。 但是,对于ZhO而言,今天的数据中心应该感谢那些对此方法无名英雄的早期超频者。

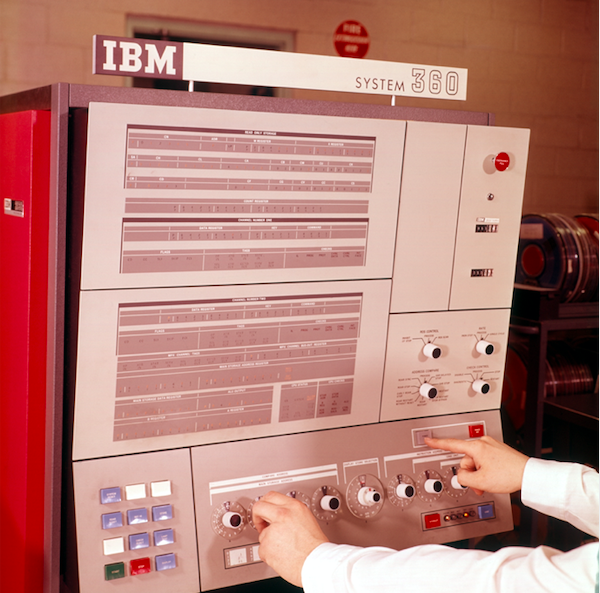

IBM System 360数据处理系统的控制面板

IBM System 360数据处理系统的控制面板液体冷却是什么意思

1964年,当IBM研究System 360大型机的过冷问题时,液体冷却成为一种流行的想法。 700和7000系列已经存在了十多年,而System / 360“开始了计算机兼容性的时代-首次使产品线中的不同机器可以协同工作”,正如他们在IBM中写道。 这个概念很简单:冷冻水必须流经将其冷却至室温以下温度的设备,然后将水直接供入系统中。 当散热器安装在主机后面时,IBM使用的电路现在称为逆冷却。 该设备通过风扇从主机上吸入热空气,然后这种空气被水冷却,就像散热器可以冷却汽车的发动机一样。

从那时起,工程师完善了这个基本概念,并出现了两种主要的VF形式:浸入式和直接接触式。 沉浸就是它的本质。 电子设备在液体浴中,由于明显的原因,它不能是水。 液体不能导电,即是绝缘体(例如3M公司甚至为此专门开发液体)。

但是潜水有很多问题和缺点。 只能从上方到达位于液体中的服务器。 因此,外部端口应位于此处。 将1U机柜的服务器放置在机架中是不切实际的,因此无法顺序放置服务器。 电介质(通常是矿物电介质)很小,非常昂贵,并且在泄漏的情况下很难清洗。 将需要特殊的硬盘驱动器,而数据中心的变更将需要大量投资。 因此,就像上面提到的超级计算机一样,浸入最好在新的数据中心中完成,而不是重做旧的数据中心。

相反,JO直接接触是散热器(或热交换器)像常规散热器一样在芯片上。 它使用两个水管来代替风扇,一个用冷水管冷却,第二个用与散热器接触加热的热水吹。 这种形式的ZhO成为最受欢迎的产品,已被HP Enterprise,Dell EMC和IBM等制造商以及Chatsworth Systems和Schneider Electric机箱制造商采用。

直接冷却用水,但是对其质量非常敏感。 禁止使用未经过滤的自来水。 只需看看您的水龙头或淋浴喷头即可。 没有人需要在服务器中积累钙。 至少直接冷却需要纯蒸馏水,有时还需要与防冻剂混合。 这种冷却剂的制造本身就是一门科学。

英特尔联络

我们如何从IBM散热器过渡到现代的奢侈冷却系统? 再次感谢超频者。 在本世纪之交,液体冷却开始在个人计算机超频者和组装计算机的业余爱好者中普及,这些人希望将计算机的速度提高到超过官方极限。 但是,这是没有标准设计的深奥艺术。 每个人都做了不同的事情。 组装所有这些产品的人必须是一个

大人物 ,以至于组装宜家产品似乎完全是胡说八道。 大多数冷却系统甚至都无法装入机柜中。

2004年初,由于英特尔政策的内部变化,情况开始发生变化。 来自俄勒冈州希尔斯伯勒(Hillsboro)设计中心的工程师(尽管公司的大多数芯片都在该中心进行设计,尽管其总部位于加利福尼亚州圣克拉拉)已经从事了一个特殊的冷却项目已有好几年了。 该项目使公司花费了100万美元,目的是为英特尔处理器开发一种液体冷却器。 不幸的是,英特尔即将关闭它。

工程师希望获得不同的结果。 为了保存该项目,他在Falcon Northwest提出了这个想法,Falcon Northwest是一家位于波特兰的公司,为计算机构建游戏附加组件。 Falcon Northwest总裁Kelt Reeves说:“原因是该公司认为液冷会鼓励人们超频,而当时禁止这种活动。” 在这个职位上,英特尔拥有自己的逻辑。 当时,亚洲的无原则零售商以更强大的笔记本电脑为幌子销售超频PC,并且散热不佳,在公众眼中,这在某种程度上变成了英特尔的问题。 因此,公司反对超频。

但是,这位俄勒冈州的工程师认为,如果他设法找到这种冷却器的客户和市场,那么英特尔将屈服。 (此外,Reeves告诉我们,最终的Intel产品在质量上要比市场上的产品好得多)。 因此,经过两家公司之间的内部说服和谈判之后,英特尔允许Falcon销售冷却系统-尤其是因为英特尔已经生产了数千套冷却系统。 唯一的收获是Falcon无法提及Intel的介入。 Falcon同意,并很快成为第一个提供完全密封的多合一PC系统的制造商。

里夫斯指出,这种先进的ZhO解决方案并非特别用户友好。 猎鹰不得不改变外壳以适合散热器,并发明了一种水冷却板。 但是随着时间的流逝,诸如ThermalTake和Corsair之类的散热器制造商了解了英特尔在做什么,并开始进行持续的改进。 从那时起,出现了一些产品和制造商,例如CoolIT和Asetek,他们专门为数据中心生产ZhO。 他们的某些产品-例如不破裂,不破裂和不泄漏的管道(最长可保证长达7年)-最终是根据许可证授予最终用户的冷却系统制造商的,双向的这种技术交流已成为常态。

随着市场向不同方向发展,甚至英特尔最终也改变了主意。 现在,她宣传K和X系列处理器的超频功能,甚至不关心为游戏玩家出售常规散热器和顶级CPU。

里夫斯说:“ ZhO已经是一种成熟的技术-每个人都在消费者方面这样做。” 英特尔已经停止为常规散热器提供最强大的CPU,因为它们需要JO。 它已经得到证明,并获得了英特尔的祝福。 我认为没有人会说完整的解决方案还不够可靠。”

数据中心的浸入式冷却。 盒子里充满了流经管道的绝缘流体。

数据中心的浸入式冷却。 盒子里充满了流经管道的绝缘流体。 通过沉浸式技术从Skybox数据中心进行液体冷却。 热交换器浸没在计算机设备中,绝缘液体不会离开储罐。 水回路穿过房间并到达每个热交换器。

通过沉浸式技术从Skybox数据中心进行液体冷却。 热交换器浸没在计算机设备中,绝缘液体不会离开储罐。 水回路穿过房间并到达每个热交换器。有利于液体冷却实用性的事实

长期以来,传统的数据中心都在高架地板上提供小开口,服务器通过这些小开口吸入冷空气。 这就是所谓的CRAC,或计算机房空调。 问题在于,现在仅通过地板的开口吹冷空气还不够。

最近液体冷却的繁荣的主要原因是需要。 当今的处理器温度太高,服务器也离得太近,无法通过空气有效地冷却它们,甚至谷歌都说。 水的热容量是空气的3300倍,并且水冷却系统每分钟可以抽出300升水,而每分钟只有20立方米的空气。

简而言之,水可以在更小的空间内更有效地冷却。 因此,经过多年努力降低功耗后,处理器制造商可以分散功率并扭曲电压以获得最佳性能-知道液体冷却可以解决这一问题。

“我们要求冷却功耗将很快超过500瓦的芯片,” CoolIT主管Jeff Lyon说。 -一些尚未进入市场的处理器每个将消耗300瓦。 所有这些都是根据AI和机器学习的要求而发展的。 冷却速度根本不够。”

里昂说,CoolIT正在考虑将冷却系统扩展到芯片组,电源控制系统,网络芯片和内存。 他补充说:“在处理记忆方面,没有任何根本方法。” -提供带有高级包装的RAM选项,每个DIMM消耗18瓦。 典型的DIMM消耗4-6瓦。 在具有大量内存的系统中,我们发现安装了16个甚至24个DIMM的服务器,这意味着热量很大。”

制造商一一面对这些要求。 Equinix观察到平均密度如何从5 kW增长到7-8 kW,现在又增长到15-16 kW,有些设备已经显示出40 kW的密度。 “因此,需要泵送的空气总量太大。 Equinix的Pennington说:“这不会立即发生,但是在接下来的几年中,将会从根本上采用液体冷却。”

关于浸入式冷却的一些知识

Green Revolution Cooling专注于沉浸式冷却,其董事Peter Poulin说,从能源效率的角度来看,沉浸式冷却优于直接冷却,原因有两个。 首先,从所有服务器上卸下风扇。 只有这样,才能将能耗平均降低15%。 该公司的一位客户将其减少了30%。

消除粉丝的另一个间接优势是:保持沉默。 尽管服务器通常使用非常小的风扇,但是服务器的风扇却非常嘈杂,并且由于发热量和噪音而使数据服务器处于令人不快的状态。 液体冷却使这些场所更令人愉悦。

另一个优点是支持浸入式冷却系统所需的能量非常少。 只有三个运动部件:用于使冷却器循环的泵,用于将其移动到冷却塔的泵以及冷却塔风扇。 更换液冷空气后,耗电量可降至空调费用的5%。 Poulnin说:“您将大大减少能耗,这使您可以做很多其他事情。” “取决于消费者,数据中心可能会更节能,或者减少与数据中心建设相关的碳排放。”

支持节能液体冷却的事实

长期以来,能源消耗一直是数据中心行业关注的问题(美国环境保护署一直在追踪这一数字至少十年了)。 当今的数据中心是巨大的企业,估计消耗全球所有电力的2%,并向大气中释放与航空业一样多的CO

2 。 因此,对该问题的兴趣不会消失。 幸运的是,液体冷却降低了电费。

首先节省的费用是由于断开了数据中心的空调。 第二是淘汰球迷。 每个服务器机架上都有许多风扇吹气,但是根据密度的不同,风扇的数量可以减少到零或为零。

借助不冻结的“干式冷却”技术,您可以节省更多成本。 最初,直接连接的冷却装置使水流过冰箱,然后将其冷却到15-25摄氏度。 但是最后,事实证明,液体冷却器使水通过一系列的管道和风扇,通过热水加热的冷却管道以及自然的热扩散也将水冷却到足够的温度。

彭宁顿说:“由于此过程非常有效,因此您不必担心将水冷却到一定温度。” -热水仍然可以有效地带走服务器中的所有热量。 您不需要压缩循环,只需使用干式冷却器即可。”

干式冷却器还可以节水。 使用冰箱的大型数据中心每年可消耗数百万升的水,但是带有干式冷却器的数据中心不会消耗水。 这样可以节省能源和水,如果数据中心位于城市内,这将非常有用。

彭宁顿说:“我们不消耗大量水。” -如果仔细设计所有内容,就会得到封闭的系统。 水不会倒入也不会倒出,您只需要每年大约加水一次即可保持水箱充满。 您不会经常在车上加水,这就是我们的情况。”

接受跟随有效性

PowerEdge Dell EMC产品管理和营销副总裁Brian Payne认为,一个真实的例子是:戴尔改用液体冷却,将能效(

PUE )提高了56%。

PUE是冷却系统所需的能量与操作系统所需的能量之比[实际上,这是数据中心消耗的总能量与直接为IT基础架构供电所消耗的能量之比/大约。 perev]。 PUE等于3意味着在冷却系统上花费的能量是系统功耗的2倍,而PUE = 2意味着在能量和冷却方面的消耗相等。 PUE不能等于1,因为必须进行冷却,但是数据中心运营商着迷于使数值尽可能接近1.0。除了提高PUE之外,戴尔客户获得的计算能力最多可提高23%,这不会使系统过载。 Payne说:“基于必要的基础设施投资,我们可以预测系统的年收益。” -我会将其与购买更节能的家用空调进行比较。您花了一点钱,但是随着时间的流逝,您会感受到电费的好处。”作为液体冷却的完全不同的拥护者,请选择位于OSC俄亥俄州的超级计算机中心。该群集使用1800个节点。正如首席系统架构师道格·约翰逊(Doug Johnson)所说,切换到JO后,中心达到PUE = 1.5。 OSC使用外部电路,因此将水从建筑物中除去并冷却到环境温度,夏季的平均温度为30°C,冬季的平均温度低得多。碎屑达到70°C,即使水加热到40°C,它仍然比碎屑要冷得多,并达到了目的。像许多新技术的早期采用者一样,对于OSC来说,它是全新的。五年前,该中心根本没有使用ZhO,而如今已占到25%。该中心希望,在三年内该门槛将增长到75%,几年后,他们将完全转向ZhO。但是,根据约翰逊的说法,即使在今天的状态下,冷却中心所需的能源也比过渡到ZhO之前的能源少四倍,通常,此解决方案将总能耗降低了2/3。 “我认为当我们开始将GPU集成到冷却系统中时,百分比将会增加。”从客户的角度来看,评估一项新技术需要时间和精力,这就是为什么像戴尔这样的大公司同意与CoolIT合作宣传ZhO的原因。毫不奇怪,首先,客户担心的仍然是泄漏的可能性。但是,尽管有所有的波动,但事实证明,目前,他们想要获得最佳性能的选择很少。“一直以来都担心泄漏,” CoolIT的里昂说。-情况已经改变,现在根本没有其他选择。高速计算机不能做到这一点。”