tl; dr:

- 机器学习在数据中寻找模式。 但是,人工智能可以被“偏见”-也就是说,找到错误的模式。 例如,来自照片的皮肤癌检测系统可能会特别注意在医生办公室拍摄的照片。 机器学习不知道如何:它的算法仅显示数字模式,如果数据不具有代表性,则其处理结果也将如此。 由于机器学习的机制,捕获此类错误可能很困难。

- 最明显和最可怕的问题是人的多样性。 人们数据即使在收集阶段也可能失去客观性,原因有很多。 但是您不应该认为这个问题只涉及人员:试图在仓库中发现洪水或燃气轮机出现故障时,也会出现同样的困难。 一些系统可能在肤色方面存在偏见,而其他系统则偏向于西门子传感器。

- 这样的问题对于机器学习来说并不陌生,而且远非他独有。 在任何复杂的结构中都做出不正确的假设,并且总是很难理解为什么要做出决定。 有必要以复杂的方式处理此问题:创建用于验证的工具和流程-并对用户进行教育,以使他们不会盲目地遵循AI的建议。 机器学习确实在某些方面比我们做得要好得多,但是例如,狗在检测毒品方面比人们有效得多,这并不是将它们带为证人并根据其证词通过句子的理由。 顺便说一下,狗比任何机器学习系统都要聪明得多。

如今,机器学习是最重要的基础技术趋势之一。 这是技术在未来十年内改变我们周围世界的主要方式之一。 这些变化的某些方面令人担忧。 例如,机器学习对劳动力市场的潜在影响,或将其用于不道德目的(例如,专制政权)。 这篇文章专门讨论了另一个问题: 人工智能的偏见 。

这是一个很难的故事。

Google AI可以找到猫。 那么,2012年的这一消息真是太特别了。

什么是AI偏见?

“原始数据”既是矛盾的,也是一个坏主意; 数据必须精心准备。 杰弗里·博克(Jeffrey Boker)

在2013年之前的某个地方,为了创建一个可以识别照片中猫的系统,您必须描述逻辑步骤。 如何在图像中找到角落,识别眼睛,分析纹理以发现毛发,计数爪子等等。 然后收集所有组件-并发现所有这些实际上都不起作用。 有点像机械马-理论上可以做到,但是在实践中,描述起来太复杂了。 在出口处,您有数百个(甚至数千个)手写规则。 而不是单一的工作模型。

随着机器学习的出现,我们不再使用“手动”规则来识别对象。 取而代之的是,我们取一千个“ X”样本,一千个“另一个” Y样本,并强迫计算机根据其统计分析来构建模型。 然后,我们为该模型提供一些样本数据,并以某种精度确定其是否适合其中一组。 机器学习基于数据而不是在编写者的帮助下生成模型。 结果令人印象深刻,尤其是在图像和模式识别领域,这就是为什么整个技术行业现在都转向机器学习(ML)的原因。

但不是那么简单。 在现实世界中,您成千上万个X或Y的示例还包含A,B,J,L,O,R甚至L。它们可能分布不均匀,并且其中一些经常被发现,因此系统比它们更关注它们吸引您感兴趣的对象。

在实践中这意味着什么? 我最喜欢的例子是,当图像识别系统看着草地上的小山说“绵羊”时 。 可以理解为什么:大多数“绵羊”的示例照片是在它们生活的草地上拍摄的,在这些图像中,草占据的空间比白色蓬松小得多,并且被认为是最重要的系统草。

还有更严重的例子。 最近的一项-在照片中检测皮肤癌的项目 。 事实证明,皮肤科医生经常将阵容以及皮肤癌的表现拍照,以固定形成物的大小。 在健康皮肤的照片示例中,没有标尺。 对于AI系统,这样的标尺(更确切地说,我们定义为“标尺”的像素)已成为示例集之间的差异之一,有时比小皮疹更重要。 因此,一个旨在识别皮肤癌的系统有时会识别出这条线。

这里的关键点是系统对所查看的内容没有语义上的理解。 我们查看一组像素,并在其中看到绵羊,皮肤或标尺,以及系统-仅是数字线。 她看不到三维空间,她看不到物体,纹理或绵羊。 她只是看到数据中的模式。

诊断此类问题的困难在于神经网络(由机器学习系统生成的模型)由成千上万个节点组成。 没有简单的方法可以研究模型并查看其如何做出决策。 这种方法的存在意味着该过程足够简单,无需使用机器学习即可手动描述所有规则。 人们担心机器学习已成为一种黑匣子。 (我稍后会解释为什么这种比较仍然太多。)

一般而言,这是人工智能或机器学习的偏见问题:用于在数据中查找模式的系统可以找到错误的模式,但您可能不会注意到它。 这是技术的基本特征,对于科学界和大型技术公司中使用它的每个人来说都是显而易见的。 但是其后果是复杂的,我们对这些后果的可能解决方案也是如此。

让我们先谈谈后果。

人工智能可以基于大量不起眼的信号为我们暗中做出选择,以支持某些类别的人

AI偏见场景

最明显和最可怕的事情是,当涉及到人类多样性时,这个问题就会显现出来。 最近,有传闻说亚马逊试图建立一个机器学习系统来对候选人进行初步筛选。 由于亚马逊工作人员中的男性较多,因此“成功录用”的案例也比男性更多,并且在系统建议的简历选择中,男性也更多。 亚马逊注意到了这一点,并没有在生产中发布该系统。

在此示例中,最重要的是,有传言称该系统偏爱男性候选人,尽管简历中没有列出性别。 该系统在“成功录用”的示例中还看到了其他模式:例如,女性可以使用特殊的词语来描述成就,或者具有特殊的爱好。 当然,该系统不知道“曲棍球”是什么,谁也不是“人”,也不知道什么是“成功”,它只是对文本进行了统计分析。 但是她看到的模式很可能仍然未被人们所注意,其中有些模式(例如,不同性别的人对成功的描述不同),即使我们看着它们,我们也可能很难看清。

更糟的是。 机器学习系统在苍白的皮肤上发现癌症的机率很高,而在深色皮肤上则表现更差,反之亦然 不一定是因为偏见,而是因为您可能需要针对其他肤色构建单独的模型,并选择其他特征。 机器学习系统即使在像图像识别这样狭窄的领域也无法互换。 您有时需要简单地通过反复试验来设置系统,以充分注意您感兴趣的数据中的功能,直到达到所需的准确性为止。 但是您可能不会注意到,与一个小组一起工作时,该系统在98%的情况下是准确的,而在另一小组上只有91%(尽管这比一个人进行的分析更准确)。

到目前为止,我主要使用了有关人员及其特征的示例。 有关此问题的讨论主要集中在此主题上。 但重要的是要了解,偏重于人只是问题的一部分。 我们将在许多事情上使用机器学习,而采样错误将与所有这些事情有关。 另一方面,如果您与他人一起工作,则数据偏向可能与他们无关。

为了理解这一点,让我们回到皮肤癌的例子,并考虑系统崩溃的三种假设可能性。

- 人的分布不均:不同色调的皮肤照片数量不平衡,导致与色素沉着相关的假阳性或假阴性结果。

- 对该系统进行训练的数据包含与人无关且不具有诊断价值的经常遇到且异质分布的特征:皮肤癌表现照片上的标尺或绵羊照片上的草皮。 在这种情况下,如果系统在人眼定义为“标尺”的图像中找到像素,结果将有所不同。

- 数据包含一个人即使看到它也看不到的第三方特征。

这是什么意思? 我们先验地知道,不同的人群可以不同地呈现数据,至少我们可以计划搜索此类异常。 换句话说,有很多社会原因认为关于人群的数据已经包含一些偏见。 如果我们用标尺看照片,我们将看到此标尺-我们之前只是忽略了它,知道它没有关系,而忘记了系统什么都不知道。

但是,如果您所有不健康的皮肤照片都是在使用白炽灯泡且在荧光灯下健康的办公室拍摄的,该怎么办? 如果完成健康皮肤的去除后,在拍摄不健康之前,您更新了手机上的操作系统,而Apple或Google稍微更改了降噪算法,该怎么办? 一个人不管有多少寻求这样的特征,都不会注意到这一点。 但是随后,机器使用系统将立即看到并使用它。 她什么都不知道

当我们谈论错误的相关性时,可能会出现数据准确且结果正确的情况,但是出于道德,法律或行政原因,您不想使用它们。 例如,在某些辖区中,尽管妇女可能会更安全地驾驶,但无法为妇女提供保险折扣。 我们可以轻松地想象一个系统,在分析历史数据时,会将较低的风险因素分配给女性名字。 好的,让我们从选择中删除名称。 但是请记住亚马逊的示例:系统可以通过其他因素确定性别(尽管它不知道性别是什么,什么是机器),并且直到监管机构追溯分析您提供的费率并且不向您收费时,您才会注意到这一点。你还好

最后,通常暗示我们只会将此类系统用于与人和社会互动相关的项目。 事实并非如此。 如果您制造燃气轮机,则可能希望将机器学习应用于产品上数十个或数百个传感器传输的遥测(音频,视频,温度和任何其他传感器生成的数据可以很容易地用于创建机器学习模型) 假设地说,您可以说:“这是在故障之前获得的一千台故障涡轮机的数据,但这是来自一千台未损坏的涡轮机的数据。 建立一个模型来说明它们之间的区别是什么。” 好吧,现在想象一下,西门子传感器的坏涡轮成本为75%,而好的涡轮成本仅为12%(与故障无关)。 该系统将建立一个模型来定位带有西门子传感器的涡轮机。 糟糕!

图片-加州大学伯克利分校的Moritz Hardt

人工智能偏差管理

我们该怎么办? 您可以从三个方面解决问题:

- 在收集和管理用于培训系统的数据方面,方法学上十分严格。

- 用于分析和诊断模型行为的技术工具。

- 在将机器学习引入产品中的培训,教育和警告。

莫里哀的《贵族商人》一书开了个玩笑:一个人被告知文学分为散文和诗歌,他钦佩自己一生都不讲散文,对此他很钦佩。 统计学家今天可能以某种方式感到这种感觉:他们没有注意到这一点,而是将自己的职业致力于人工智能和抽样误差。 要查找采样错误并担心它不是一个新问题,我们只需要系统地解决它的解决方案即可。 如上所述,在某些情况下,通过研究与人员数据相关的问题来做到这一点确实很容易。 我们先验地假设我们可能对不同的人群有先入为主的观念,但是我们很难想象对西门子传感器的偏见。

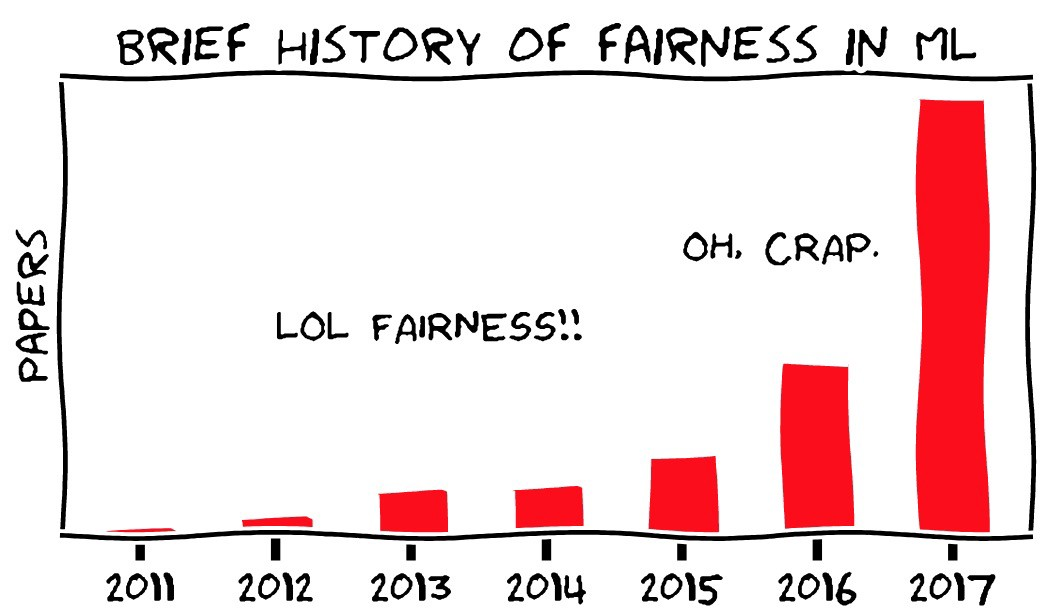

当然,所有这一切的新之处在于人们不再直接参与统计分析。 它是由创建难以理解的大型复杂模型的机器执行的。 透明度问题是偏见问题的主要方面之一。 我们担心该系统不仅有偏差,而且没有办法检测其偏差,并且机器学习不同于其他形式的自动化,后者应该由可以验证的清晰逻辑步骤组成。

这里有两个问题。 但是,也许我们仍然可以对机器学习系统进行审核。 实际上,对其他任何系统的审核实际上都不容易。

首先,机器学习领域的现代研究领域之一是寻找有关如何识别机器学习系统重要功能的方法。 同时,机器学习(处于目前的状态)是一个瞬息万变的科学新领域,因此,您不应认为今天不可能发生的事情不会很快变成现实。 OpenAI项目就是一个有趣的例子。

第二,在现有系统或组织中可以检查和理解决策过程的想法在理论上是好的,但在实践中却是这样。 了解大型组织如何制定决策绝非易事。 即使那里有一个正式的决策过程,它也不能反映人们的实际互动方式,实际上,他们通常没有逻辑上系统的决策方法。 正如我的同事维杰·潘德 ( Vijay Pande)所说 , 人们也是黑匣子 。

在几家重叠的公司和机构中雇用一千人,问题将变得更加复杂。 我们知道航天飞机注定要在返回时瓦解,事实上,美国宇航局内部的一些人掌握的信息使他们有理由认为可能会发生不好的事情,但整个系统并不知道。 美国宇航局甚至失去了之前的航天飞机,也刚刚通过了类似的审核,但又由于同样的原因又失去了另一架。 可以轻松地说,组织和人员遵循可以检查,理解和更改的清晰逻辑规则,但经验证明事实恰恰相反。 这就是“ 国家计委的错误 ”。

我经常将机器学习与数据库(尤其是关系数据库)进行比较,这是一种新的基础技术,它改变了计算机科学及其周围世界的可能性,这已成为我们经常使用而没有意识到的一切的一部分。 数据库也有问题,并且具有类似的属性:系统可以基于错误的假设或错误的数据构建,但是很难注意到,并且使用该系统的人将按要求执行操作,而不会提出问题。 有很多关于税务工作者的古老笑话,他们曾经把您的名字拼错了,说服他们纠正错误比实际更改名字困难得多。 可以用不同的方式来考虑这一点,但是尚不清楚如何做到最好:SQL中的技术问题如何,或者Oracle版本中的错误如何,或者官僚机构的失败如何? 在过程中发现导致系统不具有错字校正功能的错误是多么困难? 在人们开始抱怨之前可以理解吗?

当驾驶员由于导航器中的数据过时而去河边时,故事会更容易说明这个问题。 好的,地图必须不断更新。 但是,TomTom对您的汽车吹入海中这一事实应负责多少?

我这样说是肯定的-机器学习的偏见会造成问题。 但是,这些问题将与我们过去遇到的问题类似,并且与我们过去一样,它们可以被注意到和解决(或不能被解决)。 因此,对于在大型组织中工作的领先研究人员而言,不太可能发生AI偏见的情况。 , - - , , . “ ” , , , , . . , . .

结论

, , — , .

, « » . , — . HAL9000 Skynet — -, . 但是没有 , , , . , , … . . , , , - . , — , , .

, — , — . , , .

, , « — , » . , « ». , , , . , . , — , , , . , , .

翻译: Diana Letskaya。

编辑: Alexey Ivanov。

社区: @PonchikNews。